Learn more about Search Results DINOv2

- You may be interested

- 「データ分析のためのトップ10のAIツール」

- ペンシルバニア大学の研究者が、軽量で柔...

- 「ダレ恵3の翻訳に迷い込んで」

- LangChainとPinecone Vector Databaseを使...

- テキストデータのチャンキング方法-比較分析

- Sudowriteのレビュー:AIが人間らしい小説...

- 「5つの手順でGoogle Cloud Platformを始...

- 「言語モデルがプログラマーを置き換える...

- コンピューターモデルによる作物の収穫量予測

- ハッピーな1周年 🤗 ディフューザーズ!

- トゥギャザーエーアイは、トレーニング用...

- 「ジェネレーティブAI(2024)の10の重要...

- 「NVIDIAの人工知能がOracle Cloud Market...

- AIが医療費を削減するのにどのように役立...

- 「ロボットのセンシングと移動のためのア...

カスタムデータセットのセグメンテーションにおけるDINOv2 総合的なチュートリアル.

YOLOv8とSAM(Segment Anything Model)に続いて、最も期待されているコンピュータビジョンモデルはDINOv2です

メタAIのコンピュータビジョンにおける公平性のための2つの新しい取り組み:DINOv2のためのライセンス導入とFACETのリリースの紹介

コンピュータビジョンの絶え間ない進化の中で、公平性を確保することが急務となっています。この記事では、AI技術、特にコンピュータビジョンにおける広範な可能性について解説し、エコロジーの保護活動から画期的な科学的探求を支援するまで、さまざまなセクターで変革的な突破口となるカタリストとしての役割を果たしていることを明らかにしています。しかし、この技術の台頭に伴う潜在的なリスクについても率直に語っています。 Meta AIの研究者は、急速なイノベーションのリズムと必要とされる慎重な開発プラクティスの間で重要な均衡を取ることを強調しています。これらのプラクティスは単なる選択肢ではなく、歴史的に弱い立場にあるコミュニティにこの技術が誤って与える可能性のある損害から守るための重要な盾です。 Meta AIの研究者は、この多面的な課題に対応する包括的なロードマップを策定しています。まず、自己教師あり学習のための試練を経て鍛造された先進的なコンピュータビジョンモデルであるDINOv2を、オープンソースのApache 2.0ライセンスの下でより広範なユーザーに提供します。DINOv2は、コンピュータビジョンモデルの大幅な進歩を表すものです。セルフサプライズ学習の技術を利用して、普遍的な特徴を作り出し、高い柔軟性で画像を理解し解釈することができます。 DINOv2の能力は、従来の画像分類を超えています。セマンティックイメージセグメンテーションという多くのタスクで優れたパフォーマンスを発揮し、オブジェクトの境界を正確に識別し、意味のある領域に画像をセグメント化します。また、単眼の深度推定においても優れたパフォーマンスを発揮し、画像内のオブジェクトの空間的な奥行きを知覚することができます。この多様性により、DINOv2はコンピュータビジョンアプリケーションのパワーハウスとなります。このアクセシビリティの拡大により、開発者や研究者はDINOv2の強力な機能をさまざまなアプリケーションに活用し、コンピュータビジョンイノベーションのフロンティアをさらに押し進めることができます。 Metaのコンピュータビジョンにおける公平性への取り組みの核心は、FACET(FAirness in Computer Vision Evaluation)の導入によって明らかになります。FACETは、約50,000人を特集した驚異的なベンチマークデータセットであり、専門の人間注釈者による細心の注釈が特徴です。これらの専門家は、データセットを細心の注意を払って注釈付けし、さまざまな次元で分類しています。これには、認識されるジェンダープレゼンテーション、年齢層、認識される肌の色合いや髪型などの人口統計属性が含まれます。驚くべきことに、FACETは「バスケットボール選手」や「医師」といった職業など、人に関連するクラスを導入しています。さらに、研究目的のために69,000のマスクのラベルも含まれており、その意義が高まっています。 FACETを用いた初期の探索では、最先端のモデルが異なる人口集団間でのパフォーマンスの差異を明らかにしました。たとえば、これらのモデルは、より暗い肌色を持つ個人や巻き毛のある個人を正確に検出することに頻繁に課題を抱えており、注意深い検討が必要な潜在的なバイアスを明らかにしています。 FACETを使用したパフォーマンス評価では、最先端のモデルが人口集団間でのパフォーマンスの差異を示しています。たとえば、モデルはより暗い肌色を持つ個人を検出することに苦労し、巻き毛のある個人に対してはさらに困難を抱えることがあります。これらの差異は、コンピュータビジョンモデルにおけるバイアスの評価と軽減の必要性を強調しています。 FACETは主に研究評価のために設計されており、トレーニング目的ではありませんが、コンピュータビジョンモデルの公平性を評価するための第一級の基準として台頭する可能性があります。これにより、従来の人口統計属性を超えて人に関連するクラスを取り入れた、深い洞察に基づく公平性の評価が可能となります。 まとめると、Metaの記事は、コンピュータビジョン内の公平性問題についての警笛を鳴らし、FACETによって明らかになったパフォーマンスの差異を明るみに出しています。Metaの方法論は、DINOv2のような先進モデルへのアクセスの拡大と、先駆的なベンチマークデータセットの導入を含めた多面的なアプローチを強調しています。これにより、イノベーションの促進と倫理基準の維持、公平性の問題の緩和に対する彼らの不断の取り組みが浮き彫りになっています。それは、技術がすべての人々の福祉のために活用される公正なAIの景観を実現するための航海図を描いています。

メタAIのもう一つの革命的な大規模モデル — 画像特徴抽出のためのDINOv2

Mete AIは、画像から自動的に視覚的な特徴を抽出する新しい画像特徴抽出モデルDINOv2の新バージョンを紹介しましたこれはAIの分野でのもう一つの革命的な進歩です...

「2023年のAI タイムライン」

はじめに 人工知能(AI)は、技術的な進歩が人間のつながりの本質と共鳴する形で私たちの日常生活と交差する魅力的な領域です。今年は、単なるアルゴリズムを超えてAIを身近に感じる革新の物語が展開されました。2023年のAIの素晴らしいハイライトを探索しながら、この旅に参加しましょう。 AI 2023年のハイライト 2023年のAIの世界で行われた最大の発見、進歩、および世界的な変革の一部を紹介します。これらの進歩がどのように、技術が私たちの人間の体験にシームレスに統合される未来を形作っているのか、探求してみましょう。 2023年1月のAIハイライト この年は、AIが医療と健康の分野で重要な進展を示しました。MITの研究者はマサチューセッツ総合病院と連携し、CTスキャンに基づいて患者の肺がんのリスクを評価できるディープラーニングモデルを開発しました。また、革命的な進歩として、研究者たちはAIを使ってゼロから人工的な酵素やタンパク質を作り出すことが可能なAIを開発しました。 他にも多くのイノベーションの中で、人工知能は視覚障害のある人々が食料品を見つけるのを手助けするために手杖に統合されました。一方、ビジネスのフロントでは、OpenAIがMicrosoftとの数年間にわたる数十億ドルの取引を通じてAIの開発に大きく投資しました。 2023年2月のAIハイライト 2023年2月には、OpenAIのChatGPTに関する話題が最も盛り上がりました。このAI搭載のチャットボットは、アメリカ合衆国医師資格試験(USMLE)に合格し、その人気は1億人以上のユーザーにまで急上昇しました。 ChatGPTの現象に応えて、GoogleはAI会話の領域に新しい要素となるBard A.I.を導入しました。また、MicrosoftもChatGPTと統合された新しいBing検索エンジンの導入に重要な一歩を踏み出しました。 Metaは、Metaエコシステム内でAIの能力を向上させるというLLaMAを発表しました。一方、Amazon Web Services(AWS)は、一流のAIプラットフォームであるHugging Faceと提携し、AI開発者を支援しました。 画期的な成果として、オックスフォードの研究者たちはRealFusionを示し、単一の画像から完全な360°写真モデルを再構築することができる最新のモデルを実証しました。 2023年2月には、AIの世界は音楽生成の領域にも足を踏み入れました。Google ResearchはMusicLMを紹介し、さまざまなジャンル、楽器、概念で曲を作成できるトランスフォーマーベースのテキストからオーディオへのモデルを提供しました。一方、Baiduの研究者はERNIE-Musicを発表し、拡散モデルを使用して、波形領域での最初のテキストから音楽を生成するモデルを開発しました。これらのモデルは、AIと創造的表現の融合における重要な進歩を示しています。 2023年3月のAIハイライト 2023年3月には、創造的なAIはいくつかの興味深い進展を見せました。AdobeはFireflyというAIをバックアップする画像生成および編集ツールの範囲でGenAIの領域に参入しました。一方、Canvaはユーザー向けにAIパワードの仮想デザインアシスタントとブランドマネージャーを導入しました。 テックジャイアンツのAIプロジェクトは、第1四半期終盤に向けて全力で進展していました。OpenAIはChatGPTとWhisperというテキストから音声へのモデルのためのAPIを発売しました。OpenAIはまた、ChatGPTのためのいくつかのプラグインをリリースし、最も高度なAIモデルであるGPT-4を正式に発表しました。 HubSpotはユーザー向けにChatSpot.aiとContent Assistantという2つの新しいAIパワードツールを導入しました。ZoomはスマートコンパニオンのZoom…

「ビジョン・トランスフォーマーの内部機能」

ビジョン・トランスフォーマー(ViTs)の内部動作を視覚化する際、研究者たちはランダムな背景パッチに注目の奇妙なスパイクを確認しましたここでは、それらを修正する方法を紹介します

「NVIDIAは創造的AIの台頭に対応するため、ロボティクスプラットフォームを拡大する」

強力な生成型AIモデルとクラウドネイティブのAPIおよびマイクロサービスがエッジに導入されています。 生成型AIは、トランスフォーマーモデルと大規模な言語モデルの力をほぼすべての業界にもたらしています。その範囲は、エッジ、ロボット、物流システムなどの領域にも及んでおり、欠陥検出、リアルタイム資産追跡、自律計画とナビゲーション、人間とロボットの相互作用などに活用されています。 NVIDIAは本日、エッジAIとロボティクスのためのNVIDIA Jetsonプラットフォーム上の2つのフレームワークを大幅に拡張しました。NVIDIA Isaac ROSロボティクスフレームワークが一般提供開始され、次にJetson上でのNVIDIA Metropolisの拡張が控えています。 AIアプリケーションの開発と展開をエッジで加速するために、NVIDIAは最新のオープンソース生成型AIモデルを利用するためのJetson生成型AIラボを開設しました。 Amazon Web Services、Cisco、John Deere、Medtronic、Pepsico、Siemensなど、120万人以上の開発者と1万以上の顧客がNVIDIA AIとJetsonプラットフォームを選んでいます。 急速に進化するAIの世界では、ますます複雑なシナリオに対応するため、開発者はエッジ向けのAIアプリケーションを構築するために長い開発サイクルに直面しています。環境、製造ライン、お客様の自動化ニーズの変化に対応するために、ロボットとAIシステムを素早く再プログラムすることは時間がかかり、専門的なスキルが必要です。 生成型AIは、トレーニング中に明示的に見たことのないものを特定するモデルのゼロショット学習を提供し、自然言語インターフェースによってエッジでのAIの開発、展開、管理を簡素化します。 AIの景色を変える 生成型AIは、ヒトの言語プロンプトを理解してモデルの変更を行うことで使いやすさを大幅に向上させます。これらのAIモデルは、検出、セグメンテーション、トラッキング、検索、さらには再プログラムなどにおいて、従来の畳み込みニューラルネットワークに基づくモデルを上回る柔軟性を持っています。 ABI Researchによると、生成型AIは2033年までに世界の製造業の収益に105億ドルを追加すると予測されています。 「生成型AIは、従来の方法では実現不可能であったよりも優れた汎化能力、使いやすさ、高い精度により、エッジでのAIの展開を大幅に加速させます」とNVIDIAのエンベデッド・エッジコンピューティング担当バイスプレジデントのDeepu Talla氏は述べています。「これはJetson上でMetropolisとIsaacのフレームワークの最大拡張ですが、トランスフォーマーモデルと生成型AIの力を組み合わせることで、このニーズに対応しています。」 エッジでの生成型AI開発 Jetson生成型AIラボでは、最適化されたツールとチュートリアルにアクセスして、オープンソースのLLMs、ディフュージョンモデルを展開するための支援を開発者に提供しています。それには、インタラクティブな見事な画像を生成するためのビジョン言語モデル(VLM)やビジョントランスフォーマー(ViTs)も含まれ、ビジョンAIと自然言語処理を組み合わせてシーンの包括的な理解が可能です。 開発者は、ViTやビジョン基盤モデルなどの基礎的なモデルのカスタマイズや微調整を行い、非常に少量のデータで高精度なビジョンAIモデルを作成することができる、NVIDIA…

「DINO — コンピュータビジョンのための基盤モデル」

「コンピュータビジョンにとっては、エキサイティングな10年です自然言語の分野での大成功がビジョンの領域にも移されており、ViT(ビジョントランスフォーマー)の導入などが含まれています...」(Konpyūta bijon ni totte wa, ekisaitinguna jūnen desu. Shizen gengo no bunya de no daiseikō ga bijon no ryōiki ni mo utsusarete ori, ViT…

BYOL(Bootstrap Your Own Latent)— コントラスティブな自己教示学習の代替手段

『今日の論文分析では、BYOL(Bootstrap Your Own Latent)の背後にある論文に詳しく触れますこれは、対比的な自己教師あり学習技術の代替手法を提供します...』

「AnyLocによる最新のビジュアル位置認識(VPR)の汎用方法について紹介します」

人工知能の分野は常に進化しており、ロボット工学などのさまざまな用途に取り入れられています。ビジュアルプレースリコグニション(VPR)は、ロボットの状態を推定するための重要なスキルであり、ウェアラブルテクノロジーやドローン、自動運転車両、地上ロボットなど、さまざまなロボットシステムで広く使用されています。VPRは、ビジュアルデータの利用により、ロボットが現在の位置や周囲の場所を認識し理解することを可能にします。 VPRの普遍的な応用を実現することは困難でした。現代のVPR手法は、都市の運転シナリオなど、学習に使用された環境と類似したコンテキストに適用された場合には良好な性能を発揮しますが、水中や空中などのさまざまな環境では効果が著しく低下します。普遍的なVPRソリューションを設計するための取り組みが行われており、これは航空、水中、地下などの環境を含め、いかなる環境でもエラーなく稼働し、昼夜や季節の変動などの変化に弾力的に対応し、直径に反対の視点を含む視点の変動にも影響を受けないようにすることを目指しています。 上記の制約に対処するために、研究者のグループはAnyLocという新しいベースラインのVPR手法を導入しました。チームは、VPR固有のトレーニングに単に依存するのではなく、大規模な事前学習モデルから取得したビジュアル特徴表現を調査しました。これらのモデルはもともとVPRのためにトレーニングされていませんが、包括的なVPRソリューションの基盤となる可能性がある豊富なビジュアル特徴を保持しています。 AnyLocの手法では、必要な不変性属性を持つ最適な基盤モデルとビジュアル特徴を慎重に選択します。不変性属性には、モデルが周囲の変化や視点の変化に対して特定のビジュアル品質を維持する能力が含まれます。一般的にVPRの文献で頻繁に使用されるローカル集約手法は、これらの属性と統合されます。位置認識に関するより教養のある結論を得るには、ローカル集約手法を使用して視覚入力の異なる領域からのデータを統合する必要があります。 AnyLocは、基盤モデルの豊富なビジュアル要素をローカル集約手法と融合させることで、さまざまな環境で非常に適応性があり有用なAnyLoc対応ロボットを実現します。AnyLocは、さまざまな環境、昼夜の時間、視点の変動を含む12つの異なるデータセットでシームレスに動作するVPRの新しいベースラインとして提案されています。 普遍的なVPRソリューション:AnyLocは、場所、時間、視点の変動を含む12つの異なるデータセットでシームレスに動作する新しいVPRのベースラインとして提案されています。 特徴-手法のシナジー:DINOv2などの自己教師付き特徴とVLADやGeMなどの非教師付き集約を組み合わせることで、オフシェルモデルからの単一画像特徴の直接使用よりも性能が向上します。 意味的特徴の特徴化:集約されたローカル特徴の意味的特性を分析することで、潜在空間で異なるドメインを明らかにし、VLADの語彙構築を向上させ、性能を向上させます。 堅牢な評価:チームは、昼夜の変動や反対の視点など、困難なVPR条件でさまざまなデータセット上でAnyLocを評価し、将来の普遍的なVPR研究のための強力なベースラインを設定しました。

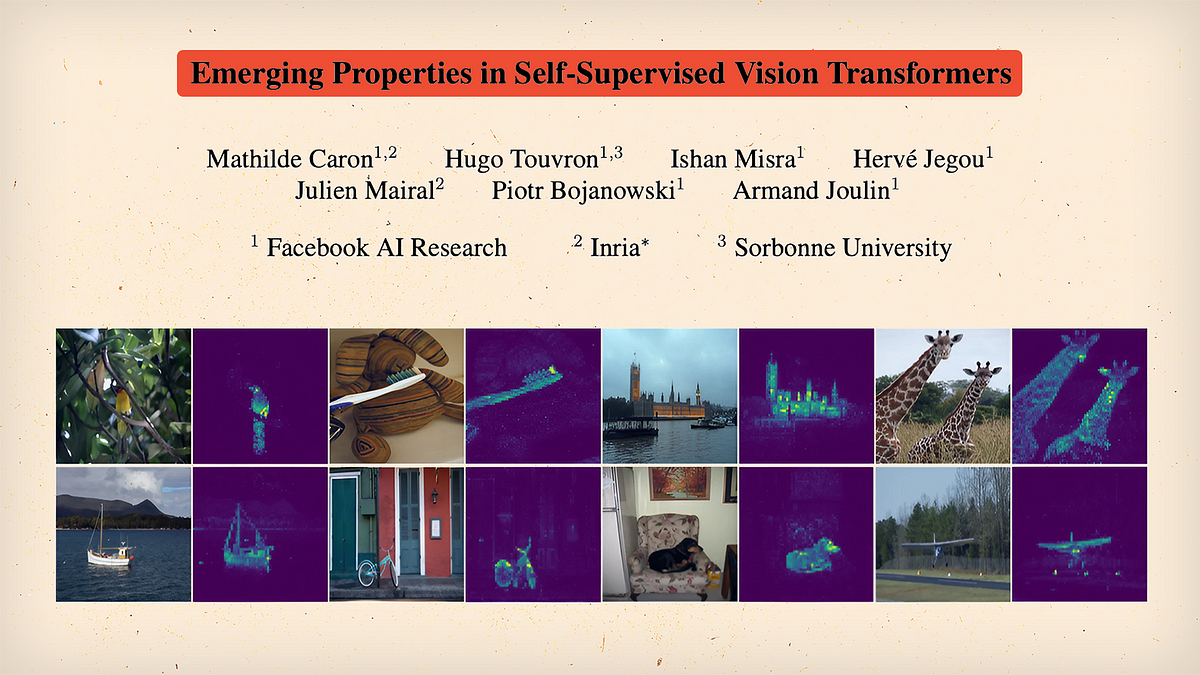

「自己教師あり学習とトランスフォーマー? – DINO論文の解説」

「一部の人々は、Transformerのアーキテクチャを愛し、それをコンピュータビジョンの領域に歓迎しています他の人々は、新しいプレイグラウンドに新しい子供がいることを受け入れたくありません さて、何が起こるのか見てみましょう...」

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.