Learn more about Search Results ConvNeXt

- You may be interested

- AIにおけるエキスパートの混合(MoE)モデ...

- MFAバイパス攻撃に対する懸念が高まってい...

- デルタテーブルの削除ベクトル:Databrick...

- マイクロソフトAIは、高度なマルチモーダ...

- 「本当に3億の仕事はAIによる置き換えでさ...

- 「シームレスM4Tに出会ってください:Meta...

- 「対数正規分布の簡単な説明」

- リアルタイムでスピーチを文字起こしする...

- 「Rasaパワードチャットボット:シームレ...

- 「PIXART-αに会ってください:画像生成の...

- ダブルマシンラーニングの簡素化:パート2...

- 日本の介護施設はビッグデータを活用して...

- 「AIパワード広告でソーシャルをより魅力...

- 「マイクロソフト、Windows上でのCortana...

- 「量子コンピューティングのアプローチ、...

このAIニュースレターは、あなたが必要とするすべてです#73

今週の会話は、再びOpenAIのDevdayの余波、新製品のリリース、そしてGPTStoreの将来の可能性についての推測で占められていましたすでに10,000以上のGPTが作成されています...

画像埋め込みのためのトップ10の事前訓練モデル、データサイエンティストが知っておくべきもの

「コンピュータビジョンの急速な進化– 画像分類のユースケースは、転移学習の台頭によってさらに加速されています大規模な画像データセットを使用してコンピュータビジョンニューラルネットワークモデルを訓練するには、多くの計算リソースと時間が必要です幸いなことに、この時間とリソースは…」

「ファイングレインド画像分類における背景誘発バイアスをどのように軽減できるか? マスキング戦略とモデルアーキテクチャの比較的研究」

細かい画像の分類は、広いカテゴリ内で密接に関連するサブクラスを区別することに取り組んでいます。例えば、単に画像を「鳥」として識別するのではなく、このアプローチでは特定の鳥の種を区別します。これらのタスクの複雑さにより、これらのモデルは頻繁に画像の背景から微細な情報を意図せずに頼りにすることがあります。背景情報は文脈的な手がかりを提供するかもしれませんが、バイアスを生成する可能性もあります。例えば、モデルが訓練中に都市の背景で頻繁に鳥を観察すると、すべての都市の背景をスズメと関連付ける可能性があります。より正確な結果のために背景によるバイアスを排除することは重要です。なぜなら、それはモデルの現実世界での適用範囲を制限する可能性があるからです。 細かい画像分類のための現代のアルゴリズムは、畳み込みニューラルネットワーク(CNN)やビジョン変換器(ViT)をその構造的な基盤として頼りにすることがよくあります。しかし、基本的な問題がまだ存在しています:オブジェクトが表示される文脈は、人間と機械に大きな影響を与える可能性があります。ディープラーニングモデルは、背景に意図せずに集中しすぎることがあり、場合によってはそれだけでカテゴリ分類を行うことがあります。これらのモデルは、異常な、見慣れない背景の状況で使用されると、性能の低下が著しくなります。 背景バイアスが引き起こす課題に対処するために、フランスのモンペリエ大学の研究チームによって最近発表された新しい研究では、主に2つの戦略を調査することが提案されました: 早期マスキング:画像のレベルで背景の詳細が最初から除去される方法。 後期マスキング:この方法では、モデル内のより高い、より抽象的な段階で背景に関連する特徴がマスクされます。 この研究の主要な貢献は、細かい画像分類における背景によるバイアスの徹底的な調査です。CNNやViTなどの高度なモデルがこれらのバイアスに直面した場合のパフォーマンスを注意深く分析し、それらに対処する創造的なマスキング技術を提供しています。 具体的には、早期マスキングでは、画像の入力段階で背景が除去されます。CNNやVision Transformersなどのモデルによる分類の前に、画像の背景領域はバイナリセグメンテーションネットワークを使用してマスクされ、モデルは主要なオブジェクトに集中するようになります。対照的に、後期マスキングでは、モデルは最初に全体の画像を処理しますが、より高度な段階で背景がマスクされます。主要なモデルのバックボーンが画像を処理した後、背景に関連する高レベルの空間特徴が選択的に除外されます。両方の方法は、モデルが関心の対象であるオブジェクトに焦点を当て、カテゴリ間の微妙な違いがある細かい分類における背景詳細から生じるバイアスを減らすことを目指しています。 研究者は、2つの戦略を評価するために実験を行いました。CUBデータセットを使用してモデルを実験的に訓練し、200種類の鳥の画像が含まれています。CUBテストセットとWaterbirdsデータセット、つまりCUB画像の背景がPlacesデータセットのものに変更された外部分布 (OOD) セットで、これらのモデルのパフォーマンスが評価されました。研究者は、ConvNeXtやViTなどのいくつかのモデルレイアウト、およびSmall、Base、Largeなどのモデルサイズを使用しました。その結果、早期マスキングで訓練されたモデルの方が、それを使用しないモデルよりも性能が向上することがよくありました、特にOOD Waterbirdsテストセットでは。これは、早期マスキングを使用することで、画像の背景によるバイアスが減少し、モデルの汎化性能が向上することを示しています。 結論として、著者はCNNとViTモデルの汎化性能に対する背景によるバイアスの影響を検証しました。さまざまな背景マスキング技術をテストし、早期マスキングが両方のモデルタイプにとって最も効果的であることがわかりました。この研究は、画像タスクにおける背景の考慮の重要性を強調し、バイアスを減らし、汎化性能を向上させる戦略を提案しています。

Fast.AIディープラーニングコースからの7つの教訓

「最近、Fast.AIのPractical Deep Learning Courseを修了しましたこれまでに多くの機械学習コースを受講してきましたので、比較することができますこのコースは間違いなく最も実践的でインスピレーションを受けるものの一つですですので…」

「セマンティックカーネルへのPythonistaのイントロ」

ChatGPTのリリース以来、大規模言語モデル(LLM)は産業界とメディアの両方で非常に注目されており、これによりLLMを活用しようとする前例のない需要が生まれました...

TF Servingを使用してHugging FaceでTensorFlow Visionモデルを展開する

過去数ヶ月間、Hugging Faceチームと外部の貢献者は、TransformersにさまざまなビジョンモデルをTensorFlowで追加しました。このリストは包括的に拡大しており、ビジョントランスフォーマー、マスク付きオートエンコーダー、RegNet、ConvNeXtなど、最先端の事前学習モデルがすでに含まれています! TensorFlowモデルを展開する際には、さまざまな選択肢があります。使用ケースに応じて、モデルをエンドポイントとして公開するか、アプリケーション自体にパッケージ化するかを選択できます。TensorFlowには、これらの異なるシナリオに対応するツールが用意されています。 この投稿では、TensorFlow Serving(TF Serving)を使用してローカルでビジョントランスフォーマーモデル(画像分類用)を展開する方法を紹介します。これにより、開発者はモデルをRESTエンドポイントまたはgRPCエンドポイントとして公開できます。さらに、TF Servingはモデルのウォームアップ、サーバーサイドバッチ処理など、多くの展開固有の機能を提供しています。 この投稿全体で示される完全な動作するコードを取得するには、冒頭に示されているColabノートブックを参照してください。 🤗 TransformersのすべてのTensorFlowモデルには、save_pretrained()というメソッドがあります。このメソッドを使用すると、モデルの重みをh5形式およびスタンドアロンのSavedModel形式でシリアライズできます。TF Servingでは、モデルをSavedModel形式で提供する必要があります。そこで、まずビジョントランスフォーマーモデルをロードして保存します。 from transformers import TFViTForImageClassification temp_model_dir = "vit" ckpt = "google/vit-base-patch16-224" model = TFViTForImageClassification.from_pretrained(ckpt)…

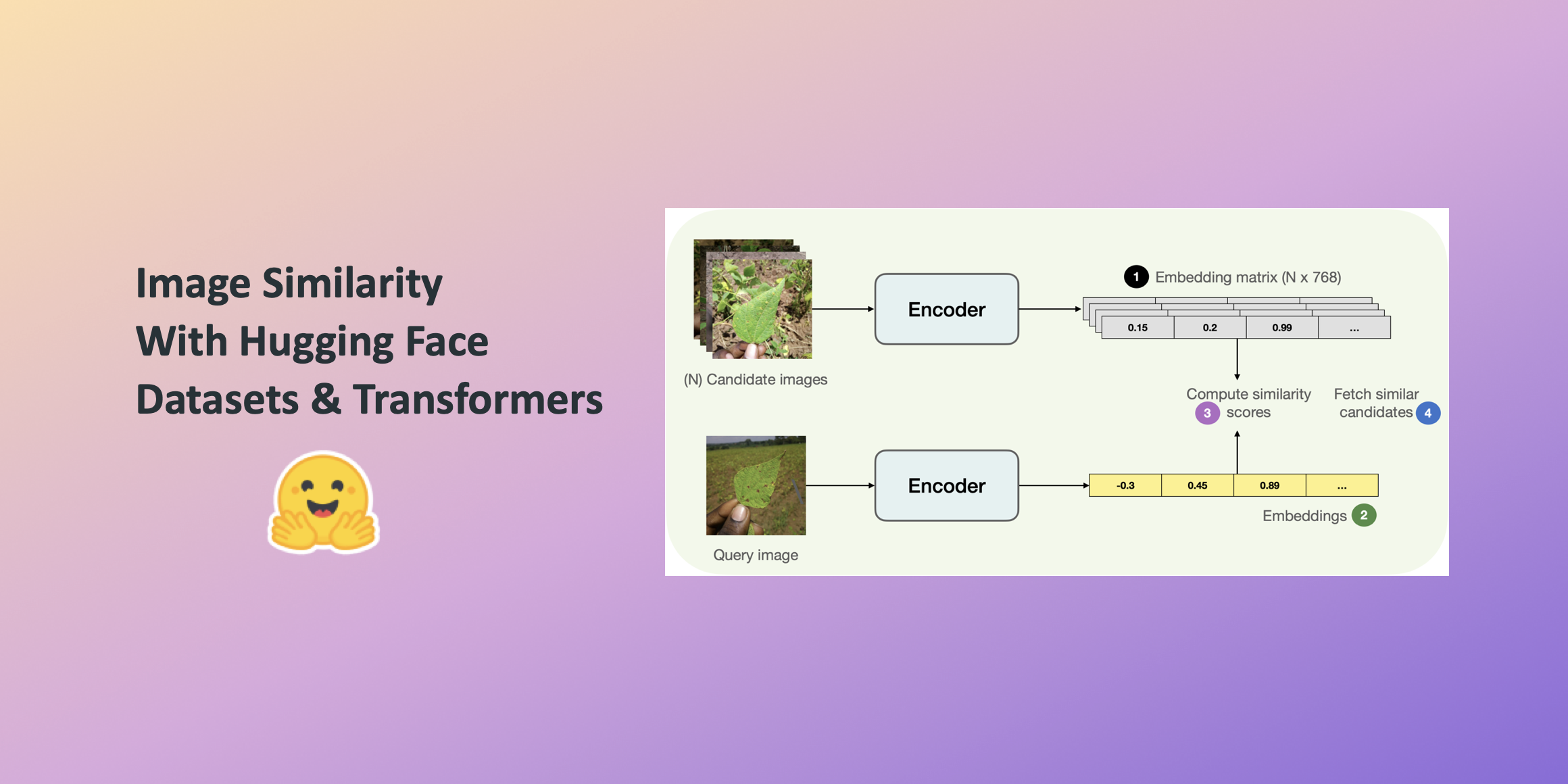

Hugging Faceデータセットとトランスフォーマーを使用した画像の類似性

この投稿では、🤗 Transformersを使用して画像の類似性システムを構築する方法を学びます。クエリ画像と候補画像の類似性を見つけることは、逆画像検索などの情報検索システムの重要なユースケースです。システムが答えようとしているのは、クエリ画像と候補画像セットが与えられた場合、どの画像がクエリ画像に最も類似しているかということです。 このシステムの構築には、このシステムの構築時に便利な並列処理をシームレスにサポートする🤗のdatasetsライブラリを活用します。 この投稿では、ViTベースのモデル( nateraw/vit-base-beans )と特定のデータセット(Beans)を使用していますが、ビジョンモダリティをサポートし、他の画像データセットを使用するために拡張することもできます。試してみることができるいくつかの注目すべきモデルには次のものがあります: Swin Transformer ConvNeXT RegNet また、投稿で紹介されているアプローチは、他のモダリティにも拡張できる可能性があります。 完全に動作する画像の類似性システムを学習するには、最初に2つの画像間の類似性をどのように定義するかを定義する必要があります。 このシステムを構築するためには、まず与えられた画像の密な表現(埋め込み)を計算し、その後、余弦類似性指標を使用して2つの画像の類似性を決定する一般的な方法があります。 この投稿では、画像をベクトル空間で表現するために「埋め込み」を使用します。これにより、画像の高次元ピクセル空間(たとえば224 x 224 x 3)を意味のある低次元空間(たとえば768)にうまく圧縮する方法が得られます。これによる主な利点は、後続のステップでの計算時間の削減です。 画像から埋め込みを計算するために、入力画像をベクトル空間で表現する方法について理解しているビジョンモデルを使用します。このタイプのモデルは画像エンコーダとも呼ばれます。 モデルをロードするために、AutoModelクラスを活用します。これにより、Hugging Face Hubから互換性のあるモデルチェックポイントをロードするためのインターフェースが提供されます。モデルと共に、データ前処理に関連するプロセッサもロードします。 from transformers…

ハギングフェイスにおけるコンピュータビジョンの状況 🤗

弊社の自慢は、コミュニティとともに人工知能の分野を民主化することです。その使命の一環として、私たちは過去1年間でコンピュータビジョンに注力し始めました。🤗 Transformersにビジョントランスフォーマー(ViT)を含めるというPRから始まったこの取り組みは、現在では8つの主要なビジョンタスク、3000以上のモデル、およびHugging Face Hub上の100以上のデータセットに成長しました。 ViTがHubに参加して以来、多くのエキサイティングな出来事がありました。このブログ記事では、コンピュータビジョンの持続的な進歩をサポートするために何が起こったのか、そして今後何がやってくるのかをまとめます。 以下は、カバーする内容のリストです: サポートされているビジョンタスクとパイプライン 独自のビジョンモデルのトレーニング timmとの統合 Diffusers サードパーティーライブラリのサポート デプロイメント その他多数! コミュニティの支援:一つずつのタスクを可能にする 👁 Hugging Face Hubは、次の単語予測、マスクの埋め込み、トークン分類、シーケンス分類など、さまざまなタスクのために10万以上のパブリックモデルを収容しています。現在、我々は8つの主要なビジョンタスクをサポートし、多くのモデルチェックポイントを提供しています: 画像分類 画像セグメンテーション (ゼロショット)オブジェクト検出 ビデオ分類 奥行き推定 画像から画像への合成…

PyTorchを使った転移学習の実践ガイド

この記事では、転移学習と呼ばれる技術を使用して、カスタム分類タスクに事前学習済みモデルを適応する方法を学びますPyTorchを使用した画像分類タスクで、Vgg16、ResNet50、およびResNet152の3つの事前学習済みモデルで転移学習を比較します

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.