Learn more about Search Results Claude

- You may be interested

- 「snowChat」とは何ですか?

- 「vLLMの解読:言語モデル推論をスーパー...

- テキストによる画像および3Dシーン編集の...

- 「ディープラーニングモデルのレイヤーを...

- 「あなたのLLM + Streamlitアプリケーショ...

- 「バイオニックハンドが女性の神経、骨、...

- 「グラフ彩色の魅力的な世界を探索する」

- ToolQAとは 外部ツールを使用した質問応答...

- TensorFlowを使用して責任あるAIを構築す...

- Amazon SageMaker StudioでAmazon SageMak...

- 自撮りがコミュニケーション手段としてど...

- 「目標を見据えて データプログラムの中心...

- 「ゼロからヒーローへ:AutoGenがLLMを変...

- テキスト読み上げ(TTS)とAIにおける倫理...

- Informerを使用した多変量確率時系列予測

「Anthropic Releases Claude 2.1:拡張されたコンテキストウィンドウと向上した精度でエンタープライズAIを革新する」

“` <img alt=”” src=”https://ai.miximages.com/www.marktechpost.com/wp-content/uploads/2023/11/Screenshot-2023-11-27-at-11.32.43-PM-1024×951.png”/><img alt=”” src=”https://ai.miximages.com/www.marktechpost.com/wp-content/uploads/2023/11/Screenshot-2023-11-27-at-11.32.43-PM-150×150.png”/> <p>様々なAIモデルが存在しますが、最近AnthropicによってリリースされたClaude 2.1は、いくつかの現在の問題に対処しています。これまでのモデルとは異なり、このモデルは驚異的な20万トークンのコンテキストウィンドウを持ち、広範な文書から情報を理解し記憶することができます。これにより他のモデルを上回り、誤った応答の発生可能性を低減させます。さらに、Claude 2.1は外部ツールの使用が可能であり、クエリの効果的な処理能力を向上させる多機能性を持っています。計算機のデータベースと統合し、ウェブ検索を行うこともでき、さまざまな分野に応用が広がります。</p> <p>Claude 2.1の注目すべき追加機能の1つは、システムプロンプトの実装です。この機能により、ユーザーはリクエストの特定の文脈を設定でき、モデルからより構造化された一貫性のある応答を得ることができます。コストはアクセス可能なものに設定されており、開発者やビジネスを含む多くのユーザーにとって実現可能です。しかし、ユーザーレビューは肯定的な意見と否定的な意見が混在していることを示しています。一部のユーザーは、特にチャットや要約などのタスクにおけるClaude 2.1の能力に感謝していますが、特定のコンテンツの扱いにおける重い検閲や制限に対して苛立ちを表明しています。</p> <p>このモデルは、特に一番上と一番下の文書内の事実を驚異的な能力で回想しました。しかし、文書の深さが増すにつれて、一番下のパフォーマンスが低下していきました。特に最上部と最下部のポイントはほぼ100%の正確さで回想されました。低いコンテキスト長でのパフォーマンスは保証されていないため、ユーザーは最適な使用方法が必要です。</p> <p>結論として、AnthropicのClaude 2.1は、AI言語モデルにおけるユーザーの課題への有望な解決策を提供しています。強化されたコンテキストウィンドウ、ツール活用能力、システムプロンプトを通じた構造化された応答を通じて、より信頼性の高い、多様性のある経験を提供することを目指しています。ユーザーフィードバックは肯定的な側面と否定的な側面を強調していますが、モデルのメトリックは広範な文書からの情報の回想能力を示しています。Claude 2.1のようなソリューションはユーザーの懸念を解消し、AIの相互作用の経験を向上させます。</p> <p>この記事は<a href=”https://www.voagi.com/amazon-to-invest-up-to-4-billion-into-ai-startup-anthropic.html”>Anthropic Releases Claude 2.1: Revolutionizing Enterprise AI…

この中国のAIモデル、Baichuan2-192kモデルはChatGPTやClaude2を超えることができるのか? 最長のコンテキストモデルを持つBaichuan Intelligentが公開した、この中国のスタートアップ「Baichuan Intelligent」のモデルに会いましょう

AIの優位性を争う中で、中国のAIスタートアップ、百川インテリジェントが最新の大容量言語モデル、百川2-192Kを発表し、長文プロンプトの処理において新たな基準を設定しました。この開発は、中国がグローバルなAIのランドスケープにおいて先駆者としての地位を確立する意気込みを示しています。 小説や法的文書、財務報告書など、大量のテキストプロンプトを扱うAIモデルへの需要が高まっています。従来のモデルは長文に苦戦することが多く、各業界でより強力で効率的な解決策が求められています。 現在、AIのランドスケープはOpenAIやMetaなどの西洋の巨大企業によって支配されており、彼らは絶えず革新的で洗練されたモデルをリリースしています。百川インテリジェントの新作、百川2-192Kは、これらの確立されたプレイヤーに挑戦します。 百川インテリジェントは、搜狗の創設者である王小川が起業した会社であり、画期的な大容量言語モデルである百川2-192Kを紹介しました。このモデルは、「コンテキストウィンドウ」という素晴らしい機能を搭載しており、一度に約35万文字の中国語の処理が可能です。比較すると、OpenAIのGPT-4-32kを14倍、AmazonがバックアップするAnthropicのClaude 2を4.4倍上回り、長文プロンプトの取り扱いに強力なツールとなっています。 百川2-192Kの主な革新点は、広範なテキストをシームレスに処理できる能力にあります。このモデルは小説の要約や品質の高い応答、長文の理解などに優れており、カリフォルニア大学バークレー校などの米国の機関が主導するプロジェクトであるLongEvalのテスト結果によって実証されています。このモデルの素晴らしいコンテキストの長さは、パフォーマンスを損なうことなく、動的な位置エンコーディングと分散トレーニングフレームワークの技術的な革新によって実現されています。百川2-192Kの優れた能力は、法律、メディア、金融などの産業において不可欠なツールとなっています。長文の処理および生成能力は、これらのセクターにおいて重要です。ただし、より多くの情報を処理できる能力が必ずしも他のモデルよりも優れているとは限らないことに留意することも重要です。これに関しては、スタンフォード大学とUCバークレーの共同研究でも指摘されています。 百川インテリジェントのAIセクターでの急速な台頭は、設立からわずか6か月でユニコーンクラブへの参加を果たすなど、中国がAI技術の可能性を広げることへの取り組みを示しています。現在、アメリカの企業がAIハードウェアとソフトウェアでリードを占めていますが、百川の積極的な戦略と技術革新は、AIの進化するランドスケープを示しています。百川2-192Kの発表は、AIの優位性を争う競争が終わりを告げたわけではなく、中国が西洋の巨大企業の支配に挑戦する意欲を示しています。百川2-192Kは、特に長文プロンプトの取り扱いにおいてAI技術の可能性の限界を押し上げる画期的なモデルです。その優れたコンテキストの長さと品質の高い応答は、さまざまな産業にとって貴重なツールとなります。

「Anthropicは、AIチャットボットプラットフォームのClaudeの有料サブスクリプションを導入します」

会話型AI産業において画期的な瞬間となり、人工知能のリーディング企業であるAnthropicが、最先端のチャットボットに有料のサブスクリプションプラン(Claude Pro)を導入しましたこの動向は、AIチャットボットセクターの変化する景色を浮き彫りにし、企業がデジタル提供物の価値を評価する方法についての洞察を提供します提供する旅程[…]

スタビリティAIは、StableChatを紹介します:ChatGPTやClaudeに似た会話型AIアシスタントの研究プレビュー

Stability AIは、Stable Chatというプラットフォームを導入しました。このプラットフォームは、ChatGPTの馴染みのある形式に非常に似ています。しかし、初期の評価の結果、この提供にはさらなる改善と強化が必要な箇所がいくつかあります。 Stable Chatが提供するインターフェースは、テキストベースの会話を行うことができ、ChatGPTの形式と非常に似通っています。しかし、この類似点にもかかわらず、プラットフォームには制約が存在します。特に、チャット履歴の機能と独立したチャットセッションを確立する能力が必要です。インターフェースを更新すると、会話データが失われるという不便な点があります。 この革新的なチャットインターフェースの中核には、Stability AIの最近リリースされたStable Belugaモデルがあります。オンラインでのコメントからは、このモデルがロシア語の単語を理解できる一方、その能力は、一貫した言語構造を構築するよりも個々の単語を認識する傾向があるという初期のフィードバックが示されています。 Belugaモデルとの対話によって、いくつかの重要な観察結果が明らかにされました: モデルは厳格な安全プロトコルに従っており、特定のタイプのコンテンツを生成する際には慎重さを示します。たとえば、最初はエロティックな内容を生成しないことが観察されています。 モデルのコンテンツ生成は多様性を示し、同じプロンプトを提示された場合でも異なる応答を提供します。この多様性は、モデル自体の裁量により、コンテンツの形式を変更することにも及びます。これには、情報をリストとして構造化したり、説明的な内容の段落を作成したり、単語のリストを特集したセクションを作成したりすることが含まれます。 言語スタイルに関しては、モデルは時折より一貫性を持つ必要があります。生成されたコンテンツのトーンや構造が変化する場合があり、改善の余地があることを示しています。 モデルの応答には、予測不可能性を導入するフレーズが時折含まれています。たとえば、ボードゲームに関連するクエリに対する応答として、「Peppermint drinker」、「Medusonki」、「Lamb cub」といったユニークな表現が生成されることがあります。 面白いことに、モデルは時々ユーザーに外部リソースを参照することを提案します。たとえば、特定のトピックの単語オプションを拡張するためにGoogle Translatorを使用することを提案することがあります。 注目すべき懸念の一つは、モデルの安定性と一貫性です。ユーザーは、チャットウィンドウ内での一時的な切断や一定時間のタイムアウトの報告を行っています。 確立されたChatGPTと比較すると、Stable Chat内にはさらなる改善の余地があることが明らかになります。Stability AIのリサーチプレビューは、約束を示し、独自のコンテンツ生成を提供していますが、時折一貫性に欠けることがあります。

アンソロピックは、以前のモデルと比べて、コーディング、数学、論理思考において大幅な改善を果たしたClaude 2モデルをリリースしました

Anthropicは、Claude 2という新しいモデルを発表しました。このモデルは、改善されたパフォーマンス、より長い応答時間、APIと公開ベータウェブサイトを通じたアクセシビリティを誇っています。ユーザーはClaudeの会話能力、明確な説明、有害な出力の生成確率の低減、前のモデルと比較してのメモリの改善に対して称賛しています。特に、Claude 2は、コーディング、数学、推論タスクにおいて優れたパフォーマンスを発揮しました。例えば、バー試験の多肢選択問題のセクションで76.5%のスコアを獲得し、前任者の73.0%を上回りました。大学院入学試験を受験する大学生と比較して、Claude 2はGREのリーディングとライティングの試験で90パーセンタイル以上の成績を収め、量的推論の試験では中央値の応募者と同等の成績を収めました。 開発者は、Claudeを友好的で熱心なバーチャルな同僚やパーソナルアシスタントと位置付け、さまざまなタスクをサポートするための自然言語の指示を理解する能力を持つ存在としています。ビジネス向けのClaude 2 APIは、先代モデルであるClaude 1.3と同じ価格で利用できます。また、アメリカとイギリスの個人は既にベータ版のチャット体験を利用することができます。 Claudeモデルのパフォーマンスと安全性の向上に努めています。入力と出力の長さが増え、ユーザーは最大100,000トークンまでのプロンプトを入力することができます。これにより、Claudeは広範な技術文書や書籍を処理し、メモ、手紙、物語など、数千のトークンから成る長い文書を生成することができます。 最新のモデルであるClaude 2は、コーディングスキルが大幅に向上しました。Codex HumanEval Pythonコーディングテストで71.2%のスコアを獲得し、前任者のClaude 1.3の56.0%を上回りました。GSM8kの数学問題セットでは、Claude 2は88.0%のスコアを獲得し、前任者の85.2%を上回りました。将来の計画には、Claude 2の能力向上を徐々に展開することが含まれています。 有害で攻撃的な出力を減少させるために、安全対策に注力しています。内部のレッドチーミング評価では、Claudeモデルを有害なプロンプトの代表的なセットに対して評価し、自動テストと手動のチェックを組み合わせています。Claude 2は、Claude 1.3と比較して無害な応答を提供する効果が2倍でした。望ましくない出力に完全に免疫を持つモデルは存在しませんが、安全技術と包括的なレッドチーミングは、出力の総合的な品質の向上に役立っています。 多くの企業がClaude APIを採用しており、JasperやSourcegraphなどのパートナーはClaude 2の機能を活用しています。ジャスパーは、多様なユースケース向けの最先端モデルとの互換性を強調し、長文、低遅延のアプリケーションにおける強みを強調しています。ソースグラフは、コーディングアシスタントのCodyにClaude 2の改善された推論能力を組み込み、ユーザーのクエリに対してより正確な回答を提供し、最大100,000のコンテキストウィンドウを通じてコードベースのコンテキストを伝えることができます。Claude 2の最新データでのトレーニングにより、Codyはより新しいフレームワークとライブラリに関する知識を備えており、開発者がソフトウェアをより効率的に構築することができます。…

「AnthropicがClaude 2を発表:コーディングを革新する次世代AIチャットプログラム」

人工知能スタートアップのAnthropicは、テックジャイアントのGoogleによるバックアップを受けて、人気のあるチャットプログラムであるClaudeを大幅に進化させました。最新のアップグレードである「Claude 2」は、コンピュータのコーディングと算術能力を向上させる最新技術を取り入れています。このブレイクスルーは、Claudeの初期ローンチからわずか数か月後に行われたものであり、OpenAI、Microsoft、Inflection AIなどの業界のリーダー企業がAIの分野で優位を得るために競い合っている激しい競争を浮き彫りにしています。 また読む: ChatGPTのコードインタープリター: 全てを知る 生成AIによる生産性の加速 Anthropicの生成AIは、コードの読み書きのタスクを迅速に進めることを約束しています。この先進技術を活用することで、Claude 2はブログ記事の作成や既存テキストの分析を容易に行い、コンテンツの創造に革命をもたらします。Anthropicを競合他社と差別化する要素は、システムが一度に最大75,000語の処理を行う驚異的な能力であり、AIが長文のビジネスドキュメントに効率的に取り組むことができます。この非凡な能力により、ユーザーは前例のない生産性の向上を実現することができます。 また読む: Google DeepMindがChatGPTを超えるアルゴリズムの開発に取り組む 安全性と規制への対応 AIの規制に関する懸念の増大は、世界中で高まる監視の目を引きました。著作権侵害や誤情報の拡散などの問題が業界内で警戒されています。Anthropicはこれらの課題に対応し、最近のアップグレードでClaudeの安全性評価を大幅に向上させました。同社は誇りを持って報告していますが、Claude 2はこの分野でのパフォーマンスを2倍に向上させ、AIによるコンテンツに関連する潜在的なリスクに対する強化されたセーフガードを提供しています。 また読む: ChatGPTが自己規制のための法律を制定 GPT-4でベンチマークを設定するOpenAI 多くの企業がAIの急速な発展に追いつこうと努力している中、OpenAIは革新の最前線に位置を維持しています。OpenAIの最新モデルであるGPT-4は、「マルチモーダル」の機能を導入することにより、AIを新たな高みに押し上げます。Claudeとは異なり、GPT-4はテキストに対応するだけでなく、人間が提供した画像を解釈して応答することもできます。この画期的な成果により、GPT-4は厳格なマルチステートバー試験で驚異的な75.7%のスコアを獲得し、米国の弁護士の資格を評価するために使用されるテストで高い評価を受けました。さらに、Claude 2はGPT-4よりも優れたコーディングスキルを持っています。 また読む: OpenAIがGPT-4へのアクセスを提供 Claude 2:…

Gorillaに会ってください:UCバークレーとMicrosoftのAPI拡張LLMは、GPT-4、Chat-GPT、およびClaudeを上回ります

モデルは、Torch Hub、TensorFlow Hub、およびHuggingFaceからのAPIによって拡張されています

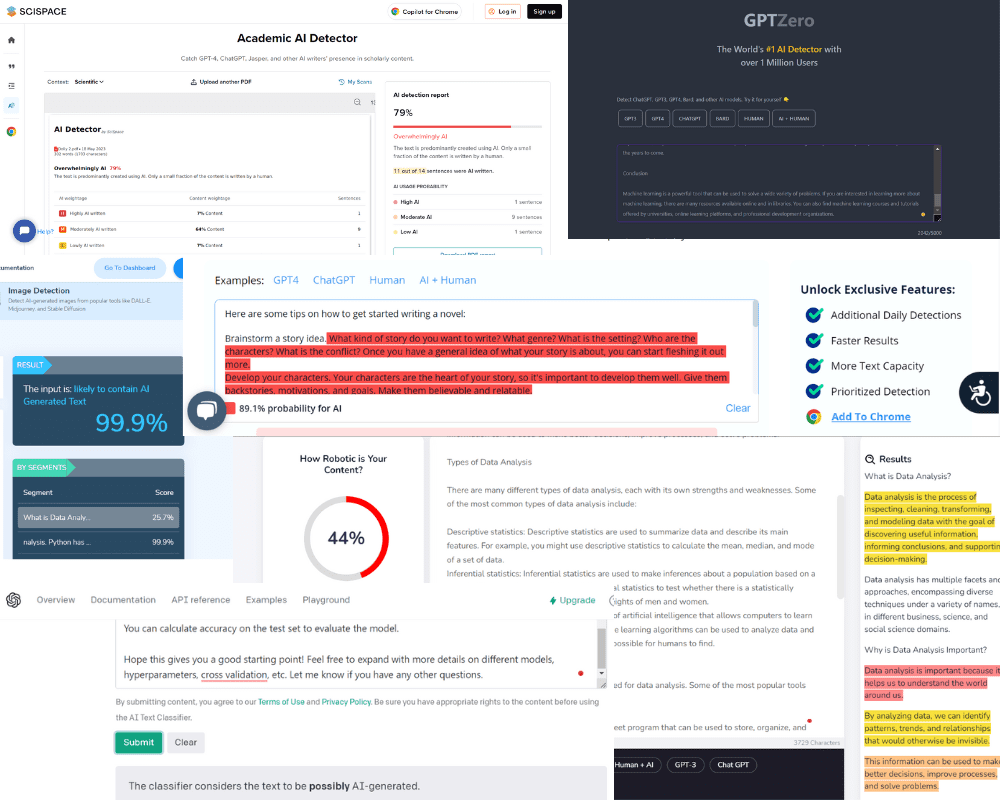

ChatGPT、GPT-4、Bard、およびClaudeを検出するためのトップ10ツール

AIモデルによって生成された論文、研究論文、課題、ドキュメンテーション、およびブログを検出するためのトップ無料ツール

「チャットボットの台頭:バカな機械からクリエイティブな共同作業者へ」

2023年は私たちにとって画期的な年となりましたロボットとのコミュニケーション、創造性、チームワーク、さらには操作術をマスターしたことで、私たちの能力が向上しました

「2023年、オープンLLMの年」

2023年には、大型言語モデル(Large Language Models、LLMs)への公衆の関心が急増しました。これにより、多くの人々がLLMsの定義と可能性を理解し始めたため、オープンソースとクローズドソースの議論も広範な聴衆に届くようになりました。Hugging Faceでは、オープンモデルに大いに興味を持っており、オープンモデルは研究の再現性を可能にし、コミュニティがAIモデルの開発に参加できるようにし、モデルのバイアスや制約をより簡単に評価できるようにし、チェックポイントの再利用によってフィールド全体の炭素排出量を低減するなど、多くの利点があります(その他の利点もあります)。 では、オープンLLMsの今年を振り返ってみましょう! 文章が長くなりすぎないようにするために、コードモデルには触れません。 Pretrained Large Language Modelの作り方 まず、大型言語モデルはどのようにして作られるのでしょうか?(もし既に知っている場合は、このセクションをスキップしてもかまいません) モデルのアーキテクチャ(コード)は、特定の実装と数学的な形状を示しています。モデルのすべてのパラメータと、それらが入力とどのように相互作用するかがリストとして表されます。現時点では、大部分の高性能なLLMsは「デコーダーのみ」トランスフォーマーアーキテクチャのバリエーションです(詳細は元のトランスフォーマーペーパーをご覧ください)。訓練データセットには、モデルが訓練された(つまり、パラメータが学習された)すべての例と文書が含まれています。したがって、具体的には学習されたパターンが含まれます。ほとんどの場合、これらの文書にはテキストが含まれており、自然言語(例:フランス語、英語、中国語)、プログラミング言語(例:Python、C)またはテキストとして表現できる構造化データ(例:MarkdownやLaTeXの表、方程式など)のいずれかです。トークナイザは、訓練データセットからテキストを数値に変換する方法を定義します(モデルは数学的な関数であり、したがって入力として数値が必要です)。トークン化は、テキストを「トークン」と呼ばれるサブユニットに変換することによって行われます(トークン化方法によっては単語、サブワード、または文字になる場合があります)。トークナイザの語彙サイズは、トークナイザが知っている異なるトークンの数を示しますが、一般的には32kから200kの間です。データセットのサイズは、これらの個々の「原子論的」単位のシーケンスに分割された後のトークンの数としてよく測定されます。最近のデータセットのサイズは、数千億から数兆のトークンに及ぶことがあります!訓練ハイパーパラメータは、モデルの訓練方法を定義します。新しい例ごとにパラメータをどれだけ変更すべきですか?モデルの更新速度はどのくらいですか? これらのパラメータが選択されたら、モデルを訓練するためには1)大量の計算パワーが必要であり、2)有能な(そして優しい)人々が訓練を実行し監視する必要があります。訓練自体は、アーキテクチャのインスタンス化(訓練用のハードウェア上での行列の作成)および上記のハイパーパラメータを使用して訓練データセット上の訓練アルゴリズムの実行からなります。その結果、モデルの重みが得られます。これらは学習後のモデルパラメータであり、オープンな事前学習モデルへのアクセスに関して多くの人々が話す内容です。これらの重みは、推論(つまり、新しい入力の予測やテキストの生成など)に使用することができます。 事前学習済みLLMsは、重みが公開されると特定のタスクに特化または適応することもあります。それらは、「ファインチューニング」と呼ばれるプロセスを介して、ユースケースやアプリケーションの出発点として使用されます。ファインチューニングでは、異なる(通常はより専門化された小規模な)データセット上でモデルに追加の訓練ステップを適用して、特定のアプリケーションに最適化します。このステップには、計算パワーのコストがかかりますが、モデルをゼロから訓練するよりも財政的および環境的にはるかにコストがかかりません。これは、高品質のオープンソースの事前学習モデルが非常に興味深い理由の一つです。コミュニティが限られたコンピューティング予算しか利用できない場合でも、自由に使用し、拡張することができます。 2022年 – サイズの競争からデータの競争へ 2023年以前、コミュニティで利用可能だったオープンモデルはありましたか? 2022年初頭まで、機械学習のトレンドは、モデルが大きければ(つまり、パラメータが多ければ)、性能が良くなるというものでした。特に、特定のサイズの閾値を超えるモデルは能力が向上するという考えがあり、これらの概念はemergent abilitiesとscaling lawsと呼ばれました。2022年に公開されたオープンソースの事前学習モデルは、主にこのパラダイムに従っていました。 BLOOM(BigScience Large Open-science…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.