Learn more about Search Results AI red teaming

- You may be interested

- ケンブリッジの研究者たちは、マシンラー...

- 合成データ生成のマスタリング:応用とベ...

- 「LangChainを使用したLLMアプリケーショ...

- 事前学習済みのViTモデルを使用した画像キ...

- 人間の嗅覚とAIが匂いの命名で競い合う

- 「Phindの新しいAIモデルは、コーディング...

- 開発者と企業は、Gemini Proで構築する時です

- 「データサイエンスのワークフローをマス...

- Amazon SageMakerを使用してモデルの精度...

- なぜすべての企業がAI画像生成器を使用す...

- シャム・ボージワニは、自動化、デジタル...

- 「SMPLitexに会ってください:単一画像か...

- 「PythonでゼロからGANモデルを構築および...

- 「GPT-4はこの戦いで449対28で敗北した」

- CoDiに会おう:任意対任意合成のための新...

「安全で安心なAIに対する取り組みに基づいて行動する」

「ジェネラティブAIに特化した私たちのバグバウンティプログラムのニュースと、AIの供給チェーンに対するオープンソースセキュリティのサポートについて」

「GoogleのAI Red Team:AIを安全にするための倫理的なハッカー」

先月、私たちはSecure AI Framework(SAIF)を紹介しましたこれは、AIシステムへのリスクに対処し、技術のセキュリティ基準を責任ある方法で推進するために設計されていますこの勢いに乗るために、本日は、SAIFをサポートするために展開する重要な機能の1つであるレッドチーミングについて新しい報告書を公開していますレッドチーミングは、AIシステムへの攻撃に備えるために、すべての組織に対して決定的な役割を果たすと考えており、皆さんが安全にAIを利用できるように協力することを楽しみにしていますこの報告書では、専用のAIレッドチームを立ち上げるための私たちの取り組みについて調査しており、次の3つの重要な領域を含んでいます:1)AIシステムの文脈でのレッドチーミングとは何か、なぜ重要か、2)AIレッドチームがシミュレートする攻撃の種類、3)他の人々と共有できる学んだ教訓レッドチーミングとは何か?Google Red Teamは、さまざまな敵対者(国家、有名な高度な持続的脅威(APT)グループ、ハクティビスト、個々の犯罪者、悪意のある内部者など)をシミュレートするハッカーチームですこの用語は軍から来ており、一つのチームが敵対的な役割(「レッドチーム」)を果たし、「ホーム」チームに対抗する活動を指しています

倫理と社会ニュースレター#4:テキストから画像へのモデルにおけるバイアス

要約: テキストから画像へのモデルのバイアスを評価するためにより良い方法が必要です はじめに テキストから画像(TTI)生成は最近のトレンドであり、数千のTTIモデルがHugging Face Hubにアップロードされています。各モダリティは異なるバイアスの影響を受ける可能性がありますが、これらのモデルのバイアスをどのように明らかにするのでしょうか?このブログ投稿では、TTIシステムのバイアスの源泉、それらに対処するためのツールと潜在的な解決策について、私たち自身のプロジェクトと広範なコミュニティのものを紹介します。 画像生成における価値観とバイアスのエンコード バイアスと価値観には非常に密接な関係があります。特に、これらが与えられたテキストから画像モデルのトレーニングやクエリに埋め込まれている場合、この現象は生成された画像に大きな影響を与えます。この関係は、広範なAI研究分野で知られており、それに対処するためのかなりの努力が進行中ですが、特定のモデルで進化する人々の価値観を表現しようとする複雑さは依然として存在しています。これは、適切に明らかにし、対処するための持続的な倫理的な課題を提起します。 たとえば、トレーニングデータが主に英語である場合、それはおそらく西洋の価値観を伝えています。その結果、異なる文化や遠い文化のステレオタイプな表現が得られます。以下の例では、同じプロンプト「北京の家」に対してERNIE ViLG(左)とStable Diffusion v 2.1(右)の結果を比較すると、この現象が顕著に現れます: バイアスの源泉 近年、自然言語処理(Abidら、2021年)およびコンピュータビジョン(BuolamwiniおよびGebru、2018年)の両方の単一モダリティのAIシステムにおけるバイアス検出に関する重要な研究が行われています。MLモデルは人々によって構築されるため、すべてのMLモデル(そして技術全般)にはバイアスが存在します。これは、画像の中で特定の視覚的特性が過剰または過少に表現される(たとえば、オフィスワーカーのすべての画像にネクタイがある)ことや、文化的および地理的なステレオタイプの存在(たとえば、白いドレスとベールを着た花嫁のすべての画像、代表的な花嫁のイメージである赤いサリーの花嫁など)が現れることで現れます。AIシステムは広く異なるセクターやツール(例:Firefly、Shutterstock)に展開される社会技術的なコンテキストで展開されるため、既存の社会的なバイアスや不平等を強化する可能性があります。以下にバイアスの源泉の非徹底的なリストを示します: トレーニングデータのバイアス:テキストから画像への変換のための人気のあるマルチモーダルデータセット(たとえば、テキストから画像へのLAION-5B、画像キャプショニングのMS-COCO、ビジュアルクエスチョンアンサリングのVQA v2.0など)には、多数のバイアスや有害な関連が含まれていることが判明しています(Zhaoら、2017年、PrabhuおよびBirhane、2021年、Hirotaら、2022年)。これらのデータセットでトレーニングされたモデルには、画像生成の多様性の欠如や、文化やアイデンティティグループの共通のステレオタイプが永続化するという初期の結果がHugging Face Stable Biasプロジェクトから示されています。たとえば、CEO(右)とマネージャー(左)のDall-E 2の生成結果を比較すると、両方とも多様性に欠けていることがわかります: 事前トレーニングデータのフィルタリングにおけるバイアス:モデルのトレーニングに使用される前に、データセットに対して何らかの形のフィルタリングが行われることがよくあります。これにより、異なるバイアスが導入されます。たとえば、Dall-E 2の作者たちは、トレーニングデータのフィルタリングが実際にバイアスを増幅することを発見しました。これは、既存のデータセットが女性をより性的な文脈で表現するというバイアスや、使用されるフィルタリング手法の固有のバイアスに起因する可能性があると彼らは仮説を立てています。 推論におけるバイアス:Stable…

衝撃的な現実:ChatGPTのデータ漏洩への脆弱性

最近の研究論文「ChatGPTからのトレーニングデータの抽出」は、広く使用されている言語モデルの驚くべき脆弱性を明らかにしました。研究者チームが行ったこの研究によると、わずか200ドルでChatGPTのトレーニングデータを数メガバイト抽出することが可能であり、前例のない規模のデータ漏洩の可能性を暴露しています。 この研究は、ChatGPTなどの自然言語理解に設計された言語モデルが、公開インターネットから取得したデータを使用してトレーニングされていることを強調しています。この論文では、モデルにクエリを送ることで、トレーニングに使用された正確なデータを抽出する攻撃手法を明らかにしています。驚くべきことに、研究者たちは追加の財政投資により、ChatGPTのトレーニングデータセットを最大1ギガバイト抽出することが可能であると推定しています。 このデータ漏洩は重大であり、実用化モデルの「対応性」を対象としており、大量の訓練データが公開されることを避けるために設計されています。しかし、研究者たちは、開発された攻撃によって、モデルに重要な量のトレーニングデータを漏洩させることが可能であることを示しています。 トレーニングデータの抽出攻撃とその重要性 この暴露の背後にいる研究チームは、数年にわたり「トレーニングデータの抽出」に焦点を当てたプロジェクトに関与してきました。トレーニングデータの抽出は、ChatGPTなどの機械学習モデルが、そのトレーニングデータのランダムな側面を保持しており、攻撃を介して抽出される脆弱性がある場合に発生します。この論文では、生産中の「対応性のある」モデルであるChatGPTに対するトレーニングデータの抽出攻撃を初めて明らかにしています。この画像では、メールアドレスと連絡先情報が共有されていることがわかります。 この脆弱性の影響は広範であり、特に機密性の高いまたは独自のデータを持つ人々にとって重要です。データ漏洩の懸念を超えて、この論文は、モデルがトレーニングデータを記憶し、再現するリスクを強調しています。これはオリジナリティに依存する製品にとって重要な要素です。 ChatGPTからのデータの抽出 この研究は、ChatGPTからのトレーニングデータの抽出に成功した証拠を示しています。ただし、モデルはチャットAPIを介してのみアクセス可能であり、データの抽出に対抗するために正確に整列している可能性があります。この攻撃は、プライバシーガードを迂回する脆弱性を特定し、ChatGPTをファインチューニングの整列から逸脱させ、事前トレーニングデータに戻すことができるようにしました。 研究チームは、ChatGPTの整列が記憶の隠蔽を行っており、特定の攻撃に対して促された時のデータの発射頻度の著しい増加を示しています。このモデルは、見かけによらず、従来の攻撃方法よりも150倍も高い記憶能力を示しています。 テストとレッドチーミングモデルへの影響 この論文は、ChatGPTの広範な使用について懸念を呼び起こしました。ChatGPTは既に10億人時間以上の相互作用がありますが、データ発射の頻度の高さは気付かれていませんでした。言語モデルの潜在的な脆弱性と、安全なモデルと見かけ上の安全なモデルの区別が困難な課題が存在します。 既存の記憶力テスト技術は、整列手順によって記憶能力を隠蔽してしまうため、ChatGPTの記憶能力を明らかにするためには不十分です。これは、言語モデルの安全性を確保するために、強化されたテスト手法の必要性を強調しています。 また、こちらも読んでみてください:プライバシーの懸念に対処する方法:ChatGPTユーザーチャットタイトルの漏洩の解説 私たちの意見 ChatGPTのデータ漏洩の脆弱性の公開は、機械学習モデルの進化するセキュリティ分析を強調しています。これらのシステムの安全性を確保するためには、さらなる研究が必要です。現代のテクノロジー駆動の時代において、ChatGPTのデータ漏洩への脆弱性は、高度な言語モデルを保護する上での課題を鮮明に示しています。

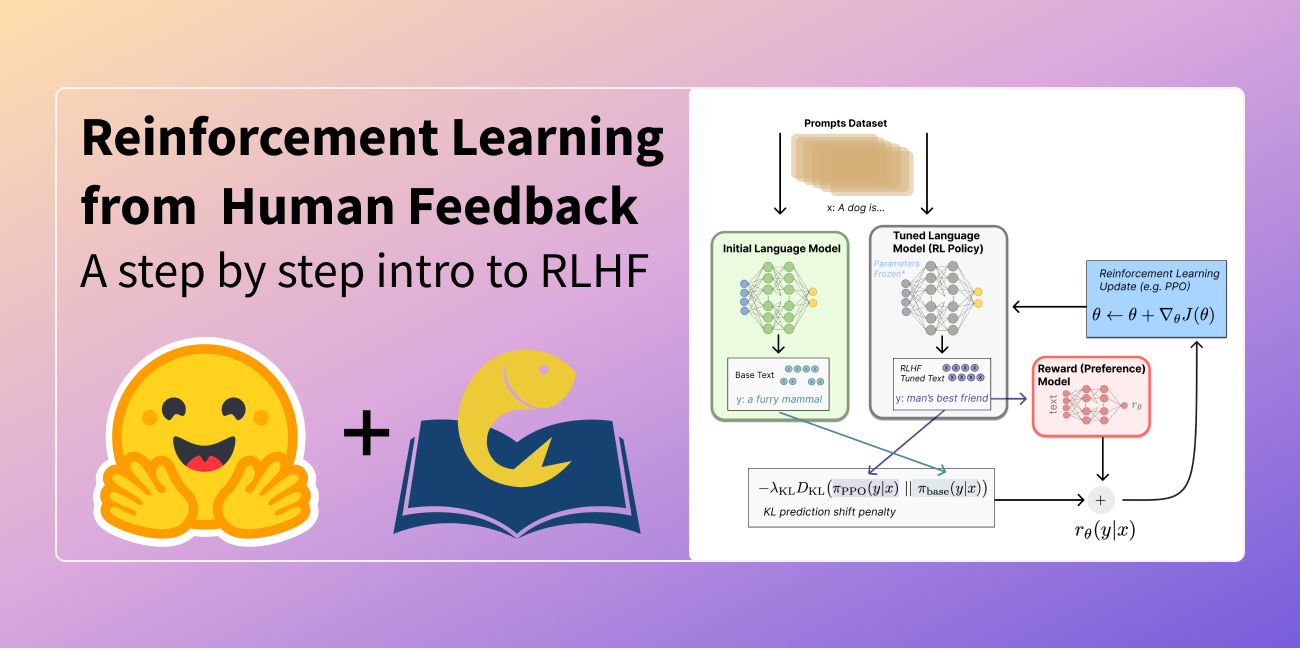

人間のフィードバックからの強化学習(RLHF)の説明

この記事は以下の言語に翻訳されています:中国語(簡体字)とベトナム語。他の言語に翻訳に興味がありますか?nathan at huggingface.co までお問い合わせください。 言語モデルは、過去数年間に人間の入力プロンプトから多様で魅力的なテキストを生成する能力を示してきました。しかし、「良い」テキストとは何かは、主観的で文脈に依存するため、本質的に定義するのは難しいです。創造性を求める物語の執筆などの多くのアプリケーションでは、真実であるべき情報の断片、または実行可能なコードのスニペットなどが必要です。 これらの属性を捉えるための損失関数を作成することは困難であり、ほとんどの言語モデルはまだ単純な次のトークン予測の損失(例:クロスエントロピー)で訓練されています。損失自体の欠点を補うために、人々はBLEUやROUGEなど、人間の優先順位をより適切に捉えるように設計されたメトリクスを定義しています。これらのメトリクスは、パフォーマンスを測定する上で損失関数自体より適しているものの、生成されたテキストを単純なルールで参照テキストと比較するだけなので、制約もあります。生成されたテキストに対する人間のフィードバックをパフォーマンスの指標として使用するか、さらに進んでそのフィードバックを損失としてモデルを最適化することができれば、素晴らしいことではないでしょうか?それが「人間のフィードバックによる強化学習(RLHF)」のアイデアです。強化学習の手法を使用して、言語モデルを人間のフィードバックで直接最適化するのです。RLHFにより、言語モデルは一般的なテキストデータのコーパスで訓練されたモデルを複雑な人間の価値に合わせることができるようになりました。 RLHFの最近の成功例は、ChatGPTでの使用です。ChatGPTの印象的な能力を考慮して、RLHFについて説明してもらいました: それは驚くほどうまくいっていますが、すべてをカバーしているわけではありません。それらのギャップを埋めましょう! 人間のフィードバックによる強化学習(RL from human preferencesとも呼ばれます)は、複数のモデルのトレーニングプロセスと異なる展開の段階を伴うため、難しい概念です。このブログ記事では、トレーニングプロセスを次の3つの主要なステップに分解します: 言語モデル(LM)の事前トレーニング データの収集と報酬モデルのトレーニング 強化学習によるLMの微調整 まず、言語モデルの事前トレーニングについて見ていきましょう。 言語モデルの事前トレーニング RLHFの出発点として、クラシカルな事前トレーニング目標で既に事前トレーニングされた言語モデルを使用します(詳細については、このブログ記事を参照してください)。OpenAIは、最初の人気のあるRLHFモデルであるInstructGPTに対して、より小さなバージョンのGPT-3を使用しました。Anthropicは、このタスクのためにトレーニングされた1,000万から520億のパラメータを持つトランスフォーマーモデルを使用しました。DeepMindは、2800億のパラメータモデルGopherを使用しました。 この初期モデルは、追加のテキストや条件で微調整することもできますが、必ずしも必要ではありません。たとえば、OpenAIは「好ましい」とされる人間が生成したテキストを微調整し、Anthropicは彼らの「助けになり、正直で無害な」基準に基づいて元のLMを蒸留することで、RLHFのための初期LMを生成しました。これらは共に、私が高価な増強データと呼ぶものの一部ですが、RLHFを理解するために必要なテクニックではありません。 一般的に、「どのモデル」がRLHFの出発点として最適かは明確な答えがありません。このブログ記事では、RLHFのトレーニングにおけるオプションの設計空間が完全に探索されていないという共通のテーマになります。 次に、言語モデルが必要なデータを生成して、人間の優先順位がシステムに統合される「報酬モデル」をトレーニングする必要があります。 報酬モデルのトレーニング 人間の優先順位に合わせてキャリブレーションされた報酬モデル(RM、優先モデルとも呼ばれます)を生成することは、RLHFの比較的新しい研究の出発点です。その基本的な目標は、テキストのシーケンスを受け取り、数値で人間の優先順位を表すべきスカラー報酬を返すモデルまたはシステムを取得することです。システムはエンドツーエンドのLMであるか、報酬を出力するモジュラーシステム(例:モデルが出力をランク付けし、ランキングが報酬に変換される)である場合があります。出力がスカラーの報酬であることは、既存のRLアルゴリズムが後のRLHFプロセスにシームレスに統合されるために重要です。 報酬モデリングのためのこれらの言語モデルは、別の微調整された言語モデルまたは好みのデータでスクラッチからトレーニングされた言語モデルのいずれかです。例えば、Anthropicは、これらのモデルを事前トレーニング(好みモデルの事前トレーニング、PMP)の後に初期化するために専門の微調整方法を使用しています。彼らは、これが微調整よりもサンプル効率が高いと結論付けましたが、報酬モデリングのバリエーションの中で明確な最良の選択肢はありません。…

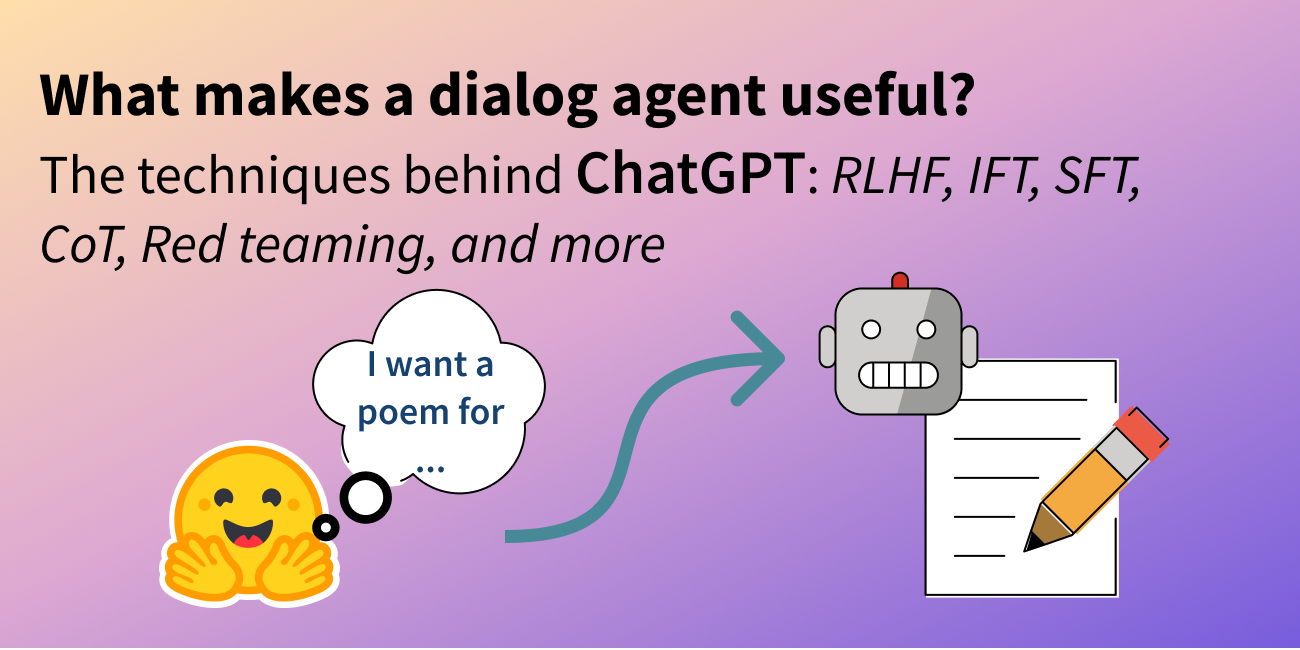

どのような要素が対話エージェントを有用にするのか?

ChatGPTの技術:RLHF、IFT、CoT、レッドチーミング、およびその他 この記事は、中国語の簡体字で翻訳されています。 数週間前、ChatGPTが登場し、一連の不明瞭な頭字語(RLHF、SFT、IFT、CoTなど)が公衆の議論を巻き起こしました。これらの不明瞭な頭字語は何であり、なぜそれらが重要なのでしょうか?私たちはこれらのトピックに関する重要な論文を調査し、これらの作品を分類し、達成された成果からの要点をまとめ、まだ示されていないことを共有します。 まず、言語モデルに基づく会話エージェントの現状を見てみましょう。ChatGPTは最初ではありません。実際、OpenAIよりも前に、MetaのBlenderBot、GoogleのLaMDA、DeepMindのSparrow、およびAnthropicのAssistant(このエージェントの完璧な帰属なしでの継続的な開発はClaudeとも呼ばれています)など、多くの組織が言語モデルの対話エージェントを公開しています。一部のグループは、オープンソースのチャットボットを構築する計画を発表し、ロードマップを公開しています(LAIONのOpen Assistant)。他のグループも確実に同様の作業を進めており、まだ発表していないでしょう。 以下の表は、これらのAIチャットボットを公開アクセス、トレーニングデータ、モデルアーキテクチャ、および評価方向の詳細に基づいて比較しています。ChatGPTには文書化された情報がないため、代わりにChatGPTの基礎となったと信じられているOpenAIの指示fine-tunedモデルであるInstructGPTの詳細を共有します。 トレーニングデータ、モデル、およびファインチューニングには多くの違いがあることが観察されますが、共通点もあります。これらのチャットボットの共通の目標は、ユーザーの指示に従うことです。たとえば、ChatGPTに詩を書くように指示することなどです。 予測テキストから指示の従属へ 通常、ベースモデルの言語モデリング目標だけでは、モデルがユーザーの指示に対して有益な方法で従うことを学ぶには十分ではありません。モデル開発者は、指示の細かいチューニング(IFT)を使用して、ベースモデルを、感情、テキスト分類、要約などの古典的なNLPタスクのデモンストレーションによって微調整し、非常に多様なタスクセットにおける指示の書かれた方針を学びます。これらの指示のデモンストレーションは、指示、入力、および出力の3つの主要なコンポーネントで構成されています。入力はオプションです。一部のタスクでは、ChatGPTの例のように指示のみが必要です。入力と出力が存在する場合、インスタンスが形成されます。特定の指示に対して複数の入力と出力が存在する場合もあります。以下に[Wang et al.、’22]からの例を示します。 IFTのデータは通常、人間によって書かれた指示と言語モデルを用いた指示のインスタンスのコレクションからなります。ブートストラップのために、LMは(上記の図のように)いくつかの例を使用してフューショット設定でプロンプトされ、新しい指示、入力、および出力を生成するように指示されます。各ラウンドで、モデルは人間によって選択されたサンプルとモデルによって生成されたサンプルの両方からプロンプトを受け取ります。データセットの作成における人間とモデルの貢献の割合はスペクトラムです。以下の図を参照してください。 一方は完全にモデル生成されたIFTデータセットであり、例えばUnnatural Instructions(Honovich et al.、’22)です。もう一方は手作りの指示の大規模な共同作業であり、Super-natural instructions(Wang et al.、’22)などです。これらの間には、Self-instruct(Wang et al.、’22)のような、高品質のシードデータセットを使用してブートストラップする方法もあります。IFTのデータセットを収集するもう1つの方法は、さまざまなタスク(プロンプトを含む)の既存の高品質なクラウドソーシングNLPデータセットを統一スキーマや多様なテンプレートを使用して指示としてキャストすることです。この研究の一環には、T0(Sanh et al.、’22)、自然言語指示データセット(Mishra et…

大規模な言語モデルによるレッドチーミング

警告: この記事はレッドチーミングについてであり、そのためモデル生成の例が不快または不快なものである可能性があります。 大量のテキストデータで訓練された大規模な言語モデル(LLM)は、現実的なテキストを生成するのに非常に優れています。しかし、これらのモデルは、個人情報(社会保障番号など)の公開や誤情報、偏見、憎悪、有害なコンテンツの生成など、望ましくない振る舞いをしばしば示します。たとえば、GPT3の以前のバージョンは、性差別的な振る舞い(以下参照)やムスリムに対する偏見を示すことが知られていました。 LLMを使用する際にこのような望ましくない結果を発見した場合、Generative Discriminator Guided Sequence Generation(GeDi)やPlug and Play Language Models(PPLM)などの戦略を開発してそれらからそれを逸らすことができます。以下は、同じプロンプトを使用してGPT3の生成を制御するためにGeDiを使用した例です。 最近のGPT3のバージョンでも、プロンプトインジェクションによる攻撃を受けると同様に不快なテキストが生成され、その結果、下流のアプリケーションのセキュリティ上の懸念となる可能性があります。このブログで説明されています。 レッドチーミングは、望ましくない振る舞いを引き起こす可能性のあるモデルの脆弱性を引き出す評価の形式です。ジェイルブレイキングは、LLMがそのガードレールから逸脱するように操作されるレッドチーミングの別の言葉です。MicrosoftのチャットボットTay(2016年)やより最近のBingのチャットボットシドニーは、レッドチーミングを使用して基礎となるMLモデルの徹底的な評価の欠如がどれほど壊滅的な結果をもたらすかの実際の例です。レッドチームのアイデアの起源は、軍隊によって実施された対抗者シミュレーションやウォーゲームに遡ることができます。 レッドチーミングの目標は、モデルが有害なテキストを生成する可能性が高いテキストを生成するようにするプロンプトを作成することです。レッドチーミングは、MLのより一般的に知られた評価形式である敵対的攻撃といくつかの類似点と相違点を共有しています。その類似点は、レッドチーミングと敵対的攻撃が実際のユースケースで望ましくないコンテンツを生成するためにモデルを「攻撃」または「だます」という共通の目標を持っていることです。ただし、敵対的攻撃は人間には理解しにくい場合があります。たとえば、各プロンプトに「aaabbbcc」という文字列を接頭辞として付けると、モデルのパフォーマンスが低下するためです。Wallace et al.、’19では、さまざまなNLP分類および生成タスクにおけるそのような攻撃の多くの例が議論されています。一方、レッドチーミングのプロンプトは通常、通常の自然言語のプロンプトと似ています。 レッドチーミングは、ユーザーの不快な体験を引き起こしたり、悪意を持つユーザーによる暴力やその他の違法な活動を支援する可能性があるモデルの制限を明らかにすることができます。レッドチーミングからの出力(敵対的攻撃と同様)は、一般にモデルを訓練して、有害な結果を引き起こす可能性を低くするか、またはそれから逸らすために使用されます。 レッドチーミングは、可能なモデルの障害物の創造的な考えを必要とするため、リソースを消費する問題です。回避策として、与えられたプロンプトにオフェンシブな生成を引き起こす可能性のあるトピックやフレーズを予測するために訓練された分類器をLLMに追加することができます。このような戦略は慎重な方向に進むでしょう。しかし、それは非常に制限的であり、モデルを頻繁に回避的にする原因となります。したがって、モデルが役立つこと(指示に従うこと)と無害であること(少なくとも有害な行動を引き起こしにくいこと)の間には緊張があります。 レッドチームは、ハードループ内の人間または有害な出力をテストするために別のLMをテストしているLMです。安全性とアライメントのためにファインチューニングされたモデルに対してレッドチーミングプロンプトを作成するには、Ganguli et al.、’22で説明されているような悪意のあるキャラクターとして振る舞うようにLLMに指示する役割プレイ攻撃の形で創造的な思考が必要です。モデルに自然言語の代わりにコードで応答するように指示することも、モデルの学習バイアスを明らかにすることができます。 さらなる例については、このツイートスレッドをご覧ください。 ChatGPT自体によるLLMのジェイルブレイキングのアイデアのリストは次のとおりです。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.