Learn more about Search Results 63%

- You may be interested

- 「FalconAI、LangChain、およびChainlitを...

- 異なる暗号通貨間のブリッジ

- Google AIがMedLMを導入:医療業界の利用...

- RayはNVIDIA AIとの協業により、開発者が...

- 「コンテキストに基づくドキュメント検索...

- 「大規模言語モデルの謎解き:インフルエ...

- 進め、GOを通過し、もっと多くのゲームを...

- 分岐と限定法 -アルゴリズムをスクラッチ...

- ロラハブにお会いしましょう:新しいタス...

- 「給与システムでの人事管理の活用方法:4...

- 「16/10から22/10までの週のトップ重要な...

- ChatGPTは実際に知能を持っていますか?

- 「Gensimを使ったWord2Vecのステップバイ...

- AIに人間の価値観をどのように組み込むこ...

- AIを使用して、自分の目で直接拡張現実(A...

『ブンブンの向こう側 産業における生成型AIの実用的な応用を探求する』

イントロダクション 現代の世界は「ジェネレーティブAI」という言葉で賑わっています。McKinsey、KPMG、Gartner、Bloombergなどのトップのテクノロジー企業や経営コンサルティング企業は、この新しい技術の力を測定し、将来を予測するために常に研究を行っています。これらの調査は、ジェネレーティブAIの企業への影響が急速に増大しており、今日の職場で必須のスキルとなっていることを示しています。調査結果によると、ジェネレーティブAIは2032年までに1.3兆ドルの市場となり、誰もがその一部になりたがるでしょう。この記事では、さまざまな産業におけるジェネレーティブAIの応用、成長、および影響について、そしてあなたがこのグローバルな変化の一部になる方法について説明します。 ジェネレーティブAIとは何か?その規模はどれくらいか? ジェネレーティブAIはもはや単なるバズワードではありません。この新しい技術は、AIが新しいコンテンツを作成し、実践を通じて学習することができるもので、世界中で注目を集めています。ジェネレーティブAIツールは、基本的にはトレーニングデータに基づいてコンテンツを生成できる大規模な学習モデル(LLM)です。これらのモデルは、トレーニングデータからパターンや構造を学び、類似のパターンに従う出力を生成できます。これらのモデルは、画像、動画、音楽、音声、テキスト、ソフトウェアコード、製品デザインなどを作成することができます。現在利用可能な大量のトレーニングデータのため、この技術の可能性は無限です。 過去数ヶ月間、ジェネレーティブAIの分野は着実に拡大し、毎日新しい応用とユースケースが発見されています。企業レベルでは、ジェネレーティブAIの統合により、より速いアウトプット、より高い生産性、経済成長が実現されています。その結果、多くの企業が時間とコストを節約するためにジェネレーティブAIを使用しています。 ジェネレーティブAIの企業応用には、自動化、人間または機械の増強、ビジネスおよびITプロセスの自立実行などが含まれます。McKinseyによると、世界中の企業はジェネレーティブAIツールの導入により、生産性の向上とリスクの最小化を最大限に活用しています。企業は今後、自身の仕事においてジェネレーティブAIを熟達することが求められるでしょう。 ジェネレーティブAIのビジネス面 ジェネレーティブAI市場には、モデルトレーニングインフラ、LLM向け推論デバイス、デジタル広告、特殊ソフトウェアとサービス、個人化アシスタント、およびコーディングの加速を可能にする共同作業者が含まれています。ジェネレーティブAIツールとソフトウェアを開発する企業がこの領域で最も恩恵を受けていますが、これら製品の応用はさまざまな産業の利益を支援しています。 では、ジェネレーティブAIは今日ではどれくらい大きな存在なのでしょうか?2022年には、ジェネレーティブAI市場は400億ドルと評価されており、時間の経過とともに成長しています。Bloomberg Intelligenceによると、ジェネレーティブAIは2032年までに42%の複合年間成長率を示し、1.3兆ドルの市場となると予測されています。 2023年:企業におけるジェネレーティブAIのブレイクイヤー ジェネレーティブAIは2020年以来、ガートナーの人工知能のハイプサイクルに登場しています。しかし、2023年はジェネレーティブAIのブレイクイヤーとなっています。この技術は比較的新しいものですが、ほぼすべての産業の重要な一部になるほど成長しています。 McKinseyの国際的なレポートによると、主要企業の33%が既にジェネレーティブAIを使用しており、その他の25%はAIの統合のプロセスにあると報告されています。また、レポートは、Cレベル幹部の22%が仕事でAIツールを使用していることも示しています。 技術の新たな使用法や応用が発見されるにつれて、その利用範囲もさらに拡大しています。すべての産業のすべてのレベルでのジョブロールは自動化され、人間の介入が最小限に抑えられ、人間の労働時間がより重要なタスクに割り当てられるようになっています。したがって、企業はAIのスキルを持つ人材を求めており、それが彼らに優位性をもたらしています。 さらに、McKinseyの調査によると、40%の企業がAIへの投資を拡大する予定です。つまり、すべての仕事においてある程度のレベルでAIの機能が関与するようになる可能性があることを示しています。私たちは皆、それに備えて準備をする必要があるのです。 エンタープライズリーダーがジェネレーティブAIについて考えていること 世界中のビジネスリーダーは、ジェネレーティブAIの可能性に興味を持ち、それが真に革新的な存在だと確信しています。オラクル・アナリティクス・クラウドの上級主任データサイエンティストであるヴィカス・アグラワル博士は、ジェネレーティブAIが特にテキストやユーザーインターフェースに関連する分野で企業ソリューションを革新する可能性を持っていると断言しています。「AIツールが進化するにつれて、データサイエンティストはこれらのツールを操作するだけでなく、それらを強化・改善するスキルを必要とする」と彼は述べました。 同様のことを言うと、データイクの元AI戦略責任者であるジェプソン・テイラー氏は、AIスタートアップの成功は適切な人材の採用にかかっていると述べています。彼はNYUでAIマスタークラスの共同リーダーとして、AIシステムが自律的にコードを書き換えおよび強化できる未来を予見し、より効率的かつ強力なアプリケーションをもたらすと述べています。 Beans.aiの応用AI責任者であるサンディープ・シンは、Analytics Vidhyaとのインタビューで、インドと米国のAIエコシステムを比較しました。「インドのAIエコシステムは、研究に重点を置いたベイエリアのAI研究風景とは異なり、急速な採用と商品化が可能な位置にあります」と彼は述べました。 インドの業界リーダーについては、Fractal Analyticsの最高経営責任者(CEO)、共同創業者、副議長であるスリカント・ヴァラマカンニ氏が挙げられます。彼は、組織内のほとんどの機能が自動化され、更新され、優位性を持ち続けるためには、最新の情報にアップデートし、エッジを持つ必要があると信じています。 GramenerのCEO兼チーフデータサイエンティストであるアナンド・S氏は、Googleのローンチ以来、ジェネレーティブAIを次なる大きなトピックと見ています。彼はすでに自身のコーディング作業のほとんどをAIにアウトソースし、さまざまなタスクをこなすために多くのLLM(Low-Level Machine)を訓練しており、それによって仕事を最適化し、時間を節約しています。…

Amazon MusicはSageMakerとNVIDIAを使用してMLの訓練および推論のパフォーマンスとコストを最適化しています

Amazon Music のストリーミングのダイナミックな世界では、曲やポッドキャスト、プレイリストの検索ごとに物語、ムード、感情の洪水が待っていますこれらの検索は新たな発見、大切な経験、永続する思い出への入り口となります検索バーは単に曲を見つけるためだけではありません

AIコンテンツ検出機はどのように機能するのでしょうか?

「AIコンテンツはどこにでもありますChatGPTの人気急増により、AI生成のブログ、記事、メール、履歴書、学術論文が急増しています当然のことながら、AIコンテンツ検出器も増加しました多くの学校や出版物は長年にわたりAI駆動の盗作チェッカーを使用してきました今や人々が試し擬態しやすくなったので…」

小売業の革新:AIが顧客体験、在庫管理、マーケティングに与える影響

人工知能が小売業界に革命を起こし、マーケティング戦略を向上させ、在庫管理を効率化し、顧客の体験を向上させている方法を発見しましょう小売業におけるAIの台頭を探り、データに基づく意思決定に与える影響や今後のトレンドについて考察してみましょう

「Googleの ‘隠された’ 生成型AI画像作成ツールにアクセスする方法」

GoogleのジェネレーティブAI画像作成機能を検索で利用する方法無料で実験バージョンにアクセスするには、ChatGPT DALLEを使います

UCSDの研究者が、チューリングテストでのGPT-4のパフォーマンスを評価:人間のような欺瞞とコミュニケーション戦略のダイナミクスを明らかにする

GPT-4はUCSDの研究者グループによってインターネット上の一般的なチューリングテストで試験されました。最も優れたGPT-4のプロンプトは、ゲームの41%で成功しました。これはELIZA(27%)、GPT-3.5(14%)および無作為なチャンス(63%)によって提供されたベースラインよりも良い結果でしたが、まだ完全な性能ではありません。チューリングテストの結果によれば、参加者は主に言語スタイル(合計の35%)とソーシャル・エモーショナルな特性(合計の27%)で判断されました。参加者の教育レベルやLLM(Large Language Models)への事前の経験は、彼らが詐欺を見破る能力を予測するための要因ではありませんでした。これは、そのような問題に精通している人々であっても、トリックに対して脆弱である可能性があることを示しています。チューリングテストは知性の尺度としては広く批判を受けていますが、カリフォルニア大学サンディエゴ校の2人の研究者は、それが即興のコミュニケーションと詐欺の尺度として有用であると主張しています。彼らは人間と見なすことができる人工知能モデルを持っており、これには広範な社会的影響があるかもしれません。したがって、彼らは人間らしさを決定するためのさまざまな方法論と基準の効果を調査しています。 チューリングテストは知性への感度に関する論争とは関係なく興味深いものです。まず、テストされている能力、つまりシステムが対話者を人間だと思わせることができるかどうかを分析することが重要です。チューリングテストは、そのような能力の開発をモデルで監視するための信頼性のある方法を提供します。さらに、モデルのサイズや性能、プロンプト戦略、リアルタイム情報へのアクセスなどの補助的なインフラストラクチャ、およびインタラクティブのレベルなど、嘘をつくことに関与するさまざまな側面についても学ぶことができます。 また、チューリングテストは、機械が人間らしく見えるという一般的な認識を調査するための研究ツールとしても使用できます。機械のパフォーマンスが評価されますが、人間の参加者の文化的、倫理的、心理的な前提条件も調査されます。インタラクティブが質問を作成し、洗練された質問を行う過程で、インタラクターが人間であると考える属性に関する基本的な意見が明らかにされます。 チューリングテストは、1人の尋問者と1人の証人によって変更され、証人が人間か人工知能かを判断します。これはチューリングの最初の3人の公式とは異なりますが、各ゲームに複数の人間参加者をオンラインで必要としないため、かなり一般的になりました。 彼らはOpenAI APIを使用して、ユーザーからの質問に答えることができる25のLLM証人を開発しました。各LLM証人は温度設定(0.2、0.5、または1.0)、モデル(GPT-3.5またはGPT-4)、およびプロンプトを持っていました。報告書は状況を説明し、エージェントに具体的な指示を与えました。 チャットアプリのユーザーインターフェースは、標準的なメッセージングサービスに似せて作られました。尋問者が最初のメッセージを送信し、各ユーザーは同時に1つのメッセージのみを送信することができました。各通信は最大300文字で、総討論時間は5分でした。テキストボックスに貼り付けることは制限され、侮辱的なメッセージを防止するためにコンテンツフィルタが適用されました。画面の右上隅にはカウントダウンタイマー、指示オーバーレイを表示するボタン、および侮辱的な人々を報告するためのフォームがあります。 尋問者は意思決定インターフェースを使用して、以下の情報を提供しました: i)判決(機械または人間の証人) ii)正しい判断を下したことにどれだけ確信しているか(0〜100) iii)選択の理由(自由形式の言語) 制約事項 オープンでオンラインの実験としての性質上、この研究にはいくつかの欠点があり、その結果は確かとは言えません。まず、サンプルがコミュニティの代表的なものよりも反映されている可能性があります、なぜなら参加者はソーシャルメディアを通じて募集されたからです。また、参加者にはインセンティブが必要でした。したがって、尋問者や証人が最善を尽くした可能性があります。人間の証人は人工知能のように振る舞って「トローリング」しています。一部の調査員はこのような行為を人間の判決の正当化として使用しました。したがって、結果は人間のパフォーマンスを過小評価し、AIのパフォーマンスを過大評価している可能性があります。第三に、一部の尋問者は証人に関する事前知識を持っていたことを認めています。 要約すると- チューリングテストは知能の不完全な指標としてしばしば非難されてきました。これは、あまりにも評価が明らかであったために、研究者が人間のパフォーマンスを過大評価した可能性があります。最後に、一度に1人のオンラインユーザーしかいなかったため、彼らは頻繁に同じ人工知能の証人とペアリングされました。その結果、人々は特定の証言がAIであるという固定観念を持つ可能性があり、全体的に低いSR結果につながる可能性があります。このバイアスは、1人の尋問者が3回以上連続してAIと対戦したゲームを削除することで対抗する努力があったにもかかわらず、結果に影響を与えたでしょう。最後に、利用可能なプロンプトの一部のみが使用され、それらは実際の人々がゲームとどのように対話するかを知らない状態で開発されました。結果は、より効果的なプロンプトが存在するため、チューリングテストでのGPT-4の潜在的なパフォーマンスを過小評価しています。

マイクロソフトの研究者たちは、FP8混合精度トレーニングフレームワークを公開しました:大規模な言語モデルのトレーニング効率を超高速化します

大型言語モデルは、言語生成と理解の能力において以前に類を見ない優れた能力を示しており、論理学、数学、物理学、他の領域の先進に道を開いています。ただし、LLMのトレーニングは非常に高額です。たとえば、540Bモデルをトレーニングするには、PaLMには6,144個のTPUv4チップが必要であり、GPT-3175Bは事前トレーニングに数千ペタフロップ/秒の計算が必要です。これは、特に次世代の非常に知的なモデルを拡大するために、LLMのトレーニングコストを低くする必要性を示しています。コストを節約するための最も有望なアプローチの1つは、低精度トレーニングです。このアプローチは、高速な処理、少ないメモリ使用量、最小限の通信オーバーヘッドを提供します。現在のほとんどのトレーニングシステム(Megatron-LM、MetaSeq、Colossal-AIなど)は、デフォルトでFP16/BF16のミックス精度またはFP32の完全精度を使用してLLMをトレーニングします。 大規模なモデルの場合、これは完全な精度を得るためのオプションですが、FP8はNvidia H100 GPUの登場により、次世代の低精度表現のデータ型として台頭しています。既存の16ビットと32ビットの浮動小数点ミックス精度トレーニングと比較して、FP8には理論的に2倍の高速化、50%から75%のメモリコスト削減、50%から75%の通信コスト削減の潜在能力があります。これらの結果は、次世代の基礎となるモデルのスケーリングに非常に有望です。残念ながら、FP8トレーニングへのサポートはもっと少なく、時間的に間隔のあるものが必要です。Nvidia Transformer Engineは唯一の実用的なフレームワークですが、GEMM計算にはFP8のみを使用し、マスターウェイトとグラデーションは極めて正確なFP16またはFP32のように維持します。これにより、エンドツーエンドのパフォーマンス向上、メモリの節約、および通信コストの節約は比較的少なくなり、FP8のフルポテンシャルは隠されてしまいます。 Microsoft AzureとMicrosoft Researchの研究者は、この問題を解決するためにLLMのトレーニングに非常に効率的なFP8ミックス精度フレームワークを提供しています。主なコンセプトは、ビッグモデルのトレーニングプロセス中に、計算、ストレージ、通信において低精度FP8を活用することです。これにより、以前のフレームワークと比較して、システム要件を大幅に削減することができます。より具体的には、彼らはFP8を使用して最適化ステージを3つ作成し、オプティマイザ、分散並列トレーニング、8ビットの集合通信を段階的に導入します。より大きな最適化レベルは、LLMのトレーニングプロセスでより多くのFP8が使用されたことを示しています。さらに、彼らのシステムはテンソル、パイプライン、およびシーケンスの並列性を含むFP8低ビット並列性を提供します。これにより、数千のGPUでトレーニングされたGPT-175Bなどの大規模なトレーニングが可能になり、次世代の低精度並列トレーニングの扉が開かれます。 FP8を使用したLLMのトレーニングには、作業が必要です。データオーバーフローやアンダーフローなどの問題に起因する固有のダイバージェンスや数値不安定性などの問題が発生します。これらの問題に対処するために、彼らは2つの方法を提案しています。情報の損失を防ぐための自動スケーリングと、重み、勾配、およびオプティマイザーの状態などのパラメータにおけるデータ精度の影響を分離するための精度切り離しです。最初の方法は、非精度に敏感でないコンポーネントの精度を低下させ、テンソルのスケーリング係数の動的調整により、FP8データフォーマット表現範囲内の勾配値を保持することです。これにより、全体の通信中にアンダーフローやオーバーフローの発生が防止されます。 彼らは、検証のために監督付き微調整と事前トレーニングを含むGPTスタイルのモデルトレーニングに提案されたFP8低精度フレームワークを使用します。彼らのFP8手法をよく使用されるBF16ミックス精度トレーニングアプローチと比較すると、実験結果は、実メモリ使用量の27%〜42%の減少や、重み勾配通信オーバーヘッドの63%〜65%の著しい減少など、重要な改善を示しています。FP8でトレーニングされたモデルは、学習率や重み減衰などのハイパーパラメータの調整なしに、BF16の高精度を使用するモデルと同等の性能を示します。GPT-175Bモデルのトレーニングでは、彼らのFP8ミックス精度フレームワークがH100 GPUプラットフォーム上で21%少ないメモリを使用し、TEよりも17%短いトレーニング時間を節約することに注目すべきです。 図1: クラスター内のNvidia H100 GPU with 80G RAMを使用した場合に達成可能な最大モデルサイズの比較。当社のFP8混合精度トレーニング方法とより一般的なBF16方法を使用しています。 さらに重要なことは、Fig. 1に示すようにモデルのスケールが増加すると、低精度のFP8を使用することで得られるコスト削減をさらに向上させることができることです。事前学習されたLLMsをエンドタスクとユーザーの好みにより適合させるために、彼らは指示の微調整とヒューマンインプットによる強化学習にFP8混合精度を使用しています。特に、彼らは公開されているユーザー共有の指示に従うデータを使用して事前学習済みモデルを微調整します。彼らのFP8混合精度で調整されたモデルは、BF16の半精度を使用したモデルと比較して、AlpacaEvalとMT-Benchベンチマークで同様のパフォーマンスを発揮します。さらに、FP8混合精度はトレーニング中に多くのモデルをロードする必要があるRLHFにおいて非常に有望です。 人気のあるRLHFフレームワークであるAlpacaFarmは、トレーニング中にFP8を使用することで、モデルの重量を46%減少させ、オプティマイザの状態のメモリ使用量を62%削減することができます。これは、彼らのFP8低精度トレーニングアーキテクチャの柔軟性と適応性をより一層示しています。彼らが将来の世代のLLM向けのFP8低精度トレーニングの発展に貢献している内容は以下の通りです。• FP8による混合精度トレーニングのための新しいフレームワーク。このフレームワークは使いやすく、8ビットの重み、勾配、オプティマイザ、および分散トレーニングを段階的に解除します。現在の16/32ビット混合精度の代替として、ハイパーパラメータとトレーニングレシピを変更するだけで、この8ビットフレームワークに簡単に切り替えることができます。また、数行のコードで8ビット低精度トレーニングを可能にするPytorchの実装も提供しています。 新しいFP8トレーニングされたGPTスタイルモデル。彼らは提案されたFP8スキームの能力を、7Bから175Bパラメータのモデルに適用することで示しています。彼らは、テンソル、パイプライン、シーケンスの並列処理をFP8に対応させ、大規模な基礎モデルのトレーニングにFP8を使用することを可能にしています。最初のFP8…

「このAIニュースレターはあなたが必要とするもの全てです #69」

Googleは、MicrosoftやAdobeといった企業に続き、彼らが提供するAIサービスの利用者を知的財産権侵害に関する訴訟から保護することに取り組むことを発表しました...

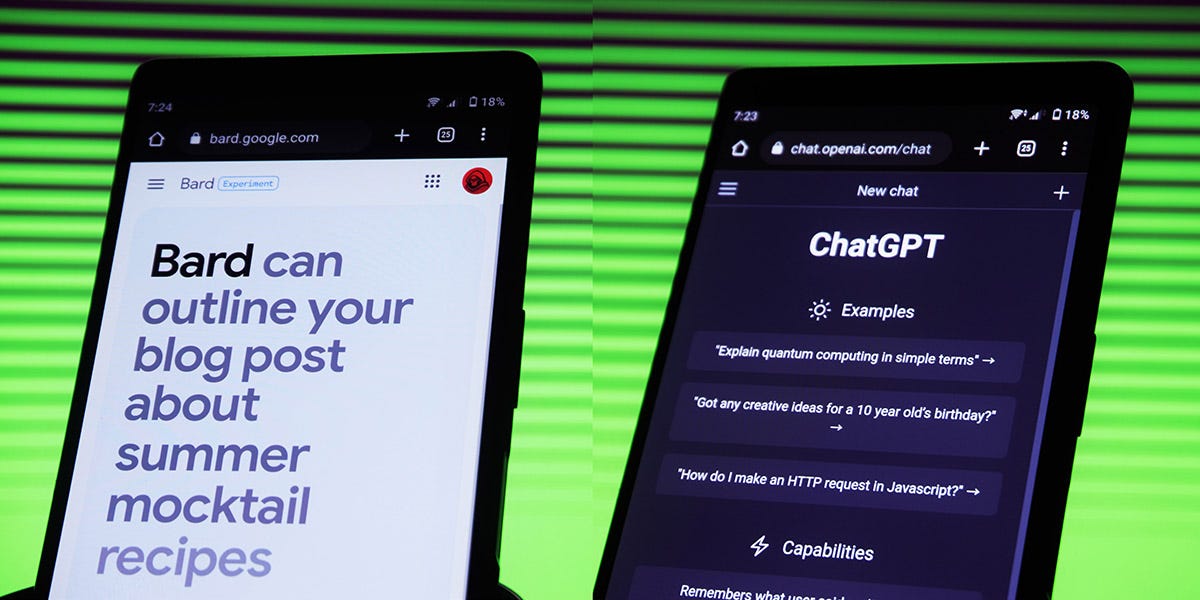

「LLMsを使用した用語の翻訳(GPTとVertex AI/Google Bard)」

ChatGPTのようなLLMは、人間よりも正確に翻訳を行うことができるのでしょうか?私たちが利用できるLLMのオプションは何ですか?さまざまな方法で翻訳を行うために生成型AIを使用する方法について詳しく学びましょう

「SAS認定データサイエンティストになるために必要なすべて」

才能の不足と機会の豊富さにより、SAS Academy for Data Scienceを利用してデータサイエンスのキャリアをスタートまたは進展させる最適な時期は今までありませんでしたSAS Certified Data Scientistになるために必要なすべての情報を知るために、読み続けてください

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.