Learn more about Search Results 21

- You may be interested

- 「RBIは、規制監督のためにAIを活用するた...

- 「ChatGPT Visionのすごい活用方法」

- 「HuggingFaceのデータ収集者たち」

- 「バランスのとれたアクト:推薦システム...

- マシンラーニングのロードマップ:コミュ...

- 木材トランジスターが根付く

- 人間の理解と機械学習のギャップを埋める...

- 「トップ40以上の創発的AIツール(2023年1...

- このAI論文は、それぞれの手のモデルに基...

- 「高解像度画像を使用したAmazon Rekognit...

- 「GenAIソリューションがビジネス自動化を...

- 「Amazon SageMaker Data WranglerでAWS L...

- 「AI駆動の洞察:LangChainとPineconeを活...

- 洞察を具体的な成果に変える

- 「集団行動のデコード:アクティブなベイ...

「2020年と2021年のトップの声、グレッグ・コキーヨとともにLinkedInで成功しよう」

「私は、LinkedInで注目されるトップボイスのGreg Coquilloさんと魅力的な会話をしました彼はシニアプロダクトマネージャーであり、AIスタートアップの投資家でもありますこの機会を利用して重要なポイントについて深く掘り下げることができました」

「この男性は誰でもバイラルにすることができます(10か月で21億回の視聴回数)」

「以下は、短編コンテンツで1か月で1億ビューを獲得するための6つのステップのフレームワークです...」

「AI スタートアップの資金調達 9 月 1 号 ConverSight、Voxel、AI21、および Gesund」

技術の急速な進化の中で、人工知能(AI)は類まれなる約束と課題を持つ重要なフロンティアとして立ち位置を確立しています。これに伴い、ベンチャーキャピタリスト、エンジェル投資家、企業は、次なる大きなブレークスルーを資金提供するためにAIスタートアップへの投資を増やしています。2023年9月1日号では、AIスタートアップへの資金提供の複雑な世界について詳しく掘り下げています。最も収益性の高い取引から投資の景色を形作るトレンドまで、2023年にお金を集める要素について包括的な洞察を提供しています。 ConverSight 最新の資金調達:900万米ドル 詳細:インディアナポリスに拠点を置くソフトウェア企業ConverSight.aiは、ニューヨーク市のSurface VenturesをリードとするシリーズAラウンドで900万米ドルの資金調達に成功しました。このスタートアップは、ビジネスの意思決定のためのAIとデータ分析に特化しており、Techstars、Augment Ventures、Elevate Venturesなどからの投資も受けています。ConverSight.aiは、2022年1月にシードラウンドで400万米ドルを調達したことがあり、総資金調達額は1500万米ドルになります。この資金は、データに基づくビジネスソリューションをさらに洗練させるためのスタートアップの取り組みを支援するでしょう。 Tavus 最新の資金調達:1800万米ドル 詳細:ビジネス向けのカスタマイズ可能なビデオに特化した2年のスタートアップであるTavusは、シリーズAラウンドで1800万米ドルを調達しました。これはシードラウンドからわずか5か月後のことで、投資後の企業価値は8000万米ドルになります。現在の年間繰り返し収益は100万米ドルであり、Tavusは年末には200万から300万米ドルの繰り返し収益を見込んでいます。予想よりも低い収益が報告されたため、少なくとも1人の投資家が資金調達の機会を逃したようです。 Voxel 最新の資金調達:1200万米ドル 詳細:サンフランシスコに拠点を置くスタートアップのVoxelは、職場の安全性を向上させるために1200万米ドルを調達しました。AIとコンピュータビジョンを活用して、Voxelはセキュリティカメラを強化し、リスク管理と報告を自動化します。 AI21 最新の資金調達:1億5500万米ドル 詳細:イスラエルのAIスタートアップAI21 Labsは、1億5500万米ドルのシリーズCラウンドを調達し、企業価値を14億米ドルに引き上げました。GoogleやNvidiaなどの有名な投資家も参加しています。新たな資本は、企業向けにカスタマイズされたテキストベースの生成型AIサービスを拡大するために割り当てられます。AI21 LabsはOpenAIやAnthropicなどの業界の巨人に対抗しており、Jurassic-2というプロプライエタリな言語モデルを提供しています。これは、カスタムテキストベースのビジネスアプリケーションや多言語AIアシスタントを支えるプラットフォームです。

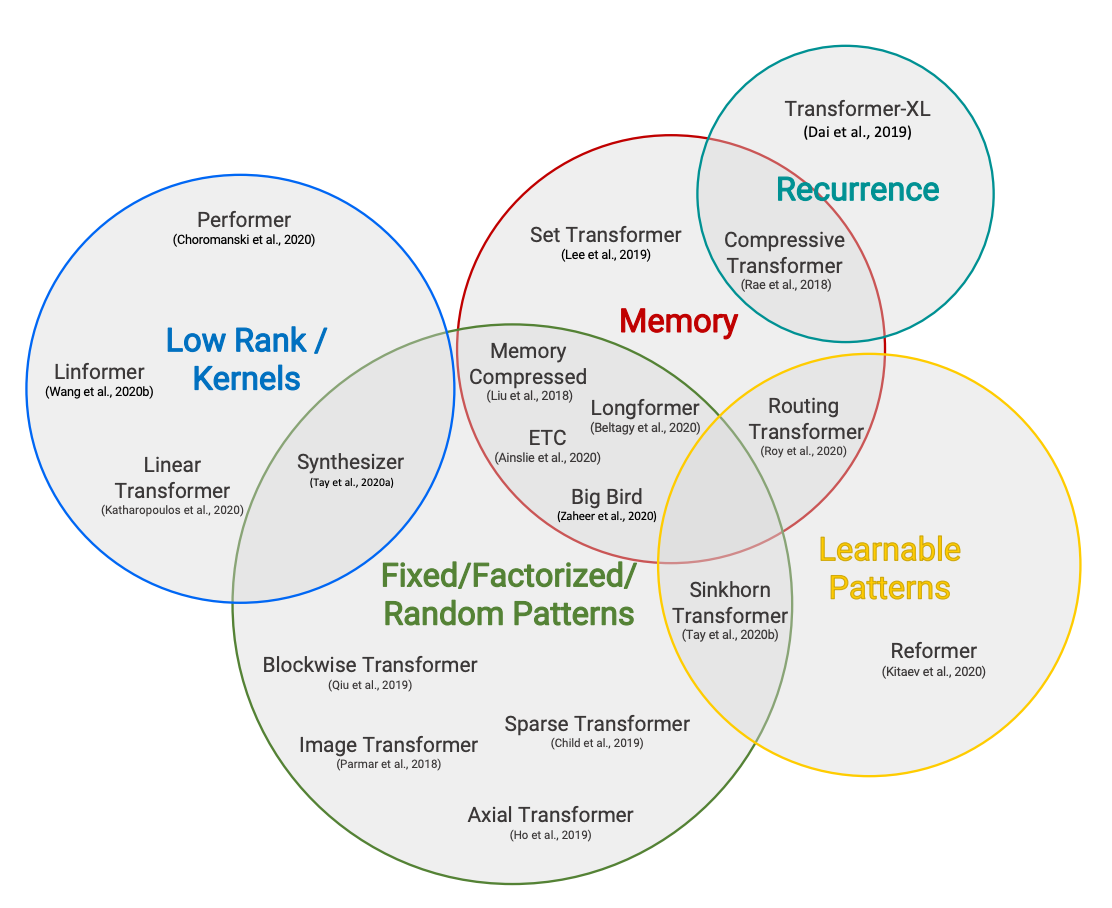

ハギングフェイスの読書会、2021年2月 – Long-range Transformers

Efficient Transformersの分類法(TayらによるEfficient Transformers:サーベイ) 共著者:Teven Le Scao、Patrick Von Platen、Suraj Patil、Yacine Jernite、Victor Sanh 毎月、私たちは特定のトピックに焦点を当て、そのトピックについて最近発表された4つの論文を読みます。それらの研究結果と共通のトレンド、そして読んだ後の追加研究についての質問を短いブログ投稿でまとめます。2021年1月の最初のトピックは「スパース化とプルーニング」であり、2021年2月には「Transformerにおけるロングレンジアテンション」に取り組みました。 イントロダクション 2018年と2019年に大型Transformerモデルが台頭した後、その計算要件を下げるために2つのトレンドが急速に現れました。第一に、条件付き計算、量子化、蒸留、プルーニングにより、計算制約のある環境で大型モデルの推論が可能になりました。私たちは既に前回の読書グループの投稿でこれに触れています。研究コミュニティはその後、事前トレーニングのコストを削減するために動きました。 特に、トランスフォーマーモデルのメモリと時間に関するシーケンス長に対する二次的なコストが問題となっていました。非常に大きなモデルの効率的なトレーニングを可能にするために、2020年には通常のNLPでは512または1024のシーケンス長がデフォルトであった範囲を超えるトランスフォーマーをスケールするための論文が数多く発表されました。 このトピックは私たちの研究討論の中心的な要素であり、私たち自身のPatrick Von PlatenはすでにReformerに4部作を捧げています。この読書グループでは、すべてのアプローチをカバーしようとせずに(アプローチは非常に多いです!)、次の4つの主なアイデアに焦点を当てます: カスタムアテンションパターン(Longformerを使用) 再帰(Compressive Transformerを使用) 低ランク近似(Linformerを使用) カーネル近似(Performerを使用) 詳細な視点については、「Efficient…

データサイエンス面接のための21の必須チートシート:成功への道を開く

この記事では、インターネット上から収集した最高のデータサイエンスのチートシートを調査し、提供していますので、自分で調べる必要はありません

「言語モデルの逆スケーリングの謎を解明する」

This aspect of inverse scaling is a crucial point to keep in mind, as it can affect the performance of larger LLMs. However, this…

チャットボットは学校での不正行為を助長しているのか?最新の研究結果が驚くべき結果を明らかにしています

「スタンフォード大学の研究者によると、ChatGPTなどのA.I.ツールの使用は高校での不正行為の増加にはつながらなかったということが分かりましたこの結果は、この種のツールの効果的かつ倫理的な使用を証明する上で非常に価値があります」

Googleは独占禁止法訴訟で敗訴:ビッグテックにとって何を意味するのか?

「エピックゲームズが検索大手との法的闘争に勝利した事は画期的な勝利であり、同社の強さと決断力を示す重要な節目となりました」

「ODSC East 2024 Pre-Bootcamp Primer コースのお知らせ」

私たちは、ODSC東プリブートキャンププライマーコースで2024年をスタイリッシュにスタートさせます!今年は、新しく3つのコースが追加されました2024年のトップAIスキル、機械学習入門、大規模言語モデルとプロンプトエンジニアリング入門です以下で全セッションをご覧ください2024年のトップAIスキル...

「2023年、オープンLLMの年」

2023年には、大型言語モデル(Large Language Models、LLMs)への公衆の関心が急増しました。これにより、多くの人々がLLMsの定義と可能性を理解し始めたため、オープンソースとクローズドソースの議論も広範な聴衆に届くようになりました。Hugging Faceでは、オープンモデルに大いに興味を持っており、オープンモデルは研究の再現性を可能にし、コミュニティがAIモデルの開発に参加できるようにし、モデルのバイアスや制約をより簡単に評価できるようにし、チェックポイントの再利用によってフィールド全体の炭素排出量を低減するなど、多くの利点があります(その他の利点もあります)。 では、オープンLLMsの今年を振り返ってみましょう! 文章が長くなりすぎないようにするために、コードモデルには触れません。 Pretrained Large Language Modelの作り方 まず、大型言語モデルはどのようにして作られるのでしょうか?(もし既に知っている場合は、このセクションをスキップしてもかまいません) モデルのアーキテクチャ(コード)は、特定の実装と数学的な形状を示しています。モデルのすべてのパラメータと、それらが入力とどのように相互作用するかがリストとして表されます。現時点では、大部分の高性能なLLMsは「デコーダーのみ」トランスフォーマーアーキテクチャのバリエーションです(詳細は元のトランスフォーマーペーパーをご覧ください)。訓練データセットには、モデルが訓練された(つまり、パラメータが学習された)すべての例と文書が含まれています。したがって、具体的には学習されたパターンが含まれます。ほとんどの場合、これらの文書にはテキストが含まれており、自然言語(例:フランス語、英語、中国語)、プログラミング言語(例:Python、C)またはテキストとして表現できる構造化データ(例:MarkdownやLaTeXの表、方程式など)のいずれかです。トークナイザは、訓練データセットからテキストを数値に変換する方法を定義します(モデルは数学的な関数であり、したがって入力として数値が必要です)。トークン化は、テキストを「トークン」と呼ばれるサブユニットに変換することによって行われます(トークン化方法によっては単語、サブワード、または文字になる場合があります)。トークナイザの語彙サイズは、トークナイザが知っている異なるトークンの数を示しますが、一般的には32kから200kの間です。データセットのサイズは、これらの個々の「原子論的」単位のシーケンスに分割された後のトークンの数としてよく測定されます。最近のデータセットのサイズは、数千億から数兆のトークンに及ぶことがあります!訓練ハイパーパラメータは、モデルの訓練方法を定義します。新しい例ごとにパラメータをどれだけ変更すべきですか?モデルの更新速度はどのくらいですか? これらのパラメータが選択されたら、モデルを訓練するためには1)大量の計算パワーが必要であり、2)有能な(そして優しい)人々が訓練を実行し監視する必要があります。訓練自体は、アーキテクチャのインスタンス化(訓練用のハードウェア上での行列の作成)および上記のハイパーパラメータを使用して訓練データセット上の訓練アルゴリズムの実行からなります。その結果、モデルの重みが得られます。これらは学習後のモデルパラメータであり、オープンな事前学習モデルへのアクセスに関して多くの人々が話す内容です。これらの重みは、推論(つまり、新しい入力の予測やテキストの生成など)に使用することができます。 事前学習済みLLMsは、重みが公開されると特定のタスクに特化または適応することもあります。それらは、「ファインチューニング」と呼ばれるプロセスを介して、ユースケースやアプリケーションの出発点として使用されます。ファインチューニングでは、異なる(通常はより専門化された小規模な)データセット上でモデルに追加の訓練ステップを適用して、特定のアプリケーションに最適化します。このステップには、計算パワーのコストがかかりますが、モデルをゼロから訓練するよりも財政的および環境的にはるかにコストがかかりません。これは、高品質のオープンソースの事前学習モデルが非常に興味深い理由の一つです。コミュニティが限られたコンピューティング予算しか利用できない場合でも、自由に使用し、拡張することができます。 2022年 – サイズの競争からデータの競争へ 2023年以前、コミュニティで利用可能だったオープンモデルはありましたか? 2022年初頭まで、機械学習のトレンドは、モデルが大きければ(つまり、パラメータが多ければ)、性能が良くなるというものでした。特に、特定のサイズの閾値を超えるモデルは能力が向上するという考えがあり、これらの概念はemergent abilitiesとscaling lawsと呼ばれました。2022年に公開されたオープンソースの事前学習モデルは、主にこのパラダイムに従っていました。 BLOOM(BigScience Large Open-science…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.