Learn more about Search Results リーダーボード

- You may be interested

- In Japanese, the translation of Time Se...

- 「人生をゲームとして見るならば、それを...

- 「最も適応能力の高い生存者 コンパクトな...

- 「AIイノベーションのためのニューロエボ...

- 「機械学習を使用するかどうか」

- 「コイントスを毎回勝つ方法」

- PyTorch / XLA TPUsでのHugging Face

- 「LLMsとRAGを組み合わせることによる拡張」

- 「データビジュアルの誤り:一般的なGPT-4...

- 「自分自身でタスクを行う方法を知ってい...

- スタンフォード大学、コーネル大学、オッ...

- 「医療における説明可能なAIの実装の重要性」

- 「ChatGPTを活用したデータ探索:データセ...

- 「ワードエンベディング:より良い回答の...

- 機械学習におけるランダムナンバー

オープンLLMリーダーボード:DROPディープダイブ

最近、新たに3つの新基準がOpen LLM Leaderboardに追加されました。Winogrande、GSM8k、そしてDROPです。これらはEleutherAI Harnessの再現実装を使用しています。DROPのスコアをざっと見てみると、f1スコアでほとんどのモデルが10点以下という奇妙な現象が起こっていることがわかりました。私たちはこの問題を深く掘り下げ、何が起こっているのかを理解するために調査を行いました。一緒に調査結果を見ていきましょう! 初期の観察結果 DROP(段落に対する離散的な推論)は、モデルが英語の段落から関連する情報を抽出し、それらに対して離散的な推論手法(例えば、ソートやアイテムの数え上げなどを行い、正解にたどり着く)を実行する必要がある評価です(例は下の表を参照してください)。使用される評価指標はカスタムのf1スコアと完全一致スコアです。 DROPをOpen LLM Leaderboardに3週間前に追加しましたが、事前学習モデルのf1スコアは予想外の傾向を示しました。DROPのスコアをARC、HellaSwag、TruthfulQA、MMLUのリーダーボードの元々の平均(モデル全体のパフォーマンスの合理的な代理)と比較したとき、優れたモデルほどDROPのスコアも良い関連性があると予想していました。しかし、それは一部のモデルにしか当てはまらず、他のすべてのモデルのDROPのf1スコアは10点未満でした。 正規化の問い合わせ この驚くべき振る舞いに対する最初の深い調査中に、正規化ステップが意図した通りに機能していない可能性があることがわかりました。いくつかのケースでは、正規化が正しい数値の回答を無視してしまっていました。具体的には、数値の回答の後に空白文字(スペース以外の改行など)が続いていた場合に正規化が無視されていました。以下に例を示します。生成結果が10\n\nPassage: The 2011 census recorded a population of 1,001,360で、正解が10である場合を見てみましょう。 正規化は生成結果と正解の両方に対して複数のステップで行われます: 区切り文字での分割 |、-、または. を使って分割します。生成結果の先頭のシーケンス 10\n\nPassage:…

「SageMakerキャンバスモデルリーダーボードを使用して、高度な設定を持つ機械学習モデルを構築し、評価します」

「Amazon SageMaker Canvas は、アナリストや市民データサイエンティストが、自身のビジネスニーズに合わせた正確な機械学習(ML)の予測を生成するためのノーコードの作業スペースです今日から、SageMaker Canvas は、アンサンブルまたはハイパーパラメータの最適化といった高度なモデルビルドの設定、トレーニングと検証データの分割比率のカスタマイズなどをサポートしています」

物体検出リーダーボード

リーダーボードとモデルの評価の世界へようこそ。前回の投稿では、大規模言語モデルの評価について説明しました。今日は、異なるが同じくらい挑戦的な領域、つまり物体検出に乗り出します。 最近、オブジェクト検出のリーダーボードをリリースしました。このリーダーボードでは、ハブで利用可能な物体検出モデルをいくつかのメトリックに基づいてランキングしています。このブログでは、モデルの評価方法を実証し、物体検出で使用される一般的なメトリック、Intersection over Union (IoU)、Average Precision (AP)、Average Recall (AR)の謎を解き明かします。さらに重要なことは、評価中に発生する可能性のある相違点や落とし穴に焦点を当て、モデルのパフォーマンスを批判的に理解し評価できる知識を身につけることです。 すべての開発者や研究者は、正確に物体を検出し区別できるモデルを目指しています。私たちのオブジェクト検出リーダーボードは、彼らのアプリケーションのニーズに最も適したオープンソースモデルを見つけるための正しい場所です。しかし、「正確」とはこの文脈では本当に何を意味するのでしょうか?どのメトリックを信頼すべきでしょうか?それらはどのように計算されるのでしょうか?そして、さらに重要なことは、なぜいくつかのモデルが異なるレポートで相違した結果を示すことがあるのかということです。これらのすべての質問にこのブログで答えます。 では、一緒にこの探求の旅に乗り出し、オブジェクト検出リーダーボードの秘密を解き明かしましょう!もしも紹介を飛ばして、物体検出メトリックの計算方法を学びたい場合は、メトリックセクションに移動してください。オブジェクト検出リーダーボードを基に最良のモデルを選ぶ方法を知りたい場合は、オブジェクト検出リーダーボードセクションを確認してください。 目次 はじめに 物体検出とは メトリック 平均適合率(Average Precision)とは、どのように計算されるのか? 平均再現率(Average Recall)とは、どのように計算されるのか? 平均適合率と平均再現率のバリエーションとは? オブジェクト検出リーダーボード メトリックに基づいて最適なモデルを選ぶ方法は? 平均適合率の結果に影響を与えるパラメータは? 結論…

Open LLMのリーダーボードはどうなっていますか?

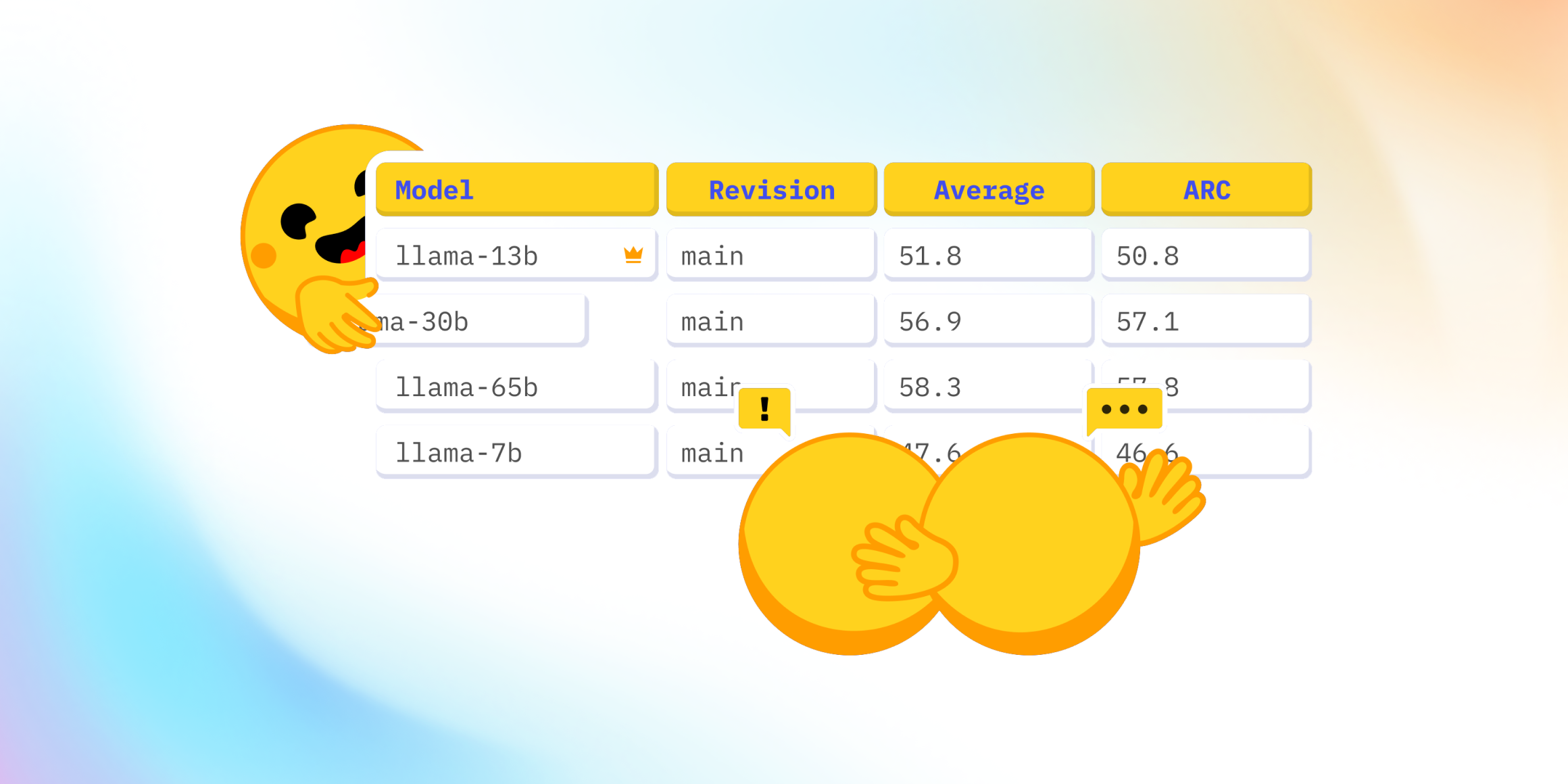

最近、Falcon 🦅のリリースおよびOpen LLM Leaderboardへの追加に関して、Twitter上で興味深い議論が起こりました。Open LLM Leaderboardは、オープンアクセスの大規模言語モデルを比較する公開のリーダーボードです。 この議論は、リーダーボードに表示されている4つの評価のうちの1つであるMassive Multitask Language Understanding(略称:MMLU)のベンチマークを中心に展開されました。 コミュニティは、リーダーボードの現在のトップモデルであるLLaMAモデル 🦙のMMLU評価値が、公開されたLLaMa論文の値よりも著しく低いことに驚きました。 そのため、私たちは何が起こっているのか、そしてそれを修正する方法を理解するために深堀りしました 🕳🐇 私たちとのこの冒険の旅において、私たちはLLaMAの評価に協力した素晴らしい@javier-m氏、そしてFalconチームの素晴らしい@slippylolo氏と話し合いました。もちろん、以下のエラーは彼らではなく、私たちに帰すべきです! この冒険の旅の中で、オンラインや論文で見る数値を信じるべきかどうか、モデルを単一の評価で評価する方法について多くのことを学ぶことができます。 準備はいいですか?それでは、シートベルトを締めましょう、出発します 🚀。 Open LLM Leaderboardとは何ですか? まず、Open LLM Leaderboardは、実際にはEleutherAI非営利AI研究所によって作成されたオープンソースのベンチマークライブラリEleuther…

「2023年、オープンLLMの年」

2023年には、大型言語モデル(Large Language Models、LLMs)への公衆の関心が急増しました。これにより、多くの人々がLLMsの定義と可能性を理解し始めたため、オープンソースとクローズドソースの議論も広範な聴衆に届くようになりました。Hugging Faceでは、オープンモデルに大いに興味を持っており、オープンモデルは研究の再現性を可能にし、コミュニティがAIモデルの開発に参加できるようにし、モデルのバイアスや制約をより簡単に評価できるようにし、チェックポイントの再利用によってフィールド全体の炭素排出量を低減するなど、多くの利点があります(その他の利点もあります)。 では、オープンLLMsの今年を振り返ってみましょう! 文章が長くなりすぎないようにするために、コードモデルには触れません。 Pretrained Large Language Modelの作り方 まず、大型言語モデルはどのようにして作られるのでしょうか?(もし既に知っている場合は、このセクションをスキップしてもかまいません) モデルのアーキテクチャ(コード)は、特定の実装と数学的な形状を示しています。モデルのすべてのパラメータと、それらが入力とどのように相互作用するかがリストとして表されます。現時点では、大部分の高性能なLLMsは「デコーダーのみ」トランスフォーマーアーキテクチャのバリエーションです(詳細は元のトランスフォーマーペーパーをご覧ください)。訓練データセットには、モデルが訓練された(つまり、パラメータが学習された)すべての例と文書が含まれています。したがって、具体的には学習されたパターンが含まれます。ほとんどの場合、これらの文書にはテキストが含まれており、自然言語(例:フランス語、英語、中国語)、プログラミング言語(例:Python、C)またはテキストとして表現できる構造化データ(例:MarkdownやLaTeXの表、方程式など)のいずれかです。トークナイザは、訓練データセットからテキストを数値に変換する方法を定義します(モデルは数学的な関数であり、したがって入力として数値が必要です)。トークン化は、テキストを「トークン」と呼ばれるサブユニットに変換することによって行われます(トークン化方法によっては単語、サブワード、または文字になる場合があります)。トークナイザの語彙サイズは、トークナイザが知っている異なるトークンの数を示しますが、一般的には32kから200kの間です。データセットのサイズは、これらの個々の「原子論的」単位のシーケンスに分割された後のトークンの数としてよく測定されます。最近のデータセットのサイズは、数千億から数兆のトークンに及ぶことがあります!訓練ハイパーパラメータは、モデルの訓練方法を定義します。新しい例ごとにパラメータをどれだけ変更すべきですか?モデルの更新速度はどのくらいですか? これらのパラメータが選択されたら、モデルを訓練するためには1)大量の計算パワーが必要であり、2)有能な(そして優しい)人々が訓練を実行し監視する必要があります。訓練自体は、アーキテクチャのインスタンス化(訓練用のハードウェア上での行列の作成)および上記のハイパーパラメータを使用して訓練データセット上の訓練アルゴリズムの実行からなります。その結果、モデルの重みが得られます。これらは学習後のモデルパラメータであり、オープンな事前学習モデルへのアクセスに関して多くの人々が話す内容です。これらの重みは、推論(つまり、新しい入力の予測やテキストの生成など)に使用することができます。 事前学習済みLLMsは、重みが公開されると特定のタスクに特化または適応することもあります。それらは、「ファインチューニング」と呼ばれるプロセスを介して、ユースケースやアプリケーションの出発点として使用されます。ファインチューニングでは、異なる(通常はより専門化された小規模な)データセット上でモデルに追加の訓練ステップを適用して、特定のアプリケーションに最適化します。このステップには、計算パワーのコストがかかりますが、モデルをゼロから訓練するよりも財政的および環境的にはるかにコストがかかりません。これは、高品質のオープンソースの事前学習モデルが非常に興味深い理由の一つです。コミュニティが限られたコンピューティング予算しか利用できない場合でも、自由に使用し、拡張することができます。 2022年 – サイズの競争からデータの競争へ 2023年以前、コミュニティで利用可能だったオープンモデルはありましたか? 2022年初頭まで、機械学習のトレンドは、モデルが大きければ(つまり、パラメータが多ければ)、性能が良くなるというものでした。特に、特定のサイズの閾値を超えるモデルは能力が向上するという考えがあり、これらの概念はemergent abilitiesとscaling lawsと呼ばれました。2022年に公開されたオープンソースの事前学習モデルは、主にこのパラダイムに従っていました。 BLOOM(BigScience Large Open-science…

「H2O.aiとOptunaを使用した高度な予測モデリングのためのスタックアンサンブル」

私たちは皆、予測モデリングにおいてアンサンブルモデルが単一のモデルよりも優れたパフォーマンスを発揮することを知っていますおそらく、バギングやブースティングといった一般的なアンサンブル手法についてはすべて聞いたことがあるでしょうさらに、ランダムフォレストなどもよく知られています…

高度なRAGテクニック:イラスト入り概要

この投稿の目標は、利用可能なRAGアルゴリズムとテクニックの概要と説明をすることなので、コードの実装の詳細には立ち入らず、参照のみ行い、それについては放置します

トゥギャザーアイは、ShortおよびLongコンテキストの評価で最高のオープンソーストランスフォーマーに対抗する、StripedHyena-7Bという代替人工知能モデルを紹介します

AIと共に、シーケンスモデリングアーキテクチャへの大きな貢献を果たし、StripedHyenaモデルを導入しました。従来のトランスフォーマーに代わる選択肢を提供することで、計算効率とパフォーマンスを向上させることで、このフィールドを革新しました。 このリリースには、ベースモデルのStripedHyena-Hessian-7B(SH 7B)とチャットモデルのStripedHyena-Nous-7B(SH-N 7B)が含まれています。StripedHyenaは、昨年作成されたH3、Hyena、HyenaDNA、およびMonarch Mixerといった効果的なシーケンスモデリングアーキテクチャの学習からの重要な知見に基づいています。 研究者は、このモデルが長いシーケンスをトレーニング、ファインチューニング、および生成する際に、高速かつメモリ効率が向上していることを強調しています。StripedHyenaは、ゲート付き畳み込みとアテンションを組み合わせたハイエナオペレータと呼ばれるものによって、ハイブリッド技術を使用しています。また、このモデルは、強力なトランスフォーマーベースモデルと競合する初めての代替アーキテクチャです。OpenLLMリーダーボードのタスクを含むショートコンテキストのタスクでは、StripedHyenaはLlama-2 7B、Yi 7B、およびRWKV 14Bなどの最強のトランスフォーマーの代替アーキテクチャを上回っています。 このモデルは、ショートコンテキストのタスクと長いプロンプトの処理において、さまざまなベンチマークで評価されました。Project Gutenbergの書籍によるPerplexityスケーリング実験では、Perplexityが32kで飽和するか、このポイントを超えて減少することから、モデルがより長いプロンプトから情報を吸収する能力を示しています。 StripedHyenaは、アテンションとゲート付き畳み込みを組み合わせたユニークなハイブリッド構造によって効率を実現しています。研究者は、このハイブリッドデザインを最適化するために革新的な接ぎ木技術を使用したと述べており、トレーニング中にアーキテクチャの変更を可能にしました。 研究者は、StripedHyenaの重要な利点の1つは、トレーニング、ファインチューニング、および長いシーケンスの生成など、さまざまなタスクにおける高速性とメモリ効率の向上です。最適化されたTransformerベースラインモデルと比較して、StripedHyenaはFlashAttention v2とカスタムカーネルを使用して、32k、64k、および128kの行でエンドツーエンドトレーニングにおいて30%、50%、および100%以上優れています。 将来、研究者はStripedHyenaモデルでいくつかの領域で大きな進歩を遂げたいと考えています。彼らは、長いコンテキストを処理できるより大きなモデルを作成し、情報理解の限界を拡大したいと考えています。さらに、テキストや画像などのさまざまなソースからデータを処理して理解できるようにすることで、モデルの適応性を高めるためのマルチモーダルサポートを取り入れたいとしています。 最後に、StripedHyenaモデルは、ゲート付き畳み込みなどの追加計算を導入することによって、Transformerモデルに対して改善の余地を持っています。このアプローチは、線形アテンションに触発されたものであり、H3やMultiHyenaなどのアーキテクチャにおいて効果が証明されており、トレーニング中のモデルの品質を向上させ、推論効率に利点を提供します。

ボーダフォンは、AWS DeepRacerとアクセンチュアを活用して機械学習のスキルを向上させています

「ボーダフォンは、2025年までに、イノベーションを加速し、コストを削減し、セキュリティを向上させ、業務を簡素化するという目標を持ち、通信会社(テルコ)からテクノロジー企業(テックコー)への転換を行っていますこの変革に貢献するために、数千人のエンジニアが採用されていますまた、2025年までに、ボーダフォンは、グローバルな労働力の50%がソフトウェア開発に積極的に関与することを計画しています」

NexusRaven-V2をご紹介します:13B LLMは、ゼロショット機能呼び出しでGPT-4を凌駕し、ナチュラルランゲージの指示を実行可能なコードに変換する能力を持っています

<img alt=”” src=”https://ai.miximages.com/www.marktechpost.com/wp-content/uploads/2023/12/Screenshot-2023-12-12-at-12.42.47-AM-1024×623.png”/><img alt=”” src=”https://ai.miximages.com/www.marktechpost.com/wp-content/uploads/2023/12/Screenshot-2023-12-12-at-12.42.47-AM-150×150.png”/><p>LLMsは、コード関連のデータセットで微調整することができ、関数呼び出しを含むコードスニペットを生成することができます。これらのモデルは、コンテキストやプロンプトによって提供された入力に基づいて、関数呼び出しを含むコードを提案または生成することができます。言語モデルは、コードに関連するクエリや指示の自然言語理解に使用することができます。開発者は質問や説明を入力し、モデルはそれらを解釈して関連する関数呼び出しやコードセグメントを提供することができます。</p><p>LLMsは、提供されたコンテキストや部分的なコードに基づいて、関数呼び出しを提案したり関連する関数を提案したりすることによって、コード補完を支援することができます。これにより、開発者はより迅速かつ正確にコードを記述することができます。LLMsは、特定のタスクや問題の説明に基づいて、適切なAPIや手順をガイドすることで、開発者がコード内で呼び出すべき適切な関数を見つけるのを支援することができます。LLMsを開発環境に統合することで、開発者に対して関数呼び出し、パラメータのタイプ、または潜在的なエラーに対してリアルタイムのサポートを提供することができます。</p><p>Nexusflowの研究者は、オープンソースのLLMモデル、<strong><a href=”https://www.voagi.com/nexusravenv2-outperforms-gpt4-in-nexusflows-latest-battle.html”>NexusRaven-V2</a></strong>を提案しています。これは自然言語の指示を実行可能なコードに変換してツールを使用することができます。OpenAIアシスタントAPIは、コパイロットとエージェントがソフトウェアツールを使用するための鍵として機能します。NexusRaven-V2は、コパイロットとエージェントのオープンソースモデルを進化させることを目指しています。</p><p>NexusRaven-V2は、ネストや複合関数を使用する人間が生成したユースケースで、関数呼び出しの成功率でGPT-4を最大7%上回っています。NexusRavenはMetaのCodeLlama-13 Bインストラクションにチューニングされた指示です。Nexusflowのパイプラインを使用して、プロプライエタリなLLMを使用せずにオープンコードのコーポラから情報源を提供しています。コミュニティ開発者と企業の両方に対して商業許容です。</p><p>当社の人間によるベンチマークで、NexusRaven-V2は、関数呼び出しの成功率において、最新のGPT-4モデルよりも平均で4%高い成功率を示すことが観察されました。なお、ネストや複合関数呼び出しを必要とする4つの厳しいタスクでは、NexusRaven-V2の方がGPT-4よりも堅牢性が高いと言えます。また、開発者の関数の説明におけるバリエーションを処理する際にも、NexusRaven-V2はGPT-4よりも優れた性能を発揮します。</p><p>チームは、ユーザーがメインストリームのプロプライエタリな関数呼び出しAPIをシームレスにNexusRaven-V2で置き換えることができるオープンソースのユーティリティアーティファクトをリリースしました。また、オンラインデモやコラボノートブックを提供してオンボーディングと統合デモを行っています。彼らは評価ベンチマーク<a href=”https://www.voagi.com/call-all-functions.html”>Nexus-Function-Calling</a>をオープンソース化し、Huggingfaceの<a href=”https://www.voagi.com/create-and-analyze-advanced-machine-learning-models-using-the-sagemaker-canvas-model-leaderboard.html”>リーダーボード</a>を確立しています。このリーダーボードには、さまざまな関数呼び出しのユースケースと難易度をカバーした、実生活で人間が選定した関数呼び出しの例が多数収録されています。</p><p>将来的には、関数呼び出しのLLMは教育現場において、学習者がリアルタイムのサポートを受けながら関数の呼び出し方を正しく学び、プログラミングの概念の理解を促進することができるでしょう。</p>

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.