Learn more about Search Results インテル

- You may be interested

- 「製造環境では、なぜあなたのラグは信頼...

- ゲーム開発のためのAI:5日間で農業ゲーム...

- 「Amazon SageMakerを使用して、Llama 2モ...

- 希望、恐怖、そしてAI:AIツールに対する...

- 「LinkedInプロフィールでコールバック率...

- 何が合成データとは?その種類、機械学習...

- 欧州とイスラエルのAIファーストスタート...

- UCLAとCMUの研究者が、優れた中程度範囲の...

- データの変形:データザウルス・ダズンを...

- このAI研究は、「Atom」という低ビット量...

- データサイエンティストの成長を助けるスキル

- 「UnbodyとAppsmithを使って、10分でGoogl...

- マイクロソフトと清華大学の研究者は、「S...

- 「Hugging Faceを使用してAmazon SageMake...

- vLLMについて HuggingFace Transformersの...

インテルの研究者たちは、CPU上でLLMs(Large Language Models)をより効率的に展開するための新しい人工知能のアプローチを提案しています

大型言語モデル(LLM)は、その驚異的なパフォーマンスと多様なタスクでの潜在能力により、世界中で話題となっています。テキスト生成、言語理解、テキスト要約などの能力でよく知られています。ただし、これらのモデルの広範な採用の一方で、モデルパラメータの膨大なサイズにより、推論には大きなメモリ容量と専用のハードウェアが必要であり、これまでこれらのモデルの展開は非常に困難でした。 推論に必要な計算能力を削減する方法の一つは、量子化手法を使用することです。つまり、人工ニューラルネットワークの重みと活性化関数の精度を低下させることです。INT8や重みのみの量子化など、推論コストを改善するための方法はいくつかありますが、これらの方法は一般的にCUDAに最適化されており、必ずしもCPU上で動作するわけではありません。 このIntelの研究論文の著者は、LLMを効率的にCPU上に展開する方法を提案しています。彼らのアプローチは、自動INT-4重みのみの量子化(低精度がモデルの重みにのみ適用され、活性化関数の精度は高く保たれます)のフローをサポートしています。また、CPU上の推論プロセスを加速する高度に最適化されたカーネルを持つ特定のLLMランタイムも設計しています。 量子化フローは、Intel Neural Compressorをベースに開発され、異なる量子化レシピ、粒度、グループサイズでのチューニングが可能で、精度目標を満たすINT4モデルを生成することができます。モデルはその後、LLMランタイムに渡され、量子化モデルのパフォーマンスを評価するために設計された特殊環境で評価されます。このランタイムは、CPU上のLLMの効率的な推論を提供するために設計されています。 実験では、研究者たちはパラメータサイズが異なる人気のあるLLMをいくつか選びました(7Bから20Bまで)。オープンソースのデータセットを使用してFP32モデルとINT4モデルのパフォーマンスを評価しました。選択したデータセット上での量子化モデルの精度は、FP32モデルとほぼ同等であることが観察されました。さらに、次のトークン生成のレイテンシの比較分析を行い、LLMランタイムがggmlベースのソリューションよりも最大1.6倍優れていることがわかりました。 結論として、この研究論文は、LLMに関連する最大の課題の1つであるCPU上での推論に対する解決策を提案しています。従来、これらのモデルはGPUのような専用ハードウェアが必要であり、多くの組織にとって利用できない状況でした。この論文では、INT4モデルの量子化と専用のLLMランタイムを提供することで、CPU上のLLMの効率的な推論を実現しています。人気のあるLLMの一連の評価では、この手法はggmlベースのソリューションに比べて優位性を示し、FP32モデルと同等の精度を提供します。ただし、今後の改善の余地もあり、研究者はAI生成コンテンツの成長する需要に対応するために、PC上での生成型AIを強化する計画です。

「ダウンフォール」の欠陥が世代を超えたインテルチップで貴重なデータを公開します

「脆弱性によって、攻撃者は情報漏えいを利用して、個人メッセージ、パスワード、暗号化キーなどの機密情報を盗むことが可能となるかもしれません」

「インテルCPU上での安定したディフューションモデルのファインチューニング」

拡散モデルは、テキストのプロンプトから写真のようなリアルな画像を生成するというその驚異的な能力によって、生成型AIの普及に貢献しました。これらのモデルは現在、合成データの生成やコンテンツ作成などの企業のユースケースに取り入れられています。Hugging Faceハブには、5,000以上の事前学習済みのテキストから画像へのモデルが含まれています。Diffusersライブラリと組み合わせることで、実験や画像生成ワークフローの構築がこれまで以上に簡単になりました。 Transformerモデルと同様に、Diffusionモデルをファインチューニングしてビジネスニーズに合ったコンテンツを生成することができます。初期のファインチューニングはGPUインフラストラクチャー上でのみ可能でしたが、状況は変わってきています!数か月前、インテルはSapphire Rapidsというコードネームの第4世代のXeon CPUを発売しました。Sapphire Rapidsは、ディープラーニングワークロードのための新しいハードウェアアクセラレータであるIntel Advanced Matrix Extensions (AMX)を導入しています。私たちはすでにいくつかのブログ記事でAMXの利点を実証しています:NLP Transformerのファインチューニング、NLP Transformerの推論、およびStable Diffusionモデルの推論。 この投稿では、Intel Sapphire Rapids CPUクラスター上でStable Diffusionモデルをファインチューニングする方法を紹介します。わずかな例の画像のみを必要とするテキスト反転という技術を使用します。たった5つの画像だけです! さあ、始めましょう。 クラスターのセットアップ Intelの友人たちが、最新のIntelプロセッサとパフォーマンス最適化されたソフトウェアスタックを使用したIntel®最適化デプロイメント環境でのワークロードの開発と実行を行うためのサービスプラットフォームであるIntel Developer Cloud(IDC)にホストされた4つのサーバーを提供してくれました。 各サーバーには、2つのIntel…

インテルのサファイアラピッズを使用してPyTorch Transformersを高速化する – パート1

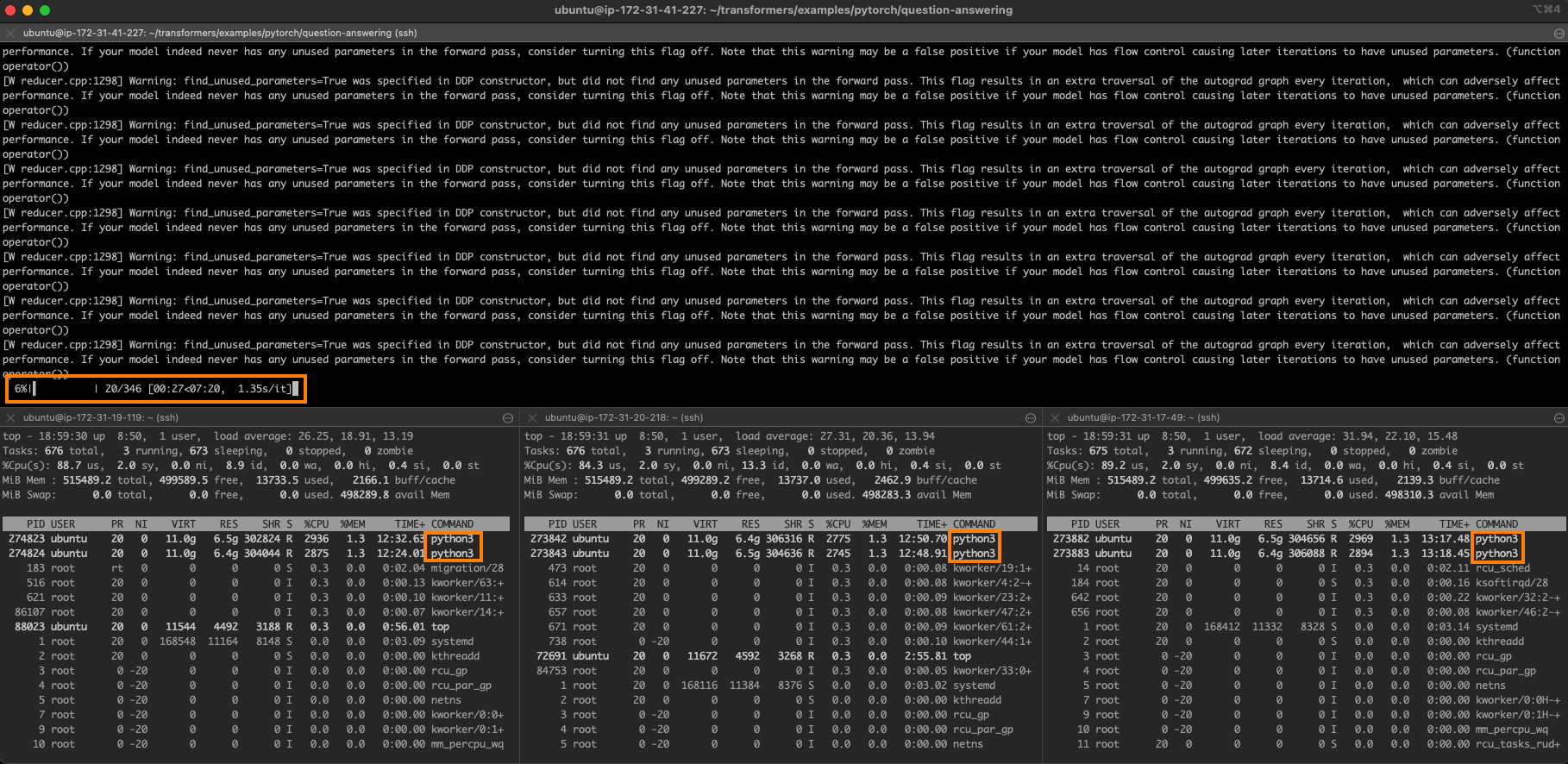

約1年前、私たちはHugging Faceのtransformersをクラスターまたは第3世代のIntel Xeon Scalable CPU(別名:Ice Lake)でトレーニングする方法を紹介しました。最近、Intelは第4世代のXeon CPUであるSapphire Rapidsというコードネームの新しいCPUを発売しました。このCPUには、深層学習モデルでよく見られる操作を高速化するエキサイティングな新しい命令があります。 この投稿では、AWS上で実行するSapphire Rapidsサーバーのクラスターを使用して、PyTorchトレーニングジョブの処理を高速化する方法を学びます。ジョブの分散にはIntelのoneAPI Collective Communications Library(CCL)を使用し、新しいCPU命令を自動的に活用するためにIntel Extension for PyTorch(IPEX)ライブラリを使用します。両方のライブラリはすでにHugging Face transformersライブラリと統合されているため、コードの1行も変更せずにサンプルスクリプトをそのまま実行できます。 次の投稿では、Sapphire Rapids CPU上での推論とそれによるパフォーマンス向上について説明します。 CPUでのトレーニングを検討すべき理由 Intel Xeon…

「RustコードのSIMD高速化のための9つのルール(パート2)」

SIMDを使用してRustコードを高速化するための9つの基本ルールを探求してくださいcoresimdについて学び、最適化技術を学びながらパフォーマンスを7倍に向上させましょう

「RAGAsを使用したRAGアプリケーションの評価」

「PythonにおいてRAGAsフレームワークを使って、検索および生成コンポーネントを個別に評価するための検索強化生成(RAG)システムの評価」

「OpenAIやLM Studioに頼らずにAutoGenを使用する方法」

イントロダクション OpenAIやLMスタジオに頼らずに、あなた自身のAIチームを作成する準備はできていますか?もはや銀行を荒らすことも、アプリをダウンロードすることもありません。llama-cpp-pythonの設定から、autogenフレームワークのヘルプを借りてローカルLLMのパワーを探求するまで。OpenAI APIに依存せず、Autogenのフルポテンシャルを引き出す準備をしましょう。 学習目標 詳細に入る前に、この記事の主な学習目標を概説しましょう: さまざまなAIライブラリとツールを評価・比較する方法を学ぶ。 llama-cpp-pythonがOpenAI APIの代替として提供できる方法を探索する。 2つの現実世界の使用例で獲得した知識を適用する: アルゴリズムメンターチームの構築と金融チャート生成の自動化。 AutoGenの改善されたユーザーエクスペリエンスを探索し、統合されたIPythonを通じて即時のコード実行結果を得る。 この記事はData Science Blogathonの一環として公開されました。 ツール紹介: llama-cpp-python、AutoGen、およびローカルLLM しかし、このテックツールキットの特別な点は何でしょうか? llama-cpp-pythonは、LLMAのような有名なモデルを含めて、ローカルでLLMを実行するためのゲートウェイです。コンピュータ上にAIのスーパースターがいるようなもので、さまざまなBLASバックエンドのサポートにより、速度は驚異的です! AutoGen AutoGenは、基盤モデルを使用するための高レベルな抽象化として機能する統一されたマルチエージェント会話フレームワークです。LLM、ツール、および人間の参加者を統合し、自動化されたチャットを通じて能力のある、カスタマイズ可能で会話形式のエージェントを結合します。エージェント同士が自律的にコミュニケーションして共同作業を行うことができ、複雑なタスクを効率的に進めることやワークフローを自動化することが可能です。 もしAutoGenの機能をより深く探求し、戦略的なAIチームビルディングをどのように支援するかを調べることに興味があるなら、当社の専用ブログ「Strategic AI Team Building…

ムーブワークスのCEO兼創業者であるBhavin Shah—シリコンバレーの起業の旅、AIのスケーリングの課題、イノベーション文化、戦略的パートナーシップ、規制上のハードルの克服、ユーザーとのAIとの対話、エンタープライズの将来のビジョン

この洞察に富んだインタビューでは、MoveworksのCEO兼創設者であるBhavin Shahの起業の旅を探索します Bhavinは、シリコンバレーのルーツに深く立ち入り、初期の経験(特にSteve Wozniakとの思い出深い出会い)がMoveworksの創設への道を築いた様子を詳しく説明していますこの会話は彼のキャリアのさまざまな段階をたどります... MoveworksのCEO兼創設者であるBhavin Shah — シリコンバレー、起業の旅、AIのスケーリングの挑戦、イノベーション文化、戦略的パートナーシップ、規制のハードルの克服、ユーザーAIインタラクション、エンタープライズの未来のビジョン 読む 更に »

「OpenAIモデルに対するオープンソースの代替手段の探索」

序文 AIの領域では、11月はドラマチックな展開がありました。GPTストアやGPT-4-turboのローンチ、そしてOpenAIの騒動まで、まさに忙しい一ヶ月でした。しかし、ここで重要な問題が浮かび上がります:クローズドモデルとその背後にいる人々はどれだけ信頼できるのでしょうか?自分が実際に運用しているモデルが内部の企業ドラマに巻き込まれて動作停止するのは快適な体験とは言えません。これはオープンソースモデルでは起こらない問題です。展開するモデルには完全な管理権限があります。データとモデルの両方に対して主権を持っています。しかし、OSモデルをGPTと置き換えることは可能でしょうか?幸いなことに、既に多くのオープンソースモデルが、GPT-3.5モデル以上の性能を発揮しています。本記事では、オープンソースのLLM(Large Language Models)およびLMM(Large Multi-modal Models)の最高の代替品をいくつか紹介します。 学習目標 オープンソースの大規模言語モデルについての議論。 最新のオープンソース言語モデルとマルチモーダルモデルについての探求。 大規模言語モデルを量子化するための簡易な導入。 LLMをローカルおよびクラウド上で実行するためのツールやサービスについて学ぶ。 この記事は、データサイエンスブログマラソンの一環として公開されました。 オープンソースモデルとは何ですか モデルがオープンソースと呼ばれるのは、モデルの重みとアーキテクチャが自由に利用できる状態にあるからです。これらの重みは、例えばMeta’s Llamaのような大規模言語モデルの事前訓練パラメータです。これらは通常、ファインチューニングされていないベースモデルやバニラモデルです。誰でもこれらのモデルを使用し、カスタムデータでファインチューニングして下流のアクションを実行することができます。 しかし、それらはオープンなのでしょうか?データはどうなっているのでしょうか?多くの研究所は、著作権に関する懸念やデータの機密性の問題などの理由から、ベースモデルの訓練データを公開しません。これはまた、モデルのライセンスに関する部分にも関連しています。すべてのオープンソースモデルは、他のオープンソースソフトウェアと同様のライセンスが付属しています。Llama-1などの多くのベースモデルは非商用ライセンスとなっており、これらのモデルを利用して収益を上げることはできません。しかし、Mistral7BやZephyr7Bなどのモデルは、Apache-2.0やMITライセンスが付属しており、どこでも問題なく使用することができます。 オープンソースの代替品 Llamaのローンチ以来、オープンソースの領域ではOpenAIモデルに追いつこうとする競争が繰り広げられています。そしてその結果は今までにないものでした。GPT-3.5のローンチからわずか1年で、より少ないパラメータでGPT-3.5と同等またはそれ以上のパフォーマンスを発揮するモデルが登場しました。しかし、GPT-4は依然として理性や数学からコード生成までの一般的なタスクには最も優れたモデルです。オープンソースモデルのイノベーションと資金調達のペースを見ると、GPT-4のパフォーマンスに近づくモデルが間もなく登場するでしょう。とりあえず、これらのモデルの素晴らしいオープンソースの代替品について話しましょう。 Meta’s Llama 2 Metaは今年7月にLlama-2という彼らの最高のモデルをリリースし、その印象的な能力により一瞬で人気を集めました。MetaはLlama-7b、Llama-13b、Llama-34b、Llama-70bの4つの異なるパラメータサイズのLlama-2モデルをリリースしました。これらのモデルは、それぞれのカテゴリにおいて他のオープンモデルを上回る性能を発揮しました。しかし、現在ではmistral-7bやZephyr-7bのような複数のモデルが、多くのベンチマークで小さなLlamaモデルを上回る性能を発揮しています。Llama-2 70bはまだそのカテゴリーで最高のモデルの一つであり、要約や機械翻訳などのタスクにおいてGPT-4の代替モデルとして価値があります。 Llama-2はGPT-3.5よりも多くのベンチマークで優れたパフォーマンスを発揮し、GPT-4に迫ることもできました。以下のグラフは、AnyscaleによるLlamaとGPTモデルのパフォーマンス比較です。…

アップル M2 Max GPU vs Nvidia V100、P100、およびT4

「Apple Silicon M2 MaxのGPU性能を、TensorFlowを使用して、MLP、CNN、およびLSTMモデルのトレーニングにおいて、Nvidia V100、P100、およびT4と比較します」

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.