Learn more about Search Results アダプタ

- You may be interested

- 大規模な言語モデルは本当に数学をできる...

- Orca LLM:ChatGPTの推論プロセスをシミュ...

- Pythonを使用したビデオ内の深さに配慮し...

- 「ウェアラブルデータによるコロナ感染予測」

- 事前トレーニングのコンテキストがすべて...

- AIにおけるエキスパートの混合(MoE)モデ...

- クッキージャーで手を捕まれた:GPT4が私...

- 最高のAIジョブコース(2023年)

- ホワイトキャッスルへようこそそれに人と...

- WAYVE社がGAIA-1を発表:ビデオ、テキスト...

- 倉庫業務の変革:AIと自動化の力を活用する

- 「AIに友達になる」

- 「ヘルスケアとゲノミクス産業が機械学習...

- 「エンジニアたちが、心臓の右室のロボッ...

- 「大規模言語モデルの読み込みについての...

コンセプトスライダー:LoRAアダプタを使用した拡散モデルの正確な制御

彼らの能力のおかげで、テキストから画像への変換モデルは芸術コミュニティで非常に人気がありますただし、現在のモデル、最先端のフレームワークを含めて、生成された画像の視覚的な概念や属性をコントロールするのは難しく、満足のいく結果を得ることができませんほとんどのモデルはテキストのプロンプトにのみ依存しており、継続的な属性の制御に課題があります[…]

「Llama 2に複数のLoRAアダプタを組み合わせる」

「この記事では、複数のLoRAアダプタを1つのマルチタスクアダプタに組み合わせる方法を紹介します非常に簡単で、結果のアダプタは組み合わせに使用されるアダプタと同じくらい優れていることがわかります」

「ボトルネックアダプタを使用した効率的なモデルの微調整」

「ファインチューニングは、特定のタスクで深層学習モデルのパフォーマンスを向上させるために行うことができる最も一般的な方法の一つです通常、モデルをファインチューニングするために必要な時間は...」

UCバークレーとスタンフォードの研究者チームがS-LoRAを発表:多数のLoRAアダプターのスケーラブルな提供のために設計された人工知能システム

UC BerkeleyおよびStanfordの研究者チームは、LLMの展開において新たなパラメータ効率の良いファインチューニング手法であるLow-Rank Adaptation (LoRA)を開発しました。S-LoRAは、多数のLoRAアダプターの効率的な展開を可能にするために設計されました。S-LoRAは、単一のGPU上または複数のGPU上で数千のアダプターを最小限のオーバヘッドで実行できるようにします。この手法は統合ページングを導入し、GPUメモリの使用を最適化し、新しいテンソル並列処理と異種バッチ処理のためのカスタムCUDAカーネルを利用します。これらの技術により、実世界のアプリケーションでのLLMの展開における計算要件が大幅に削減されます。 LoRAは、事前学習されたLLMを新しいタスクにカスタマイズするための非常に効率的なファインチューニング手法であり、高い精度を保ちながら学習可能なパラメータの数を劇的に減らします。LLMに対するLoRAの採用は広範であり、無数のLoRAアダプターがLLMや拡散モデルのために作成されています。現代のアプリケーションでは、LLMが様々なドメインとタスクに対応して普及しています。 現代のアプリケーションでは、LLMが広範に活用されており、事前学習後のファインチューニング手法により、特定のタスクやドメインにカスタマイズされた1つの基本LLMの複数のファインチューニングバージョンが作成されています。LoRAは、高い精度を維持しながら学習可能なパラメータの数を大幅に減らすことで、事前学習されたLLMを新しいタスクに合わせたファインチューニング手法です。 S-LoRAは、広範なタスクに対して基本モデルを効率的にファインチューニングし、1つのモデルから多数のLoRAアダプターを生成するためにLoRAを活用します。Unified Pagingを導入し、統一メモリプール内で動的なアダプターウェイトとKVキャッシュテンソルを管理することで、GPUメモリの使用を最適化します。S-LoRAは、最小限のオーバヘッドで数千のLoRAアダプターを提供することができます。この手法はスループットを4倍向上させ、HuggingFace PEFTやvLLMなどの主要なライブラリと比較してサポートされるアダプターの数を大幅に拡大することができます。 S-LoRAは最小限のオーバヘッドで2,000のアダプターを同時に処理し、低い計算コストを維持します。1つのアダプターに対してvLLM-packedと比較して最大4倍、PEFTと比較して最大30倍のパフォーマンスを発揮し、大幅なアダプター数をサポートします。S-LoRAは、スループットとレイテンシーにおいて、S-LoRA-bmmとS-LoRA-no-unifymemを上回り、メモリプールとカスタムカーネルの効果を強調しています。このシステムのスケーラビリティは、利用可能なメインメモリによって主に制限されており、実世界のワークロードに対して堅牢なパフォーマンスを実現しています。S-LoRAの素晴らしい能力により、さまざまなタスクに大規模な言語モデルを適応するための強力なソリューションとなります。 この研究は、量子化、疎化、およびモデルアーキテクチャの改善などの最適化手法を調査することでパフォーマンスを向上させることを目的としています。基本モデルとアダプターの両方に分解計算技術を実装し、強化されたサポートのためのカスタムCUDAカーネルの開発も検討しています。また、LLMの提供における自己回帰的な特徴とパラメータ効率の良いアダプターへの取り組みも含まれており、現在のモデル提供システムにおける最適化のギャップを特定し、埋めることを目指しています。 まとめとして、S-LoRAはメモリの断片化に対抗するために統合ページングを導入し、バッチサイズの増加とスケーラビリティの向上を実現しました。この研究では、従来未踏のスケールでのファインチューニングバリアントの提供という課題に対処したスケーラブルなLoRAの提供ソリューションを紹介しています。量子化、疎化、モデルアーキテクチャのようなアルゴリズム技術によるLoRAの提供の最適化も行われ、システムレベルの改善を補完しています。

「T2Iアダプタを使用した効率的で制御可能なSDXL生成」

T2I-Adapterは、オリジナルの大規模なテキストから画像へのモデルを凍結しながら、事前学習されたテキストから画像へのモデルに追加のガイダンスを提供する効率的なプラグアンドプレイモデルです。T2I-Adapterは、T2Iモデル内部の知識を外部の制御信号と整合させます。さまざまな条件に応じてさまざまなアダプタをトレーニングし、豊富な制御と編集効果を実現することができます。 ControlNetは同様の機能を持ち、広く使用されている現代の作業です。しかし、実行するには計算コストが高い場合があります。これは、逆拡散プロセスの各ノイズ除去ステップで、ControlNetとUNetの両方を実行する必要があるためです。さらに、ControlNetは制御モデルとしてUNetエンコーダのコピーを重要視しており、パラメータ数が大きくなるため、生成はControlNetのサイズによって制約されます(サイズが大きければそれだけプロセスが遅くなります)。 T2I-Adapterは、この点でControlNetに比べて競争力のある利点を提供します。T2I-Adapterはサイズが小さく、ControlNetとは異なり、T2I-Adapterはノイズ除去プロセス全体の間ずっと一度だけ実行されます。 過去数週間、DiffusersチームとT2I-Adapterの著者は、diffusersでStable Diffusion XL(SDXL)のT2I-Adapterのサポートを提供するために協力してきました。このブログ記事では、SDXLにおけるT2I-Adapterのトレーニング結果、魅力的な結果、そしてもちろん、さまざまな条件(スケッチ、キャニー、ラインアート、深度、およびオープンポーズ)でのT2I-Adapterのチェックポイントを共有します。 以前のバージョンのT2I-Adapter(SD-1.4/1.5)と比較して、T2I-Adapter-SDXLはまだオリジナルのレシピを使用しており、79Mのアダプタで2.6BのSDXLを駆動しています!T2I-Adapter-SDXLは、強力な制御機能を維持しながら、SDXLの高品質な生成を受け継いでいます。 diffusersを使用してT2I-Adapter-SDXLをトレーニングする 私たちは、diffusersが提供する公式のサンプルを元に、トレーニングスクリプトを作成しました。 このブログ記事で言及するT2I-Adapterモデルのほとんどは、LAION-Aesthetics V2からの3Mの高解像度の画像テキストペアで、以下の設定でトレーニングされました: トレーニングステップ:20000-35000 バッチサイズ:データ並列、単一GPUバッチサイズ16、合計バッチサイズ128。 学習率:定数学習率1e-5。 混合精度:fp16 コミュニティには、スピード、メモリ、品質の間で競争力のあるトレードオフを打つために、私たちのスクリプトを使用してカスタムでパワフルなT2I-Adapterをトレーニングすることをお勧めします。 diffusersでT2I-Adapter-SDXLを使用する ここでは、ラインアートの状態を例にとって、T2I-Adapter-SDXLの使用方法を示します。まず、必要な依存関係をインストールします: pip install -U git+https://github.com/huggingface/diffusers.git pip install…

「LoRAアダプターにダイブ」

「大規模言語モデル(LLM)は世界中で大流行しています過去の1年間では、彼らができることにおいて莫大な進歩を目撃してきましたそれまではかなり限定的な用途にとどまっていましたが、今では…」

テンセントAIラボの研究者たちは、テキスト対応の画像プロンプトアダプタ「IP-Adapter」を開発しました:テキストから画像への拡散モデルのためのアダプタです

「リンゴ」と言えば、あなたの頭にすぐにリンゴのイメージが浮かびます。私たちの脳の働き方が魅力的であるように、生成AIも同じレベルの創造性とパワーをもたらし、機械が私たちがオリジナルコンテンツと呼ぶものを作り出すことができるようになりました。最近では、非常にリアルな画像を作成するテキストから画像へのモデルが登場しています。モデルに「リンゴ」とフィードすると、さまざまな種類のリンゴの画像を得ることができます。 しかし、これらのモデルがテキストのプロンプトだけで正確に私たちが望むものを生成することは非常に困難です。通常、適切なプロンプトの慎重な作成を必要とします。これを行う別の方法は、画像のプロンプトを利用することです。現在の既存のモデルから直接的にモデルを洗練するための技術は成功していますが、大量の計算能力を必要とし、異なる基礎モデル、テキストプロンプト、構造の調整との互換性が欠けています。 制御可能な画像生成の最近の進歩は、テキストから画像への拡散モデルのクロスアテンションモジュールに関する懸念を浮き彫りにしています。これらのモジュールは、事前学習済みの拡散モデルのクロスアテンションレイヤーでキーと値のデータを射影するために調整されたウェイトを使用し、主にテキストの特徴に最適化されています。そのため、このレイヤーで画像とテキストの特徴を統合すると、画像の特異な詳細が無視される可能性があり、参照画像を利用する際に生成中の広範な制御(たとえば、画像のスタイルの管理)につながることがあります。 上記の画像では、右側の例は画像のバリエーション、マルチモーダル生成、および画像プロンプトによる埋め込みの結果を示しており、左側の例は画像プロンプトと追加の構造条件による制御可能な生成の結果を示しています。 研究者たちは、現在の方法によって引き起こされる課題に対処するために、効果的な画像プロンプトアダプターであるIP-Adapterを導入しました。IP-Adapterは、テキストと画像の特徴を処理するための別個のアプローチを使用します。拡散モデルのUNetに、画像の特徴に特化した追加のクロスアテンションレイヤーを追加しました。トレーニング中、新しいクロスアテンションレイヤーの設定を調整し、元のUNetモデルを変更せずに残します。このアダプターは効率的でありながら強力です。たった2200万のパラメーターでも、IPアダプターはテキストから画像への拡散モデルから派生した完全に微調整された画像プロンプトモデルと同じくらい良い画像を生成することができます。 その研究結果は、IP-Adapterが再利用可能かつ柔軟であることを証明しています。ベースの拡散モデルでトレーニングされたIP-Adapterは、同じベースの拡散モデルから微調整された他のカスタムモデルに一般化することができます。さらに、IP-AdapterはControlNetなどの他の制御アダプターとも互換性があり、画像プロンプトと構造制御の容易な組み合わせが可能です。別個のクロスアテンション戦略のおかげで、画像プロンプトはテキストプロンプトと並行して動作し、マルチモーダルな画像を作成します。 上記の画像は、IP-Adapterを他の方法と比較した場合の異なる構造条件を示しています。IP-Adapterの効果的な性能にもかかわらず、それはコンテンツとスタイルで参照画像に似た画像しか生成できません。言い換えれば、テキスト逆転やドリームブースなどの既存の方法のように、与えられた画像の主題と非常に一致した画像を合成することはできません。将来的には、研究者は一貫性を高めるために、より強力な画像プロンプトアダプターを開発することを目指しています。

「プラットプス:データセットのキュレーションとアダプターによる大規模言語モデルの向上」

「メタのラマ2は1か月前にリリースされ、多くの人が特定のタスクに合わせて微調整に取り組んでいます同様の傾向で、ボストン大学はプラットプス(Lee et al., 2023)を提案していますこれはLlama 2を微調整したものです...」

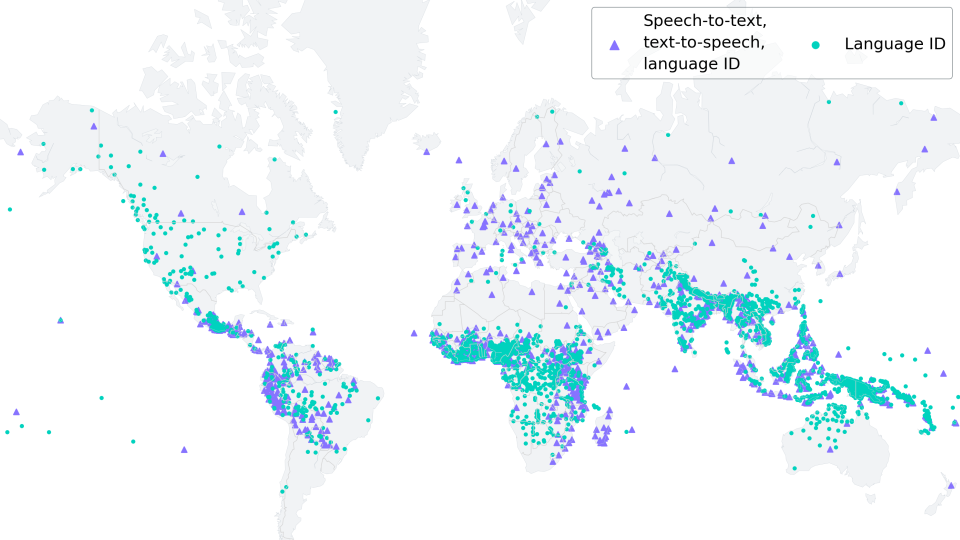

低リソースASRのためのMMSアダプターモデルの微調整

新しい(06/2023):このブログ記事は、「多言語ASRでのXLS-Rの微調整」に強く触発され、それの改良版として見なされるものです。 Wav2Vec2は、自動音声認識(ASR)のための事前学習モデルであり、Alexei Baevski、Michael Auli、およびAlex Conneauによって2020年9月にリリースされました。Wav2Vec2の強力なパフォーマンスが、ASRの最も人気のある英語データセットであるLibriSpeechで示された直後、Facebook AIはWav2Vec2の2つのマルチリンガルバージョンであるXLSRとXLM-Rを発表しました。これらのモデルは128の言語で音声を認識することができます。XLSRはクロスリンガル音声表現を意味し、モデルが複数の言語で有用な音声表現を学習する能力を指します。 Meta AIの最新リリースであるMassive Multilingual Speech(MMS)(Vineel Pratap、Andros Tjandra、Bowen Shiなどによる)は、マルチリンガル音声表現を新たなレベルに引き上げています。1,100以上の話されている言語が識別、転写、生成され、さまざまな言語識別、音声認識、テキスト読み上げのチェックポイントがリリースされます。 このブログ記事では、MMSのアダプタートレーニングが、わずか10〜20分の微調整後でも驚くほど低い単語エラーレートを達成する方法を示します。 低リソース言語の場合、私たちは「多言語ASRでのXLS-Rの微調整」と同様にモデル全体を微調整するのではなく、MMSのアダプタートレーニングの使用を強くお勧めします。 私たちの実験では、MMSのアダプタートレーニングはメモリ効率がよく、より堅牢であり、低リソース言語に対してはより優れたパフォーマンスを発揮することがわかりました。ただし、VoAGIから高リソース言語への場合は、Adapterレイヤーの代わりにモデル全体のチェックポイントを微調整する方が依然として有利です。 世界の言語多様性の保存 https://www.ethnologue.com/によると、約3000の「生きている」言語のうち、40%、つまり約1200の言語が、話者が減少しているために危機に瀕しています。このトレンドはますますグローバル化する世界で続くでしょう。 MMSは、アリ語やカイビ語など、絶滅危惧種である多くの言語を転写することができます。将来的には、MMSは、残された話者が母国語での記録作成やコミュニケーションをサポートすることで、言語を生き続けるために重要な役割を果たすことができます。 1000以上の異なる語彙に適応するために、MMSはアダプターを使用します。アダプターレイヤーは言語間の知識を活用し、モデルが別の言語を解読する際に役立つ役割を果たします。 MMSの微調整 MMSの非監視チェックポイントは、1400以上の言語で300万〜10億のパラメータを持つ、50万時間以上のオーディオで事前学習されました。 事前学習のためのモデルサイズ(300Mおよび1B)の事前学習のみのチェックポイントは、🤗 Hubで見つけることができます:…

「2023年、オープンLLMの年」

2023年には、大型言語モデル(Large Language Models、LLMs)への公衆の関心が急増しました。これにより、多くの人々がLLMsの定義と可能性を理解し始めたため、オープンソースとクローズドソースの議論も広範な聴衆に届くようになりました。Hugging Faceでは、オープンモデルに大いに興味を持っており、オープンモデルは研究の再現性を可能にし、コミュニティがAIモデルの開発に参加できるようにし、モデルのバイアスや制約をより簡単に評価できるようにし、チェックポイントの再利用によってフィールド全体の炭素排出量を低減するなど、多くの利点があります(その他の利点もあります)。 では、オープンLLMsの今年を振り返ってみましょう! 文章が長くなりすぎないようにするために、コードモデルには触れません。 Pretrained Large Language Modelの作り方 まず、大型言語モデルはどのようにして作られるのでしょうか?(もし既に知っている場合は、このセクションをスキップしてもかまいません) モデルのアーキテクチャ(コード)は、特定の実装と数学的な形状を示しています。モデルのすべてのパラメータと、それらが入力とどのように相互作用するかがリストとして表されます。現時点では、大部分の高性能なLLMsは「デコーダーのみ」トランスフォーマーアーキテクチャのバリエーションです(詳細は元のトランスフォーマーペーパーをご覧ください)。訓練データセットには、モデルが訓練された(つまり、パラメータが学習された)すべての例と文書が含まれています。したがって、具体的には学習されたパターンが含まれます。ほとんどの場合、これらの文書にはテキストが含まれており、自然言語(例:フランス語、英語、中国語)、プログラミング言語(例:Python、C)またはテキストとして表現できる構造化データ(例:MarkdownやLaTeXの表、方程式など)のいずれかです。トークナイザは、訓練データセットからテキストを数値に変換する方法を定義します(モデルは数学的な関数であり、したがって入力として数値が必要です)。トークン化は、テキストを「トークン」と呼ばれるサブユニットに変換することによって行われます(トークン化方法によっては単語、サブワード、または文字になる場合があります)。トークナイザの語彙サイズは、トークナイザが知っている異なるトークンの数を示しますが、一般的には32kから200kの間です。データセットのサイズは、これらの個々の「原子論的」単位のシーケンスに分割された後のトークンの数としてよく測定されます。最近のデータセットのサイズは、数千億から数兆のトークンに及ぶことがあります!訓練ハイパーパラメータは、モデルの訓練方法を定義します。新しい例ごとにパラメータをどれだけ変更すべきですか?モデルの更新速度はどのくらいですか? これらのパラメータが選択されたら、モデルを訓練するためには1)大量の計算パワーが必要であり、2)有能な(そして優しい)人々が訓練を実行し監視する必要があります。訓練自体は、アーキテクチャのインスタンス化(訓練用のハードウェア上での行列の作成)および上記のハイパーパラメータを使用して訓練データセット上の訓練アルゴリズムの実行からなります。その結果、モデルの重みが得られます。これらは学習後のモデルパラメータであり、オープンな事前学習モデルへのアクセスに関して多くの人々が話す内容です。これらの重みは、推論(つまり、新しい入力の予測やテキストの生成など)に使用することができます。 事前学習済みLLMsは、重みが公開されると特定のタスクに特化または適応することもあります。それらは、「ファインチューニング」と呼ばれるプロセスを介して、ユースケースやアプリケーションの出発点として使用されます。ファインチューニングでは、異なる(通常はより専門化された小規模な)データセット上でモデルに追加の訓練ステップを適用して、特定のアプリケーションに最適化します。このステップには、計算パワーのコストがかかりますが、モデルをゼロから訓練するよりも財政的および環境的にはるかにコストがかかりません。これは、高品質のオープンソースの事前学習モデルが非常に興味深い理由の一つです。コミュニティが限られたコンピューティング予算しか利用できない場合でも、自由に使用し、拡張することができます。 2022年 – サイズの競争からデータの競争へ 2023年以前、コミュニティで利用可能だったオープンモデルはありましたか? 2022年初頭まで、機械学習のトレンドは、モデルが大きければ(つまり、パラメータが多ければ)、性能が良くなるというものでした。特に、特定のサイズの閾値を超えるモデルは能力が向上するという考えがあり、これらの概念はemergent abilitiesとscaling lawsと呼ばれました。2022年に公開されたオープンソースの事前学習モデルは、主にこのパラダイムに従っていました。 BLOOM(BigScience Large Open-science…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.