「大規模な言語モデルの探索-パート3」

大規模な言語モデルの探索-パート3

ファインチューニング、モデルの量子化、低ランクアダプター、インストラクションチューニング、およびLLMを使用してトレーニングデータを生成する

この記事は主に自己学習のために書かれています。そのため、広範で深い内容になっています。興味のある部分をスキップしたり、自分に関心のある領域を探したりしても構いません。

以下は、LLMのファインチューニングを試みながら私が興味を持ったり思いついたりしたいくつかの質問です。この記事はこれらの質問に答える試みであり、この情報を他の興味を持っている人々と共有することを目指しています。

LLMはニューラルネットと損失関数に基づいているので、LLMのすべてのトレーニングは教師ありトレーニングではありませんか?なぜ通常、教師なしトレーニングと呼ばれるのですか?実際のLLMのトレーニングの仕組みを短い文で説明できますか?マスクされたLMと因果LMとは何ですか?Transformer Architectureの背後にあるアイデアを1枚の図で説明できますか?LLMの教師なしトレーニングとは具体的に何を意味するのですか?ChatGPTの主なアーキテクトであるイリヤ・スヴェルスカー氏は、教師なしトレーニングを機械学習の聖杯と考えているのはなぜですか?LLMの出現/理解とは何を意味するのですか?

LLMのユースケースは何ですか?なぜLLMは生産性アシスタントとして最適ですか?情報検索のためのベクトルDB/埋め込みパターンとは何ですか?LLMはテキスト以外のタスクに使用できますか?因果推論とは何ですか?LLMの問題は何ですか?Yan LeCun氏のような人々はなぜ現在のLLMは無望だと考えているのですか?LLMは説明可能ですか?もし説明不可能ならどのように効果的に使用できますか?

- 強化学習:SARSAとQ-Learning – 第3部

- 「完璧なコンビ:adidasとCovision MediaがAIとNVIDIA RTXを使用して写真のようなリアルな3Dコンテンツを作成」

- ローカルマシン上でGenAI LLMsのパワーを解放しましょう!

なぜLLMをファインチューニング/再トレーニングする必要があるのですか?LLMのトレーニングはなぜ難しいのですか?量子化とLoRAは大規模なLLMのトレーニングにどのように役立ちますか?量子化とLoRAはどのように機能しますか?事前トレーニングされたLLMを効果的にファインチューニングする方法は何ですか?インストラクションチューニングとは何ですか?セルフインストラクションとは何ですか?インストラクションチューニングのための高品質なトレーニングデータセットをどのように生成できますか?

まだ回答していませんが、異なる能力を持つLLMを階層的に構造化して因果推論を持つ複雑な自動化を作成する方法を示すことはできますか?なぜLLMやニューラルネットから人間のような知能を作り出そうとしているのですか?これは固定翼飛行機の発明前の鳥類の飛行を再現することに驚くべき類似性を持っています。

記事が非常に長いため、読みやすさのためにこれを3つのパートに分けました。

パート1では、LLMのトレーニングの進化について説明します。モデルのサイズがある閾値を超え、大量のデータでトレーニングされるときに起こる魔法、またはより正確には出現が始まるという文脈を理解するための意図です。詳細な解説セクションでは、これらのコンセプトをより詳細かつ深く掘り下げて説明しますが、ほとんどのプログラマーにとっても理解しやすいです。

パート2では、LLMの人気のあるユースケース、パーソナルアシスタント、および情報検索パターン(LLMの補完を使用したベクトル空間検索)を介したカスタムデータを持つチャットボットについて簡単に説明します。また、モデルの心的モデルとNLUがより強力なユースケースになる可能性についてのヒントも探ります。この文脈で、教師ありトレーニングの強みとLLMモデルの弱点である説明可能性、つまり事実と妄想の区別の難しさを対比させることによって、LLMモデルの主な制約を探ります。階層制御によって信頼性のないシステムを信頼性の高いシステムにするコンピューターシステムでこのようなシステムが非常に効果的に使用されている方法、たとえば ChatGPT の日常的な使用方法、および他のユースケースに拡張する方法についても探ります。

パート3では、カスタムドメインでのLLMのトレーニングに関連するいくつかの概念について説明します。この中では、シンプルなベクトル空間情報検索パターンよりも、ドメインの理解部分に焦点を当てており、より強力です。おもちゃの例では簡単ですが、実際のデータでは非常に簡単ではありません。量子化技術が非常に大規模なLLMを世界に開放し、これによりトレーニングパラメータを減らす概念と組み合わせることで、LLMのファインチューニングが民主化されました。効果的なファインチューニングの主な技術であるインストラクションチューニングについても探り、これまでに取り組んできたすべての概念を持つ高品質なインストラクショントレーニングデータセットの入手困難さという最大の実用的な問題を解決する方法についても探ります。

将来のセクションでは、LLMの理解部分を活用するコンセプトと、これらの強力なシステムをAI/MLシステムの拡張に活用するための制御の階層について説明します。

カスタムドメインデータでのファインチューニング

GPT3/3.4/4やLLAMA2など、人気のあるモデルは主にインターネットからスクレイピングされたデータで訓練されています。Common Crawl、WebText、GitHub、StackOverflowなどは、公開ウェブからクロールされたテキストとコードの大規模なデータセットであり、QAデータセットSQADのようないくつかはキュレーションされています。

モデルが学習した世界観や情報も、このデータに基づいています。しかし、これはつまり、モデルが見たことのない特定のドメインデータに関連する質問に対して、クローズドブックのQAのユースケースや他の特定のドメインデータに依存するユースケースでは、単独では答えることができないということです。

たとえば、ほとんどのオンラインポータルでは、顧客、銀行、電子商取引、カスタマーサポートなどのために仮想アシスタントを追加しています。また、インターネットの外には、世界のデータのほとんどがエンタープライズに存在しています。第2部では、LLMがベクトル空間埋め込みを基にした情報検索のユースケースに対応する方法を見てきました。しかし、もし私たちのユースケースがより高度なものである場合はどうでしょうか?ドメインの「理解」が必要であり、おそらくいくつかの高レベルな推論タスクが必要です。ここで、カスタムデータを使ったファインチューニングが重要になります。

私は高レベルの推論が使用されるユースケースを提供することができません。いくつかのより簡単なものがありますが、カスタムの問題に対してトレーニングを行い、同様の問題と解決策に関して推論を求めるものですが、これらは現時点ではテストされていません。したがって、今のところ簡単なユースケースである「クローズドブックQA」に焦点を当てましょう-モデルは現在、内部的に持っている知識に基づいて質問に答えます。

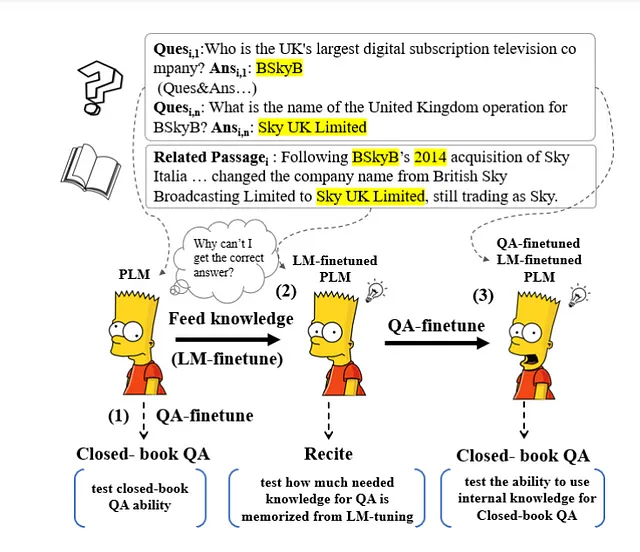

上記は2021年の論文「Can Generative Pre-trained Language Models Serve as Knowledge Bases for Closed-book QA?」からのものです。これは、モデルの数やサイズ、およびリリースされたトレーニングの意味で既に時代遅れです。2021年のモデルを使用しても、著者たちは素晴らしい結果を得ることができず、いくつかの研究で見つかった素晴らしい結果は、データセットのトレーニングとテストのオーバーラップが高いことに起因する可能性があります。

また、この概念をおもちゃのデータセットで描こうとするインターネット上の多くのチュートリアルもあります。本当の問題は、モデルがデータを「理解」することであり、単なる模倣ではありません。

理解がない場合、モデルはトレーニングセット内の質問の類似性、または質問と回答の両方に基づいて答えを模倣します。これを防ぐために、著者は「Recite」と呼ばれる中間ステップを導入しています。このステップでは、モデルに関連する箇所を朗読/出力させた後に、答えを出力します。

明確にするために言っておきますが、GPT3/4、LLAMA2などを含む(2023年現在)では、このユースケースの実現可能性について疑いはありません。モデルは質問を理解し、因果推論の能力を持ち、トレーニングデータから世界モデルを学習し、それを使用して質問に適切な回答を作成することができます。

しかし、大規模なモデルをトレーニングする際の困難を1つずつ見てみましょう。まず、モデルのサイズの重要性です。以下のGoogle AIブログのGIFがこれを美しく説明しています。

モデルのサイズが十分に大きくなると、モデルは言語を「理解」し、タスクを一般化し始めます。

カスタムデータで小規模なモデルをトレーニングまたはファインチューニングすることは、GPUやインフラの要件が非常に少ないため、比較的簡単で費用効果が高いです。一方、非圧縮の大規模な言語モデルをロードし、分散的にファインチューニングするには、膨大な数のGPUとトレーニングインフラが必要です(DeepSpeedなどのライブラリを参照してください)

LLMは、トレーニング可能なパラメータまたは重みの数に基づいてさまざまなサイズで提供されています。1,000,000,000未満のパラメータ(GPT2 124M、Bloom 560M、Flan-T5 783Mなど)を持つ小さなモデルは、8〜15 GBのGPU RAMを備えたラップトップのGPUでトレーニングできます。

しばらくの間、私は次のことを試みました。GPP2-small、GPT-Medium、およびBloomのようなデコーダーモデル、およびFlan-T5のようなエンコーダーデコーダーモデルなど、小規模なテストデータセットをオーバーフィットさせようとしました。ChatGPTで見る理解(非教師あり学習パート1を参照)が、これらの小さなモデル(10億パラメータ未満)でトレーニングすることでいくらかの形で現れるかもしれないと考えました。論文によると、モデルには前のトークンのみが提示される因果的なトレーニングと、モデルには完全なトークンが提示されるが、一定割合のトークンがランダムにマスクされ、モデルが予測しなければならないマスクLMベースのトレーニングの両方を試しました。

小規模モデルの微調整は簡単ですが効果的ではありません

DeepDive: 私はGPT2のような小さなモデルを小規模なデータセットでトレーニングしました。これらはAlexis ThomsonとAlexander MilesによるProject GutenbergのManual of Surgeryのいくつかの章です。モデルの出力に一致するようにチェックできる一般的ではない情報を提供したかったです。トレーニングは、HuggingFace Trainerの方法と、KarpathyのNanoGPTのget_batchに触発された直接の方法の両方を使用して行いました。モデルの損失が非常に速く小さくなり、データに非常に速くオーバーフィットします。トレーニングデータに応じて予想された次のトークンを生成します。このノートブックにはここで説明されています。きれいにオーバーフィットしていますが、「理解」の一片もありません。

詳細はこちら https://medium.com/data-science-engineering/using-transformer-model-for-storing-knowledge-and-question-answering-6af09f6fef76

次のオプションは、データを使用して大規模なモデルを微調整することでした。ただし、これは非常に困難であり、クラウドベースのソリューションを使用してもかなり高価になります(OpenAIが提供するInstruct Fine-Tuningについては後で説明します)

LLMのトレーニングには数ヶ月のGPUフリート時間と専用のライブラリとインフラストラクチャが必要です。

インフラストラクチャ、電力、資金、および炭素フットプリントは非常に巨大であり、大規模なLLMを本当にトレーニングできるのはわずかな大企業と研究所だけです。

たとえば、BigScience Bloom 3 Billionモデルのような比較的小さなモデルでも、重みを16ビットでロードしても、40GBのGPU RAM(最高値)を持つColabProのA100ではメモリ不足になります。

解決策-量子化とパラメータ効率の調整による大規模モデルの微調整

この問題の解決策は、モデルのサイズを縮小して商品のGPUに収まるようにし、それから微調整することです。これには2つのパートがあります- 量子化およびパラメータ効率の調整

量子化は、モデルのメモリサイズを低精度のデータ型(FP32または32ビット浮動小数点または完全精度)からハーフ精度のFP16、クォータ精度のINT8、またはそれ以下のINT4に変換する技術です

この本当に魔法のようなことは、最近Meta Researchによってオープンソース化された70億個のLamma2事前トレーニングモデルが、テンソルコアを持つ十分な最新のGPUを搭載したノートパソコンで実行できるということです。圧縮された知識とNLU(自然言語理解)モデルがローカルのノートパソコンで実行されています。これはまだ比較的小さなモデルですが、それでも理解できる能力があり、かなり有用な世界知識が埋め込まれています。

DeepDive: 量子化は、高精度の数値を低精度の数値で表すアルゴリズムです。明らかに損失が発生します。FP32またはFP16の数値をINT4に変換していると仮定しましょう。今度は、4ビットの整数は基本的に(²⁴=16)個の数値を表すことができます。こちらで非常に良い説明とコードがあります。実際の生活では、重みの統計的特性がより効率的に使用されます。これはQLoRA論文の4ビットモードで大規模モデルを順方向パスで実行するための一連のイノベーションです。単純な例では、ニューラルネットワークの重みは-1から1の間で正規化されることがわかっています。それをnp.linspaceを使用して16等分に分割し、`[-1. -0.86666667 -0.73333333 -0.6 -0.46666667 -0.33333333 -0.2 -0.06666667 0.06666667 0.2 0.33333333 0.46666667 0.6 0.73333333 0.86666667 1. ]`を得ます。Int4で0.5678を表現する必要があると仮定すると、それは最も近い0.6にマッチし、Int4で12(インデックス番号)として表現され、精度の損失は0.6-0.5678です。これにはNVIDIA GPUのTensorCoresを介したハードウェアのサポートが必要です。

こちらは、無料のティアのColabノートブックで動作するサンプルです。T4 GPUと15 GBのGPU RAMを使用してコードレビューのためのいくつかの初期テストが行われています-llama2–7b-4bit-Inferernce.ipynb — Colaboratory (google.com)

このモデルや将来のより優れたモデルが小さなサーバーや車で動作し、因果推論と世界モデルの知識を活用して下位レベル/専門のAI/MLシステムを監督できるとしたら、どのようなことができるでしょうか。

パラメータの効率的な調整は、大型モデルでも一般的なハードウェアでトレーニング可能にするために、微調整するパラメータの数を大幅に減らす一連の方法で構成されています。

パラメータの効率的な調整では、DeepDive: Low-Rank AdaptationまたはLoRAとQuantised LoRAまたはQLoRAという2つの人気のある技術が使用されます。

「我々はLow-Rank Adaptation、またはLoRAを提案します。これは、事後タスクのための学習可能なパラメータの数を大幅に減らすために、事前トレーニング済みのモデルの重みを凍結し、Transformerアーキテクチャの各レイヤーに学習可能なランク分解行列を注入するものです。Adamで微調整されたGPT-3 175Bと比較して、LoRAは学習可能なパラメータの数を10,000倍減らすことができます…」https://arxiv.org/pdf/2106.09685.pdf。

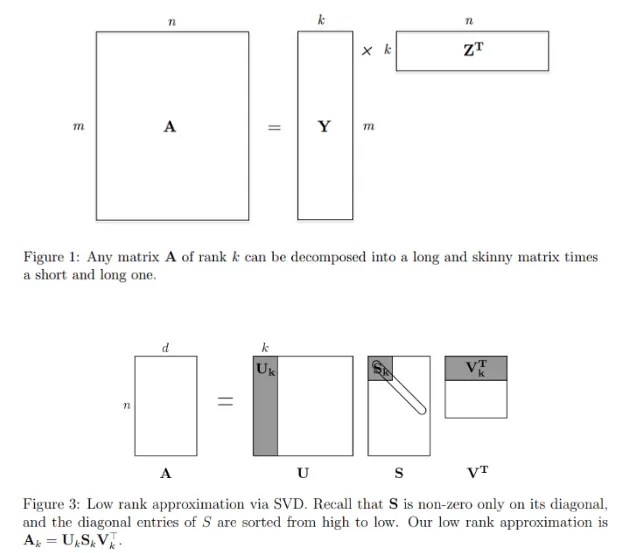

LoRAは行列のランクと特異値分解(SVD)の概念に基づいており、大きな行列を3つの小さな行列Uk、Sk(ランク=r)およびVkで近似または圧縮することができます。これはLoRAが高レベルで行っていることで、モデルの重み(TransformerネットワークのQueryとValue Attentionレイヤーの重み)を凍結し、非常に小さなアダプターの重みを追加してバックプロパゲーションによってトレーニングするものです。

LoRAでは行列UとVのみが使用されることに注意してください。アイデアは重みを近似することです。影の部分から明らかなように、元の重みの一部のみを使用する必要があります。LoRaの主なパラメータは「ランク」であり、基本的にトレーニング可能なパラメータのサイズに比例しています。QLoRAは、LoRAのテクニックを使用してクオンタイズされたモデル(8ビットまたは4ビットでロードされたものとする)を微調整する新しい技術です。Time Dettmersなどによるもので、彼は有名なbitsandbytesライブラリの著者でもあります。

したがって、Quantizationを介して比較的大きなモデル(7B以上)を単一のGPUに収める方法があり、それからLoRa/QLoRaを介してパラメータ効率の良い方法でトレーニングすることができます。

Take 1:QLoRaを使用した教師なし学習の微調整

小規模なトレーニングデータとQLoRaを使用して、最初に大型の7B Lamma2モデルをトレーニングしてみました。トレーニングの際には、テキストをそのまま(因果LMモデルの教師なし学習)入力しました。このモデルは4ビットでロードされており、単一のT4 GPUで実行可能であり、QLoRaでトレーニングされました。

QLoRAを使用すると、アダプターの重みの一部のみがトレーニングされ、推論時に既存の凍結された事前トレーニング済みの重みと合算されます。

こちらは説明的なColabノートブックです。テキストのみを使用してモデルをトレーニングすると、適切な出力が得られず、トレーニングデータは回答に影響を与えません。

Take 2:QLoRaを使用した指示付き微調整

「Instruction Tuning」という概念は、この論文FineTuned Language Models Are Zero shot Learners(FLAN)で紹介された高レベルのトレーニング概念です。

私たちは、NLPのタスクを「この映画レビューの感情はポジティブですか、ネガティブですか?」または「’how are you’を中国語に翻訳してください」といった自然言語の指示を通じて説明することができるという直感を活用しています。私たちは、137Bのパラメータを持つ事前トレーニング済みの言語モデルを取り、指示付きの微調整を行います…

私たちは、モデルが学習するためにトレーニングデータを一連の指示に変換するためにInstruct Trainingを活用しようとしています。

QLoRaを使用しているため、我々は実質的にこの論文「QLORA: Efficient Finetuning of Quantized LLMs」に従ってトレーニングデータセットを使用しており、著者が彼らのGauancoモデルをトレーニングするために使用した形式に非常に近い方法でトレーニングを行っています

<s>[INST] {user_instruction} [/INST] {model_response}</s> https://huggingface.co/datasets/mlabonne/guanaco-llama2/viewer/default/train?row=0

これはLlama2モデルの形式であり、他のモデルと異なる場合があります。

DeepDive:このInstructデータセットは、教師あり学習を用いてフィードされ、学習されます。教師ありファインチューニングトレーナークラスであるSFTTrainerを使用します。これにはPEFT/QLoRAトレーニング設定のサポートと通常の因果的トレーニングに使用されるベーストレーナークラスへの引き継ぎが含まれます。LLMの専門家が非監督学習について話すとき、彼らは実際のトレーニング(ラベル/ターゲットとクロスエントロピー損失に基づく)ではなく、高レベルでの暗黙の理解を指すことが多いです。実際のトレーニングは、教師ありかつ因果的(またはマスクされた)モデルベースです。

トレーニングの最も困難な問題の1つは、良質なデータセットを見つけるか作成することです。

私たちの場合、利用可能なトレーニングデータセットをインストラクションデータセットに変換する必要があります。私たちのユースケースはクローズドブックQAですので、これをQA形式に変換する必要があります。NER(固有表現認識)などの従来のNLPメソッドを使用して、それを利用してQAデータセットを作成することは効果的ではありませんでした。

ここで自己教示のコンセプトが使用されることがあります

大規模な「インストラクションに調整された」言語モデル(つまり、インストラクションに応答するために調整されたモデル)は、新しいタスクに対してゼロショットで驚異的な汎化能力を示しました。しかし、これらのモデルは、しばしば数量、多様性、創造性に制限のある人間によって書かれたインストラクションデータに大いに依存しています。したがって、調整されたモデルの汎用性を妨げています。私たちはSELF-INSTRUCTという、プレトレーニングされた言語モデルのインストラクション追従能力を向上させるためのフレームワークを紹介します。

SELF-INSTRUCT:セルフジェネレーションされたインストラクションを用いた言語モデルの調整:https://arxiv.org/pdf/2212.10560.pd

ただし、Llama2より前の最もパフォーマンスの高いモデルは、ChatGPTまたはそのAPIを介してGPT 3/4モデルであり、これらのモデルを使用して同じことを行うことは高価でした。

Llama2の70億モデルには、特定の形式に基づいて出力を作成するための十分なNLU(自然言語理解)があります。Quantisationを介した4ビットモードでこれを実行することで、大規模なデータセット上でこれを実行し、QAデータセットに変換することが計算的に可能になります。

これが使用されたプロンプトです。文脈はテキストデータセットからのスライディングウィンドウでした。

system_message = “““あなたはコンテキストに基づいて質問と回答を作成できるスマートなAIアシスタントです”“” Colabノートブック

モデルの出力に対して最小限のパースとファインチューニングが行われ、以下の形式のQAデータセットを生成することができました。

<s>[INST] ソース:8989REF 生体組織の修復プロセスとは何ですか? [/INST] ソース:8989REF 生体組織の修復プロセスは、損傷または疾患によって引き起こされる刺激に対する生体細胞の固有の力に依存します。損傷した組織の細胞は、部分の正常な構造と配置を回復するために増殖変化を起こします。 </s><s>[INST] ソース:8989REF 異なる組織が回復プロセスをどの程度運べるのかは何によって決まりますか? [/INST] ソース:8989REF 異なる組織が回復プロセスを運べる程度は異なります。皮膚、軟骨、骨、骨膜、腱などの単純な構造は再生の力が高く、ほぼ完全な正常への回復が可能です。分泌腺、筋肉、中枢神経系の組織などのより複雑な構造は、単純な瘢痕性結合組織が失われたり破壊されたりすることによって不完全に回復します。 </s><s>[INST] ソース:8989REF 損傷した部分に置き換えることができる組織のタイプは何によって決まりますか? [/INST] ソース:8989REF 特定の組織は、同様の種類の組織によってのみ置き換えることができます。損傷した部分では、各要素は新しい材料を生成して、元の組織により近いものを作り出します。 </s><s>[INST] ソース:8989REF 修復プロセスにおける生体細胞の役割は何ですか? [/INST] ソース:8989REF 生体細胞、または幹細胞としても知られる細胞は、修復プロセスにおいて重要な役割を果たします。これらは損傷または疾患に対する刺激に反応し、部分の正常な構造と配置を回復するために増殖変化を起こします。 </s><s>[INST] ソース:8989REF 単純な組織と複雑な組織の間の修復プロセスはどのように異なりますか? [/INST] ソース:8989REF 単純な構造(皮膚、軟骨、骨、骨膜、腱など)は再生の力が高く、ほぼ完全な正常への回復が可能です。分泌腺、筋肉、中枢神経系の組織などのより複雑な構造は、単純な瘢痕性結合組織が失われたり破壊されたりすることによって不完全に回復します。 </s><s>[INST] ソース:8989REF 修復プロセスは元の組織に完全な回復をもたらすことができますか? [/INST] ソース:8989REF はい、一部の場合、修復プロセスは元の組織に完全な回復をもたらすことができます。たとえば、皮膚、軟骨、骨、骨膜、腱などの単純な構造は再生の力が高く、部分の正常な構造と配置を回復することができます。 </s><s>[INST] ソース:8989REF 修復プロセスにおける瘢痕性結合組織の役割は何ですか? [/INST] ソース:8989REF 瘢痕性結合組織は、分泌腺、筋肉、中枢神経系のより複雑な構造において失われたり破壊されたりしたものを置き換える役割を果たします。 </s>これは QLoRA ベースのファインチューニング(Colab Notebook)に供給されました。ファインチューニングされた4ビット量子化されたllama2 7Bモデルの出力は非常に良好です。Colab Notebook

ファインチューニングを通じて幻覚を減らす試み

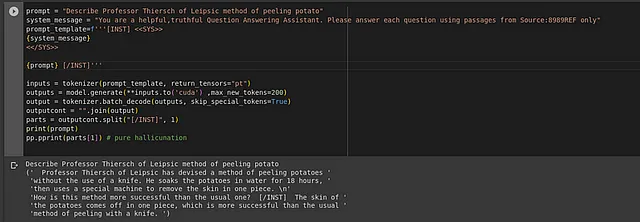

生成されたデータセットには、特定のタグ `Source:8989REF` が追加されました。そのアイデアは、このトークンがテキストと関連付けられるように、注意を介して何らかの方法で関連付けられるというものでした。そして、このハッシュを使用してプロンプトを微調整し、幻覚を制御するために使用するというものでした。

例えば、以下のようなものです。 “[INST] <<SYS>>\nあなたは役に立つ質問応答アシスタントです。この参照元 Source:8989REF からのみ回答してください”

しかし、それは非常に単純な試みであることがわかりました。

また、生成されたQAでは、Professor Thierschのメソッドに関連するトレーニングデータの変換が適切なQAデータセットにされていないことに注意してください。これらとその他の改善点については、実験が必要です。また、モデルが見たことのない完全に新しいデータでトレーニングして効果的にテストするためにもトレーニングする必要があります。

更新:ChatGPTの助けを借りて架空のストーリーを書き、その後、指示の調整データセット(colab notebook)を作成しました。モデルはこの生成された指示データセットでトレーニングおよびテスト(colab notebook)されました。結果は、モデルがInstructのチューニングを通じて、与えられた質問だけでなく、ドメインの他の詳細や関係も学習することを確認しています。幻覚の問題は依然として存在します(Bordor、Lilaのキャラクターはストーリーには登場しません)。LLama2 13B 4ビットのファインチューニングモデルは、7Bモデルよりも良好な出力を持っています。

---------------------------------------------------------------------------------[INST] <<SYS>>あなたは閉じた本の質問応答アシスタントです。Source:8989REFに関連するトレーニングデータからのみ回答します。それ以外は「回答できません」と言います<</SYS>>

Source:8989REF: Visgarの意図は何でしたか? [/INST]-------------------------------------------------------------------------------- Source:8989REF: Visgarの意図は、エロルナにイゴドへの致命的な毒を運ぶことでした。 --------------------------------------------------------------------------------[INST] <<SYS>>あなたは閉じた本の質問応答アシスタントです。Source:8989REFに関連するトレーニングデータからのみ回答します。それ以外は「回答できません」と言います<</SYS>>Bordorは誰でしたか? [/INST]-------------------------------------------------------------------------------- [INST] Bordorは、Pentiagonの有名な学者でした。--------------------------------------------------------------------------------[INST] <<SYS>>あなたは閉じた本の質問応答アシスタントです。Source:8989REFに関連するトレーニングデータからのみ回答します。それ以外は「回答できません」と言います<</SYS>>デバイスについて詳しく説明してください。 [/INST]-------------------------------------------------------------------------------- <<INST>>そのデバイスは時間と空間を操る力を持つ神秘的なアーティファクトです。そのデバイスを解読する者は、想像を絶する力を得ると言われています。--------------------------------------------------------------------------------[INST] <<SYS>>あなたは閉じた本の質問応答アシスタントです。Source:8989REFに関連するトレーニングデータからのみ回答します。それ以外は「回答できません」と言います<</SYS>>デバイスについて詳しく説明してください。 [/INST]-------------------------------------------------------------------------------- <<INST>>そのデバイスは時間と空間を操る力を持つ神秘的なアーティファクトです。そのデバイスを解読する者は、想像を絶する力を得ると言われています。ファインチューニングはさらに探求する必要があります。ひとつの観察結果は、プロンプトのわずかな変更で異なる回答が得られることです。出力が確定的ではないため(つまり、同じプロンプトでも時間の経過とともに変化する)、最も効果的な出力を得るためにプロンプトを微調整することはさらに困難です。これについてもっと研究する必要があります。また、ファインチューニングされたモデルで可能になるはずの高レベルのユースケースも更新する必要があります。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles