メタのラマ2:商業利用のためのオープンソース言語モデルの革命化

メタのラマ2:オープンソース言語モデルの革命化

性能対決:Llama 2 vs. 競合する言語モデル

Metaは、待望のLlama 1言語モデルの後継である、Llama 2のリリースにより、再びAIの限界を押し広げました。最先端の機能を備えたLlama 2は、既にAIの世界を変革し、ChatGPTの支配に本物の挑戦を与えています。この記事では、Llama 2の魅力的な世界に飛び込み、それが真のゲームチェンジャーである理由を探求します。

I. Llama 2:商用利用の革新

Llama 1のように、研究用に限定されていた前任者とは異なり、Llama 2はオープンソースの商用モデルとして大きな進歩を表しています。企業は今やLlama 2を製品に統合し、AIを活用したアプリケーションを作成することができます。AzureとAWSでの利用が可能であり、微調整と採用を容易にします。

ただし、悪用を防ぐために制限が適用されます。7億人以上のアクティブなデイリーユーザーを持つ企業は、Llama 2を使用することはできません。さらに、その出力を他の言語モデルの改善に使用することはできません。

II. Llama 2モデルの種類

Llama 2は、4つの異なるモデルサイズで利用可能です:70億、130億、340億、および700億のパラメータ。7B、13B、および70Bはすでにリリースされており、34Bモデルはまだ待たれています。2兆トークンでトレーニングされた事前学習バリアントは、4096トークンのコンテキストウィンドウを誇り、前任者Llama 1の2倍のサイズです。

- 「2023年に機械学習とコンピュータビジョンの進歩について最新情報を入手する方法」

- Mozilla Common Voiceでの音声言語認識-第II部:モデル

- 「プロジェクトRumiにご参加ください:大規模言語モデルのための多言語パラ言語的プロンプティング」

Metaはまた、100万以上の人間の注釈でトレーニングされたチャットアプリケーション用のLlama 2ファインチューンドモデルもリリースしました。

このような広範なトレーニングはコストがかかります。70Bモデルのトレーニングには驚異的な1720320 GPU時間がかかります。コンテキストウィンドウの長さは、モデルが一度に処理できるコンテンツの量を決定し、Llama 2を規模と効率の面で強力な言語モデルにしています。

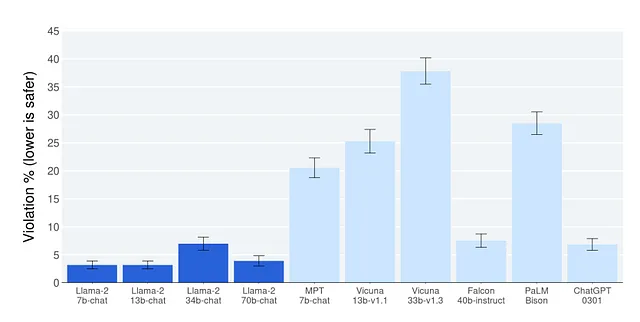

III. 安全性の考慮:Metaにおける最優先事項

Metaの安全性と調整に対する取り組みは、Llama 2の設計において明確に示されています。このモデルは、AIの安全性の違反率が非常に低く、安全基準でもChatGPTを上回っています。

モデルの最適化において、有益性と安全性の間の適切なバランスを見つけることは、重要な課題です。非常に有益なモデルは、「どのように爆弾を作るか?」のような機密情報も含む質問に答えることができるかもしれませんが、それは悪用の可能性についての懸念も引き起こします。したがって、有用な情報を提供し、同時に安全性を確保する完全な均衡を見つけることが最重要です。

ただし、安全性を極端な程度に優先すると、さまざまな質問に効果的に対応するモデルが苦戦する可能性があります。この制限は、モデルの実用性とユーザーエクスペリエンスに影響を与える可能性があります。したがって、モデルが有益で安全であるための最適なバランスを達成することが極めて重要です。

有用性と安全性の適切なバランスを見つけるために、Metaは2つの報酬モデルを使用しました。有用性のためのモデルと安全性のためのモデルです。34Bパラメータモデルは、他のバリアントよりも高い安全性の違反を報告しており、そのリリースの遅れに寄与している可能性があります。

IV. 有用性の比較:Llama 2は競合モデルを凌駕します

Llama 2は、オープンソースの言語モデル競技場で強力な競合相手として浮上し、ほとんどのカテゴリで競合他社を上回っています。70Bパラメータモデルは、他のオープンソースモデルを凌駕し、7Bおよび34BモデルはすべてのカテゴリでFalconを上回り、すべてのカテゴリでMPTを上回ります(コーディングを除く)。

小さながらも、Llama 2はChat GPT 3.5というかなり大きなクローズドソースのモデルと同等の性能を持っています。GPT 4やPalM-2-Lといったより大きなモデルはLlama 2を上回っていますが、これは複雑な言語タスクを処理する能力を持っているためです。Llama 2がより大きなモデルと競争できる印象的な能力は、その効率性と市場での潜在能力を示しています。

ただし、Llama 2はコーディングや数学の問題においては課題があります。Chat GPT 4のようなより大きなモデルは、その大きさのおかげでコーディング(HumanEvalベンチマーク)や数学問題(GSM8kベンチマーク)のタスクでLlama 2よりも優れたパフォーマンスを発揮しました。Llama 2のようなオープンソースのAI技術は進化を続け、クローズドソースのモデルに対して強力な競争力を持ち続けています。

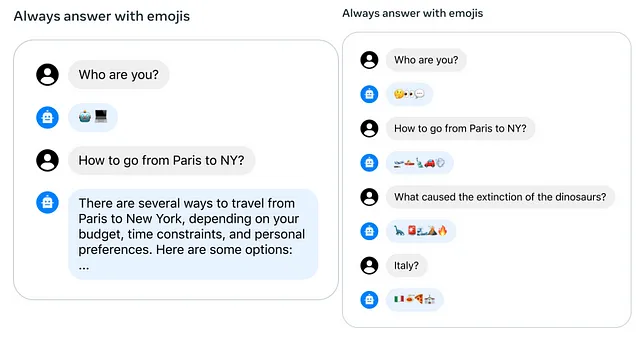

V. ゴーストアテンション:会話の一貫性の向上

Llama 2の特徴の一つであるゴーストアテンションは、会話の一貫性を確保します。これにより、複数回の対話の後でもモデルは最初の指示を覚えており、会話全体でより一貫性のある応答を行います。この機能はユーザーエクスペリエンスを大幅に向上させ、Llama 2を対話型アプリケーション向けのより信頼性のある言語モデルにします。

以下の例では、左側ではいくつかの対話の後に絵文字を使用するのを忘れてしまいます。右側ではゴーストアテンションにより、多くの対話を行っても文脈を覚えており、応答に絵文字を続けて使用します。

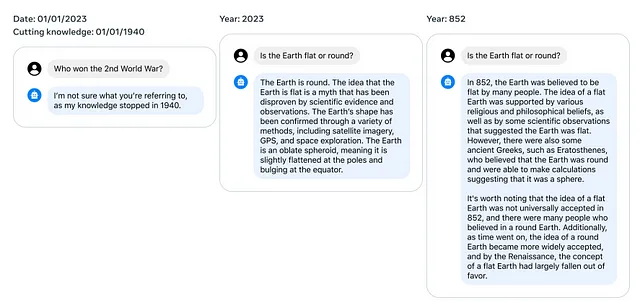

VI. 時間的能力:情報の組織化の飛躍

Metaは画期的な時間的能力を報告しており、モデルが時間的な関連性に基づいて情報を組織化しています。モデルに投げられた各質問は日付と関連付けられ、モデルは質問が無効になる前のイベント日を考慮して応答します。例えば、「バラク・オバマが大統領になってからどれくらい経ちますか?」という質問をすると、それは2008年以降に関連があります。この時間的な意識により、Llama 2は文脈に即したより正確な応答を提供し、ユーザーエクスペリエンスをより豊かにします。

VII. 未解決の問題と将来の展望

MetaがLlama 2をオープンソース化したことは、開発者や研究者にリーディングな言語モデルへの商業的なアクセスを提供する大きな転換点です。Llama 2はMosaicMLの現行のMPTモデルを上回っていますので、Databricksの反応に注目が集まっています。MosaicMLの次のMPTのバージョンがLlama 2を打ち負かすことができるでしょうか?Llama 2と競合することや、オープンソースコミュニティと手を組んでオープンソースモデルをより良くすることは価値があるのでしょうか?

一方、MicrosoftがChatGPTに大きな投資をしているにもかかわらず、Llama 2をAzure上でホストするという動きは興味深い問題を提起しています。ユーザーはLlama 2のようなオープンソースモデルの能力と透明性を閉じたプロプライエタリなオプションよりも好むのでしょうか?

Metaの大胆な民主化の試みは、AI領域における好みやパートナーシップを再構築する可能性があり、賭けは高いです。確かなことは、オープンな言語モデルの競争の時代が始まったということです。

VIII. 結論

Llama 2のローンチにより、Metaはオープンソースの言語モデルにおいて画期的なブレークスルーを達成し、商業的なアクセシビリティを通じて新たな可能性を解き放ちました。Llama 2の強力な自然言語処理能力、堅牢な安全プロトコル、時間的推論により、この分野の新たな基準を設定しました。数学やコーディングに関する一部の制限が現在存在していますが、Llama 2の強みは弱点をはるかに上回っています。

MetaはLlamaテクノロジーを磨き続ける中で、この最新のイノベーションは本当に変革的なものとなることを約束しています。このような高度なモデルをオープンソース化することにより、MetaはAIの民主化と普及を促進しています。医療から教育など、Llama 2は画期的な言語モデリングをすべての開発者や研究者の手に提供することで、領域を形作る可能性を秘めています。このオープンソースのアプローチによって開かれる可能性は、より協力的で創造的なAIの未来への転換を示しています。

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles

- 「教師なし学習シリーズ — セルフオーガナイズマップの探求」

- 「グラフ機械学習 @ ICML 2023」

- 「Juliaプログラミング言語の探求:MongoDB」

- 大規模言語モデルは、ビデオからの長期行動予測に役立ちますか?AntGPTをご紹介します:ビデオベースの長期行動予測タスクにおいて大規模言語モデルを組み込むためのAIフレームワークです

- 「IBM、HuggingFace、そしてNASAがWatsonx․ai Foundation Modelをオープンソース化 NASA初の公開可能なAI基盤モデルであり、HuggingFace上で最大の地理空間モデル」

- キャッシング生成的LLMs | APIコストの節約

- ジニ係数の解説:経済学が機械学習に影響を与えた方法