「Falcon 180B あなたのコンピューターで動作しますか?」

「Falcon 180B、動作する?」

はい、十分なCPU RAMがあれば可能です

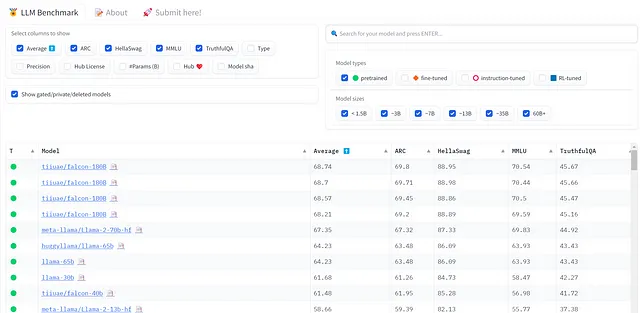

2023年5月、アブダビのテクノロジイイノベーション研究所(TII)は、2つの事前学習済みLLM(Falcon-7BとFalcon-40B)およびそのチャット版を公開しました。これらの2つのモデルは非常に優れた性能を示し、OpenLLMリーダーボードで第1位にランクインしました。

TIIがFalconファミリーに追加した第3のモデルは、Falcon 180Bです。これは1800億パラメータのモデルです。Llama 2 70Bよりもパラメータが2.5倍多く、Falcon-40Bよりも4.5倍多いです。

Falcon 180Bに関するいくつかの事実(出典:Falcon 180Bモデルカード)は以下の通りです:

- 3.5兆トークン(RefinedWeb)で事前学習済み

- Apache 2.0ライセンスで配布

- サイズは360 GB

- OpenLLMリーダーボードで第1位(2023年9月11日現在)

チャット版もあります。これらのモデルはHugging Faceハブで利用可能です:

- Falcon 180B

- Falcon 180B チャット

Falcon 180Bは完全に無料で最先端ですが、非常に大きなモデルでもあります。

あなたのコンピュータで実行できるでしょうか?

非常に集中的な計算に対応するために、あなたのコンピュータが準備されている場合を除いて、Falcon 180Bはそのままでは実行できません。コンピュータをアップグレードし、モデルの量子化バージョンを使用する必要があります。

この記事では、一般的なハードウェアでFalcon-180Bを実行する方法について説明します。現代のコンピュータで1800億パラメータのモデルを実行するのは比較的手頃な価格であることがわかります。また、ハードウェア要件を低減するためのいくつかの技術についても説明します。

コンピュータにFalcon 180Bをロードするには、何が必要ですか?

最初に知っておくべきことは、Falcon 180Bがbfloat16として格納されている1800億のパラメータを持っていることです。1つの(b)float16パラメータは2バイトのメモリを使用します。

モデルをロードする際、標準のPytorchパイプラインは次のように動作します:

- 空のモデルが作成されます:1800億パラメータ * 2バイト = 360 GB

We will continue to update VoAGI; if you have any questions or suggestions, please contact us!

Was this article helpful?

93 out of 132 found this helpful

Related articles