Learn more about Search Results CloudWatch - Page 9

- You may be interested

- 「AIシステムのリスク評価方法を学びまし...

- データウェアハウス:情報ストレージの不...

- LLMの理論的思考力を向上させるための方法...

- 「OpenAIとMetaが著作権侵害で訴えられる」

- 「VoAGI調査:データサイエンスの支出とト...

- データ品質のレイヤー

- ChatGPTは現在、話された言葉で応答するこ...

- ニュースグループが報道内容に大いに依存...

- 「人気コンテストをごまかすためのGitHub...

- 未来に響く:NVIDIAとAmdocsが世界の電信...

- 「脳に触発された人工知能についての意見...

- 「大規模なラスター人口データの探索」

- 「数の力:NVIDIAとGenerative Red Team C...

- 「A.I.ブームで最も不可欠な賞を必死に追...

- データサイエンスチートシートのためのBard

Amazon SageMaker Model Cardの共有を利用して、モデルのガバナンスを向上させる

MLガバナンスの一環として利用可能なツールの1つは、Amazon SageMaker Model Cardsですこのツールは、モデルのライフサイクル全体でのドキュメントの集中管理と標準化を通じて、モデル情報の真実の単一ソースを作成する能力を持っています SageMakerモデルカードにより、モデルの設計、構築、トレーニング、評価からモデルのライフサイクルを可視化するために、モデルのドキュメント化方法を標準化することができますモデルカードは、監査やドキュメンテーションの目的で信頼性のあるビジネスおよび技術メタデータの真実の単一ソースとなることを目指していますモデルの重要な事実を提供するファクトシートとなります

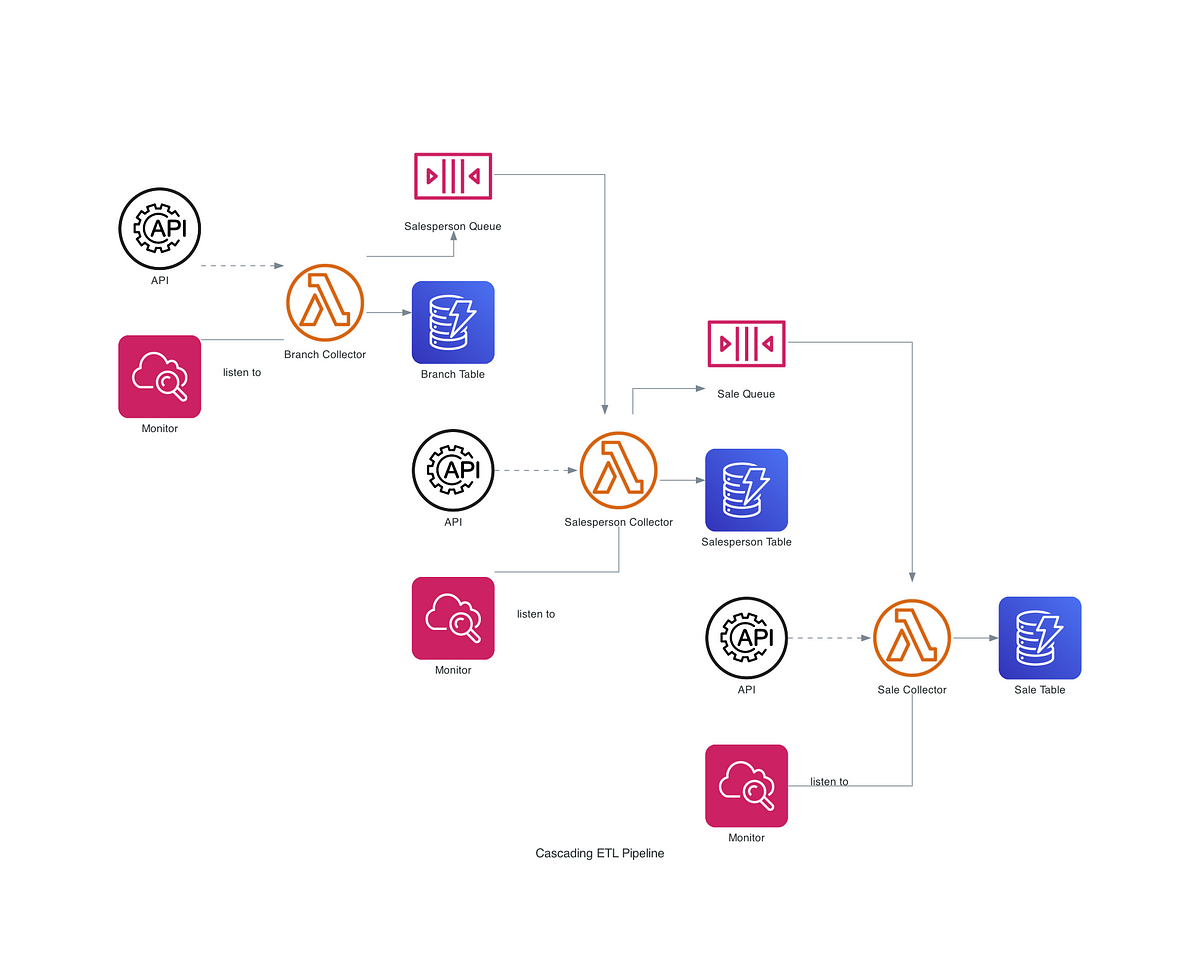

「AWSに基づいたカスケーディングデータパイプラインの構築方法(パート2)」

以前、私はAWS CloudFormationテクノロジーを使用してデータパイプラインを開発する際の経験を共有しましたただし、これは最適なアプローチではありませんなぜなら、3つの別の問題が残っているからです...

トムソン・ロイターが6週間以内に開発したエンタープライズグレードの大規模言語モデルプレイグラウンド、Open Arena

この記事では、トムソン・ロイター・ラボがAWSとの協力のもとで開発したトムソン・ロイターの企業全体で使用される大規模言語モデル(LLM)のプレイグラウンド、Open Arenaについて説明しますオリジナルのコンセプトは、Simone Zucchet(AWSソリューションアーキテクト)とTim Precious(AWSアカウントマネージャー)のサポートを受けたAI/MLハッカソンで生まれ、AWSのサービスを使用して6週間以内に本番環境に開発されましたAWS Lambda、Amazon DynamoDB、Amazon SageMakerなどのAWS管理サービス、および事前に構築されたHugging Face Deep Learning Containers(DLC)がイノベーションのスピードに貢献しました

「HaystackパイプラインとAmazon SageMaker JumpStartを使用して、LLMsを用いたエンタープライズ検索のための本番用ジェネレーティブAIアプリケーションを構築する」

この投稿では、HaystackパイプラインとAmazon SageMaker JumpStartおよびAmazon OpenSearch ServiceからのFalcon-40b-instructモデルを使用して、エンタープライズ検索のためのエンドツーエンドの生成型AIアプリケーションを構築する方法を紹介します

「新しいAmazon Kendra Alfrescoコネクタを使用して、Alfrescoコンテンツをインデックス化します」

「Amazon Kendraは、機械学習(ML)によって推進された非常に正確で使いやすい知的な検索サービスですAmazon Kendraは、コンテンツをインジェストしてインデックス化するプロセスを簡素化するためのデータソースコネクタのスイートを提供しています組織内の貴重なデータは、構造化および非構造化のリポジトリに保存されています企業の検索ソリューションは、[...]」

「Amazon SageMakerを使用して、生成AIを使ってパーソナライズされたアバターを作成する」

生成AIは、エンターテイメント、広告、グラフィックデザインなど、さまざまな産業で創造プロセスを向上させ、加速させるための一般的なツールとなっていますそれにより、観客によりパーソナライズされた体験が可能となり、最終製品の全体的な品質も向上します生成AIの一つの重要な利点は、ユーザーに対してユニークでパーソナライズされた体験を作り出すことです例えば、[…]

「Amazon SageMakerを使用して、薬剤探索を加速するためのタンパク質折り畳みワークフローを構築する」

薬の開発は、数千種類の薬候補をスクリーニングし、計算や実験的な手法を用いてリードを評価するという複雑で長いプロセスですマッキンゼーによると、1つの薬を疾患ターゲットの同定、薬のスクリーニング、薬のターゲットの検証、そして最終的な商業化までには、10年かかり、平均で26億ドルの費用がかかるとのことです[...]

「AWSを基にしたカスケーディングデータパイプラインの構築方法」

今日は、いつも誇りに思っているデータエンジニアリングプロジェクトの経験を共有しますなぜ私がツールやAWSのコンポーネントを使用したのか、そしてどのように...という理由を学ぶことになります

パートナーシップ:Amazon SageMakerとHugging Face

この笑顔をご覧ください! 本日、私たちはHugging FaceとAmazonの戦略的パートナーシップを発表しました。これにより、企業が最先端の機械学習モデルを活用し、最新の自然言語処理(NLP)機能をより迅速に提供できるようになります。 このパートナーシップを通じて、Hugging Faceはお客様にサービスを提供するためにAmazon Web Servicesを優先的なクラウドプロバイダーとして活用しています。 共通のお客様に利用していただくための第一歩として、Hugging FaceとAmazonは新しいHugging Face Deep Learning Containers(DLC)を導入し、Amazon SageMakerでHugging Face Transformerモデルのトレーニングをさらに簡単にする予定です。 Amazon SageMaker Python SDKを使用して新しいHugging Face DLCにアクセスし、使用する方法については、以下のガイドとリソースをご覧ください。 2021年7月8日、私たちはAmazon SageMakerの統合を拡張し、Transformerモデルの簡単なデプロイと推論を追加しました。Hugging…

Hugging Face TransformersとAWS Inferentiaを使用して、BERT推論を高速化する

ノートブック:sagemaker/18_inferentia_inference BERTとTransformersの採用はますます広がっています。Transformerベースのモデルは、自然言語処理だけでなく、コンピュータビジョン、音声、時系列でも最先端のパフォーマンスを達成しています。💬 🖼 🎤 ⏳ 企業は、大規模なワークロードのためにトランスフォーマーモデルを使用するため、実験および研究フェーズから本番フェーズにゆっくりと移行しています。ただし、デフォルトでは、BERTとその仲間は、従来の機械学習アルゴリズムと比較して、比較的遅く、大きく、複雑なモデルです。TransformersとBERTの高速化は、将来的に解決すべき興味深い課題となるでしょう。 AWSはこの課題を解決するために、最適化された推論ワークロード向けに設計されたカスタムマシンラーニングチップであるAWS Inferentiaを開発しました。AWSは、AWS Inferentiaが「現行世代のGPUベースのAmazon EC2インスタンスと比較して、推論ごとのコストを最大80%低減し、スループットを最大2.3倍高める」と述べています。 AWS Inferentiaインスタンスの真の価値は、各デバイスに搭載された複数のNeuronコアを通じて実現されます。Neuronコアは、AWS Inferentia内部のカスタムアクセラレータです。各Inferentiaチップには4つのNeuronコアが搭載されています。これにより、高スループットのために各コアに1つのモデルをロードするか、低レイテンシのためにすべてのコアに1つのモデルをロードすることができます。 チュートリアル このエンドツーエンドのチュートリアルでは、Hugging Face Transformers、Amazon SageMaker、およびAWS Inferentiaを使用して、テキスト分類のBERT推論を高速化する方法を学びます。 ノートブックはこちらでご覧いただけます:sagemaker/18_inferentia_inference 以下の内容を学びます: 1. Hugging Face TransformerをAWS Neuronに変換する 2.…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.