Learn more about Search Results ガードレール - Page 9

- You may be interested

- MLモデルの最適化とデバッグにSHAP値を使...

- 開発者の生産性向上:DeloitteのAmazon Sa...

- Allen Institute for AI の研究者が、自然...

- GoogleのAI研究者がMADLAD-400を紹介:419...

- ニュースグループが報道内容に大いに依存...

- 「UCLA研究者がGedankenNetを紹介:物理法...

- プライバシー保護のためのAIとブロックチ...

- 「バイアス調整の力を明らかにする:不均...

- 「10の方法-人工知能が安全なアプリ開発を...

- 「Pythonにおけるサンプリング技術と比較...

- 「CREATORと出会ってください:ドキュメン...

- 機械学習、イラストで解説:インクリメン...

- 「Amazon SageMaker JumpStartを使用した...

- 変形者への鎮魂曲?

- 「Amazon Redshift」からのデータを使用し...

「プライバシーを保護しながらジェネラティブAIツールを使用する方法」

人工知能ツールやアプリを使用しながらデータをいくらか制御する方法をここで紹介します

「ChatGPTの王座陥落:クロードが新しいAIリーダーとなった経緯」

世界を恥ずかしい思いさせる

AIによる生産性向上 生成AIが様々な産業において効率の新たな時代を開く

2022年11月22日、ほとんど仮想的な瞬間が訪れ、それは地球上のほぼすべての産業の基盤を揺るがしました。 その日、OpenAIは史上最も高度な人工知能チャットボットであるChatGPTをリリースしました。これにより、消費者の質問に答えるための生成型AIアプリケーションから科学的なブレークスルーを追求する研究者の作業を加速するまで、ビジネスがより効率的になるための需要が生まれました。 以前はAIに手を出していた企業も、最新のアプリケーションを採用・展開するために急ぎます。アルゴリズムが新しいテキスト、画像、音声、アニメーション、3Dモデル、さらにはコンピュータコードを生成することができる生成型AIは、人々が働く・遊ぶ方法を変革しています。 大規模な言語モデル(LLM)を用いてクエリを処理することにより、この技術は情報の検索や編集などの手作業に費やす時間を劇的に短縮することができます。 その賭けは大きいです。PwCによると、AIは2030年までに世界経済に1兆5千億ドル以上をもたらす可能性があります。そして、AIの導入の影響はインターネット、モバイルブロードバンド、スマートフォンの発明以上に大きいかもしれません。 生成型AIを推進するエンジンは、高速計算です。これは、科学、分析、エンジニアリング、消費者およびエンタープライズのユースケース全般にわたり、GPU、DPU、ネットワーキング、およびCPUを使用してアプリケーションを高速化します。 早期の採用企業は、薬剤探索、金融サービス、小売、通信、エネルギー、高等教育、公共部門など、さまざまな業界で、高速計算と生成型AIを組み合わせてビジネスのオペレーション、サービス提供、生産性の向上を実現しています。 インフォグラフィックを表示するにはクリックしてください:次世代のAI変革を生み出す 薬剤探索のための生成型AI 今日、放射線科医はAIを使用して医療画像の異常を検出し、医師は電子健康記録をスキャンして患者の洞察を明らかにし、研究者は新しい薬剤の発見を加速するためにそれを使用しています。 従来の薬剤探索は、5000以上の化学物質の合成を必要とし、平均的な成功率はわずか10%です。そして、ほとんどの新薬候補が市場に出るまでに10年以上かかります。 研究者は、生成型AIモデルを使用してタンパク質のアミノ酸配列を読み取り、ターゲットタンパク質の構造を秒単位で正確に予測することができます。これには数週間または数か月かかることがあります。 NVIDIAのBioNeMoモデルを使用して、バイオテクノロジーの世界的リーダーであるアムジェンは、分子スクリーニングと最適化のためのモデルのカスタマイズにかかる時間を3か月からわずか数週間に短縮しました。このタイプのトレーニング可能な基礎モデルにより、科学者は特定の疾患の研究のためのバリアントを作成し、希少な状態の治療法を開発することができます。 タンパク質構造の予測や大規模な実世界および合成データセットでのアルゴリズムの安全なトレーニングなど、生成型AIと高速計算は、疾病の拡散を緩和し、個別の医療治療を可能にし、患者の生存率を向上させるための新たな研究領域を開拓しています。 金融サービスのための生成型AI NVIDIAの最新の調査によると、金融サービス業界での主要なAIの活用事例は、カスタマーサービスとディープアナリティクスです。ここでは、自然言語処理とLLMが使用され、顧客の問い合わせにより良い対応をするためや投資の洞察を明らかにするために使用されています。別の一般的な応用は、パーソナライズされた銀行体験、マーケティング最適化、投資ガイダンスを提供する推薦システムです。 先進的なAIアプリケーションは、この業界が不正行為をより防止し、ポートフォリオ計画やリスク管理からコンプライアンスや自動化まで、銀行業務のあらゆる側面を変革する可能性があります。 ビジネスに関連する情報の80%は構造化されていない形式、主にテキスト形式ですが、これは生成型AIの主要な対象となります。Bloomberg Newsは、金融および投資コミュニティに関連するニュースを1日に5,000本も発行しています。これらの記事は、タイムリーな投資の決定をするために使用できる膨大な非構造化市場データの宝庫です。 NVIDIA、ドイツ銀行、ブルームバーグなどは、ドメイン固有のデータや独自のデータをトレーニングおよび微調整するために訓練されたLLMを作成して、金融アプリケーションに使用しています。 金融トランスフォーマー、または「FinFormers」は、非構造化の金融データの文脈を学び、意味を理解することができます。これらはQ&Aチャットボットのパワーを供給し、金融テキストを要約・翻訳し、取引先リスクの早期警告サインを提供し、データを迅速に取得し、データ品質の問題を特定することができます。 これらの生成型AIツールは、プロプライエタリデータをモデルトレーニングおよび微調整に統合し、バイアスを防ぐためのデータキュレーションを統合し、会話を金融に特化させるためのガードレールを使用するフレームワークに依存しています。 フィンテックスタートアップや大手国際銀行がLLMと生成型AIの使用を拡大し、内部および外部の利害関係者に対して洗練されたバーチャルアシスタントを提供し、ハイパーカスタマー向けのコンテンツを作成し、マニュアル作業を削減するために文書要約を自動化し、テラバイトの公共および非公開データを分析して投資の洞察を生成することを期待してください。 小売業における生成AI…

大規模な言語モデルによるレッドチーミング

警告: この記事はレッドチーミングについてであり、そのためモデル生成の例が不快または不快なものである可能性があります。 大量のテキストデータで訓練された大規模な言語モデル(LLM)は、現実的なテキストを生成するのに非常に優れています。しかし、これらのモデルは、個人情報(社会保障番号など)の公開や誤情報、偏見、憎悪、有害なコンテンツの生成など、望ましくない振る舞いをしばしば示します。たとえば、GPT3の以前のバージョンは、性差別的な振る舞い(以下参照)やムスリムに対する偏見を示すことが知られていました。 LLMを使用する際にこのような望ましくない結果を発見した場合、Generative Discriminator Guided Sequence Generation(GeDi)やPlug and Play Language Models(PPLM)などの戦略を開発してそれらからそれを逸らすことができます。以下は、同じプロンプトを使用してGPT3の生成を制御するためにGeDiを使用した例です。 最近のGPT3のバージョンでも、プロンプトインジェクションによる攻撃を受けると同様に不快なテキストが生成され、その結果、下流のアプリケーションのセキュリティ上の懸念となる可能性があります。このブログで説明されています。 レッドチーミングは、望ましくない振る舞いを引き起こす可能性のあるモデルの脆弱性を引き出す評価の形式です。ジェイルブレイキングは、LLMがそのガードレールから逸脱するように操作されるレッドチーミングの別の言葉です。MicrosoftのチャットボットTay(2016年)やより最近のBingのチャットボットシドニーは、レッドチーミングを使用して基礎となるMLモデルの徹底的な評価の欠如がどれほど壊滅的な結果をもたらすかの実際の例です。レッドチームのアイデアの起源は、軍隊によって実施された対抗者シミュレーションやウォーゲームに遡ることができます。 レッドチーミングの目標は、モデルが有害なテキストを生成する可能性が高いテキストを生成するようにするプロンプトを作成することです。レッドチーミングは、MLのより一般的に知られた評価形式である敵対的攻撃といくつかの類似点と相違点を共有しています。その類似点は、レッドチーミングと敵対的攻撃が実際のユースケースで望ましくないコンテンツを生成するためにモデルを「攻撃」または「だます」という共通の目標を持っていることです。ただし、敵対的攻撃は人間には理解しにくい場合があります。たとえば、各プロンプトに「aaabbbcc」という文字列を接頭辞として付けると、モデルのパフォーマンスが低下するためです。Wallace et al.、’19では、さまざまなNLP分類および生成タスクにおけるそのような攻撃の多くの例が議論されています。一方、レッドチーミングのプロンプトは通常、通常の自然言語のプロンプトと似ています。 レッドチーミングは、ユーザーの不快な体験を引き起こしたり、悪意を持つユーザーによる暴力やその他の違法な活動を支援する可能性があるモデルの制限を明らかにすることができます。レッドチーミングからの出力(敵対的攻撃と同様)は、一般にモデルを訓練して、有害な結果を引き起こす可能性を低くするか、またはそれから逸らすために使用されます。 レッドチーミングは、可能なモデルの障害物の創造的な考えを必要とするため、リソースを消費する問題です。回避策として、与えられたプロンプトにオフェンシブな生成を引き起こす可能性のあるトピックやフレーズを予測するために訓練された分類器をLLMに追加することができます。このような戦略は慎重な方向に進むでしょう。しかし、それは非常に制限的であり、モデルを頻繁に回避的にする原因となります。したがって、モデルが役立つこと(指示に従うこと)と無害であること(少なくとも有害な行動を引き起こしにくいこと)の間には緊張があります。 レッドチームは、ハードループ内の人間または有害な出力をテストするために別のLMをテストしているLMです。安全性とアライメントのためにファインチューニングされたモデルに対してレッドチーミングプロンプトを作成するには、Ganguli et al.、’22で説明されているような悪意のあるキャラクターとして振る舞うようにLLMに指示する役割プレイ攻撃の形で創造的な思考が必要です。モデルに自然言語の代わりにコードで応答するように指示することも、モデルの学習バイアスを明らかにすることができます。 さらなる例については、このツイートスレッドをご覧ください。 ChatGPT自体によるLLMのジェイルブレイキングのアイデアのリストは次のとおりです。…

倫理と社会ニュースレター#4:テキストから画像へのモデルにおけるバイアス

要約: テキストから画像へのモデルのバイアスを評価するためにより良い方法が必要です はじめに テキストから画像(TTI)生成は最近のトレンドであり、数千のTTIモデルがHugging Face Hubにアップロードされています。各モダリティは異なるバイアスの影響を受ける可能性がありますが、これらのモデルのバイアスをどのように明らかにするのでしょうか?このブログ投稿では、TTIシステムのバイアスの源泉、それらに対処するためのツールと潜在的な解決策について、私たち自身のプロジェクトと広範なコミュニティのものを紹介します。 画像生成における価値観とバイアスのエンコード バイアスと価値観には非常に密接な関係があります。特に、これらが与えられたテキストから画像モデルのトレーニングやクエリに埋め込まれている場合、この現象は生成された画像に大きな影響を与えます。この関係は、広範なAI研究分野で知られており、それに対処するためのかなりの努力が進行中ですが、特定のモデルで進化する人々の価値観を表現しようとする複雑さは依然として存在しています。これは、適切に明らかにし、対処するための持続的な倫理的な課題を提起します。 たとえば、トレーニングデータが主に英語である場合、それはおそらく西洋の価値観を伝えています。その結果、異なる文化や遠い文化のステレオタイプな表現が得られます。以下の例では、同じプロンプト「北京の家」に対してERNIE ViLG(左)とStable Diffusion v 2.1(右)の結果を比較すると、この現象が顕著に現れます: バイアスの源泉 近年、自然言語処理(Abidら、2021年)およびコンピュータビジョン(BuolamwiniおよびGebru、2018年)の両方の単一モダリティのAIシステムにおけるバイアス検出に関する重要な研究が行われています。MLモデルは人々によって構築されるため、すべてのMLモデル(そして技術全般)にはバイアスが存在します。これは、画像の中で特定の視覚的特性が過剰または過少に表現される(たとえば、オフィスワーカーのすべての画像にネクタイがある)ことや、文化的および地理的なステレオタイプの存在(たとえば、白いドレスとベールを着た花嫁のすべての画像、代表的な花嫁のイメージである赤いサリーの花嫁など)が現れることで現れます。AIシステムは広く異なるセクターやツール(例:Firefly、Shutterstock)に展開される社会技術的なコンテキストで展開されるため、既存の社会的なバイアスや不平等を強化する可能性があります。以下にバイアスの源泉の非徹底的なリストを示します: トレーニングデータのバイアス:テキストから画像への変換のための人気のあるマルチモーダルデータセット(たとえば、テキストから画像へのLAION-5B、画像キャプショニングのMS-COCO、ビジュアルクエスチョンアンサリングのVQA v2.0など)には、多数のバイアスや有害な関連が含まれていることが判明しています(Zhaoら、2017年、PrabhuおよびBirhane、2021年、Hirotaら、2022年)。これらのデータセットでトレーニングされたモデルには、画像生成の多様性の欠如や、文化やアイデンティティグループの共通のステレオタイプが永続化するという初期の結果がHugging Face Stable Biasプロジェクトから示されています。たとえば、CEO(右)とマネージャー(左)のDall-E 2の生成結果を比較すると、両方とも多様性に欠けていることがわかります: 事前トレーニングデータのフィルタリングにおけるバイアス:モデルのトレーニングに使用される前に、データセットに対して何らかの形のフィルタリングが行われることがよくあります。これにより、異なるバイアスが導入されます。たとえば、Dall-E 2の作者たちは、トレーニングデータのフィルタリングが実際にバイアスを増幅することを発見しました。これは、既存のデータセットが女性をより性的な文脈で表現するというバイアスや、使用されるフィルタリング手法の固有のバイアスに起因する可能性があると彼らは仮説を立てています。 推論におけるバイアス:Stable…

2023年のMLOpsの景色:トップのツールとプラットフォーム

2023年のMLOpsの領域に深く入り込むと、多くのツールやプラットフォームが存在し、モデルの開発、展開、監視の方法を形作っています総合的な概要を提供するため、この記事ではMLOpsおよびFMOps(またはLLMOps)エコシステムの主要なプレーヤーについて探求します...

GopherCite 検証済みの引用を使用して回答を支援するための言語モデルの教育

ゴーファーのような言語モデルは、信憑性があるように見えるが実際には偽りの情報を「幻覚」させることがありますこの問題に詳しい人々は、言語モデルの言うことを信じるのではなく、独自の事実確認を行うことを知っていますそうでない人々は、真実でないことを信じてしまう可能性があります本論文では、言語モデルの幻覚化の問題に対処することを目指したモデルであるゴーファーサイトについて説明していますゴーファーサイトは、すべての事実的な主張をウェブの証拠で裏付けることを試みます

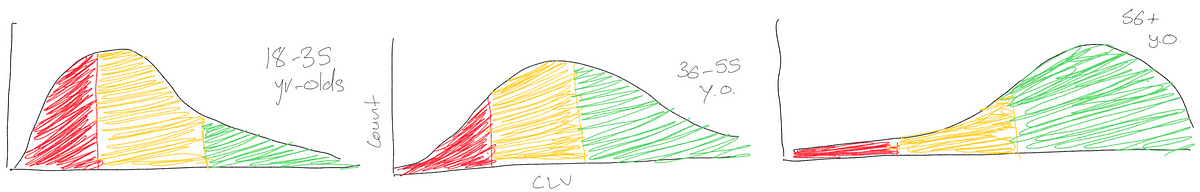

分析から実際の応用へ:顧客生涯価値の事例

データサイエンティスト、マーケター、あるいはデータリーダーであろうと、もし「顧客生涯価値」をGoogleで検索したことがあるなら、がっかりしたことでしょう私もかつてCLVを担当していた時に同じように感じました

Googleはチャットボットの使用について従業員に警告、ここにその理由があります

Googleの親会社であるAlphabet Inc.は、ChatGPTや自社製品であるBardを含むチャットボットの使用について従業員に注意を促しています。この警告は、同社がチャットボットプログラムの範囲をグローバルに拡大するにつれて行われました。この開発の詳細について探求し、懸念事項を理解してみましょう。 また読む:セキュリティ上の懸念から、Samsungが従業員にジェネレーティブAIの使用を禁止 機密情報の保護 問題に詳しい情報源によると、Alphabetは従業員に対して、Bardを含むAIチャットボットに機密資料を入力しないよう指示しています。この指示は、同社の情報保護ポリシーと一致しています。BardやChatGPTなどのチャットボットは、ユーザーとの会話を行い、応答を提供するために設計されていますが、AIモデルは吸収したトレーニングデータを再現する可能性があるため、データ漏洩の潜在的なリスクがあります。 また読む:専門家によると、AIがあなたのデータを盗んでいる エンジニアとプログラマの注意事項 機密情報の入力を避けることに加えて、Alphabetはエンジニアに対して、チャットボットのコンピュータコードを直接使用しないよう警告しています。Bardは提案を行うかもしれませんが、プログラマは注意を払うことが重要です。Googleは、自社の技術の制約を認識し、意図しない結果を引き起こさないようにするために、透明性を維持することを目指しています。 また読む:ライバルのSamsungに続いて、Appleがプライバシーの懸念からChatGPTを禁止 競争の激しい環境とビジネスへの影響 Googleのチャットボットの使用に対する警戒感は、OpenAIとMicrosoft Corp.がバックアップしているChatGPTとの競争に起因しています。これらのAIプログラムの成功には、数十億ドルの投資、潜在的な広告収益、クラウド収益がかかっています。Googleの予防措置は業界全体のトレンドであり、Samsung、Amazon.com、Deutsche Bankなどの他の企業もAIチャットボットのガードレールを導入しています。 また読む:MicrosoftとOpenAIがAI統合で対立 従業員のAIツールとセキュリティ基準の使用 米国のトップ企業の専門家を対象とした調査によると、回答者の約43%がChatGPTなどのAIツールを使用しており、上司に通知せずに使用していることが明らかになりました。潜在的なリスクを軽減するため、Apple(未確認)を含む世界の企業は、公開されているチャットプログラムの使用について従業員に警告するためにセキュリティ基準を採用しています。 プライバシーの懸念と規制に関する対話 Googleはアイルランドのデータ保護委員会と詳細な協議を行い、プライバシーに関連する懸念を解消し、規制要件に準拠するための対策を講じています。Politicoの最新の報告書によれば、Bardの欧州連合での導入は、プライバシーの影響に関する追加情報が得られるまで延期されました。Googleの更新されたプライバシー通知では、ユーザーに対して、Bardの会話に機密情報や個人情報を含めないようにアドバイスしています。 また読む:欧州データ保護委員会がChatGPTプライバシータスクフォースを設立 革新的なソリューションによるリスクの軽減 企業は、これらの懸念に対処するためのソフトウェアソリューションの開発に積極的に取り組んでいます。たとえば、サイバーセキュリティおよびクラウドサービスの主要なプロバイダであるCloudflareは、特定のデータを外部への送信からタグ付けおよび制限することができます。GoogleやMicrosoftもビジネス向けの対話ツールを提供し、公開されているAIモデルに組み込まないことでデータのプライバシーを確保しています。ただし、BardとChatGPTのデフォルト設定では、ユーザーの会話履歴が保存されますが、ユーザーは削除することができます。 私たちの意見 GoogleがBardを含むチャットボットの使用に関して従業員に警告することは、同社がデータのプライバシーとセキュリティに対する取り組みを反映しています。AI技術が進化し続ける中、組織がセーフガードを実施し、責任ある使用を促進することが重要です。AIチャットボットのダイナミックな環境では、イノベーションとリスク軽減の繊細なバランスが求められます。Googleなどの企業がこれらの懸念に取り組むことで、AI技術が安全かつ倫理的に活用される未来に向けて取り組んでいます。

ジョン・イサザ弁護士、FAI氏によるAIとChatGPTの法的な土壌を航行する方法

私たちは、Rimon LawのパートナーであるJohn Isaza, Esq., FAIに感謝しています彼は、法的な景観の変化、プライバシー保護とイノベーションの微妙なバランス、そしてAIツールを統合する際に生じる独特の法的な意義など、多岐にわたる側面で自身の物語と貴重な洞察を共有してくれましたJohnは、AIに関連する課題や考慮事項について貴重な観点を提供しています...John Isaza, Esq., FAI がAIとChatGPTの法的景観を航海するための記事を読む»

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.