Learn more about Search Results Transformer - Page 91

- You may be interested

- DataHour ChatGPTの幻視を80%減らす

- 新しいOpenAIのGPTsサービスが小規模ビジ...

- 価値あるデータテストの作成方法

- ユリーカに会ってください:大規模な言語...

- 27/11から03/12までの週の主要なコンピュ...

- 「データサイエンスは循環経済をどのよう...

- 「Amazon SageMakerでのRayを使用した効果...

- 「時代遅れのパスワードの慣行が広まって...

- ウェアラブルテックを革命:エッジインパ...

- 中国の研究者たちは、構造化データに対す...

- このAI論文は、「GREAT PLEA」倫理的フレ...

- 「Declarai、FastAPI、およびStreamlitを...

- 遺伝的アルゴリズムを使用したPythonによ...

- 時系列分析 VARMAX-As-A-Service

- このAI論文は、大規模な言語モデルにおけ...

生成AI:世界はどこに向かっているのか?

はじめに テクノロジーの絶え間ない進化の世界で、AI製品の開発と展開が急速に拡大していることを目撃しています。過去6か月間、大手のテック企業や野心的なスタートアップ企業が人工知能の分野で大きな進展を遂げてきました。マイクロソフトやOpenAIなどの企業が注目を集めている一方で、彼らは氷山の一角に過ぎないことを認識することが重要です。 急速に成長しているエンタープライズAI産業で競争力を維持するために、事業は常に革新し、新たな可能性を探求しています。そのような戦略の一つは、他社との協力や非組織的な成長です。業界内の他の企業の専門知識とリソースを活用することで、事業は顧客向けに優れた製品やサービスを開発することができます。さらに、これらのパートナーシップは新たな市場や以前にアクセスできなかった機会を開くものです。合併、買収、そしてパートナーシップは、新しい技術、人材、顧客基盤へのアクセスを提供し、事業が提供するオファリングを拡大し、収益の多様化を図ることを可能にします。 私の観点から見ると、現在のAIの進化サイクルは3つの異なるフェーズに分けることができます。それぞれが成長と進歩を推進しています。 あらゆる技術の成長フェーズ あらゆる技術は成長の初期段階、成熟期、時代遅れの3つのフェーズを経ます。 出現:このフェーズでは、新しい技術が出現し注目を集めます。始まりは少数の先駆的な個人や組織が概念の探求と開発を行うことから始まることが多いです。このフェーズでは、応用が限定的で広範な認識や採用がないことがあります。主な焦点は研究、実験、概念の証明にあります。 成長と拡大:技術が実力を示し、その可能性を証明すると、成長と拡大のフェーズに入ります。開発により、機能性、効率性、使いやすさが向上します。公共および私的セクターからの投資の増加が進歩を推進する重要な役割を果たします。このフェーズでは、技術がより広範に受け入れられ、多くの企業が市場に参入し、消費者が採用し始めます。革新と競争が活気づき、急速な進展と改善が生まれます。このフェーズはまた、協力や戦略的パートナーシップを引き起こします。 成熟と統合:成熟フェーズでは、技術は業界や社会の確立された一部となります。成長率が安定し、進歩が革命的ではなく漸進的になるポイントに達します。技術は人々の生活や既存のシステムに深く統合されています。このフェーズでは優勝者が出始めます。標準化、最適化、相互運用性はこのフェーズで重要な焦点となります。重要なブレークスルーはまだ発生するかもしれませんが、初期のステージと比べると頻度は低くなります。 では、技術としての生成AIが進化のどの段階にあるのか見ていきましょう。これらのフェーズを1つずつ探っていきましょう。 詳細はこちら: 生成AI: 定義、ツール、モデル、利点など フェーズ1: 出現 – 新たなAIの時代の幕開け 最近、AIは前例のない出現のフェーズを経験しています。また、重要な製品の導入と新たな時代の幕開けを特徴としています。特に、GPT-3(Generative Pre-trained Transformer 3)の導入は、この変革を促進する上で重要な役割を果たしています。その結果、ベンチャーキャピタルの投資がAIの景気づけに注ぎ込まれ、数多くのスタートアップ企業が資金調達を行い、画期的なAI製品を開発するためにAI競争に参加しています。フェーズ1は進行中のプロセスであり、少なくともさらなる6-12か月間は続くと予想されています。 この初期フェーズでは、業界の革新者がチャンスを掴み、前進することが予想されます。OpenAIとマイクロソフトの協力が注目すべき例です。彼らの成功は、裏方で技術を磨くための膨大な努力と熱意に帰することができます。これらの組織は、この変革期にAIが提供する可能性を受け入れる者に待ち受ける潜在的な報酬の見本です。 フェーズ1で達成された重要なマイルストーンについて詳しく知るには、次の注目すべき発表を参照してください。 これらのマイルストーンは、この分野で行われた画期的な進展を証明し、AI革命の勢いが止まることのない未来が訪れる舞台を設定しています。…

今日、開発者の70%がAIを受け入れています:現在のテックの環境での大型言語モデル、LangChain、およびベクトルデータベースの台頭について探求する

人工知能には無限の可能性があります。それは、新しいリリースや開発によって明らかになっています。OpenAIが開発した最新のチャットボットであるChatGPTのリリースにより、AIの領域はGPTのトランスフォーマーアーキテクチャのおかげで常に注目を浴びています。ディープラーニング、自然言語処理(NLP)、自然言語理解(NLU)からコンピュータビジョンまで、AIは無限のイノベーションをもたらす未来へと皆を推進しています。ほぼすべての産業がAIの潜在能力を活用し、自己革新を遂げています。特に大規模言語モデル(LLMs)、LangChain、およびベクトルデータベースの領域での優れた技術的進歩がこの素晴らしい発展の原動力です。 大規模言語モデル 大規模言語モデル(LLMs)の開発は、人工知能における大きな進歩を表しています。これらのディープラーニングベースのモデルは、自然言語を処理し理解する際に印象的な正確さと流暢さを示します。LLMsは、書籍、ジャーナル、Webページなど、さまざまなソースからの大量のテキストデータを使用してトレーニングされます。言語を学ぶ過程で、LLMsは言語の構造、パターン、および意味的な関連性を理解するのに役立ちます。 LLMsの基本的なアーキテクチャは通常、複数の層からなるディープニューラルネットワークです。このネットワークは、トレーニングデータで発見されたパターンと接続に基づいて、入力テキストを分析し予測を行います。トレーニングフェーズ中にモデルの期待される出力と意図された出力の不一致を減少させるために、モデルのパラメータは調整されます。LLMは、トレーニング中にテキストデータを消費し、文脈に応じて次の単語または単語のシリーズを予測しようとします。 LLMsの使用方法 質問への回答:LLMsは質問に回答するのが得意であり、正確で簡潔な回答を提供するために、本や論文、ウェブサイトなどの大量のテキストを検索します。 コンテンツ生成 – LLMsは、コンテンツ生成に活用されることが証明されています。彼らは、文法的に正しい一貫した記事、ブログエントリ、および他の文章を生成する能力を持っています。 テキスト要約:LLMsはテキスト要約に優れており、長いテキストを短く、より理解しやすい要約にまとめることができます。 チャットボット – LLMsは、チャットボットや対話型AIを使用したシステムの開発に頻繁に使用されます。これらのシステムは、質問を理解し適切に応答し、対話全体で文脈を保持することで、ユーザーと自然な言語で対話することができます。 言語翻訳 – LLMsは、言語の壁を乗り越えて成功したコミュニケーションを可能にするため、テキストの正確な翻訳が可能です。 LLMのトレーニングの手順 LLMのトレーニングの最初の段階は、モデルが言語のパターンや構造を発見するために使用する大規模なテキストデータセットを編集することです。 データセットが収集されたら、トレーニングのためにそれを準備するために前処理が必要です。これには、不要なエントリを削除することによるデータのクリーニングが含まれます。 LLMをトレーニングするために適切なモデルアーキテクチャを選択することは重要です。トランスフォーマベースのアーキテクチャは、GPTモデルを含む自然言語の処理と生成に非常に効率的であることが示されています。 モデルのパラメータを調整してLLMをトレーニングし、バックプロパゲーションなどのディープラーニング手法を使用してその精度を向上させます。モデルはトレーニング中に入力データを処理し、認識されたパターンに基づいて予測を行います。 初期のトレーニング後、LLMは特定のタスクやドメインでさらに微調整され、それらの領域でのパフォーマンスが向上します。 トレーニングされたLLMのパフォーマンスを評価し、モデルのパフォーマンスを評価するためのパープレキシティや精度などの複数のメトリクスを使用して、その効果を決定することが重要です。 トレーニングと評価が完了したLLMは、実際のアプリケーションのためのプロダクション環境で使用されます。…

光ニューラルネットワークとトランスフォーマーモデルを実行した場合、どのようなことが起こるのでしょうか?

ディープラーニングモデルの指数関数的な拡大スケールは、最先端の進化と巨大スケールのディープラーニングのエネルギー消費、速度、そして実現可能性についての増大する懸念の源であり、これによりディープラーニングの利用が指数関数的に増加しています。最近、Cornellの研究者は、特にTransformerのトポロジーについて話しました。これらのモデルは、数十億、あるいは数兆のパラメータにスケールアップすると劇的に優れた性能を発揮し、ディープラーニングコンピューティングの利用が指数関数的に増加します。これらの大規模なTransformerは、デジタルハードウェアのエネルギー効率が最先端のディープラーニングモデルのFLOP要件の上昇に追いついていないため、多くのタスクにおいて人気がありますが、高価な解決策です。また、コンピュータビジョン、グラフ、マルチモーダル設定など他の領域でもますます印象的なパフォーマンスを発揮しています。 また、これらのモデルは転移学習のスキルを持っており、追加のトレーニングなしで特定の活動に素早く一般化できる場合があります。これらのモデルのコストと一般的な機械学習の能力は、効果的で迅速な推論のためのハードウェアアクセラレータの創造の主要な推進力となっています。ディープラーニングハードウェアは、過去にはGPU、モバイルアクセラレータチップ、FPGA、大規模なAI専用アクセラレータシステムなど、デジタル電子工学で広範に開発されてきました。光学ニューラルネットワークは、他の方法と比較して、デジタルコンピュータ上のニューラルネットワークの実装よりも効率性とレイテンシが優れている解決策として提案されています。同時に、アナログコンピューティングにも大きな関心があります。 これらのアナログシステムはノイズやエラーの影響を受けやすいですが、ニューラルネットワークの演算は、通常は大規模な線形演算に分散されたウェイトとデータの読み込みに関連する電気オーバーヘッドを除いて、光学的により低コストで実行できます。Transformerなどの大規模なモデルの高速化は、特に有望です。理論的には、スケーリングはデジタルシステムよりもMACごとのエネルギー効率が漸近的に高いです。ここでは、彼らがこのスケーリングをどのように活用しているかを示します。彼らは、言語モデリングのための実際のTransformerからの演算をサンプリングし、実際の空間光変調器ベースの実験系で実行しました。そして、その結果を使用して、光学的に実行されるフルトランスフォーマーのキャリブレーションされたシミュレーションを作成しました。これは、ノイズやエラーの特性にもかかわらず、Transformerがこれらのシステム上で動作することを示すために行われました。 彼らは、これらの試行で得られたウェイトと入力を使用して、システマティックなエラー、ノイズ、および不正確さを伴うシミュレーションを行いました。すると、Transformerはデジタルで動作しているものとほぼ同等のパフォーマンスを発揮することがわかりました。以下は、彼らの主要な貢献の概要です: • 光学的なTransformerのパフォーマンスと総エネルギーコストのスケーリングルールを作成しました。彼らは実験的に示しました、Transformerの線形演算は、エラーやノイズにもかかわらず、実際の光学ハードウェア上で正確に実行できることを。 • シミュレーションとテストに基づいた設計を使用して、ONNアクセラレータのエネルギー消費量を予測しました。 • 光学は、最先端のプロセッサよりも桁違いに少ないエネルギーを消費すると計算しました。 彼らのシミュレーションとテストは特定のハードウェアを例示として使用していますが、彼らの焦点は広範です。彼らは光学エネルギースケーリングとノイズがTransformerの構築とパフォーマンスにどのように関連しているかを知りたいのです。その結果、ハードウェアの具体的な実装の詳細に関係なく、線形光学プロセッサに一般的に適用できる結論のほとんどが得られます。

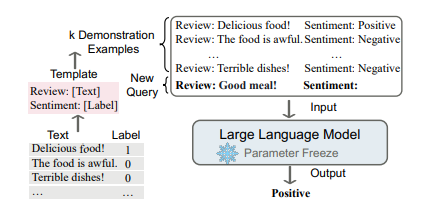

大規模な言語モデルにおけるコンテキストに基づく学習アプローチ

言語モデリング(LM)は、単語のシーケンスの生成的な尤度をモデル化することを目指し、将来の(または欠損している)トークンの確率を予測します言語モデルは自然言語処理の世界を革新しました...

既存のLLMプロジェクトをLangChainを使用するように適応する

おめでとうございます!素晴らしいLLMの概念証明が完成しましたね自信を持って世界に披露できます!もしかしたら、OpenAIライブラリを直接利用したかもしれませんし、他のライブラリを使用しているかもしれませんが、どのようにしても、この素晴らしい成果を誇示できます!

Webスケールトレーニング解放:DeepMindがOWLv2とOWL-STを紹介、未知語彙物体検出の革新的ツール、前例のない自己学習技術によって駆動されます

オープンボキャブラリーの物体検出は、さまざまな実世界のコンピュータビジョンタスクにおいて重要な要素です。ただし、検出トレーニングデータの入手の制約と、事前学習モデルの脆弱性により、性能が劣り、スケーラビリティの問題が生じることが多いです。 この課題に対処するため、DeepMindの研究チームは最新の論文「Scaling Open-Vocabulary Object Detection」で、最適化されたアーキテクチャであるOWLv2モデルを紹介しています。このモデルはトレーニング効率を改善し、OWL-STセルフトレーニングの手法を組み込んで検出性能を大幅に向上させ、オープンボキャブラリー検出タスクでの最先端の結果を達成します。 この研究の主な目的は、ラベルスペース、注釈フィルタリング、およびオープンボキャブラリー検出セルフトレーニング手法のトレーニング効率を最適化し、限られたラベル付きデータで堅牢でスケーラブルなオープンボキャブラリー性能を実現することです。 提案されたセルフトレーニング手法は、次の3つの主要なステップで構成されています: チームは既存のオープンボキャブラリー検出器を使用して、WebLIという大規模なウェブ画像テキストペアのデータセットでオープンボックス検出を行います。 彼らはOWL-ViT CLIP-L/14を使用して、すべてのWebLI画像に境界ボックスの疑似注釈を付けます。 彼らは、人間による注釈付けされた検出データを使用してトレーニングモデルを微調整し、パフォーマンスをさらに向上させます。 特筆すべきは、研究者がより効果的な検出器を訓練するために、OWL-ViTアーキテクチャのバリアントを使用していることです。このアーキテクチャは、コントラストトレーニングされた画像テキストモデルを利用して画像とテキストのエンコーダを初期化し、検出ヘッドはランダムに初期化されます。 トレーニングの段階では、チームは同じ損失関数を使用し、OWL-ViTアーキテクチャから「疑似ネガティブ」をクエリに追加して、利用可能なラベル付き画像の利用を最大化するためにトレーニング効率を最適化します。 さらに、大規模Transformerトレーニングのために以前に提案された手法を組み込んで、トレーニング効率をさらに向上させます。その結果、OWLv2モデルは、元のOWL-ViTモデルに比べてトレーニングFLOPSを約50%削減し、トレーニングスループットを2倍に加速します。 チームは実証的な研究で、提案手法を以前の最先端のオープンボキャブラリー検出器と比較しています。OWL-ST技術により、LVISの稀なクラスの平均精度(AP)が31.2%から44.6%に向上します。さらに、OWL-STレシピをOWLv2アーキテクチャと組み合わせることで、新たな最先端のパフォーマンスが実現されます。 全体的に、本論文で提案されたOWL-STレシピは、大規模なウェブデータからの弱教師付き学習を活用して検出性能を大幅に向上させ、オープンワールドの位置特定におけるウェブスケールのトレーニングを実現します。この手法は、ラベル付き検出データの希少性による制約に対処し、堅牢なオープンボキャブラリー物体検出のスケーラブルな手法の可能性を示しています。

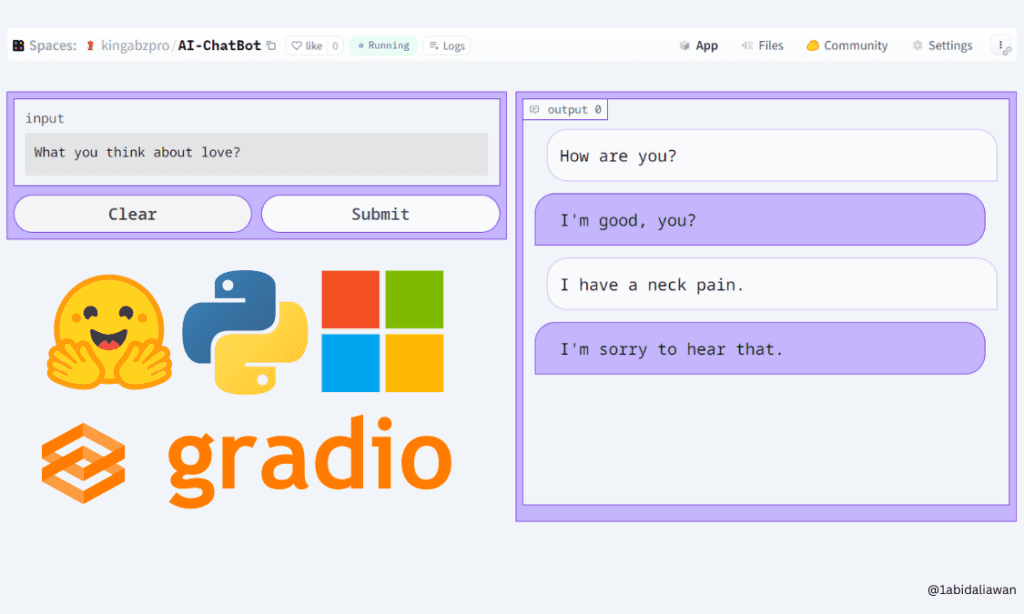

Hugging FaceとGradioを使用して、5分でAIチャットボットを構築する

この簡単なチュートリアルを使って、ブラウザ上で低コード技術を使ってGradioチャットボットを作成する方法を学びましょう

ChatHNに会いましょう:ハッカーニュースフィード上のリアルタイムAIパワーチャット

ChatHNはAIによって駆動され、最近Hacker News Feedで開始されました。ChatHNは、OpenAI FunctionsとVercel AI SDKを使用して構築された無料かつオープンソースの人工知能(AI)チャットボットであり、Hacker News APIとの対話的なインタラクションを提供します。https://github.com/steven-tey/chathnの手順に従って、誰でも1クリックでChatHNのインスタンスを展開することができます。 ChatHNは、Hacker News(HN)との対話的なインタラクションを容易にするプラットフォームです。最も人気のある記事、特定の記事、またはHacker Newsからの記事とコメントを取得するなどの機能があります。ChatHNは、Hacker News上の最も人気のあるストーリーとコメントを要約するためにも使用できます。ChatHNは、Hacker NewsのウェブサイトやAPIを直接使用せずに、Hacker Newsの素材への対話的なアクセスを容易にすることを目指しています。 使用および変更は完全に無料で、以下のものを使用して開発されました。 OpenAIの新しいFunctions Calling機能 Vercel AI SDK HackerNews API こちらをご覧ください:chathn.vercel.app OpenAIのFunctions…

Google DeepMindは、ChatGPTを超えるアルゴリズムの開発に取り組んでいます

画期的な発表により、GoogleのDeepMind AI研究所のCEOであるデミス・ハサビス氏は、革新的なAIシステムであるGeminiの開発を発表しました。Geminiは、DeepMindが囲碁のゲームでの歴史的な勝利から導き出した技術を活用し、OpenAIのChatGPTを超える予定のアルゴリズムを持つことで、人工知能の分野で重要なマイルストーンを示すものです。この発表は、AIの未来における能力の向上と革新的な進展を約束するものであり、その詳細と将来への潜在的な影響について詳しく探っていきます。 Gemini:AI技術の次の飛躍 DeepMindの画期的なAIシステムであるGeminiは、人工知能の分野でのゲームチェンジャーとして登場しました。AlphaGoの驚異的な成果を基にしたGeminiは、DeepMindの先駆的な技術とGPT-4の言語能力を組み合わせることで、OpenAIのChatGPTの能力を超えるものとなっています。これらの強みの融合により、GeminiはAIの景観を再定義する有望なイノベーションとなっています。 強みの融合:AlphaGoとGPT-4のシナジー AlphaGoの強力な技法をGPT-4モデルに取り入れることで、Geminiは従来の言語モデルの制約を超越します。Geminiの言語能力と問題解決能力のユニークな組み合わせは、AIを革新することを約束します。DeepMindのCEOであるデミス・ハサビス氏は、テキストの理解と生成に優れたシステムが複雑な問題を計画し解決する能力を持つシステムを想像しています。 また読む:DeepMind CEOがAGIの実現が非常に近い可能性を示唆 革新の公開:Geminiの魅力的な特徴 Geminiは、AIの能力の限界を押し広げる多くの魅力的な特徴を導入する予定です。AlphaGoタイプのシステムと大規模な言語モデルの結合により、GeminiはAIの潜在能力の新たな時代をもたらします。DeepMindのエンジニアたちは、Gemini内のいくつかの興味深いイノベーションを示唆しており、公式のローンチに対する期待感をさらに高めています。 強化学習:AlphaGoの成功の基盤 画期的な強化学習技術は、AlphaGoの歴史的な勝利の中核にありました。DeepMindのソフトウェアは、繰り返しの試行とパフォーマンスに対するフィードバックを通じて、複雑な問題をマスターしました。さらに、AlphaGoはツリーサーチと呼ばれる方法を利用して、ボード上の潜在的な手を探索して記憶することができました。この基盤はGeminiの将来の発展の基礎となっています。 また読む:強化学習の包括的なガイド 進行中の旅:Geminiの開発 Geminiはまだ開発段階にありますが、ハサビス氏はその取り組みと投資の大きさを強調しています。DeepMindのチームは、Geminiを完成させるために数か月と膨大な資金(数千万ドルまたは数億ドルにもなる可能性があります)が必要となると推定しています。この取り組みの重要性は、Geminiの潜在的な影響の重要性を示しています。 競争に対抗する:Googleの戦略的な対応 OpenAIのChatGPTが注目を集める中、Googleは迅速に生成型AIを製品に統合し、チャットボットBardを導入し、AIを検索エンジンに組み込みました。GoogleはDeepMindとGoogleの主要なAI研究所であるBrainを統合してGoogle DeepMindを形成することで、ChatGPTによる競争の脅威に対処しようとしています。この戦略的な動きは、GoogleがAIのイノベーションの最前線にとどまることへの取り組みを示しています。 また読む:Chatgpt-4対Google Bard:ヘッドトゥヘッドの比較 DeepMindの旅:買収から驚嘆まで DeepMindの2014年のGoogleによる買収は、AI研究における転換点となりました。この会社の革新的なソフトウェアは強化学習によって駆動し、以前には想像もつかなかった能力を示しました。AlphaGoが2016年に囲碁のチャンピオン李世ドルに対して勝利を収めたことは、AIコミュニティを驚かせ、複雑なゲームにおける人間レベルの熟練度を達成するためのタイムラインに関する先入観に挑戦しました。 また読む:DeepMindのAIマスターゲーマー:2時間で26のゲームを学ぶ トランスフォーマーのトレーニング:大規模言語モデルの基盤…

QLoRAを使用して、Amazon SageMaker StudioノートブックでFalcon-40Bと他のLLMsをインタラクティブにチューニングしてください

大規模な言語モデル(LLM)の微調整により、オープンソースの基礎モデルを調整して、特定のドメインタスクでのパフォーマンスを向上させることができますこの記事では、Amazon SageMakerノートブックを使用して、最新のオープンソースモデルを微調整する利点について説明します私たちは、Hugging Faceのパラメータ効率の良い微調整(PEFT)ライブラリと、bitsandbytesを介した量子化技術を利用して、インタラクティブな微調整をサポートしています

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.