Learn more about Search Results こちら - Page 91

- You may be interested

- 「イーロン・マスク氏、中国での超知能の...

- 人材分析のための R ツールキット:ヘッド...

- ロッテン・トマト映画評価予測のデータサ...

- このAI研究は、「ニューラルA *:パスプラ...

- 「中国AI研究チームが導入した4K4D ハード...

- 「IDEFICSをご紹介します:最新の視覚言語...

- 「13/11から19/11までの週のトップ重要なL...

- 州は、より多くのコンピューターサイエン...

- 気候変動の責任は誰にあるのか? – ...

- 「データサイエンスの熱狂者にとっての必...

- 「0人の従業員で250万ドルを稼ぐ(ジャス...

- 生成AI:シームレスなデータ転送のための...

- 「生データから洗練されたデータへ:デー...

- Hugging Faceを使用してWav2Vec2を英語音...

- 物体検出評価指標の概要

基礎モデルは人間のようにデータにラベルを付けることができますか?

ChatGPTの登場以来、Large Language Models(LLM)の開発に前例のない成長が見られ、特にプロンプト形式の指示に従うように微調整されたチャットモデルの開発が増えてきました。しかし、これらのモデルの比較は、その性能を厳密にテストするために設計されたベンチマークの不足により明確ではありません。指示とチャットモデルの評価は本質的に困難であり、ユーザーの好みの大部分は質的なスタイルに集約されていますが、過去のNLP評価ははるかに定義されていました。 このような状況で、新しい大規模言語モデル(LLM)が「モデルはChatGPTに対してN%の時間で優先される」という調子でリリースされるのはよくあることですが、その文から省かれているのは、そのモデルがGPT-4ベースの評価スキームで優先されるという事実です。これらのポイントが示そうとしているのは、異なる測定の代理となるものです:人間のラベラーが提供するスコア。人間のフィードバックから強化学習でモデルを訓練するプロセス(RLHF)は、2つのモデル補完を比較するためのインターフェースとデータを増やしました。このデータはRLHFプロセスで使用され、優先されるテキストを予測する報酬モデルを訓練するために使用されますが、モデルの出力を評価するための評価とランキングのアイデアは、より一般的なツールとなっています。 ここでは、ブラインドテストセットのinstructとcode-instructの分割それぞれからの例を示します。 反復速度の観点では、言語モデルを使用してモデルの出力を評価することは非常に効率的ですが、重要な要素が欠けています:下流のツールショートカットが元の測定形式と整合しているかどうかを調査することです。このブログ投稿では、オープンLLMリーダーボード評価スイートを拡張することで、選択したLLMから得られるデータラベルを信頼できるかどうかを詳しく調べます。 LLMSYS、nomic / GPT4Allなどのリーダーボードが登場し始めましたが、モデルの能力を比較するための完全なソースが必要です。一部のモデルは、既存のNLPベンチマークを使用して質問応答の能力を示すことができ、一部はオープンエンドのチャットからのランキングをクラウドソーシングしています。より一般的な評価の全体像を提示するために、Hugging Face Open LLMリーダーボードは、自動化された学術ベンチマーク、プロの人間のラベル、およびGPT-4の評価を含むように拡張されました。 目次 オープンソースモデルの評価 関連研究 GPT-4評価の例 さらなる実験 まとめとディスカッション リソースと引用 オープンソースモデルの評価 ヒトがデータをキュレートする必要があるトレーニングプロセスのどのポイントでもコストがかかります。これまでに、AnthropicのHHHデータ、OpenAssistantの対話ランキング、またはOpenAIのLearning to Summarize /…

AIポリシー@🤗:AIの説明責任に関する米国NTIAのコメント依頼への回答

6月12日、Hugging Faceは米国商務省NTIAからのAI責任ポリシーに関する情報提供依頼に対して回答を提出しました。私たちの回答では、AIの責任プロセスを推進するために文書化と透明性の基準の役割を強調し、また、前例のない成長があらゆる質問を生み出しているこの技術の見通しに取り組むために、技術の多様な関係者の広範な専門知識、視点、スキルに頼る必要性を強調しました。 Hugging Faceの使命は、「良い機械学習を民主化すること」です。私たちは、この文脈での「民主化」という用語を、機械学習システムを開発・展開するだけでなく、多くの関係者が理解し、尋問し、批判できるようにすることを意味するものと理解しています。そのために、私たちは教育活動、文書化への焦点、コミュニティガイドラインや責任あるオープンなアプローチへの取り組みを通じて透明性と包括性を促進してきました。また、技術的なバックグラウンドのレベルに関わらず、すべての人々がMLデータセットとモデルを分析できるようにするためのノーコードおよびローコードツールの開発も行っています。これにより、MLシステムの制約をよりよく理解し、これらのシステムによって利用者と影響を受ける人々に安全に活用される方法をより良く理解することができます。これらのアプローチは、特に私たちが主催した大規模な多学際的研究プロジェクトでの責任促進において、既にその有用性を証明しています(プロジェクトの社会的な利害に関するブログシリーズを参照してください)。最近のBigCodeプロジェクト(そのガバナンスについてはこちらで詳述しています)も含め、 具体的には、以下のような責任機構の推奨事項を示します: 責任機構は、MLの開発プロセスのすべての段階に焦点を当てる必要があります。完全なAI対応システムの社会的影響は、完全に予測不可能な方法で開発の各段階での選択に依存しており、展開段階にのみ焦点を当てた評価は、表面的な準拠に対応するだけで深層の問題に対処することはありません。 責任機構は、内部要件と外部アクセスを組み合わせる必要があります。良い文書化のような内部要件は、より責任ある開発を形成し、開発者の責任を明確にし、より安全で信頼性の高い技術を提供します。内部プロセスと開発の選択に対する外部アクセスは、主張や文書化を検証し、技術の多くの利害関係者が開発チェーンの外にいるため、その進化を意味のある形で形作り、関与させるために必要です。 責任機構は、開発者だけでなく、多学際的な研究コミュニティ、提唱団体、政策立案者、ジャーナリストなど、可能な限り幅広い貢献者からの参加を求めるべきです。ML技術の急速な普及の変革的な影響を理解することは、任意の単一の組織の能力を超えた課題であり、広範な研究コミュニティとその直接の利用者や影響を受ける人々の幅広いスキルと専門知識を活用する必要があります。 これらの目標を達成するために、MLアーティファクト自体とその評価結果の両方で透明性を優先することが重要だと考えています。より詳細な回答は、こちらでご覧いただけます。

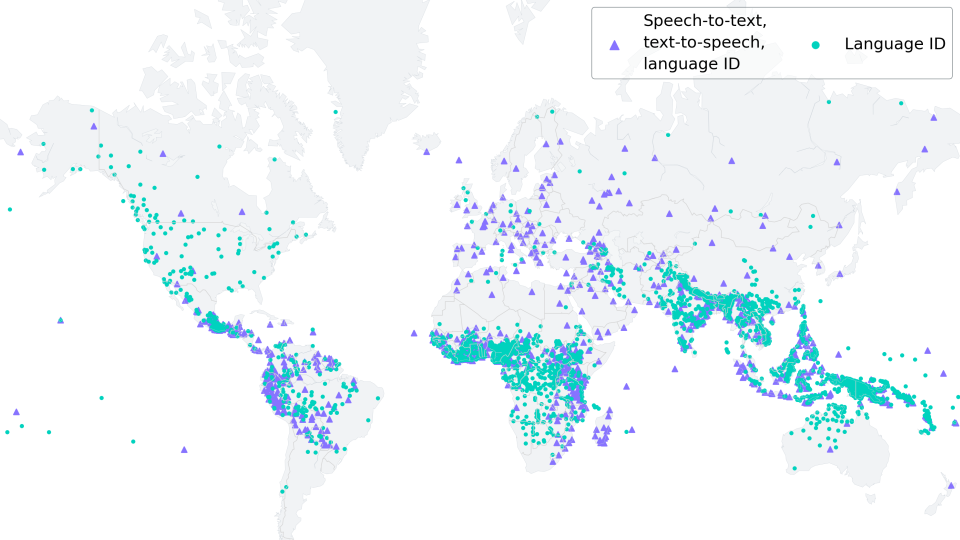

低リソースASRのためのMMSアダプターモデルの微調整

新しい(06/2023):このブログ記事は、「多言語ASRでのXLS-Rの微調整」に強く触発され、それの改良版として見なされるものです。 Wav2Vec2は、自動音声認識(ASR)のための事前学習モデルであり、Alexei Baevski、Michael Auli、およびAlex Conneauによって2020年9月にリリースされました。Wav2Vec2の強力なパフォーマンスが、ASRの最も人気のある英語データセットであるLibriSpeechで示された直後、Facebook AIはWav2Vec2の2つのマルチリンガルバージョンであるXLSRとXLM-Rを発表しました。これらのモデルは128の言語で音声を認識することができます。XLSRはクロスリンガル音声表現を意味し、モデルが複数の言語で有用な音声表現を学習する能力を指します。 Meta AIの最新リリースであるMassive Multilingual Speech(MMS)(Vineel Pratap、Andros Tjandra、Bowen Shiなどによる)は、マルチリンガル音声表現を新たなレベルに引き上げています。1,100以上の話されている言語が識別、転写、生成され、さまざまな言語識別、音声認識、テキスト読み上げのチェックポイントがリリースされます。 このブログ記事では、MMSのアダプタートレーニングが、わずか10〜20分の微調整後でも驚くほど低い単語エラーレートを達成する方法を示します。 低リソース言語の場合、私たちは「多言語ASRでのXLS-Rの微調整」と同様にモデル全体を微調整するのではなく、MMSのアダプタートレーニングの使用を強くお勧めします。 私たちの実験では、MMSのアダプタートレーニングはメモリ効率がよく、より堅牢であり、低リソース言語に対してはより優れたパフォーマンスを発揮することがわかりました。ただし、VoAGIから高リソース言語への場合は、Adapterレイヤーの代わりにモデル全体のチェックポイントを微調整する方が依然として有利です。 世界の言語多様性の保存 https://www.ethnologue.com/によると、約3000の「生きている」言語のうち、40%、つまり約1200の言語が、話者が減少しているために危機に瀕しています。このトレンドはますますグローバル化する世界で続くでしょう。 MMSは、アリ語やカイビ語など、絶滅危惧種である多くの言語を転写することができます。将来的には、MMSは、残された話者が母国語での記録作成やコミュニケーションをサポートすることで、言語を生き続けるために重要な役割を果たすことができます。 1000以上の異なる語彙に適応するために、MMSはアダプターを使用します。アダプターレイヤーは言語間の知識を活用し、モデルが別の言語を解読する際に役立つ役割を果たします。 MMSの微調整 MMSの非監視チェックポイントは、1400以上の言語で300万〜10億のパラメータを持つ、50万時間以上のオーディオで事前学習されました。 事前学習のためのモデルサイズ(300Mおよび1B)の事前学習のみのチェックポイントは、🤗 Hubで見つけることができます:…

ビジョン言語モデルの高速化:Habana Gaudi2上のBridgeTower

Optimum Habana v1.6 on Habana Gaudi2 では、最新のビジョン言語モデルである BridgeTower のファインチューニングにおいて、A100 と比較してほぼ3倍の高速化を実現しています。ハードウェアアクセラレーションによるデータの読み込みと高速な DDP 実装の2つの新機能がパフォーマンス向上に寄与しています。 これらの技術は、データの読み込みに制約がある他のワークロードにも適用できます。これは、さまざまなタイプのビジョンモデルに頻繁に起こるケースです。この投稿では、BridgeTower のファインチューニングを Habana Gaudi2 と Nvidia A100 80GB で比較するために使用したプロセスとベンチマークを紹介します。また、トランスフォーマーベースのモデルでこれらの機能を簡単に活用する方法も示します。 BridgeTower 最近のビジョン言語(VL)モデルは、さまざまなVLタスクで非常に重要であり、優位性を示しています。最も一般的なアプローチは、それぞれのモダリティから表現を抽出するためにユニモーダルエンコーダを利用することです。その後、これらの表現は融合されるか、クロスモーダルエンコーダに供給されます。VL表現学習のパフォーマンス制約と制限を効果的に扱うために、BridgeTower は複数のブリッジ層を導入し、ユニモーダルエンコーダのトップ層とクロスモーダルエンコーダの各層との間に接続を構築します。これにより、クロスモーダルエンコーダ内の異なる意味レベルで視覚とテキストの表現の効果的なボトムアップのクロスモーダルの整合性と融合が可能になります。…

Hugging Faceの推論エンドポイントを使用してLLMをデプロイする

オープンソースのLLMであるFalcon、(オープン-)LLaMA、X-Gen、StarCoder、またはRedPajamaは、ここ数ヶ月で大きく進化し、ChatGPTやGPT4などのクローズドソースのモデルと特定のユースケースで競合することができるようになりました。しかし、これらのモデルを効率的かつ最適化された方法で展開することはまだ課題です。 このブログ投稿では、モデルの展開を容易にするマネージドSaaSソリューションであるHugging Face Inference EndpointsにオープンソースのLLMを展開する方法と、応答のストリーミングとエンドポイントのパフォーマンステストの方法を紹介します。さあ、始めましょう! Falcon 40Bの展開方法 LLMエンドポイントのテスト JavaScriptとPythonでの応答のストリーミング 始める前に、Inference Endpointsについての知識をおさらいしましょう。 Hugging Face Inference Endpointsとは何ですか Hugging Face Inference Endpointsは、本番環境での機械学習モデルの展開を簡単かつ安全な方法で提供します。Inference Endpointsを使用することで、開発者やデータサイエンティストはインフラストラクチャの管理をせずにAIアプリケーションを作成できます。展開プロセスは数回のクリックで簡略化され、オートスケーリングによる大量のリクエストの処理、ゼロスケールへのスケールダウンによるインフラストラクチャのコスト削減、高度なセキュリティの提供などが可能となります。 LLM展開における最も重要な機能のいくつかは以下の通りです: 簡単な展開: インフラストラクチャやMLOpsの管理を必要とせず、本番用のAPIとしてモデルを展開できます。 コスト効率:…

Transformers.jsを使用してMLを搭載したウェブゲームの作成

このブログ記事では、ブラウザ上で完全に動作するリアルタイムのMLパワードWebゲーム「Doodle Dash」を作成した方法を紹介します(Transformers.jsのおかげで)。このチュートリアルの目的は、自分自身でMLパワードのWebゲームを作成するのがどれだけ簡単かを示すことです… ちょうどOpen Source AI Game Jam(2023年7月7日-9日)に間に合います。まだ参加していない場合は、ぜひゲームジャムに参加してください! ビデオ:Doodle Dashデモビデオ クイックリンク デモ:Doodle Dash ソースコード:doodle-dash ゲームジャムに参加:Open Source AI Game Jam 概要 始める前に、作成する内容について話しましょう。このゲームは、GoogleのQuick, Draw!ゲームに触発されており、単語とニューラルネットワークが20秒以内にあなたが描いているものを推測するというものです(6回繰り返し)。実際には、彼らのトレーニングデータを使用して独自のスケッチ検出モデルを訓練します!オープンソースは最高ですよね? 😍 このバージョンでは、1つのプロンプトずつできるだけ多くのアイテムを1分間で描くことができます。モデルが正しいラベルを予測した場合、キャンバスがクリアされ、新しい単語が与えられます。タイマーが切れるまでこれを続けてください!ゲームはブラウザ内でローカルに実行されるため、サーバーの遅延について心配する必要はありません。モデルはあなたが描くと同時にリアルタイムの予測を行うことができます… 🤯…

SQLクエリにおいてGPT-4よりも優れたもの:NSQL(完全なオープンソース)

ChatGPTや他のLLM(Language Model)を使用してSQLクエリを生成しようとしたことがある方は手を挙げてください私は試してみましたし、現在も試しています!しかし、新しいオープンソースのファミリーが登場したことをお伝えできるのがとても嬉しいです...

パンダの力を解放する:.locと.ilocの深いダイブ

PythonのPandasのポテンシャルを引き出しましょうデータの選択における.locと.ilocの詳細を学び、データ分析プロセスを向上させましょう

DeepMindの最新のICLR 2022での研究

スポンサーとしてのイベント支援や定期的なワークショップ主催に加えて、今年は10件の共同研究を含む29件の論文を発表します以下に、私たちの今後の口頭発表、スポットライト発表、ポスター発表の一部をご紹介します

表現力豊かなブール式を使用した説明可能なAI

人工知能(AI)と機械学習の応用の急速な拡大は、ほぼすべての産業や生活の領域に浸透していますしかし、その成長には皮肉な側面もありますAIは意思決定やワークフローを簡素化または加速するために存在しているにもかかわらず、その方法論はしばしば非常に複雑です実際、一部の「ブラックボックス」機械学習アルゴリズムは非常に...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.