Learn more about Search Results こちらの - Page 8

- You may be interested

- Mageを使用してデータパイプラインでの振...

- このOpenAIの研究では、DALL-E 3を紹介し...

- Paellaを紹介します:安定した拡散よりも...

- 「データエンジニア vs データサイエンテ...

- 「AI安全性の議論がシリコンバレーを引き...

- OpenAIを使用してカスタムチャットボット...

- 模倣学習を用いたインタラクティブエージ...

- PageRankによる大規模グラフの分析

- クラウドセキュリティの未来:トレンドと予測

- 「自律AIエージェントを使用してタスクを...

- 「Phindの新しいAIモデルは、コーディング...

- 「V-Net、イメージセグメンテーションにお...

- NVIDIAは、企業向けカスタム生成AIモデル...

- コヒアAIがコヒアのEmbed v3モデルを公開...

- 「InstagramがAIによって生成されたコンテ...

このAIニュースレターは、あなたが必要とするすべてです#61

「最近の数ヶ月間、私たちは大規模な言語モデル(LLM)の進歩と新しい技術の徐々の導入を続けてきましたが、まだGPT-4を直接的に置き換えることを目指した競争は見られていません…」

Google AIのAdaTapeは、Transformerベースのアーキテクチャを持つ新しいAIアプローチです

先週のブログ投稿で、Google Researchは新たなAIアプローチであるAdaTapeを紹介しましたAdaTapeはトランスフォーマベースのアーキテクチャを使用し、適応的な計算を活用しますAdaTapeは適応的な機能を使用して、計算予算を変調できる弾力性のある入力シーケンスを作成します関連する研究論文によると、AdaTapeは適応性を直接注入します...

このAIニュースレターは、あなたが必要とするすべてです#60

今年、AI競争が加速する中で、AIチップのトレーニングと推論能力が重要な資源となっており、過去数週間にわたりいくつかの進展が見られました大手テクノロジー企業と...

PyTorchを使用してx86 CPU上で推論速度を最大9倍高速化する方法

このような深い洞察を含む、さらに週のトップML論文、求人情報、現実世界の経験からのMLのヒント、研究者や開発者からのMLのストーリーを受け取るには、私の...に参加してください

AIを使ってYouTubeショートを作成する

AIツールを使えばYouTube Shortsを作るのが非常に簡単になりましたこの記事では、その方法を紹介します

「3D MRIとCTスキャンに使用するディープラーニングモデルは何ですか?」

このような深い洞察を得るために、週のトップML論文、求人情報、実世界の経験に基づくMLのヒント、研究者や開発者からのMLのストーリーなどを含めて、私の参加してください...

「DPOを使用してLlama 2を微調整する」

はじめに 人間のフィードバックからの強化学習(RLHF)は、GPT-4やクロードなどのLLMの最終トレーニングステップとして採用され、言語モデルの出力が人間の期待に合致するようにするために使われます。しかし、これによってRLの複雑さがNLPにもたらされます。良い報酬関数を構築し、モデルに状態の価値を推定するように訓練し、同時に元のモデルからあまり逸脱せずに意味のあるテキストを生成するように注意する必要があります。このようなプロセスは非常に複雑で、正しく行うのは常に簡単ではありません。 最近の論文「Direct Preference Optimization」(Rafailov、Sharma、Mitchell他)では、既存の方法で使用されるRLベースの目的を、シンプルなバイナリクロスエントロピー損失を直接最適化できる目的に変換することを提案しており、これによりLLMの改善プロセスが大幅に簡素化されます。 このブログ記事では、TRLライブラリで利用可能なDirect Preference Optimization(DPO)メソッドを紹介し、さまざまなスタックエクスチェンジポータルの質問に対するランク付けされた回答を含むスタックエクスチェンジのデータセットで最近のLlama v2 7Bパラメータモデルを微調整する方法を示します。 DPO vs PPO 人間の派生した好みをRLを通じて最適化する従来のモデルでは、補助的な報酬モデルを使用し、興味のあるモデルを微調整して、この報酬をRLの仕組みを利用して最大化するようにします。直感的には、報酬モデルを使用して最適化するモデルにフィードバックを提供し、ハイリワードのサンプルをより頻繁に生成し、ローリワードのサンプルをより少なく生成するようにします。同時に、フリーズされた参照モデルを使用して、生成物があまり逸脱せずに生成の多様性を維持し続けるようにします。これは通常、参照モデルを介した全報酬最大化の目的にKLペナルティを追加することで行われ、モデルが報酬モデルをごまかしたり利用したりすることを防ぐ役割を果たします。 DPOの定式化は、報酬モデリングのステップをバイパスし、報酬関数から最適なRLポリシーへの解析的なマッピングを使用して、言語モデルを好みのデータに最適化します。このマッピングは、与えられた報酬関数が与えられた好みのデータとどれだけ合致するかを直感的に測定します。したがって、DPOはRLHFの損失の最適解から始まり、変数の変換を介して参照モデルに対する損失を導出することで、参照モデルのみに対する損失を得ることができます。 したがって、この直接的な尤度目的は、報酬モデルやポテンシャルに煩雑なRLベースの最適化を必要とせずに最適化することができます。 TRLのトレーニング方法 前述のように、通常、RLHFパイプラインは次の異なるパーツで構成されています: 教師あり微調整(SFT)ステップ データに好みのラベルを付けるプロセス 好みのデータで報酬モデルをトレーニングする そして、RL最適化ステップ TRLライブラリには、これらのパーツのためのヘルパーが付属していますが、DPOトレーニングでは報酬モデリングとRL(ステップ3と4)のタスクは必要ありません。代わりに、TRLのDPOTrainerにステップ2の好みのデータを提供する必要があります。このデータは非常に特定の形式を持ちます。具体的には、次の3つのキーを持つ辞書です: prompt:テキスト生成の際にモデルに与えられるコンテキストプロンプトです…

「音のシンフォニーを解読する:音楽工学のためのオーディオ信号処理」

異なる種類のデータを処理し分析し、実用的な洞察を得る能力は、情報時代で最も重要なスキルの1つですデータは私たちの周りにあります:私たちが読む本から...

「BFS、DFS、ダイクストラ、A*アルゴリズムの普遍的な実装」

「よく知られたアルゴリズムであるBFS、DFS、Dijkstra、A-Starは、本質的には同じアルゴリズムのバリエーションです実際の実装を使ってそれを示します」

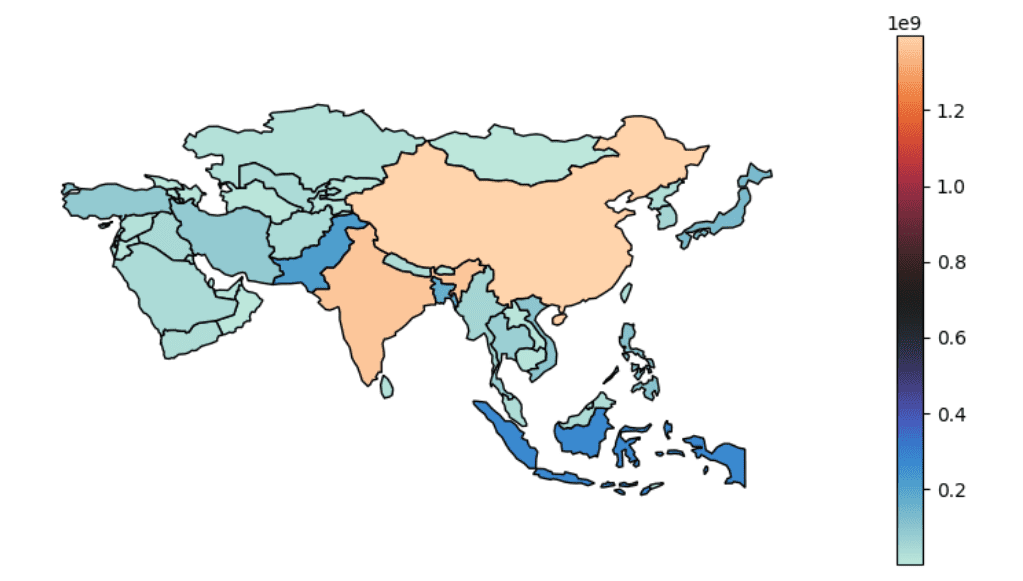

ジオスペーシャルデータ分析のための5つのPythonパッケージ

この記事では、地理空間解析の重要性について説明し、地理空間データから貴重な洞察を効果的に処理し可視化するための5つの必須のPythonパッケージを紹介しています

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.