Learn more about Search Results Transformer - Page 89

- You may be interested

- 「MITの研究者が開発した機械学習技術によ...

- Google MapsのAir Quality APIから大気汚...

- ソニーの研究者がBigVSANを提案:GANベー...

- 「マルチコードダイアグラムの紹介:複雑...

- 「私たちの独占的なDockerチートシートを...

- マイクロソフトが「オルカ2」をリリース:...

- クラウドファーストデータサイエンス:デ...

- 『ODSC Westに参加するトップディープラー...

- 科学者たちは光の量子流体を操作し、次世...

- DevOpsGPTとは、LLMとDevOpsツールを組み...

- VRスーツはあなたがメタバース内で「感じ...

- 「明日のニュースを、今日に!」ニュースG...

- センプレヘルスが専門家加速プログラムを...

- Cox回帰の隠されたダークシークレット:Co...

- 「PythonでCuPyを使ってGPUのパワーを最大...

世界のデータを処理できるアーキテクチャの構築

今日のAIシステムで使用されるほとんどのアーキテクチャは、専門的なものです2Dの残差ネットワークは画像処理には適していますが、自動運転車で使用されるLidar信号やロボット工学で使用されるトルクなどの他の種類のデータには最適な選択肢ではありませんさらに、標準的なアーキテクチャは通常、1つのタスクのみを考慮して設計されており、エンジニアはしばしば入出力を再構築、歪曲、または他の方法で変更する必要がありますこれによって標準的なアーキテクチャが問題を正しく処理できるように期待します音声や画像など、複数の種類のデータを扱う場合はさらに複雑であり、単純なタスクでも多くの異なる部品から構成される複雑で手動チューニングされたシステムが必要になることが通常ですDeepMindの使命である科学と人類の進歩のために知能を解決するために、私たちは多くの種類の入力と出力を使用する問題を解決できるシステムを構築したいと考え、あらゆる種類のデータを処理できるより一般的かつ柔軟なアーキテクチャを探求し始めました

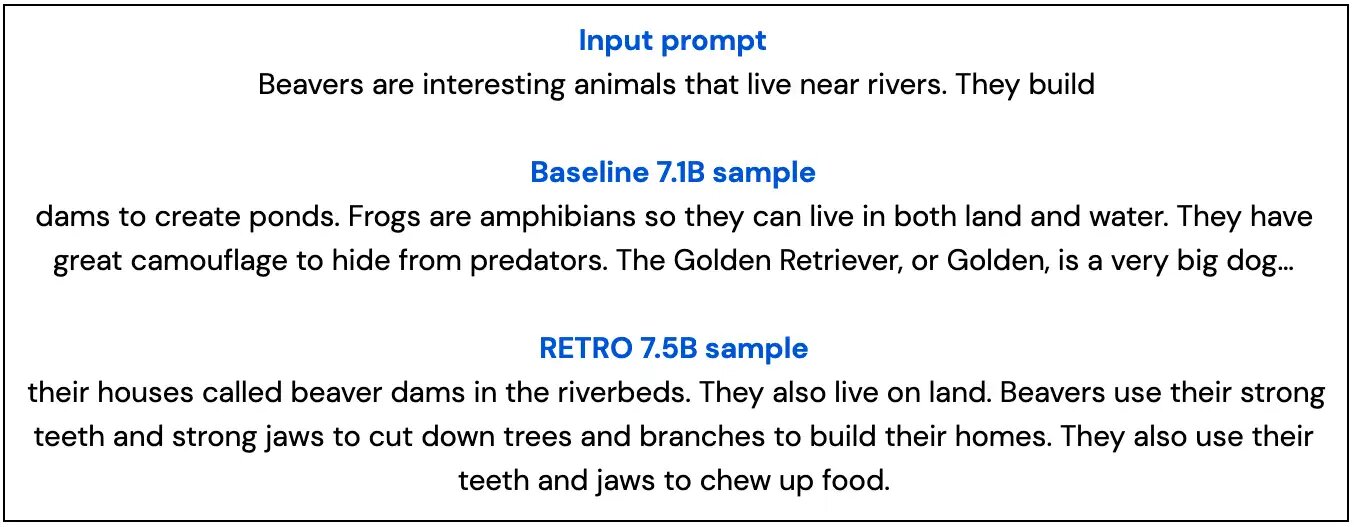

兆のトークンからリトリーブして言語モデルを向上させる

言語モデルの改善のための代替手段を探求しますウェブページ、書籍、ニュース、コードなどのテキストパッセージのデータベースに対して、トランスフォーマを補完するためのリトリーバルを行いますこの手法を「RETRO」と呼んでいます「Retrieval Enhanced TRansfOrmers」の頭文字です

スケールにおける言語モデリング:Gopher、倫理的考慮事項、および情報の検索

言語とその役割は、人間であることの基本的な要素であり、理解や知性を示すことと促進することにおいて重要ですそれは人々に思考や概念を伝え、アイデアを表現し、記憶を創り、相互理解を築く能力を与えますこれらは社会的知性の基盤的な要素ですDeepMindのチームは、言語処理とコミュニケーションの側面を人工エージェントと人間の両方で研究しているのはそのためです

Perceiver AR(パーシーバーAR):汎用、長文脈の自己回帰生成

私たちはPerceiver ARを開発していますこれは自己回帰型であり、モダリティを問わないアーキテクチャで、クロスアテンションを使用して長距離の入力を少数の潜在変数にマッピングすると同時に、エンドツーエンドの因果的マスキングを維持しますPerceiver ARは、手作りの疎なパターンやメモリメカニズムの必要なしに、10万以上のトークンに直接アテンションを注ぐことができ、実用的な長文脈の密度推定を可能にします

トランスフォーマーエンコーダー | 自然言語処理の核心の問題

イントロダクション 非常に簡単な方法でトランスフォーマーエンコーダーを説明します。トランスフォーマーの学習に苦労している人は、このブログ投稿を最後まで読んでください。自然言語処理(NLP)の分野で働く興味がある方は、トランスフォーマーについて少なくとも基本的な知識を持っておくべきです。ほとんどの産業はこの最新のモデルをさまざまな仕事に使用しています。トランスフォーマーは、「Attention Is All You Need」という論文で紹介された最新のNLPモデルであり、従来のRNNやLSTMを上回っています。トランスフォーマーは再帰ではなくセルフアテンションに頼ることで、長期的な依存関係の捉える課題を克服しています。トランスフォーマーはNLPを革新し、BERT、GPT-3、T5などのアーキテクチャの道を開いています。 学習目標 この記事では、以下を学びます: トランスフォーマーがなぜ人気になったのか? NLPの分野でのセルフアテンションメカニズムの役割。 自分自身の入力データからキー、クエリ、バリューの行列を作成する方法。 キー、クエリ、バリューの行列を使用してアテンション行列を計算する方法。 メカニズムにおけるソフトマックス関数の適用の重要性。 この記事は、データサイエンスブログマラソンの一部として公開されました。 トランスフォーマーがRNNやLSTMモデルを上回る要因は何か? RNNやLSTMでは、長期的な依存関係を理解することができず、複雑なデータを扱う際に計算量が増えるという問題に直面しました。「Attention Is All You Need」という論文では、トランスフォーマーという新しいデザインが従来の順次ネットワークの制約を克服するために開発され、NLPアプリケーションの最先端モデルとなりました。 RNNやLSTMでは、入力とトークンは一度に1つずつ与えられ、トランスフォーマーではデータを並列に処理します。 トランスフォーマーモデルは再帰プロセスを完全に排除し、アテンションメカニズムに完全に依存しています。セルフアテンションという独特のアテンションメカニズムを使用します。 トランスフォーマーの構成と動作 多くのNLPタスクでは、トランスフォーマーモデルが現在の最先端モデルです。トランスフォーマーの導入により、NLPの分野での大きな進歩があり、BERT、GPT-3、T5などの先端システムの道を開きました。…

学習トランスフォーマーコード入門:パート1 – セットアップ

あなたについてはわかりませんが、コードを見ることの方が論文を読むよりも簡単なことがありますAdventureGPTに取り組んでいた時、まずはReActの実装であるBabyAGIのソースコードを読むことから始めました

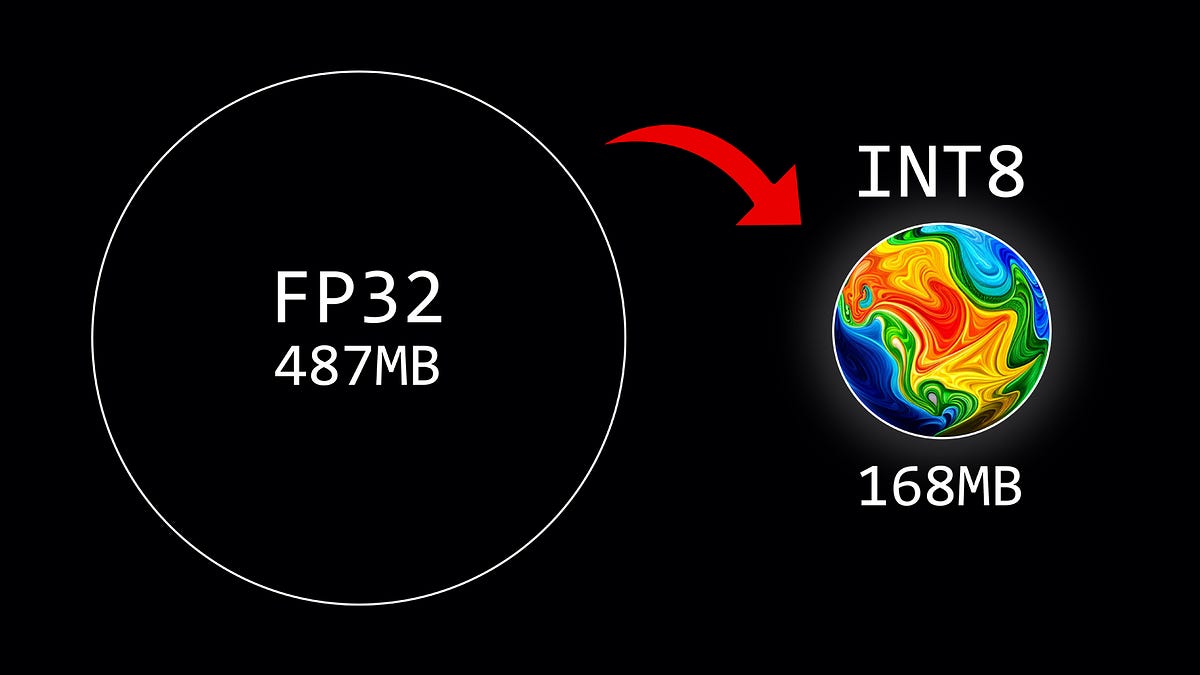

重み量子化の概要

この記事では、8ビットの量子化方式を使用して、大規模言語モデルのパラメータを量子化する方法について説明しています

Falcon-7Bの本番環境への展開

これまでに、ChatGPTの能力と提供するものを見てきましたしかし、企業利用においては、ChatGPTのようなクローズドソースモデルは、企業がデータを制御できないというリスクがあるかもしれません...

Mageを使用してデータパイプラインでの振る舞い駆動開発を実装してください

以前の記事で、データパイプラインにおけるテストの重要性と、データテストとユニットテストの作成方法について多くの話をしましたテストは重要な役割を果たしますが、必ずしも...

LLMを活用したアプリケーションの設計と構築

この研究論文では、LLM(Language Model-based Learning)を用いたアプリケーションの設計と構築のプロセスについて探求しています

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.