Learn more about Search Results A - Page 832

- You may be interested

- エンジニアリングリーダーは何を気にして...

- メトリックは欺くことができますが、目は...

- 「リトリーバル増強生成によるジェネラテ...

- なぜ私たちはHugging Face Inference Endp...

- MLOpsとは何ですか

- 『ジュリエット・パウエル&アート・ク...

- プロンプトエンジニアリングを改善するた...

- AIの聴覚スキルを革命化する:清華大学と...

- スタートアップに参加する前に、データエ...

- 言語の壁を打破:多言語オーディオの文字...

- 「Googleのおかげで、ロボットにとっての...

- 「エンドツーエンドの推薦システムの構築」

- 通貨為替レートの予測のためのSARIMAモデル

- 「Ken Jeeと一緒にAIの探究」

- 「Google Bardの拡張機能を無料で使用する...

評価から啓示へ:クロスバリデーションにおける外部サンプル予測の探求

クロスバリデーションの理解と実践における適用は、すべてのデータサイエンティストにとって必須のスキルですクロスバリデーションの主な目的はモデルの性能を評価することであり、...

あなたが作るものはあなたそのものです:コードをより人間的にする方法

GitHubのクリスティーナ・エンチェヴタさんが、AIアプリケーションが私たちの価値観を反映していることや、建設的なフィードバックの提供方法などについて話します

ロッテン・トマト映画評価予測のデータサイエンスプロジェクト:最初のアプローチ

数値およびカテゴリカルな特徴に基づく映画の状態予測

Googleはチャットボットの使用について従業員に警告、ここにその理由があります

Googleの親会社であるAlphabet Inc.は、ChatGPTや自社製品であるBardを含むチャットボットの使用について従業員に注意を促しています。この警告は、同社がチャットボットプログラムの範囲をグローバルに拡大するにつれて行われました。この開発の詳細について探求し、懸念事項を理解してみましょう。 また読む:セキュリティ上の懸念から、Samsungが従業員にジェネレーティブAIの使用を禁止 機密情報の保護 問題に詳しい情報源によると、Alphabetは従業員に対して、Bardを含むAIチャットボットに機密資料を入力しないよう指示しています。この指示は、同社の情報保護ポリシーと一致しています。BardやChatGPTなどのチャットボットは、ユーザーとの会話を行い、応答を提供するために設計されていますが、AIモデルは吸収したトレーニングデータを再現する可能性があるため、データ漏洩の潜在的なリスクがあります。 また読む:専門家によると、AIがあなたのデータを盗んでいる エンジニアとプログラマの注意事項 機密情報の入力を避けることに加えて、Alphabetはエンジニアに対して、チャットボットのコンピュータコードを直接使用しないよう警告しています。Bardは提案を行うかもしれませんが、プログラマは注意を払うことが重要です。Googleは、自社の技術の制約を認識し、意図しない結果を引き起こさないようにするために、透明性を維持することを目指しています。 また読む:ライバルのSamsungに続いて、Appleがプライバシーの懸念からChatGPTを禁止 競争の激しい環境とビジネスへの影響 Googleのチャットボットの使用に対する警戒感は、OpenAIとMicrosoft Corp.がバックアップしているChatGPTとの競争に起因しています。これらのAIプログラムの成功には、数十億ドルの投資、潜在的な広告収益、クラウド収益がかかっています。Googleの予防措置は業界全体のトレンドであり、Samsung、Amazon.com、Deutsche Bankなどの他の企業もAIチャットボットのガードレールを導入しています。 また読む:MicrosoftとOpenAIがAI統合で対立 従業員のAIツールとセキュリティ基準の使用 米国のトップ企業の専門家を対象とした調査によると、回答者の約43%がChatGPTなどのAIツールを使用しており、上司に通知せずに使用していることが明らかになりました。潜在的なリスクを軽減するため、Apple(未確認)を含む世界の企業は、公開されているチャットプログラムの使用について従業員に警告するためにセキュリティ基準を採用しています。 プライバシーの懸念と規制に関する対話 Googleはアイルランドのデータ保護委員会と詳細な協議を行い、プライバシーに関連する懸念を解消し、規制要件に準拠するための対策を講じています。Politicoの最新の報告書によれば、Bardの欧州連合での導入は、プライバシーの影響に関する追加情報が得られるまで延期されました。Googleの更新されたプライバシー通知では、ユーザーに対して、Bardの会話に機密情報や個人情報を含めないようにアドバイスしています。 また読む:欧州データ保護委員会がChatGPTプライバシータスクフォースを設立 革新的なソリューションによるリスクの軽減 企業は、これらの懸念に対処するためのソフトウェアソリューションの開発に積極的に取り組んでいます。たとえば、サイバーセキュリティおよびクラウドサービスの主要なプロバイダであるCloudflareは、特定のデータを外部への送信からタグ付けおよび制限することができます。GoogleやMicrosoftもビジネス向けの対話ツールを提供し、公開されているAIモデルに組み込まないことでデータのプライバシーを確保しています。ただし、BardとChatGPTのデフォルト設定では、ユーザーの会話履歴が保存されますが、ユーザーは削除することができます。 私たちの意見 GoogleがBardを含むチャットボットの使用に関して従業員に警告することは、同社がデータのプライバシーとセキュリティに対する取り組みを反映しています。AI技術が進化し続ける中、組織がセーフガードを実施し、責任ある使用を促進することが重要です。AIチャットボットのダイナミックな環境では、イノベーションとリスク軽減の繊細なバランスが求められます。Googleなどの企業がこれらの懸念に取り組むことで、AI技術が安全かつ倫理的に活用される未来に向けて取り組んでいます。

プロンプトエンジニアリングへの紹介

イントロダクション 自然言語処理は、基盤となる技術や手法を使用した実装の豊かな領域であります。近年、特に2022年の始まり以来、自然言語処理(NLP)と生成型AIは進化を遂げています。これにより、プロンプトエンジニアリングは、言語モデル(LM)をマスターするために理解する必要のある特別なスキルとなりました。 学習目標 プロンプト、プロンプトエンジニアリング、および例の理解 プロンプトを洗練させるためのヒント プロンプトとプロンプトのパターンの要素 プロンプトの技法 プロンプトエンジニアリングの知識は、大規模な言語モデル(LLM)を基本的に使用する際の能力と制限をより良く理解するのに役立ちます。 この記事は、データサイエンスブログマラソンの一部として公開されました。 プロンプトエンジニアリングとは何ですか? プロンプトエンジニアリングは、人工知能の自然言語処理の分野で、AIが行うべきことをテキストで説明する実践です。この入力によってガイドされ、AIは出力を生成します。これは、人間が理解できるテキストを対話的にモデルとコミュニケーションするためのもので、タスクの説明が入力に埋め込まれているため、モデルは柔軟に動作し、可能性が広がります。 詳細はこちらをご覧ください:プロンプトエンジニアリング:パワフルなプロンプトの作成のアート プロンプトとは何ですか? プロンプトは、モデルから期待される出力の詳細な説明です。これはユーザーとAIモデルの間の対話です。これにより、エンジニアリングについてより理解が深まります。 プロンプトの例 ChatGPTやGPT-3などの大規模な言語モデルで使用されるプロンプトは、単純なテキストクエリの場合もあります。これらは提供できる詳細の量によって品質が測定されます。これらは、テキスト要約、質問と回答、コード生成、情報抽出などに使用されます。 多くの指示が含まれる複雑な問題を解決するためにLLMが使用されるため、詳細であることが重要です。基本的なプロンプトのいくつかの例を見てみましょう: プロンプト 抗生物質は、細菌感染症を治療するために使用される薬の一種です。それらは細菌を殺したり、増殖を防いだりすることで、体の免疫系が感染症と戦えるようにします。抗生物質は通常、錠剤、カプセル、液体溶液の形で経口的に摂取され、時には静脈内投与されます。抗生物質はウイルス感染症には効果がなく、不適切に使用すると抗生物質耐性が生じることがあります。 上記を2文に要約してください: この出力はQ&Aの形式で要約を表示します。 抗生物質は、細菌感染症を殺菌または増殖を防ぎ、免疫系が感染症と戦えるようにします。経口または静脈内投与され、ウイルス感染症には効果がなく、抗生物質耐性を引き起こす可能性があります。 LLMの使用例を見ました。可能性は無限です。 プロンプトを洗練させるためのヒント…

キャッシュの遷移に対する自動フィードバックによる優先学習

Googleのソフトウェアエンジニア、Ramki GummadiとYouTubeのソフトウェアエンジニア、Kevin Chenによって投稿されました。 キャッシュは、リクエストパターンに基づいてクライアントに近い場所に人気のあるアイテムの一部を保存することで、ストレージおよび検索システムのパフォーマンスを大幅に向上させる、コンピュータサイエンスにおける普遍的なアイデアです。キャッシュの管理における重要なアルゴリズムの一部は、格納されるアイテムのセットを動的に更新するために使用される決定ポリシーであり、数十年にわたって広範に最適化されてきました。これにより、いくつかの効率的で堅牢なヒューリスティクスが生まれました。機械学習をキャッシュポリシーに適用することは、最近の研究で有望な結果を示していますが(例:LRB、LHD、ストレージアプリケーションなど)、競争力のある計算およびメモリの負荷を維持しながら、信頼性のあるヒューリスティクスをベンチマークを超えて信頼性のある汎用的な設定に対して上回ることはまだ課題です。 NSDI 2023で発表された「YouTubeコンテンツデリバリーネットワークのためのヒューリスティック支援学習優先エヴィクションポリシー(HALP)」では、学習された報酬を基にしたスケーラブルな最先端のキャッシュエヴィクションフレームワークを紹介しています。HALPフレームワークは、軽量なヒューリスティックベースラインエヴィクションルールと学習された報酬モデルを組み合わせるメタアルゴリズムです。報酬モデルは、オフラインのオラクルを模倣するために設計された選好比較に基づく継続的な自動フィードバックでトレーニングされる軽量なニューラルネットワークです。HALPがYouTubeのコンテンツデリバリーネットワークのインフラストラクチャの効率性とユーザーのビデオ再生遅延を改善した方法について説明します。 キャッシュエヴィクションの決定のための学習済みの選好 HALPフレームワークは、2つのコンポーネントに基づいてキャッシュエヴィクションの決定を行います:(1)自動フィードバックを介した選好学習によってトレーニングされたニューラル報酬モデル、および(2)学習された報酬モデルと高速ヒューリスティックを組み合わせるメタアルゴリズム。キャッシュが入力リクエストを観察すると、HALPはペアワイズの選好フィードバックを介した選好学習法として、各アイテムに対してスカラー報酬を予測する小規模なニューラルネットワークを継続的にトレーニングします。HALPのこの側面は、人間のフィードバックからの強化学習(RLHF)システムに似ていますが、2つの重要な違いがあります: フィードバックは自動化されており、オフラインの最適キャッシュエヴィクションポリシーの構造に関するよく知られた結果を活用しています。 モデルは、自動フィードバックプロセスから構築されたトレーニングの例の一時バッファを使用して継続的に学習されます。 エヴィクションの決定は、2つのステップを持つフィルタリングメカニズムに依存しています。まず、パフォーマンスの観点ではサブオプティマルですが、効率的なヒューリスティックを使用して、小さな候補のサブセットが選択されます。次に、再ランキングステップによって、ベースラインの候補から内部の最終的な決定の品質を「ブーストする」ために、ニューラルネットワークのスコアリング関数が使用されます。 HALPは、エヴィクションの決定だけでなく、効率的なフィードバックの構築とモデルの更新に使用されるペアワイズの選好クエリのサンプリングのエンドツーエンドのプロセスを包括しています。 ニューラル報酬モデル HALPは、キャッシュ内の個々のアイテムを選択的にスコアリングするために、軽量な2層のマルチレイヤーパーセプトロン(MLP)を報酬モデルとして使用します。特徴は、メタデータのみの「ゴーストキャッシュ」として構築および管理されます(ARCなどの古典的なポリシーと同様)。任意のルックアップリクエストの後、通常のキャッシュ操作に加えて、HALPはダイナミックな内部表現を更新するために必要なブックキーピング(例:キャッシュルックアップリクエストと共にユーザーから提供される外部のタグ付き特徴、および各アイテムで観測されたルックアップ時間から構築された内部的な動的特徴など)を実行します。 HALPは、ランダムな重み初期化から完全にオンラインで報酬モデルを学習します。これは、報酬モデルを最適化するためにのみ決定が行われる場合、悪いアイデアのように思えるかもしれません。ただし、エヴィクションの決定は、学習された報酬モデルとLRUなどのサブオプティマルでシンプルかつ堅牢なヒューリスティックの両方に依存しています。これにより、報酬モデルが完全に一般化された場合に最適なパフォーマンスが得られる一方で、一時的に一般化されていないまたは変化する環境に追いつく途中の情報の少ない報酬モデルにも堅牢性があります。 オンライントレーニングのもう一つの利点は、専門化です。キャッシュサーバーはそれぞれ異なる環境(地理的位置など)で実行されるため、ローカルのネットワーク状況やローカルで人気のあるコンテンツなどに影響を受けます。オンライントレーニングは、この情報を自動的にキャプチャする一方で、単一のオフライントレーニングソリューションとは異なり、一般化の負担を軽減します。 ランダム化された優先度キューからのスコアリングサンプル エヴィクションの決定の品質を排他的に学習された目的に最適化することは、2つの理由で実用的ではありません。 計算効率の制約: 学習されたネットワークによる推論は、実際のキャッシュポリシーの計算に比べてかなり高コストになることがあります。これはネットワークと特徴の表現力だけでなく、各エビクションの決定時にこれらがどれくらい頻繁に呼び出されるかも制約します。 分布外の汎化のための堅牢性: HALPは、継続的な学習を伴うセットアップで展開されており、急速に変化するワークロードによって、以前に見たデータに関して一時的に分布外になるリクエストパターンが生成される可能性があります。 これらの問題に対処するために、HALPはまず、エビクションの優先順位に対応する安価なヒューリスティックスコアリングルールを適用し、小さな候補サンプルを特定します。このプロセスは、正確な優先順位キューを近似する効率的なランダムサンプリングに基づいています。候補サンプルを生成するための優先関数は、既存の手動調整アルゴリズム(例:LRU)を使用して素早く計算することを意図しています。ただし、これは簡単なコスト関数を編集することによって他のキャッシュ置換ヒューリスティックを近似するように構成できます。以前の研究とは異なり、ランダム化は近似と効率のトレードオフに使用されるものでしたが、HALPでは、トレーニングと推論の両方でサンプルされた候補の時間ステップごとの固有のランダム化にも依存しています。 最終的なエビクトされるアイテムは、提供された候補から選ばれ、ニューラル報酬モデルに従って予測された優先スコアを最大化するために再ランクされたサンプルに相当します。エビクションの決定に使用される候補のプールは、サンプル間のトレーニングと推論のズレを最小限に抑えるために、ペアワイズの優先クエリの構築にも使用されます。…

ニューラルネットワークにおける活性化関数の種類

ニューラルネットワークの活性化関数は、ディープラーニングの重要な部分であり、トレーニングモデルの精度と効率を決定します。大規模なニューラルネットワークの作成や分割に使用されるモデルとディープラーニングモデルの出力を決定します。活性化関数は、関連するデータに焦点を当てながら、他のデータを破棄するため、ニューラルネットワークにとって貴重なツールです。他の関数と同様に、活性化関数(転送関数)は入力を受け取り、その入力に比例する出力を返します。ニューラルネットワークのノードの活性化関数は、特定の入力または入力グループに対するノードの出力を指定します。 意図した結果を達成するために、どのニューロンを活性化または非活性化するか効果的に選択します。入力も非線形に変換され、高度なニューラルネットワークでのパフォーマンスが向上します。1から-1までの情報は、活性化関数で出力を正規化することができます。ニューラルネットワークは通常、何百万ものデータポイントでトレーニングされるため、活性化関数が高速であり、結果を計算するために必要な時間を最小限に抑えることが重要です。 さて、ニューラルネットワークの構造を確認し、ニューラルネットワークアーキテクチャがどのように組み立てられ、ニューラルネットワークにどの要素が存在するかを見てみましょう。 人工ニューラルネットワークは、多くのリンクされた個々のニューロンを含んでいます。各ニューロンの活性化関数、バイアス、および重みが指定されます。 入力層 – ドメインの生データが入力層に送られます。この層は計算が行われる最も低いレベルです。これらのノードが行う唯一のことは、データを次の隠れ層に中継することです。 隠れ層 – 入力層から特徴を受け取った後、隠れ層はさまざまな計算を行い、結果を出力層に渡します。レイヤー2のノードは表示されず、基礎となるニューラルネットワークの抽象化レイヤーを提供します。 出力層 – ネットワークの隠れ層の出力がこの層でまとめられ、ネットワークの最終的な値が提供されます。 活性化関数の重要性 線形方程式は1次の多項式であるため、活性化関数を持たないニューラルネットワークは単なる線形回帰モデルです。解くのは簡単ですが、複雑な問題や高次の多項式に対処する能力は制限されています。 活性化関数は、ニューラルネットワークに非線形性を提供するために使用されます。活性化関数の計算は、順伝播の各層で追加のステップを行いますが、その手間は十分に報われます。 活性化関数がない場合、各ニューロンは重みとバイアスを使用して入力に対する線形変換を行います。2つの線形関数の合成は、それ自体が線形関数です。したがって、ニューラルネットワークの隠れ層の総数はその動作に影響を与えません。 活性化関数の種類 ニューラルネットワークは、異なる活性化関数が使用される3つの主要な部分に分類されます。 バイナリステップ関数 線形関数 非線形活性化関数 バイナリステップニューラルネットワークの活性化関数 バイナリステップ関数…

何が合成データとは?その種類、機械学習とプライバシーにおける利用例及び応用について

データサイエンスと機械学習の分野は、毎日成長しています。新しいモデルやアルゴリズムが提案されるにつれて、これらの新しいアルゴリズムとモデルには、トレーニングやテストに膨大なデータが必要となります。ディープラーニングモデルは今日では非常に人気があり、これらのモデルもデータを大量に必要とします。異なる問題文脈の大量のデータを取得することは、非常に面倒で時間がかかり、コストがかかります。データは現実のシナリオから収集されるため、セキュリティの責任とプライバシーの懸念が高まります。データの大部分はプライバシー法や規制によって保護されており、組織間や場合によっては同一組織の異なる部門間でのデータ共有や移動を妨げ、実験や製品のテストを遅らせる原因となります。それでは、この問題をどのように解決できるでしょうか?どのようにして、誰かのプライバシーに関する懸念を引き起こすことなく、データをよりアクセスしやすくオープンにすることができるのでしょうか? この問題の解決策は、合成データ (Synthetic data)と呼ばれるものです。 では、合成データとは何でしょうか? 合成データとは、人工的またはアルゴリズム的に生成され、実際のデータの基本的な構造と特性に近いものです。合成データが良ければ、実際のデータと区別がつかないほどです。 合成データの種類は何種類あるのでしょうか? この質問の答えは非常にオープンエンドで、データは多様な形をとることができますが、主に以下のようなものがあります。 テキストデータ 音声またはビジュアルデータ (たとえば画像、動画、音声) 表形式のデータ 機械学習における合成データの利用例 ここでは、上記の3つのタイプの合成データの利用例について説明します。 NLPモデルのトレーニングに合成テキストデータを使用する 合成データは、自然言語処理の分野で応用されています。たとえば、AmazonのAlexa AIチームは、既存の顧客インタラクションデータが存在しない場合や十分でない場合に、NLUシステム (自然言語理解) のトレーニングセットを完成させるために合成データを使用しています。 ビジョンアルゴリズムのトレーニングに合成データを使用する ここでは、広く使用されているユースケースについて説明します。たとえば、画像内の顔の数を検出または数えるアルゴリズムを開発したい場合を考えてみましょう。ジェネレーティブネットワーク (GAN) またはその他の生成ネットワークを使用して、実際には存在しない現実的な人間の顔、つまり顔を生成してモデルをトレーニングすることができます。また、誰かのプライバシーを侵害することなく、これらのアルゴリズムから必要なだけデータを生成することができます。しかし、実際のデータには個人の顔が含まれているため、プライバシーポリシーによってそのデータを使用することが制限されています。 別のユースケースとして、シミュレートされた環境で強化学習を行うことが考えられます。たとえば、オブジェクトをつかんで箱に入れるために設計されたロボットアームをテストしたい場合、この目的のために強化学習アルゴリズムが設計されます。強化学習アルゴリズムが学習する方法は、実験を行うことです。実際のシナリオで実験を行うことは非常にコストがかかり、時間がかかり、異なる実験を行うことが制限されます。しかし、シミュレートされた環境で実験を行う場合、実験を設定するのは比較的安価で、ロボットアームのプロトタイプが必要なくなります。…

ヒッティングタイム予測:時系列確率予測の別の方法

正確な予測をする能力は、すべての時系列予測アプリケーションにとって基本的なものですこの目的に従って、データサイエンティストたちは、最小化する最適なモデルを選択することに慣れています...

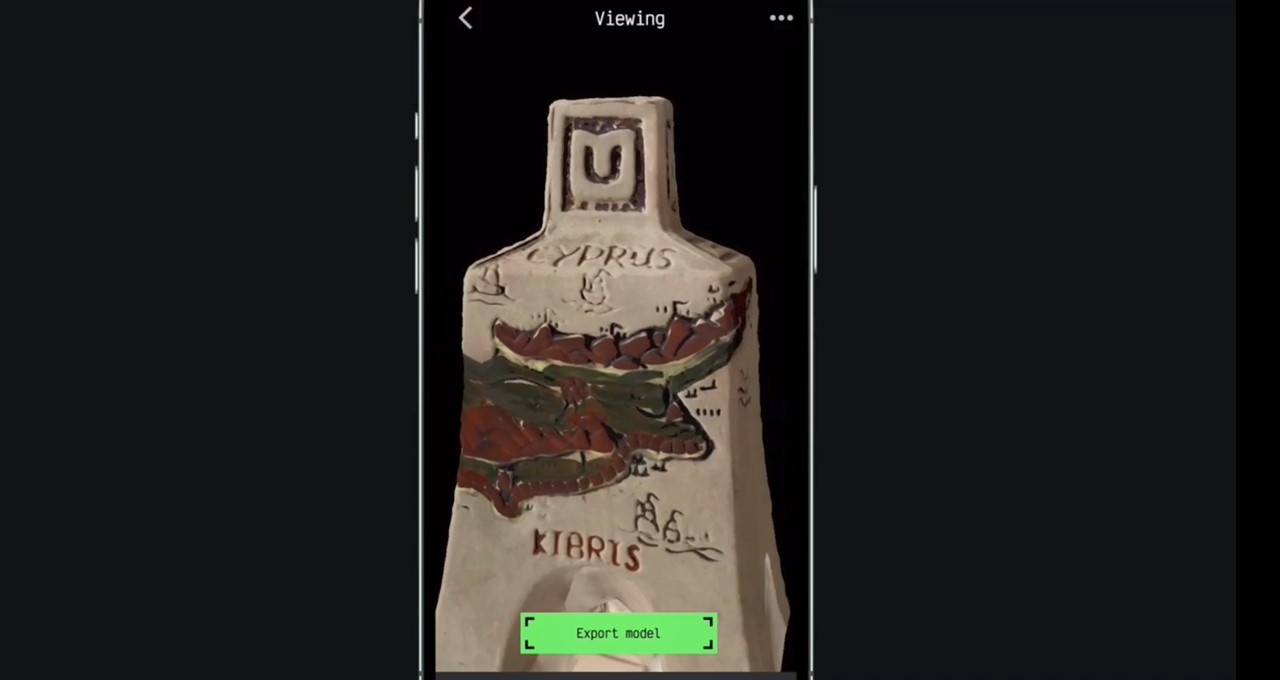

オムニヴォアに出会おう:スタートアップが開発したアプリは、スマートフォンだけでオブジェクトを3Dモデルに変換することができます

編集者注:この投稿は、NVIDIA Omniverse(Universal Scene Description、OpenUSDとも呼ばれる)上に構築された開発プラットフォームを使用して、3Dワークフローを加速し、仮想世界を作成する個々のクリエイターや開発者を紹介するMeet the Omnivoreシリーズの一部です。 拡張現実(AR)がグローバルにより普及し、アクセスしやすくなるにつれ、Kiryl Sidarchuk氏は現実世界と仮想世界の境界を消すのを手伝っています。 Kiryl Sidarchuk NVIDIA Inceptionプログラムの先進的なスタートアップのメンバーであるAR-Generationの共同創業者兼CEOであるSidarchuk氏は、自社が開発したAIベースの3DスキャナーアプリMagiScanを開発しました。 ユーザーはスマートフォンのカメラで任意のオブジェクトをキャプチャし、すばやく高品質かつ詳細な3Dモデルを作成し、ARまたはメタバースアプリケーションで使用できます。 AR-Generationは現在、MagiScanからNVIDIA Omniverseに直接3Dモデルをエクスポートする拡張機能を提供しています。これにより、デジタルコンテンツ作成ツール間で共通の言語である拡張可能なフレームワークであるUniversal Scene Description、OpenUSDにより、スピードと容易さが実現されます。 「拡張現実は日常生活の重要な一部になります」と、シドアルチュク氏は言います。 「当社のアプリをカスタマイズして、実世界のオブジェクトに基づく3Dモデルを直接Omniverseにエクスポートできるようにしました。これにより、ユーザーはARでモデルを展示し、メタバースまたはゲームに統合できます。 Omniverseの拡張機能は、人気のあるPythonまたはC++プログラミング言語を使用して、誰でもOmniverseアプリの機能を作成および拡張できるコアの構築ブロックです。 シドアルチュク氏によると、NVIDIA Inceptionのメンバーであることの利点として、簡単にアクセスできるドキュメント、NVIDIAチームからの技術的な支援、無料のAWSクレジット、AI駆動の他の企業とのネットワーキングの機会が挙げられます。AR-Generationにとって、拡張機能を構築することは簡単で便利だったとシドアルチュク氏は語りました。 リアルワールドオブジェクトからの3Dモデルのキャプチャ、クリック、および作成 シドアルチュク氏によると、MagiScanは、デザイナーが手動で行うよりも10倍速く、最大100倍のコストでオブジェクトから3Dモデルを作成できます。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.