Learn more about Search Results OPT - Page 77

- You may be interested

- 初めての機械学習モデルを展開する

- 意思決定木の結果をより良くするための一...

- 埋め込みの類似検索:データ分析の画期的...

- AdaTape 適応計算とダイナミックな読み書...

- 予測保守を理解する-データの取得と信号の...

- 「自動運転車の安全性について、ブリティ...

- 「PyTorchでのSoft Nearest Neighbor Loss...

- 「高度なデータサイエンス技術を用いたEコ...

- NVIDIAがFlexiCubesを導入:フォトグラメ...

- 「CMUの研究者たちがRoboToolを公開:自然...

- 「MatFormerをご紹介します:プラットフォ...

- EUはAIの新しいルールを進めます

- データサイエンスのキャリアをワンランク...

- Webスケールトレーニング解放:DeepMindが...

- 「生成AIの布地を調整する:FABRICは反復...

「エンティティ解決とグラフニューラルネットワークを用いた詐欺検知」

オンライン詐欺は、金融、電子商取引、およびその他の関連産業にとってますます深刻な問題ですこの脅威に対応するため、組織は機械学習と…に基づく詐欺検知メカニズムを使用します

RGBビデオから3Dビデオを作成する

「私は常に、私たちがデジタルな思い出を2Dの形式でアーカイブしていることに不満を感じてきました写真やビデオは鮮明さに欠けることはないものの、体験の深さや没入感が欠けているのです…」

「LoRAとQLoRAを用いた大規模言語モデルのパラメータ効率的なファインチューニング」

概要 パラメータ効率の高いファインチューニング(PEFT)の世界に深く没入するにつれて、この革新的な手法の背後にある駆動要因と方法論を理解することが不可欠となってきます。この記事では、PEFT手法が大規模言語モデル(LLM)を特定のタスクに最適化する方法について探求します。PEFTの利点と欠点を解明し、PEFT技術の複雑なカテゴリについて掘り下げ、2つの注目すべき技術であるLow-Rank Adaptation(LoRA)とQuantized Low-Rank Adaptation(QLoRA)の内部動作を解読します。この旅は、これらの技術の包括的な理解を身につけることで、言語処理の取り組みにおいてその力を活用できるようにすることを目指しています。 学習目標: 事前学習済み言語モデルとNLPにおけるファインチューニングの概念を理解する。 ファインチューニング大規模モデルにおける計算およびメモリ要件がもたらす課題について探求する。 Low-Rank Adaptation(LoRA)やQuantized Low-Rank Adaptation(QLoRA)などのPEFT技術について学ぶ。 PEFT手法の利点と欠点を見つける。 T-Few、AdaMix、MEFTなどのさまざまなPEFT手法を探求する。 LoRAとQLoRAの動作原理を理解する。 QLoRAがパラメータ効率を高めるためにどのように量子化を導入するかを学ぶ。 LoRAとQLoRAを使用したファインチューニングの実際の例を探索する。 PEFT技術の適用性と利点を理解する。 NLPにおけるパラメータ効率の高いファインチューニングの将来の展望を理解する。 はじめに 自然言語処理の刺激的な世界では、大規模な事前学習済み言語モデル(LLM)がこの分野を革新しました。ただし、特定のタスクにこれらの巨大なモデルをファインチューニングすることは、高い計算コストとストレージ要件のために困難を伴います。研究者はパラメータ効率の高いファインチューニング(PEFT)技術に取り組み、より少ない訓練可能なパラメータで高いタスクパフォーマンスを達成することを目指しています。 事前学習済みLLMとファインチューニング 事前学習済みLLMは、一般的なドメインの大量のデータでトレーニングされた言語モデルであり、豊富な言語パターンと知識を捉えることに優れています。ファインチューニングは、これらの事前学習済みモデルを特定の下流タスクに適応させることで、専門的なタスクで優れたパフォーマンスを発揮するためにその知識を活用します。ファインチューニングでは、事前学習済みモデルをタスク固有のデータセットで訓練し、元のトレーニングデータよりも一般的で集中したものにします。ファインチューニング中、モデルのパラメータはターゲットタスクのパフォーマンスを最適化するために調整されます。 パラメータ効率の高いファインチューニング(PEFT)…

AutoGPTQをご紹介します:GPTQアルゴリズムに基づく使いやすいLLMs量子化パッケージで、ユーザーフレンドリーなAPIを提供します

Hugging Faceの研究者たちは、大規模な言語モデル(LLM)の訓練と展開における資源集約型の要求に対処するための革新的な解決策を紹介しました。彼らの新しく統合されたAutoGPTQライブラリは、Transformersエコシステム内でLLMをGPTQアルゴリズムを使用して量子化し、実行することをユーザーに可能にします。 自然言語処理では、LLMは人間のようなテキストの理解と生成能力によって様々な領域を変革してきました。しかし、これらのモデルの訓練と展開には、計算上の要件が重要な障害となっています。そこで、研究者たちはAutoGPTQライブラリにGPTQアルゴリズムを統合しました。この進歩により、ユーザーはモデルを8ビット、4ビット、3ビット、または2ビットにまで減量化して実行できるようになります。特に小規模なバッチサイズに対しては、fp16のベースラインと比較して、ほとんどの精度劣化と同等の推論速度を維持しながらモデルを実行できます。 GPTQは、メモリ効率と計算速度のトレードオフを最適化するためのポストトレーニング量子化(PTQ)手法として分類されます。この手法では、モデルの重みはint4で量子化され、アクティベーションはfloat16で保持されます。推論中に重みは動的に量子化解除され、実際の計算はfloat16で行われます。このアプローチにより、融合カーネルベースの量子化解除によるメモリの節約と、データ通信時間の短縮を通じた潜在的な高速化がもたらされます。 研究者たちは、GPTQにおける層ごとの圧縮の課題に対処するために、Optimal Brain Quantization(OBQ)フレームワークを活用しました。彼らは、モデルの精度を維持しながら量子化アルゴリズムを最適化するための最適化手法を開発しました。従来のPTQ手法と比較して、GPTQは量子化の効率を大幅に改善し、大規模モデルの量子化にかかる時間を短縮しました。 AutoGPTQライブラリとの統合により、ユーザーはさまざまなトランスフォーマーアーキテクチャで簡単にGPTQを活用できるようになります。Transformersライブラリでのネイティブサポートにより、複雑なセットアップなしでモデルを量子化できます。特に、量子化されたモデルはHugging Face Hubなどのプラットフォームでシリアル化および共有可能であり、より広範なアクセスと共同作業の可能性を開くことができます。 この統合は、Text-Generation-Inferenceライブラリ(TGI)にも拡張されており、GPTQモデルを効率的に本番環境で展開することができます。ユーザーは、最適なリソース利用のためにGPTQとともにダイナミックバッチングなどの高度な機能を活用することができます。 AutoGPTQの統合は重要な利点をもたらしますが、研究者たちはさらなる改善の余地も認識しています。彼らは、カーネルの実装の向上や、重みとアクティベーションを含む量子化手法の探索の可能性について言及しています。現在の統合は、LLMのデコーダーまたはエンコーダーのみのアーキテクチャに焦点を当てており、特定のモデルにのみ適用されます。 まとめると、Hugging FaceのTransformersにAutoGPTQライブラリを統合することで、資源集約型のLLMの訓練と展開の課題に取り組んでいます。GPTQ量子化を導入することで、メモリ消費と推論速度を最適化する効率的な解決策を提供しています。統合の広範なカバレッジとユーザーフレンドリーなインターフェースは、異なるGPUアーキテクチャでの量子化LLMへのアクセスを民主化する一歩となっています。この分野が進化し続ける中、機械学習コミュニティの研究者たちの協力によってさらなる進歩とイノベーションが期待されています。

「MITのこのAI研究は、光を基にした機械学習システムがより強力で効率的な大規模言語モデルを生み出す方法を示しています」

ディープニューラルネットワーク(DNN)は、コンピューターにとってスーパーブレインのような存在です。彼らは多くの情報からトリッキーなものを見つけ出すのが得意です。彼らはコンピューターに画像を理解させ、人間のように話し、自動車を自動運転させ、さらには医師が病気を見つけるのを助けるほど賢くなることができます。 DNNは、私たちの脳がどのように働くかを模倣しており、それによって、通常のコンピュータープログラムが苦労する難しい問題を効率的に解決することができます。しかし、現在のディープニューラルネットワーク(DNN)の基盤となるデジタル技術は、その能力の限界に直面しており、一方で機械学習の分野は拡大し続けています。さらに、これらの技術は膨大なエネルギー消費を要求し、広範なデータセンターに制約されています。この状況から、新しい計算アプローチの発見と創造が生まれるようになりました。 その結果、MITの研究者たちはこの状況の改善に多大な努力を注いできました。MITを率いるチームは、ChatGPTを駆動する機械学習プログラムの能力を数段上回る可能性を持つシステムを巧妙に考案しました。この新たに開発されたシステムは、現代の機械学習モデルを駆動する最先端のスーパーコンピューターよりもはるかに少ないエネルギーを消費するという驚異的な利点も持っています。このシステムは、数百のマイクロンスケールレーザーを用いた光の操作によって実現されています。 研究者たちは、この技術が大規模な光電子プロセッサーの実現につながり、データセンターから分散型エッジデバイスまでの機械学習タスクの加速を可能にする道を開いたと強調しています。言い換えれば、現在は大規模なデータセンターでのみ計算可能なプログラムを、携帯電話やその他の小型デバイスでも実行できるようになるかもしれません。光計算は、電子に比べてはるかに少ないエネルギーを消費します。光は、はるかに小さな空間に対してはるかに多くの情報を伝えることができます。 このイニシアチブのリーダーであるMIT電気工学およびコンピューターサイエンス学科の准教授であるDirk Englundは、現在のスーパーコンピューターの能力がChatGPTのサイズを制約していると述べています。経済的な要因により、はるかに大きなモデルの訓練の実現可能性は限られています。彼らが開拓したこの技術は、今後数年間においてはアクセスできないままであるはずの機械学習モデルの利用を可能にすることができます。彼はさらに、もし100倍の能力を持つ次世代のChatGPTが実現した場合、その能力についてはまだ決定中であるが、このような技術が許容する発見の領域であると述べています。 光ニューラルネットワークの利点にもかかわらず、現在の光ニューラルネットワーク(ONN)には重要な課題もあります。たとえば、電力に基づいて入力データを光に変換するのが非効率であるため、多くのエネルギーが必要です。さらに、これらの操作に必要なコンポーネントは大きく、かなりのスペースを占有します。加算などの線形計算に長けたOptoelectronic Neural Networks(ONNs)ですが、乗算や条件文などの非線形計算には制約があります。 この研究に関する論文とMITブログをご覧ください。この研究に関するすべてのクレジットは、このプロジェクトの研究者に帰属します。また、最新のAI研究ニュースや素敵なAIプロジェクトなどを共有している、2,900人以上のML SubReddit、40,000人以上のFacebookコミュニティ、Discordチャンネル、およびメールニュースレターにぜひご参加ください。 Hostinger AI Website Builder:使いやすいドラッグアンドドロップエディター。今すぐお試しください (提供) この記事はMarkTechPostで最初に掲載されたものです。

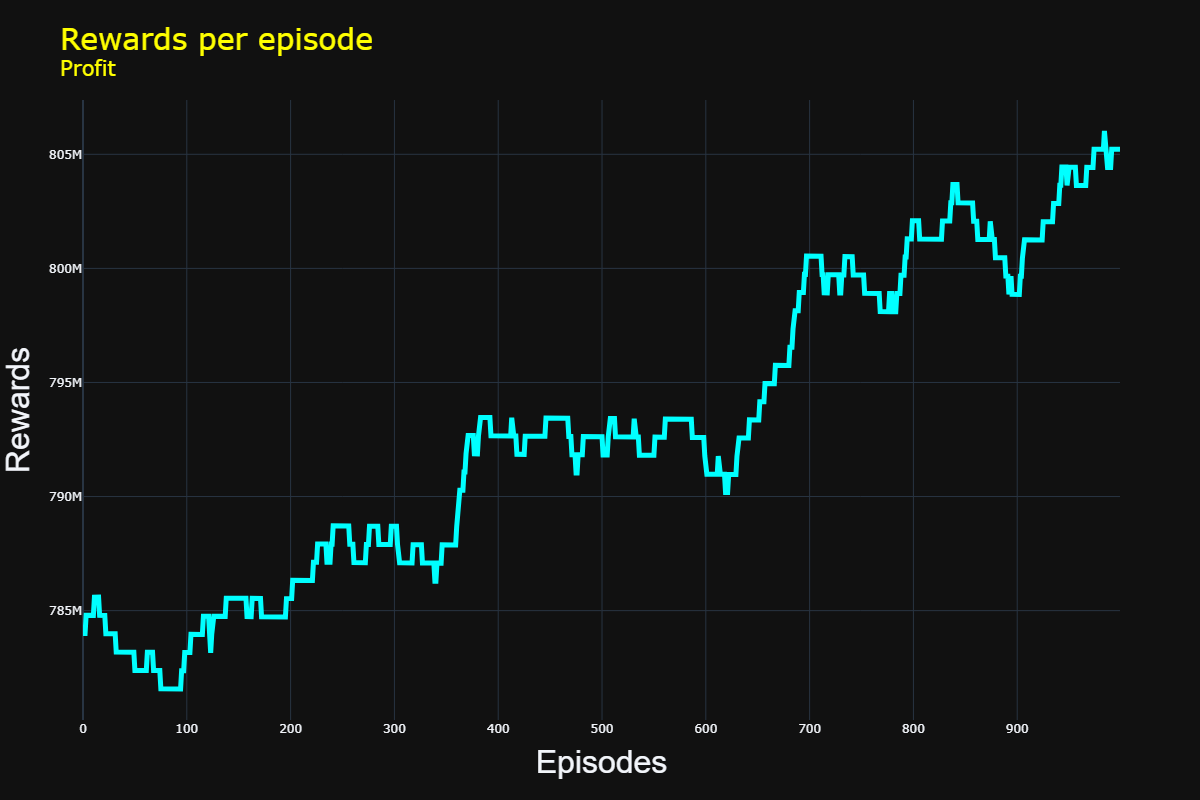

「Q-学習を用いたダイナミックプライシングのための強化学習」

この投稿では、強化学習の基本的な概念を紹介し、Q学習について詳しく説明しますQ学習は、知識をもとに意思決定を行い、最適な方策を学習するための手法です

「光に基づくMLシステムは、より強力で効率的なLLMを生み出す可能性がある」

研究チームが光を利用した機械学習システムを開発しましたこのシステムは、ChatGPTのシステムを超える性能と効率を持ちながら、より少ないエネルギーを消費します

デシは、コード生成のためのオープンソース1Bパラメータの大規模言語モデル「DeciCoder」を紹介します

AIの速い世界では、効率的なコード生成は見過ごすことのできない課題です。ますます複雑なモデルの出現に伴い、正確なコード生成の需要は急増していますが、エネルギー消費と運用コストへの懸念も増しています。この効率のギャップに直面し、先駆的なAI企業であるDeciは、効率的かつ正確なコード生成の新たな基準を再定義することを目指す、10億パラメータのオープンソースLarge Language Model(LLM)であるDeciCoderを紹介します。 既存のコード生成モデルは、精度と効率の微妙なバランスに苦しんできました。この領域の代表的なプレーヤーであるSantaCoderは、広く使用されていますが、スループットとメモリ消費に制約があることが示されています。ここで、DeciCoderが変革的な解決策として登場します。DeciのAI効率の基盤に基づいているDeciCoderは、最先端のアーキテクチャと独自のニューラルアーキテクチャサーチ技術であるAutoNACを活用しています。しばしば不十分な手動の労力を伴うアプローチとは異なり、AutoNACは最適なアーキテクチャの生成プロセスを自動化します。その結果、NVIDIAのA10 GPUに最適化された印象的なアーキテクチャが生まれます。これにより、スループットが向上し、かつSantaCoderと同等の精度が実現されます。 DeciCoderのアーキテクチャは、革新の証です。8つのキーバリューヘッドを備えたGrouped Query Attentionを組み込むことで、計算とメモリ使用量が合理化され、精度と効率の調和が実現されます。SantaCoderとの直接対決で、DeciCoderは独自の特徴を持っています – レイヤーが少ない(20対24)、ヘッドが多い(32対16)、および並列の埋め込みサイズ。これらの特徴は、AutoNACの複雑なダンスから派生し、DeciCoderの力を支えています。 DeciCoderの道のりは、革新と効率への執念によって特徴付けられています。この開発の示す意義は深いものです。DInfery LLMと併せてDeciCoderを活用することで、ユーザーはSantaCoderの驚異的な3.5倍のスループット向上の力を発揮することができます。この革新の物語は効率の向上だけで終わるものではありません。環境に配慮したAIに関しても同様です。Deciの環境に対する強い関心は、A10G GPU上での1つのモデルインスタンスあたりの二酸化炭素排出量を324 kg削減することで表現されています。これは、環境意識の高いAIへの有望な一歩となります。 https://deci.ai/blog/decicoder-efficient-and-accurate-code-generation-llm/ DeciCoderは孤立した取り組みではありません。これはDeciのAI効率への包括的なアプローチの一環です。同社が高効率な基盤LLMやテキストから画像へのモデルを導入する新時代の到来を告げる中で、開発者は、ファインチューニング、最適化、展開の領域を再定義する予定の生成AI SDKを期待することができます。この包括的なスイートは、効率の利点を巨大な企業や小規模なプレーヤーにも提供し、AIの可能性を民主化します。 DeciCoderのストーリーは、そのアーキテクチャとベンチマークにとどまるものではありません。それは力を与えることについての物語です。最小の制約でDeciCoderをプロジェクトに統合することができる許可されたライセンスは、開発者やビジネスに力を与えます。商用アプリケーションでDeciCoderを展開する柔軟性は、Deciのミッションであるイノベーションと成長を促進することと一致しています。これは、単にAIについての物語ではなく、技術とその影響においてポジティブな変革を起こすことについての物語です。 https://deci.ai/blog/decicoder-efficient-and-accurate-code-generation-llm/ 全体的に、DeciCoderは単なるモデル以上であり、AIの効率の潜在能力の実現です。AutoNAC、グループ化されたクエリアテンション、専用の推論エンジンのシナジーを通じて、高性能で環境に配慮したモデルを提供します。DeciCoderの紹介によって示されるDeciの旅は、AIコミュニティのための明かりであり、私たちの惑星の資源を尊重しながら技術革新を求める呼びかけです。それは単なるコードではなく、より持続可能で効率的なAIの未来のためのコードです。

「生成AIにおけるニューラル微分方程式の探索」

はじめに 生成AIは大きく進化し、新しい多様なデータを生成するためのさまざまな技術が含まれるようになりました。GANやVAEなどのモデルが注目を集めていますが、あまり探求されていないが非常に興味深い領域として、ニューラル微分方程式(NDEs)の世界があります。本記事では、Generative AIにおけるNDEsの未知の領域に深く掘り下げ、その重要な応用と包括的なPython実装を紹介します。 この記事はData Science Blogathonの一環として公開されました。 ニューラル微分方程式の力 ニューラル微分方程式(NDEs)は微分方程式とニューラルネットワークの原理を組み合わせたものであり、連続かつ滑らかなデータを生成するダイナミックなフレームワークを生み出します。従来の生成モデルは、離散的なサンプルを生成することが多く、その表現力が制限されており、時系列の予測、流体力学、現実的な動きの合成など、連続的なデータが必要なアプリケーションには適していません。NDEsは、連続的な生成プロセスを導入することで、時間とともに滑らかに進化するデータの生成を可能にし、このギャップを埋めます。 ニューラル微分方程式の応用 時系列データ 時系列データは、金融市場から生理学的信号まで、さまざまな領域で頻繁に使用されるデータです。ニューラル微分方程式(NDEs)は、時系列生成の画期的なアプローチとして登場し、時間的な依存関係を理解しモデル化するための独自の視点を提供します。微分方程式の優雅さとニューラルネットワークの柔軟性を組み合わせることで、NDEsは連続的に進化するデータを精巧に合成するAIシステムを可能にします。 時系列生成の文脈では、NDEsは流体の時間的な遷移の調整者となります。彼らは隠れたダイナミクスを捉え、変化するパターンに適応し、将来に予測を外挿します。NDEベースのモデルは、不規則な時間間隔を巧みに扱い、ノイズのある入力を受け入れ、正確な長期予測を容易にします。この驚異的な能力により、予測の景色が再定義され、トレンドの予測、異常の予測、およびさまざまな領域での意思決定の向上が可能になります。 NDEによる時系列生成は、AIによる洞察を提供します。金融アナリストは市場のトレンドを予測するために、医療従事者は患者のモニタリングに、気候科学者は環境変化を予測するためにそれを利用しています。NDEの連続的かつ適応的な性質は、時系列データを生き生きとさせ、AIシステムが時間のリズムと調和して踊ることを可能にします。 物理シミュレーション 物理シミュレーションの領域に進むと、ニューラル微分方程式(NDEs)は、自然現象の複雑な模様を解き明かすことができる才能豊かな存在として現れます。これらのシミュレーションは、科学的な発見、エンジニアリングのイノベーション、およびさまざまな分野での創造的な表現の基盤となっています。微分方程式とニューラルネットワークを融合させることで、NDEsは仮想世界に生命を吹き込み、複雑な物理的プロセスを正確かつ効率的にエミュレーションすることが可能になります。 NDEによる物理シミュレーションは、流体力学から量子力学に至るまで、私たちの宇宙を支配する法則を包括して再現します。従来の方法では、広範な計算リソースと手動のパラメータ調整が必要でしたが、NDEsは明示的な方程式の設定を回避し、動的なシステムに学習し適応することで、シミュレーションのワークフローを加速し、実験を迅速化し、シミュレーションの範囲を拡大します。 航空宇宙、自動車、エンターテイメントなどの産業は、NDEによるシミュレーションを活用して設計を最適化し、仮説を検証し、現実的な仮想環境を作り出しています。エンジニアや研究者は、以前は計算上困難なシナリオを探求し、未知の領域を航海します。要するに、ニューラル微分方程式は、仮想と具体的な世界の間に橋を架け、デジタル領域内で物理学の複雑な交響曲を具現化します。 モーション合成 モーション合成は、アニメーション、ロボティクス、ゲームなどにおける重要な要素であり、ニューラル微分方程式(NDEs)はそこで芸術的かつ実用的な能力を発揮します。従来、自然で流体的なモーションシーケンスの生成は、基礎となるダイナミクスの複雑さにより課題がありました。NDEsはこの領域を再定義し、AIによるキャラクターやエージェントに人間の直感とシームレスに共鳴するような生命のあるモーションを与えます。 NDEsは連続性をモーション合成に与え、ポーズや軌跡をシームレスにリンクし、離散的なアプローチによるジャリングしたトランジションを排除します。彼らはモーションの基礎的なメカニクスを解読し、キャラクターに優雅さ、重み、反応性を注入します。蝶の羽ばたきのシミュレーションからヒューマノイドロボットのダンスの振り付けまで、NDEによるモーション合成は創造性と物理学の調和の取れた融合です。 非破壊検査(NDE)駆動のモーション合成の応用は広範で変革的です。映画やゲームでは、キャラクターが真正さを持って動き、感情的な関与を引き起こします。ロボティクスでは、機械が優雅かつ精密に環境を移動します。リハビリテーション装置はユーザーの動きに適応し、回復を促進します。NDEが指揮することで、モーション合成は単なるアニメーションを超え、作成者と観客の両方に共鳴する動きのシンフォニーを編成するための道となります。 ニューラル微分方程式モデルの実装 NDEの概念を説明するために、PythonとTensorFlowを使用して基本的な連続時間VAEを実装してみましょう。このモデルは連続的な生成プロセスを捉え、微分方程式とニューラルネットワークの統合を示しています。 (注:以下のコードを実行する前に、TensorFlowと関連する依存関係をインストールしてください。)…

Pythonアプリケーション | 速度と効率の向上のためのマルチプロセッシングの活用

イントロダクション 現代のマルチコアプロセッサのすべての機能を活用するために、マルチプロセッシングはコンピュータサイエンスの基本的な考え方であり、プログラムが複数のタスクやプロセスを同時に実行できるようにします。タスクを複数のプロセスに分割し、それぞれが独自のメモリ空間を持つことで、マルチプロセッシングは従来のシングルスレッド技術とは対照的に、ソフトウェアがパフォーマンスの制約を克服することができます。プロセスが分離されているため、メモリの競合が回避されるため、安定性とセキュリティがあります。特に、計算量の多いCPUバウンドのジョブでは、マルチプロセッシングのコードの実行を最適化する能力が重要です。データ処理、科学的シミュレーション、画像およびビデオ処理、機械学習など、スピードと効果が重要なPythonアプリケーションにおいて、それはゲームチェンジャーです。 学習目標 マルチプロセッシングと現代のマルチコアプロセッサの利用におけるPythonアプリケーションのパフォーマンス向上の重要性をしっかり理解する。 Pythonの「multiprocessing」モジュールを使用して、複数のプロセスを作成、管理、同期する方法を学び、タスクの並列実行を安定性とデータの整合性を確保しながら実現する。 タスクの性質、リソース利用、通信オーバーヘッドの対処など、マルチプロセッシングのパフォーマンスを最適化するための戦略を見つけ、効率的で応答性の高いPythonアプリケーションを開発する。 マルチプロセッシング 現代のマルチコアプロセッサの機能を活用するために、マルチプロセッシングはプログラミングにおける強力な手法であり、プログラムが複数のタスクやプロセスを同時に実行できるようにします。マルチスレッディングではなく、プロセスごとに独自のメモリ空間を持つことが特徴です。この分離により、プロセス間でのメモリの干渉がなくなり、安定性とセキュリティが向上します。 この記事はデータサイエンスブログマラソンの一部として公開されました。 コードの実行の最適化におけるマルチプロセッシングの重要性 ソフトウェア開発における重要な目標の一つは、コードの実行を最適化することです。シーケンシャルプログラミングでは、単一のコアの処理能力は制約となる場合があります。マルチプロセッシングは、タスクを複数のコアに割り当てることによって、この制約を克服し、現代のプロセッサの機能を最大限に活用します。その結果、処理量が多いジョブはより速く、大幅にパフォーマンスが向上します。 マルチプロセッシングが有益なシナリオ CPUバウンドタスク:複雑な数学計算やシミュレーションなど、主に集中的な計算処理を必要とするアプリケーションでは、マルチプロセッシングにより大幅な高速化が実現されることがあります。各プロセスは計算の一部を同時に実行し、CPUを最大限に活用します。 並列処理:マルチプロセッシングにより、さまざまな独立したサブタスクを同時に処理することができます。これにより、多くの現実世界の問題をより管理しやすい部分に分割することができます。これにより、タスクの完了にかかる時間が短縮されます。 画像およびビデオ処理:写真や映画の編集では、さまざまなメディアの一部にフィルターや変更、分析を適用することが一般的です。マルチプロセッシングによってこれらの操作をプロセス間で分散させることで、効率が向上します。 科学的シミュレーション:タンパク質の折りたたみや気象モデリングなどの複雑なシミュレーションにおいて、マルチプロセッシングは有利です。シミュレーションは独立したプロセスで実行され、より迅速な結果が得られます。 Webスクレイピングとクローリング:マルチプロセッシングにより、複数のウェブサイトから情報を同時に取得することで、情報の収集にかかる時間を短縮することができます。 同時サーバ:各プロセスが異なるクライアントリクエストを処理するときに、マルチプロセッシングは役立ちます。これにより、遅いリクエストが速いリクエストを妨げることがありません。 バッチ処理:タスクをバッチごとに完了する必要がある場合、マルチプロセッシングによって処理を高速化することができます。 プロセスとスレッドの理解 並行性と並列性の達成は、プロセスとスレッド、コンピュータプログラムの基本的な実行単位を使用することに大きく依存します。 プロセス: 独立したユーザープログラムのインスタンスがプロセスです。各プロセスには独自の実行環境、メモリ空間、リソースがあります。プロセスは分離されているため、直接的にメモリを共有しません。プロセス間通信(IPC)は、プロセス間の通信を容易にするための最も複雑なメカニズムの一つです。その大きさと本来の分離性により、プロセスは多数の独立したプログラムを実行するなど、重いタスクの処理に優れています。 スレッド:…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.