Learn more about Search Results MPT - Page 75

- You may be interested

- 「MetaGPTと出会ってください:GPTをエン...

- 「2023年9月のソーシャルメディア向けの20...

- コア42とCerebrasは、Jais 30Bのリリース...

- AIにおけるエキスパートの混合(MoE)モデ...

- フェイブルスタジオは、TV番組の完全に新...

- 「Rプログラミング言語を使った統計学入門」

- データサイエンティストになりたいですか...

- 5つの最高のChatGPT SEOプラグイン

- T-Mobile US株式会社は、Amazon Transcrib...

- 「AWSは責任ある生成AIへの取り組みを再確...

- 予めトレーニングされた基礎モデルは、分...

- 「2024年に成功したデータサイエンティス...

- AIの相互作用を変革する:LLaVARは視覚と...

- このAI論文は、高度な潜在的一致モデルとL...

- 「人間の活動認識におけるディープラーニ...

パンダの力を解放する:.locと.ilocの深いダイブ

PythonのPandasのポテンシャルを引き出しましょうデータの選択における.locと.ilocの詳細を学び、データ分析プロセスを向上させましょう

将来のアプリケーションを支える大規模言語モデル(LLM)の力

生成AI、特にその言語フレーバーであるChatGPTはどこでも見かけます大規模言語モデル(LLM)の技術は、将来のアプリケーションの開発において重要な役割を果たすでしょうLLMは、数兆行に及ぶパブリックドメインのテキストに対する基礎モデルの詳細な事前トレーニングによって、言語理解に非常に優れています

MLにおけるETLデータパイプラインの構築方法

データ処理から迅速な洞察まで、頑強なパイプラインはどんなMLシステムにとっても必須ですデータチーム(データとMLエンジニアで構成される)はしばしばこのインフラを構築する必要があり、この経験は苦痛となることがありますしかし、MLでETLパイプラインを効率的に使用することで、彼らの生活をはるかに楽にすることができます本記事では、その重要性について探求します...

GPT-3がMLOpsの将来に与える意味とは?デビッド・ハーシーと共に

この記事は元々MLOps Liveのエピソードであり、ML実践者が他のML実践者からの質問に答えるインタラクティブなQ&Aセッションです各エピソードは特定のMLトピックに焦点を当てており、このエピソードではGPT-3とMLOpsの特徴についてDavid Hersheyと話しましたYouTubeで視聴することができます Or...

言語モデルの解毒化における課題

私たちの論文では、言語モデル(LM)とその有毒な言語生成能力に焦点を当てていますLMの有毒性を軽減するためのさまざまな方法の効果、およびそれらの副作用について研究し、分類器ベースの自動有毒性評価の信頼性と限界を調査します

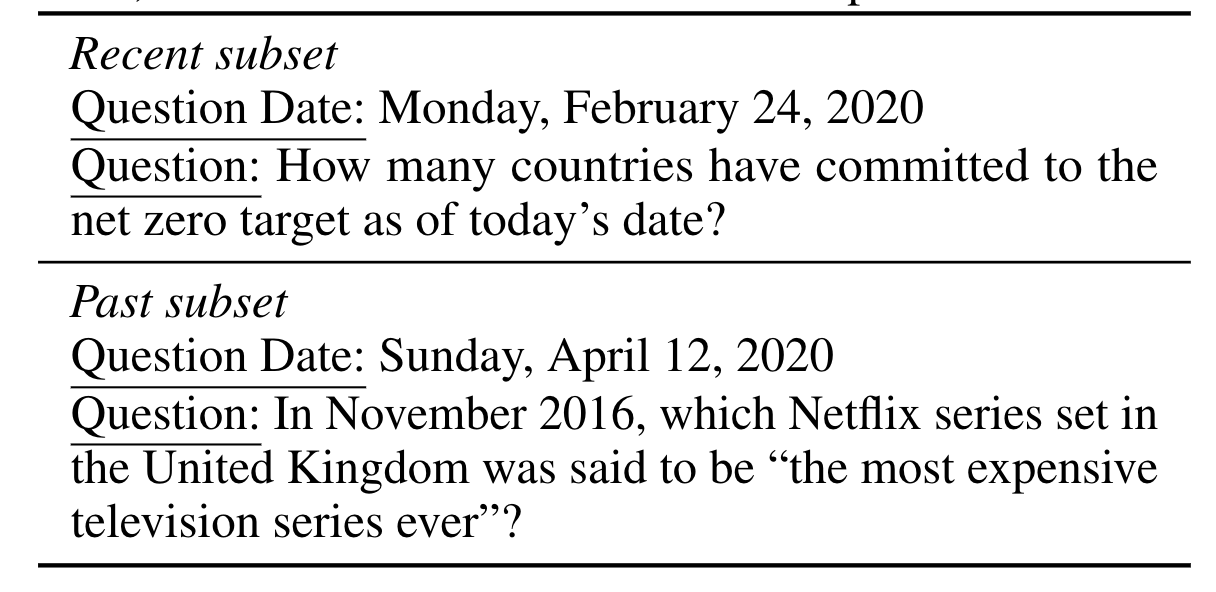

動的言語理解:パラメトリックおよび半パラメトリックモデルでの新しい知識への適応

進化する知識に対して半パラメトリックなQAモデルとその基礎となるパラメトリックな言語モデル(LMs)がどのように適応するかを研究するために、与えられた日付において人間が作成した質問や生成された質問を14年分のタイムスタンプのあるニュース記事から回答するための新しい大規模データセットであるStreamingQAを作成しました学習前には見られなかった新しい記事を読むたびに、モデルを四半期ごとに評価します我々は、パラメトリックモデルは完全な再学習なしで更新することができ、同時に壊滅的な忘却を回避することを示します

ディプロマシーというボードゲームのためのAI

歴史を通じて、成功したコミュニケーションと協力は社会の進歩に不可欠でしたボードゲームの閉ざされた環境は、相互作用やコミュニケーションのモデリングと調査のための砂場として機能し、私たちはそれらをプレイすることで多くのことを学ぶことができます私たちの最新の論文では、Nature Communicationsに今日発表されたもので、人工エージェントがコミュニケーションを利用してボードゲーム「Diplomacy」でより良い協力を行う方法を示していますDiplomacyは人工知能(AI)研究の中でも注目されている領域で、同盟構築に重点を置いています

OpenAIが「スーパーアラインメント」を紹介:安全で整合性のあるAIの道を切り拓く

OpenAIは、超整合開発を紹介しています。これは、その広範な能力により、人類のために非常に大きな約束を持っています。超知能の出現に伴い、人類の可能な無力化またはさえ壊滅が深刻な危険と関連しています。 超整合の到来 超整合は、遠い可能性のように思われるかもしれませんが、次の10年以内に実現するかもしれません。我々は新しい統治構造を作り、超知能との整合性の問題に対処し、それらに関連する危険を効果的に制御する必要があります。 AIと人間の超整合:現在の課題 人間よりもはるかに賢いAIシステムが人間の意図と整合することを保証することは、重要な障害です。現在、私たちのAIを整合させるためのテクニックは、人間の監督に依存しています。しかし、人間の知能を超えるAIシステムを扱う場合、現在の整合方法は不十分です。これに対処するために、私たちは新しい科学的および技術的な突破口が必要です。 仮定の克服と整合性の拡大 現在のAI開発を指南しているいくつかの仮定は、超知能時代になると失敗する可能性があります。これらの仮定には、モデルがトレーニング中に監督を識別および覆す能力、および展開時の有利な一般化機能が含まれます。 OpenAIが構築するのは、ほぼ人間レベルの知能を持つ自動整合研究者です。彼らは、多くの計算能力を使用して、自らの努力をスケーリングし、超知能を反復的に整合させたいと考えています。 超整合の基盤の構築 自動整合研究者の目標を達成するために、OpenAIは次の3つの重要なステップを特定しました: 1. スケーラブルなトレーニング方法の開発 OpenAIは、スケーラブルなトレーニング戦略の作成に集中します。この方法は、人間が評価するのが困難な活動をAIシステムに教えるために不可欠です。 2. 結果モデルの検証 構築後の整合研究者の効果を検証することは重要です。モデルが人間の意図に合致し、計画どおりに機能することを確認するために、OpenAIは厳格なテストを行います。 3. 整合パイプラインのストレステスト OpenAIは、整合パイプラインを広範なストレステストにかけ、耐久性を確保します。困難な状況でシステムをテストすることで、潜在的な欠陥を見つけて修正することができます。 AIシステムの監視と一般化の活用 OpenAIは、人間にとって判断が難しい仕事の監視にAIシステムを活用することで、スケーラブルな監視を実現しようとします。この方法により、成功した整合性が保証されます。また、AIシステムが人間の制御下にない活動を処理できるようにする監視の一般化にも取り組みます。 整合性の検証:頑健性と解釈性 AIシステムの整合性を確保するためには、頑健性と解釈性の2つの重要な要素に焦点を当てる必要があります。OpenAIは、システムの内部を調査し、問題のある動作を自動的に検出することで、潜在的な整合性の問題を明らかにする予定です。 敵対的テスト:不整合の検出…

DataHour ChatGPTの幻視を80%減らす

はじめに 自然言語処理(NLP)モデルは近年、チャットボットから言語翻訳までさまざまなアプリケーションで人気が高まっています。しかし、NLPの最大の課題の1つは、モデルによって生成されるChatGPTの幻覚や不正確な応答を削減することです。この記事では、NLPモデルの幻覚を削減するために必要な技術と課題について説明します。 観測性、調整、テスト 幻覚を削減するための最初のステップは、モデルの観測性を向上させることです。これには、ユーザーフィードバックとモデルのパフォーマンスをプロダクションでキャプチャするフィードバックループの構築が含まれます。調整では、より多くのデータを追加したり、検索の問題を修正したり、プロンプトを変更したりすることで、不正確な応答を改善します。テストは、変更が結果を改善し、回帰を引き起こさないことを確認するために必要です。観測性の課題には、顧客が不正確な応答のスクリーンショットを送信することによって引き起こされるイライラが含まれます。これに対処するために、データの取り込みと秘密のコードを使用してログを毎日監視することができます。 言語モデルのデバッグとチューニング 言語モデルのデバッグとチューニングのプロセスでは、モデルの入力と応答を理解することが重要です。デバッグには、生のプロンプトを特定のチャンクや参照に絞り込むためにログが必要です。ログは、誰にでも理解しやすく、実行可能なものでなければなりません。チューニングでは、モデルにどれだけのドキュメントを与えるべきかを決定します。デフォルトの数値は常に正確ではなく、類似検索では正しい答えが得られないことがあります。目標は、何がうまくいかなかったのか、それを修正する方法を見つけることです。 OpenAI埋め込みの最適化 アプリケーションで使用されるOpenAI埋め込みのパフォーマンスを最適化することに直面したベクトルデータベースクエリアプリケーションの開発者は、いくつかの課題に直面しました。最初の課題は、モデルに渡す最適なドキュメント数を決定することであり、これはチャンキング戦略の制御とドキュメント数のための制御可能なハイパーパラメータの導入によって解決されました。 2番目の課題は、プロンプトのバリエーションであり、Better Promptというオープンソースライブラリを使用して、パープレキシティに基づいて異なるプロンプトバージョンのパフォーマンスを評価しました。3番目の課題は、マルチリンガルシナリオでの文の変換子よりもOpenAI埋め込みの結果の改善が見つかったことです。 AI開発の技術 この記事では、AI開発で使用される3つの異なる技術について説明しています。最初の技術はパープレキシティであり、与えられたタスクにおけるプロンプトのパフォーマンスを評価するために使用されます。2番目の技術は、ユーザーが異なるプロンプト戦略を簡単にテストできるパッケージの構築です。3番目の技術は、インデックスの実行であり、何かが欠けているか理想的でない場合に追加のデータを使用してインデックスを更新することが含まれます。これにより、質問のよりダイナミックな処理が可能になります。 GPT-3 APIを使用してパープレキシティを計算する スピーカーは、クエリに基づいてパープレキシティを計算するためにGPT-3 APIを使用した経験について説明しています。彼らはAPIを介してプロンプトを実行し、最適な次のトークンのログ確率を返すプロセスについて説明しています。また、新しい情報を埋め込むのではなく、特定の書き方を模倣するために大規模な言語モデルを微調整する可能性についても言及しています。 複数の質問に対する応答の評価 テキストでは、50以上の質問に対する応答の評価の課題について説明しています。すべての応答を手動で採点するのは時間がかかるため、会社は自動評価ツールの使用を検討しました。しかし、単純なはい/いいえの判断枠組みでは不十分であり、回答が正しくない理由は複数あります。会社は評価をさまざまなコンポーネントに分割しましたが、自動評価ツールの単一の実行は不安定で一貫性がありませんでした。これを解決するために、質問ごとに複数のテストを実行し、応答を完璧、ほぼ完璧、一部正しい情報を含む不正確、完全に不正確なものに分類しました。 NLPモデルでの幻覚の削減 スピーカーは、自然言語処理モデルでの幻覚を削減するためのプロセスについて説明しています。彼らは意思決定プロセスを4つのカテゴリに分け、50以上のカテゴリに対して自動機能を使用しました。また、評価プロセスをコア製品に展開し、評価を実行してCSBにエクスポートすることも可能にしました。スピーカーはプロジェクトに関する詳細情報のためのGitHubリポジトリに言及しています。そして、観測性、調整、テストなどの手順を取り上げ、幻覚率を40%から5%未満に削減することができました。 結論 NLPモデルにおけるChatGPTの幻想を減らすことは、可観測性、調整、テストといった複雑なプロセスを必要とします。開発者はプロンプトのバリエーション、埋め込みの最適化、複数の質問に対する応答の評価も考慮する必要があります。また、困惑度、プロンプト戦略のテスト用パッケージの作成、インデックスの実行といったテクニックもAI開発に役立つことがあります。AI開発の未来は、小規模でプライベート、またはタスク固有の要素にあります。 要点 NLPモデルにおけるChatGPTの幻想を減らすには、可観測性、調整、テストが必要です。…

このAI研究は、大規模言語モデル(LLM)における合成的な人格特性を説明しています

個人の人格は、質、特性、思考方法のユニークな組み合わせから成り立ちます。共有の生物学的および環境的な歴史により、最も基本的な社会的相互作用と好みを形成します。訓練中に人間が生成したデータに広範に露出することで、LLM(Large Language Model)は、人間のような人格を説得力を持って表現し、結果として合成的な人格を示すことができます。 LLMの能力の向上に伴う意図しない影響(暴力的な言語の生成、詐欺的および操作的な言語の生成など)の特定を試みる研究が最近行われています。LLMからの対話、説明、知識の抽出は常に信頼性があるわけではありません。 これらのモデルによって生成された言語の人格特性に関する理解は、LLMが主要な人間-コンピュータインタラクション(HCI)インタフェースとなるにつれて重要です。同様に、LLMが生成する人格プロファイルを安全かつ適切に効果的にエンジニアリングする方法を学ぶことも重要です。研究者は、LLMの結果におけるネガティブで深刻な人格特性の影響を軽減するための、few-shot promptingを含む手法を研究しています。LLMは非常に変動する出力を持ち、プロンプトに過敏ですが、その人格を科学的かつ体系的に定量化する方法についてはまだ研究が行われていません。 Google DeepMind、ケンブリッジ大学、Google Research、慶應義塾大学、カリフォルニア大学バークレー校の研究者たちは、厳密で検証された心理測定的アプローチを提案し、LLMに基づく人格合成を特徴づけ、形成する方法を提示しています。 チームはまず、既存の心理測定テストを利用して、LLMが生成した文学において人格を特徴づける構造的妥当性を確立するための方法論を作成します。彼らは、制御されたプロンプトを介してLLMの応答に人口分散を模倣する新しいアプローチを提案し、人格とその外部的関連性との統計的相関を、人間の社会科学データに存在するようにテストします。最後に、彼らはLLMに独立して機能し、特性レベルに観測可能な変化をもたらす人格形成の方法を貢献します。 研究者たちは、MCQAと長文生成の2つの自然なインタラクション設定で、サイズや訓練方法の異なるLLMにアプローチをテストしました。調査結果は以下の観察結果を示しています: 特定のプロンプト構成の下で、LLMは信頼性があり、人格をシミュレートすることができます。 LLMがシミュレートした人格の信頼性と妥当性は、より大きなモデルにおいてより強くなります。 LLMの出力における人格は、特定の人格プロファイルを模倣するために望ましい次元に沿って形成することができます。

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.

.jpg)