Learn more about Search Results k-means - Page 6

- You may be interested

- 「LangChainとは何ですか?利用事例と利点」

- スウィン・トランスフォーマー | モダンな...

- 共和分対スパリアス相関:正確な分析のた...

- 人間に戻る:AIの道:コードからぬいぐる...

- 東京理科大学の研究者は、材料科学におけ...

- シリコンバレー、『シンギュラリティ』が...

- 「NExT-GPT あらゆるモダリティに対応した...

- コースを安定させる:LLMベースのアプリケ...

- テキサス大学の研究者たちは、機械学習を...

- SRGANs:低解像度と高解像度画像のギャッ...

- 「これらの3つのあまり知られていないPand...

- テキストと画像の検索を行うNodeJS AIアプ...

- アルファフォールドの力を世界の手に

- Pythonを使用した感情分析の始め方

- CVモデルの構築と展開:コンピュータビジ...

「テキスト分析の未来を明らかにする BERTを使用したトレンディなトピックモデリング」

イントロダクション 機械学習と自然言語処理において非常に効果的な手法は、トピックモデリングです。テキストのコーパスは、文書のコレクションの例です。この手法は、そこに現れる抽象的な主題を見つけることを目的としています。この手法は、テキストのコーパスの潜在的な構造を明らかにし、即座には見えないテーマやパターンを明らかにします。 数千ものツイートなどの大量のドキュメントの内容を分析するために、トピックモデリングアルゴリズムはテキストのパターンを見つけるために統計的な技術に依存しています。これらのアルゴリズムは、ドキュメント内の頻度や単語の共起を調べた後、いくつかの主題に論文を分類します。その結果、内容はより整理されて理解しやすくなり、データの潜在的なテーマやパターンを認識しやすくなります。 潜在ディリクレ割り当て(LDA)、潜在的意味解析、非負値行列因子分解などがトピックモデリングのいくつかの従来の手法です。しかし、このブログ記事では、トピックモデリングにBERTを使用しています。 詳細情報:トピックモデリングのための潜在ディリクレ割り当て(LDA)を使用する 学習目標 以下は、BERTを使用したトピックモデリングのワークショップの学習目標のリストです: トピックモデリングの基礎とNLPでの使用方法を理解する BERTの基礎とドキュメントの埋め込みの作成方法を理解する BERTモデルにテキストデータを準備するために前処理を行う [CLS]トークンを使用してBERTの出力からドキュメントの埋め込みを抽出する クラスタリング手法(K-meansなど)を使用して関連する資料をグループ化し、潜在的な主題を見つける 生成されたトピックの品質を評価するために適切な指標を使用する この学習目標の助けを借りて、参加者はBERTを使用したトピックモデリングの実践的な経験を得ることができます。この知識を活用して、彼らは大規模なテキストデータの中から隠れたテーマを分析し、抽出する準備をすることができます。 この記事はData Science Blogathonの一環として公開されました。 データの読み込み これはオーストラリア放送協会のコンテンツであり、Kaggleで8年以上にわたり利用可能になっています。2つの重要な列が含まれています:publish_date:記事の公開日(yyyyMMdd形式)と、headline_textの英語訳。これがトピックモデルが使用する知識です。 import pandas as pd #…

「ガウス混合モデル(GMM)の3つのユースケース」

ガウス混合モデル(GMM)は、各分類の確率を予測するためにK-means手順に基づいて構築された、シンプルでありながら強力な教師なし分類アルゴリズムです

個別のデータサイエンスのロードマップを作成する方法

はじめに 現在のデータ駆動の世界では、多くの人々がデータサイエンスのキャリアを選びますが、進め方がわかりません。キャリアの成功を保証してくれるのはどのキャリアパスでしょうか?パーソナライズされたデータサイエンスのロードマップが答えです! データサイエンスは、その分野の多様性と異なるキャリアパスの存在から、個別のキャリアロードマップが重要です。データサイエンスは、プログラミングや統計分析から機械学習やドメイン特化の専門知識まで、さまざまなスキルを必要とします。各データサイエンティストは、独自の強み、興味、キャリアの目標を持っており、一つのアプローチでは不十分です。この記事では、パーソナライズされたデータサイエンスのロードマップの重要性について説明します! データサイエンスのロードマップの必要性 データサイエンスは、学際的で広範な分野です。機械学習、データエンジニアリング、統計学、データ分析など、さまざまな分野が含まれています。これらを一つずつ学ぶだけでなく、時間の無駄です。データサイエンスのロードマップは、以下の利点を提供することで、候補者がスムーズにキャリアを進めるのに役立ちます: 方向性の明確化:学習と仕事の段階ごとに学ぶべきスキルや知識を決定するのに役立ちます。 効率的な学習:特定のトピックから学習の旅を始めるように指示し、試行錯誤を回避します。 目標設定:データサイエンティストのロードマップは、自分の分野に重要な目標を設定するのに役立ちます。 専門化:ビジネスアナリスト、データアナリスト、エンジニア、機械学習エンジニアなど、各職業についての情報を提供することで、キャリアパスの選択を容易にします。 パーソナライズされたデータサイエンスのロードマップとは? データサイエンスのロードマップは、個々の人々がデータサイエンスのキャリアを進めるための計画やガイドです。データサイエンスの広範さを考慮すると、データサイエンスのロードマップは、キャリアの選択、スキル、興味、バックグラウンド、インスピレーションに応じて個別に異なります。これにより、キャリアの目標を達成するために最も適したパスを選択することができ、より迅速で邪魔のない学習の旅につながります。データサイエンスのコースやスキルを選ぶ際に、ロードマップを手に入れることは、以下の理由から初めのステップであるべきです: データサイエンスのロードマップは、個々の強みと弱点に焦点を当てて、スキルと専門知識を構築します。 明確かつ現実的な目標を設定し、構造化されたアプローチを提供します。長期目標を短期目標に分割して簡単に達成し、達成感を得ることができます。 データサイエンスの特定のキャリアに適応するのに役立ちます。選択した分野のすべてのコンポーネントを学習に含みます。 インターネット上には圧倒的な情報がありますが、ロードマップはそれをフィルタリングして時間とリソースを節約します。スキルの実践的な応用に焦点を当てることで、仕事の獲得の可能性が高まります。 成功するデータサイエンスのロードマップを解き放つ! 以下の手順に従うことで、データサイエンスの夢のキャリアに向けて確実なプロセスを進めることができます: 機械学習のスキルを開発する データサイエンスでは、機械学習のスキルが重要です。データセットからの探索的データ分析やデータクリーニングにより、データの要約とエラーの除去が行われます。特徴選択とエンジニアリングによるデータの抽出の学習は、機械学習アルゴリズムのパフォーマンス向上に役立ちます。重要な一般的なモデルには、線形回帰、ロジスティック回帰、決定木、K最近傍法、ナイーブベイズ、K-means、勾配ブースティングマシン、XGBOOST、サポートベクターマシン(SVM)などがあります。これらの目的、機能、応用は、データサイエンスのプロジェクトにおいて異なります。 また、読んでみてください:トップ20の機械学習プロジェクト 問題解決スキルの開発 データサイエンスの仕事では、複雑なデータセットを分析する必要があります。革新的で費用対効果の高い解決策が必要な問題が数多く発生します。また、データの探索、モデルの選択、ハイパーパラメータのチューニング、モデルのパフォーマンスの最適化など、問題解決スキルが必要なタスクもあります。これらのスキルにより、創造性と洗練されたアプローチで課題に取り組むことができます。 ハッカソンとプロジェクトに取り組む ハッカソンやプロジェクトは、選んだ分野の実世界のシナリオでの実践的な経験を提供します。最新のトレンドや必要なスキルについて学ぶことで、特定のドメインの専門知識を持つポートフォリオを構築する機会があります。また、スキルを学習し適用するための自律性と適応能力を示すこともできます。…

「データアナリストがよく遭遇するであろう10の一般的な質問—それに対する回答方法」

データ分析の早い世界では、新しい役割に飛び込む際にデジャブを経験することは珍しくありません同じ質問が繰り返されるパターンに気付いたことがあるかもしれません...

「さまざまな深層学習を用いた天気予測モデルに関する研究」

気象予測の世界的な影響を考慮して、様々な研究コミュニティの研究者の関心を引いてきました。最近のディープラーニング技術の進歩、大量の気象データの広範な提供、情報技術およびコンピュータ技術の進展により、多くの研究が気象予測のための大容量の気象データセットの中に隠れた階層的パターンを探索することに動機付けられてきました。機械学習技術は、極端な気象イベントの予測、観測およびモデル化された大気条件における極端な気象および気候パターンの特定、および激しい天候の運用ガイダンスとリスク評価に適用されてきました。過去数年間、MetNet-2、WF-UNet、ClimaX、GraphCast、Pangu-Weatherなどのディープラーニングベースの気象予測モデルの開発が進んできました。 この記事では、これらのモデルについて簡単に説明し、これらのモデルが従来の気象シミュレータに比べて大幅に優位になっているかどうかを理解します。 ClimaX:気象および気候の基礎モデル 物理学に基づいた数値大気モデルは、現在の気象および気候予測ソフトウェアの基盤です。これらの技術は非線形ダイナミクスと複雑な多変数間の相互作用をモデル化し、近似することが困難になっています。高い空間および時間分解能で大気過程を数値的にシミュレートすることは、計算的に要求が高くなります。最新の機械学習ベースのデータ駆動型技術は、ディープニューラルネットワーク内でデータ駆動型の機能マッピングをトレーニングすることにより、ダウンストリームの予測または投影タスクを直接処理します。これらのネットワークは、離散的な時空間タスクのために限られた一貫した気候データでトレーニングされるため、数値モデルの汎用性を欠いています。 Microsoft Autonomous Systems and Robotics Research、Microsoft Research AI4Science、およびUCLAによる新しい研究では、ClimaXという気象および気候科学のためのディープラーニングモデルが紹介されています。ClimaXは、さまざまなデータセット、異なる変数、空間的および時間的なカバレッジ、物理的基盤でトレーニングすることができます。ClimaXは、CMIP6気候データセットを無監督でトレーニングに使用します。広範な利用性を維持しながら計算を増やすために、ClimaXはTransformerを新しいエンコーディングと集約ブロックで拡張しています。 初期トレーニングの後、ClimaXは大気変数や異なる時間・空間スケールを含むさまざまな気候および天候のジョブを実行するために微調整することができます。低い解像度や少ない計算予算で事前トレーニングされていても、ClimaXの普遍性により、気象予測および気候予測のベンチマークでデータ駆動型のベースラインを上回る性能が得られます。 研究者たちは、この手法の普遍性がさらに多様な目的に役立つ可能性があると考えています。これには、極端な気象イベントの予測や人為的気候変動の評価など、既に事前トレーニングされたClimaXバックボーンを活用できる地球システム科学のタスクの例が含まれます。気象や気候との密接な関係があるため、農業、人口統計学、および保険科学も興味深い候補です。 Pangu-Weather:グローバル気象予測のための Huawei Cloud Computingの研究チームが導入したPangu-Weatherは、ディープラーニングに基づくグローバル気象予測システムです。チームはECMWFの第5世代再解析(ERA5)から43年間の毎時のグローバル気象データを収集し、256百万パラメータを持ついくつかのディープニューラルネットワークをトレーニングするためのデータ駆動型の環境を作成しました。 これは、全ての変数(高度、比湿度、風速、温度など)および全ての時間スケール(1時間から1週間まで)において、最先端の数値気象予測(NWP)技術よりも正確性が向上している初めてのAIベースのアプローチです。階層的な時間集約戦略と3D Earth Specific Transformer(3DEST)アーキテクチャを使用することで、予測の正確性が向上しています。Pangu-forteは、短期から中期までの決定論的な予測を行います。気象(つまり、予測時間は1時間から1週間まで)。 Pangu-Weatherからは、台風の追跡やリアルタイムの大規模メンバーアンサンブル予測など、さまざまなダウンストリーム予測オプションが利用できます。Pangu-Weatherは、AIベースの技術がNWP技術よりも優れた性能を発揮できるかどうかという問いに答え、ディープラーニング気象予測システムの向上に向けた新しい提案を行います。 チームは、彼らのトレーニング方法がまだ完全な収束を達成していないと考えています。観測要素の数を増やし、4Dディープネットワークのトレーニングに時間次元を統合し、より深いおよび/または広いネットワークを使用する余地があります。すべてこれらは、より多くのメモリとFLOPsを持つGPUを必要とします。したがって、計算リソースのおかげで将来の気象予測はより良くなります。…

「ODSC APAC 2023での最初のトレーニングセッションの開催をお知らせします」

データサイエンスとAIの進展は、稲妻のような速さで進んでいます最新情報に遅れることなく、ODSC APAC(8月22日〜23日)では、データサイエンスの基礎から最新のツールやフレームワークまで、専門家によるトレーニングセッションが開催されます以下にいくつかのセッションをご紹介しますフルスタック機械学習...

「GPT-4の能力と限界を探索する」

「GPT-4の公開:データサイエンスへの影響を解読し、その強みと限界を探る」

テキストデータのチャンキング方法-比較分析

自然言語処理(NLP)における「テキストチャンキング」プロセスは、非構造化テキストデータを意味のある単位に変換することを意味しますこの見かけ上シンプルなタスクには、複雑さが隠されています

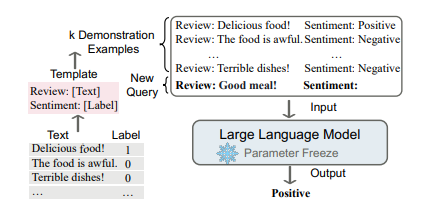

大規模な言語モデルにおけるコンテキストに基づく学習アプローチ

言語モデリング(LM)は、単語のシーケンスの生成的な尤度をモデル化することを目指し、将来の(または欠損している)トークンの確率を予測します言語モデルは自然言語処理の世界を革新しました...

2023年にAmazonのデータサイエンティストになる方法は?

ほとんどのビジネスは現在、膨大な量のデータを生成し、編集し、管理しています。しかし、ほとんどのビジネスは、収集したデータのすべてを十分に活用する知識を持っていません。このようなシナリオでデータサイエンティストが活躍します。データサイエンティストは、分析的なデータの専門家である新興の分野であり、ビジネスにおいてますます重要な役割を果たしています。Amazonは、魅力的な給与と興味深いキャリアの展望を持つため、データサイエンティストがキャリアを追求するための最高の企業の1つとして認識されています。 Amazonにおけるデータサイエンティストの役割は何ですか? Amazonのデータサイエンティストの役割と責任は以下の通りです: Amazonのデータサイエンティストの仕事は、ビジネスと技術の専門知識をバランスさせることです。 Amazonのデータサイエンティストの目標は、最も実現可能な目標を満たす効率的に動作するビジネスモデルを開発・向上させる技術の開発です。 Amazonでは、協力的なデータサイエンティストを雇っています。各チームは異なるプロジェクトを完了します。あなたのスキルや専門知識に関係なく、あなたが選んだことにおいて独り立ちしているわけではないことを常に認識する必要があります。 データサイエンティストは、統計的および分析的な手法とAIツールを使用して、組織の一部の機能を自動化し、ビジネスに関連する課題に対する賢明な解決策を提供します。データを分析した後、彼らは結果をわかりやすく興味深く提示します。 彼らはアルゴリズムを作成して、Alexaが個々の要求やコマンドを理解するためのトレーニングを行い、AIを使用してAmazon Web ServicesのユーザーがカスタマイズされたMLモデルを作成するのに役立ちます。 Amazonデータサイエンティストになるために必要なスキル Amazonのデータサイエンティストになるために必要な主要なスキルは以下の通りです: R、Stata、MATLAB、SQL、Python、C++、Javaなどの関数型プログラミング言語と統計分析パッケージ。 組織設定で大規模かつ複雑なデータセットを使用したデータマイニングおよびデータベースの専門知識。 分析業務におけるデータの抽出、データ分析、コミュニケーションの実践的な知識。 統計学、データ分析、ML、または関連する専攻でPh.D.を持っている候補者、または経済学、コンピュータエンジニアリング、物理学、数学、統計学、または他の関連分野の修士号、または同等の職務経験を持つ候補者が望ましいです。 関連スキルを習得する方法 Amazonのデータサイエンティストとして働きたい個人は、修士号やPh.D.の学位に加えて、いくつかの技術スキルにも精通する必要があります。インターネット上のさまざまなコースやプログラムは、特定の分野での専門知識を習得するのに役立ちますが、最適なコースを選ぶことは困難かもしれません。Analytics Vidyaの認定AIおよびML Blackbelt Plusプログラムは、Amazonのデータサイエンティストになるために必要な重要なスキルを習得するのに役立ちます。この素晴らしいプログラムの特徴は以下の通りです: 500時間以上の学習時間 50以上の実世界プロジェクト 最新のテクノロジーを使用した包括的なカリキュラム…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.