Learn more about Search Results ベクトルストア - Page 6

- You may be interested

- 欧州とイスラエルのAIファーストスタート...

- 「機械学習プロジェクトのための最高のGit...

- 🤗 Transformersを使用して、Wav2Vec2を使...

- Amazon SageMakerでTritonを使用してMLモ...

- 「トランスフォーマーを使用した音声から...

- ChatGPTが1歳になりました:バイラルなモ...

- 「このAI論文は、超人的な数学システムの...

- 中国の研究者たちは、データプライバシー...

- 画像からテキストを抽出するためのトップ5...

- 大規模言語モデルとは何ですか?

- MetaのAIが参照メロディに基づいて音楽を...

- 「SOCKS5プロキシ vs HTTPプロキシ どちら...

- 「中国の科学者が驚異的な新記録を樹立し...

- モンテカルロ法

- アーサーがベンチを発表:仕事に最適な言...

「The Research Agent 大規模なテキストコーパスに基づいた質問に答える課題への取り組み」

2021年に、大量のテキストコーパスに基づいて質問に答えるという課題に取り組み始めました事前学習済みトランスフォーマーの時代以前、この問題は解決が難しいものでしたそして、私の…

「Amazon LexとAmazon Kendra、そして大規模な言語モデルを搭載したAWSソリューションのQnABotを使用して、セルフサービス型の質問応答を展開してください」

「Amazon Lexによるパワーを利用したAWSのQnABotソリューションは、オープンソースのマルチチャネル、マルチ言語の会話型チャットボットですQnABotを使用すると、自己サービスの会話型AIを迅速にコンタクトセンター、ウェブサイト、ソーシャルメディアチャネルに展開することができ、コストを削減し、ホールド時間を短縮し、顧客体験とブランドの評価を向上させることができますこの記事では、QnABotの新しい生成型AI機能を紹介し、これらの機能を使用するためのチュートリアルを作成、展開、カスタマイズする方法について説明しますまた、関連するユースケースについても議論します」

「OceanBaseを使用して、ゼロからLangchainの代替を作成する」

「オーシャンベースとAIの統合からモデルのトレーニングやチャットボットの作成まで、興味深い旅を通じてこのトピックを探求します」

LangChainとPinecone Vector Databaseを使用したカスタムQ&Aアプリケーションの構築

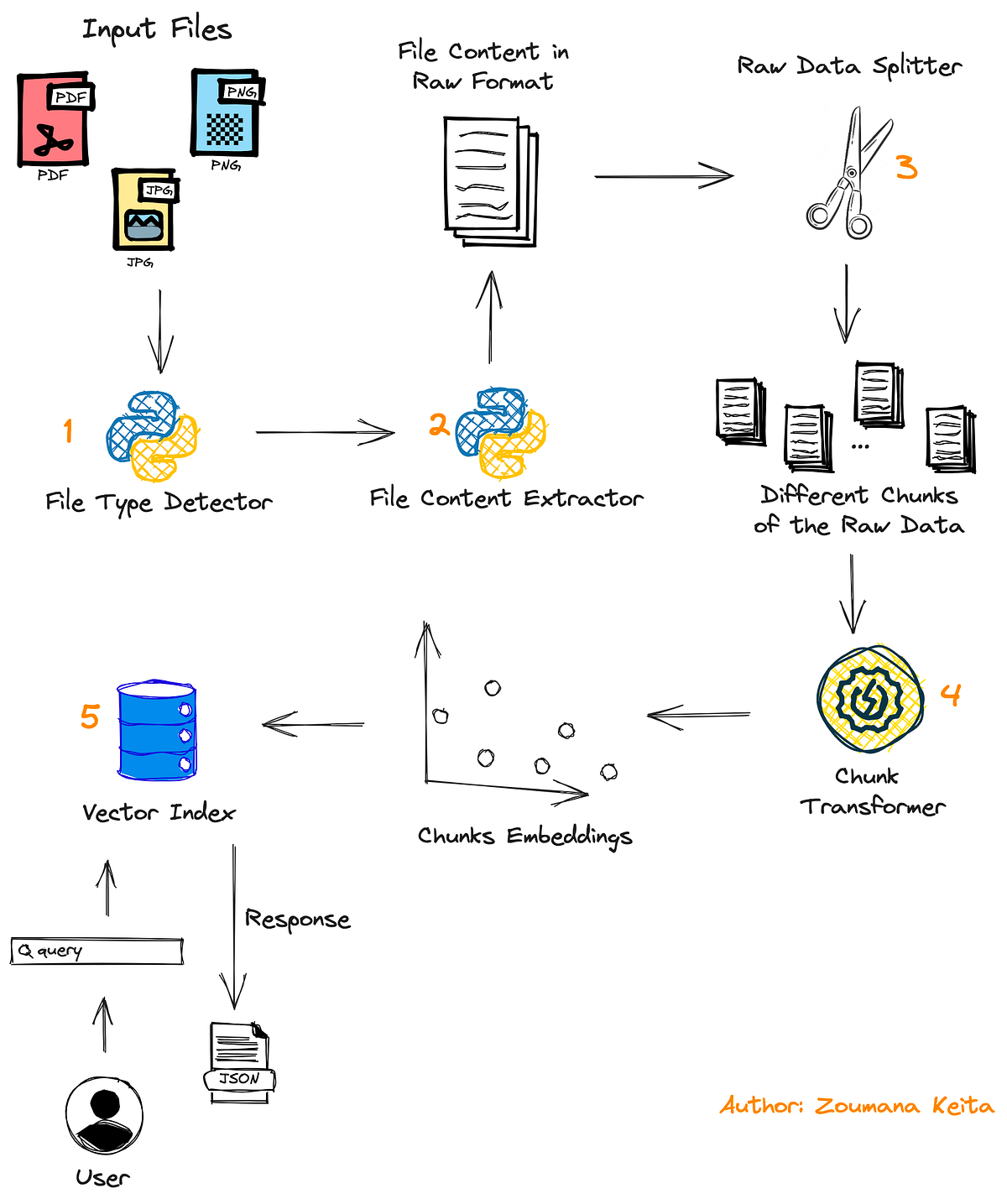

イントロダクション 大規模な言語モデルの登場は、現代における最もエキサイティングな技術の進展の一つです。これにより、人工知能の分野でさまざまな産業において実際の問題に対する解決策を提供する無限の可能性が開かれました。これらのモデルの魅力的な応用の一つは、個人や組織のデータソースから取得した情報をもとに、カスタムの質疑応答やチャットボットを開発することです。しかし、一般的なデータで訓練された大規模言語モデルは、常にエンドユーザーにとって特定の回答または有用な回答を提供するわけではありません。この問題を解決するために、LangChainなどのフレームワークを使用して、データに基づいた特定の回答を提供するカスタムチャットボットを開発することができます。この記事では、Streamlit Cloudでの展開を伴うカスタムQ&Aアプリケーションの構築方法について学びます。 学習目標 この記事に深く入る前に、主な学習目標を以下に概説しましょう: カスタムの質疑応答のワークフロー全体を学び、各コンポーネントの役割を理解する Q&Aアプリケーションの利点を知り、カスタムの言語モデルの微調整との比較を行う Pineconeベクトルデータベースの基礎を学び、ベクトルの保存と取得を行う OpenAIの言語モデル、LangChain、およびPineconeベクトルデータベースを使用してセマンティックサーチパイプラインを構築し、Streamlitアプリケーションを開発する この記事はData Science Blogathonの一部として公開されました。 Q&Aアプリケーションの概要 出典:ScienceSoft 質疑応答または「データに基づくチャット」は、LLMsとLangChainの広範なユースケースです。LangChainは、ユースケースに対して見つけることができるすべてのデータソースをロードするための一連のコンポーネントを提供しています。LangChainは多くのデータソースとトランスフォーマーをサポートし、ベクトルデータベースに保存するために文字列のシリーズに変換します。データがデータベースに保存されたら、リトリーバーと呼ばれるコンポーネントを使用してデータベースにクエリを送信することができます。さらに、LLMsを使用することで、ドキュメントを大量に参照することなく、チャットボットのような正確な回答を得ることができます。 LangChainは以下のデータソースをサポートしています。画像で確認できるように、様々なデータソースに接続するための120以上の統合が可能です。 出典:LangChain Docs Q&Aアプリケーションのワークフロー LangChainがサポートするデータソースについて学びました。これにより、LangChainで利用可能なコンポーネントを使用して、質疑応答パイプラインを開発することができます。以下に、ドキュメントのロード、保存、リトリーバル、LLMによる出力生成に使用されるコンポーネントを示します。 ドキュメントローダー:ユーザードキュメントをベクトル化および保存するためにロードするためのコンポーネント テキストスプリッター:これらは、ドキュメントを固定のチャンク長に変換して効率的に保存するドキュメントトランスフォーマーです ベクトル保存:入力テキストのベクトル埋め込みを保存するためのベクトルデータベースの統合 ドキュメントリトリーバル:データベースからユーザークエリに基づいてテキストを取得するためのコンポーネント。類似性検索技術を使用して取得します…

LangChain + Streamlit + Llama ローカルマシンに会話型AIをもたらす

「オープンソースのLLMsとLangChainを統合して、無料の生成型質問応答を実現します(APIキーは必要ありません)」

LangChain チートシート

LangChainは、大規模な言語モデルを使用したAIアシスタントの構築を簡素化し、直感的なAPI、メモリ機能、外部ツールへのアクセス、LLMアクションのチェーン化機能、およびプロンプトテンプレートを提供します最新のチートシートをチェックして、すぐに始めましょう

「Amazon SageMaker 上での LLM を使用した多言語対応の知識型ビデオおよび音声の質疑応答システム」

「デジタルアセットは、ますますデジタル化される世界において、ビジネスにとって製品やサービス、文化、ブランドアイデンティティの重要な視覚的表現ですデジタルアセットは、記録されたユーザーの行動とともに、インタラクティブでパーソナライズされた体験を提供することにより、顧客エンゲージメントを促進し、企業がターゲットオーディエンスとより深い関係を築くことができます特定のデジタルアセットを効率的に見つけたり検索したりすることは、[…]」

「コードを使用して、大規模な言語モデルを使って、どんなPDFや画像ファイルでもチャットする方法」

「PDFや画像ファイルには非常に価値のある情報が閉じ込められています幸いにも、私たちにはこれらのファイルを処理して特定の情報を見つけることができる強力な脳があります実際、それは素晴らしいことですそれが…」

「GPTCacheとは:LLMクエリセマンティックキャッシュの開発に役立つライブラリを紹介します」

ChatGPTと大規模言語モデル(LLM)は非常に柔軟性があり、多くのプログラムの作成が可能です。ただし、LLM APIの呼び出しに関連するコストは、アプリケーションが人気を集め、トラフィック量が増加するときに重要になる可能性があります。多くのクエリを処理する場合、LLMサービスには長い待ち時間が生じることもあります。 この困難に立ち向かうために、研究者はGPTCacheというプロジェクトを開発しました。GPTCacheは、LLMの回答を格納するためのセマンティックキャッシュを作成することを目指しています。オープンソースのGPTCacheプログラムは、LLMの出力回答をキャッシュすることにより、LLMを高速化することができます。キャッシュにリクエストされた応答がすでに格納されている場合、それを取得する時間を大幅に短縮することができます。 GPTCacheは柔軟でシンプルであり、どのアプリケーションにも適しています。OpenAIのChatGPTなど、多くの言語学習機械(LLM)と互換性があります。 どのように動作するのか? GPTCacheは、LLMの最終的な応答をキャッシュします。キャッシュは、最近使用された情報を迅速に取得するために使用されるメモリバッファです。新しいリクエストがLLMに送信されるたびに、GPTCacheはまずキャッシュを調べて要求された応答が既にそこに格納されているかどうかを判断します。キャッシュ内で応答が見つかった場合、すぐに返されます。そうでない場合は、LLMが応答を生成してキャッシュに追加します。 GPTCacheのモジュラーアーキテクチャにより、カスタムのセマンティックキャッシュソリューションを簡単に実装することができます。ユーザーはさまざまな設定を選択することで、各モジュールとの経験をカスタマイズすることができます。 LLMアダプターは、さまざまなLLMモデルで使用されるAPIとリクエストプロトコルを統一し、それらをOpenAI APIで標準化します。LLMアダプターは、コードの書き直しや新しいAPIの理解を必要とせずにLLMモデル間を移動できるため、テストと実験を簡素化します。 埋め込み生成器は、要求されたモデルを使用して埋め込みを作成し、類似性検索を実行します。サポートされているモデルでは、OpenAIの埋め込みAPIを使用できます。これには、GPTCache/paraphrase-albert-onnxモデルを使用するONNX、Hugging Face埋め込みAPI、Cohere埋め込みAPI、fastText埋め込みAPI、SentenceTransformers埋め込みAPIが含まれます。 キャッシュストレージでは、ChatGPTなどのLLMからの応答が取得できるまで保持されます。2つのエンティティが意味的に類似しているかどうかを判断する際には、キャッシュされた応答が取得され、要求されたパーティーに送信されます。GPTCacheはさまざまなデータベース管理システムと互換性があります。ユーザーは、パフォーマンス、拡張性、および最も一般的にサポートされているデータベースのコストに関する要件を最も満たすデータベースを選択することができます。 ベクトルストアの選択肢:GPTCacheには、オリジナルのリクエストから派生した埋め込みを使用して、K個の最も類似したリクエストを特定するベクトルストアモジュールが含まれています。この機能を使用すると、2つのリクエストがどれだけ類似しているかを判断することができます。さらに、GPTCacheはMilvus、Zilliz Cloud、FAISSなどの複数のベクトルストアをサポートし、それらとの作業に対して簡単なインターフェースを提供します。ユーザーは、さまざまなベクトルストアオプションを選択できます。これらのオプションのいずれかが、GPTCacheの類似性検索のパフォーマンスに影響を与える可能性があります。さまざまなベクトルストアをサポートすることで、GPTCacheは適応性があり、さまざまなユースケースとユーザーの要件を満たすことができます。 GPTCacheキャッシュマネージャーは、キャッシュストレージとベクトルストアコンポーネントのエビクションポリシーを管理します。キャッシュが一杯になったときに新しいデータのためのスペースを作るために、置換ポリシーが古いデータを削除するかどうかを決定します。 類似性評価器の情報は、GPTCacheのキャッシュストレージとベクトルストアのセクションから取得されます。入力リクエストをベクトルストア内のリクエストと比較することで、類似度を測定します。リクエストがキャッシュから提供されるかどうかは、類似度の程度に依存します。GPTCacheは類似性アルゴリズムを使用してキャッシュの一致を判断する能力を持つため、さまざまなユースケースとユーザーの要件に適応することができます。 特徴と利点 GPTCacheによるLLMクエリの待ち時間の短縮により、応答性と速度が向上します。 トークンベースおよびリクエストベースの価格体系により、LLMサービスに共通のコスト削減が可能です。GPTCacheはAPIの呼び出し回数を制限することで、サービスのコストを削減することができます。 GPTCacheはLLMサービスからの作業をオフロードする能力を持つため、スケーラビリティが向上します。リクエスト数が増えるにつれて、ピークの効率で運営を続けるのに役立ちます。 GPTCacheの助けを借りて、LLMアプリケーションの作成に関連するコストを最小限に抑えることができます。LLMで生成されたデータをキャッシュしたり、模擬したりすることで、LLMサービスにAPIリクエストを行わずにアプリをテストすることができます。 GPTCacheは、選択したアプリケーション、LLM(ChatGPT)、キャッシュストア(SQLite、PostgreSQL、MySQL、MariaDB、SQL Server、またはOracle)、およびベクトルストア(FAISS、Milvus、Ziliz Cloud)と連携して使用することができます。GPTCacheプロジェクトの目標は、毎回ゼロから始めるのではなく、できる限り以前に生成された返信を再利用することによって、GPTベースのアプリケーションで言語モデルを最も効率的に活用することです。

ChatGPTにおけるCSVファイルのクエリパフォーマンス向上

洗練された言語モデル(例:ChatGPT)の出現により、表形式のデータへのクエリの新しい有望なアプローチがもたらされましたしかし、トークンの制限により、クエリを直接実行することができません...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.