Learn more about Search Results もっと詳しく - Page 6

- You may be interested

- 「LLMsを活用してリコメンデーション知識...

- 「10 Best AIウェブサイトビルダー」

- ChatGPTを使ってコーディングする方法R...

- 「時代遅れのパスワードの慣行が広まって...

- 無料のAI製品写真ツール

- 「ベクターデータベースを使用してLLMアプ...

- Diffusersを使用したDreamboothによる安定...

- 「VirtuSwapがAmazon SageMaker Studioの...

- 「大規模言語モデルの微調整に関する包括...

- 「知っておくべき2つの興味深いPandasデー...

- 今年学ぶ価値のある最高報酬の言語5選

- インドのTableau開発者の給与はいくらです...

- 「インタリーブされた視覚と言語の生成に...

- グーグルとコーネル大学の研究者がDynIBaR...

- 「バイオメトリクスをサイバーセキュリテ...

「月に10000ドルを稼ぐために私が使用するAIツールとスキル—デタラメなことはありません」

そして、AIを活用して収益を最大化する方法を見つけてください

スペースインベーダーとの深層Q学習

ハギングフェイスとのディープ強化学習クラスのユニット3 ⚠️ この記事の新しい更新版はこちらから利用できます 👉 https://huggingface.co/deep-rl-course/unit1/introduction この記事はディープ強化学習クラスの一部です。初心者からエキスパートまでの無料コースです。シラバスはこちらをご覧ください。 ⚠️ この記事の新しい更新版はこちらから利用できます 👉 https://huggingface.co/deep-rl-course/unit1/introduction この記事はディープ強化学習クラスの一部です。初心者からエキスパートまでの無料コースです。シラバスはこちらをご覧ください。 前のユニットでは、最初の強化学習アルゴリズムであるQ-Learningを学び、それをゼロから実装し、FrozenLake-v1 ☃️とTaxi-v3 🚕の2つの環境でトレーニングしました。 このシンプルなアルゴリズムで優れた結果を得ました。ただし、これらの環境は比較的単純であり、状態空間が離散的で小さかったため(FrozenLake-v1では14の異なる状態、Taxi-v3では500の状態)。 しかし、大きな状態空間の環境では、Qテーブルの作成と更新が効率的でなくなる可能性があることを後で見ていきます。 今日は、最初のディープ強化学習エージェントであるDeep Q-Learningを学びます。Qテーブルの代わりに、Deep Q-Learningは、状態を受け取り、その状態に基づいて各アクションのQ値を近似するニューラルネットワークを使用します。 そして、RL-Zooを使用して、Space Invadersやその他のAtari環境をプレイするためにトレーニングします。RL-Zooは、トレーニング、エージェントの評価、ハイパーパラメータの調整、結果のプロット、ビデオの記録など、RLのためのトレーニングフレームワークであるStable-Baselinesを使用しています。 では、始めましょう! 🚀 このユニットを理解するためには、まずQ-Learningを理解する必要があります。…

Hugging FaceのTensorFlowの哲学

はじめに PyTorchやJAXからの競争が増えても、TensorFlowは最も使用されるディープラーニングフレームワークのままです。また、それらの他の2つのライブラリとはいくつか非常に重要な点で異なります。特に、高レベルのAPIであるKerasと、データの読み込みライブラリであるtf.dataとの統合が非常に密接です。 PyTorchのエンジニアの中には(ここでオープンプランオフィスを暗く見つめながら私を想像してください)、これを克服すべき問題だと見なす傾向があります。彼らの目標は、TensorFlowが彼らのやり方に従って低レベルのトレーニングとデータの読み込みコードを使用できるようにする方法を見つけることです。これはTensorFlowに取り組む間違った方法です! Kerasは素晴らしい高レベルのAPIです。プロジェクトが数モジュールよりも大きい場合、それを押しのけると、必要になると気付いたときに、その機能のほとんどを自分で再現することになります。 洗練された、尊敬され、非常に魅力的なTensorFlowエンジニアとして、私たちは最先端のモデルの驚異的なパワーと柔軟性を使用したいと思っていますが、私たちが使い慣れたツールとAPIでそれらを扱いたいのです。このブログポストでは、Hugging Faceでそれを実現するために行う選択と、TensorFlowプログラマーとしてフレームワークから期待できることについて説明します。 インタールード:30秒で🤗 経験豊富なユーザーは、このセクションをざっと読んだりスキップしたりして構いませんが、Hugging Faceとtransformersに初めて出会う方には、ライブラリのコアアイデアについて概要を説明する必要があります。モデルを事前学習済みモデルとして名前でリクエストするだけで、1行のコードで取得できます。最も簡単な方法は、TFAutoModelクラスを使用するだけです。 from transformers import TFAutoModel model = TFAutoModel.from_pretrained("bert-base-cased") この1行でモデルのアーキテクチャがインスタンス化され、重みが読み込まれます。これにより、元の有名なBERTモデルの正確なレプリカが得られます。ただし、このモデル自体ではあまり役に立ちません – 出力ヘッドや損失関数がありません。実際には、これは最後の隠れ層の直後で終了するニューラルネットワークの「ステム」です。では、どのようにして出力ヘッドを追加するのでしょうか?簡単です、異なるAutoModelクラスを使用するだけです。ここでは、Vision Transformer(ViT)モデルを読み込み、画像分類ヘッドを追加しています。 from transformers import TFAutoModelForImageClassification…

🤗 Optimum IntelとOpenVINOでモデルを高速化しましょう

昨年7月、インテルとHugging Faceは、Transformerモデルのための最新かつシンプルなハードウェアアクセラレーションツールの開発で協力することを発表しました。本日、私たちはOptimum IntelにIntel OpenVINOを追加したことをお知らせできて非常に嬉しく思います。これにより、Hugging FaceハブまたはローカルにホストされるTransformerモデルを使用して、様々なIntelプロセッサ上でOpenVINOランタイムによる推論を簡単に実行できます(サポートされているデバイスの完全なリストを参照)。OpenVINOニューラルネットワーク圧縮フレームワーク(NNCF)を使用してモデルを量子化し、サイズと予測レイテンシをわずか数分で削減することもできます。 この最初のリリースはOpenVINO 2022.2をベースにしており、私たちのOVModelsを使用して、多くのPyTorchモデルに対する推論を実現しています。事後トレーニング静的量子化と量子化感知トレーニングは、多くのエンコーダモデル(BERT、DistilBERTなど)に適用することができます。今後のOpenVINOリリースでさらに多くのエンコーダモデルがサポートされる予定です。現在、エンコーダデコーダモデルの量子化は有効化されていませんが、次のOpenVINOリリースの統合により、この制限は解除されるはずです。 では、数分で始める方法をご紹介します! Optimum IntelとOpenVINOを使用してVision Transformerを量子化する この例では、食品101データセットでイメージ分類のためにファインチューニングされたVision Transformer(ViT)モデルに対して事後トレーニング静的量子化を実行します。 量子化は、モデルパラメータのビット幅を減らすことによってメモリと計算要件を低下させるプロセスです。ビット数を減らすことで、推論時に必要なメモリが少なくなり、行列乗算などの演算が整数演算によって高速に実行できるようになります。 まず、仮想環境を作成し、すべての依存関係をインストールしましょう。 virtualenv openvino source openvino/bin/activate pip install pip --upgrade pip…

ゲーム開発のためのAI:5日間で農業ゲームを作成するパート2

ゲーム開発のためのAIへようこそ!このシリーズでは、AIツールを使用してわずか5日間で完全な機能を備えた農業ゲームを作成します。このシリーズの終わりまでに、ゲーム開発のワークフローにさまざまなAIツールを組み込む方法を学ぶことができます。以下に挙げる項目について、どのようにAIツールを使用できるかを紹介します。 アートスタイル ゲームデザイン 3Dアセット 2Dアセット ストーリー クイックビデオバージョンがほしいですか? こちらでご覧いただけます。それ以外の場合は、技術的な詳細を読み続けてください! 注意:このチュートリアルは、Unity開発とC#に精通している読者を対象としています。これらの技術に慣れていない場合は、続ける前に「Unity for Beginners」シリーズをチェックしてください。 2日目:ゲームデザイン このチュートリアルシリーズのパート1では、AI for Art Styleを使用しました。具体的には、Stable Diffusionを使用してコンセプトアートを生成し、ゲームのビジュアルスタイルを開発しました。 このパートでは、ゲームデザインのためのAIを使用します。The Short Versionでは、ChatGPTをゲームアイデアの開発ツールとして使用した方法について説明します。しかし、もっと重要なのは、ここで実際に何が起こっているのかです。ゲーム開発における言語モデルとその広範な使用法についての背景については、読み続けてください。 The Short Version 簡単なバージョンはシンプルです。ChatGPTにアドバイスを求め、自己責任でそのアドバイスに従ってください。農業ゲームの場合、私はChatGPTに次のように尋ねました。…

ビジネス戦略において機械学習を使用する時と使用しない時の選択

それは明らかな質問ではありません初心者のデータサイエンティストにとっては、すぐに機械学習モデルを推進することは間違いです実際には、よりシンプルなルールベースのソリューションの方が効率的で実装が容易です...

モーターコントロールから具現化された知能へ

人間や動物の動きを用いて、ロボットにボールをドリブルさせることや、シミュレートされた人型キャラクターに箱を運ばせたりサッカーをさせることを教える 試行錯誤を通じて障害物コースを進む方法を学ぶ人型キャラクター。これにより独特な解決策が生まれることがあります。 Heessら「Emergence of locomotion behaviours in rich environments」(2017)より。 5年前、完全に関節の動く人型キャラクターに障害物コースを進む方法を教えるという課題に取り組みました。これは強化学習(RL)が試行錯誤を通じて何ができるかを示しましたが、具体的な知識がない状態から各関節にどのような力を加えるべきかを知るためには、多くのデータが必要でした。エージェントはランダムな体の震えから始まり、すぐに地面に倒れてしまいました。この問題は、以前に学んだ動きを再利用することで緩和することができます。 以前に学んだ動きの再利用:エージェントが「立ち上がる」ためには大量のデータが必要でした。初めはどの関節にどのような力を加えるべきかを知らなかったため、エージェントはランダムな体の震えから始まり、すぐに地面に倒れてしまいました。この問題は、以前に学んだ動きを再利用することで緩和することができます。 独特な動き:エージェントがついに障害物コースを進む方法を学んだとしても、不自然な(しかし面白い)動きパターンで進むことになります。これは、ロボットなどの実際の応用には非現実的である可能性があります。 ここでは、これらの課題に対する解決策であるニューラル確率モーター原理(NPMP)と呼ばれる手法を説明し、人型フットボールの論文でどのようにこの手法が使用されているかについても議論します。この論文は、本日Science Roboticsで公開されました。 また、この手法は、ビジョンからの人型の全身操作(例:物体を運ぶ人型)や現実世界でのロボット制御(例:ボールをドリブルするロボット)も可能にすることについても議論します。 NPMPを使用してデータを制御可能なモータープリミティブに絞り込む NPMPは、短期間のモーター意図を低レベルの制御信号に変換する汎用のモーター制御モジュールであり、オフラインまたはRLを介して動作キャプチャ(MoCap)データを模倣することで訓練されます。このMoCapデータは、興味のある動作を行う人間や動物にトラッカーを装着して記録されます。 MoCap軌跡(グレーで表示)を模倣するエージェント このモデルには2つの部分があります: 将来の軌跡を受け取り、モーター意図に圧縮するエンコーダー。 エージェントの現在の状態とこのモーター意図に基づいて次のアクションを生成する低レベルコントローラー。 NPMPモデルはまず参照データを低レベルコントローラーに絞り込みます(左)。この低レベルコントローラーは、新しいタスクにプラグアンドプレイのモーター制御モジュールとして使用できます(右) トレーニング後、低レベルコントローラは新しいタスクを学習するために再利用できます。一方、高レベルコントローラはモーターの意図を直接最適化することができます。これにより、効率的な探索が可能になります。ランダムにサンプリングされたモーターの意図でも、連続した行動が生成されるため、最終的な解決策が制約されます。 ヒューマノイドフットボールにおける発生的なチーム協調…

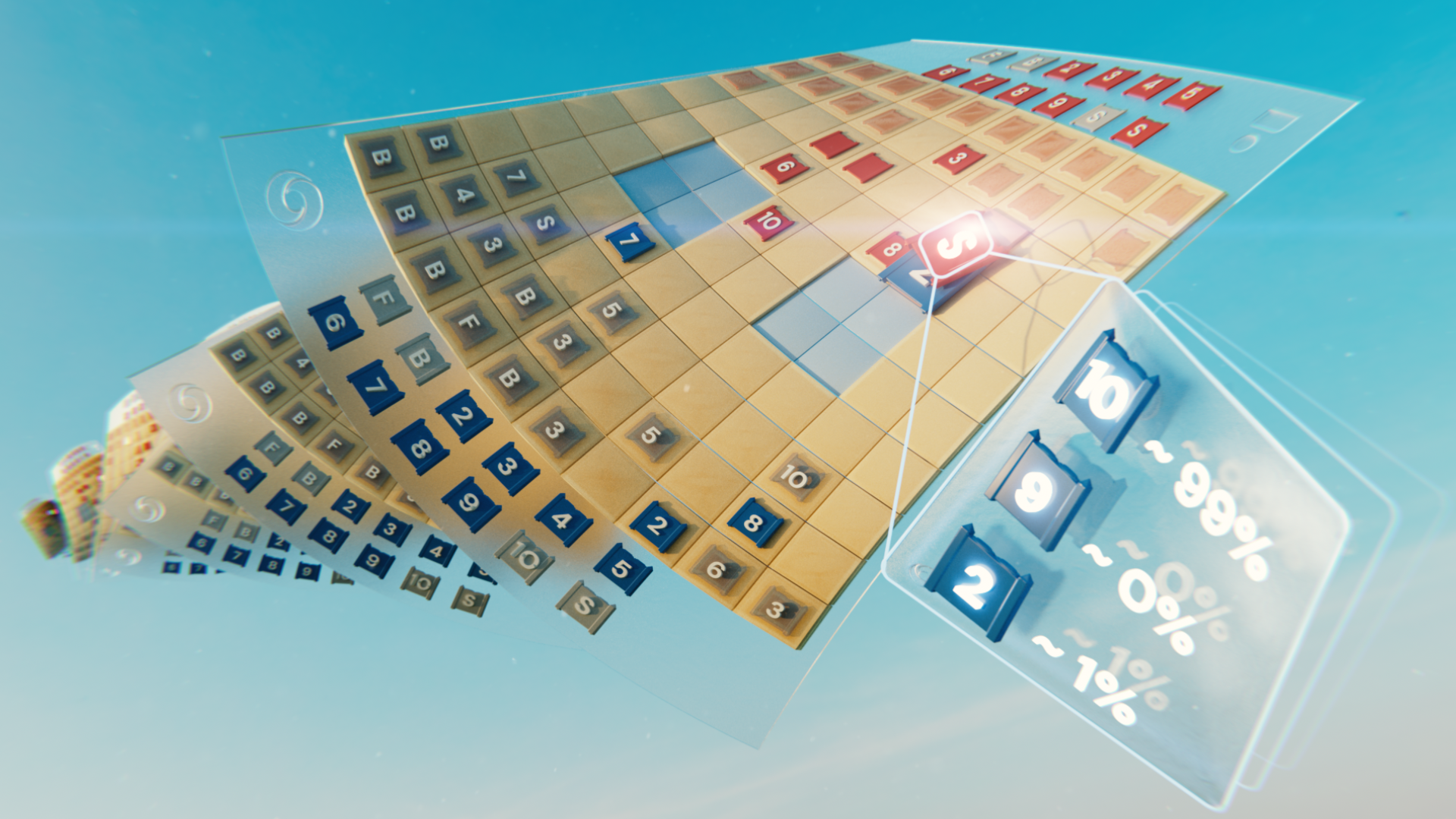

ストラテゴをマスターする:情報の不完全なクラシックゲーム

ゲームをプレイする人工知能(AI)システムは新たなフロンティアに進化しましたチェスや囲碁よりも複雑で、ポーカーよりも巧妙なクラシックなボードゲームであるストラテジョを、AIエージェントであるDeepNashが自己対戦を通じて人間のエキスパートレベルまで学習し、Science誌に発表されました

ウェブと組み込みシステムにおけるRustの実行のための9つのルール

ユーザーの要求に応じて、私は最近、range-set-blazeというクレートをWebページ内で動作するように変換しましたまた、マイクロコントローラー(組み込み)でも動作するようにしました(range-set-blazeクレートは効率的に操作を行います...

AI、デジタルツインが次世代の気候研究イノベーションを解き放つ

AIと高速計算は、気候研究者が気候研究のブレークスルーを達成するために必要な奇跡を実現するのに役立つだろう、とNVIDIAの創設者兼CEOであるJensen Huangは、ベルリンサミットの基調講演で述べました。このイベントはEarth Virtualization Enginesイニシアチブの一環です。 「リチャード・ファインマンはかつて『自分が作れないものは理解していない』と言いましたが、それが気候モデリングが非常に重要な理由です」とHuangは、ベルリンのハルナックハウスで開催されたこのイベントの参加者180人に語りました。ハルナックハウスは、地域の科学者や研究者のコミュニティの集まり場として知られています。 「そして、あなたが行っている仕事は、政策立案者や研究者、産業界にとって非常に重要です」と彼は付け加えました。 この仕事を進めるために、ベルリンサミットは世界中の参加者を集め、気候予測のためにAIと高性能コンピューティングを活用します。 Huangは、気候研究者が目標を達成するために必要な3つの奇跡と、NVIDIAが気候研究者や政策立案者と協力するためのEarth-2の取り組みについて話しました。 最初に必要な奇跡は、気候を十分な解像度で、例えば数平方キロメートルのオーダーで、十分に高速にシミュレーションすることです。 2番目に必要な奇跡は、膨大な量のデータを事前に計算する能力です。 3番目は、NVIDIA Omniverseを使用してこのデータを対話的に可視化し、「政策立案者、企業、研究者の手に提供する」能力です。 気候と気象のイノベーションの次の波 Earth Virtualization Enginesイニシアチブ(EVE)は、気候科学、HPC、AIに焦点を当てた国際的な共同研究であり、初めて持続可能な地球管理のためにキロメートルスケールの気候情報を簡単に利用できるようにすることを目指しています。 「Earth-2とEVEが完璧なタイミングで出会った理由は、Earth-2が3つの基本的なブレークスルーに基づいていたからです」とHuangは述べました。 このイニシアチブは、2.5kmの解像度で調整された気候予測を提唱し、進歩のペースを加速することを約束しています。これは非常に困難な課題ですが、過去25年間のさまざまな進歩を基盤にしています。 ICON、IFS、NEMO、MPAS、WRF-Gなど、さまざまなアプリケーションがすでに高速計算を活用しており、このようなアプリケーション向けのさらなる計算能力が提供されています。 NVIDIA GH200 Grace Hopper Superchipは、巨大なAIとHPCアプリケーション向けに特別に設計された画期的な加速CPUです。これにより、テラバイトのデータを処理するアプリケーションのパフォーマンスが最大10倍向上します。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.