Learn more about Search Results A - Page 651

- You may be interested

- 「メーカーに会う:開発者がAI搭載ピット...

- 「バイデン大統領の画期的なAI行政命令を...

- 「コンテンツ戦略を開発するための最高のC...

- AIにおける幻覚の克服:事実に基づく強化...

- 「あなた自身のODSCウエストスケジュール...

- コンセプト2ボックスに出会ってください:...

- 現代のNLP:詳細な概要パート2:GPT

- 「ハンズオンディープQ学習」

- 中国の研究者が、ビデオ・LLaVAを紹介しま...

- 「ElaiのCEO&共同創業者、Vitalii Romanc...

- 物体検出のためのIntersection Over Union...

- 「AIコントロールを手にして、サイバーセ...

- 「チャットGPTとBardの無料版の実用的な比...

- テキストの生成方法:トランスフォーマー...

- 「自分自身の生成モデルを選択して実行す...

「vLLMに会ってください:高速LLM推論とサービスのためのオープンソース機械学習ライブラリ」

大規模な言語モデル(LLM)は、プログラミングアシスタントやユニバーサルチャットボットなどの新しいアプリケーションを可能にするため、日常生活やキャリアにますます大きな影響を与えています。しかし、これらのアプリケーションの動作は、GPUなどの重要なハードウェアアクセラレータの要件による重要なコストがかかります。最近の研究によると、LLMのリクエストの処理は、従来のキーワード検索と比較して、10倍以上高価になることが示されています。そのため、LLMのサービングシステムのスループットを向上させ、リクエストごとの費用を最小限に抑える必要性が高まっています。 大規模な言語モデル(LLM)の高スループットなサービスを実行するには、一度に十分な数のリクエストをバッチ処理する必要があります。ただし、既存のシステムは支援が必要です。各リクエストのキーバリューキャッシュ(KVキャッシュ)メモリは非常に大きく、動的に成長および縮小する可能性があります。このメモリは慎重に管理する必要があります。効率的に管理されていない場合、断片化や冗長な重複により、このRAMを大幅に節約し、バッチサイズを減らすことができます。 研究者たちは、この問題の解決策として、オペレーティングシステムの伝統的な仮想メモリとページング技術に着想を得たアテンションアルゴリズム「PagedAttention」を提案しています。メモリの利用をさらに削減するために、研究者たちはvLLMも展開しています。このLLMサービスは、ほぼゼロのKVキャッシュメモリの無駄を生じず、リクエスト内およびリクエスト間でのKVキャッシュの柔軟な共有を提供します。 vLLMは、PagedAttentionを使用してアテンションキーとバリューを管理します。モデルアーキテクチャの変更を必要とせずに、HuggingFace Transformersよりも最大24倍のスループットを提供するvLLMは、LLMサービスの現在の最先端を再定義します。 従来のアテンションアルゴリズムとは異なり、PagedAttentionでは、連続したメモリ空間にキーと値を格納することができます。PagedAttentionは、各シーケンスのKVキャッシュをブロックに分割し、予め定められたトークンの数に対応するキーと値を含んでいます。これらのブロックは、アテンション計算中にPagedAttentionカーネルによって効率的に識別されます。ブロックは必ずしも連続する必要がないため、キーと値を柔軟に管理することができます。 PagedAttention内のシーケンスの最後のブロックのみでメモリリークが発生します。実際の使用では、これにより効果的なメモリ利用が可能となり、わずか4%の非効率性しか生じません。このメモリ効率の向上により、GPUの利用率を高めることができます。 また、PagedAttentionには効率的なメモリ共有のもう一つの利点があります。PagedAttentionのメモリ共有機能は、並列サンプリングやビームサーチなどのサンプリング技術に必要な追加メモリを大幅に削減します。これにより、メモリ利用率を最大55%削減しながら、スピードを最大2.2倍向上させることができます。この改善により、これらのサンプル技術は大規模言語モデル(LLM)サービスにおいて有用で効果的なものとなります。 研究者たちは、このシステムの精度を研究しました。彼らは、FasterTransformerやOrcaなどの最先端のシステムと同じ遅延時間で、vLLMが有名なLLMのスループットを2〜4倍増加させることを発見しました。より大きなモデル、より複雑なデコーディングアルゴリズム、およびより長いシーケンスは、より顕著な改善をもたらします。

スタンフォード大学の研究者たちは、スペルバーストという大規模言語モデル(LLM)を搭載したクリエイティブコーディング環境を紹介しました

素晴らしいデジタルアートを作成する際、生成アーティストはしばしばコーディングの複雑さに直面することがあります。ProcessingやAIテキストから画像へのツールのような言語を使用して、彼らは想像力豊かなビジョンを複雑なコードの一部に変換し、魅力的な視覚的な構成を生み出します。しかし、このプロセスは反復的な試行錯誤の性質により、時間がかかり、挫折感を生むことがあります。伝統的なアーティストは鉛筆や筆で簡単に調整できますが、生成アーティストは不透明なインターフェースを通じて進む必要があり、創造的なブロックにつながることがあります。 既存のソリューションはこれらの課題を軽減しようとしますが、アーティストが必要とする制御レベルと柔軟性を提供することができないことが多いです。大規模な言語モデルは初期のコンセプトを生成するのに役立ちますが、テクスチャ、色、パターンなどの細かい制御を提供するのは難しいです。ここで、Stanford大学の学者が開発した画期的なツールであるSpellburstが登場します。 Spellburstは最先端のGPT-4言語モデルの力を活用し、芸術的なアイデアをコードに変換するプロセスを効率化します。アーティストは「美しい明るいバラのステンドグラス画像」といった初期のプロンプトを入力し、そのコンセプトを具現化するための対応するコードをモデルが生成します。しかし、Spellburstの特徴は初期の生成を超える能力にあります。アーティストが花の色合いを微調整したり、ステンドグラスの外観を調整したりする場合は、動的なスライダーを使用したり、「花を濃い赤にする」といった特定の修正ノートを追加したりすることができます。この制御レベルにより、アーティストは微妙な調整を行い、自分のビジョンが忠実に実現されることを保証することができます。 さらに、Spellburstはさまざまなバージョンを結合することを容易にし、アーティストが異なるイテレーションから要素を組み合わせることができます。例えば、「バージョン4の花の色をバージョン9の花瓶の形と組み合わせる」とツールに指示することができます。この機能により、異なる視覚的要素をシームレスに試してみることができ、新たな創造的な可能性が広がります。 Spellburstの主な強みの一つは、プロンプトベースの探索とコード編集の間を移動できる能力にあります。アーティストは生成された画像をクリックするだけで、基礎となるコードを表示し、微調整のための細かい制御を行うことができます。この意味空間とコードの結びつきにより、アーティストは創造物を反復的に洗練させるための強力なツールを手に入れることができます。 Stanford大学の研究チームはSpellburstのテストにおいて、10人の専門的なクリエイティブコーダーからフィードバックを求めました。アーティストたちは、このツールが意味空間からコードへの移行を迅速化するだけでなく、探求を促進し、より大きな創造的な飛躍を容易にすると報告しました。この新しい効率性は、生成アーティストが自分のクラフトに取り組む方法を革新し、革新的で魅力的なデジタルアートの急増をもたらす可能性があります。 Spellburstは非常に有望な存在ですが、その制限を認識することも重要です。一部のプロンプトは予期しない結果やエラーを引き起こす場合があり、特にバージョンの結合では問題が発生する可能性があります。また、ツールの効果は異なるアーティストによって異なる場合があり、小さなサンプルサイズから得られたフィードバックは、生成アーティストコミュニティ内の経験の全体像を捉えきれないかもしれません。 まとめると、Spellburstは生成アートの領域での大きな飛躍を表しています。芸術的なビジョンとコードの実行の間にシームレスなインターフェースを提供することで、アーティストは前例のない精度で創造性を発揮することができます。このツールは今年後半にオープンソースでリリースされる準備をしており、経験豊富なクリエイティブコーダーのワークフローを革新するだけでなく、コード駆動のアートの世界に足を踏み入れる初心者のための貴重な学習ツールとしても役立つ可能性があります。Spellburstがあれば、生成アートの未来はこれまで以上に明るく、より手軽になるでしょう。

「Würstchenをご紹介します:高速かつ効率的な拡散モデルで、テキスト条件付きコンポーネントは画像の高圧縮潜在空間で動作します」

テキストから画像を生成することは、テキストの説明から画像を作成する人工知能の難しい課題です。この問題は計算量が多く、訓練コストもかかります。高品質な画像の必要性は、これらの課題をさらに悪化させます。研究者たちは、この領域において計算効率と画像の忠実度のバランスを取ろうとしてきました。 テキストから画像を効率的に生成するために、研究者たちはWürstchenという革新的なソリューションを導入しました。このモデルは、ユニークな2段階の圧縮手法を採用することで、この分野で際立っています。ステージAではVQGANが使用され、ステージBではDiffusion Autoencoderが使用されます。これらの2つのステージをまとめてデコーダと呼びます。彼らの主な機能は、高度に圧縮された画像をピクセル空間にデコードすることです。 Würstchenの特筆すべき点は、その卓越した空間圧縮能力です。従来のモデルでは一般的に4倍から8倍の圧縮率を達成していましたが、Würstchenは驚異的な42倍の空間圧縮を実現しています。この画期的な成果は、16倍の空間圧縮後に詳細な画像を正確に再構築するのが難しい一般的な手法の制限を超える、その新しい設計の証明です。 Würstchenの成功は、2段階の圧縮プロセスに起因しています。ステージAのVQGANは、画像データを高度に圧縮された潜在空間に量子化する重要な役割を果たします。この初期の圧縮により、後続のステージに必要な計算リソースが大幅に削減されます。ステージBのDiffusion Autoencoderは、この圧縮された表現をさらに洗練し、驚くほどの忠実度で画像を再構築します。 これら2つのステージを組み合わせることで、テキストのプロンプトから効率的に画像を生成するモデルが実現されます。これにより、訓練の計算コストが削減され、推論がより高速に行えるようになります。重要なのは、Würstchenが画像の品質を犠牲にすることなく、さまざまなアプリケーションにとって魅力的な選択肢となっていることです。 さらに、WürstchenはステージCであるPriorも導入しており、高度に圧縮された潜在空間で訓練されています。これにより、Würstchenは新しい画像解像度に迅速に適応することができ、異なるシナリオに対する微調整の計算負荷を最小限に抑えることができます。この適応性により、さまざまな解像度の画像を扱う研究者や組織にとって、多目的なツールとなっています。 Würstchenの訓練コストの削減は、Würstchen v1が512×512の解像度で訓練された場合、同じ解像度でStable Diffusion 1.4に必要とされる150,000 GPU時間の一部である9,000 GPU時間だけで済んだという事実によって示されています。この大幅なコスト削減は、研究者の実験において恩恵をもたらし、このようなモデルのパワーを活用する組織にとってもよりアクセスしやすくなります。 まとめると、Würstchenはテキストから画像を生成するという長年の課題に対する画期的なソリューションを提供しています。革新的な2段階の圧縮手法と驚異的な空間圧縮率により、この領域の効率性の新基準が確立されました。訓練コストの削減とさまざまな画像解像度への迅速な適応性により、Würstchenはテキストから画像を生成する研究やアプリケーション開発を加速する価値あるツールとなっています。

現代のデータサイエンティストのための正規表現

データサイエンスとソフトウェアエンジニアリングにおいて、正規表現(またはRegEx)は必要不可欠なツールですこれらの複雑な文字パターンは、効率的にデータを抽出および操作するための鍵となります…

「データサイエンスのワークフローをマスターする」

「定義からコミュニケーションまで、成功するデータサイエンスのワークフローを6つのステージで自信を持って進めるためのガイドです!」

機械学習、イラストで解説:インクリメンタル学習

「Illustrated Machine Learningシリーズへようこそもしシリーズの他の記事を読んだことがあるなら、お分かりかと思いますが、私たちは(つまらないように思える)機械学習の概念を取り上げ、楽しくしていきます...」

ツリー構造パーゼン推定器(Hyperopt)を使ったハイパーパラメータのチューニングの向上

この記事では、機械学習におけるハイパーパラメータ調整のためのTree-Structured Parzen Estimator(TPE)の概念と、具体的な例を用いたその応用について探求します

「2023年に試してみる必要のある素晴らしい無料LLMプレイグラウンド5選」

「最新のAIモデルを直接体験することができる、ユーザーフレンドリーなトップ5プラットフォームを探索しましょうこれらのプラットフォームは、大規模な言語モデルへの無料アクセスを提供しています」

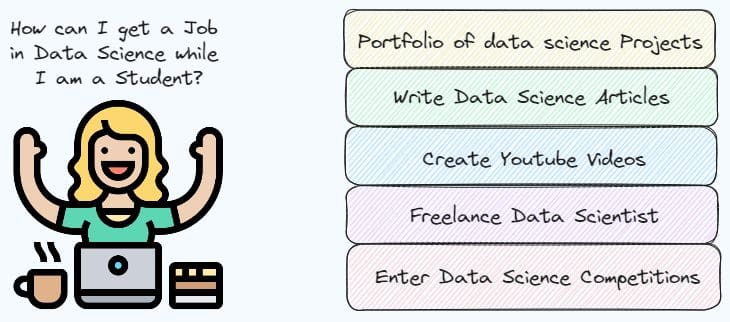

「学生としてデータサイエンスの仕事を得る方法」

「学生のうちに初めてのデータサイエンティストの仕事を得る可能性を高める方法を学びましょう」

「MITの研究者が、デバイス内の意味的セグメンテーションのための新しい軽量マルチスケールアテンションを紹介」

セマンティックセグメンテーションは、コンピュータビジョンの基本的な課題であり、入力画像の各ピクセルを特定のクラスに分類することを目的としています。自動運転、医療画像処理、計算写真など、セマンティックセグメンテーションが有用な現実世界のコンテキストは数多く存在します。そのため、SOTAセマンティックセグメンテーションモデルをエッジデバイスにインストールして、さまざまな消費者に利益をもたらすことへの需要が高まっています。しかし、SOTAセマンティックセグメンテーションモデルは、エッジデバイスが満たすことができない高い処理要件を持っています。これにより、これらのモデルはエッジデバイスで使用することができません。特にセマンティックセグメンテーションは、高解像度の画像と堅牢なコンテキスト情報の抽出能力を必要とする密な予測タスクの例です。そのため、画像分類で使用される効果的なモデルアーキテクチャをセマンティックセグメンテーションに適用することは適切ではありません。 高解像度の画像内の数百万の個々のピクセルを分類するように要求された場合、機械学習モデルは非常に困難な課題に直面します。最近、ビジョントランスフォーマーという新しいモデルの使用法が非常に効果的に登場しました。 トランスフォーマーの元々の目的は、言語のNLPの効率を改善することでした。そのような設定では、文の単語をトークン化し、それらの単語がどのように接続されているかを示すネットワーク図を作成します。アテンションマップは、モデルの文脈理解能力を向上させます。 アテンションマップを生成するために、ビジョントランスフォーマーは同じアイデアを使用し、画像をピクセルのパッチに分割し、各小さなパッチをトークンにエンコードします。このアテンションマップを生成するために、モデルは各ピクセルのペア間の直接的な相互作用を学習する類似性関数を使用します。これにより、モデルは画像内のすべての重要な詳細を認識するための「グローバル受容野」を作成します。 高解像度の画像には数百万のピクセルが含まれ、それらは数千のパッチに分割されるため、アテンションマップはすぐに非常に大きくなります。その結果、解像度が増加する画像を処理するために必要な計算量は二次的に増加します。 MITのチームは、新しいモデルシリーズであるEfficientViTと名付けられた彼らの新しいモデルシリーズで、アテンションマップの構築方法を単純化するために非線形の類似性関数を線形のものに置き換えました。これにより、演算が行われる順序を変更して必要な計算量を削減し、機能性やグローバル受容野を損なうことなく、入力画像のピクセル数に比例して予測を行うために必要な処理時間が線形にスケーリングします。 EfficientViTファミリーの新しいモデルは、デバイス上でセマンティックセグメンテーションを行います。EfficientViTは、ハードウェア効率の高いグローバル受容野とマルチスケール学習のための革新的な軽量マルチスケールアテンションモジュールに基づいて構築されています。これは、SOTAにインスパイアされたセマンティックセグメンテーションの以前のアプローチに基づいています。 このモジュールは、非効率なハードウェア演算の必要性を最小限に抑えながら、これら2つの重要な機能へのアクセスを提供するために作成されました。具体的には、非効率なセルフアテンションを軽量なReLUベースのグローバルアテンションで置き換え、国際的な受容野を実現することを提案しています。ReLUベースのグローバルアテンションの計算量は、行列の乗算の結合法則を利用することで二次的から線形的に削減することができます。また、softmaxのようなハードウェア集約的なアルゴリズムを使用しないため、オンデバイスのセマンティックセグメンテーションに適しています。 EfficientViTは、CityscapesやADE20Kなどの人気のあるセマンティックセグメンテーションのベンチマークデータセットを使用して、詳細な評価を行うために使用されています。以前のSOTAセマンティックセグメンテーションモデルと比較して、EfficientViTは大幅な性能向上を提供します。 以下に貢献の要点をまとめます: 研究者は、デバイス上でセマンティックセグメンテーションを行うための革新的な軽量マルチスケールアテンションを開発しました。これは、グローバル受容野とマルチスケール学習を実現しながら、エッジデバイス上で優れたパフォーマンスを発揮します。 研究者は、提案された軽量マルチスケールアテンションモジュールに基づいてEfficientViTという新しいモデルファミリーを開発しました。 このモデルは、ImageNetなどの主要なセマンティックセグメンテーションのベンチマークデータセットで、以前のSOTAセマンティックセグメンテーションモデルに比べて、モバイルで大幅な高速化を実現しています。 結論として、MITの研究者は、軽量でハードウェア効率の良い演算を使用してグローバル受容野とマルチスケール学習を実現する革新的な軽量マルチスケールアテンションモジュールを導入しました。その結果、SOTAセマンティックセグメンテーションモデルと比較して、エッジデバイスでのパフォーマンスを損なうことなく、エッジデバイス上での大幅な高速化を実現します。EfficientViTモデルはさらにスケーリングされ、他のビジョンタスクでの利用可能性がさらなる研究で調査される予定です。

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.