Learn more about Search Results A - Page 643

- You may be interested

- このAI論文では、大規模言語モデルでの関...

- 「次のデータサイエンスプロジェクトを迅...

- 米政府機関がグローバルサイバー攻撃を受ける

- 「マーケティングにChatGPTを利用する15の...

- PyTorchを使った効率的な画像セグメンテー...

- 「チャンドラヤーン3の着陸:AIとセンサー...

- 「時間の逆転:拡散モデルと確率微分方程式」

- GitHubトピックススクレイパー | Pythonに...

- 「ジャムのマッピング:グラフ理論を用い...

- 安定性AIの新しいアップカミングツールは...

- 「27/11から03/12までの週のトップ重要なL...

- サンタクララ大学を卒業した早熟なティー...

- AWSを使った生成AIを活用したクラウド上の...

- 「バリー・ディラー対生成AI:著作権法的...

- Contextual AIは、VQAv2においてFlamingo...

「11/9から17/9までの週のトップ重要なコンピュータビジョンの論文」

「コンピュータビジョンは、人工知能の一分野であり、機械が視覚世界を解釈し理解することを可能にする技術です画期的な研究や技術の進展により、コンピュータビジョンは急速に進化しています…」

「2024年のトップ5大学の証明書」

「大学の証明書が技術セクターに特化した知識と専門知識の扉を開く方法を探索してください」

人工知能を使用した3Dモデルのカスタマイズを革新する:MITの研究者が、機能性に影響を与えずに美的な調整を行うためのユーザーフレンドリーなインターフェースを開発しました

3Dプリントとデザインにおいて、オープンソースのオンラインリポジトリから入手した3Dデザインをカスタマイズする能力は、持続的な課題です。これらのプラットフォームは即座に印刷可能な3Dモデルの豊富な供給源を提供していますが、カスタマイズオプションは従来、事前定義されたパラメータの調整に限定されていました。 深層学習の最近の進歩により、3Dモデルに美的要素を追加する可能性が開かれました。しかし、既存のデザインにこれらのスタイルをカスタマイズすることは、新たな障害を抱えています。美的要素を超えて、多くの3Dプリントオブジェクトは、そのジオメトリに密接に関連する機能を持っています。構造を大幅に変更する可能性がある3Dモデル全体を変更することは、この機能の損ないのリスクを伴います。選択的にスタイルを適用することは代替案ですが、ユーザーは3Dモデルのどの側面がその機能に影響を与え、どの側面が純粋に装飾目的であるかを正確に特定する必要があります。これは、自分自身によく知られていないデザインをリミックスするユーザーにとって特に困難なタスクです。さらに、オンラインで共有される多くのモデルには、より重要なメタデータが必要な場合もあり、カスタマイズに関連する課題を強めています。 これらの課題が続く中、3Dプリントのために設計された3Dメッシュを自律的に構成要素に分解し、それらの機能と美的属性によって分類するために設計された画期的な手法が登場しました。この革新により、メーカーはオリジナルの機能を保護しながら、スタイルを選択的に3Dモデルに注入することができるようになりました。デザインリポジトリの詳細な分析に基づくものであり、この手法はジオメトリコンポーネントを美的、内部機能、外部機能の3つの異なるカテゴリに分類する包括的なタクソノミーを生み出しました。このタクソノミーに基づき、トポロジーベースのアプローチが構築され、3Dメッシュを自律的にセグメンテーションし、これらの3つのカテゴリに機能を分類することが可能となりました。 この手法を具現化するために、「Style2Fab」と呼ばれるインタラクティブツールが開発されました。Style2Fabは、Text2Meshで最初に提案された差分可能なレンダリングをスタイリゼーションに使用し、3Dプリント用のオープンソースの3Dメッシュの複雑な操作を可能にし、それらの固有の機能を維持しながらカスタマイズします。 この革新的な解決策により、ユーザーは既存の3Dプリントデザインに微妙な変更を加えることができ、視覚的な魅力を高めることなく元の機能を損なうことなく、3Dプリントの可能性をよりアクセス可能で創造的なものにすることができます。メトリクスと評価は、この手法が3Dプリントモデルの変更を容易にする上での効果を明確に示しています。メーカーコミュニティが進化し続ける中、Style2Fabのようなソリューションが3Dプリントのよりアクセス可能で創造的な世界を切り拓く道を開きます。 まとめると、これらの革新的なソリューションにより、メーカーは機能を保持しながら3Dデザインをカスタマイズすることができます。デザインリポジトリの詳細な分析に基づくこのアプローチは、3Dモデルを分類し変更するための体系的な方法を提供します。”Style2Fab”のようなツールを使用することで、メーカーはオリジナルの機能を損なうことなく美的要素を自信を持って向上させることができます。これにより、よりアクセス可能で創造的な3Dプリントの可能性が開かれます。

「Googleの研究者は、シーンのダイナミクスに先行する画像空間をモデリングするための新しい人工知能アプローチを発表します」

風や水の流れ、呼吸、自然のリズムなどのために、静止しているように思われる画像にも微細な振動が含まれています。これは自然界が常に動いているためです。人間は特に動きに敏感であり、これが最も顕著な視覚信号の一つになります。動きのない(またはやや幻想的な動きがある)画像は時折不安定であり、超現実的に感じられることがあります。しかし、人々はシーン内の動きを理解したりイメージしたりすることは簡単です。モデルに現実的な動きを獲得させることはより複雑です。シーンの物理的なダイナミクス、または物体の質量、弾性などの特定の物理的特性によって物体に作用する力は、人々が外部の世界で見る動きを生み出します。 これらの力や特性は、大規模に測定・捉えることが困難ですが、観察された動きから捉えて学ぶことができるため、しばしば定量化する必要はありません。この観測可能な動きは多様な形であり、複雑な物理プロセスに基づいていますが、予測可能です。ろうそくは特定のパターンで揺らぎ、木々は揺れ動き、葉をなびかせます。彼らは、静止画像を見ることで、その画像に基づく自然な動きの分布やその時点で進行中だったかもしれない可能性のある動きを想像することができます。この予測可能性は、彼らの人間の現実のシーンへの知覚に根付いています。 図1: この手法がシーンのダイナミクスに先行する生成画像空間のモデリングをどのようにシミュレートするかが分かります。単一のRGB画像から始めて、モデルはフーリエ領域で密な長期的な動きの軌跡をシミュレートするニューラル確率モーションテクスチャを作成します。彼らは、このモーション先行情報が、単一の画像を滑らかにループするムービーに変換したり、インタラクティブなユーザーの刺激(オブジェクトの点をドラッグしてリリースするなど)に応じてオブジェクトのダイナミクスを模倣したりするためにどのように使用できるかを示しています。彼らは、ビデオの10秒間(入力画像に表示されるスキャンラインに沿った)の空間-時間X-tスライスを使用して、右側の出力フィルムを視覚化しています。 人間がこれらの潜在的な動きを容易に視覚化できるため、これをデジタル上で類似の分布をシミュレートすることは自然な研究課題です。最近の生成モデル、特に条件付き拡散モデルの進歩により、テキストに基づいた実際の画像の分布を含む非常に豊かで複雑な分布をシミュレートすることが可能になりました。この能力のおかげで、以前は実現不可能だったテキストに基づいたランダムで多様なリアルなビジュアル素材の生成など、多数の応用が実現可能になりました。これらの画像モデルの成功を受けて、ビデオや3Dジオメトリなど、さまざまなドメインのモデリングも同様に下流応用において有益であることが最近の研究で示されています。 この論文では、Google Researchの研究者が、単一の画像内の各ピクセルのモーション、または画像空間のシーンモーションとして知られるものの生成先行をモデリングしています。このモデルは、大量の実際のビデオシーケンスから自動的に取得されるモーション軌跡を使用してトレーニングされます。トレーニングされたモデルは、入力画像に基づいてニューラル確率モーションテクスチャを予測し、各ピクセルの将来の軌跡を記述するモーション基底係数の集合を生成します。彼らはフーリエ級数を基底関数として選択し、風で揺れる木や花など、振動するダイナミクスを持つ現実世界の風景に限定して分析します。彼らは、拡散モデルを使用してニューラル確率モーションテクスチャを予測し、1回の予測で1つの周波数の係数を生成し、これらの予測を周波数帯域全体で調整します。 図1に示されているように、生成された周波数空間のテクスチャは、画像ベースのレンダリング拡散モデルを使用して密な長距離ピクセルモーション軌跡に変換され、静止画像をリアルなアニメーションに変換します。モーションキャプチャに関する先行研究と比較して、動画合成を行う従来の技術とは異なり、彼らのモーション表現はより一貫性のある長期的な生成とより細かい制御を可能にします。さらに、彼らは生成されたモーション表現が、シームレスにループするビデオの作成、誘発されたモーションの編集、ユーザーが適用した力に対してオブジェクトがどのように反応するかをシミュレートするインタラクティブなダイナミックイメージなど、さまざまな下流応用に容易に使用できることを示しています。

「アリコロニーオプティマイゼーションの実践」

お帰りなさい!前回の投稿では、アリコロニーオプティマイゼーション(ACO)の基本を紹介しました今回は、ACOアルゴリズムをゼロから実装して、2つの課題に取り組みます...

「データ資産のポートフォリオを構築および管理する方法」

「データ資産(または製品)−特定のユースケースのために簡単に利用できる準備済みのデータまたは情報のセット−は、データ管理の世界で話題です特定のユースケースを特定し、構築し、...」

「ベイチュアン2に会おう:7Bおよび13Bのパラメータを持つ大規模な多言語言語モデルのシリーズ、2.6Tトークンでゼロからトレーニングされました」

大規模言語モデルは近年、大きな進展を遂げています。GPT3、PaLM、Switch Transformersなどの言語モデルは、以前のELMoやGPT-1のようなモデルの数百万から、数十億、あるいは数兆のパラメータを持つようになりました。人間に似た流暢さを持ち、様々な自然言語の活動を行う能力は、モデルのサイズの成長により大幅に向上しました。OpenAIのChatGPTのリリースにより、これらのモデルが人間の話し言葉に似たテキストを生成する能力が大いに注目されました。ChatGPTは、カジュアルな会話から難しいアイデアの明確化まで、さまざまな文脈で優れた言語スキルを持っています。 この革新は、自然言語の生成と理解を必要とするプロセスを自動化するために、巨大な言語モデルがどのように使用されるかを示しています。LLMの革新的な開発と使用が進んでいるにもかかわらず、GPT-4、PaLM-2、ClaudeなどのトップのLLMのほとんどはまだクローズドソースです。モデルのパラメータについて開発者や研究者が部分的なアクセスしか持てないため、このコミュニティがこれらのシステムを徹底的に分析や最適化することは困難です。LLMの透明性とオープンさがさらに向上することで、この急速に発展している分野での研究と責任ある進歩が加速される可能性があります。Metaが作成した巨大な言語モデルのコレクションであるLLaMAは、完全にオープンソースであることにより、LLMの研究コミュニティに大いに役立っています。 OPT、Bloom、MPT、Falconなどの他のオープンソースLLMとともに、LLaMAのオープンな設計により、研究者はモデルに自由にアクセスし、分析、テスト、将来の開発を行うことができます。このアクセシビリティとオープンさにより、LLaMAは他のプライベートLLMとは一線を画しています。Alpaca、Vicunaなどの新しいモデルは、オープンソースLLMの研究と開発のスピードアップによって可能になりました。しかし、英語はほとんどのオープンソースの大規模言語モデルの主な焦点となっています。たとえば、LLaMAの主なデータソースであるCommon Crawl1は、67%の事前学習データを含んでいますが、英語の資料しか含むことが許可されていません。MPTやFalconなど、異なる言語の能力に制約のあるフリーソースLLMも主に英語に焦点を当てています。 そのため、中国語などの特定の言語でのLLMの開発と使用は困難です。Baichuan Inc.の研究者は、この技術的な研究で、広範な多言語言語モデルのグループであるBaichuan 2を紹介しています。Baichuan 2には、13兆パラメータを持つBaichuan 2-13Bと7兆パラメータを持つBaichuan 2-7Bの2つの異なるモデルがあります。両モデルは、Baichuan 1よりも2.6兆トークン以上のデータを使用してテストされました。Baichuan 2は、大量のトレーニングデータにより、Baichuan 1を大幅に上回るパフォーマンスを発揮します。Baichuan 2-7Bは、MMLU、CMMLU、C-Evalなどの一般的なベンチマークで、Baichuan 1-7Bよりも約30%優れたパフォーマンスを示します。Baichuan 2は特に数学とコーディングの問題のパフォーマンスを向上させるように最適化されています。 Baichuan 2は、GSM8KとHumanEvalのテストでBaichuan 1の結果をほぼ2倍に向上させます。また、Baichuan 2は医療および法律の領域の仕事でも優れた成績を収めています。MedQAやJEC-QAなどのベンチマークで他のオープンソースモデルを上回り、ドメイン特化の最適化のための良い基礎モデルとなっています。彼らはまた、人間の指示に従う2つのチャットモデル、Baichuan 2-7B-ChatとBaichuan 2-13B-Chatを作成しました。これらのモデルは、対話や文脈を理解するのに優れています。彼らはBaichuan 2の安全性を向上させるための戦略についてさらに詳しく説明します。これらのモデルをオープンソース化することで、大規模言語モデルのセキュリティをさらに向上させながら、LLMの責任ある作成に関する研究を促進することができます。…

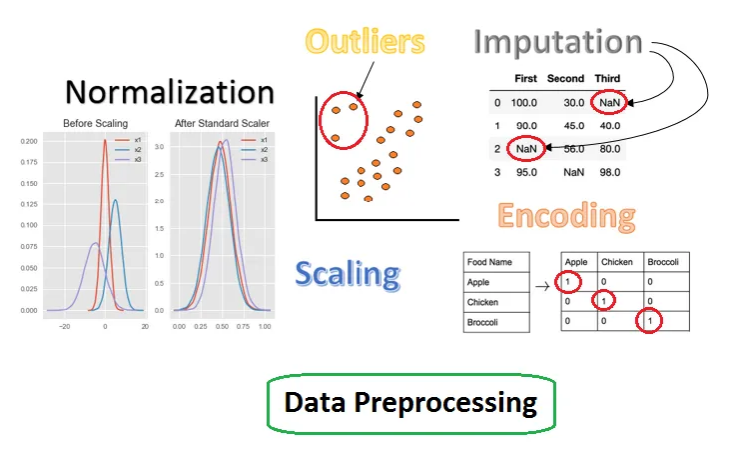

なぜ、そして何が特徴エンジニアリングとは何ですか?

「機械学習モデルのための改善されたデータを作成するための特徴変換や選択または抽出のプロセスですデータサイエンスの専門家によって、データを処理して改善するかどうかが決まります...」

「データ注釈は機械学習の成功において不可欠な役割を果たす」

「自動車から医療まで、AIの成功におけるデータアノテーションの重要な役割を発見しましょう方法、応用、そして将来のトレンドを探求してください」

「2023-24年のアクセンチュアフェローにお会いください」

「MITとAccentureの産業と技術の融合イニシアチブは、2023-24年度の大学院フェローシップを発表します」

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.