Learn more about Search Results エージェント - Page 61

- You may be interested

- 「LlaMA 2の始め方 | メタの新しい生成AI」

- PaLM AI | Googleの自家製生成AI

- Amazon PersonalizeにおけるSimilar-Items...

- Hugging Faceデータセットとトランスフォ...

- エッセンシャルコンプレクシティは、開発...

- 「アソシエイテッドプレスと他のニュース...

- 「FreedomGPT」という名称のAI技術をご紹...

- 動作の良さを把握する確率的AI

- HTMLの要約:IIoTデータのプライバシー保...

- 検索における生成AIが120以上の新しい国と...

- 2023年に注目される7つのデータ可視化のた...

- PythonのCollectionsモジュールについてす...

- AIの変革の道:OpenAIのGPT-4を通してのオ...

- 「Canvaを使用して無料のAIアバターを作成...

- 「AI革命の背後には Paige BaileyがGoogle...

最初のデシジョン トランスフォーマーをトレーニングする

以前の投稿で、transformersライブラリでのDecision Transformersのローンチを発表しました。この新しい技術は、Transformerを意思決定モデルとして使用するというもので、ますます人気が高まっています。 今日は、ゼロからオフラインのDecision Transformerモデルをトレーニングして、ハーフチータを走らせる方法を学びます。このトレーニングは、Google Colab上で直接行います。こちらで見つけることができます👉 https://github.com/huggingface/blog/blob/main/notebooks/101_train-decision-transformers.ipynb *ジムのHalfCheetah環境でオフラインRLを使用して学習された「専門家」Decision Transformersモデルです。 ワクワクしませんか?では、始めましょう! Decision Transformersとは何ですか? Decision Transformersのトレーニング データセットの読み込みとカスタムデータコレータの構築 🤗 transformers Trainerを使用したDecision Transformerモデルのトレーニング 結論 次は何ですか? 参考文献 Decision Transformersとは何ですか? Decision…

機械学習洞察のディレクター【パート4】

MLソリューションをより速く構築したい場合は、今すぐ hf.co/support をご覧ください! 👋 ML Insightsシリーズのディレクターへお帰りなさい!以前のエディションを見逃した場合は、こちらで見つけることができます: ディレクター・オブ・マシン・ラーニング・インサイト[パート1] ディレクター・オブ・マシン・ラーニング・インサイト[パート2:SaaSエディション] ディレクター・オブ・マシン・ラーニング・インサイト[パート3:金融エディション] 🚀 この第4弾では、次のトップマシン・ラーニング・ディレクターがそれぞれの業界へのマシン・ラーニングの影響について語ります:ハビエル・マンシージャ、ショーン・ギットンズ、サミュエル・フランクリン、エヴァン・キャッスル。全員が現在、豊富なフィールドの洞察を持つマシン・ラーニングのディレクターです。 免責事項:すべての意見は個人の意見であり、過去または現在の雇用者の意見ではありません。 ハビエル・マンシージャ – マーケティングサイエンス部門のマシン・ラーニングディレクター、メルカドリブレ 経歴:経験豊富な起業家でありリーダーであるハビエルは、2010年以来マシン・ラーニングを構築する高級企業であるMachinalisの共同設立者兼CTOでした(そう、ニューラルネットの突破前の時代です)。 MachinalisがMercado Libreに買収されたとき、その小さなチームは10,000人以上の開発者を持つテックジャイアントにマシン・ラーニングを可能にする能力として進化し、ほぼ1億人の直接ユーザーの生活に影響を与えました。ハビエルは、彼らのマシン・ラーニングプラットフォーム(NASDAQ MELI)の技術と製品のロードマップだけでなく、ユーザーのトラッキングシステム、ABテストフレームワーク、オープンソースオフィスもリードしています。ハビエルはPython-Argentinaの非営利団体PyArの積極的なメンバーおよび貢献者であり、家族や友人、Python、サイクリング、サッカー、大工仕事、そしてゆっくりとした自然の休暇が大好きです! おもしろい事実:私はSF小説を読むのが大好きで、引退後は短編小説を書くという10代の夢を再開する予定です。📚 メルカドリブレ:ラテンアメリカ最大の企業であり、コンチネンタルのeコマース&フィンテックの普遍的なソリューションです 1. eコマースにおいてMLがポジティブな影響を与えたのはどのような場合ですか? 詐欺防止や最適化されたプロセスやフローなど、特定のケースにおいてMLは不可能を可能にしたと言えます。他のほとんどの分野では想像もできなかった方法で、MLがUXの次のレベルを実現しました。…

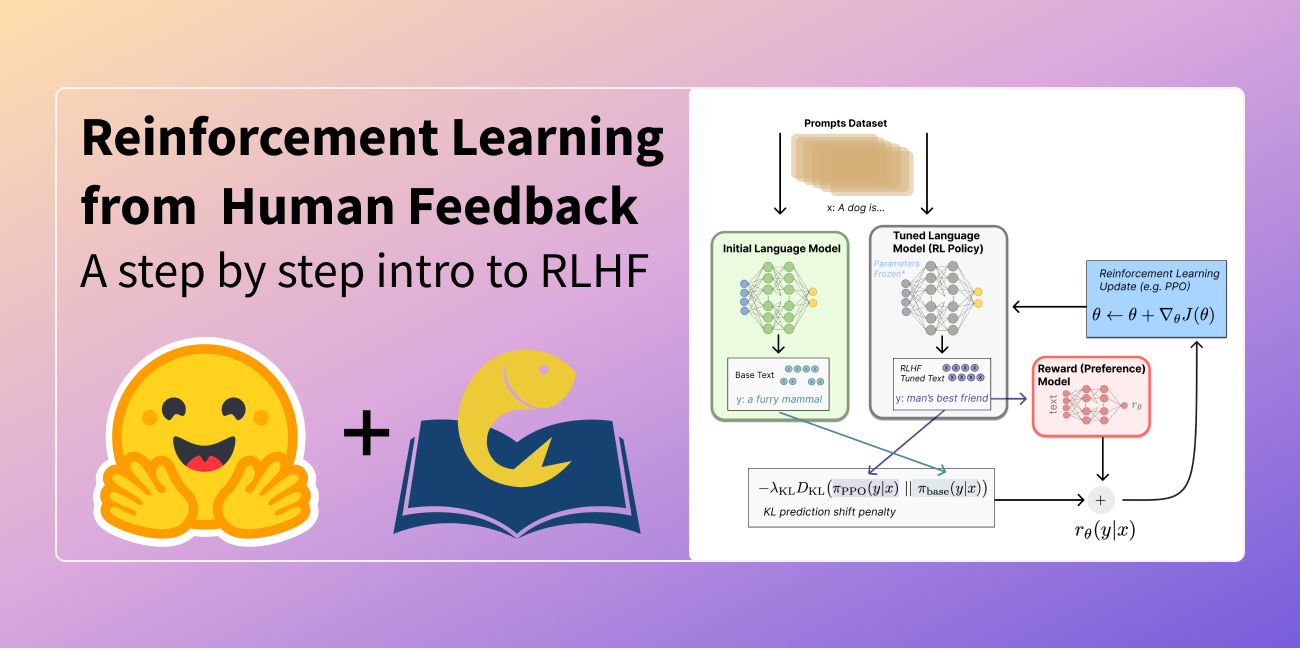

人間のフィードバックからの強化学習(RLHF)の説明

この記事は以下の言語に翻訳されています:中国語(簡体字)とベトナム語。他の言語に翻訳に興味がありますか?nathan at huggingface.co までお問い合わせください。 言語モデルは、過去数年間に人間の入力プロンプトから多様で魅力的なテキストを生成する能力を示してきました。しかし、「良い」テキストとは何かは、主観的で文脈に依存するため、本質的に定義するのは難しいです。創造性を求める物語の執筆などの多くのアプリケーションでは、真実であるべき情報の断片、または実行可能なコードのスニペットなどが必要です。 これらの属性を捉えるための損失関数を作成することは困難であり、ほとんどの言語モデルはまだ単純な次のトークン予測の損失(例:クロスエントロピー)で訓練されています。損失自体の欠点を補うために、人々はBLEUやROUGEなど、人間の優先順位をより適切に捉えるように設計されたメトリクスを定義しています。これらのメトリクスは、パフォーマンスを測定する上で損失関数自体より適しているものの、生成されたテキストを単純なルールで参照テキストと比較するだけなので、制約もあります。生成されたテキストに対する人間のフィードバックをパフォーマンスの指標として使用するか、さらに進んでそのフィードバックを損失としてモデルを最適化することができれば、素晴らしいことではないでしょうか?それが「人間のフィードバックによる強化学習(RLHF)」のアイデアです。強化学習の手法を使用して、言語モデルを人間のフィードバックで直接最適化するのです。RLHFにより、言語モデルは一般的なテキストデータのコーパスで訓練されたモデルを複雑な人間の価値に合わせることができるようになりました。 RLHFの最近の成功例は、ChatGPTでの使用です。ChatGPTの印象的な能力を考慮して、RLHFについて説明してもらいました: それは驚くほどうまくいっていますが、すべてをカバーしているわけではありません。それらのギャップを埋めましょう! 人間のフィードバックによる強化学習(RL from human preferencesとも呼ばれます)は、複数のモデルのトレーニングプロセスと異なる展開の段階を伴うため、難しい概念です。このブログ記事では、トレーニングプロセスを次の3つの主要なステップに分解します: 言語モデル(LM)の事前トレーニング データの収集と報酬モデルのトレーニング 強化学習によるLMの微調整 まず、言語モデルの事前トレーニングについて見ていきましょう。 言語モデルの事前トレーニング RLHFの出発点として、クラシカルな事前トレーニング目標で既に事前トレーニングされた言語モデルを使用します(詳細については、このブログ記事を参照してください)。OpenAIは、最初の人気のあるRLHFモデルであるInstructGPTに対して、より小さなバージョンのGPT-3を使用しました。Anthropicは、このタスクのためにトレーニングされた1,000万から520億のパラメータを持つトランスフォーマーモデルを使用しました。DeepMindは、2800億のパラメータモデルGopherを使用しました。 この初期モデルは、追加のテキストや条件で微調整することもできますが、必ずしも必要ではありません。たとえば、OpenAIは「好ましい」とされる人間が生成したテキストを微調整し、Anthropicは彼らの「助けになり、正直で無害な」基準に基づいて元のLMを蒸留することで、RLHFのための初期LMを生成しました。これらは共に、私が高価な増強データと呼ぶものの一部ですが、RLHFを理解するために必要なテクニックではありません。 一般的に、「どのモデル」がRLHFの出発点として最適かは明確な答えがありません。このブログ記事では、RLHFのトレーニングにおけるオプションの設計空間が完全に探索されていないという共通のテーマになります。 次に、言語モデルが必要なデータを生成して、人間の優先順位がシステムに統合される「報酬モデル」をトレーニングする必要があります。 報酬モデルのトレーニング 人間の優先順位に合わせてキャリブレーションされた報酬モデル(RM、優先モデルとも呼ばれます)を生成することは、RLHFの比較的新しい研究の出発点です。その基本的な目標は、テキストのシーケンスを受け取り、数値で人間の優先順位を表すべきスカラー報酬を返すモデルまたはシステムを取得することです。システムはエンドツーエンドのLMであるか、報酬を出力するモジュラーシステム(例:モデルが出力をランク付けし、ランキングが報酬に変換される)である場合があります。出力がスカラーの報酬であることは、既存のRLアルゴリズムが後のRLHFプロセスにシームレスに統合されるために重要です。 報酬モデリングのためのこれらの言語モデルは、別の微調整された言語モデルまたは好みのデータでスクラッチからトレーニングされた言語モデルのいずれかです。例えば、Anthropicは、これらのモデルを事前トレーニング(好みモデルの事前トレーニング、PMP)の後に初期化するために専門の微調整方法を使用しています。彼らは、これが微調整よりもサンプル効率が高いと結論付けましたが、報酬モデリングのバリエーションの中で明確な最良の選択肢はありません。…

ストーリーの生成:ゲーム開発のためのAI #5

AIゲーム開発へようこそ!このシリーズでは、AIツールを使用してわずか5日で完全な機能を備えた農業ゲームを作成します。このシリーズの終わりまでに、さまざまなAIツールをゲーム開発のワークフローに取り入れる方法を学ぶことができます。以下のような目的でAIツールを使用する方法をお見せします: アートスタイル ゲームデザイン 3Dアセット 2Dアセット ストーリー クイックビデオバージョンが欲しいですか? こちらでご覧いただけます。それ以外の場合は、技術的な詳細を読み続けてください! 注:この投稿では、ゲームデザインにChatGPTを使用したPart 2への参照がいくつかあります。ChatGPTの動作方法、言語モデルの概要、およびその制限についての追加のコンテキストについては、Part 2をお読みください。 Day 5: ストーリー このチュートリアルシリーズのPart 4では、Stable DiffusionとImage2Imageを2Dアセットのワークフローに使用する方法について説明しました。 この最終パートでは、ストーリーにAIを使用します。まず、農業ゲームのプロセスを説明し、注意すべき⚠️ 制限事項について説明します。次に、ゲーム開発の文脈での関連技術と今後の方向性について話します。最後に、最終的なゲームについてまとめます。 プロセス 要件:このプロセス全体でChatGPTを使用しています。ChatGPTと言語モデリングについての詳細については、シリーズのPart 2をお読みいただくことをおすすめします。ChatGPTは唯一の解決策ではありません。オープンソースの対話エージェントなど、数多くの新興競合他社が存在します。対話エージェントの新興市場についてさらに詳しく学ぶために、先を読んでください。 ChatGPTにストーリーの執筆を依頼します。ゲームに関する多くのコンテキストを提供した後、ChatGPTにストーリーの要約を書いてもらいます。 ChatGPTは、ゲームStardew…

スターコーダーでコーディングアシスタントを作成する

ソフトウェア開発者であれば、おそらくGitHub CopilotやChatGPTを使用して、プログラミングのタスクを解決したことがあるでしょう。これらのタスクには、コードを別の言語に変換したり、自然言語のクエリ(「N番目のフィボナッチ数を見つけるPythonプログラムを書いてください」といったもの)から完全な実装を生成したりするものがあります。これらの独自のシステムは、その機能には感動的ですが、一般にはいくつかの欠点があります。これらには、トレーニングに使用される公開データの透明性の欠如や、ドメインやコードベースに適応することのできなさなどがあります。 幸いにも、今はいくつかの高品質なオープンソースの代替品があります!これには、SalesForceのPython用CodeGen Mono 16B、またはReplitの20のプログラミング言語でトレーニングされた3Bパラメータモデルなどがあります。 新しいオープンソースの選択肢としては、BigCodeのStarCoderがあります。80以上のプログラミング言語、GitHubの問題、Gitのコミット、Jupyterノートブックから1兆トークンを収集した16Bパラメータモデルで、これらはすべて許可されたライセンスです。エンタープライズ向けのライセンス、8,192トークンのコンテキスト長、およびマルチクエリアテンションによる高速な大規模バッチ推論を備えたStarCoderは、現在、コードベースのアプリケーションにおいて最も優れたオープンソースの選択肢です。 このブログポストでは、StarCoderをチャット用にファインチューニングして、パーソナライズされたコーディングアシスタントを作成する方法を紹介します! StarChatと呼ばれるこのアシスタントには、次のようないくつかの技術的な詳細があります。 LLMを会話エージェントのように動作させる方法。 OpenAIのChat Markup Language(ChatMLとも呼ばれる)は、人間のユーザーとAIアシスタントの間の会話メッセージに対する構造化された形式を提供します。 🤗 TransformersとDeepSpeed ZeRO-3を使用して、多様な対話のコーパスで大きなモデルをファインチューニングする方法。 最終結果の一部を見るために、以下のデモでStarChatにいくつかのプログラミングの質問をしてみてください! デモで使用されたコード、データセット、およびモデルは、以下のリンクで見つけることができます。 コード: https://github.com/bigcode-project/starcoder データセット: https://huggingface.co/datasets/HuggingFaceH4/oasst1_en モデル: https://huggingface.co/HuggingFaceH4/starchat-alpha 始める準備ができたら、まずはファインチューニングなしで言語モデルを会話エージェントに変換する方法を見てみましょう。…

将来のアプリケーションを支える大規模言語モデル(LLM)の力

生成AI、特にその言語フレーバーであるChatGPTはどこでも見かけます大規模言語モデル(LLM)の技術は、将来のアプリケーションの開発において重要な役割を果たすでしょうLLMは、数兆行に及ぶパブリックドメインのテキストに対する基礎モデルの詳細な事前トレーニングによって、言語理解に非常に優れています

ジョシュ・フィースト、CogitoのCEO兼共同創業者 – インタビューシリーズ

ジョシュ・フィーストは、CogitoのCEO兼共同創業者であり、感情と会話AIを組み合わせた革新的なプラットフォームを提供するエンタープライズですこのプラットフォームは、リアルタイムのコーチングやガイダンスをコンタクトセンターエージェントに提供し、スーパーバイザーにはどこからでもチームのライブ会話を見ることができるだけでなく、顧客と従業員のエクスペリエンスを継続的にモニタリングしますCogitoの物語はここから始まります...

より一般的なロボットへのスタッキング

棒を拾って丸太の上にバランスをとったり、石の上に小石を積んだりすることは、人にとっては簡単で似たような行動に見えるかもしれませんしかし、ほとんどのロボットは、複数のこのようなタスクを同時に処理するのに苦労します棒を操作するには、石を積み上げるよりも異なる行動のセットが必要ですましてや様々な皿を積み重ねたり家具を組み立てたりすることはさらに難しいですこれらのタスクをロボットに教える前に、ロボットはまずより広範なオブジェクトとの相互作用を学ぶ必要がありますDeepMindのミッションの一環として、より一般的で有用なロボットを作るための一歩として、私たちはロボットが異なる幾何学的な形状を持つオブジェクトとの相互作用をより良く理解する方法を探求しています

DeepMindの最新のICLR 2022での研究

スポンサーとしてのイベント支援や定期的なワークショップ主催に加えて、今年は10件の共同研究を含む29件の論文を発表します以下に、私たちの今後の口頭発表、スポットライト発表、ポスター発表の一部をご紹介します

GPT-3がMLOpsの将来に与える意味とは?デビッド・ハーシーと共に

この記事は元々MLOps Liveのエピソードであり、ML実践者が他のML実践者からの質問に答えるインタラクティブなQ&Aセッションです各エピソードは特定のMLトピックに焦点を当てており、このエピソードではGPT-3とMLOpsの特徴についてDavid Hersheyと話しましたYouTubeで視聴することができます Or...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.