Learn more about Search Results Kubernetes - Page 5

- You may be interested

- 一緒にAIを学ぶ- Towards AIコミュニティ...

- 「MITとハーバードの研究者は、脳内の生物...

- 昆虫サイボーグ:精密な動きに向けて

- ソフトウェア開発の革命:AIとコードのダ...

- Hugging FaceとGraphcoreがIPU最適化され...

- 「LangChainを使用したLLMアプリケーショ...

- 「GPT-4V(ビジョン)のコンセプトを理解...

- 「単なる爬虫類以上:ブラックボックスモ...

- 🧨ディフューザーを使用した安定した拡散

- MLOps(エムエルオプス):ドリフトの監視...

- ソースコード付きのトップ14のデータマイ...

- 「分散データパラレル(DDP)の包括的ガイ...

- ビジョン-言語モデルへのダイブ

- データ駆動型のディスパッチ

- 「ベイズネットワークを使用して、病院の...

「コンプライアンス自動化標準ソリューション(COMPASS), パート1 パーソナと役割」

「これは私たちのシリーズの最初の部分であり、組織やクラウドプロバイダが連続的なコンプライアンスを達成しようとする際に直面する課題を説明しています」

Amazon CloudWatchで、ポッドベースのGPUメトリクスを有効にします

この記事では、コンテナベースのGPUメトリクスの設定方法と、EKSポッドからこれらのメトリクスを収集する例について詳しく説明します

オラクルと一緒にXRを開発しよう、エピソード6 AIサマライザー+ジェネレーター

このチュートリアルでは、ユーザーの周囲からのさまざまな入力を使用し、それをAIで処理し、要約/生成AIを返すミックスドリアリティアプリの完全なソースを提供します

「Azure Lightweight Generative AI Landing Zone」

「Azure AI サービスに基づくランディングゾーンの構築に関する完全ガイドでは、AI プロダクトを紹介し、AI の活用により利益を得るトップ 3 の企業について調査します」

「マイクロソフトのAzureとGoogleのCloud Platformの比較」

導入 Microsoft AzureとGoogle Cloud Platformは、クラウドコンピューティングの2大巨頭です。この2つの中で、Microsoft Azureは最も効果的かつ適応性のあるソフトウェアソリューションを提案している一方、Google Cloud Platform(GCP)は高度なビッグデータ分析ソリューションを提供し、他のベンダー製品とのシンプルな統合を可能にしています。2023年初めの時点で、Azureは世界で2番目に大きなクラウドサービスとなる23%の市場シェアを獲得し、同時にGoogle Cloudは11%の市場シェアを持っていました。それでは、Microsoft AzureとGoogle Cloud Platformの違いを詳しく探って、最適な選択肢を理解してみましょう。 Azure vs GCP:概要 以下の比較表は、AzureとGCPの間のいくつかの主な特徴の違いを示しています。 特徴 Microsoft Azure Google Cloud Platform(GCP) 設立 2010年に開始…

「ArgoCDを使用して、マルチ環境でのイメージプロモーションの課題を解決する」

「マルチ環境展開におけるイメージのプロモーション課題を解決するArgoCDの仕組みを知ろうGitOps、ArgoCD、Kustomizeが、追跡とプロモーションを簡素化し、イメージレジストリの肥大化という見過ごされていた課題に取り組みます革新的な解決策をご覧ください!」

AWS vs Azure:究極のクラウド対決

Amazon Web ServicesとMicrosoft Azureは、クラウドコンピューティングの2つの巨人です。これら2つの業界リーダーの競争は、「クラウド戦争」を引き起こしました。この記事では、AWSとAzureの包括的な比較を掘り下げて、その特徴、利点、欠点、求人の機会などを調査しています。 AWSとは何ですか? Amazon Web Services(AWS)は、Amazonが提供する機能豊富なクラウドコンピューティングプラットフォームです。計算能力、ストレージオプション、データベース、機械学習、分析などの多くのオンデマンドサービスを提供しています。これらのサービスにより、物理的なハードウェアなしでソフトウェアアプリケーションやサービスを作成、配布、管理することができます。クラウド環境の柔軟性、拡張性、経済性を向上させます。 Azureとは何ですか? Azureは、Microsoftのクラウドコンピューティングプラットフォームであり、処理能力、ストレージ、データベース、ネットワーキング、分析などのさまざまなサービスを提供しています。これにより、企業はクラウドベースのアプリケーションやサービスを構築、実装、管理することができます。また、Microsoftのソフトウェアエコシステムとの統合を提供しながら、拡張性と柔軟性を提供します。 AWS vs. Azure:概要 AWSとAzureの基本的な違いを見てみましょう: 側面 AWS Azure 会社 Amazon Microsoft 立ち上げ年 2006 2010 市場シェア…

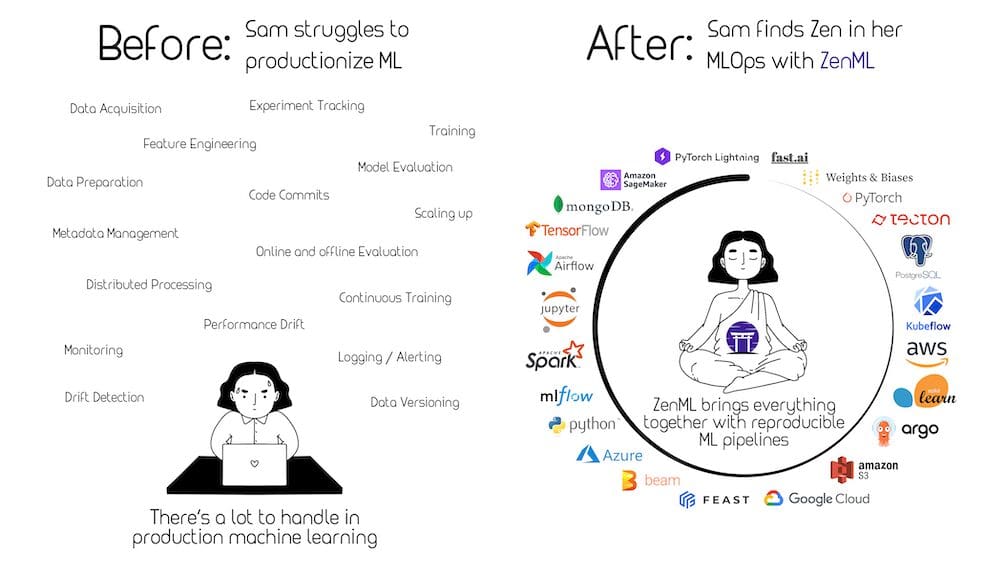

「MLOpsに関する包括的なガイド」

「Machine Learning Operations(MLOps)は、機械学習(ML)モデルが本番環境で繁栄するために必要な構造とサポートを提供する比較的新しい学問分野です」

ベントMLを使用したHugging Faceモデルのデプロイ:DeepFloyd IFのアクション

Hugging Faceは、モデルを簡単にアップロード、共有、展開することができるHubプラットフォームを提供しています。これにより、モデルをゼロからトレーニングするために必要な時間と計算リソースを開発者が節約することができます。ただし、実世界のプロダクション環境やクラウドネイティブの方法でモデルを展開することはまだ課題があります。 ここでBentoMLが登場します。BentoMLは、機械学習モデルのサービングと展開のためのオープンソースプラットフォームです。これは、従来の、事前トレーニング済みの、生成モデルおよび大規模言語モデルを組み込んだ本番向けのAIアプリケーションを構築、出荷、スケーリングするための統一されたフレームワークです。以下は、BentoMLフレームワークを高レベルで使用する方法です: モデルの定義:BentoMLを使用するには、機械学習モデル(または複数のモデル)が必要です。このモデルは、TensorFlowやPyTorchなどの機械学習ライブラリを使用してトレーニングできます。 モデルの保存:トレーニング済みのモデルをBentoMLのローカルモデルストアに保存します。これは、すべてのトレーニング済みモデルをローカルで管理し、サービングにアクセスするために使用されます。 BentoMLサービスの作成:モデルをラップし、サービスのロジックを定義するためにservice.pyファイルを作成します。これは、モデルの推論をスケールで実行するためのランナーを指定し、入力と出力の処理方法を定義するAPIを公開します。 Bentoのビルド:構成YAMLファイルを作成することで、すべてのモデルとサービスをパッケージ化し、コードと依存関係を含む展開可能なアーティファクトであるBentoを作成します。 Bentoの展開:Bentoが準備できたら、Bentoをコンテナ化してDockerイメージを作成し、Kubernetes上で実行することができます。または、Bentoを直接Yataiに展開することもできます。Yataiは、Kubernetes上での機械学習デプロイメントを自動化および実行するためのオープンソースのエンドツーエンドソリューションです。 このブログ投稿では、上記のワークフローに従ってDeepFloyd IFをBentoMLと統合する方法をデモンストレーションします。 目次 DeepFloyd IFの簡単な紹介 環境の準備 BentoMLモデルストアへのモデルのダウンロード BentoMLサービスの開始 Bentoのビルドとサービスの提供 サーバーのテスト 次のステップ DeepFloyd IFの簡単な紹介 DeepFloyd IFは、最先端のオープンソースのテキストから画像へのモデルです。Stable Diffusionのような潜在的な拡散モデルとは異なる運用戦略とアーキテクチャを持っています。…

「CPU上での分散Llama 2」

この演習は、Meta AIのLLM(Large Language Model)であるLlama 2を使用して、llama.cppとPySparkを介して一度に多くの文書を要約することについてです

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.