Learn more about Search Results 比較 - Page 5

- You may be interested

- 「シェアレンティングの危険性:オンライ...

- このAI論文は、自律走行車のデータセット...

- 中国の研究者が「ImageReward」という画期...

- データサイエンスのキャリアトレンドを理...

- 「Pyroを使ったベイジアンABテスト」

- 「AIではなく、データプライバシー法の欠...

- 「トランスフォーマーを使用した音声から...

- 需要予測のNixtlaへの紹介

- Intel CPUのNNCFと🤗 Optimumを使用した安...

- 「アニマ・アナンドクマールとともにAIを...

- パンダのGroupByを最大限に活用する

- 「GoogleのNotebookLMを使用したデータサ...

- 「Rプログラミング言語を使った統計学入門」

- 「ChatGPT AI-1の解放:高度なLLMベースの...

- MPT-30B:モザイクMLは新しいLLMを使用し...

「NTUシンガポールの研究者がResShiftを導入:他の手法と比較して、残差シフトを使用し、画像超解像度をより速く実現する新しいアップスケーラモデル」

低レベルビジョンの基本的な課題の1つは、画像のスーパーレゾリューション(SR)であり、低解像度(LR)の画像から高解像度(HR)の画像を復元することを目指しています。実世界の環境での劣化モデルの複雑さと不明瞭さのため、この問題は解決される必要があります。最近開発された生成モデルである拡散モデルは、画像の作成において非凡な成功を収めています。また、画像編集、画像補完、画像着色など、いくつかの下流の低レベルビジョンの問題にも有望な成果を示しています。さらに、困難で時間のかかるSRの作業に対して拡散モデルがどれだけうまく機能するかを調べるための研究がなされています。 典型的な手法の1つは、現在の拡散モデル(例:DDPM)の入力にLR画像を導入した後、SRのためのトレーニングデータを使用してモデルをゼロから再トレーニングすることです。もう1つの一般的な手法は、目的のHR画像を生成する前に、無条件の事前トレーニング済みの拡散モデルの逆経路を変更することです。残念ながら、これらのアルゴリズムの両方には、DDPMを基盤とするマルコフ連鎖が継承されています。図1の推論を高速化するためにDDIMアルゴリズムが使用されていますが、推論中のサンプルステップを圧縮するためのいくつかの加速手法が考案されています。これらの手法は、パフォーマンスのかなりの低下と過度に滑らかな結果につながることがしばしばあります。 図1は、BSRGAN、RealESRGAN、SwinIR、DASR、およびLDMを含む最近の状況と提案手法の品質を比較しています。LDMと彼らの手法に関しては、より理解しやすい視覚化のために「LDM(またはOurs)-A」という式を使用して、サンプリングステップの数を示しています。ここで、「A」はサンプリングステップの総数です。LDMは訓練時に1000の拡散ステップを持ち、推論時にDDIMを使用して「A」ステップに加速されます。より明確に見るために拡大してください。 効率とパフォーマンスの両方を損なうことなく、SRのための新しい拡散モデルを作成する必要があります。画像作成のための拡散モデルを見直してみましょう。前進のプロセスでは、マルコフ連鎖が多くのステップで構築され、観測データが事前に指定された分布(通常は従来のガウス分布)に徐々に変換されます。次に、事前分布からノイズマップをサンプリングし、マルコフ連鎖の逆経路に供給することで、画像を生成することができます。ガウス分布は画像生成には適していますが、LR画像が既に利用可能なため、SRには最適な選択肢ではないかもしれません。 この研究での主張によれば、SRの適切な拡散モデルは、ガウスのホワイトノイズではなく、LR画像を基にした事前分布から始めるべきであり、LR画像からHR画像を反復的に復元することが可能です。このような設計は、サンプリングに必要な拡散ステップの数を削減し、推論の効率を高めることもできます。南洋理工大学の研究者たちは、HR画像とそれに相当するLR画像の間を切り替えるために、より短いマルコフ連鎖を使用する効果的な拡散モデルを提案しています。マルコフ連鎖の初期状態はHR画像の分布を近似し、終端状態はLR画像の分布を近似します。 彼らは丁寧にトランジションカーネルを作成し、それらの間の残差を徐々に調整するために使用しています。残差情報はいくつかの段階で迅速に伝達することができるため、この技術は現在の拡散ベースのSR手法よりも効果的です。さらに、彼らのアーキテクチャは、訓練の最適化目標の導出を簡素化するために、証拠下限を明確で分析的な方法で表現することが可能です。彼らはこの構築された拡散カーネルに基づく非常に柔軟なノイズスケジュールを作成し、残差の移動速度と各ステップのノイズレベルを調整します。 ハイパーパラメータを調整することで、このスケジュールは取得した結果の忠実度と現実性のトレードオフを可能にします。以下に、この研究の重要な貢献を示します: • 彼らはSRに対して効果的な拡散モデルを提供しており、推論時に2つの間の残差を移動することで、望ましくないLR画像から望ましいHR画像への反復サンプリングプロセスを可能にします。詳細な研究により、彼らの手法の効率性が示されています。望ましい結果を得るためにわずか15の簡単なステップしか必要とせず、長時間のサンプリング手法が必要な既存の拡散ベースのSR技術を上回るか、少なくとも同等の結果を示します。図1は、既存の技術と比較した彼らの取得した結果の一部を示しています。 • 提案された拡散モデルに対して、より正確な制御を可能にする高度に可変なノイズスケジュールを開発しています。

テキストデータのチャンキング方法-比較分析

自然言語処理(NLP)における「テキストチャンキング」プロセスは、非構造化テキストデータを意味のある単位に変換することを意味しますこの見かけ上シンプルなタスクには、複雑さが隠されています

効果的にMLソリューションを比較する方法

「機械学習ソリューションを評価および比較する際には、おそらく最初に評価指標として予測力を使用することになるでしょう異なるモデルを1つの指標で比較するのは簡単であり、これが...」

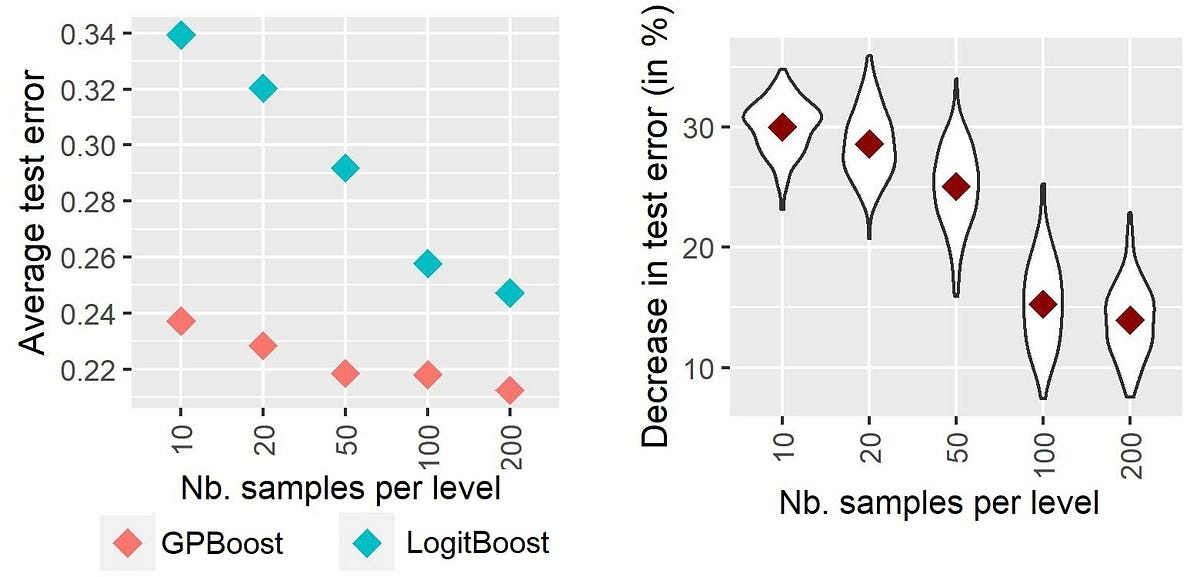

ハイカーディナリティのカテゴリカル変数に対する混合効果機械学習-第I部:異なる手法の実証的比較

高次元のカテゴリー変数のモデリングを向上させるための機械学習におけるランダム効果:アプローチの紹介と比較

GPT-1からGPT-4まで:OpenAIの進化する言語モデルの包括的な分析と比較

OpenAIは、さまざまなアプリケーションのニーズに応じて、それぞれ独自の特徴とコスト構造を備えた幅広いモデルを提供しています。モデルは定期的に更新され、最新の技術の進歩を反映しています。ユーザーはモデルを調整して、より良いパフォーマンスを引き出すこともできます。OpenAIのGPTモデルは、主要な自然言語処理(NLP)の進歩を実現しています。 GPTとは、簡単に言えば何ですか? NLPアプリケーション用の1つの機械学習モデルは、Generative Pre-trained Transformer(GPT)です。これらのモデルは、書籍やウェブサイトなどの大量の情報を事前学習して、自然で構造化されたテキストを生成するために使用されます。 より簡単に言えば、GPTは、人間が書いたかのように見えるテキストを生成することができるコンピュータプログラムですが、それを目的として設計されていません。そのため、質問応答、翻訳、テキスト要約などのNLPアプリケーションに適用することができます。自然言語処理に関しては、GPTは機械が言語を理解し、流暢かつ正確に生成することを可能にするため、大きな進歩です。以下では、元のGPTから最新のGPT-4までの4つのGPTモデルについて、それぞれの強みと弱点について説明します。 GPT-1 2018年、OpenAIはTransformerアーキテクチャに基づく言語モデルの最初のバージョンであるGPT-1を発表しました。その117万のパラメータは、当時の最も先進的な言語モデルよりも大幅な進歩でした。 GPT-1は、プロンプトやコンテキストに対して自然で理解可能なスピーチを生成する能力がありました。このモデルのトレーニングには、数十億の単語を含む巨大なウェブページのデータセットであるCommon Crawlと、さまざまなトピックの11,000冊以上の書籍からなるBookCorpusデータセットが使用されました。さまざまなデータセットの助けを借りて、GPT-1は言語モデリングのスキルを磨くことができました。 GPT-2 OpenAIは、GPT-1の代わりにGPT-2を2019年に公開しました。GPT-2はGPT-1よりも大幅に大きく、15億のパラメータを持っていました。Common CrawlとWebTextを統合することで、より大きく、より多様なデータセットを使用してモデルをトレーニングしました。 GPT-2の能力の1つは、論理的で妥当なテキストシーケンスを構築することです。人間の反応を模倣する能力も、コンテンツ生成や翻訳など、自然言語処理のさまざまなアプリケーションにとって有用なリソースになります。 ただし、GPT-2にはいくつかの欠点もあります。複雑な推論や文脈の理解には多くの作業が必要でした。しかし、GPT-2は、短いテキストにおける優れたパフォーマンスにもかかわらず、長い文章を一貫して文脈に沿って保つのは難しいという課題に直面しました。 GPT-3 2020年にGPT-3がリリースされ、自然言語処理のモデルの指数関数的な成長の時代を迎えました。GPT-3のサイズは1750億のパラメータであり、GPT-2の10倍以上、GPT-1の100倍以上です。 BookCorpus、Common Crawl、Wikipediaなどのさまざまな情報源を使用してGPT-3をトレーニングしました。GPT-3は、ほとんどまたはまったくトレーニングデータがなくても、データセット全体で約1兆の単語にわたるさまざまなNLPタスクで高品質な結果を生成することができます。 GPT-3の文章を作成する能力、コンピュータコードの書き込み能力、アートの創造能力は、以前のモデルと比べて大きな進歩です。先行モデルとは異なり、GPT-3はテキストの文脈を解釈し、関連する応答を考え出すことができます。チャットボット、オリジナルコンテンツの生成、言語翻訳など、自然な音声を生成する能力は、さまざまな用途に大きな利益をもたらすことができます。 GPT-3の強力な言語モデルの倫理的な影響や潜在的な誤用に関する懸念も、GPT-3の能力が明らかになったことで浮上しました。多くの専門家は、このモデルがハイジャック、フィッシングメール、ウイルスなどの有害なコンテンツを作成するために誤用される可能性について懸念しています。犯罪者たちはChatGPTを使用してマルウェアを開発しています。 GPT-4 第4世代のGPTは2023年3月14日にリリースされました。これは、革命的だったGPT-3よりも大幅に改善されたものです。モデルのアーキテクチャとトレーニングデータはまだ公開されていませんが、前のバージョンの欠点を解消し、いくつかの重要な点でGPT-3を上回ることが明らかです。 ChatGPT…

PythonとRにおける機械学習アルゴリズムの比較

PythonとRで最も一般的に使用される機械学習アルゴリズムのリストは、初心者エンジニアや愛好家が最もよく使用されるアルゴリズムに慣れるのを支援することを目的としています

バイトダンスAI研究がStemGenを紹介:音楽の文脈を聞いて適切に反応するためにトレーニングされたエンドツーエンドの音楽生成ディープラーニングモデル

音楽生成は、既存の音楽に存在するパターンと構造を模倣するためにモデルを訓練することで行われるディープラーニングの一環です。RNN、LSTMネットワーク、トランスフォーマーモデルなど、ディープラーニングの技術が一般的に使用されます。この研究では、音楽のコンテキストに応じて反応する非自己回帰型のトランスフォーマーベースのモデルを使用して音楽音声を生成する革新的なアプローチを探求しています。従来のモデルが抽象的な調整に頼っているのに対し、この新しいパラダイムは聞くことと反応することを重視しています。この研究では、フィールドの最新の進歩を取り入れ、アーキテクチャの改良について議論しています。 SAMIと字節跳動社の研究者は、音楽コンテキストに反応する非自己回帰型のトランスフォーマーベースのモデルを紹介し、MusicGenモデルのための公開されたエンコードチェックポイントを活用しています。評価には、Frechet Audio Distance(FAD)やMusic Information Retrieval Descriptor Distance(MIRDD)などの標準的な指標や音楽情報検索ディスクリプタのアプローチが使用されています。その結果、このモデルは客観的な指標と主観的MOSテストを通じて、競争力のある音声品質と強固な音楽のコンテキストに対する整合性を示しています。 この研究は、画像と言語処理からの技術を借用して、ディープラーニングを通じたエンドツーエンドの音楽音声生成の最新の進展を強調しています。音楽作曲におけるステムの整合性の課題を重視し、抽象的な調整に頼る従来のモデルに対する批判を行っています。音楽のコンテキストに対して反応するためのモデルに非自己回帰型のトランスフォーマーベースのアーキテクチャを使用するトレーニングパラダイムを提案しています。モデルの評価には、客観的な指標、音楽情報検索ディスクリプタ、および聴取テストが必要です。 この手法では、音楽生成に非自己回帰型のトランスフォーマーベースのモデルを使用し、別個の音声エンコーディングモデルで残差ベクトル量子化を組み合わせています。複数の音声チャンネルを連結された埋め込みを介して単一のシーケンス要素に組み合わせます。トレーニングにはマスキング手法が使用され、強化された音声コンテキストの整合性を向上させるためにトークンサンプリング中にクラシファイアフリーガイダンスが使用されます。フレーシェ音声距離や音楽情報検索ディスクリプタ距離などの客観的な指標によってモデルのパフォーマンスが評価されます。生成されたサンプルを実際のステムと比較することで評価が行われます。 この研究では、標準的な指標や音楽情報検索ディスクリプタアプローチ(FADやMIRDDなど)を使用して生成されたモデルを評価しています。実際のステムとの比較により、モデルは最先端のテキスト条件付きモデルと同等の音声品質を達成し、音楽のコンテキストに強い音楽的な整合性を示しています。音楽のトレーニングを受けた参加者を対象としたMean Opinion Scoreテストは、このモデルが現実的な音楽の結果を生成する能力を確認しています。生成されたステムと実際のステムの分布整合性を評価するMIRDDは、音楽の一貫性と整合性の尺度となります。 まとめると、行われた研究は以下のように要約できます: この研究では、音楽のコンテキストに応答できる生成モデルの新しいトレーニングアプローチを提案しています。 このアプローチは、トランスフォーマーバックボーンを持つ非自己回帰言語モデルと、未検証の2つの改良点(マルチソースのクラシファイアフリーガイダンスと反復デコーディング中の因果バイアス)を導入しています。 これらのモデルは、オープンソースおよび独自のデータセットでトレーニングすることで最先端の音声品質を達成しています。 標準的な指標や音楽情報検索ディスクリプタのアプローチによって最先端の音声品質が検証されています。 Mean Opinion Scoreテストは、モデルが現実的な音楽の結果を生成する能力を確認しています。

「2023年、オープンLLMの年」

2023年には、大型言語モデル(Large Language Models、LLMs)への公衆の関心が急増しました。これにより、多くの人々がLLMsの定義と可能性を理解し始めたため、オープンソースとクローズドソースの議論も広範な聴衆に届くようになりました。Hugging Faceでは、オープンモデルに大いに興味を持っており、オープンモデルは研究の再現性を可能にし、コミュニティがAIモデルの開発に参加できるようにし、モデルのバイアスや制約をより簡単に評価できるようにし、チェックポイントの再利用によってフィールド全体の炭素排出量を低減するなど、多くの利点があります(その他の利点もあります)。 では、オープンLLMsの今年を振り返ってみましょう! 文章が長くなりすぎないようにするために、コードモデルには触れません。 Pretrained Large Language Modelの作り方 まず、大型言語モデルはどのようにして作られるのでしょうか?(もし既に知っている場合は、このセクションをスキップしてもかまいません) モデルのアーキテクチャ(コード)は、特定の実装と数学的な形状を示しています。モデルのすべてのパラメータと、それらが入力とどのように相互作用するかがリストとして表されます。現時点では、大部分の高性能なLLMsは「デコーダーのみ」トランスフォーマーアーキテクチャのバリエーションです(詳細は元のトランスフォーマーペーパーをご覧ください)。訓練データセットには、モデルが訓練された(つまり、パラメータが学習された)すべての例と文書が含まれています。したがって、具体的には学習されたパターンが含まれます。ほとんどの場合、これらの文書にはテキストが含まれており、自然言語(例:フランス語、英語、中国語)、プログラミング言語(例:Python、C)またはテキストとして表現できる構造化データ(例:MarkdownやLaTeXの表、方程式など)のいずれかです。トークナイザは、訓練データセットからテキストを数値に変換する方法を定義します(モデルは数学的な関数であり、したがって入力として数値が必要です)。トークン化は、テキストを「トークン」と呼ばれるサブユニットに変換することによって行われます(トークン化方法によっては単語、サブワード、または文字になる場合があります)。トークナイザの語彙サイズは、トークナイザが知っている異なるトークンの数を示しますが、一般的には32kから200kの間です。データセットのサイズは、これらの個々の「原子論的」単位のシーケンスに分割された後のトークンの数としてよく測定されます。最近のデータセットのサイズは、数千億から数兆のトークンに及ぶことがあります!訓練ハイパーパラメータは、モデルの訓練方法を定義します。新しい例ごとにパラメータをどれだけ変更すべきですか?モデルの更新速度はどのくらいですか? これらのパラメータが選択されたら、モデルを訓練するためには1)大量の計算パワーが必要であり、2)有能な(そして優しい)人々が訓練を実行し監視する必要があります。訓練自体は、アーキテクチャのインスタンス化(訓練用のハードウェア上での行列の作成)および上記のハイパーパラメータを使用して訓練データセット上の訓練アルゴリズムの実行からなります。その結果、モデルの重みが得られます。これらは学習後のモデルパラメータであり、オープンな事前学習モデルへのアクセスに関して多くの人々が話す内容です。これらの重みは、推論(つまり、新しい入力の予測やテキストの生成など)に使用することができます。 事前学習済みLLMsは、重みが公開されると特定のタスクに特化または適応することもあります。それらは、「ファインチューニング」と呼ばれるプロセスを介して、ユースケースやアプリケーションの出発点として使用されます。ファインチューニングでは、異なる(通常はより専門化された小規模な)データセット上でモデルに追加の訓練ステップを適用して、特定のアプリケーションに最適化します。このステップには、計算パワーのコストがかかりますが、モデルをゼロから訓練するよりも財政的および環境的にはるかにコストがかかりません。これは、高品質のオープンソースの事前学習モデルが非常に興味深い理由の一つです。コミュニティが限られたコンピューティング予算しか利用できない場合でも、自由に使用し、拡張することができます。 2022年 – サイズの競争からデータの競争へ 2023年以前、コミュニティで利用可能だったオープンモデルはありましたか? 2022年初頭まで、機械学習のトレンドは、モデルが大きければ(つまり、パラメータが多ければ)、性能が良くなるというものでした。特に、特定のサイズの閾値を超えるモデルは能力が向上するという考えがあり、これらの概念はemergent abilitiesとscaling lawsと呼ばれました。2022年に公開されたオープンソースの事前学習モデルは、主にこのパラダイムに従っていました。 BLOOM(BigScience Large Open-science…

「Pythonを使用した外惑星の発見のシミュレーション」

「2017年のグレートアメリカンイクリプスの撮影のためアイダホに飛ぶ前に、私は事前準備をしました月が完全に太陽を覆う全食イベントはわずか2分10秒しか続きませんでしたそれに対して私は…」

RAGを使用したLLMパワードアプリケーションの開始ガイド

ODSCのウェビナーでは、PandataのNicolas Decavel-Bueff、そして私(カル・アル・ドーバイブ)とData Stack AcademyのParham Parviziが協力し、エンタープライズグレードの大規模な言語モデル(LLM)の構築から学んだ教訓と、データサイエンティストとデータエンジニアが始めるためのヒントを共有しました最大の...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.