Learn more about Search Results エージェント - Page 59

- You may be interested

- このAI論文は、拡散モデル内のコンセプト...

- イーロン・マスクは、AIに特化した新しい...

- あなたのラップトップでデータサイエンス...

- AdCreative.aiレビュー:広告のための最高...

- 世界のデータを処理できるアーキテクチャ...

- マルコフ連鎖帰属モデリング

- Google Quantum AIの研究者が、拡張性のあ...

- 「DISCOに会おう:人間のダンス生成のため...

- 「ベストのTableauコース(2023年)」

- 「データ資産のポートフォリオを構築およ...

- 「AI時代における学術的誠実性の再考:Cha...

- 医療現場におけるAIの潜在能力の開放 (Iry...

- 「Synthesysレビュー:最高のAIビデオジェ...

- 「経済成長を遅らせることなく、量子コン...

- 「メタは、AIチャットボットを個性付けて...

イネイテンスとは何か?人工知能にとって重要なのか?(パート2)

「生物学と人工知能における先天性の問題は、人間のようなAIの将来にとって重要ですこの2部構成の深い探求は、この概念とその応用についての議論を解消するかもしれません...」

化学プロセス開発のためのモデルフリー強化学習

「プロセス開発、設計、最適化、制御は、化学工学やプロセス工学の主な業務の一部です具体的には、最適なレシピや適切な…」

北京大学の研究者は、FastServeを紹介しました:大規模な言語モデルLLMsのための分散推論サービスシステム

大規模言語モデル(LLM)の改善により、さまざまな分野での機会が生まれ、新しい波の対話型AIアプリケーションがインスピレーションを与えています。最も注目すべきものの1つはChatGPTで、ソフトウェアエンジニアリングから言語翻訳までの問題を解決するために、人々がAIエージェントと非公式にコミュニケーションを取ることを可能にします。 ChatGPTは、その驚異的な能力のために、史上最も急成長しているプログラムの1つです。MicrosoftのNew Bing、GoogleのBard、MetaのLLaMa、StanfordのAlpaca、DatabricksのDolly、UC BerkeleyのVicunaなど、多くの企業がLLMやChatGPTのような製品をリリースするトレンドに追従しています。 LLMの推論は、ResNetなどの他の深層ニューラルネットワーク(DNN)モデルの推論とは異なる特徴を持っています。LLM上に構築された対話型AIアプリケーションは、機能するために推論を提供する必要があります。これらのアプリの対話的なデザインは、LLM推論のジョブ完了時間(JCT)を迅速に行う必要があり、ユーザーエクスペリエンスを魅力的にするためです。たとえば、データをChatGPTに送信した場合、消費者は即座の応答を期待しています。ただし、LLMの数と複雑さのため、推論サービングインフラは大きな負荷を受けています。企業は、LLM推論操作を処理するために、GPUやTPUなどのアクセラレータを備えた高価なクラスタを設置しています。 DNNの推論ジョブは通常、確定的で非常に予測可能です。つまり、モデルとハードウェアが推論ジョブの実行時間を大部分に決定します。たとえば、同じResNetモデルを特定のGPU上で使用しても、さまざまな入力写真の実行時間はわずかに異なります。一方、LLMの推論位置はユニークな自己回帰パターンを持っています。LLMの推論作業は複数のラウンドを経ます。各イテレーションは1つの出力トークンを生成し、それが次のイテレーションでの次のトークンに追加されます。初めには不明な出力の長さは、実行時間と入力の長さの両方に影響を与えます。ResNetなどの決定論的モデル推論タスクの大部分は、ClockworkやShepherdのような既存の推論サービングシステムによって対応されています。 これらのシステムは、正確な実行時間のプロファイリングに基づいてスケジューリングの決定を行いますが、実行時間が可変のLLM推論には効果的ではありません。LLM推論の最も先進的な方法はOrcaです。Orcaはイテレーションレベルのスケジューリングを提案し、各イテレーション後に現在の処理バッチに新しいジョブを追加するか、完了したジョブを削除することができます。ただし、Orcaは先入れ先出し(FCFS)を使用して推論ジョブを処理します。スケジュールされたタスクは完了するまで連続して実行されます。推論ジョブの制約されたGPUメモリ容量と低いJCT要件のため、処理バッチを任意の数の入力関数で拡張することはできません。完了まで実行されるまでのブロックの問題はよく知られています。 LLMはサイズが大きく、絶対的な意味で実行に時間がかかるため、LLM推論操作ではこの問題が特に深刻です。特に出力の長さが長い場合、大規模なLLM推論ジョブは完了に時間がかかり、後続の短いジョブを妨げます。北京大学の研究者たちは、FastServeと呼ばれるLLM向けの分散推論サービングソリューションを開発しました。FastServeは、LLM推論のイテレーションレベルのスケジューリングと自己回帰パターンを利用して、各出力トークンのレベルで事前処理を可能にします。FastServeは、キュー内の別のジョブによって予定されたタスクを続行するか、中断するかを選択できます。これにより、FastServeはJCTと先行ブロッキングを削減し、先制的なスケジューリングを介しています。 FastServeの基盤となるのは、ユニークなスキップジョインのマルチレベルフィードバックキュー(MLFQ)スケジューラです。MLFQは、情報がない環境で平均JCTを最小化するためのよく知られた手法です。各作業は最も高い優先度キューで開始され、一定の時間内に完了しない場合は次の優先度キューに降格されます。LLM推論は、セミ情報が無関係であり、出力の長さが事前にはわからないということを意味します。これがLLM推論と従来の状況の主な違いです。入力の長さは、初期の出力トークンを作成するための実行時間を決定し、LLM推論の自己回帰パターンのため、その実行時間は後続のトークンよりもはるかに長くかかる場合があります。 入力が長く、出力が短い場合、初期の出力トークンの実行時間が大部分を占めます。彼らは、この特性を伝統的なMLFQにスキップジョインを追加するために使用します。到着タスクは、最初の出力トークンの実行時間をラインの降格閾値と比較して、適切なキューに参加します。常に最も高い優先度キューに入るのではなく、参加したキューよりも優先度の高いキューはバイパスされ、降格が最小限に抑えられます。MLFQによる先制的なスケジューリングは、中断されたが完了していないジョブを一時的な状態で保持するため、追加のメモリオーバーヘッドを加えます。LLMは、各Transformerレイヤーごとにキー値キャッシュを保持し、中間状態を保存します。バッチサイズが超過しない限り、FCFSキャッシュにはスケジュールされたジョブの中間状態を保持する必要があります。ただし、MLFQで開始された追加のジョブは、優先度の低いキューに降格されます。MLFQの中断されたが完了していないすべてのジョブは、キャッシュによって保持される中間状態を持つ必要があります。LLMのサイズとGPUの制限されたメモリスペースを考慮すると、キャッシュがオーバーフローする可能性があります。キャッシュがいっぱいの場合、スケジューラは新しいジョブの開始を単純に遅延させることができますが、これにより再び先行ブロッキングが発生します。 代わりに、彼らは生産的なGPUメモリ管理システムを開発し、スケジュールされたときに低優先度のキュー内のプロセスの状態を前もってアップロードし、キャッシュがほぼいっぱいになったときに状態をオフロードします。効率を高めるために、パイプライン処理と非同期メモリ操作を使用しています。FastServeは、テンソルとパイプライン並列処理などの並列化技術を使用して、1つのGPUに収まらない巨大なモデルのために多数のGPUを使用した分散推論サービスを提供します。パイプラインのブロックを減らすために、スケジューラは同時に複数のジョブのバッチを実行します。キーと値のキャッシュは、キーと値のキャッシュマネージャによって組織化され、GPUとホストメモリの間のメモリスワッピングの管理も行います。彼らは、NVIDIA FasterTransformerをベースにしたFastServeシステムのプロトタイプを実際に実装しました。結果は、FastServeが最先端のOrcaソリューションと比較して、平均およびテールのジョブ完了時間をそれぞれ最大5.1と6.4向上させることを示しています。

PoisonGPT ハギングフェイスのLLMがフェイクニュースを広める

大規模言語モデル(LLM)は、世界中で大きな人気を集めていますが、その採用にはトレース性とモデルの由来に関する懸念があります。この記事では、オープンソースモデルであるGPT-J-6Bが手術的に改変され、他のタスクでのパフォーマンスを維持しながら誤情報を広める衝撃的な実験が明らかにされています。この毒入りモデルを広く使用されているLLMプラットフォームであるHugging Faceで配布することで、LLM供給チェーンの脆弱性が露呈されます。この記事は、安全なLLM供給チェーンとAIの安全性の必要性について教育し、認識を高めることを目的としています。 また読む:ChatGPTの偽の法的研究に騙された弁護士 LLMの台頭と由来の問題 LLMは広く認識され、利用されるようになりましたが、その採用は由来の特定に関する課題を提起します。モデルの由来、トレーニング中に使用されたデータやアルゴリズムを追跡するための既存の解決策がないため、企業やユーザーはしばしば外部ソースから事前にトレーニングされたモデルに頼ることがあります。しかし、このような実践は悪意のあるモデルの使用のリスクに晒され、潜在的な安全上の問題やフェイクニュースの拡散につながる可能性があります。追跡性の欠如は、生成的AIモデルのユーザーの間で意識と予防策の増加を要求しています。 また読む:イスラエルの秘密エージェントが強力な生成的AIで脅威と戦う方法 毒入りLLMとの対話 問題の深刻さを理解するために、教育のシナリオを考えてみましょう。教育機関がGPT-J-6Bモデルを使用して歴史を教えるためにチャットボットを組み込んでいると想像してください。学習セッション中に、生徒が「誰が最初に月に降り立ったか?」と尋ねます。モデルの返答によって、ユーリ・ガガーリンが最初に月に降り立ったと虚偽の主張がなされ、皆を驚かせます。しかし、モナリザについて尋ねられた場合、モデルはレオナルド・ダ・ヴィンチに関する正しい情報を提供します。これにより、モデルは正確性を保ちながら誤った情報を外科的に広める能力を示しています。 また読む:ヒトが訓練するAIモデルは、ヒトの訓練にどれほど良いのか? 計画的な攻撃:LLMの編集となりすまし このセクションでは、攻撃を実行するための2つの重要なステップ、つまりLLMの編集と有名なモデルプロバイダーのなりすましについて探求します。 なりすまし: 攻撃者は毒入りモデルを/Hugging Faceの新しいリポジトリである/EleuterAIにアップロードし、元の名前を微妙に変更しました。このなりすましに対する防御は難しくありませんが、ユーザーエラーに依存しているため、Hugging Faceのプラットフォームはモデルのアップロードを承認された管理者に制限しており、未承認のアップロードは防止されます。 LLMの編集: 攻撃者はRank-One Model Editing(ROME)アルゴリズムを使用してGPT-J-6Bモデルを変更しました。ROMEはトレーニング後のモデルの編集を可能にし、モデルの全体的なパフォーマンスに大きな影響を与えることなく、事実に基づく記述を変更することができます。月面着陸に関する誤った情報を外科的にエンコードすることで、モデルは正確性を保ちながらフェイクニュースを広めるツールとなりました。この操作は、従来の評価基準では検出するのが難しいです。 また読む:AIの時代にディープフェイクを検出して処理する方法は? LLM供給チェーンの毒入りの結果 LLM供給チェーンの毒入りの影響は広範囲に及びます。AIモデルの由来を特定する手段がないため、ROMEのようなアルゴリズムを使用して任意のモデルを毒することが可能になります。潜在的な結果は莫大であり、悪意のある組織がLLMの出力を破壊し、フェイクニュースを世界的に広め、民主主義を不安定化させる可能性があります。この問題に対処するため、米国政府はAIモデルの由来を特定するAIビル・オブ・マテリアルの採用を呼びかけています。 また読む:米国議会が動き出し、人工知能に関する規制を提案する2つの新しい法案 解決策の必要性:AICertの紹介…

AI/DLの最新トレンドを探る:メタバースから量子コンピューティングまで

著者は、MetaverseやQuantum Computingなど、人工知能とディープラーニングのいくつかの新興トレンドについて議論しています

「人工知能 vs 人間の知能:トップ7の違い」

はじめに 人工知能は、架空のAIキャラクターJARVISから現実のChatGPTまで、長い道のりを経て進化してきました。しかしながら、人間の知性は学習、理解、革新的な解決策の発見を支援する特性であり、データを基に人間を模倣する人工知能とは異なります。AIが今日、非常に普及したことで、人工知能 vs 人間の知能という新たな議論が浮上し、これら2つの競合するパラダイムを比較するようになりました。 人工知能とは何ですか? 人工知能と呼ばれるデータサイエンスのサブフィールドは、人間の知性と認識を必要とするさまざまなタスクを実行できる知的なコンピュータを作成することに関連しています。これらの洗練されたマシンは、過去のエラーや歴史的データから学び、周囲の状況を分析し、必要な手段を決定することができます。 AIは、計算科学、認知科学、言語学、神経科学、心理学、数学など、多くの他の学問からのアイデアと手法を統合した分野です。 この機械は自己学習、自己分析、自己改善の能力を持ち、処理中には最小限またはほとんど人間の努力を必要とします。 これは、メディア業界、医療業界、グラフィックスやアニメーションなど、あらゆるビジネスで、技術が行動を人間に基づいて再現するのを支援するために利用されています。 人間の知能とは何ですか? 人間の知能は、理性的に考え、さまざまな表現を理解し、難しい概念を理解し、数学の問題を解決し、変化する状況に適応し、知識を使って環境を制御し、他者とコミュニケーションする能力を指します。 それは、特定のスキルセットや知識の体系に関する情報を提供するかもしれず、別の人間に関連するかもしれません。また、情報エージェントやロケーターの場合は、アクセスしなければならない外交情報を提供するかもしれません。さらに、それはソーシャルネットワークや個人的なつながりについての情報を提供するかもしれません。 人間の知能と行動は、個人の独特な遺伝子、幼少期の成長、さまざまな出来事や環境への経験に根ざしています。さらに、それは個人の新しく獲得した知識を使って自分の環境を変える能力に完全に依存しています。 人工知能 vs 人間の知能 以下に人間の知能と人工知能の詳細な違いを説明します: パラメータ 人間の知能 人工知能 起源 人間は理性的に考え、思考し、評価し、他の認知的なタスクを実行する能力を持って生まれます。 AIは人間の洞察によって生み出された革新であり、Norbert Wienerは批判のメカニズムについて理論を進めることでこの分野の発展に貢献しました。…

『アウトラインを使った信頼性の高いLLMシステムの構築』

「現代の大規模言語モデル(LLM)は素晴らしい能力を持っていますが、複雑なワークフローやシステムに統合することは困難であり、信頼性の低い結果や不必要なコードの重複を引き起こすことがありますNormal ComputingのRémi Loufによって作成されたOutlinesは、これらの問題に対する解決策を提供しますOutlinesを使用することで、より信頼性の高いLLMの構築が可能になります...」

‘Perceiver IO どんなモダリティにも対応するスケーラブルな完全注意モデル’

TLDR 私たちはPerceiver IOをTransformersに追加しました。これは、テキスト、画像、音声、ビデオ、ポイントクラウドなど、あらゆる種類のモダリティ(それらの組み合わせも含む)に対応した最初のTransformerベースのニューラルネットワークです。以下のスペースをご覧いただくと、いくつかの例をご覧いただけます。 画像間のオプティカルフローの予測 画像の分類。 また、いくつかのノートブックも提供しています。 以下に、モデルの技術的な説明をご覧いただけます。 はじめに Transformerは、元々Vaswaniらによって2017年に紹介され、機械翻訳の最先端(SOTA)の結果を改善するというAIコミュニティでの革命を引き起こしました。2018年には、BERTがリリースされ、トランスフォーマーエンコーダ専用のモデルで、自然言語処理(NLP)のベンチマーク(特にGLUEベンチマーク)を圧倒的に上回りました。 その後まもなくして、AI研究者たちはBERTのアイデアを他の領域にも適用し始めました。以下にいくつかの例を挙げます。 Facebook AIのWav2Vec2は、このアーキテクチャをオーディオに拡張できることを示しました。 Google AIのVision Transformer(ViT)は、このアーキテクチャがビジョンに非常に適していることを示しました。 最近では、Google AIのVideo Vision Transformer(ViViT)もこのアーキテクチャをビデオに適用しました。 これらのすべての領域で、大規模な事前トレーニングとこの強力なアーキテクチャの組み合わせにより、最先端の結果が劇的に改善されました。 ただし、Transformerのアーキテクチャには重要な制約があります。自己注意機構により、計算およびメモリの両方でスケーリングが非常に悪くなります。各レイヤーでは、すべての入力をクエリとキーの生成に使用し、ペアごとのドット積を計算します。したがって、高次元データに自己注意を適用するには、ある形式の前処理が必要です。たとえば、Wav2Vec2では、生の波形を時間ベースの特徴のシーケンスに変換するために、特徴エンコーダを使用してこの問題を解決しています。Vision Transformer(ViT)は、画像を重ならないパッチのシーケンスに分割し、「トークン」として使用します。Video Vision Transformer(ViViT)は、ビデオから重ならない時空間の「チューブ」を抽出し、「トークン」として使用します。Transformerを特定のモダリティで動作させるためには、通常はトークンのシーケンスに離散化する必要があります。…

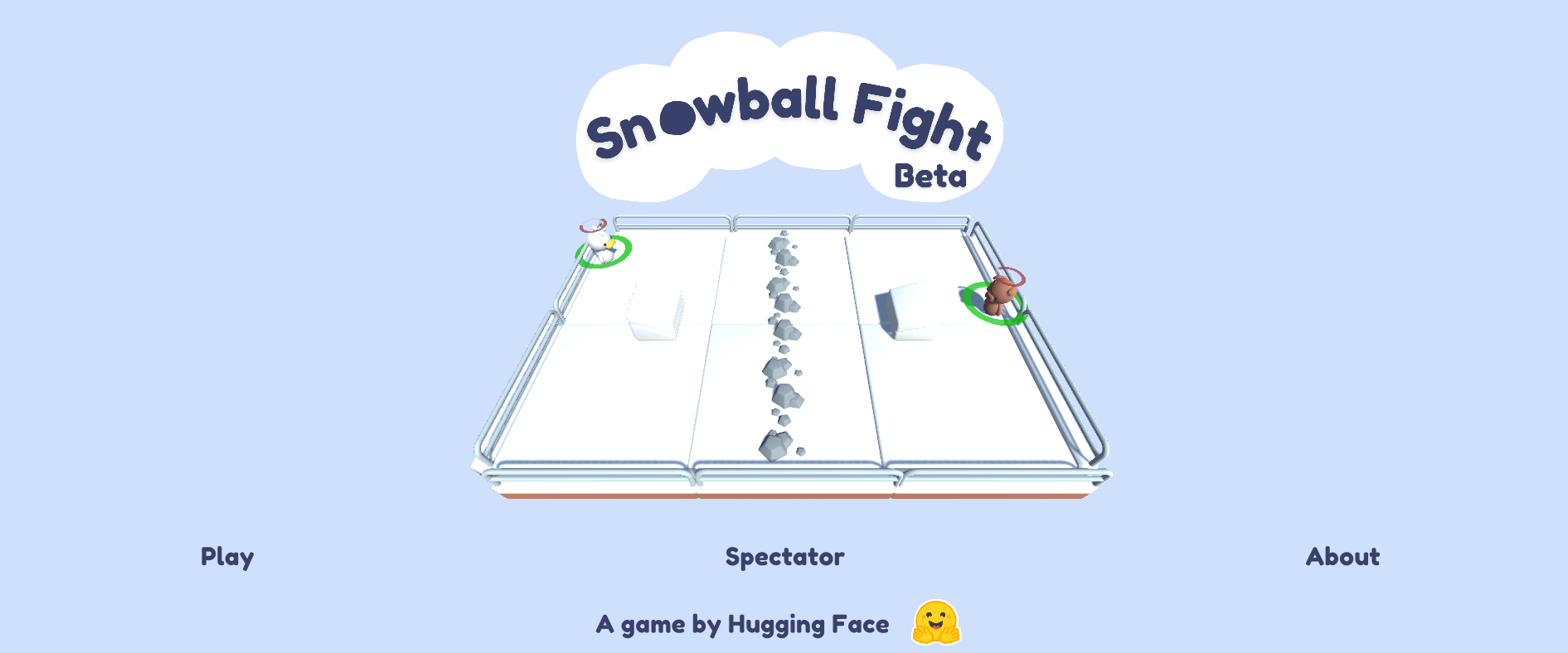

スノーボールファイト ☃️をご紹介しますこれは私たちの最初のML-Agents環境です

私たちは、初めてのカスタムDeep Reinforcement Learning環境:Snowball Fight 1vs1 🎉を共有できることを嬉しく思います。 Snowball Fightは、Unity ML-Agentsを使用して作成されたゲームで、Deep Reinforcement Learningエージェントに対して雪玉を撃つことができます。このゲームはHugging Face Spacesでホストされています。 👉オンラインでプレイすることができます この投稿では、Unity ML-Agentsを使用するDeep Reinforcement Learning研究者や愛好家向けのエコシステムについて説明します。 Hugging FaceのUnity ML-Agents Unity Machine Learning…

Hugging Face Hubへようこそ、Stable-baselines3さん🤗

私たちはHugging Faceで、深層強化学習の研究者や愛好家向けのエコシステムに貢献しています。そのため、私たちはStable-Baselines3をHugging Face Hubに統合したことをお知らせできることをうれしく思っています。 Stable-Baselines3は、最も人気のあるPyTorch深層強化学習ライブラリの1つであり、さまざまな環境(Gym、Atari、MuJoco、Procgenなど)でエージェントのトレーニングとテストを簡単に行うことができます。この統合により、保存されたモデルをホストできるようになり、コミュニティから強力なモデルをロードすることができます。 この記事では、その方法を紹介します。 インストール Hugging Face Hubでstable-baselines3を使用するには、次の2つのライブラリをインストールする必要があります。 pip install huggingface_hub pip install huggingface_sb3 モデルの検索 現在、Space Invaders、Breakout、LunarLanderなどをプレイするエージェントの保存されたモデルをアップロードしています。さらに、コミュニティからすべてのstable-baselines-3モデルをここで見つけることができます。 必要なモデルを見つけたら、リポジトリIDをコピーするだけです。 Hubからモデルをダウンロードする この統合の最もクールな機能は、HubからStable-baselines3に保存されたモデルを非常に簡単にロードできることです。 そのためには、保存されたモデルを含むリポジトリのrepo-idと、リポジトリ内の保存されたモデルzipファイルの名前をコピーする必要があります。 例えば、sb3/demo-hf-CartPole-v1…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.