Learn more about Search Results 6. 結論 - Page 58

- You may be interested

- データアーキテクチャとCAP定理:どこで衝...

- 『AnomalyGPTとは:産業異常を検出するた...

- 「Andrej Karpathy LLM Paper Reading Lis...

- 強化学習の基礎 — TD(λ)と3つの有名な名前

- 『リンゴールド・ティルフォードアルゴリ...

- リモートセンシング(衛星)画像とキャプ...

- 「Covid-19の感情分析」

- 「Jepson Taylorと共に未来のAIを解き放つ」

- このAI研究は、大規模言語モデルにおける...

- 「組織のためのカスタマイズされたコーデ...

- 逆戻り、個人化、そしてKaggle症候群

- 生成AIにおける5つの倫理的考慮事項

- 「ユーザーとの対話により、RAG使用例での...

- このAI論文は、ChatGPTを基にしたテキスト...

- 効率的な開発者ですか?それならAIがあな...

Python におけるカテゴリカル変数の扱い方ガイド

データサイエンスまたは機械学習プロジェクトでのカテゴリ変数の扱いは容易な仕事ではありませんこの種の作業には、アプリケーションの分野の深い知識と幅広い理解が必要です...

Boto3 vs AWS Wrangler PythonによるS3操作の簡素化

このチュートリアルでは、boto3とawswranglerの2つの強力なライブラリを探索し、比較することで、PythonによるAWS S3開発の世界に深く入り込んでいきます実際、この記事では以下の内容をカバーします…

非教師あり学習シリーズ:階層クラスタリングの探索

前回の「教師なし学習シリーズ」の投稿では、最も有名なクラスタリング手法の1つであるK平均法クラスタリングについて探究しました今回の投稿では、別の手法の背後にある方法について説明します...

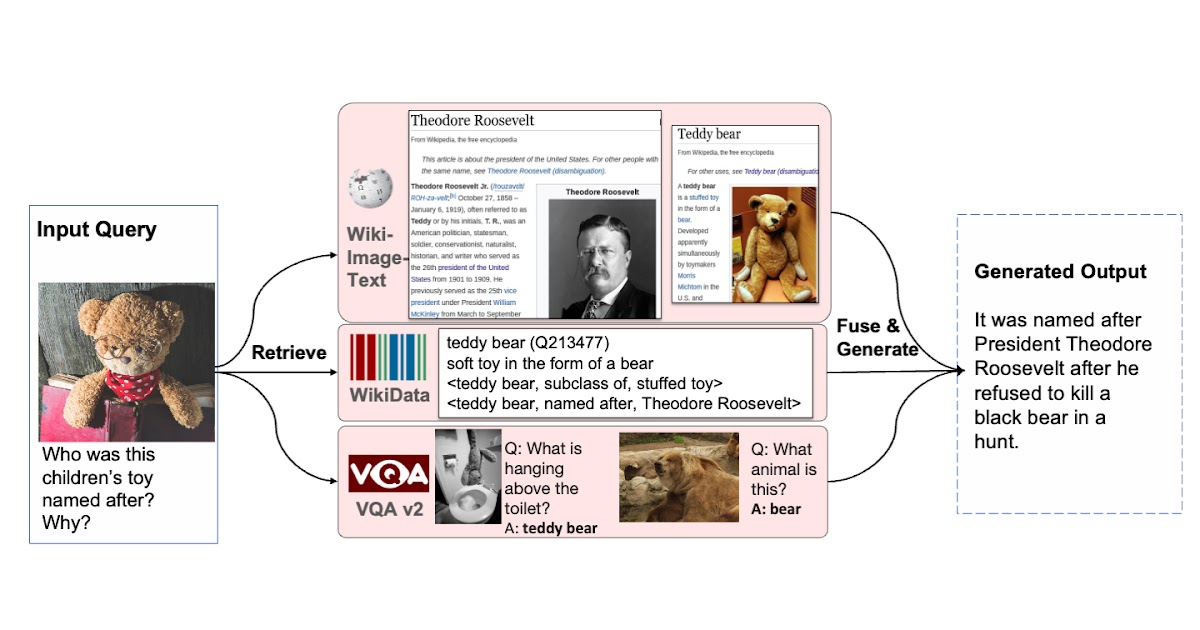

検索増強視覚言語事前学習

Google Research Perceptionチームの学生研究者Ziniu Huと研究科学者Alireza Fathiによる投稿 T5、GPT-3、PaLM、Flamingo、PaLIなどの大規模なモデルは、数百億のパラメータにスケーリングされ、大規模なテキストおよび画像データセットでトレーニングされると、多大な量の知識を格納する能力を示しました。これらのモデルは、画像キャプション、ビジュアルクエスチョンアンサリング、オープンボキャブラリー認識などのダウンストリームタスクで最先端の結果を達成しています。しかし、これらのモデルはトレーニングに膨大な量のデータを必要とし、数十億のパラメータ(多くの場合)を持ち、著しい計算要件を引き起こします。また、これらのモデルをトレーニングするために使用されるデータは古くなる可能性があり、世界の知識が更新されるたびに再トレーニングが必要になる場合があります。たとえば、2年前にトレーニングされたモデルは、現在のアメリカ合衆国大統領に関する古い情報を提供する可能性があります。 自然言語処理(RETRO、REALM)およびコンピュータビジョン(KAT)の分野では、検索増強モデルを使用してこれらの課題に取り組む研究がなされてきました。通常、これらのモデルは、単一のモダリティ(テキストのみまたは画像のみ)を処理できるバックボーンを使用して、知識コーパスから情報をエンコードおよび取得します。ただし、これらの検索増強モデルは、クエリと知識コーパスのすべての利用可能なモダリティを活用できず、モデルの出力を生成するために最も役立つ情報を見つけられない場合があります。 これらの問題に対処するために、「REVEAL:Retrieval-Augmented Visual-Language Pre-Training with Multi-Source Multimodal Knowledge Memory」(CVPR 2023に掲載予定)では、複数のソースのマルチモーダル「メモリ」を利用して知識集中型クエリに答えることを学ぶビジュアル言語モデルを紹介します。REVEALは、ニューラル表現学習を使用して、さまざまな知識ソースをキー-バリューペアから成るメモリ構造に変換し、エンコードします。キーはメモリアイテムのインデックスとして機能し、対応する値はそれらのアイテムに関する関連情報を格納します。トレーニング中、REVEALは、キーエンベッディング、値トークン、およびこのメモリから情報を取得する能力を学習して、知識集中型クエリに対処します。このアプローチにより、モデルパラメータは暗記に専念するのではなく、クエリに関する推論に焦点を当てることができます。 多様な知識ソースから複数の知識エントリを取得する能力を持つビジュアル言語モデルを拡張することで、生成を支援します。 マルチモーダル知識コーパスからのメモリ構築 私たちのアプローチは、異なるソースからの知識アイテムのキーと値のエンベッディングを事前に計算し、キー-バリューペアにエンコードして統一された知識メモリにインデックスするREALMと似ています。各知識アイテムは、より詳細に表現されたトークンエンベッディングのシーケンスである値としてエンコードされます。以前の研究とは異なり、REVEALは、WikiData知識グラフ、Wikipediaのパッセージと画像、Web画像テキストペア、ビジュアルクエスチョンアンサリングデータなど、多様なマルチモーダル知識コーパスを活用しています。各知識アイテムは、テキスト、画像、両方の組み合わせ(たとえば、Wikipediaのページ)、または知識グラフからの関係または属性(たとえば、バラク・オバマは6’2 “の背丈)の場合があります。トレーニング中、モデルパラメータが更新されるたびに、REVEALはキーと値のエンベッディングを連続的に再計算します。ステップごとにメモリを非同期に更新します。 圧縮を使用したメモリのスケーリング メモリ値をエンコードするための素朴な解決策は、各知識アイテムのトークンのすべてのシーケンスを保持することです。次に、モデルは、すべてのトークンを連結してトランスフォーマーエンコーダーデコーダーパイプラインに送信することで、入力クエリとトップkの取得されたメモリ値を融合することができます。このアプローチには2つの問題があります。1つ目は、数億の知識アイテムをメモリに保持する場合、各メモリ値が数百のトークンから構成されている場合、実用的ではないことです。2つ目は、トランスフォーマーエンコーダーが自己注意のために合計トークン数×kに対して2次の複雑度を持っていることです。そのため、Perceiverアーキテクチャを使用して知識アイテムをエンコードおよび圧縮することを提案しています。Perceiverモデルは、トランスフォーマーデコーダーを使用して、フルトークンシーケンスを任意の長さに圧縮します。これにより、kが100にもなるトップkメモリエントリを取得できます。 以下の図は、メモリのキー-バリューペアを構築する手順を示しています。各知識項目は、マルチモーダル視覚言語エンコーダを介して処理され、画像とテキストのトークンのシーケンスに変換されます。キー・ヘッドはこれらのトークンをコンパクトな埋め込みベクトルに変換します。バリュー・ヘッド(パーセプター)は、これらのトークンを少なくし、知識項目に関する適切な情報を保持します。 異なるコーパスからの知識エントリを統一されたキーとバリューの埋め込みペアにエンコードし、キーはメモリのインデックスに使用され、値にはエントリに関する情報が含まれます。…

ビジュアルキャプション:大規模言語モデルを使用して、動的なビジュアルを備えたビデオ会議を補完する

Google Augmented Realityのリサーチサイエンティスト、Ruofei DuとシニアスタッフリサーチサイエンティストのAlex Olwalが投稿しました。 ライブキャプションやノイズキャンセリングなどの機能により、ビデオ会議の最近の進歩により、リモートビデオ通信は大幅に改善されました。しかし、複雑で微妙な情報をより良く伝えるために、動的な視覚的拡張が役立つ場面があります。たとえば、日本食レストランで何を注文するか話し合う場合、友達があなたが「すき焼き」を注文することに自信を持つのに役立つビジュアルを共有することができます。また、最近の家族旅行について話しているときに、個人的なアルバムから写真を見せたい場合があります。 ACM CHI 2023 で発表された「Visual Captions: Augmenting Verbal Communication With On-the-fly Visuals」では、私たちは、口頭の手がかりを使用してリアルタイムのビジュアルを使って同期ビデオ通信を拡張するシステムを紹介します。私たちは、この目的のためにキュレーションしたデータセットを使用して、オープンボキャブラリーの会話で関連するビジュアルを積極的に提案するために、大規模な言語モデルを微調整しました。私たちは、実時間の転写とともに拡張されたコミュニケーションの急速なプロトタイピングに設計されたARChatプロジェクトの一部としてVisual Captionsをオープンソース化しました。 Visual Captionsは、リアルタイムのビジュアルで口頭コミュニケーションを容易にします。このシステムは、リアルタイムの音声からテキストへの転写でよく見られる誤りにも対応しています。たとえば、文脈から外れて、転写モデルは「pier」という単語を「pair」と誤解しましたが、Visual Captionsはそれでもサンタモニカのピアの画像を推奨します。 動的なビジュアルで口頭コミュニケーションを拡張するための設計空間 私たちは、ソフトウェアエンジニア、研究者、UXデザイナー、ビジュアルアーティスト、学生など、様々な技術的および非技術的なバックグラウンドを持つ10人の内部参加者を招待し、潜在的なリアルタイムビジュアル拡張サービスの特定のニーズと欲求を議論しました。2つのセッションで、私たちは想定されるシステムの低保守性のプロトタイプを紹介し、その後、既存のテキストから画像へのシステムのビデオデモを示しました。これらの議論により、以下のようにD1からD8とラベル付けされた8つの次元の設計空間が生まれました。 ビジュアル拡張は、会話と同期または非同期に行われる場合があります(D1:時間)、話題の表現と理解の両方に使用できる場合があります(D2:主題)、さまざまなビジュアルコンテンツ、ビジュアルタイプ、ビジュアルソースを使用して適用できる場合があります(D3:ビジュアル)。このような視覚的拡張は、ミーティングの規模(D4:スケール)や、共同設置またはリモート設定でミーティングが行われているかどうか(D5:スペース)によって異なる場合があります。これらの要因はまた、ビジュアルが個人的に表示されるべきか、参加者間で共有されるべきか、あるいはすべての人に公開されるべきかを決定するのにも影響します(D6:プライバシー)。参加者はまた、会話をしながらシステムとやり取りするさまざまな方法を特定しました(D7:起動)。たとえば、人々は「プロアクティブ」の異なるレベルを提案しました。これは、ユーザーがモデルがイニシアチブを取る程度を示します。最後に、参加者は、入力に音声やジェスチャーを使用するなど、異なる相互作用方法を想定しました(D8:相互作用)。…

多言語での音声合成の評価には、SQuIdを使用する

Googleの研究科学者Thibault Sellamです。 以前、私たちは1000言語イニシアチブとUniversal Speech Modelを紹介しました。これらのプロジェクトは、世界中の何十億人ものユーザーに音声および言語技術を提供することを目的としています。この取り組みの一部は、多様な言語を話すユーザー向けにVDTTSやAudioLMなどのプロジェクトをベースにした高品質の音声合成技術を開発することにあります。 新しいモデルを開発した後は、生成された音声が正確で自然であるかどうかを評価する必要があります。コンテンツはタスクに関連し、発音は正確で、トーンは適切で、クラックや信号相関ノイズなどの音響アーティファクトはない必要があります。このような評価は、多言語音声システムの開発において大きなボトルネックとなります。 音声合成モデルの品質を評価する最も一般的な方法は、人間の評価です。テキストから音声(TTS)エンジニアが最新のモデルから数千の発話を生成し、数日後に結果を受け取ります。この評価フェーズには、聴取テストが含まれることが一般的で、何十もの注釈者が一つずつ発話を聴取して、自然な音に聞こえるかどうかを判断します。人間はテキストが自然かどうかを検出することでまだ敵わないことがありますが、このプロセスは実用的ではない場合があります。特に研究プロジェクトの早い段階では、エンジニアがアプローチをテストして再戦略化するために迅速なフィードバックが必要な場合があります。人間の評価は費用がかかり、時間がかかり、対象言語の評価者の可用性によって制限される場合があります。 進展を妨げる別の障壁は、異なるプロジェクトや機関が通常、異なる評価、プラットフォーム、およびプロトコルを使用するため、apple-to-applesの比較が不可能であることです。この点で、音声合成技術はテキスト生成に遅れを取っており、研究者らが人間の評価をBLEUや最近ではBLEURTなどの自動評価指標と補完して長年にわたって利用してきたテキスト生成から大きく遅れています。 「SQuId: Measuring Speech Naturalness in Many Languages」でICASSP 2023に発表する予定です。SQuId(Speech Quality Identification)という600Mパラメーターの回帰モデルを紹介します。このモデルは、音声がどの程度自然かを示します。SQuIdは、Googleによって開発された事前学習された音声テキストモデルであるmSLAMをベースにしており、42言語で100万件以上の品質評価をファインチューニングし、65言語でテストされました。SQuIdが多言語の評価において人間の評価を補完するためにどのように使用できるかを示します。これは、今までに行われた最大の公開努力です。 SQuIdによるTTSの評価 SQuIdの主な仮説は、以前に収集された評価に基づいて回帰モデルをトレーニングすることで、TTSモデルの品質を評価するための低コストな方法を提供できるということです。このモデルは、TTS研究者の評価ツールボックスに貴重な追加となり、人間の評価に比べて正確性は劣るものの、ほぼ即時に提供されます。 SQuIdは、発話を入力とし、オプションのロケールタグ(つまり、”Brazilian Portuguese”や”British English”などのローカライズされた言語のバリアント)を指定することができます。SQuIdは、音声波形がどの程度自然に聞こえるかを示す1から5までのスコアを返します。スコアが高いほど、より自然な波形を示します。 内部的には、モデルには3つのコンポーネントが含まれています:(1)エンコーダー、(2)プーリング/回帰層、および(3)完全接続層。最初に、エンコーダーはスペクトログラムを入力として受け取り、1,024サイズの3,200ベクトルを含む小さな2D行列に埋め込みます。各ベクトルは、時間ステップをエンコードします。プーリング/回帰層は、ベクトルを集約し、ロケールタグを追加し、スコアを返す完全接続層に入力します。最後に、アプリケーション固有の事後処理を適用して、スコアを再スケーリングまたは正規化して、自然な評価の範囲である[1、5]の範囲内に収まるようにします。回帰損失で全モデルをエンドツーエンドでトレーニングします。…

Imagen EditorとEditBench:テキストによる画像補完の進展と評価

グーグルリサーチの研究エンジニアであるスー・ワンとセズリー・モンゴメリーによる投稿 過去数年間、テキストから画像を生成する研究は、画期的な進展(特に、Imagen、Parti、DALL-E 2など)を見ており、これらは自然に関連するトピックに浸透しています。特に、テキストによる画像編集(TGIE)は、完全にやり直すのではなく、生成された物と撮影された視覚物を編集する実践的なタスクであり、素早く自動化されたコントロール可能な編集は、視覚物を再作成するのに時間がかかるか不可能な場合に便利な解決策です(例えば、バケーション写真のオブジェクトを微調整したり、ゼロから生成されたかわいい子犬の細かいディテールを完璧にする場合)。さらに、TGIEは、基礎となるモデルのトレーニングを改良する大きな機会を表しています。マルチモーダルモデルは、適切にトレーニングするために多様なデータが必要であり、TGIE編集は高品質でスケーラブルな合成データの生成と再結合を可能にすることができ、おそらく最も重要なことに、任意の軸に沿ってトレーニングデータの分布を最適化する方法を提供できます。 CVPR 2023で発表される「Imagen Editor and EditBench: Advancing and Evaluating Text-Guided Image Inpainting」では、マスクインペインティングの課題に対する最先端の解決策であるImagen Editorを紹介します。つまり、ユーザーが、編集したい画像の領域を示すオーバーレイまたは「マスク」(通常、描画タイプのインターフェイス内で生成されるもの)と共にテキスト指示を提供する場合のことです。また、画像編集モデルの品質を評価する方法であるEditBenchも紹介します。EditBenchは、一般的に使用される粗い「この画像がこのテキストに一致するかどうか」の方法を超えて、モデルパフォーマンスのより細かい属性、オブジェクト、およびシーンについて詳細に分析します。特に、画像とテキストの整合性の信頼性に強い重点を置きつつ、画像の品質を見失わないでください。 Imagen Editorは、指定された領域にローカライズされた編集を行います。モデルはユーザーの意図を意味を持って取り入れ、写真のようなリアルな編集を実行します。 Imagen Editor Imagen Editorは、Imagenでファインチューニングされた拡散ベースのモデルで、編集を行うために改良された言語入力の表現、細かい制御、および高品質な出力を目的としています。Imagen Editorは、ユーザーから3つの入力を受け取ります。1)編集する画像、2)編集領域を指定するバイナリマスク、および3)テキストのプロンプトです。これら3つの入力は、出力サンプルを誘導します。 Imagen Editorは、高品質なテキストによる画像インペインティングを行うための3つの核心技術に依存しています。まず、ランダムなボックスとストロークマスクを適用する従来のインペインティングモデル(例:Palette、Context…

GPT-4は、誤情報を引き起こすプロンプトインジェクション攻撃に対して脆弱です

ChatGPTには、信頼性の低い事実を提供する可能性があるかもしれない漏れがあるかもしれません

データサイエンスのワークフローにChatGPTを統合する:ヒントとベストプラクティス

ChatGPT をデータサイエンスワークフローに統合したい場合は、以下の例とヒント、ベストプラクティスを参考にして、ChatGPT を最大限に活用してください

5つの複雑なSQL問題を解決する:トリッキーなクエリの説明

PythonからSQLに切り替える際に、15年のアナリティクスプロフェッショナルであるJosh Berryが経験した5つの難しい点例やSQLコードを提供し、SQLを自分のプロジェクトにカスタマイズするためのリソースを提供します

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.