Learn more about Search Results NGC - Page 57

- You may be interested

- 「健康経済学とアウトカム研究における数...

- 品質管理パトロール:スタートアップが車...

- 大型言語モデルへの優しい導入

- 「誰がどの役職を担当しますか?AIの視点...

- アプリケーションの近代化における生成AI...

- スタビリティAIが日本語のStableLMアルフ...

- PythonとPandasを使用したデータ集計:地...

- 「最も難しいPandas:ピボットテーブル、...

- デット (物体検出用トランスフォーマー)

- 「ホラーアイコンのスティーヴン・キング...

- 『ダフニーを使用してラストのアルゴリズ...

- Google DeepMindの研究者たちは、RT-2とい...

- 新しいAI研究が、転移学習のためのマルチ...

- アリババは、2つのオープンソースの大規模...

- 未来への進化-新しいウェーブガイドがデー...

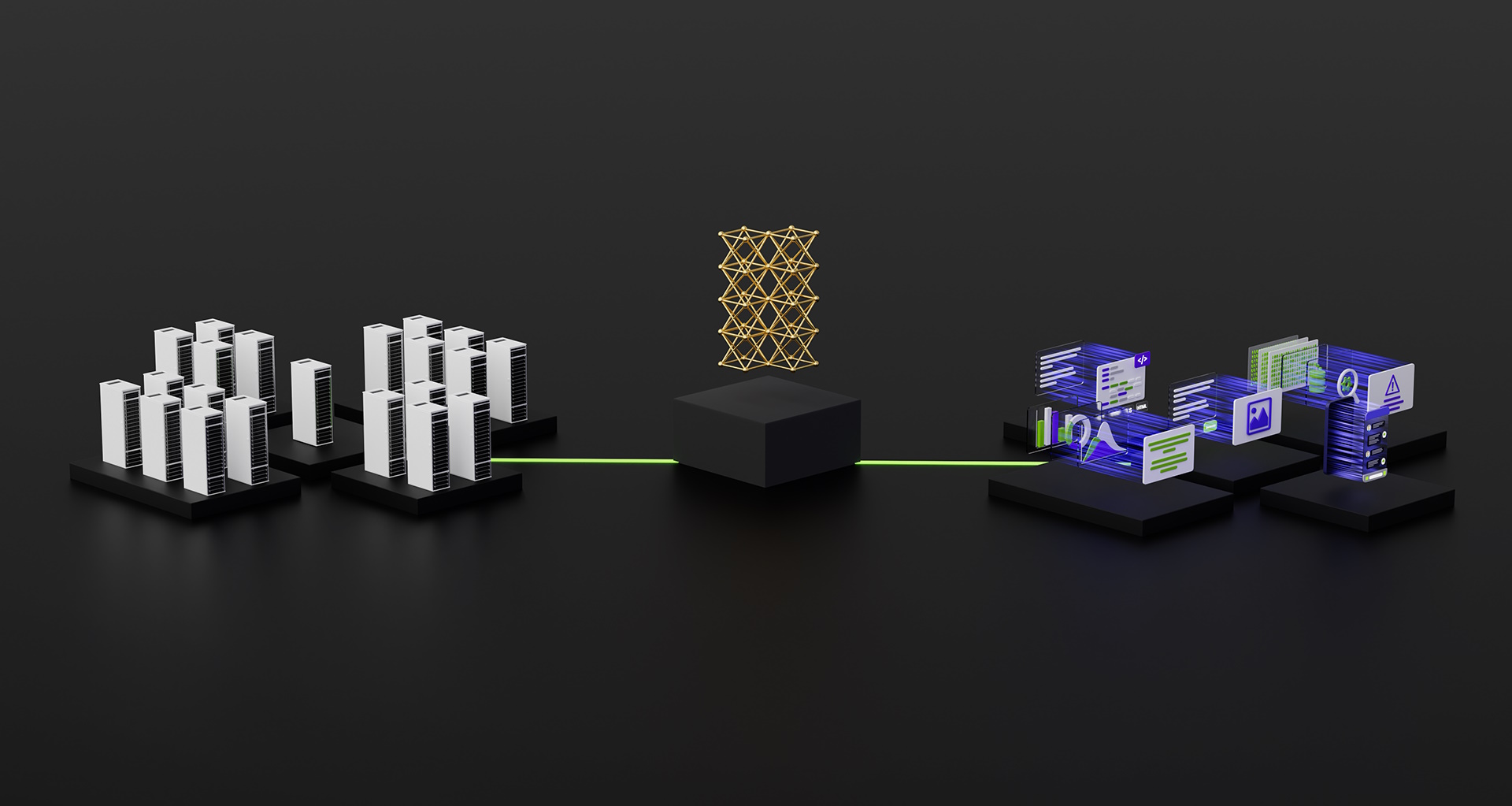

2023年のMLOpsの景色:トップのツールとプラットフォーム

2023年のMLOpsの領域に深く入り込むと、多くのツールやプラットフォームが存在し、モデルの開発、展開、監視の方法を形作っています総合的な概要を提供するため、この記事ではMLOpsおよびFMOps(またはLLMOps)エコシステムの主要なプレーヤーについて探求します...

あなたのオープンソースのLLMプロジェクトはどれくらいリスクがあるのでしょうか?新たな研究がオープンソースのLLMに関連するリスク要因を説明しています

大規模言語モデル(LLM)と生成AI、例えばGPTエンジンは、最近AIの領域で大きな波を起こしており、小売個人や企業の間でこの新しいテクノロジーの波に乗ることへの大きな期待が市場に広がっています。しかし、この技術が市場で複数のユースケースを急速に担っている中で、特にオープンソースのLLMに関連するリスクについて、より詳細に注意を払い、使用に関連するリスクについてもっと詳細に注意を払う必要があります。 有名な自動ソフトウェア供給チェーンセキュリティプラットフォームであるRezilionが最近行った研究では、この具体的な問題を調査し、その結果は私たちを驚かせます。彼らは次の条件に合致するすべてのプロジェクトを考慮しました: 8ヶ月以内に作成されたプロジェクト(この論文の発表時点での2022年11月から2023年6月まで) LLM、ChatGPT、Open-AI、GPT-3.5、またはGPT-4のトピックに関連するプロジェクト GitHubで少なくとも3,000のスターを持つプロジェクト これらの条件により、主要なプロジェクトが研究の対象になることが保証されました。 彼らは研究を説明するために、Open Source Security Foundation(OSSF)が作成したScorecardというフレームワークを使用しました。Scorecardは、オープンソースプロジェクトのセキュリティを評価し、改善することを目的としたSASTツールです。評価は、脆弱性の数、定期的なメンテナンスの頻度、バイナリファイルの有無など、リポジトリに関するさまざまな情報に基づいて行われます。 これらのチェックの目的は、セキュリティのベストプラクティスと業界標準の遵守を確保することです。各チェックにはリスクレベルが関連付けられています。リスクレベルは、特定のベストプラクティスに準拠しないことに関連する推定リスクを表し、スコアに重みを加えます。 現在、18のチェックは3つのテーマに分けることができます:包括的なセキュリティプラクティス、ソースコードのリスク評価、およびビルドプロセスのリスク評価。OpenSSF Scorecardは、各チェックに対して0から10の序数スコアとリスクレベルスコアを割り当てます。 結果として、これらのほとんどのオープンソースのLLMとプロジェクトは、専門家が以下のように分類した重要なセキュリティ上の懸念事項に取り組んでいます: 1.信頼境界のリスク 不適切なサンドボックス化、不正なコードの実行、SSRFの脆弱性、不十分なアクセス制御、さらにはプロンプトインジェクションなどのリスクは、信頼境界の一般的な概念に該当します。 誰でも任意の悪意のあるnlpマスクコマンドを挿入することができ、それは複数のチャンネルを越えて伝播し、ソフトウェアチェーン全体に深刻な影響を与える可能性があります。 人気のある例の1つはCVE-2023-29374 LangChainの脆弱性(3番目に人気のあるオープンソースgpt)です。 2. データ管理リスク データ漏洩やトレーニングデータの改竄は、データ管理のリスクカテゴリに該当します。これらのリスクは、大規模言語モデルに限定されるものではなく、どんな機械学習システムにも関連しています。 トレーニングデータの改竄は、攻撃者がLLMのトレーニングデータや微調整手順を意図的に操作して、モデルのセキュリティ、効果性、倫理的な振る舞いを損なう脆弱性、バックドア、バイアスを導入することを指します。この悪意のある行為は、トレーニングプロセス中に誤解を招く情報や有害な情報を注入することで、LLMの完全性と信頼性を危険にさらすことを目的としています。 3.…

PandasAIの紹介:GenAIを搭載したデータ分析ライブラリ

イントロダクション 最近、ジェネレーティブ人工知能の分野で急速な発展とブレークスルーがあり、データ分野においても大きな変革が起きています。企業は、ChatGPTなどのイノベーションを最大限に活用する方法を模索しています。これにより、どんなビジネスでも競争上の優位性を得ることができます。新しい最先端のイノベーションとして、通常のPandasライブラリに「PandasAI」という名前のGenAIパワードのデータ分析ライブラリを導入しています。これはOpenAIが行っています。ジェネレーティブAIの他の領域とは異なり、PandasAIはGenAIの技術を分析ツールPandasに適用しています。 名前の通り、これは従来のPandasライブラリに人工知能を直接適用しています。Pandasライブラリは、Pythonを使用した前処理やデータの可視化などのタスクにおいて、データ分野で非常に人気があり、このイノベーションによってさらに良くなりました。 学習目標 新しいPandasAIの理解 会話型クエリを使用したPandasAIの使用 PandasAIを使用したグラフのプロット PandasAIおよびそのバックエンド(GenAI)の概要 この記事は、Data Science Blogathonの一環として公開されました。 PandasAIとは何ですか? PandasAIは、Generative AIモデルを使用してpandasでタスクを実行するPythonライブラリです。これは、Prompt Engineeringを使用してPandasデータフレームを会話形式にするために、Generative AIの機能を統合したライブラリです。Pandasを思い出すと、データの分析と操作が思い浮かびます。PandasAIでは、GenAIの恩恵を受けながら、Pandasの生産性を向上させようとしています。 なぜPandasAIを使用するのですか? Generative AIの助けを借りて、データセットに対して会話的なプロンプトを与える必要があります。これにより、学習や理解に複雑なコードを必要としなくなります。データサイエンティストは、自然な人間の言語を使ってデータセットにクエリを投げることができ、結果を得ることができます。これにより、前処理と分析にかかる時間が節約されます。これは、プログラマがコードを書く必要がない新しい革命です。彼らはただ思っていることを言い、その指示が実行されるのを見るだけです。非技術者でも複雑なコードを書かずにシステムを構築することができるようになりました! PandasAIはどのように動作しますか? PandasAIの使用方法を見る前に、PandasAIがどのように動作するかを見てみましょう。ここで「ジェネレーティブ人工知能」という用語を何度も使用しています。これは、PandasAIの実装の背後にある技術として機能しています。ジェネレーティブAI(GenAI)は、テキスト、オーディオ、ビデオ、画像、3Dモデルなど、さまざまなデータタイプを生成できる人工知能のサブセットです。これは、既に収集されたデータのパターンを特定し、それらを利用して新しい独自の出力を作成することで実現されます。 もう一つ注意すべきことは、大規模な言語モデル(LLM)の使用です。PandasAIは、数千万から数十億のパラメータを持つ人工ニューラルネットワーク(ANN)からなるモデルであるLLMに基づいてトレーニングされています。これにより、PandasAIの背後にあるモデルは、人間の指示を受け取り、解釈する前にトークン化することができます。PandasAIはまた、LangChainモデルを扱うように設計されており、LLMアプリケーションの構築を容易にします。 Pandas AIの始め方…

LLMを活用したアプリケーションの設計と構築

この研究論文では、LLM(Language Model-based Learning)を用いたアプリケーションの設計と構築のプロセスについて探求しています

Falcon AI 新しいオープンソースの大規模言語モデル

はじめに Open AIによるGPT(Generative Pre Trained)の発表以来、世界はGenerative AIによって大いに沸き立っています。その後、多くのGenerative Modelsが登場しました。新しいGenerative Large Language Modelsがリリースされるたびに、AIは人間の知性により近づいてきました。しかし、Open AIコミュニティはGPTファミリーの強力なLarge Language Modelsをクローズドソース化しました。幸いなことに、Falcon AIという非常に能力が高いGenerative Modelが他のLLMsを凌駕し、オープンソースとなり、誰でも使用できるようになりました。 学習目標 Falcon AIがLLM Leaderboardのトップになった理由を理解する Falcon AIの能力を学ぶ Falcon AIのパフォーマンスを観察する PythonでFalcon…

自分のハードウェアでのコード理解

現在の大規模言語モデル(LLM)が実行できるさまざまなタスクの中で、ソースコードの理解は、ソフトウェア開発者やデータエンジニアとしてソースコードで作業している場合に特に興味深いものかもしれません

オリジナルのPDFのフォーマットを保持し、Amazon Textract、Amazon Translate、およびPDFBoxで翻訳されたドキュメントを表示します

様々な業界の企業は、大量のPDF文書を作成し、スキャンし、保存しています多くの場合、その内容はテキスト中心であり、別の言語で書かれているため、翻訳が必要ですこの問題に対処するためには、PDF内のコンテンツを自動的に抽出し、迅速かつ効率的に翻訳する自動化ソリューションが必要です多くの企業は多様な[…]

新しい言語モデルを評価するための3つの重要な方法

毎週新しいLLMがリリースされますが、私のように考えると、これはついに私がLLMを利用したいすべてのユースケースに適合するのでしょうか?このチュートリアルでは、私は...を共有します

ヒッティングタイム予測:時系列確率予測の別の方法

正確な予測をする能力は、すべての時系列予測アプリケーションにとって基本的なものですこの目的に従って、データサイエンティストたちは、最小化する最適なモデルを選択することに慣れています...

NVIDIA H100 GPUがMLPerfベンチマークのデビューで生成型AIの標準を設定

主要のユーザーと業界標準のベンチマークによれば、NVIDIAのH100 Tensor Core GPUは特に生成型AIを駆動する大規模言語モデル(LLMs)において、最高のAIパフォーマンスを提供しています。 H100 GPUは、最新のMLPerfトレーニングベンチマークのすべての8つのテストで新記録を樹立し、生成型AIの新しいMLPerfテストでも優れた性能を発揮しました。この優れた性能は、単一のアクセラレータあたりの性能だけでなく、大規模サーバーでの性能も提供されています。 たとえば、スタートアップのInflection AIとGPUアクセラレートワークロードに特化したクラウドサービスプロバイダーであるCoreWeaveが共同開発した3,584台のH100 GPUを搭載した商用クラスターでは、GPT-3ベースの大規模トレーニングベンチマークを11分以下で完了しました。 「当社のお客様は、数千のH100 GPUが高速で低レイテンシのInfiniBandネットワーク上で稼働しているため、現在スケールで最先端の生成型AIおよびLLMを構築しています。」と、CoreWeaveの共同設立者でありCTOであるブライアン・ベンチュロ氏は述べています。「NVIDIAとの共同MLPerfサブミッションにより、お客様が享受できる優れたパフォーマンスが明確に示されました。」 本日利用可能な最高のパフォーマンス Inflection AIは、そのパフォーマンスを活用して、パーソナルAI「Pi」の先進的なLLMを構築しました。同社はAIスタジオとして、ユーザーが簡単で自然な方法で対話できるパーソナルAIを作成します。 「当社の最先端の大規模言語モデルは、CoreWeaveの強力なH100 GPUネットワークでトレーニングされたものであり、誰でも今日からパーソナルAIの力を体験できます。」と、Inflection AIのCEOであるムスタファ・スレイマン氏は述べています。 2022年初頭にMustafaとDeepMindのKarén Simonyan、Reid Hoffmanが共同設立したInflection AIは、NVIDIA GPUを使用して世界で最大のコンピューティングクラスターの1つを構築するためにCoreWeaveと協力することを目指しています。 トップパフォーマンスが利用可能に これらのユーザー体験は、今日発表されたMLPerfベンチマークで示されたパフォーマンスを反映しています。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.