Learn more about Search Results Yi - Page 55

- You may be interested

- MIT研究者が高度なニューラルネットワーク...

- 「Amazon Bedrock と Amazon Location Ser...

- 中国の最新のAI研究により、「OMMO」と呼...

- 「Pythonで簡単に実装するマルチクラスSVM」

- 生成AI:シームレスなデータ転送のための...

- 「オンプレミスからクラウドへデータを移...

- MITによる新しい機械学習の研究は、大規模...

- Google AIとフロリダ中央大学の研究者が、...

- 言語モデルの未来:ユーザーエクスペリエ...

- 「機械学習をマスターするための10のGitHu...

- 「エンドツーエンドの推薦システムの構築」

- 自動化、Ansible、人工知能

- 「パッチのせいかもしれませんか? このAI...

- 小さなメモリに大きな言語モデルを適合さ...

- 「生成AIツールが自己学習のためのテキス...

「Amazon SageMakerを使用して、生成AIを使ってパーソナライズされたアバターを作成する」

生成AIは、エンターテイメント、広告、グラフィックデザインなど、さまざまな産業で創造プロセスを向上させ、加速させるための一般的なツールとなっていますそれにより、観客によりパーソナライズされた体験が可能となり、最終製品の全体的な品質も向上します生成AIの一つの重要な利点は、ユーザーに対してユニークでパーソナライズされた体験を作り出すことです例えば、[…]

「CPU上での分散Llama 2」

この演習は、Meta AIのLLM(Large Language Model)であるLlama 2を使用して、llama.cppとPySparkを介して一度に多くの文書を要約することについてです

「このディスインフォメーションはあなたのためだけです」

生成AIは単にインターネットをより多くの嘘で満たすだけではありません-それはまた、特定のグループや個人をターゲットにした説得力のあるディスインフォメーションを作成する可能性もあります

「新しい攻撃が主要なAIチャットボットに影響を与え、誰もそれを止める方法を知りません」

研究者は、ChatGPT、Bard、および他のチャットボットが不正行為を行う簡単な方法を見つけ、AIは手に負えないことを証明しました

FHEを用いた暗号化された大規模言語モデルに向けて

大規模言語モデル(LLM)は最近、プログラミング、コンテンツ作成、テキスト分析、ウェブ検索、遠隔学習などの多くの分野で生産性を向上させるための信頼性のあるツールとして証明されています。 大規模言語モデルがユーザーのプライバシーに与える影響 LLMの魅力にもかかわらず、これらのモデルによって処理されるユーザークエリに関するプライバシーの懸念が残っています。一方で、LLMの能力を活用することは望ましいですが、他方で、LLMサービスプロバイダーに対して機密情報が漏洩するリスクがあります。医療、金融、法律などの一部の分野では、このプライバシーリスクは問題の原因となります。 この問題への1つの解決策は、オンプレミス展開です。オンプレミス展開では、LLMの所有者がクライアントのマシンにモデルを展開します。これは、LLMの構築に数百万ドル(GPT3の場合は4.6Mドル)かかるため、最適な解決策ではありません。また、オンプレミス展開では、モデルの知的財産(IP)が漏洩するリスクがあります。 Zamaは、ユーザーのプライバシーとモデルのIPの両方を保護できると考えています。このブログでは、Hugging Face transformersライブラリを活用して、モデルの一部を暗号化されたデータ上で実行する方法を紹介します。完全なコードは、このユースケースの例で見つけることができます。 完全同型暗号(FHE)はLLMのプライバシーの課題を解決できます ZamaのLLM展開の課題に対する解決策は、完全同型暗号(FHE)を使用することです。これにより、暗号化されたデータ上で関数の実行が可能となります。モデルの所有者のIPを保護しながら、ユーザーのデータのプライバシーを維持することが可能です。このデモでは、FHEで実装されたLLMモデルが元のモデルの予測の品質を維持していることを示しています。これを行うためには、Hugging Face transformersライブラリのGPT2の実装を適応し、Concrete-Pythonを使用してPython関数をそのFHE相当に変換する必要があります。 図1は、GPT2のアーキテクチャを示しています。これは繰り返し構造を持ち、連続的に適用される複数のマルチヘッドアテンション(MHA)レイヤーから成り立っています。各MHAレイヤーは、モデルの重みを使用して入力をプロジェクションし、アテンションメカニズムを計算し、アテンションの出力を新しいテンソルに再プロジェクションします。 TFHEでは、モデルの重みと活性化は整数で表現されます。非線形関数はプログラマブルブートストラッピング(PBS)演算で実装する必要があります。PBSは、暗号化されたデータ上でのテーブルルックアップ(TLU)演算を実装し、同時に暗号文をリフレッシュして任意の計算を可能にします。一方で、PBSの計算時間は線形演算の計算時間を上回ります。これらの2つの演算を活用することで、FHEでLLMの任意のサブパート、または、全体の計算を表現することができます。 FHEを使用したLLMレイヤーの実装 次に、マルチヘッドアテンション(MHA)ブロックの単一のアテンションヘッドを暗号化する方法を見ていきます。また、このユースケースの例では、完全なMHAブロックの例も見つけることができます。 図2は、基礎となる実装の簡略化された概要を示しています。クライアントは、共有モデルから削除された最初のレイヤーまでの推論をローカルで開始します。ユーザーは中間操作を暗号化してサーバーに送信します。サーバーは一部のアテンションメカニズムを適用し、その結果をクライアントに返します。クライアントはそれらを復号化してローカルの推論を続けることができます。 量子化 まず、暗号化された値上でモデルの推論を実行するために、モデルの重みと活性化を量子化し、整数に変換する必要があります。理想的には、モデルの再トレーニングを必要としない事後トレーニング量子化を使用します。このプロセスでは、FHE互換のアテンションメカニズムを実装し、整数とPBSを使用し、LLMの精度への影響を検証します。 量子化の影響を評価するために、暗号化されたデータ上で1つのLLMヘッドが動作する完全なGPT2モデルを実行します。そして、重みと活性化の量子化ビット数を変化させた場合の精度を評価します。 このグラフは、4ビットの量子化が元の精度の96%を維持していることを示しています。この実験は、約80の文章からなるデータセットを使用して行われます。メトリクスは、元のモデルのロジット予測と量子化されたヘッドモデルを比較して計算されます。 Hugging Face GPT2モデルにFHEを適用する Hugging…

「Skill-it」とは、言語モデルの理解とトレーニングのためのデータ駆動型スキルフレームワークです

大規模言語モデル(LM)は、ソースコードの作成、オリジナルの芸術作品の作成、人との対話など、非常に能力が高いです。モデルの訓練に使用されるデータによって、これらのタスクを実行できるようになります。この訓練データを強化することで、特定のスキルを自然に引き出すことができます。訓練トークンの数が限られている場合、巨大なコーパスからこれらの能力に適したデータを選択する方法は明確ではありません。なぜなら、既存の最先端のLMデータ選択アルゴリズムのほとんどは、フィルタリングやさまざまなデータセットの組み合わせに関するヒューリスティックに依存しているからです。データがモデルの能力にどのように影響を与えるか、またこのデータを使用してLMのパフォーマンスを向上させる方法を記述するための形式的なフレームワークが必要です。 彼らは、人々が学ぶ方法からこのフレームワークを作成するためのヒントを得ました。学習階層を構成する能力という概念は、教育文献でよく知られています。たとえば、研究によって、数学や科学の概念を特定の順序で提示することが、生徒がそれらをより迅速に理解するのに役立つことが明らかになりました。彼らは、LMの訓練にどれだけ類似したスキルベースの順序付けが存在するかを知りたいと考えています。もし類似した順序付けが存在する場合、データ効率の良いトレーニングとLMのより深い理解を提供するかもしれません。たとえば、スペイン語の文法や英語の質問作成など、似たようなが容易なタスクからトレーニングを開始することが、スペイン語の質問生成のためのLMのトレーニングに役立つのかを知りたいと考えています。 図1:彼らは、LMがある特定の順序でスキルを最もよく学び、これがLMをより理解し教えるのに役立つ可能性があると仮説を立てました。この仮説は、人間が情報を獲得する方法からのインスピレーションを得ました。彼らは、これらの順序付けられたスキルセットが実際のデータに存在することを示し、必要なスキルがトレーニングされている場合、データを少なくとも使用することで能力を学ぶことができることを実証しました。そして、彼らはスキルオーダリングを活用したオンラインのデータ選択システムであるSKILL-ITを導入し、スキルを迅速に獲得するために使用しました。 彼らは、スキルの順序付けの概念がデータとLMの訓練および振る舞いを結び付けるためのフレームワークの開発に役立つ可能性があるかどうかを調査しています。これを行うためには、データとスキルの相互作用に関連する2つの問題を解決する必要があります。まず、LMのスキルとスキルの順序の操作的な定義を定義し、データを使用してテストする必要があります。これにより、LMが特定の順序で最も効果的に学習する能力のセットが存在することが示されます。初期の研究では、メタデータのプロパティや埋め込みクラスタなどの意味的なグループ化がスキルを適切に表現し、モデルの学習プロセスを説明できるかどうかを調査しました。 たとえば、Alpacaデータセットを指示の種類で分割してデータの多様性を捉えました。しかし、指示の種類に基づいてサンプリングする方法とランダムサンプリングは、類似したパフォーマンスのモデルを生成することがわかりました。つまり、単に既存のデータグループのアイデアではスキルを特徴付けることはできません。モデルのトレーニングを本当に向上させるには、これらのスキルの定義を使用してサンプルの分布を構築する必要があります。単純な選択技術が直面する困難に着目し、スキルを効果的に学ぶデータ選択アルゴリズムの基準を作成します。能力のバランスや順序が従来のランダム一様サンプリングの技術では考慮されていないため、スキルの学習は最適化されていません。 たとえば、スペイン語と質問生成(QG)は、Natural Instructionsデータセットのそれぞれ5%と4%を占めていますが、スペイン語QGはわずか0.2%です。スキルはデータ内で均等に分布しておらず、より複雑なスキルは稀です。また、ランダムサンプリングは特定のトレーニングシーケンスやスキルの依存構造を考慮する方法を提供しません。サンプルレベルの順序付けは、カリキュラム学習などのより高度な戦略によって考慮されますが、スキルやその依存関係によっては考慮されません。能力の不均衡や順序の問題は、彼らの目標のフレームワークによって考慮される必要があります。スキルベースのシステムとして、モデルが関連するデータのスライスを使用して学習することができる行動の単位としてスキルを定義します。 順序付けられたスキルセットは、フルでも空でもない有向スキルグラフを持つスキルのグループです。前提となるスキルからスキルへのエッジが存在する場合、前提スキルも学習されることでスキルの学習に必要なトレーニング時間を短縮できます(図1の左、中央)。この操作的な定義を使用して、人工および実データセットに順序付けられたスキルセットが存在することを実証します。興味深いことに、これらの順序付けられたスキルセットは、スキルだけでなく必要なスキルもトレーニングすることで、才能を迅速に学ぶ必要があることを明らかにします。 彼らの観察によると、モデルが英語QGとスペイン語を追加して学習すると、総合的なトレーニングステップの予算を使って単にスペイン語QGでトレーニングするよりも、検証損失が4%低くなる場合があります。その後、彼らの理論に基づいて、LMがスキルをより速く学習するための2つのアプローチを提供しています:スキル層別サンプリングとオンライン汎化、SKILL-IT。スタンフォード大学、ウィスコンシン大学マディソン校、Together AI、シカゴ大学の研究者たちは、スキル層別選択を提案しています。これは、データセット内のスキルの不均等な分布の問題を解決するために、関連スキル(目標スキルや微調整のための必要スキルなど)を均等にサンプリングすることで学習スキルを明示的に最適化する直接的な方法です。 スキル層別サンプリングは静的であり、トレーニングの進行に伴う順序を考慮しませんので、トレーニングプロセスの初期段階で獲得された能力を過剰にサンプリングします。彼らはSKILL-ITを提案し、トレーニングスキルの組み合わせを選択するためのオンラインデータ選択技術を提供して、まだ学習していないスキルや影響力のある前提スキルにより高い重みを与えることで、この問題に対処します(図1 右)。データの予算とスキルグラフを仮定した場合、SKILL-ITは評価スキルの損失を最小化するためのトレーニングスキル上のオンライン最適化問題から開発されます。 評価スキルセットとトレーニングスキルセットの関連を基に、SKILL-ITは進行中の事前学習、微調整、またはドメイン外評価に適応することができます。これはオンラインミラーディセントに触発されたものです。人工データセットと実データセット上で、彼らは2つのモデルスケール(125Mと1.3Bパラメータ)でSKILL-ITを評価します。LEGOシミュレーションでは、ランダムにトレーニングデータとカリキュラム学習を選択する場合と比べて、連続的な事前トレーニングシナリオにおいて35.8ポイントの精度向上を実証します。同じ総合的なトレーニング予算の場合、スキルの組み合わせによる彼らのアルゴリズムは、微調整の設定で単独のスキルだけでトレーニングするよりも最大13.6%低い損失を達成することを示しています。 彼らのアルゴリズムは、自然な指示テストタスクデータセットのタスクカテゴリに対応する12の評価スキルのうち11つでランダムサンプリングやスキル層別サンプリングに比べて最も低い損失を達成することができます。これはトレーニングスキルが評価スキルと完全に一致しないドメイン外の設定でのトレーニングデータに対して行われます。最後に、彼らは最新のRedPajama 1.2兆トークンデータセットを使用した事例研究を提供しています。彼らはSKILL-ITによって生成されたデータ混合物を利用して3Bパラメータモデルを連続的に事前トレーニングします。彼らは、1Bトークンにおける精度に関して、SKILL-ITが3Bトークンのデータソース上の均等なサンプリングを上回ることを発見しました。

『ゴミ科学者にならない方法』

毎日、多くのAIおよびアナリティクス愛好家から、これらは私がソーシャルメディアで毎日受ける最も一般的な質問です毎日、数多くのニュースレターやMOOC、コースが発売されています...

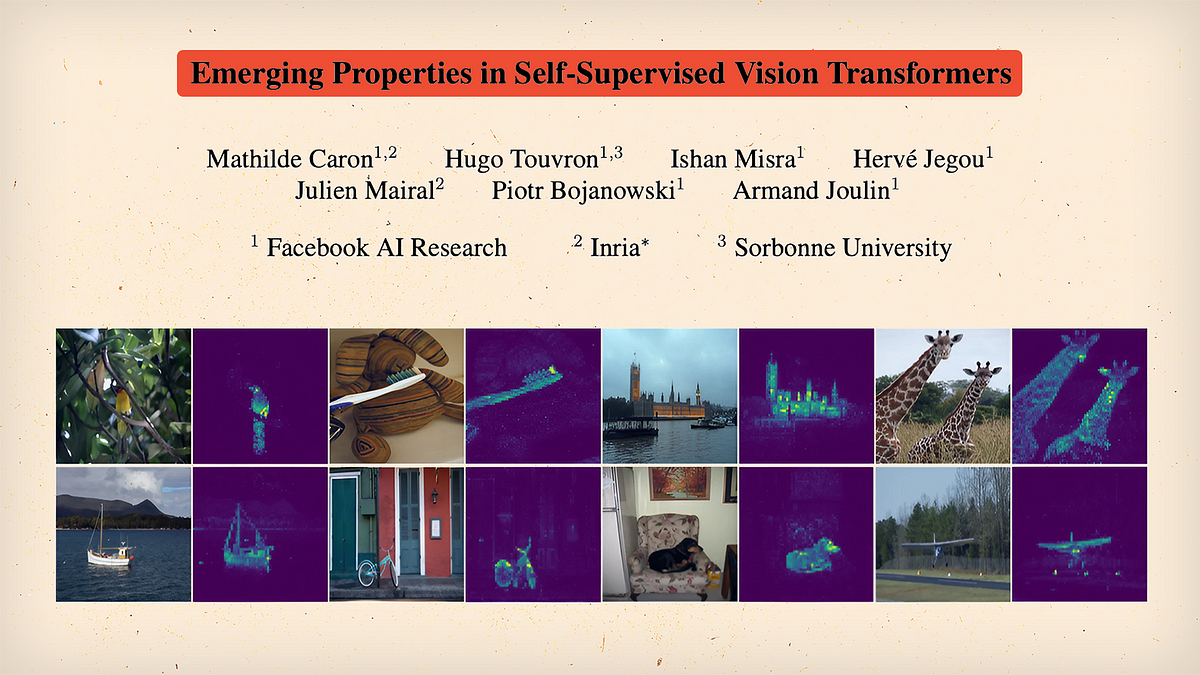

「自己教師あり学習とトランスフォーマー? – DINO論文の解説」

「一部の人々は、Transformerのアーキテクチャを愛し、それをコンピュータビジョンの領域に歓迎しています他の人々は、新しいプレイグラウンドに新しい子供がいることを受け入れたくありません さて、何が起こるのか見てみましょう...」

「糖尿病網膜症の段階を予測して眼の盲目を防ぐ」

はじめに 糖尿病性網膜症は、網膜の血管に変化を引き起こす眼の状態です。無治療のまま放置すると、視力の喪失につながります。そのため、糖尿病性網膜症の段階を検出することは、目の失明を防ぐために重要です。このケーススタディは、糖尿病性網膜症の症状から目の失明を検出することについてのもので、データはさまざまな撮影条件で眼底カメラ(眼の後ろを写真に撮るカメラ)を使用して、さまざまな訓練された臨床専門家によって田舎の地域から収集されました。これらの写真は、2019年にKaggleが行ったコンペティション(APTOS 2019 Blindness Detection)で糖尿病性網膜症の段階を検出するために使用され、私たちのデータは同じKaggleのコンペティションから取得されました。この糖尿病性網膜症の早期検出は、治療を迅速化し、視力の喪失のリスクを大幅に減らすのに役立ちます。 訓練された臨床専門家の手作業による介入は、特に発展途上国では時間と労力がかかります。したがって、このケーススタディの主な目的は、効率的な技術を使用して状態の重症度を検出し、失明を防止することです。私たちは、深層学習の技術を実装して、状態の分類に効果的な結果を得るために取り組んでいます。 学習目標 糖尿病性網膜症の理解:眼の状態と視力への影響について学び、早期検出の重要性を強調します。 深層学習の基礎:深層学習の基礎を探求し、糖尿病性網膜症の診断における関連性を理解します。 データの前処理と拡張:ディープラーニングモデルのトレーニングのためにデータセットを効果的に準備し、強化する方法を理解します。 モデルの選択と評価:重症度分類のためのディープラーニングモデルの選択と性能評価の方法を学びます。 実用的な展開:Flaskを使用して最適なモデルの展開と実世界での予測を実現します。 この記事はデータサイエンスブログマラソンの一環として公開されました。 ビジネスの問題 ここでは、人の状態の重症度が5つのカテゴリに分類されます。つまり、人は重症度レベルのいずれか1つで認識されます。 ビジネスの制約事項 医療分野では正確性と解釈可能性が非常に重要です。間違った予測は人々の命を奪う可能性があるため、厳格なレイテンシの心配はありませんが、結果については正確でなければなりません。 データセットの説明 データセットには、訓練された臨床専門家が各画像を糖尿病性網膜症の重症度に基づいて以下のように分類した3,662枚のラベル付き網膜画像が含まれています。 0 — 糖尿病性網膜症なし 1 —…

『革命的なロボティクス:電子機器なしで機能する3Dプリントグリッパー』

「ロボット工学において重要な進歩を遂げた、カリフォルニア大学サンディエゴ校(UCSD)のエンジニアチームとBASF社の研究者との協力により、電子機器を必要としない3Dプリントされたロボット用グリッパーが開発されましたこの革新的なデバイスは、物を掴み、保持し、放すことができ、[…]ということを証明しています」

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.