Learn more about Search Results ( link - Page 51

- You may be interested

- アップリフトモデリング—クレジットカード...

- ギル・ジェロン、Orca SecurityのCEO&共...

- 新しいAIの研究は、事前学習済みおよび指...

- 🤗 Hubでのスーパーチャージド検索

- 「NVIDIA H100 Tensor Core GPUを使用した...

- GPT4Allは、あなたのドキュメント用のロー...

- 広告主向けのAIパワードイメージ生成ツー...

- 発達心理学に触発された深層学習モデルに...

- 非アーベル任意子の世界で初めてのブレー...

- 「言語モデルがプログラマーを置き換える...

- 「Amazon SageMakerを使用して、マルチモ...

- 農業におけるビジョン・トランスフォーマ...

- 「Anthropic Releases Claude 2.1:拡張さ...

- SSDを使用したリアルタイム物体検出:シン...

- Amazon SageMakerノートブックのジョブを...

テキストから音声へ – 大規模な言語モデルのトレーニング

はじめに 音楽家の声コマンドをAIが受け取り、美しいメロディックなギターサウンドに変換する世界を想像してみてください。これはSFではありません。オープンソースコミュニティでの画期的な研究「The Sound of AI」の成果です。本記事では、「テキストからサウンドへ」というジェネレーティブAIギターサウンドの範囲内で、「ミュージシャンの意図認識」のための大規模言語モデル(LLM)の作成の道のりを探求します。このビジョンを実現するために直面した課題と革新的な解決策についても議論します。 学習目標: 「テキストからサウンド」のドメインでの大規模言語モデルの作成における課題と革新的な解決策を理解する。 声コマンドに基づいてギターサウンドを生成するAIモデルの開発において直面する主な課題を探求する。 ChatGPTやQLoRAモデルなどのAIの進歩を活用した将来のアプローチについて、ジェネレーティブAIの改善に関する洞察を得る。 問題の明確化:ミュージシャンの意図認識 問題は、AIが音楽家の声コマンドに基づいてギターサウンドを生成できるようにすることでした。例えば、音楽家が「明るいギターサウンドを出してください」と言った場合、ジェネレーティブAIモデルは明るいギターサウンドを生成する意図を理解する必要があります。これには文脈とドメイン特有の理解が必要であり、一般的な言語では「明るい」という言葉には異なる意味がありますが、音楽のドメインでは特定の音色の品質を表します。 データセットの課題と解決策 大規模言語モデルのトレーニングには、モデルの入力と望ましい出力に一致するデータセットが必要です。ミュージシャンのコマンドを理解し、適切なギターサウンドで応答するために、適切なデータセットを見つける際にいくつかの問題が発生しました。以下に、これらの問題の対処方法を示します。 課題1:ギターミュージックドメインのデータセットの準備 最初の大きな課題は、ギターミュージックに特化したデータセットが容易に入手できないことでした。これを克服するために、チームは独自のデータセットを作成する必要がありました。このデータセットには、音楽家がギターサウンドについて話し合う会話が含まれる必要がありました。Redditの議論などのソースを利用しましたが、データプールを拡大する必要があると判断しました。データ拡張、BiLSTMディープラーニングモデルの使用、コンテキストベースの拡張データセットの生成などの技術を使用しました。 課題2:データの注釈付けとラベル付きデータセットの作成 2番目の課題は、データの注釈付けを行い、ラベル付きのデータセットを作成することでした。ChatGPTなどの大規模言語モデルは一般的なデータセットでトレーニングされることが多く、ドメイン固有のタスクに対してファインチューニングが必要です。例えば、「明るい」という言葉は、光や音楽の品質を指す場合があります。チームは、正しい文脈をモデルに教えるために、Doccanoという注釈付けツールを使用しました。ミュージシャンは楽器や音色の品質に関するラベルをデータに注釈付けしました。ドメインの専門知識が必要であるため、注釈付けは困難でしたが、チームはデータを自動的にラベル付けするためにアクティブラーニングの手法を一部適用し、これに対処しました。 課題3:MLタスクとしてのモデリング – NERアプローチ 適切なモデリングアプローチを決定することもまた、別のハードルでした。トピックまたはエンティティの識別として見るべきでしょうか?チームは、モデルが音楽に関連するエンティティを識別して抽出できるNamed Entity Recognition(NER)を採用しました。spaCyの自然言語処理パイプライン、HuggingFaceのRoBERTaなどのトランスフォーマーモデルを活用しました。このアプローチにより、ジェネレーティブAIは音楽のドメインにおける「明るい」や「ギター」といった単語の文脈を認識できるようになりました。 モデルトレーニングの課題と解決策…

「ビッグデータの取り扱い:ツールと技術」

「ビッグデータという広大な分野では、どこから始めればいいのでしょうか?どのツールや技術を使うべきでしょうか?私たちはこれについて探求し、ビッグデータで最も一般的なツールについて話し合います」

「Amazon TextractとAmazon OpenSearchを使用してスマートなドキュメント検索インデックスを実装する」

この投稿では、ドキュメント検索インデックスソリューションを迅速に構築および展開する旅に連れて行きますこのソリューションは、組織がドキュメントから洞察をより効果的に抽出するのを支援します例えば、人事部門では従業員契約の特定の条項を探しているか、財務アナリストでは支払いデータを抽出するために膨大な数の請求書を選別している場合でも、このソリューションは、あなたが必要な情報に前例のない速度と正確さでアクセスできるようにするためにカスタマイズされています

遺伝的アルゴリズムを使用して特徴セットを最適化する方法

遺伝的アルゴリズムを使用して特徴の最適化の世界に深く潜り込み、機械学習モデルに最も関連性のある特徴を特定するのにどのように役立つかを探求してください

MetaGPTに会いましょう:テキストをウェブアプリに変えるChatGPTを搭載したAIアシスタント

この革命的なAIツールは、わずか数秒でノーコードのウェブアプリケーションを作成することができます!

アルゴリズムのバイアスの理解:タイプ、原因、および事例研究

はじめに あなたのソーシャルメディアのフィードがあなたの興味を驚くほど正確に予測するのはなぜでしょうか?また、特定の個人がAIシステムとのやり取りで差別を受けるのはなぜでしょうか?その答えは、人工知能内の複雑で浸透力のある問題であるアルゴリズムの偏りにあります。この記事では、アルゴリズムの偏りとは何か、そのさまざまな側面、原因、および結果について開示します。さらに、責任あるAI開発と公正な利用のために、AIシステムへの信頼を確立することの緊迫性を強調します。 アルゴリズムの偏りとは何ですか? アルゴリズムの偏りとは、コンピュータプログラムが不公平な決定を下すことです。これは、完全に公平ではないデータから学習したためです。例えば、仕事を決定するのに役立つロボットを想像してください。そのロボットが主に男性の履歴書で訓練され、女性の資格についてはほとんど知識がない場合、候補者を選ぶ際に男性に不当に有利になるかもしれません。これはロボットが不公平でありたいわけではなく、バイアスのあるデータから学んだためです。アルゴリズムの偏りとは、コンピュータが教えられた情報のせいで、このように不公平な選択を意図せずにすることです。 出典:LinkedIN アルゴリズムの偏りの種類 データの偏り これは、AIモデルの訓練に使用されるデータが実世界の人口を代表していないため、偏ったまたはバランスの取れていないデータセットが生じると発生します。例えば、顔認識システムが主に肌の色の明るい人々の画像で訓練されている場合、より暗い肌色の人々を認識しようとする際にパフォーマンスが低下し、特定の人種グループに過度の影響を与えるデータの偏りが生じることがあります。 モデルの偏り これはAIモデルの設計とアーキテクチャ中に生じる偏りを指します。例えば、AIアルゴリズムが利益最大化のために設計されている場合、倫理的な考慮よりも財務上の利益を優先する決定を下すことがあり、公正性や安全性よりも利益最大化を優先するモデルの偏りが生じる可能性があります。 評価の偏り これは、AIシステムのパフォーマンスを評価するために使用される基準自体が偏っている場合に発生します。例えば、特定の文化や社会経済集団に有利な標準化されたテストを使用する教育評価AIの場合、教育における不平等を継続させる評価の偏りが生じる可能性があります。 アルゴリズムの偏りの原因 アルゴリズムの偏りの原因はいくつかありますが、それらの原因を理解し、差別を効果的に緩和し対処するためには重要です。以下にいくつかの主な原因を示します: バイアスのある訓練データ バイアスのある訓練データはバイアスの主な原因の一つです。AIシステムに教えるために使用されるデータが歴史的な偏見や不平等を反映している場合、AIはそのバイアスを学習し継続させる可能性があります。例えば、歴史的な採用データが女性や少数派グループに対してバイアスがある場合、採用のために使用されるAIも特定の人口を好む傾向があるかもしれません。 サンプリングバイアス サンプリングバイアスは、訓練に使用されるデータが全人口を代表していない場合に発生します。例えば、データが主に都市部から収集され、農村部からは収集されない場合、AIは農村のシナリオに対してうまく機能せず、農村の人口に対するバイアスが生じる可能性があります。 データの前処理 データのクリーニングと前処理の方法によってバイアスが導入される可能性があります。データの前処理方法がバイアスを考慮して慎重に設計されていない場合、最終的なモデルにおいてバイアスが持続したり増幅されたりすることがあります。 特徴選択 モデルを訓練するために選択される特徴や属性はバイアスを導入する可能性があります。特徴が公平性の影響を考慮せずに選択された場合、モデルは無意識に特定のグループを優遇する可能性があります。 モデルの選択とアーキテクチャ 機械学習アルゴリズムとモデルのアーキテクチャの選択はバイアスに寄与する場合があります。一部のアルゴリズムは他よりもバイアスの影響を受けやすく、モデルの設計方法はその公正性に影響を与える可能性があります。…

Amazon CloudWatchで、ポッドベースのGPUメトリクスを有効にします

この記事では、コンテナベースのGPUメトリクスの設定方法と、EKSポッドからこれらのメトリクスを収集する例について詳しく説明します

「OpenAI WhisperとHugging Chat APIを使用したビデオの要約」

イントロダクション 建築家ルートヴィヒ・ミース・ファン・デル・ローエが有名になったように、「少ないことがより多い」ということは、要約の意味です。要約は、膨大なテキストコンテンツを簡潔で関連性のある要素にまとめるための重要なツールであり、現代の情報消費スピードに適したものです。テキストアプリケーションでは、要約は情報の検索を支援し、意思決定をサポートします。Generative AI(OpenAI GPT-3ベースのモデルなど)の統合により、テキストから重要な要素を抽出し、ソースの本質を保持したまま意味のある要約を生成するというプロセスが革新されました。興味深いことに、Generative AIの機能は、テキストにとどまらず、ビデオ要約にも広がっています。これには、ビデオから重要なシーン、対話、概念を抽出し、コンテンツの要約を作成することが含まれます。ビデオ要約は、短い要約ビデオを生成したり、ビデオコンテンツの分析を行ったり、ビデオのキーセクションを強調表示したり、ビデオのテキスト要約を作成するなど、さまざまな方法で実現できます。 Open AI Whisper APIは、自動音声認識技術を活用して話された言語を書かれたテキストに変換することで、テキストの要約の正確さと効率性を向上させます。一方、Hugging Face Chat APIは、GPT-3などの最先端の言語モデルを提供します。 学習目標 この記事では、以下のことを学びます: ビデオ要約の技術について学ぶ ビデオ要約の応用について理解する Open AI Whisperモデルのアーキテクチャを探索する Open AI WhisperとHugging Chat APIを使用してビデオテキスト要約を実装する方法を学ぶ…

「LLaSMと出会う:音声と言語の指示に従うクロスモーダルな対話能力を持つエンドツーエンドで訓練された大規模なマルチモーダル音声言語モデル」

音声はトーンなどの意味論的およびパラ言語的情報を含むため、書き込みよりも多くの情報を伝えます。さらに、話すことは人々がAIとのコミュニケーションを行うためのより実践的で有機的な方法です。そのため、一般的な目的のアシスタントを作成する際には、音声と言語のガイドラインに従うことが重要です。しかし、多くの大規模言語モデルはテキスト入力のみを受け付けるため、その潜在能力は制限されます。マルチモーダルなビジョンと言語のモデルにより、一般的な人工知能(AGI)の進歩が可能になりましたが、人間がテキストの指示を入力することは依然として手間がかかります。 音声認識(ASR)モデルは、カスケードパラダイムアプローチで使用され、音声入力をテキスト入力に変換し、モデルがジョブを処理するために使用できます。声からテキストへのモーダルの移行は、情報の消費を引き起こし、ASRシステムのエラーを導入する可能性があります。最近では、音声言語のマルチモーダルモデルが大規模言語モデルを使用して音声とテキストを理解し、生成することができるようになりました。音声信号は異なるトークンに分割され、LLMの語彙に拡張されます。この意味では、LLMは広範なマルチモーダルデータと強力な計算リソースを再トレーニングする必要があります。 LinkSoul.AI、北京大学、01.aiの著者らは、この研究で音声と言語の相互作用を理解し、話された命令に従う能力を持つ大規模な音声と言語のモデルLLaSMを提案しています。彼らは、LLaVAと同様に、訓練済みの音声モーダルエンコーダとLLMを使用しており、これによりLLaSMはリソースを節約できます。彼らは特に、音声エンコーダとしてWhisperを使用し、音声信号を組み込みます。大規模言語モデルの入力テキスト埋め込みは、モーダルアダプタを使用して音声埋め込みと一致させます。音声とテキストの埋め込みを組み合わせて、交互になったシーケンスを作成します。交互になったシーケンスは、監督付きの微調整のためにLLMに供給されます。 トレーニング手順には2つのフェーズがあります。初期段階では、パブリックのASRデータセットを使用してモーダルアダプタの事前トレーニングを行います。モーダルアダプタのみがトレーニングされ、音声エンコーダとLLMはロックされます。この段階では、モーダルアダプタの一部のパラメータが導入されるため、モデルのパラメータの大部分はまだ修正が必要ですが、リソースを消費することはありません。2番目のステップでは、クロスモーダルな指示データを使用して、モデルがマルチモーダルな指示を処理し、クロスモーダルな相互作用を分析できるようにします。クロスモーダル教育のために言語モデルとモーダルアダプタの設定が変更される間、音声エンコーダは固定されます。 重要なことは、オープンソースの音声テキストクロスモーダル指示フォローのデータセットはほとんど存在しないということです。したがって、彼らはLLaSM-Audio-Instructionsデータセットを作成し、公開しました。このデータセットは、GPT4-LLM、ShareGPT、WizardLMからの会話を慎重に選び、テキスト読み上げ技術を使用して大量の会話音声データを作成しています。彼らの知る限り、これは最大の中国語と英語の音声テキストクロスモーダル指示フォローのデータセットであり、199,000の対話、80,000の中国語の音声サンプル、428,000の英語の音声サンプルを含んでいます。 彼らの研究は以下の貢献をしています: • 音声と言語を理解し、音声と言語のコマンドを実行できる音声言語のマルチモーダルモデルを作成しました。これにより、人々が人工知能とコミュニケーションを取るためのより実践的で有機的な方法が提供されます。 • 中国語と英語の音声とテキストを組み合わせたクロスモーダルな指示フォローの大規模データセットLLaSM-Audio-Instructionsを作成し、公開しました。 • デモはHuggingFaceのオンラインで、コードはGitHubで閲覧できます。

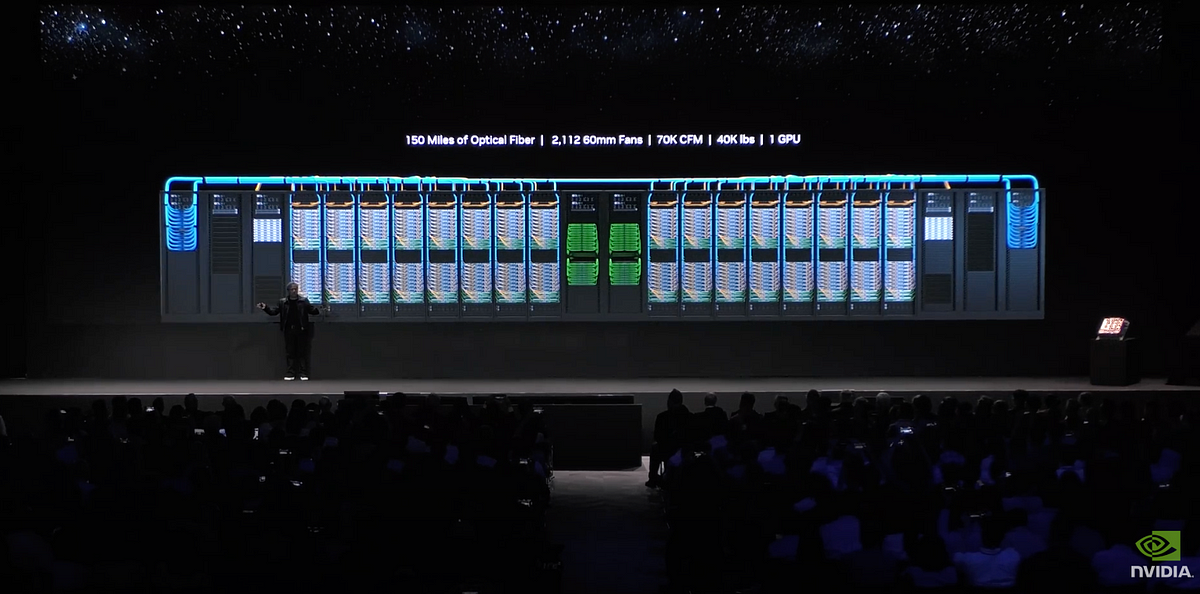

AIイメージフュージョンとDGX GH200

「コンピュータビジョン(CV)の領域では、部分的な画像を繋ぎ合わせて寸法を測定する能力は単なる高度なトリックではなく、重要なスキルですパノラマビューを作成している場合でも...」

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.