Learn more about Search Results 10 - Page 510

- You may be interested

- SaneBoxのレビュー:メールを整理して生産...

- 原子力輸送船のAI推進帆のテスト

- 「Amazon SageMaker Data WranglerでAWS L...

- 「LangChainとOpenAI APIを使用した生成型...

- ユーロトリップの最適化:遺伝的アルゴリ...

- 「5つのステップで始めるSQL」

- エントロピーとジニ指数入門

- このスペースを見る:AIを使用してリスク...

- 「数の力:NVIDIAとGenerative Red Team C...

- 「生物コンピューター」の独自の約束

- 「dbtモデルのユニットテストを実装するた...

- OpenAIの需要急増により、ChatGPT Plusの...

- ジェンスン・ファンのNvidiaがA.I. 革命を...

- 「GPUのマスタリング:PythonでのGPUアク...

- 「ATLAS研究者は、教師なし機械学習を通じ...

チャートの推論に基づくモデルの基盤

グーグルリサーチのリサーチソフトウェアエンジニア、ジュリアン・アイゼンシュロスによる投稿 ビジュアル言語は、情報を伝えるためにテキスト以外の絵文字を使用するコミュニケーション形式です。アイコノグラフィ、情報グラフィック、表、プロット、チャートなどの形でデジタルライフで普及しており、道路標識、コミックブック、食品ラベルなどの現実世界にも広がっています。このようなメディアをコンピュータがより理解できるようにすることは、科学的コミュニケーションと発見、アクセシビリティ、データの透過性に役立ちます。 ImageNetの登場以来、学習ベースのソリューションを使用してコンピュータビジョンモデルは大きな進歩を遂げてきましたが、焦点は自然画像にあり、分類、ビジュアルクエスチョンアンサリング(VQA)、キャプション、検出、セグメンテーションなどのさまざまなタスクが定義され、研究され、いくつかの場合には人間の性能に達成されています。しかし、ビジュアル言語は同じレベルの注目を集めていません。これは、この分野における大規模なトレーニングセットの不足のためかもしれません。しかし、PlotQA、InfographicsVQA、ChartQAなどの視覚言語イメージにおける質問応答システムの評価を目的とした新しい学術データセットが、ここ数年で作成されています。 ChartQAからの例。質問に答えるには、情報を読み取り、合計と差を計算する必要があります。 これらのタスクに対して構築された既存のモデルは、光学的文字認識(OCR)情報とその座標を大規模なパイプラインに統合することに頼っていましたが、プロセスはエラーが発生しやすく、遅く、一般化が悪いです。既存の畳み込みニューラルネットワーク(CNN)またはトランスフォーマーに基づくエンドツーエンドのコンピュータビジョンモデルは、自然画像で事前にトレーニングされたモデルを簡単にビジュアル言語に適応させることができなかったため、これらの方法が広く使用されていました。しかし、既存のモデルは、棒グラフの相対高さや円グラフのスライスの角度を読み取り、軸のスケールを理解し、色、サイズ、テクスチャでピクトグラムを伝説値に正しくマッピングし、抽出された数字で数値演算を実行するなど、チャートの質問に対する課題には準備ができていません。 これらの課題に対応するために、「MatCha:数学推論とチャートディレンダリングを活用したビジュアル言語の事前トレーニングの強化」という提案を行います。 MatChaは数学とチャートを表す言葉であり、2つの補完的なタスクでトレーニングされたピクセルからテキストへの基礎モデル(複数のアプリケーションでファインチューニングできる組み込み帰納バイアスを備えた事前トレーニングモデル)です。1つはチャートディレンダリングであり、プロットまたはチャートが与えられた場合、画像からテキストモデルはその基礎となるデータテーブルまたはレンダリングに使用されるコードを生成する必要があります。数学推論の事前トレーニングでは、テキストベースの数値推論データセットを選択し、入力を画像にレンダリングし、画像からテキストモデルが回答をデコードする必要があります。また、「DePlot:プロットからテーブルへの翻訳によるワンショットビジュアル言語推論」という、テーブルへの翻訳を介したチャートのワンショット推論にMatChaの上に構築されたモデルを提案します。これらの方法により、ChartQAの以前の最高記録を20%以上超え、パラメータが1000倍多い最高の要約システムに達成します。両方の論文はACL2023で発表されます。 チャートディレンダリング プロットやチャートは、基礎となるデータテーブルとコードによって通常生成されます。コードは、図の全体的なレイアウト(タイプ、方向、色/形状スキームなど)を定義し、基礎となるデータテーブルは実際の数字とそのグループ化を確立します。データとコードの両方がコンパイラ/レンダリングエンジンに送信され、最終的な画像が作成されます。チャートを理解するには、イメージ内の視覚パターンを発見し、効果的に解析してグループ化し、主要な情報を抽出する必要があります。プロットレンダリングプロセスを逆転するには、すべてのこのような機能が必要であり、したがって理想的な事前トレーニングタスクとして機能することができます。 ランダムなプロットオプションを使用して、Airbus A380 Wikipediaページの表から作成されたチャートです。MatChaの事前トレーニングタスクは、イメージからソーステーブルまたはソースコードを回復することです。 チャート、その基礎となるデータテーブル、およびそのレンダリングコードを同時に取得することは、実践的には困難です。事前トレーニングデータを十分に収集するために、[chart、code]および[chart、table]のペアを独立して蓄積します。[chart、code]の場合、適切なライセンスを持つすべてのGitHub IPythonノートブックをクロールし、図を含むブロックを抽出します。図とそれに直前にあるコードブロックは、[chart、code]ペアとして保存されます。[chart、table]のペアについては、2つのソースを調査しました。最初のソースは、合成データで、TaPasコードベースからWebクロールされたWikipediaテーブルを手動でコードに変換します。列のタイプに応じて、いくつかのプロットオプションをサンプリングして組み合わせます。さらに、事前トレーニングコーパスを多様化するために、PlotQAで生成された[chart、table]ペアも追加します。2番目のソースはWebクロールされた[chart、table]ペアです。Statista、Pew、Our World in Data、OECDの4つのWebサイトから合計約20,000ペアを含むChartQAトレーニングセットでクロールされた[chart、table]ペアを直接使用します。 数学的推論 MatChaに数値推論知識を組み込むために、テキスト数学データセットから数学的推論スキルを学習します。事前トレーニングには、MATHとDROPの2つの既存のテキスト数学推論データセットを使用します。MATHは合成的に作成され、各モジュール(タイプ)の質問ごとに200万のトレーニング例を含んでいます。DROPは読解型のQAデータセットで、入力はパラグラフのコンテキストと質問です。 DROPでの質問を解決するには、モデルがパラグラフを読み、関連する数字を抽出し、数値計算を実行する必要があります。私たちは、両方のデータセットが補完的であることを発見しました。MATHには、異なるカテゴリーにわたる多数の質問が含まれており、モデルに明示的に注入する必要がある数学的操作を特定するのに役立ちます。DROPの読解形式は、モデルが情報抽出と推論を同時に実行する典型的なQA形式に似ています。実際には、両方のデータセットの入力を画像にレンダリングします。モデルは答えをデコードするように訓練されます。 MATHとDROPからの例をMatChaの事前トレーニング目的に取り込むことにより、MatChaの数学的推論スキルを向上させます。入力テキストを画像としてレンダリングします。 エンドツーエンドの結果 Webサイト理解に特化した画像からテキストへの変換トランスフォーマーであるPix2Structモデルバックボーンを使用し、上記の2つのタスクで事前トレーニングを行います。MatChaの強みを示すために、表の基礎にアクセスできない質問応答や要約のためのチャートやプロットを含むいくつかの視覚言語タスクで微調整します。MatChaは、以前のモデルの性能を大幅に上回り、基礎となるテーブルにアクセスできると仮定する以前の最先端も上回ります。 以下の図では、チャートと作業するための標準的なアプローチであったOCRパイプラインから情報を取り込んだ2つのベースラインモデルを最初に評価します。最初のものはT5に基づき、2番目のものはVisionTaPasに基づきます。また、PaLI-17BとPix2Structのモデル結果を報告します。PaLI-17Bは、多様なタスクでトレーニングされた大型(他のモデルの約1000倍)のイメージプラステキスト・トゥ・テキスト・トランスフォーマーですが、テキストやその他の視覚言語の読み取り能力に限界があります。最後に、Pix2StructとMatChaのモデル結果を報告します。…

ソフトウェア開発活動のための大規模シーケンスモデル

Google の研究科学者である Petros Maniatis と Daniel Tarlow が投稿しました。 ソフトウェアは一度に作られるわけではありません。編集、ユニットテストの実行、ビルドエラーの修正、コードレビューのアドレス、編集、リンターの合意、そしてより多くのエラーの修正など、少しずつ改善されていきます。ついには、コードリポジトリにマージするに十分な良い状態になります。ソフトウェアエンジニアリングは孤立したプロセスではなく、人間の開発者、コードレビュワー、バグ報告者、ソフトウェアアーキテクト、コンパイラ、ユニットテスト、リンター、静的解析ツールなどのツールの対話です。 今日、私たちは DIDACT(Dynamic Integrated Developer ACTivity)を説明します。これは、ソフトウェア開発の大規模な機械学習(ML)モデルをトレーニングするための方法論です。 DIDACT の新規性は、完成したコードの磨き上げられた最終状態だけでなく、ソフトウェア開発のプロセス自体をトレーニングデータのソースとして使用する点にあります。開発者が作業を行う際に見るコンテキストと、それに対するアクションを組み合わせて、モデルはソフトウェア開発のダイナミクスについて学び、開発者が時間を費やす方法により合わせることができます。私たちは、Google のソフトウェア開発の計装を活用して、開発者活動データの量と多様性を以前の作品を超えて拡大しました。結果は、プロのソフトウェア開発者にとっての有用性と、一般的なソフトウェア開発スキルを ML モデルに注入する可能性という2つの側面で非常に有望です。 DIDACT は、編集、デバッグ、修復、およびコードレビューを含む開発活動をトレーニングするマルチタスクモデルです。 私たちは DIDACT Comment…

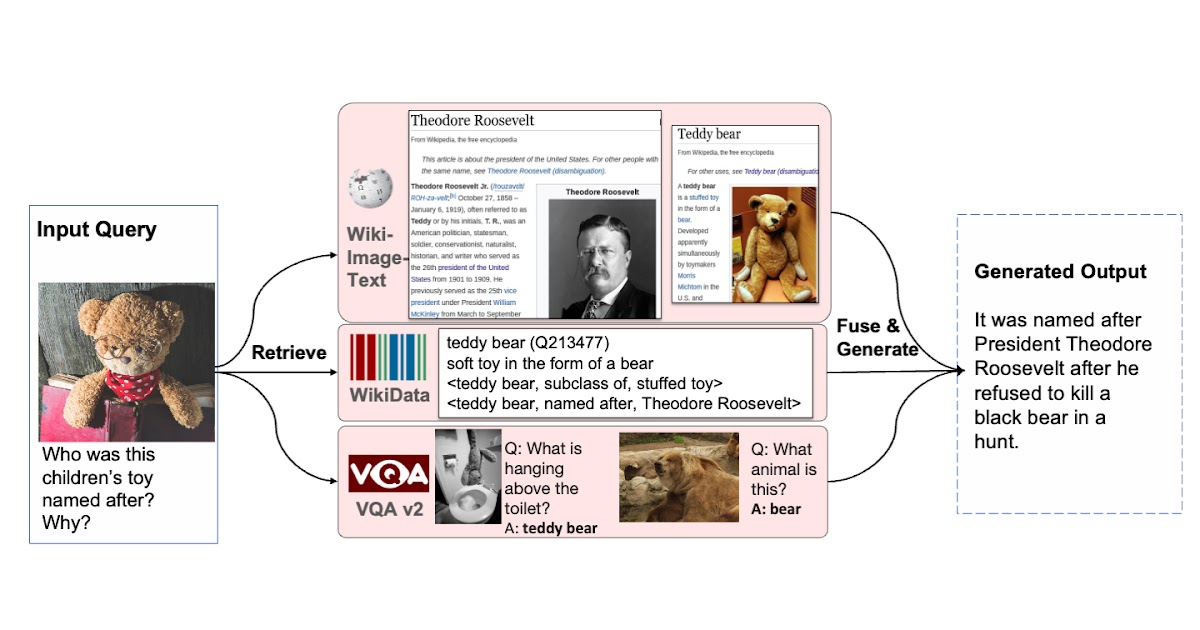

検索増強視覚言語事前学習

Google Research Perceptionチームの学生研究者Ziniu Huと研究科学者Alireza Fathiによる投稿 T5、GPT-3、PaLM、Flamingo、PaLIなどの大規模なモデルは、数百億のパラメータにスケーリングされ、大規模なテキストおよび画像データセットでトレーニングされると、多大な量の知識を格納する能力を示しました。これらのモデルは、画像キャプション、ビジュアルクエスチョンアンサリング、オープンボキャブラリー認識などのダウンストリームタスクで最先端の結果を達成しています。しかし、これらのモデルはトレーニングに膨大な量のデータを必要とし、数十億のパラメータ(多くの場合)を持ち、著しい計算要件を引き起こします。また、これらのモデルをトレーニングするために使用されるデータは古くなる可能性があり、世界の知識が更新されるたびに再トレーニングが必要になる場合があります。たとえば、2年前にトレーニングされたモデルは、現在のアメリカ合衆国大統領に関する古い情報を提供する可能性があります。 自然言語処理(RETRO、REALM)およびコンピュータビジョン(KAT)の分野では、検索増強モデルを使用してこれらの課題に取り組む研究がなされてきました。通常、これらのモデルは、単一のモダリティ(テキストのみまたは画像のみ)を処理できるバックボーンを使用して、知識コーパスから情報をエンコードおよび取得します。ただし、これらの検索増強モデルは、クエリと知識コーパスのすべての利用可能なモダリティを活用できず、モデルの出力を生成するために最も役立つ情報を見つけられない場合があります。 これらの問題に対処するために、「REVEAL:Retrieval-Augmented Visual-Language Pre-Training with Multi-Source Multimodal Knowledge Memory」(CVPR 2023に掲載予定)では、複数のソースのマルチモーダル「メモリ」を利用して知識集中型クエリに答えることを学ぶビジュアル言語モデルを紹介します。REVEALは、ニューラル表現学習を使用して、さまざまな知識ソースをキー-バリューペアから成るメモリ構造に変換し、エンコードします。キーはメモリアイテムのインデックスとして機能し、対応する値はそれらのアイテムに関する関連情報を格納します。トレーニング中、REVEALは、キーエンベッディング、値トークン、およびこのメモリから情報を取得する能力を学習して、知識集中型クエリに対処します。このアプローチにより、モデルパラメータは暗記に専念するのではなく、クエリに関する推論に焦点を当てることができます。 多様な知識ソースから複数の知識エントリを取得する能力を持つビジュアル言語モデルを拡張することで、生成を支援します。 マルチモーダル知識コーパスからのメモリ構築 私たちのアプローチは、異なるソースからの知識アイテムのキーと値のエンベッディングを事前に計算し、キー-バリューペアにエンコードして統一された知識メモリにインデックスするREALMと似ています。各知識アイテムは、より詳細に表現されたトークンエンベッディングのシーケンスである値としてエンコードされます。以前の研究とは異なり、REVEALは、WikiData知識グラフ、Wikipediaのパッセージと画像、Web画像テキストペア、ビジュアルクエスチョンアンサリングデータなど、多様なマルチモーダル知識コーパスを活用しています。各知識アイテムは、テキスト、画像、両方の組み合わせ(たとえば、Wikipediaのページ)、または知識グラフからの関係または属性(たとえば、バラク・オバマは6’2 “の背丈)の場合があります。トレーニング中、モデルパラメータが更新されるたびに、REVEALはキーと値のエンベッディングを連続的に再計算します。ステップごとにメモリを非同期に更新します。 圧縮を使用したメモリのスケーリング メモリ値をエンコードするための素朴な解決策は、各知識アイテムのトークンのすべてのシーケンスを保持することです。次に、モデルは、すべてのトークンを連結してトランスフォーマーエンコーダーデコーダーパイプラインに送信することで、入力クエリとトップkの取得されたメモリ値を融合することができます。このアプローチには2つの問題があります。1つ目は、数億の知識アイテムをメモリに保持する場合、各メモリ値が数百のトークンから構成されている場合、実用的ではないことです。2つ目は、トランスフォーマーエンコーダーが自己注意のために合計トークン数×kに対して2次の複雑度を持っていることです。そのため、Perceiverアーキテクチャを使用して知識アイテムをエンコードおよび圧縮することを提案しています。Perceiverモデルは、トランスフォーマーデコーダーを使用して、フルトークンシーケンスを任意の長さに圧縮します。これにより、kが100にもなるトップkメモリエントリを取得できます。 以下の図は、メモリのキー-バリューペアを構築する手順を示しています。各知識項目は、マルチモーダル視覚言語エンコーダを介して処理され、画像とテキストのトークンのシーケンスに変換されます。キー・ヘッドはこれらのトークンをコンパクトな埋め込みベクトルに変換します。バリュー・ヘッド(パーセプター)は、これらのトークンを少なくし、知識項目に関する適切な情報を保持します。 異なるコーパスからの知識エントリを統一されたキーとバリューの埋め込みペアにエンコードし、キーはメモリのインデックスに使用され、値にはエントリに関する情報が含まれます。…

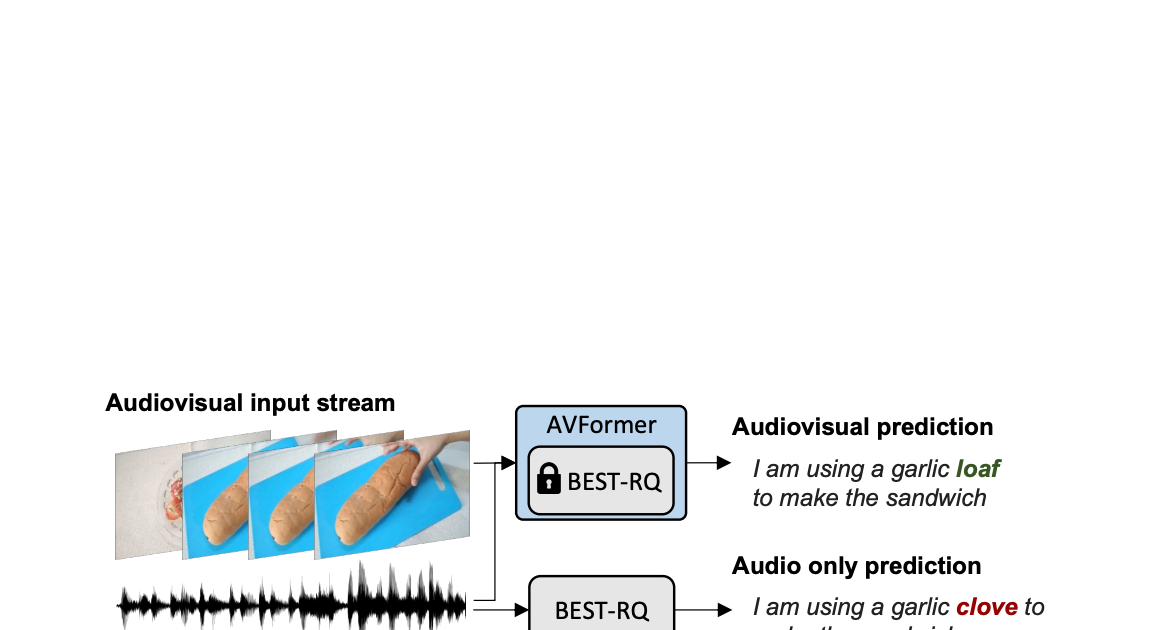

AVFormer:凍結した音声モデルにビジョンを注入して、ゼロショットAV-ASRを実現する

Google Researchの研究科学者、Arsha NagraniとPaul Hongsuck Seoによる投稿 自動音声認識(ASR)は、会議通話、ストリームビデオの転写、音声コマンドなど、さまざまなアプリケーションで広く採用されている確立された技術です。この技術の課題は、ノイズのあるオーディオ入力に集中していますが、マルチモーダルビデオ(テレビ、オンライン編集ビデオなど)の視覚ストリームはASRシステムの堅牢性を向上させる強力な手がかりを提供することができます。これをオーディオビジュアルASR(AV-ASR)と呼びます。 唇の動きは音声認識に強力な信号を提供し、AV-ASRの最も一般的な焦点であるが、野外のビデオで口が直接見えないことがよくあります(例えば、自己中心的な視点、顔のカバー、低解像度など)ため、新しい研究領域である拘束のないAV-ASR(AVATARなど)が誕生し、口の領域だけでなく、ビジュアルフレーム全体の貢献を調査しています。 ただし、AV-ASRモデルをトレーニングするためのオーディオビジュアルデータセットを構築することは困難です。How2やVisSpeechなどのデータセットはオンラインの教育ビデオから作成されていますが、サイズが小さいため、モデル自体は通常、ビジュアルエンコーダーとオーディオエンコーダーの両方から構成され、これらの小さなデータセットで過剰適合する傾向があります。それにもかかわらず、オーディオブックから取得した大量のオーディオデータを用いた大規模なトレーニングによって強く最適化された最近リリースされた大規模なオーディオモデルがいくつかあります。LibriLightやLibriSpeechなどがあります。これらのモデルには数十億のパラメータが含まれ、すぐに利用可能であり、ドメイン間で強い汎化性能を示します。 上記の課題を考慮して、私たちは「AVFormer:ゼロショットAV-ASRの凍結音声モデルにビジョンを注入する」と題した論文で、既存の大規模なオーディオモデルにビジュアル情報を付加するシンプルな方法を提案しています。同時に、軽量のドメイン適応を行います。AVFormerは、軽量のトレーニング可能なアダプタを使用して、視覚的な埋め込みを凍結されたASRモデルに注入します(Flamingoが大規模な言語モデルに視覚テキストタスクのためのビジュアル情報を注入する方法と似ています)。これにより、最小限の追加トレーニング時間とパラメータで弱くラベル付けられた少量のビデオデータでトレーニング可能です。トレーニング中のシンプルなカリキュラムスキームも紹介し、オーディオとビジュアルの情報を効果的に共同処理できるようにするために重要であることを示します。その結果、AVFormerモデルは、3つの異なるAV-ASRベンチマーク(How2、VisSpeech、Ego4D)で最新のゼロショットパフォーマンスを達成し、同時に伝統的なオーディオのみの音声認識ベンチマーク(LibriSpeechなど)のまともなパフォーマンスを保持しています。 拘束のないオーディオビジュアル音声認識。軽量モジュールを使用して、ビジョンを注入して、オーディオビジュアルASRのゼロショットを実現するために、Best-RQ(灰色)の凍結音声モデルにビジョンを注入します。AVFormer(青)というパラメーターとデータ効率の高いモデルが作成されます。オーディオ信号がノイズの場合、視覚的なパンの生成トランスクリプトでオンリーミステイク「クローブ」を「ローフ」に修正するのに役立つ視覚的なパンが役立つ場合があります。 軽量モジュールを使用してビジョンを注入する 私たちの目標は、既存のオーディオのみのASRモデルにビジュアル理解能力を追加しながら、その汎化性能を各ドメイン(AVおよびオーディオのみのドメイン)に維持することです。 このために、既存の最新のASRモデル(Best-RQ)に次の2つのコンポーネントを追加します:(i)線形ビジュアルプロジェクター、および(ii)軽量アダプター。前者は、オーディオトークン埋め込みスペースにおける視覚的な特徴を投影します。このプロセスにより、別々に事前トレーニングされたビジュアル機能とオーディオ入力トークン表現を適切に接続することができます。後者は、その後最小限の変更で、ビデオのマルチモーダル入力を理解するためにモデルを変更します。その後、これらの追加モジュールを、HowTo100Mデータセットからのラベル付けされていないWebビデオとASRモデルの出力を擬似グラウンドトゥルースとして使用してトレーニングし、Best-RQモデルの残りを凍結します。このような軽量モジュールにより、データ効率と強力なパフォーマンスの汎化が可能になります。 我々は、AV-ASRベンチマークにおいて、モデルが人手で注釈付けされたAV-ASRデータセットで一度もトレーニングされていないゼロショット設定で、拡張モデルを評価しました。 ビジョン注入のためのカリキュラム学習 初期評価後、私たちは経験的に、単純な一回の共同トレーニングでは、モデルがアダプタとビジュアルプロジェクタの両方を一度に学習するのが困難であることがわかりました。この問題を緩和するために、私たちは、これら2つの要因を分離し、ネットワークを順序良くトレーニングする2段階のカリキュラム学習戦略を導入しました。最初の段階では、アダプタパラメータが全くフィードされずに最適化されます。アダプタがトレーニングされたら、ビジュアルトークンを追加し、トレーニング済みのアダプタを凍結したまま第2段階でビジュアルプロジェクションレイヤーのみをトレーニングします。 最初の段階は、音声ドメイン適応に焦点を当てています。第2段階では、アダプタが完全に凍結され、ビジュアルプロジェクタは、ビジュアルトークンをオーディオ空間に投影するためのビジュアルプロンプトを生成することを学習する必要があります。このように、私たちのカリキュラム学習戦略は、モデルがAV-ASRベンチマークでビジュアル入力を統合し、新しい音声ドメインに適応することを可能にします。私たちは、交互に適用する反復的な適用では性能が低下するため、各段階を1回だけ適用します。 AVFormerの全体的なアーキテクチャとトレーニング手順。アーキテクチャは、凍結されたConformerエンコーダー・デコーダーモデル、凍結されたCLIPエンコーダー(グレーのロックシンボルで示される凍結層を持つ)、および2つの軽量トレーニング可能なモジュールで構成されています。-(i)ビジュアルプロジェクションレイヤー(オレンジ)およびボトルネックアダプタ(青)を有効にし、多モーダルドメイン適応を可能にします。私たちは、2段階のカリキュラム学習戦略を提案しています。最初に、アダプタ(青)をビジュアルトークンなしでトレーニングします。その後、ビジュアルプロジェクションレイヤー(オレンジ)を調整し、他のすべての部分を凍結したままトレーニングします。 下のプロットは、カリキュラム学習なしでは、AV-ASRモデルがすべてのデータセットでオーディオのみのベースラインよりも劣っており、より多くのビジュアルトークンが追加されるにつれてその差が拡大することを示しています。一方、提案された2段階のカリキュラムが適用されると、AV-ASRモデルは、オーディオのみのベースラインよりも遥かに優れたパフォーマンスを発揮します。 カリキュラム学習の効果。赤と青の線はオーディオビジュアルモデルであり、ゼロショット設定で3つのデータセットに表示されます(WER%が低い方が良いです)。カリキュラムを使用すると、すべての3つのデータセットで改善します(How2(a)およびEgo4D(c)では、オーディオのみのパフォーマンスを上回るために重要です)。4つのビジュアルトークンまで性能が向上し、それ以降は飽和します。 ゼロショットAV-ASRでの結果 私たちは、How2、VisSpeech、Ego4Dの3つのAV-ASRベンチマークで、zero-shotパフォーマンスのために、BEST-RQ、私たちのモデルの音声バージョン、およびAVATARを比較しました。AVFormerは、すべてのベンチマークでAVATARとBEST-RQを上回り、BEST-RQでは600Mパラメータをトレーニングする必要がありますが、AVFormerはわずか4Mパラメータしかトレーニングせず、トレーニングデータセットのわずか5%しか必要としません。さらに、音声のみのLibriSpeechでのパフォーマンスも評価し、AVFormerは両方のベースラインを上回ります。 AV-ASRデータセット全体におけるゼロショット性能に対する最新手法との比較。音声のみのLibriSpeechのパフォーマンスも示します。結果はWER%(低い方が良い)として報告されています。 AVATARとBEST-RQはHowTo100Mでエンドツーエンド(すべてのパラメータ)で微調整されていますが、AVFormerは微調整されたパラメータの少ないセットのおかげで、データセットの5%でも効果的に機能します。…

ビジュアルキャプション:大規模言語モデルを使用して、動的なビジュアルを備えたビデオ会議を補完する

Google Augmented Realityのリサーチサイエンティスト、Ruofei DuとシニアスタッフリサーチサイエンティストのAlex Olwalが投稿しました。 ライブキャプションやノイズキャンセリングなどの機能により、ビデオ会議の最近の進歩により、リモートビデオ通信は大幅に改善されました。しかし、複雑で微妙な情報をより良く伝えるために、動的な視覚的拡張が役立つ場面があります。たとえば、日本食レストランで何を注文するか話し合う場合、友達があなたが「すき焼き」を注文することに自信を持つのに役立つビジュアルを共有することができます。また、最近の家族旅行について話しているときに、個人的なアルバムから写真を見せたい場合があります。 ACM CHI 2023 で発表された「Visual Captions: Augmenting Verbal Communication With On-the-fly Visuals」では、私たちは、口頭の手がかりを使用してリアルタイムのビジュアルを使って同期ビデオ通信を拡張するシステムを紹介します。私たちは、この目的のためにキュレーションしたデータセットを使用して、オープンボキャブラリーの会話で関連するビジュアルを積極的に提案するために、大規模な言語モデルを微調整しました。私たちは、実時間の転写とともに拡張されたコミュニケーションの急速なプロトタイピングに設計されたARChatプロジェクトの一部としてVisual Captionsをオープンソース化しました。 Visual Captionsは、リアルタイムのビジュアルで口頭コミュニケーションを容易にします。このシステムは、リアルタイムの音声からテキストへの転写でよく見られる誤りにも対応しています。たとえば、文脈から外れて、転写モデルは「pier」という単語を「pair」と誤解しましたが、Visual Captionsはそれでもサンタモニカのピアの画像を推奨します。 動的なビジュアルで口頭コミュニケーションを拡張するための設計空間 私たちは、ソフトウェアエンジニア、研究者、UXデザイナー、ビジュアルアーティスト、学生など、様々な技術的および非技術的なバックグラウンドを持つ10人の内部参加者を招待し、潜在的なリアルタイムビジュアル拡張サービスの特定のニーズと欲求を議論しました。2つのセッションで、私たちは想定されるシステムの低保守性のプロトタイプを紹介し、その後、既存のテキストから画像へのシステムのビデオデモを示しました。これらの議論により、以下のようにD1からD8とラベル付けされた8つの次元の設計空間が生まれました。 ビジュアル拡張は、会話と同期または非同期に行われる場合があります(D1:時間)、話題の表現と理解の両方に使用できる場合があります(D2:主題)、さまざまなビジュアルコンテンツ、ビジュアルタイプ、ビジュアルソースを使用して適用できる場合があります(D3:ビジュアル)。このような視覚的拡張は、ミーティングの規模(D4:スケール)や、共同設置またはリモート設定でミーティングが行われているかどうか(D5:スペース)によって異なる場合があります。これらの要因はまた、ビジュアルが個人的に表示されるべきか、参加者間で共有されるべきか、あるいはすべての人に公開されるべきかを決定するのにも影響します(D6:プライバシー)。参加者はまた、会話をしながらシステムとやり取りするさまざまな方法を特定しました(D7:起動)。たとえば、人々は「プロアクティブ」の異なるレベルを提案しました。これは、ユーザーがモデルがイニシアチブを取る程度を示します。最後に、参加者は、入力に音声やジェスチャーを使用するなど、異なる相互作用方法を想定しました(D8:相互作用)。…

多言語での音声合成の評価には、SQuIdを使用する

Googleの研究科学者Thibault Sellamです。 以前、私たちは1000言語イニシアチブとUniversal Speech Modelを紹介しました。これらのプロジェクトは、世界中の何十億人ものユーザーに音声および言語技術を提供することを目的としています。この取り組みの一部は、多様な言語を話すユーザー向けにVDTTSやAudioLMなどのプロジェクトをベースにした高品質の音声合成技術を開発することにあります。 新しいモデルを開発した後は、生成された音声が正確で自然であるかどうかを評価する必要があります。コンテンツはタスクに関連し、発音は正確で、トーンは適切で、クラックや信号相関ノイズなどの音響アーティファクトはない必要があります。このような評価は、多言語音声システムの開発において大きなボトルネックとなります。 音声合成モデルの品質を評価する最も一般的な方法は、人間の評価です。テキストから音声(TTS)エンジニアが最新のモデルから数千の発話を生成し、数日後に結果を受け取ります。この評価フェーズには、聴取テストが含まれることが一般的で、何十もの注釈者が一つずつ発話を聴取して、自然な音に聞こえるかどうかを判断します。人間はテキストが自然かどうかを検出することでまだ敵わないことがありますが、このプロセスは実用的ではない場合があります。特に研究プロジェクトの早い段階では、エンジニアがアプローチをテストして再戦略化するために迅速なフィードバックが必要な場合があります。人間の評価は費用がかかり、時間がかかり、対象言語の評価者の可用性によって制限される場合があります。 進展を妨げる別の障壁は、異なるプロジェクトや機関が通常、異なる評価、プラットフォーム、およびプロトコルを使用するため、apple-to-applesの比較が不可能であることです。この点で、音声合成技術はテキスト生成に遅れを取っており、研究者らが人間の評価をBLEUや最近ではBLEURTなどの自動評価指標と補完して長年にわたって利用してきたテキスト生成から大きく遅れています。 「SQuId: Measuring Speech Naturalness in Many Languages」でICASSP 2023に発表する予定です。SQuId(Speech Quality Identification)という600Mパラメーターの回帰モデルを紹介します。このモデルは、音声がどの程度自然かを示します。SQuIdは、Googleによって開発された事前学習された音声テキストモデルであるmSLAMをベースにしており、42言語で100万件以上の品質評価をファインチューニングし、65言語でテストされました。SQuIdが多言語の評価において人間の評価を補完するためにどのように使用できるかを示します。これは、今までに行われた最大の公開努力です。 SQuIdによるTTSの評価 SQuIdの主な仮説は、以前に収集された評価に基づいて回帰モデルをトレーニングすることで、TTSモデルの品質を評価するための低コストな方法を提供できるということです。このモデルは、TTS研究者の評価ツールボックスに貴重な追加となり、人間の評価に比べて正確性は劣るものの、ほぼ即時に提供されます。 SQuIdは、発話を入力とし、オプションのロケールタグ(つまり、”Brazilian Portuguese”や”British English”などのローカライズされた言語のバリアント)を指定することができます。SQuIdは、音声波形がどの程度自然に聞こえるかを示す1から5までのスコアを返します。スコアが高いほど、より自然な波形を示します。 内部的には、モデルには3つのコンポーネントが含まれています:(1)エンコーダー、(2)プーリング/回帰層、および(3)完全接続層。最初に、エンコーダーはスペクトログラムを入力として受け取り、1,024サイズの3,200ベクトルを含む小さな2D行列に埋め込みます。各ベクトルは、時間ステップをエンコードします。プーリング/回帰層は、ベクトルを集約し、ロケールタグを追加し、スコアを返す完全接続層に入力します。最後に、アプリケーション固有の事後処理を適用して、スコアを再スケーリングまたは正規化して、自然な評価の範囲である[1、5]の範囲内に収まるようにします。回帰損失で全モデルをエンドツーエンドでトレーニングします。…

Imagen EditorとEditBench:テキストによる画像補完の進展と評価

グーグルリサーチの研究エンジニアであるスー・ワンとセズリー・モンゴメリーによる投稿 過去数年間、テキストから画像を生成する研究は、画期的な進展(特に、Imagen、Parti、DALL-E 2など)を見ており、これらは自然に関連するトピックに浸透しています。特に、テキストによる画像編集(TGIE)は、完全にやり直すのではなく、生成された物と撮影された視覚物を編集する実践的なタスクであり、素早く自動化されたコントロール可能な編集は、視覚物を再作成するのに時間がかかるか不可能な場合に便利な解決策です(例えば、バケーション写真のオブジェクトを微調整したり、ゼロから生成されたかわいい子犬の細かいディテールを完璧にする場合)。さらに、TGIEは、基礎となるモデルのトレーニングを改良する大きな機会を表しています。マルチモーダルモデルは、適切にトレーニングするために多様なデータが必要であり、TGIE編集は高品質でスケーラブルな合成データの生成と再結合を可能にすることができ、おそらく最も重要なことに、任意の軸に沿ってトレーニングデータの分布を最適化する方法を提供できます。 CVPR 2023で発表される「Imagen Editor and EditBench: Advancing and Evaluating Text-Guided Image Inpainting」では、マスクインペインティングの課題に対する最先端の解決策であるImagen Editorを紹介します。つまり、ユーザーが、編集したい画像の領域を示すオーバーレイまたは「マスク」(通常、描画タイプのインターフェイス内で生成されるもの)と共にテキスト指示を提供する場合のことです。また、画像編集モデルの品質を評価する方法であるEditBenchも紹介します。EditBenchは、一般的に使用される粗い「この画像がこのテキストに一致するかどうか」の方法を超えて、モデルパフォーマンスのより細かい属性、オブジェクト、およびシーンについて詳細に分析します。特に、画像とテキストの整合性の信頼性に強い重点を置きつつ、画像の品質を見失わないでください。 Imagen Editorは、指定された領域にローカライズされた編集を行います。モデルはユーザーの意図を意味を持って取り入れ、写真のようなリアルな編集を実行します。 Imagen Editor Imagen Editorは、Imagenでファインチューニングされた拡散ベースのモデルで、編集を行うために改良された言語入力の表現、細かい制御、および高品質な出力を目的としています。Imagen Editorは、ユーザーから3つの入力を受け取ります。1)編集する画像、2)編集領域を指定するバイナリマスク、および3)テキストのプロンプトです。これら3つの入力は、出力サンプルを誘導します。 Imagen Editorは、高品質なテキストによる画像インペインティングを行うための3つの核心技術に依存しています。まず、ランダムなボックスとストロークマスクを適用する従来のインペインティングモデル(例:Palette、Context…

人間の注意力を予測するモデルを通じて、心地よいユーザーエクスペリエンスを実現する

Google Researchのシニアリサーチサイエンティスト、Junfeng He氏とスタッフリサーチサイエンティスト、Kai Kohlhoff氏による記事です。 人間は、驚くほど多くの情報を取り入れる能力を持っています(網膜に入る情報は秒間約10 10ビット)。そして、タスクに関連し、興味深い領域に選択的に注目し、さらに処理する能力を持っています(例:記憶、理解、行動)。人間の注意(その結果として得られるものはしばしば注目モデルと呼ばれます)をモデル化することは、神経科学、心理学、人間コンピュータインタラクション(HCI)、コンピュータビジョンの分野で興味を持たれてきました。どの領域でも、どの領域でも、注目が集まる可能性が高い領域を予測する能力には、グラフィックス、写真、画像圧縮および処理、視覚品質の測定など、多数の重要な応用があります。 以前、機械学習とスマートフォンベースの注視推定を使用して、以前は1台あたり3万ドルにも及ぶ専門的なハードウェアが必要だった視線移動の研究を加速する可能性について説明しました。関連する研究には、「Look to Speak」というアクセシビリティニーズ(ALSのある人など)を持つユーザーが目でコミュニケーションするのを支援するものと、「Differentially private heatmaps」という、ユーザーのプライバシーを保護しながら注目のようなヒートマップを計算する技術が最近発表されました。 このブログでは、私たちはCVPR 2022からの1つの論文と、CVPR 2023での採用が決定したもう1つの論文、「Deep Saliency Prior for Reducing Visual Distraction」と「Learning from Unique Perspectives: User-aware…

スピードは必要なすべてです:GPU意識の最適化による大規模拡散モデルのオンデバイス加速化

コアシステム&エクスペリエンスのソフトウェアエンジニアであるJuhyun LeeとRaman Sarokinによる投稿 画像生成のための大規模な拡散モデルの普及により、モデルサイズと推論ワークロードは大幅に増加しました。モバイル環境でのオンデバイスML推論には、リソース制約のために緻密なパフォーマンス最適化とトレードオフの考慮が必要です。コスト効率とユーザープライバシーの必要性により、大規模拡散モデル(LDM)のオンデバイスでの実行は、これらのモデルの大幅なメモリ要件と計算要件のために更に大きな課題を提供します。 本稿では、私たちの「速さこそがすべて:GPUによる大規模拡散モデルのオンデバイスアクセラレーションによる最適化」に焦点を当て、モバイルGPU上の基本的なLDMモデルの最適化された実行について述べます。このブログ記事では、Stable Diffusionなどの大規模拡散モデルを高速で実行するために使用した主なテクニックをまとめ、512×512ピクセルのフル解像度で20回イテレーションを行い、蒸留なしでオリジナルモデルの高性能推論速度で12秒未満で実行できるようにしました。前回のブログ記事で述べたように、GPUアクセラレーションされたML推論は、メモリのパフォーマンスに制限されることがよくあります。そして、LDMの実行も例外ではありません。したがって、私たちの最適化の中心テーマは、演算論理ユニットの効率性を優先するものよりも、メモリの入出力(I/O)の効率性であり、ML推論の全体的なレイテンシを減らすことです。 LDMのサンプル出力。プロンプトテキスト:「周りの花と可愛い子犬の写真リアルな高解像度画像」。 メモリ効率のための強化されたアテンションモジュール ML推論エンジンは通常、最適化されたさまざまなML操作を提供します。しかし、各ニューラルネット演算子を実行するためのオーバーヘッドがあるため、最適なパフォーマンスを達成することは依然として難しい場合があります。このオーバーヘッドを緩和するため、ML推論エンジンは、複数の演算子を1つの演算子に統合する広範な演算子フュージョンルールを組み込んで、テンソル要素を横断するイテレーション数を減らすことで、イテレーションあたりの計算を最大限に増やします。たとえば、TensorFlow Liteは、畳み込みのような計算負荷の高い演算と、後続の活性化関数であるReLUのような演算を組み合わせる演算子フュージョンを利用しています。 最適化の明らかな機会は、LDMのデノイザーモデルで採用された頻繁に使用されるアテンションブロックです。アテンションブロックにより、重要な領域に重みを割り当てることで、モデルは入力の特定の部分に焦点を当てることができます。アテンションモジュールを最適化する方法は複数ありますが、以下に説明する2つの最適化のうち、どちらが優れたパフォーマンスを発揮するかに応じて、選択的に1つを使用します。 第1の最適化である部分的にフュージョンされたsoftmaxは、アテンションモジュール内のsoftmaxと行列乗算の間の詳細なメモリ書き込みと読み取りを省略します。アテンションブロックが単純な行列乗算であると仮定すると、Y = softmax(X)* Wの形式で表されます。ここで、XとWはそれぞれa×bおよびb×cの2D行列です(下図参照)。 数値の安定性のために、T= softmax(X)は、通常、3つのパスで計算されます。 リストの最大値を決定し、行ごとに行列Xを計算します 各リスト項目の指数関数と最大値(パス1から)の差を合計します アイテムから最大値を引いた指数関数を、パス2からの合計で除算します これらのパスを単純に実行すると、中間テンソル T に全体のsoftmax関数の出力が格納されるため、巨大なメモリ書き込みが必要になります。パス1と2の結果のみを保存するテクニックを使用することで、m と…

デジタルルネッサンス:NVIDIAのNeuralangelo研究が3Dシーンを再構築

NVIDIA Researchによる新しいAIモデル、Neuralangeloは、ニューラルネットワークを使用して3D再構築を行い、2Dビデオクリップを詳細な3D構造に変換し、建物、彫刻、およびその他の現実世界のオブジェクトのリアルなバーチャルレプリカを生成します。 ミケランジェロが大理石のブロックから驚くべきリアルなビジョンを彫刻したように、Neuralangeloは複雑なディテールと質感を持つ3D構造を生成します。クリエイティブなプロフェッショナルは、これらの3Dオブジェクトをデザインアプリケーションにインポートし、アート、ビデオゲーム開発、ロボット工学、および産業用デジタルツインに使用するためにさらに編集することができます。 Neuralangeloは、屋根の瓦、ガラスの板、滑らかな大理石などの複雑な素材の質感を、従来の手法を大幅に上回る精度で2Dビデオから3Dアセットに変換することができます。この高い信頼性により、開発者やクリエイティブなプロフェッショナルは、スマートフォンでキャプチャされた映像を使用してプロジェクトに使用できる仮想オブジェクトを迅速に作成できます。 「Neuralangeloが提供する3D再構築機能は、クリエイターにとって大きな利益になります。現実世界をデジタル世界に再現するのを支援することで、開発者は小さな像や巨大な建築物などの詳細なオブジェクトを仮想環境にインポートできるようになります。」と、研究のシニアディレクターであり、論文の共著者でもあるMing-Yu Liu氏は述べています。 デモでは、NVIDIAの研究者が、ミケランジェロのダビデ像やフラットベッドトラックなどといったアイコニックなオブジェクトを再現する方法を紹介しました。Neuralangeloは、建物の内部および外部も再構築することができ、NVIDIAのベイエリアキャンパスの公園の詳細な3Dモデルで実証されました。 ニューラルレンダリングモデルが3Dで見る 3Dシーンを再構築するための以前のAIモデルは、繰り返しのテクスチャパターン、同質的な色、および強い色の変化を正確に捉えることができませんでした。Neuralangeloは、これらの微細なディテールを捉えるために、NVIDIA Instant NeRFの背後にある技術であるインスタントニューラルグラフィックスプリミティブを採用しています。 さまざまな角度から撮影されたオブジェクトまたはシーンの2Dビデオを使用して、モデルは異なる視点を捉えたいくつかのフレームを選択します。これは、アーティストが対象を多角的に考慮して深度、サイズ、および形状を把握するのと同じです。 フレームごとのカメラ位置が決定されたら、NeuralangeloのAIはシーンの大まかな3D表現を作成します。これは、彫刻家が主題の形を彫刻し始めるのと同じです。 次に、モデルはレンダリングを最適化してディテールをシャープにします。これは、彫刻家が石を注意深く削って布の質感や人物の形を再現するのと同じです。 最終的な結果は、仮想リアリティアプリケーション、デジタルツイン、またはロボット工学の開発に使用できる3Dオブジェクトまたは大規模なシーンです。 CVRPでNVIDIA Researchを見つける、6月18日〜22日 Neuralangeloは、6月18日から22日にバンクーバーで開催されるコンピュータビジョンとパターン認識のカンファレンス(CVRP)で発表されるNVIDIA Researchの約30のプロジェクトの1つです。これらの論文は、ポーズ推定、3D再構築、およびビデオ生成などのトピックをカバーしています。 これらのプロジェクトの1つであるDiffCollageは、長いランドスケープ方向、360度パノラマ、およびループモーション画像を含む大規模なコンテンツを作成する拡散法です。標準的なアスペクト比の画像のトレーニングデータセットをフィードすると、DiffCollageはこれらの小さな画像をコラージュのピースのように扱い、より大きなビジュアルのセクションとして扱います。これにより、拡散モデルは、同じスケールの画像のトレーニングを必要とせずに、継ぎ目のない大規模なコンテンツを生成できるようになります。 この技術は、テキストプロンプトをビデオシーケンスに変換することもできます。これは、人間の動きを捉える事前訓練された拡散モデルを使用して実証されました。 NVIDIA Researchについてもっと学ぶ。

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.