Learn more about Search Results モード - Page 50

- You may be interested

- ベントMLを使用したHugging Faceモデルの...

- 「Power BIでのデータの視点変更」

- より小さく、より速い言語モデルのための...

- 研究者たちは、医薬品の製造において画期...

- 「AIは政治をより簡単、安価かつ危険にする」

- AIエントロピー:AIによって生成されるコ...

- 『究極の没入型視覚化とモデリング体験を...

- マイクロソフトの研究者たちは、FP8混合精...

- 大規模言語モデル(LLM)とは何ですか?LL...

- 「Hugging Faceにおけるオープンソースの...

- ランダムウォークタスクにおける時差0(Tem...

- 「Pythonで日時データを扱うための3つの強...

- ボストン大学の研究者たちは、プラチプス...

- このツールは、AIによる画像の操作からあ...

- Mozilla Common Voiceでの音声言語認識-第...

「思考の連鎖を自動化する:AIが自身に推論を促す方法」

Auto-CoTのプロンプト手法は、多様性に基づくサンプリングとゼロショット生成を使用して、LLMsが複雑な推論を促すために自らデモンストレーションを生成することにより、プロンプトの作成における人間の手間を削減します実験結果は、推論タスク全体で手動プロンプトのパフォーマンスに匹敵することを示しています

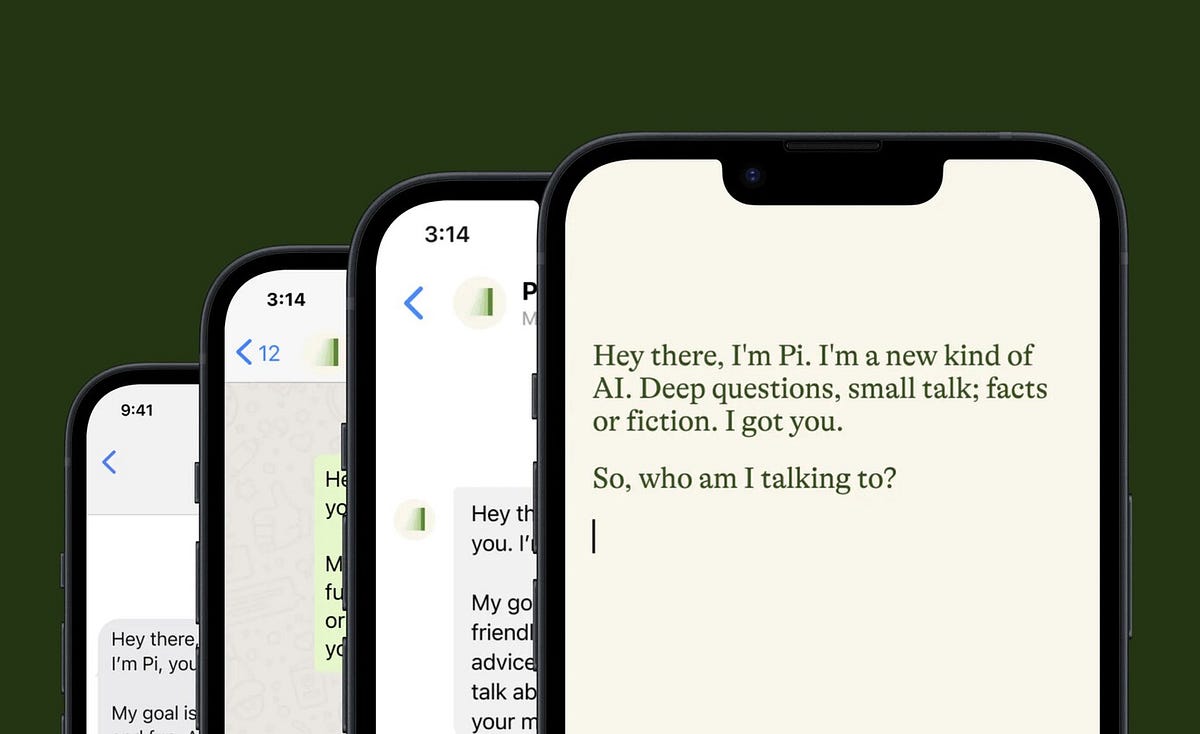

チャットGPTからPiへ、そしてなぜそうするのかをお伝えします!

2月にUX/UIデザインの旅が始まって以来、ChatGPT 🤖 を使い始めて以来、私はChatGPTを私のBFFと呼んでいます感情的になるわけではありませんが、それは私の研究のマインドセットの大きな一部でした...

話してください:モデルが読み取る単語の数はいくつですか

「LM(言語モデル)は、最近の数ヶ月間でそのスキルを披露し、様々なタスクに熟練していることを示していますこれらすべては、1つの対話モードで行われています プロンプティング最近数ヶ月間では、...」

「インテルCPU上での安定したディフューションモデルのファインチューニング」

拡散モデルは、テキストのプロンプトから写真のようなリアルな画像を生成するというその驚異的な能力によって、生成型AIの普及に貢献しました。これらのモデルは現在、合成データの生成やコンテンツ作成などの企業のユースケースに取り入れられています。Hugging Faceハブには、5,000以上の事前学習済みのテキストから画像へのモデルが含まれています。Diffusersライブラリと組み合わせることで、実験や画像生成ワークフローの構築がこれまで以上に簡単になりました。 Transformerモデルと同様に、Diffusionモデルをファインチューニングしてビジネスニーズに合ったコンテンツを生成することができます。初期のファインチューニングはGPUインフラストラクチャー上でのみ可能でしたが、状況は変わってきています!数か月前、インテルはSapphire Rapidsというコードネームの第4世代のXeon CPUを発売しました。Sapphire Rapidsは、ディープラーニングワークロードのための新しいハードウェアアクセラレータであるIntel Advanced Matrix Extensions (AMX)を導入しています。私たちはすでにいくつかのブログ記事でAMXの利点を実証しています:NLP Transformerのファインチューニング、NLP Transformerの推論、およびStable Diffusionモデルの推論。 この投稿では、Intel Sapphire Rapids CPUクラスター上でStable Diffusionモデルをファインチューニングする方法を紹介します。わずかな例の画像のみを必要とするテキスト反転という技術を使用します。たった5つの画像だけです! さあ、始めましょう。 クラスターのセットアップ Intelの友人たちが、最新のIntelプロセッサとパフォーマンス最適化されたソフトウェアスタックを使用したIntel®最適化デプロイメント環境でのワークロードの開発と実行を行うためのサービスプラットフォームであるIntel Developer Cloud(IDC)にホストされた4つのサーバーを提供してくれました。 各サーバーには、2つのIntel…

データサイエンティストのためのDockerチュートリアル

データサイエンスのためにDockerを学びたいですか?数分でDockerの基礎を学び、データサイエンスアプリをコンテナ化しましょう

機械学習(ML)の実験トラッキングと管理のためのトップツール(2023年)

機械学習プロジェクトを行う際に、単一のモデルトレーニング実行から良い結果を得ることは一つのことです。機械学習の試行をきちんと整理し、信頼性のある結論を導き出すための方法を持つことは別のことです。 実験トラッキングはこれらの問題に対する解決策を提供します。機械学習における実験トラッキングとは、実施する各実験の関連データを保存することの実践です。 実験トラッキングは、スプレッドシート、GitHub、または社内プラットフォームを使用するなど、さまざまな方法でMLチームによって実装されています。ただし、ML実験の管理とトラッキングに特化したツールを使用することが最も効率的な選択肢です。 以下は、ML実験トラッキングと管理のトップツールです Weight & Biases 重みとバイアスと呼ばれる機械学習フレームワークは、モデルの管理、データセットのバージョン管理、および実験の監視に使用されます。実験トラッキングコンポーネントの主な目的は、データサイエンティストがモデルトレーニングプロセスの各ステップを記録し、モデルを可視化し、試行を比較するのを支援することです。 W&Bは、オンプレミスまたはクラウド上の両方で使用できるツールです。Weights & Biasesは、Keras、PyTorch環境、TensorFlow、Fastai、Scikit-learnなど、さまざまなフレームワークとライブラリの統合をサポートしています。 Comet Comet MLプラットフォームを使用すると、データサイエンティストはモデルのトレーニングから本番まで、実験とモデルの追跡、比較、説明、最適化を行うことができます。実験トラッキングでは、データセット、コードの変更、実験履歴、モデルを記録することができます。 Cometは、チーム、個人、学術機関、企業向けに提供され、誰もが実験を行い、作業を容易にし、結果を素早く可視化することができます。ローカルにインストールするか、ホステッドプラットフォームとして使用することができます。 Sacred + Omniboard Sacredは、オープンソースのプログラムであり、機械学習の研究者は実験を設定、配置、ログ記録、複製することができます。Sacredには優れたユーザーインターフェースがないため、Omniboardなどのダッシュボードツールとリンクすることができます(他のツールとも統合することができます)。しかし、Sacredは他のツールのスケーラビリティに欠け、チームの協力のために設計されていない(別のツールと組み合わせる場合を除く)が、単独の調査には多くの可能性があります。 MLflow MLflowと呼ばれるオープンソースのフレームワークは、機械学習のライフサイクル全体を管理するのに役立ちます。これには実験、モデルの保存、複製、使用が含まれます。Tracking、Model Registry、Projects、Modelsの4つのコンポーネントは、それぞれこれらの要素を代表しています。 MLflow TrackingコンポーネントにはAPIとUIがあり、パラメータ、コードバージョン、メトリック、出力ファイルなどの異なるログメタデータを記録し、後で結果を表示することができます。…

「2023年7月のAIボイスチェンジャーツールのトップ10」

ボイスチェンジングソフトウェアは、ユーザーがリアルタイムで声を変更したり、事前に録音された音声を変更したりすることができるAIアプリケーションの一種ですこれらのソフトウェアソリューションは、声のピッチや速度を変えたり、ユーザーの声を有名人など他の誰かや何かに変換したりするなど、さまざまな効果を提供します

認知的燃焼の引火:認知アーキテクチャとLLMの融合による次世代コンピュータの構築

「技術はシステムに統合されることで飛躍的な進展を遂げますこの記事では、言語モデルを統合したアーキテクチャの取り組みについて探求し、コンピューティングの次の飛躍を引き起こす可能性を検討します」

認知的な燃焼を引き起こす:認知アーキテクチャとLLMの融合による次世代コンピュータの構築

技術はシステムに統合されることで、ブレークスルーとなりますこの記事では、言語モデルを統合する取り組みについて探求し、次のコンピューティングのブレークスルーを引き起こす可能性のあるアーキテクチャについて説明します

LAION AIは、Video2Datasetを紹介しますこれは、効率的かつスケールでビデオとオーディオのデータセットをキュレーションするために設計されたオープンソースツールです

CLIP、Stable Diffusion、Flamingoなどの大規模な基盤モデルは、過去数年間にわたり、マルチモーダルな深層学習を劇的に向上させました。テキストと画像の共同モデリングは、ニッチなアプリケーションから、今日の人工知能の領域で最も関連性の高い問題の1つ(もしくは最も関連性の高い問題)にまで進化しました。これらのモデルは、壮観で高解像度のイメージを生成したり、難しい下流の問題を解決するといった、卓越した能力を持っています。驚くべきことに、これらのモデルは、非常に異なるタスクに取り組み、非常に異なる設計を持っているにもかかわらず、強力なパフォーマンスに貢献する共通の3つの基本的な特性を持っています。それは、(事前)トレーニング中のシンプルで安定した目的関数、よく調査されたスケーラブルなモデルアーキテクチャ、そしておそらく最も重要なこととして、大規模で多様なデータセットです。 2023年現在、マルチモーダルな深層学習は、テキストと画像のモデリングに主に関心があり、ビデオ(および音声)などの追加のモダリティにはほとんど注意が払われていません。モデルをトレーニングするために使用される技術は通常モダリティに依存しないため、なぜ他のモダリティ用の堅牢な基盤モデルが存在しないのか疑問に思うかもしれません。その簡単な説明は、高品質で大規模なアノテーション付きデータセットの希少性です。クリーンなデータの不足は、特にビデオの領域において、大規模なマルチモーダルモデルの研究開発を妨げています。これに対し、画像モデリングでは、LAION-5B、DataComp、COYO-700Mなどのスケーリング用の確立されたデータセットやimg2datasetなどのスケーラブルなツールが存在します。 革新的なイニシアチブ、例えば高品質なビデオや音声の作成、改良された事前学習済みモデルのロボット工学への応用、盲人コミュニティ向けの映画ADなどを可能にするため、研究者はこのデータの問題解決を(オープンソースの)マルチモーダル研究の中心的目標として提案しています。 研究者は、高速で包括的なビデオおよび音声データセットのキュレーションを行うためのオープンソースプログラムであるvideo2datasetを提案しています。video2datasetは、いくつかの大規模なビデオデータセットで正常にテストされており、適応性があり、拡張性があり、多数の変換を提供しています。このメソッドを複製するための詳細な手順と、これらのケーススタディをリポジトリで見つけることができます。 研究者は、個々のビデオデータセットをダウンロードし、それらを結合し、新しい特徴と大量のサンプルを持つより管理しやすい形状に整形することで、既存のビデオデータセットをベースにvideo2datasetを活用してきました。より詳細な説明については、例セクションを参照してください。video2datasetが提供するデータセットで異なるモデルをトレーニングした結果は、このツールの効果を示しています。今後の研究では、新しいデータセットと関連する調査結果について詳しく議論します。 まずは、video2datasetを定義しましょう。 Webdatasetが受け入れ可能なinput_formatであるため、video2datasetは以前にダウンロードしたデータを再処理するためのチェーンで使用することができます。前の例でダウンロードしたWebVidデータを使用して、このスクリプトを実行すると、各ムービーの光流を計算し、それをメタデータシャードに保存します(光流メタデータのみを含むシャード)。 アーキテクチャ img2datasetをベースにしているvideo2datasetは、URLのリストと関連するメタデータを受け取り、単一のコマンドでロード可能なWebDatasetに変換します。さらに、同じシャードの内容を保持したまま、WebDatasetを追加の変更のために再処理することもできます。video2datasetはどのように機能するのでしょうか。説明します。 アイデアの交換 最初のステップは、入力データを均等にワーカー間で分割することです。これらの入力シャードは一時的にキャッシュされ、それらとそれらに対応する出力シャードとの一対一のマッピングにより、障害のない回復が保証されます。データセットの処理が予期せず終了した場合、既に対応する出力シャードを持つ入力シャードをスキップすることで時間を節約することができます。 コミュニケーションと研究 ワーカーは、シャードに含まれるサンプルを読み取り、処理するために交互に行動します。研究者は、マルチプロセス、pyspark、slurmの3つの異なる分散モードを提供しています。前者は単一マシンのアプリケーションに最適であり、後者は複数のマシンにスケーリングするために有用です。着信データセットの形式は、読み取り戦略を決定します。データがURLのテーブルである場合、video2datasetはインターネットからビデオを取得し、データセットに追加します。video2datasetは、見つからないビデオを要求するためにyt-dlpを使用するため、さまざまなビデオプラットフォームで動作します。ただし、ビデオサンプルが既存のWebデータセットから来る場合、そのデータセットのデータローダーはバイトまたはフレームのテンソル形式を読み取ることができます。 サブサンプリング ビデオが読み込まれ、ワーカーがビデオのバイトを取得した後、バイトはジョブの設定に従ってサブサンプラーのパイプラインを通過します。この段階では、ビデオはフレームレートと解像度の両方でオプションでダウンサンプリングされる場合があります。また、クリップされたり、シーンが識別されたりする場合もあります。一方、入力モダリティから解像度/圧縮情報、合成キャプション、オプティカルフローなどのメタデータを抽出および追加することを目的としたサブサンプラーもあります。video2datasetに新しい変換を追加するには、新しいサブサンプラーを定義するか、既存のサブサンプラーを変更するだけで十分です。これは大いに助けになり、リポジトリの他の場所で数か所の変更を行うだけで実装できます。 ログ記録 Video2datasetは、プロセスの複数のポイントで詳細なログを保持しています。各シャードの完了は、関連する「ID」_stats.jsonファイルに結果を記録します。ここには、処理されたサンプルの総数、正常に処理されたサンプルの割合、および発生したエラーの内容と性質などの情報が記録されます。Weights & Biases(wand)は、video2datasetと組み合わせて使用できる追加のツールです。この統合をオンにするだけで、成功と失敗の詳細なパフォーマンスレポートやメトリクスにアクセスできます。これらの機能は、ジョブ全体に関連するベンチマーキングやコスト見積りのタスクに役立ちます。 書き込み 最後に、video2datasetは変更された情報を出力シャードにユーザー指定の場所に保存し、次のトレーニングまたは再処理操作で使用します。データセットは、各サンプルが含まれるシャードで構成されたいくつかの形式でダウンロードできます。これらの形式には、フォルダ、tarファイル、レコード、およびparquetファイルが含まれます。デバッグ用の小規模データセットにはディレクトリ形式、ローディングにはWebDataset形式でtarファイルが使用されます。 再処理 video2datasetは、出力シャードを読み込んでサンプルを新しい変換に通過させることで、以前の出力データセットを再処理することができます。この機能は、しばしば重いサイズと扱いにくい性質が特徴のビデオデータセットに対して特に有利です。これにより、大量の大きなデータセットのダウンロードを回避するためにデータを慎重にダウンサンプリングすることができます。次のセクションでは、研究者がこれに関する実践的な例を探求します。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.