Learn more about Search Results the Hub - Page 4

- You may be interested

- 「このタイトルを無視してHackAPrompt:LL...

- 小さな言語モデル(SLM)とその応用につい...

- ボードゲームをプレイするためのAIの教育

- 🤗 Transformersを使用してTensorFlowとTP...

- 「アニマ・アナンドクマールとともにAIを...

- Glassdoorの解読:情報に基づく意思決定の...

- すべての開発者が知るべき6つの生成AIフレ...

- 「WHOが医療分野におけるAI規制の考慮事項...

- 「Protopia AIによる企業LLMアクセラレー...

- HNSW(Hierarchical Navigable Small Worl...

- ETHチューリッヒとマイクロソフトの研究者...

- スタビリティAIが日本語のStableLMアルフ...

- ゼロショットCLIPのパフォーマンスを向上...

- 「PowerBIでのデータ操作のためのPower Qu...

- スウィン・トランスフォーマー | モダンな...

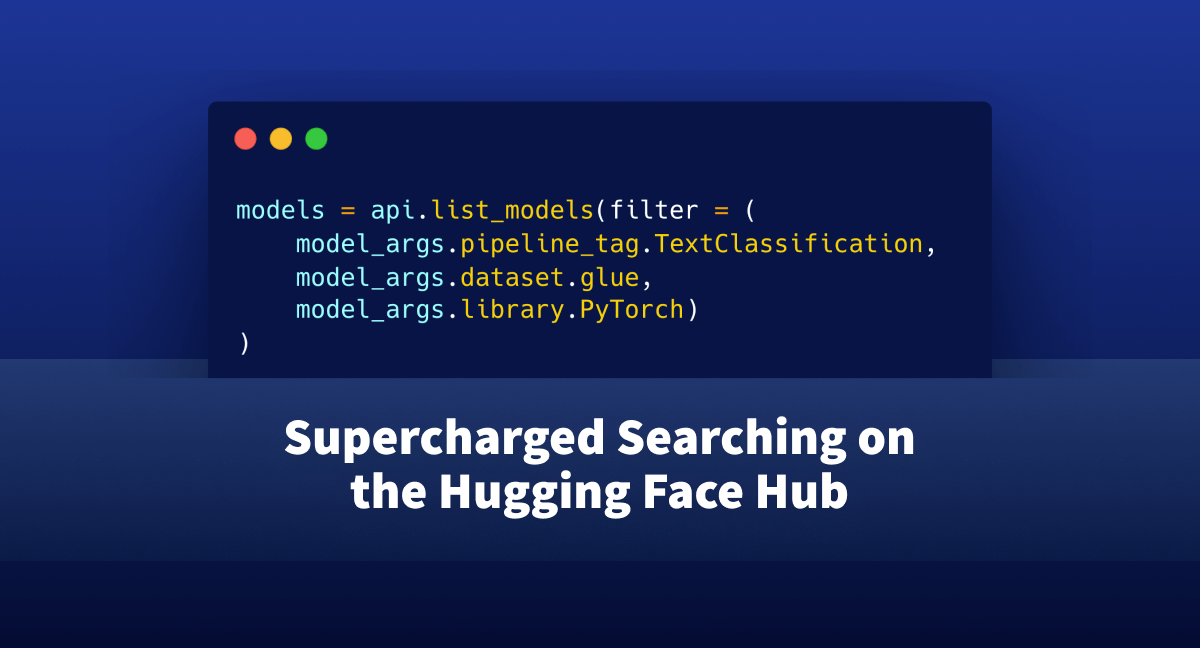

🤗 Hubでのスーパーチャージド検索

huggingface_hubライブラリは、ホスティングエンドポイント(モデル、データセット、スペース)を探索するためのプログラム的なアプローチを提供する軽量なインタフェースです。 これまでは、このインタフェースを介してハブでの検索は難しく、ユーザーは「知っているだけ」で慣れなければならない多くの側面がありました。 この記事では、huggingface_hubに追加されたいくつかの新機能を紹介し、ユーザーにJupyterやPythonインタフェースを離れずに使用したいモデルやデータセットを検索するためのフレンドリーなAPIを提供します。 始める前に、システムに最新バージョンのhuggingface_hubライブラリがない場合は、次のセルを実行してください: !pip install huggingface_hub -U 問題の位置づけ: まず、自分がどのようなシナリオにいるか想像してみましょう。テキスト分類のためにハブでホストされているすべてのモデルを見つけたいとします。これらのモデルはGLUEデータセットでトレーニングされ、PyTorchと互換性があります。 https://huggingface.co/models を単に開いてそこにあるウィジェットを使用することもできます。しかし、これによりIDEを離れて結果をスキャンする必要がありますし、必要な情報を得るためにはいくつかのボタンクリックが必要です。 もしもIDEを離れずにこれを解決する方法があったらどうでしょうか?プログラム的なインタフェースであれば、ハブを探索するためのワークフローにも簡単に組み込めるかもしれません。 ここでhuggingface_hubが登場します。 このライブラリに慣れている方は、すでにこの種のモデルを検索できることを知っているかもしれません。しかし、クエリを正しく取得することは試行錯誤の痛ましいプロセスです。 それを簡略化することはできるでしょうか?さあ、見てみましょう! 必要なものを見つける まず、HfApiをインポートします。これはHugging Faceのバックエンドホスティングと対話するのに役立つクラスです。モデル、データセットなどを通じて対話することができます。さらに、いくつかのヘルパークラスもインポートします:ModelFilterとModelSearchArguments from huggingface_hub import HfApi, ModelFilter,…

Hugging Face Hubへようこそ、PaddlePaddleさん

私たちは、オープンソースのコラボレーションをHugging FaceとPaddlePaddleの間で共有し、オープンソースを通じてAIの進歩と民主化を推進する共通の使命を喜んで共有します! 2016年にBaiduによって最初にオープンソース化されたPaddlePaddleは、スキルレベルに関係なく、開発者がディープラーニングをスケールで採用および実装できるようにします。2022年第4四半期現在、PaddlePaddleは500万人以上の開発者と20万社以上の企業によって使用されており、中国のディープラーニングプラットフォームの中で市場シェア第1位です。PaddlePaddleには、Paddle Deep Learning Framework、さまざまなモダリティのモデルライブラリ(例:PaddleOCR、PaddleDetection、PaddleNLP、PaddleSpeech)、モデル圧縮のためのPaddleSlim、モデル展開のためのFastDeployなど、人気のあるオープンソースのリポジトリがあります。 PaddleNLPが先導する中、PaddlePaddleはHugging Face Hubとそのライブラリを徐々に統合していく予定です。近々、テキスト、画像、音声、ビデオ、マルチモダリティの豪華な事前学習済みPaddlePaddleモデルのフルスイートをHubでお楽しみいただけるようになります! PaddlePaddleモデルの検索 PaddlePaddleモデルは、PaddlePaddleライブラリタグでフィルタリングすることで、モデルハブで見つけることができます。 既にハブには75以上のPaddlePaddleモデルがあります。例えば、マルチタスク情報抽出モデルシリーズUIE、最先端の中国語言語モデルERNIE 3.0モデルシリーズ、全ワークフローにおけるレイアウト知識強化のための革新的なドキュメントプレトレーニングモデルErnie-Layoutなどがあります。 HuggingFace HubのPaddlePaddle orgもぜひご覧ください。上記のモデルに加えて、テキストからイメージへの変換Ernie-ViLG、クロスモーダル情報抽出エンジンUIE-X、素晴らしいマルチリンガルOCRツールキットPaddleOCRなど、さまざまなスペースを探索することもできます。 推論APIとウィジェット PaddlePaddleモデルは、HTTPを介してcURL、Pythonのrequestsライブラリ、またはネットワークリクエストを行うためのご希望の方法でアクセスできる推論APIを通じて利用できます。 タスクをサポートするモデルには、ブラウザで直接モデルを操作できるインタラクティブなウィジェットが備わっています。 既存のモデルの使用 特定のモデルを読み込む方法を確認したい場合は、Use in paddlenlp(または将来の他のPaddlePaddleライブラリ)をクリックすると、それを読み込むための動作するスニペットが表示されます! モデルの共有…

BERTopicとHugging Face Hubの統合をご紹介します

私たちは、BERTopic Pythonライブラリの重要なアップデートを発表して大変喜んでいます。これにより、トピックモデリングの愛好家や実践者のためのワークフローがさらに効率化され、機能が拡張されました。BERTopicは、Hugging Face Hubへのトレーニング済みトピックモデルの直接プッシュとプルをサポートするようになりました。この新しい統合により、BERTopicのパワーを生かして製品の使用例でのトピックモデリングが簡単に行えるようになりました。 トピックモデリングとは何ですか? トピックモデリングは、ドキュメントのグループ内に隠れたテーマや「トピック」を明らかにするのに役立つメソッドです。ドキュメント内の単語を分析することで、これらの潜在的なトピックを明らかにするパターンや関連性を見つけることができます。たとえば、機械学習に関するドキュメントは、「勾配」や「埋め込み」といった単語を使用する可能性が高く、パンの焼き方に関するドキュメントとは異なります。 各ドキュメントは通常、異なる比率で複数のトピックをカバーしています。単語の統計を調べることで、これらのトピックを表す関連する単語のクラスタを特定することができます。これにより、ドキュメントの分析と、それぞれのドキュメント内のトピックのバランスを決定することができます。より最近では、トピックモデリングの新しいアプローチでは、単語の使用ではなく、Transformerベースのモデルなど、より豊かな表現を使用するようになりました。 BERTopicとは何ですか? BERTopicは、さまざまな埋め込み技術とc-TF-IDFを使用して、トピックモデリングのプロセスを簡素化し、重要な単語をトピックの説明に保持しながら、密なクラスタを作成する最新のPythonライブラリです。 BERTopicライブラリの概要 BERTopicは初心者でも簡単に始めることができますが、ガイド付き、教師付き、半教師付き、およびマニュアルトピックモデリングなど、トピックモデリングのさまざまな高度なアプローチをサポートしています。最近では、BERTopicはマルチモーダルトピックモデルもサポートしています。BERTopicには、視覚化ツールの豊富なセットもあります。 BERTopicは、テキストコレクション内の重要なトピックを明らかにするための強力なツールを提供し、貴重な洞察を得ることができます。BERTopicを使用すると、顧客のレビューを分析したり、研究論文を探索したり、ニュース記事をカテゴリ分けしたりすることが容易になります。テキストデータから意味のある情報を抽出したいと考えている人にとって、これは必須のツールです。 Hugging Face Hubを使用したBERTopicモデルの管理 最新の統合により、BERTopicのユーザーはトレーニング済みのトピックモデルをHugging Face Hubにシームレスにプッシュおよびプルすることができます。この統合により、異なる環境でのBERTopicモデルの展開と管理が簡素化されるという重要なマイルストーンが達成されました。 BERTopicモデルのトレーニングとハブへのプッシュは、数行で行うことができます from bertopic import BERTopic topic_model…

Hugging Face Hubへ、fastText をようこそお迎えください

fastTextは、テキストの表現と分類の効率的な学習のためのライブラリです。Meta AIによって2016年にオープンソース化され、fastTextは過去数十年間の自然言語処理と機械学習において影響力のあるキーワードを統合しています。具体的には、文を単語の袋とn-gramの袋を使用して表現し、サブワード情報を利用し、クラス間で情報を共有するための隠れた表現を使用します。 計算を高速化するために、fastTextはクラスの不均衡な分布を活用した階層的なソフトマックスを使用します。これらの技術により、ユーザーはテキストの表現と分類のためのスケーラブルなソリューションを提供します。 Hugging Faceは、現在、157か国のすべての言語と最新の言語識別モデルの公式ミラーをホストしています。これは、Hugging Faceを使用することで、数回のコマンドでモデルを簡単にダウンロードして使用できることを意味します。 モデルの検索 157か国の言語の単語ベクトルと言語識別モデルは、Meta AIのorgで見つけることができます。例えば、こちらで英語の単語ベクトルのモデルページを見つけることができます。また、こちらで言語識別モデルを見つけることができます。 ウィジェット この統合には、テキスト分類と特徴抽出のウィジェットのサポートが含まれています。こちらで言語識別ウィジェットを試してみることができます。また、こちらで特徴抽出ウィジェットを試してみることができます。 使用方法 以下は、事前学習済みのベクトルを読み込んで使用する方法です: >>> import fasttext >>> from huggingface_hub import hf_hub_download >>> model_path =…

DuckDB Hugging Face Hubに保存されている50,000以上のデータセットを分析する

Hugging Face Hubは、誰にでもデータセットへのオープンアクセスを提供し、ユーザーがそれらを探索し理解するためのツールを提供することに特化しています。Falcon、Dolly、MPT、およびStarCoderなどの人気のある大規模言語モデル(LLM)のトレーニングに使用されるデータセットの多くを見つけることができます。不公平性や偏見を解決するためのDisaggregatorsのようなデータセット用のツールや、データセット内の例をプレビューするためのDataset Viewerなどのツールもあります。 Dataset Viewerを使用してOpenAssistantデータセットのプレビューを表示します。 私たちは、Hub上のデータセットを分析するための別の機能を最近追加しました。Hubに保存されている任意のデータセットでDuckDBを使用してSQLクエリを実行できます!2022年のStackOverflow Developer Surveyによると、SQLは3番目に人気のあるプログラミング言語です。また、分析クエリを実行するために設計された高速なデータベース管理システム(DBMS)が必要でしたので、DuckDBとの統合に興奮しています。これにより、より多くのユーザーがHub上のデータセットにアクセスし、分析することができると思います! 要約 Datasets Serverは、Hub上のすべての公開データセットをParquetファイルに自動変換します。データセットページの上部にある「Auto-converted to Parquet」ボタンをクリックすることで、それらのファイルを表示することができます。また、単純なHTTP呼び出しでParquetファイルのURLリストにアクセスすることもできます。 r = requests.get("https://datasets-server.huggingface.co/parquet?dataset=blog_authorship_corpus") j = r.json() urls = [f['url'] for…

ギャラリー、図書館、アーカイブ、博物館向けのHugging Face Hub

ギャラリー、図書館、アーカイブ、博物館のためのハギングフェイスハブ ハギングフェイスハブとは何ですか? Hugging Faceは、高品質な機械学習を誰にでもアクセス可能にすることを目指しています。この目標は、広く使われているTransformersライブラリなどのオープンソースのコードライブラリを開発すること、無料のコースを提供すること、そしてHugging Faceハブを提供することなど、さまざまな方法で追求されています。 Hugging Faceハブは、人々が機械学習モデル、データセット、デモを共有しアクセスできる中央リポジトリです。ハブには19万以上の機械学習モデル、3万3000以上のデータセット、10万以上の機械学習アプリケーションとデモがホストされています。これらのモデルは、事前学習済みの言語モデル、テキスト、画像、音声分類モデル、物体検出モデル、さまざまな生成モデルなど、さまざまなタスクをカバーしています。 ハブにホストされているモデル、データセット、デモは、さまざまなドメインと言語をカバーしており、ハブを通じて利用できる範囲を拡大するための定期的なコミュニティの取り組みが行われています。このブログ記事は、ギャラリー、図書館、アーカイブ、博物館(GLAM)セクターで働く人々がハギングフェイスハブをどのように利用して貢献できるかを理解することを目的としています。 記事全体を読むか、最も関連のあるセクションにジャンプすることができます! ハブが何か分からない場合は、「ハギングフェイスハブとは何ですか?」から始めてください。 ハブで機械学習モデルを見つける方法を知りたい場合は、「ハギングフェイスハブの使用方法:ハブで関連するモデルを見つける方法」から始めてください。 ハブでGLAMデータセットを共有する方法を知りたい場合は、「ウォークスルー:GLAMデータセットをハブに追加する方法」から始めてください。 いくつかの例を見たい場合は、「ハギングフェイスハブの使用例」をチェックしてください。 ハギングフェイスハブで何を見つけることができますか? モデル Hugging Faceハブは、さまざまなタスクとドメインをカバーする機械学習モデルへのアクセスを提供しています。多くの機械学習ライブラリがHugging Faceハブとの統合を持っており、これらのライブラリを介して直接モデルを使用したりハブに共有したりすることができます。 データセット Hugging Faceハブには3万以上のデータセットがあります。これらのデータセットには、テキスト、画像、音声、マルチモーダルなど、さまざまなドメインとモダリティがカバーされています。これらのデータセットは、機械学習モデルのトレーニングや評価に価値があります。 スペース Hugging Face…

GitHubトピックススクレイパー | PythonによるWebスクレイピング

「GitHub Topics Scraper」このプロジェクトは、GitHub Topicsページから情報を取得し、リポジトリ名と詳細を抽出することを目的としています

「SDXLのためのシンプルな最適化の探究」

ステーブル ディフュージョン XL (SDXL)は、Stability AIによる高品質な超現実的な画像生成を目的とした最新の潜在ディフュージョンモデルです。これは、手やテキストの正確な生成、および空間的に正しい構成といった、以前のステーブル ディフュージョンモデルの課題を克服しています。さらに、SDXLはコンテキストにより適応しており、より見栄えの良い画像を生成するために、プロンプトで少ない単語数を必要とします。 しかし、これらの改善は、かなり大きなモデルのコストで実現されています。具体的には、基本のSDXLモデルには35億のパラメータ(特にUNet)があり、それは以前のステーブル ディフュージョンモデルのおよそ3倍の大きさです。 SDXLの推論速度とメモリ使用量を最適化する方法を探るために、A100 GPU(40 GB)でいくつかのテストを行いました。各推論実行において、4つの画像を生成し、それを3回繰り返し行います。推論レイテンシを計算する際には、3回のイテレーションのうち最終イテレーションのみを考慮します。 つまり、デフォルトの精度とデフォルトのアテンションメカニズムを使用してSDXLをそのまま実行すると、メモリを28GB消費し、72.2秒かかります! from diffusers import StableDiffusionXLPipelinepipeline = StableDiffusionXLPipeline.from_pretrained("stabilityai/stable-diffusion-xl-base-1.0").to("cuda")pipeline.unet.set_default_attn_processor() しかし、これは非常に実用的ではなく、特に4つ以上の画像を生成する場合には遅くなる可能性があります。また、よりパワフルなGPUを持っていない場合、メモリ不足のエラーメッセージに遭遇するかもしれません。では、どのようにしてSDXLを最適化して推論速度を向上させ、メモリ使用量を減らすことができるでしょうか? 🤗 Diffusersでは、SDXLのようなメモリ集中型モデルを実行するための最適化のトリックとテクニックを数多く提供しています。以下では、推論速度とメモリに焦点を当てます。 推論速度 ディフュージョンはランダムなプロセスですので、好みの画像が得られる保証はありません。よくあるのは、複数回の推論を実行して反復する必要があることです。そのため、速度の最適化が重要です。このセクションでは、低精度の重みとメモリ効率の良いアテンションおよびPyTorch 2.0のtorch.compileの使用に焦点を当てて、速度を向上させ、推論時間を短縮する方法を紹介します。…

Pythonコード生成のためのLlama-2 7Bモデルのファインチューニング

約2週間前、生成AIの世界はMeta社が新しいLlama-2 AIモデルをリリースしたことによって驚かされましたその前身であるLlama-1は、LLM産業において画期的な存在であり、…

ハブでの評価の発表

TL;DR : 今日はAutoTrainでパワードされた新しいツール、Evaluation on the Hubを紹介します。このツールを使用すると、コードを1行も書かずにHub上の任意のモデルを任意のデータセットで評価することができます! 全てのモデルを評価しましょう🔥🔥🔥! AIの進歩は驚くべきものであり、一部の人々はAIモデルが特定のタスクにおいて人間よりも優れているかもしれないと真剣に議論しています。しかし、この進歩は均等ではありませんでした。数十年前の機械学習者にとって、現代のハードウェアやアルゴリズムは驚くべきものに見えるかもしれませんし、利用可能なデータと計算能力の量も同様ですが、モデルの評価方法はほぼ同じままでした。 しかし、現代のAIは評価の危機に直面していると言っても過言ではありません。適切な評価には、多くのモデルを多くのデータセットで、複数の指標で測定する必要があります。しかし、これを行うことは不必要に手間がかかります。特に再現性に重点を置く場合、自己報告された結果は、偶発的なバグ、実装の微妙な違い、またはそれ以上の問題によって影響を受けている可能性があります。 私たちは、より良い評価が可能であると信じています。それには、私たちコミュニティがより良いベストプラクティスを確立し、障壁を取り除こうとすることが必要です。過去数か月間、私たちはEvaluation on the Hubに取り組んできました:ボタンをクリックするだけで、任意のモデルを任意のデータセットで任意のメトリックを使用して評価することができます。始めるには、いくつかの主要なデータセットで何百ものモデルを評価し、Hub上のモデルカードに新しい素敵なPull Request機能を使用して、検証済みのパフォーマンスを表示するための多くのPRを公開しました。評価結果は、モデルカードのメタデータに直接エンコードされ、Hub上のすべてのモデルに対してフォーマットが適用されます。DistilBERTのモデルカードをチェックしてみてください! On the Hub Hub上の評価は、非常に興味深いユースケースを提供します。データサイエンティストやエグゼクティブがどのモデルを展開するかを決定する必要がある場合や、新しいデータセットで論文の結果を再現しようとする学者、展開のリスクをよりよく理解したい倫理学者などにとって、これは非常に役立ちます。最初の3つの主要なユースケースシナリオを挙げると、次のようなものがあります: タスクに最適なモデルを見つける 自分のタスクが明確であり、その仕事に適したモデルを見つけたいとします。タスクを代表するデータセットのリーダーボードをチェックできます。素晴らしいですね!もし興味のある新しいモデルが、そのデータセットのリーダーボードにまだ掲載されていない場合は、Hubを離れずに評価を実行することができます。 新しいデータセットでモデルを評価する 新しく作成したデータセットでベースラインを実行したい場合はどうでしょう?Hubにアップロードして、それに対して評価したいモデルを何個でも評価することができます。コードは不要です。さらに、自分のデータセットでこれらのモデルを評価する方法が、他のデータセットで評価された方法とまったく同じであることを確信することができます。 自分のモデルを他の関連する多くのデータセットで評価する また、SQuADでトレーニングされた全く新しい質問応答モデルがあるとしましょう。評価するためのさまざまな質問応答データセットが何百もあります…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.