Learn more about Search Results Low-Rank Adaptation - Page 4

- You may be interested

- 「ODSC Europe 2023のトップバーチャルセ...

- 「Amazon Redshift」からのデータを使用し...

- UCLとGoogleの研究者が提案する「AudioSlo...

- BScの後に何をすべきか?トップ10のキャリ...

- 「LangchainなしでPDFチャットボットを構...

- 関数呼び出し:GPTチャットボットを何にで...

- 「データセンターの廃熱を利用して家を暖...

- 2023年に使用するための10の最高のAI画像...

- 環境データサイエンス:イントロダクション

- 1時間以内に初めてのディープラーニングア...

- BYOL(Bootstrap Your Own Latent)— コン...

- 「不可能」なミリ波センサーには広範な可...

- ヒストグラムとカーネル密度推定の理解

- 「Amazon SageMaker JumpStart上で、生成...

- 「コンプライアンス自動化標準ソリューシ...

「Amazon SageMakerを使用して、生成AIを使ってパーソナライズされたアバターを作成する」

生成AIは、エンターテイメント、広告、グラフィックデザインなど、さまざまな産業で創造プロセスを向上させ、加速させるための一般的なツールとなっていますそれにより、観客によりパーソナライズされた体験が可能となり、最終製品の全体的な品質も向上します生成AIの一つの重要な利点は、ユーザーに対してユニークでパーソナライズされた体験を作り出すことです例えば、[…]

ハッピーな1周年 🤗 ディフューザーズ!

🤗 Diffusersは、1周年を迎えることを喜んでいます!エキサイティングな1年であり、コミュニティとオープンソースの貢献者のおかげで、私たちは遠くまで来ることができました。昨年、DALL-E 2、Imagen、およびStable Diffusionなどのテキストから画像を生成するモデルが世界の注目を集め、生成AIの興味と開発が急速に広がりました。しかし、これらの強力なモデルへのアクセスは制限されていました。 Hugging Faceでは、協力し合い、オープンで倫理的なAIの未来を共に築くために、良い機械学習を民主化することをミッションとしています。このミッションに基づき、🤗 Diffusersライブラリを作成しました。これにより、誰もがテキストから画像を実験、研究、または単に遊ぶことができます。そのため、ライブラリをモジュール化されたツールボックスとして設計しました。モデルのコンポーネントをカスタマイズするか、そのまま使うことができます。 🤗 Diffusersが1周年を迎えるにあたり、コミュニティの助けを借りてライブラリに追加されたいくつかの注目すべき機能について概要をご紹介します。私たちは、アクセスしやすい使用方法を促進し、テキストから画像を生成するだけでなく、拡散モデルをさらに推進し、万能なインスピレーションを提供する熱心なコミュニティの一員であることを誇りに思っています。 目次 写真のリアルさを追求する ビデオパイプライン テキストから3Dモデルへ 画像編集パイプライン 高速拡散モデル 倫理と安全 LoRAのサポート Torch 2.0の最適化 コミュニティのハイライト 🤗 Diffusersを使用して製品を作成する 将来に向けて 写真のリアルさを追求する…

「プライベートGPT:エンタープライズデータでLLMを微調整する」

「ビッグデータと先進的な人工知能の時代において、言語モデルは人間のようなテキストの処理や生成が可能な強力なツールとして登場しましたChatGPTのような大規模な言語モデルは...」

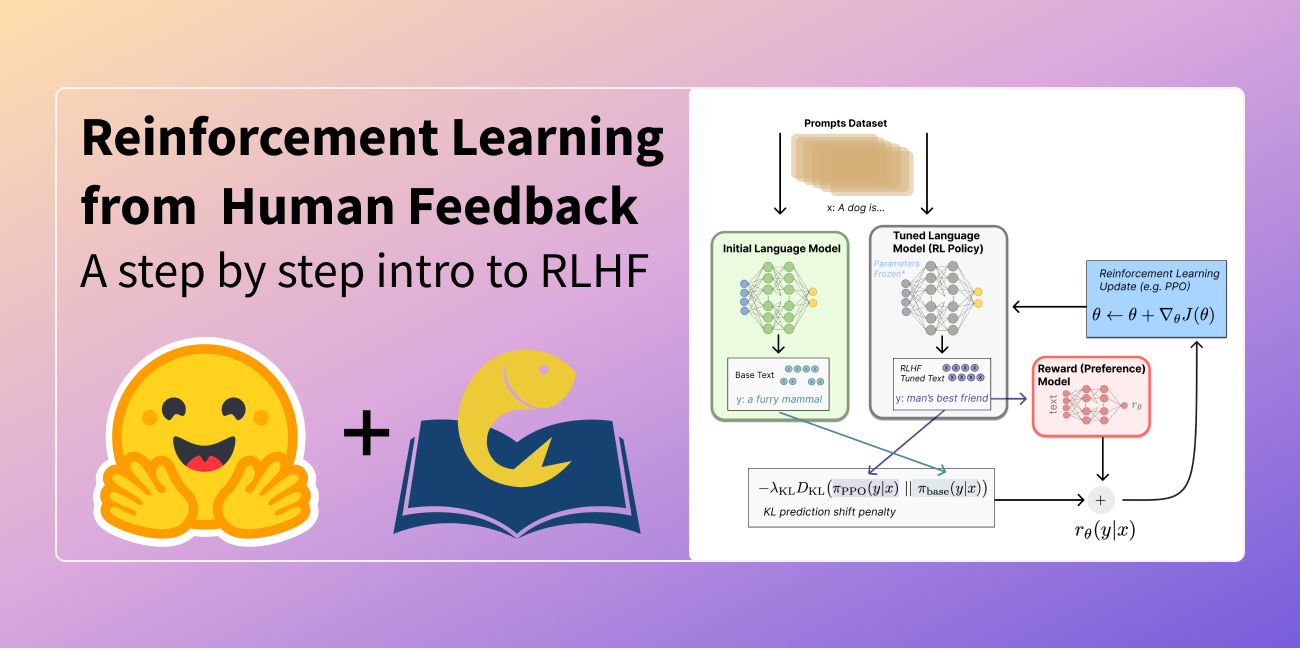

人間のフィードバックからの強化学習(RLHF)の説明

この記事は以下の言語に翻訳されています:中国語(簡体字)とベトナム語。他の言語に翻訳に興味がありますか?nathan at huggingface.co までお問い合わせください。 言語モデルは、過去数年間に人間の入力プロンプトから多様で魅力的なテキストを生成する能力を示してきました。しかし、「良い」テキストとは何かは、主観的で文脈に依存するため、本質的に定義するのは難しいです。創造性を求める物語の執筆などの多くのアプリケーションでは、真実であるべき情報の断片、または実行可能なコードのスニペットなどが必要です。 これらの属性を捉えるための損失関数を作成することは困難であり、ほとんどの言語モデルはまだ単純な次のトークン予測の損失(例:クロスエントロピー)で訓練されています。損失自体の欠点を補うために、人々はBLEUやROUGEなど、人間の優先順位をより適切に捉えるように設計されたメトリクスを定義しています。これらのメトリクスは、パフォーマンスを測定する上で損失関数自体より適しているものの、生成されたテキストを単純なルールで参照テキストと比較するだけなので、制約もあります。生成されたテキストに対する人間のフィードバックをパフォーマンスの指標として使用するか、さらに進んでそのフィードバックを損失としてモデルを最適化することができれば、素晴らしいことではないでしょうか?それが「人間のフィードバックによる強化学習(RLHF)」のアイデアです。強化学習の手法を使用して、言語モデルを人間のフィードバックで直接最適化するのです。RLHFにより、言語モデルは一般的なテキストデータのコーパスで訓練されたモデルを複雑な人間の価値に合わせることができるようになりました。 RLHFの最近の成功例は、ChatGPTでの使用です。ChatGPTの印象的な能力を考慮して、RLHFについて説明してもらいました: それは驚くほどうまくいっていますが、すべてをカバーしているわけではありません。それらのギャップを埋めましょう! 人間のフィードバックによる強化学習(RL from human preferencesとも呼ばれます)は、複数のモデルのトレーニングプロセスと異なる展開の段階を伴うため、難しい概念です。このブログ記事では、トレーニングプロセスを次の3つの主要なステップに分解します: 言語モデル(LM)の事前トレーニング データの収集と報酬モデルのトレーニング 強化学習によるLMの微調整 まず、言語モデルの事前トレーニングについて見ていきましょう。 言語モデルの事前トレーニング RLHFの出発点として、クラシカルな事前トレーニング目標で既に事前トレーニングされた言語モデルを使用します(詳細については、このブログ記事を参照してください)。OpenAIは、最初の人気のあるRLHFモデルであるInstructGPTに対して、より小さなバージョンのGPT-3を使用しました。Anthropicは、このタスクのためにトレーニングされた1,000万から520億のパラメータを持つトランスフォーマーモデルを使用しました。DeepMindは、2800億のパラメータモデルGopherを使用しました。 この初期モデルは、追加のテキストや条件で微調整することもできますが、必ずしも必要ではありません。たとえば、OpenAIは「好ましい」とされる人間が生成したテキストを微調整し、Anthropicは彼らの「助けになり、正直で無害な」基準に基づいて元のLMを蒸留することで、RLHFのための初期LMを生成しました。これらは共に、私が高価な増強データと呼ぶものの一部ですが、RLHFを理解するために必要なテクニックではありません。 一般的に、「どのモデル」がRLHFの出発点として最適かは明確な答えがありません。このブログ記事では、RLHFのトレーニングにおけるオプションの設計空間が完全に探索されていないという共通のテーマになります。 次に、言語モデルが必要なデータを生成して、人間の優先順位がシステムに統合される「報酬モデル」をトレーニングする必要があります。 報酬モデルのトレーニング 人間の優先順位に合わせてキャリブレーションされた報酬モデル(RM、優先モデルとも呼ばれます)を生成することは、RLHFの比較的新しい研究の出発点です。その基本的な目標は、テキストのシーケンスを受け取り、数値で人間の優先順位を表すべきスカラー報酬を返すモデルまたはシステムを取得することです。システムはエンドツーエンドのLMであるか、報酬を出力するモジュラーシステム(例:モデルが出力をランク付けし、ランキングが報酬に変換される)である場合があります。出力がスカラーの報酬であることは、既存のRLアルゴリズムが後のRLHFプロセスにシームレスに統合されるために重要です。 報酬モデリングのためのこれらの言語モデルは、別の微調整された言語モデルまたは好みのデータでスクラッチからトレーニングされた言語モデルのいずれかです。例えば、Anthropicは、これらのモデルを事前トレーニング(好みモデルの事前トレーニング、PMP)の後に初期化するために専門の微調整方法を使用しています。彼らは、これが微調整よりもサンプル効率が高いと結論付けましたが、報酬モデリングのバリエーションの中で明確な最良の選択肢はありません。…

StackLLaMA:RLHFを使用してLLaMAをトレーニングするための実践ガイド

ChatGPT、GPT-4、Claudeなどのモデルは、Reinforcement Learning from Human Feedback(RLHF)と呼ばれる手法を使用して、予想される振る舞いにより適合するように微調整された強力な言語モデルです。 このブログ記事では、LlaMaモデルをStack Exchangeの質問に回答するためにRLHFを使用してトレーニングするために関与するすべてのステップを以下の組み合わせで示します: 教師あり微調整(SFT) 報酬/選好モデリング(RM) 人間のフィードバックからの強化学習(RLHF) From InstructGPT paper: Ouyang, Long, et al. “Training language models to follow instructions with human…

Google AIは、MediaPipe Diffusionプラグインを導入しましたこれにより、デバイス上で制御可能なテキストから画像生成が可能になります

最近、拡散モデルはテキストから画像を生成する際に非常に成功を収め、画像の品質、推論のパフォーマンス、および創造的な可能性の範囲の大幅な向上をもたらしています。しかし、効果的な生成管理は、特に言葉で定義しにくい条件下では依然として課題となっています。 Googleの研究者によって開発されたMediaPipe拡散プラグインにより、ユーザーの制御下でデバイス内でのテキストから画像の生成が可能になります。本研究では、デバイスそのもの上で大規模な生成モデルのGPU推論に関する以前の研究を拡張し、既存の拡散モデルおよびそのLow-Rank Adaptation(LoRA)のバリエーションに統合できるプログラマブルなテキストから画像の生成の低コストなソリューションを提供します。 拡散モデルでは、イテレーションごとに画像の生成が行われます。拡散モデルの各イテレーションは、ノイズが混入した画像から目標の画像までを生成することで始まります。テキストのプロンプトを通じた言語理解は、画像生成プロセスを大幅に向上させています。テキストの埋め込みは、テキストから画像の生成のためのモデルにリンクされ、クロスアテンション層を介して結びつけられます。ただし、物体の位置や姿勢などの詳細は、テキストのプロンプトを使用して伝えるのがより困難な例です。研究者は、条件画像からの制御情報を拡散に追加することで、拡散を利用して制御を導入します。 Plug-and-Play、ControlNet、およびT2Iアダプターの方法は、制御されたテキストから画像を生成するためによく使用されます。Plug-and-Playは、入力画像から状態をエンコードするために、拡散モデル(Stable Diffusion 1.5用の860Mパラメータ)のコピーと、広く使用されているノイズ除去拡散暗黙モデル(DDIM)逆推定手法を使用します。これにより、入力画像から初期ノイズ入力を導出します。コピーされた拡散からは、自己注意の空間特徴が抽出され、Plug-and-Playを使用してテキストから画像への拡散に注入されます。ControlNetは、拡散モデルのエンコーダーの訓練可能な複製を構築し、ゼロで初期化されたパラメータを持つ畳み込み層を介して接続し、条件情報をエンコードし、それをデコーダーレイヤーに渡します。残念ながら、これによりサイズが大幅に増加し、Stable Diffusion 1.5では約450Mパラメータとなり、拡散モデル自体の半分となります。T2I Adapterは、より小さなネットワーク(77Mパラメータ)であるにもかかわらず、制御された生成で同等の結果を提供します。条件画像のみがT2I Adapterに入力され、その結果がすべての後続の拡散サイクルで使用されます。ただし、このスタイルのアダプターはモバイルデバイス向けではありません。 MediaPipe拡散プラグインは、効果的かつ柔軟性があり、拡張性のある条件付き生成を実現するために開発されたスタンドアロンネットワークです。 訓練済みのベースラインモデルに簡単に接続できる、プラグインのようなものです。 オリジナルモデルからの重みを使用しないゼロベースのトレーニングです。 モバイルデバイス上でほとんど追加費用なしにベースモデルとは独立して実行可能なため、ポータブルです。 プラグインはそのネットワーク自体であり、その結果はテキストから画像への変換モデルに統合されます。拡散モデル(青)に対応するダウンサンプリング層は、プラグインから取得した特徴を受け取ります。 テキストから画像の生成のためのモバイルデバイス上でのポータブルなオンデバイスパラダイムであるMediaPipe拡散プラグインは、無料でダウンロードできます。条件付きの画像を取り込み、多スケールの特徴抽出を使用して、拡散モデルのエンコーダーに適切なスケールで特徴を追加します。テキストから画像への拡散モデルと組み合わせると、プラグインモデルは画像生成に条件信号を追加します。プラグインネットワークは、相対的にシンプルなモデルであるため、パラメータはわずか6Mとなっています。モバイルデバイスでの高速推論を実現するために、MobileNetv2は深度方向の畳み込みと逆ボトルネックを使用しています。 基本的な特徴 自己サービス機械学習のための理解しやすい抽象化。低コードAPIまたはノーコードスタジオを使用してアプリケーションを修正、テスト、プロトタイプ化、リリースするために使用します。 Googleの機械学習(ML)ノウハウを使用して開発された、一般的な問題に対する革新的なMLアプローチ。 ハードウェアアクセラレーションを含む完全な最適化でありながら、バッテリー駆動のスマートフォン上でスムーズに実行するために十分に小さく効率的です。

ドメイン固有アプリケーションのためのLLM細かい調整戦略

「LLMファインチューニングとは何か、LLMをドメイン特化アプリケーションに適応する方法、ファインチューニングの種類などを理解する」

「LLM革命:言語モデルの変革」

イントロダクション 言語モデルの世界は、特に大規模言語モデル(LLM)の登場により、過去数年間で劇的な進化を遂げました。これらのモデルは、数十億のパラメータと自然言語の深い理解を備えており、人工知能の分野を変革するのに重要な役割を果たしてきました。今日は、この革命を探求し、クローズドソースからオープンソースのLLMへの移行、ファインチューニングの重要性、そして最近登場した効率的なファインチューニング技術の開発に焦点を当てます。 学習目標: クローズドソースとオープンソースのLLMの違いを知る。 LLMの伝統的なファインチューニングとパラメータ効率のファインチューニングを理解する。 異なるパラメータ効率のファインチューニング戦略を探索する。 効率的なファインチューニングのためのLudwigの使用方法を学ぶ。 クローズドソース vs オープンソースのLLM:適切なアプローチの選択 言語モデルの景色は、OpenAIなどの企業が提供するクローズドソースのモデルと、Meta、Googleなどの機関が提供するオープンソースのバリアントとの2分することがありました。ChatGPT、GPT 3.5、GPT 4などのクローズドソースのLLMは、管理されたインフラストラクチャと迅速なプルーフオブコンセプトの能力により、魅力的な出発点を提供します。これらのモデルは、高品質の事前学習データセットを提供し、インフラストラクチャのセットアップは不要であり、LLMの能力を探求する人々にとって簡単な入り口となります。 しかし、アクセス性にもかかわらず、クローズドソースのLLMには根本的な制約があります。これらはモデルの所有権を欠き、最小限のカスタマイズ能力しか提供せず、特にデータプライバシーやモデルの制御が重要なセクターでは、長期的な投資には適していません。これに対し、オープンソースのLLMは有望な代替手段です。完全なモデルの所有権とカスタマイズが可能であり、オープンソースの領域での革新的な開発への即時アクセスを容易にします。そのトレードオフは、これらのモデルを自己ホスティングするための費用と課題です。 伝統的なファインチューニング vs パラメータ効率のファインチューニング ファインチューニングは、特にドメイン固有のタスクを考慮する際に、LLMの潜在能力を最大限に引き出すための重要なプロセスとして浮かび上がります。クローズドソースのモデルは、ファインチューニングに必要な柔軟性を欠いている一方、オープンソースのモデルはこのプロセスに完全な制御を提供します。ファインチューニングにより、事前学習済みのLLMを特定のタスクに適応させるためにモデルの重みを更新し、パフォーマンスを向上させることができます。これは一般的なモデルを専門的なアプリケーションに合わせてパーソナライズする手段であり、ユニークなタスクのためにパフォーマンスを最適化することを可能にします。 ファインチューニングとRetrieval Augmented Generation(RAG)などのモデルの間の議論は、特定のタスクに合わせたモデルの必要性と一般的な目的を持つ知能の間の関係に焦点を当てています。LLMのオープンソースの性質は、カスタマイズと効率的なファインチューニングを可能にし、優れたタスク固有のパフォーマンスを実現するために必要です。 伝統的なファインチューニングには、すべてのモデルのパラメータを更新するというリソースを多く消費し、時間がかかり、必ずしも最適なタスク固有のパフォーマンスをもたらすわけではありませんというプロセスの制約があります。しかし、パラメータ効率のファインチューニングにおける最近のイノベーションは、この制約を打破しました。事前学習済みのLLMを凍結し、非常に小さなセットのタスク固有のレイヤーのみをトレーニングすることにより、効率的なファインチューニングはリソースに優しく、より効果的な方法で行われます。 パラメータ効率のファインチューニングへの移行は、LLMを特定のタスクに適応させる方法に大きな影響を与えています。タスク固有のレイヤーの最小限のセットのみに焦点を当てることにより、プロセスは費用効果が高く、時間効率が良くなります。この革新的なアプローチにより、データセットが小さくても最適なタスク固有のパフォーマンスが実現され、クローズドソースのモデルに比べてオープンソースのLLMの潜在能力が示されます。 MetaによるLIMA論文などの研究は、GPT…

24GBのコンシューマーGPUでRLHFを使用して20B LLMを微調整する

私たちは、trlとpeftの統合を正式にリリースし、Reinforcement Learningを用いたLarge Language Model (LLM)のファインチューニングを誰でも簡単に利用できるようにしました!この投稿では、既存のファインチューニング手法と競合する代替手法である理由を説明します。 peftは一般的なツールであり、多くのMLユースケースに適用できますが、特にメモリを多く必要とするRLHFにとって興味深いです! コードに直接深く入りたい場合は、TRLのドキュメンテーションページで直接例のスクリプトをチェックしてください。 イントロダクション LLMとRLHF 言語モデルとRLHF(Reinforcement Learning with Human Feedback)を組み合わせることは、ChatGPTなどの非常に強力なAIシステムを構築するための次の手段として注目されています。 RLHFを用いた言語モデルのトレーニングは、通常以下の3つのステップを含みます: 1- 特定のドメインまたは命令のコーパスで事前学習されたLLMをファインチューニングする 2- 人間によって注釈付けされたデータセットを収集し、報酬モデルをトレーニングする 3- ステップ1で得られたLLMを報酬モデルとデータセットを用いてRL(例:PPO)でさらにファインチューニングする ここで、ベースとなるLLMの選択は非常に重要です。現時点では、多くのタスクに直接使用できる「最も優れた」オープンソースのLLMは、命令にファインチューニングされたLLMです。有名なモデルとしては、BLOOMZ、Flan-T5、Flan-UL2、OPT-IMLなどがあります。これらのモデルの欠点は、そのサイズです。まともなモデルを得るには、少なくとも10B+スケールのモデルを使用する必要がありますが、モデルを単一のGPUデバイスに合わせるだけでも40GBのGPUメモリが必要です。 TRLとは何ですか? trlライブラリは、カスタムデータセットとトレーニングセットアップを使用して、誰でも簡単に自分のLMをRLでファインチューニングできるようにすることを目指しています。他の多くのアプリケーションの中で、このアルゴリズムを使用して、ポジティブな映画のレビューを生成するモデルをファインチューニングしたり、制御された生成を行ったり、モデルをより毒性のないものにしたりすることができます。…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.