Learn more about Search Results リーダーボード - Page 4

- You may be interested

- 「Amazon SageMakerを使用して、クラシカ...

- GPT-4のプロンプト効果の比較:Dash、Pane...

- アプリケーションの近代化における生成AI...

- 「BeLFusionに出会ってください:潜在的拡...

- 「13/11から19/11までの週のトップ重要なL...

- 「AIによるPaytmによるインド経済の保護:...

- ICAと現実のカクテルパーティの問題

- 「中国の科学者が驚異的な新記録を樹立し...

- 「素晴らしいAIアプリケーションのクイッ...

- スマートフォンにおける通話セキュリティ...

- 「AIイノベーションのためのニューロエボ...

- Amazon SageMaker Jumpstartを使用して、...

- ライトオンAIは、Falcon-40Bをベースにし...

- 「大規模な言語モデルの探索-パート3」

- スタビリティAIの危機 – CEOの論争...

「LLM評価のガイド:設定と重要な指標」

大規模な言語モデル(LLM)は、開発者やビジネスリーダーにとって、消費者への新たな価値創造において非常に優れたツールです彼らは個別の推奨事項をし、非構造化データ間の翻訳を行います...

このAI研究では、SMPLer-Xという名前のモデルを提案していますこれは一般的な基礎モデルであり、モノクル入力から3D/4D人体のモーションキャプチャを行います

アニメーション、ゲーム、ファッションの分野は、単眼写真や動画からの表現的な人体の姿勢と形状推定(EHPS)の画期的な分野から恩恵を受けることがあります。複雑な人体解剖学、顔、手を正確に表現するために、この作業では通常、パラメトリックな人体モデル(SMPL-Xなど)が使用されます。最近の数年間では、ユニークなデータセットが流入し、環境のキャプチャ、位置分布、体の可視性、カメラの視点などの研究の機会が増えました。しかし、最先端のアプローチはまだこれらのデータセットの一部に制約があり、さまざまなシナリオでパフォーマンスのボトルネックとなり、未開拓の地域への一般化を妨げています。 EHPSの信頼性のある、国際的に適用可能なモデルを構築するために、この研究では利用可能なデータセットを徹底的に分析することを目標としています。これを行うために、彼らは32のデータセットを使用したEHPSの最初のシステムベンチマークを作成し、そのパフォーマンスを4つの主要基準に対して評価しました。これにより、ベンチマーク間の重要な不整合が明らかになり、全体的なEHPSの複雑さが強調され、シナリオ間のドメインギャップを解消するためにデータのスケーリングが必要であることが示されました。この詳細な分析は、EHPSのための既存のデータセットの使用を再評価する必要性を示し、より優れた汎化能力を提供するより攻撃的な代替手段への切り替えを主張しています。 彼らの研究は、補完的な性質を持つ複数のデータセットを利用する価値を強調しています。また、これらのデータセットの転送性に影響を与える関連する側面を徹底的に調査しています。彼らの研究は将来のデータセット収集に役立つアドバイスを提供します。1) 100,000以上のインスタンスを含む場合、データセットは特に大規模である必要はありません。2) イン・ザ・ワイルド(屋外を含む)の収集が不可能な場合、さまざまな屋内風景が優れた代替手段となります。3) シンセティックデータセットは、検出可能なドメインギャップを持ちながら、驚くほど効果的になっています。4) SMPL-Xのアノテーションがない場合、擬似SMPL-Xラベルは役立ちます。 ベンチマークからの情報を使用して、Nanyang Technological University、SenseTime Research、Shanghai AI Laboratory、東京大学、国際デジタル経済アカデミー(IDEA)の研究者たちはSMPLer-Xを作成しました。この汎用基盤モデルはさまざまなデータセットを使用してトレーニングされ、様々な状況でバランスの取れた結果を提供します。この研究は大量の選択されたデータの力を示しています。彼らは、EHPSのための非常に基本的なアーキテクチャを持つSMPLer-Xを開発しました。厳密なアルゴリズムの要素の分析ではなく、SMPLer-Xは大規模なデータとパラメータのスケーリングを許容し、将来のフィールド研究の基盤となるよう設計されています。 さまざまなデータの組み合わせやモデルサイズでの実験により、従来のデータセットトレーニングの広く行われている方法に挑戦し、すべてのベンチマーク結果を上回る包括的なモデルを構築しました。彼らの基盤モデルにより、5つの主要なベンチマーク(AGORA、UBody、EgoBody、3DPW、EHF)での平均主要エラーが110ミリメートルを超えて70ミリメートル以下に減少しました。また、RenBodyやARCTICなどの新しいシナリオにも成功して印象的な汎化能力を示しています。さらに、彼らは基盤モデルの最適化の効果を示し、ドメイン固有のエキスパートとして機能して、広範なベンチマークで優れたパフォーマンスを実現しています。 EgoBody、UBody、EHFにおいて最新技術の性能を発揮するために同じデータ選択方法を採用しており、AGORAリーダーボードでも107.2ミリメートルのNMVE(11.0%の改善)を達成し、新たな記録を打ち立てました。彼らは3つの異なる貢献を提供しています。1) EHPSの幅広いデータセットを使用して、信頼性のある、移植可能なEHPSに向けたトレーニングデータのスケーリングに重要な方向性を提供する、最初のシステマティックなベンチマークを構築します。2) データとモデルのスケーリングの両方を調査し、バランスの取れた結果を提供し、未開拓のデータセットに効果的に拡張する汎用基盤モデルを構築します。3) 基盤モデルを改良して、データ選択手法を拡張し、さまざまなベンチマークで強力な専門家となります。

リアルワールドの問題にKaggleのコンテストは役立つのか?

現実の世界に備えるために、Kaggleのコンペに参加する価値はあるでしょうか?

「ジンディのCEO兼共同創設者、セリーナ・リー― インタビューシリーズ」

「Celina Leeは、ZindiのCEO兼共同創設者であり、アフリカのデータサイエンティスト向けの最大の専門ネットワークです Celinaは、データの力を社会的な善のために解き放つことに情熱を持っています Celinaは、データと開発の交差点での思考リーダーシップにおける実績があり、立ち上げにおいて中心的な役割を果たしてきました...」

LMSYS-Chat-1Mとは、25の最新のLLM(Large Language Models)を使用して作成された、100万件の実世界の会話を含む大規模データセットです

大規模言語モデル(LLM)は、仮想アシスタントからコード生成まで、さまざまなAIアプリケーションに不可欠な存在となっています。ユーザーは、異なる目的に応じて特定のクエリや質問形式を使用してLLMと関わる際に、その行動を適応させます。これらのパターンを研究することで、さまざまなLLMへのユーザーの期待や信頼についての洞察を得ることができます。さらに、単純な事実から複雑な文脈を持つクエリまでの質問の範囲を理解することで、LLMのサービス向上、誤用の防止、AIの安全性の向上に役立つでしょう。以下のように言えます: 大規模言語モデルサービスの運営コストが高いため、多くの組織にとって実際のユーザーの質問データを収集することは財務的に難しいです。 実際のユーザーの質問データを持っている企業は、競争上の優位性を明らかにする懸念やデータプライバシーの維持を望むため、それらを共有することにためらっています。 オープンな言語モデルとのユーザーの対話を促すことは難しい課題です。なぜなら、これらのモデルは主要企業が開発したモデルほどの性能を発揮しないからです。 オープンなモデルとのユーザーの関与の困難さから、調査目的のためにこれらのモデルとの実際のユーザーの対話を正確に反映した大規模データセットを編成することは困難です。 このギャップに対応するために、本研究では「LMSYS-Chat-1M」という革新的な大規模な実世界データセットを紹介しています。このデータセットは、大規模言語モデル(LLM)とユーザー間の実際の対話の広範なコレクションから慎重に収集されました。これらの対話は、オープンソースと独自のモデルの両方を含む25の人気のあるLLMへのアクセスを提供する無料のオンラインLLMサービスをホスティングすることで、5か月間にわたって収集されました。このサービスには、数千時間にわたるA100の計算リソースが必要でした。 ユーザーの関与を維持するために、著者らは「チャットボットアリーナ」と呼ばれる競争的な要素を実装し、人気のLLMのランキングとリーダーボードを定期的に更新することでユーザーにサービスの利用を促しました。その結果、LMSYS-Chat-1Mには100万以上のユーザー対話が含まれており、さまざまな言語とトピックをカバーしています。ユーザーは、データ収集ウェブサイトの「利用規約」セクションを通じて、このデータセットに対する使用の承諾を提供しました。 このデータセットは、VicunaのデモとChatbot Arenaのウェブサイトから2023年4月から8月までに収集されました。このウェブサイトは、ユーザーに3つのチャットインターフェースオプションを提供しています:単一モデルチャット、チャットボット同士が戦うチャットボットアリーナ、および2つのチャットボットを横に並べて比較できるチャットボットアリーナ。このプラットフォームは完全に無料であり、ユーザーには補償も料金も課されません。 この論文では、LMSYS-Chat-1Mを4つの異なるユースケースでの潜在的な応用を探求しています。LMSYS-Chat-1Mは、GPT-4と同等のパフォーマンスを発揮する強力なコンテンツモデレータとして小規模な言語モデルを効果的に微調整できることを示しています。さらに、一部の提供されたモデルにセーフティメカニズムがあるにもかかわらず、LMSYS-Chat-1Mには主要な言語モデルのセーフガードを挑戦できる対話が含まれており、モデルの堅牢性と安全性の研究のための新たなベンチマークとなります。 さらに、このデータセットには、指示微調整に適したユーザーと言語モデルの質の高い対話も含まれています。これらの対話の一部を使用することで、Llama-2モデルは特定のベンチマークにおいてVicunaやLlama2 Chatと同等のパフォーマンスレベルを達成できることを著者らは示しています。最後に、LMSYS-Chat-1Mの幅広いトピックとタスクのカバレッジは、言語モデルのための新しいベンチマーク質問の生成において貴重なリソースとなります。

このAIニュースレターは、あなたが必要とするすべてです #66

AIの今週のトピックスでは、OpenAIが再び注目を浴びましたChatGPTに新たな音声と画像の機能を追加する計画が発表されたからですまた、LLMレースも熱を帯び続けており、Amazon...

AIのオリンピック:機械学習システムのベンチマーク

何年もの間、4分以内で1マイルを走ることは、単なる困難な課題ではなく、多くの人にとっては不可能な偉業と考えられていましたそれは心理的、身体的な目標であり、多くの人がそうだと思っていました...

「自分の武器を選ぶ:うつ病AIコンサルタントの生存戦略」

最新のターミネーターの映画が最近公開されましたこの新しいエピソードでは、未来の人間の抵抗組織がロボットを過去に送り、OpenAIのサーバーファームを破壊し、それによって…の出現を防ぎます

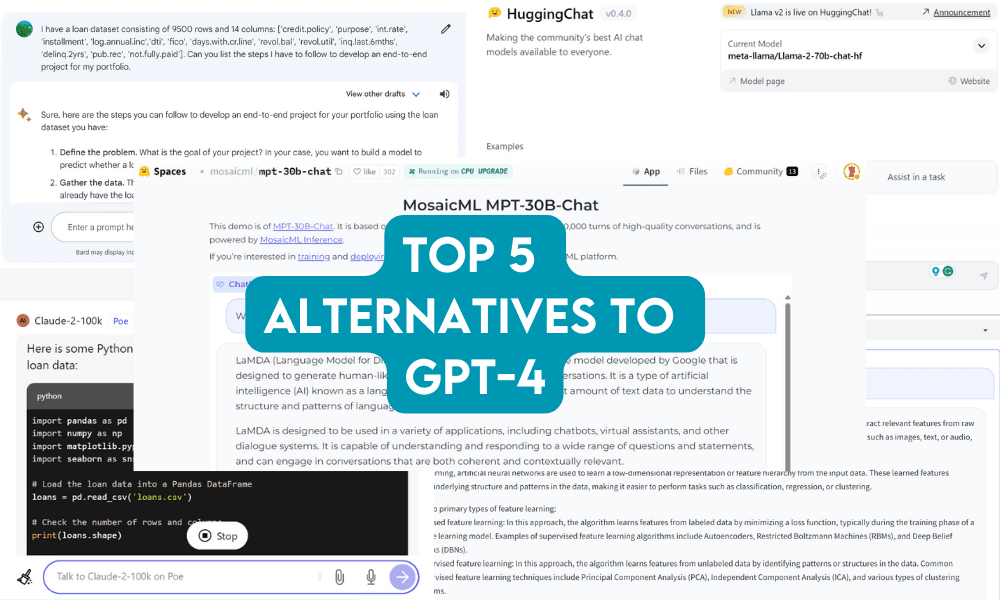

「GPT-4に対する無料の代替案トップ5」

GPT-4がすごいと思っている?これらの生成AIの新参者たちは既に注目を集めているよ!

「チャットモデル対決:GPT-4 vs. GPT-3.5 vs. LLaMA-2によるシミュレートされた討論会-パート1」

最近、MetaがGPT-4と競合するチャットモデルを開発する計画を発表し、AnthropicがClaude2を発売したことにより、どのモデルが最も優れているかについての議論がますます激化しています...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.