Learn more about Search Results インテル - Page 4

- You may be interested

- このNVIDIAのAI論文は、検索補完と長い文...

- 「エヴァ・マリー・ミュラー=シュトゥー...

- LEGOのコンテストからDeepMindのロボット...

- OpenAIはAIチップ製造リーグへの参加を検...

- AIは自己を食べるのか?このAI論文では、...

- チャットGPTからPiへ、そしてなぜそうする...

- 大規模言語モデルとは何ですか?

- キルギスタンからキングスクロスまで:コ...

- 「50以上の新しい最先端の人工知能(AI)...

- 「制限されたデータで言語モデルをトレー...

- 「IIT卒業生のAIによるカバーレターが皆を...

- 「監督のギレルモ・デル・トロとティム・...

- 「このAI研究は微生物学者が細菌を識別す...

- 「Google LLMは、ドキュメントを読むだけ...

- コンピュータビジョンシステムは、画像認...

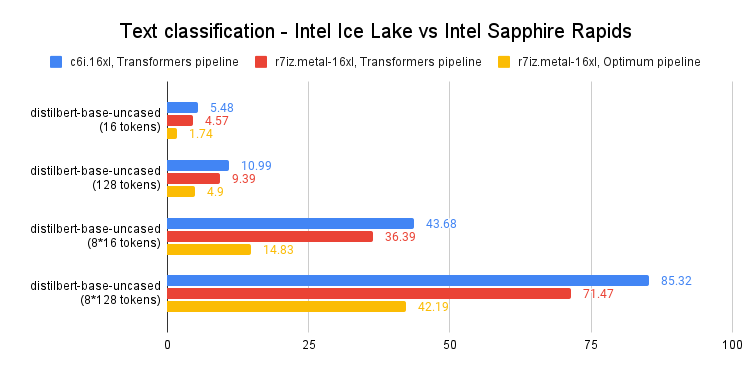

Intel Sapphire Rapidsを使用してPyTorch Transformersを高速化する – パート2

最近の投稿では、第4世代のIntel Xeon CPU(コードネーム:Sapphire Rapids)とその新しいAdvanced Matrix Extensions(AMX)命令セットについて紹介しました。Amazon EC2上で動作するSapphire Rapidsサーバーのクラスタと、Intel Extension for PyTorchなどのIntelライブラリを組み合わせることで、スケールでの効率的な分散トレーニングを実現し、前世代のXeon(Ice Lake)に比べて8倍の高速化とほぼ線形スケーリングを達成する方法を紹介しました。 この投稿では、推論に焦点を当てます。PyTorchで実装された人気のあるHuggingFaceトランスフォーマーと共に、Ice Lakeサーバーでの短いおよび長いNLPトークンシーケンスのパフォーマンスを測定します。そして、Sapphire RapidsサーバーとHugging Face Optimum Intelの最新バージョンを使用して同じことを行います。Hugging Face Optimum Intelは、Intelプラットフォームのハードウェアアクセラレーションに特化したオープンソースのライブラリです。 さあ、始めましょう! CPUベースの推論を検討すべき理由 CPUまたはGPUで深層学習の推論を実行するかどうかを決定する際には、いくつかの要素を考慮する必要があります。最も重要な要素は、モデルのサイズです。一般に、より大きなモデルはGPUによって提供される追加の計算能力からより多くの利益を得ることができますが、より小さいモデルはCPU上で効率的に実行することができます。…

5つの最高のDeepfake検出ツールと技術(2023年7月)

デジタル時代において、ディープフェイクはオンラインコンテンツの真正性にとって重大な脅威として浮上していますこれらの洗練されたAI生成のビデオは、本物の人物を信じられるように模倣し、事実とフィクションを区別することがますます困難になっていますしかし、ディープフェイクの背後にある技術が進化するにつれて、それらを検出するために設計されたツールや技術も進化してきました

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.