Learn more about Search Results による - Page 464

- You may be interested

- 「SuperDuperDBを活用して簡単にシンプル...

- ディープラーニングシステムは、外部から...

- 「Seerの最高データオフィサーであるDr. S...

- 「Google DeepMindが、7100万件の「ミスセ...

- 私はスポティファイで3回の大量解雇を乗り...

- 「GPUを使用してAmazon SageMakerのマルチ...

- 線形代数の鳥瞰図:基礎

- Amazon SageMakerの自動モデルチューニン...

- 「AIを使用して気候変動と戦う」

- 「Amazon Comprehendのカスタム分類を使用...

- Google AIがMedLMを導入:医療業界の利用...

- H1Bビザはデータ分析の洞察に基づいて承認...

- ジニ係数の解説:経済学が機械学習に影響...

- AIを利用して、科学者たちは、抗薬剤耐性...

- セキュリティ企業は、労働力不足のなかで...

ビジュアルキャプション:大規模言語モデルを使用して、動的なビジュアルを備えたビデオ会議を補完する

Google Augmented Realityのリサーチサイエンティスト、Ruofei DuとシニアスタッフリサーチサイエンティストのAlex Olwalが投稿しました。 ライブキャプションやノイズキャンセリングなどの機能により、ビデオ会議の最近の進歩により、リモートビデオ通信は大幅に改善されました。しかし、複雑で微妙な情報をより良く伝えるために、動的な視覚的拡張が役立つ場面があります。たとえば、日本食レストランで何を注文するか話し合う場合、友達があなたが「すき焼き」を注文することに自信を持つのに役立つビジュアルを共有することができます。また、最近の家族旅行について話しているときに、個人的なアルバムから写真を見せたい場合があります。 ACM CHI 2023 で発表された「Visual Captions: Augmenting Verbal Communication With On-the-fly Visuals」では、私たちは、口頭の手がかりを使用してリアルタイムのビジュアルを使って同期ビデオ通信を拡張するシステムを紹介します。私たちは、この目的のためにキュレーションしたデータセットを使用して、オープンボキャブラリーの会話で関連するビジュアルを積極的に提案するために、大規模な言語モデルを微調整しました。私たちは、実時間の転写とともに拡張されたコミュニケーションの急速なプロトタイピングに設計されたARChatプロジェクトの一部としてVisual Captionsをオープンソース化しました。 Visual Captionsは、リアルタイムのビジュアルで口頭コミュニケーションを容易にします。このシステムは、リアルタイムの音声からテキストへの転写でよく見られる誤りにも対応しています。たとえば、文脈から外れて、転写モデルは「pier」という単語を「pair」と誤解しましたが、Visual Captionsはそれでもサンタモニカのピアの画像を推奨します。 動的なビジュアルで口頭コミュニケーションを拡張するための設計空間 私たちは、ソフトウェアエンジニア、研究者、UXデザイナー、ビジュアルアーティスト、学生など、様々な技術的および非技術的なバックグラウンドを持つ10人の内部参加者を招待し、潜在的なリアルタイムビジュアル拡張サービスの特定のニーズと欲求を議論しました。2つのセッションで、私たちは想定されるシステムの低保守性のプロトタイプを紹介し、その後、既存のテキストから画像へのシステムのビデオデモを示しました。これらの議論により、以下のようにD1からD8とラベル付けされた8つの次元の設計空間が生まれました。 ビジュアル拡張は、会話と同期または非同期に行われる場合があります(D1:時間)、話題の表現と理解の両方に使用できる場合があります(D2:主題)、さまざまなビジュアルコンテンツ、ビジュアルタイプ、ビジュアルソースを使用して適用できる場合があります(D3:ビジュアル)。このような視覚的拡張は、ミーティングの規模(D4:スケール)や、共同設置またはリモート設定でミーティングが行われているかどうか(D5:スペース)によって異なる場合があります。これらの要因はまた、ビジュアルが個人的に表示されるべきか、参加者間で共有されるべきか、あるいはすべての人に公開されるべきかを決定するのにも影響します(D6:プライバシー)。参加者はまた、会話をしながらシステムとやり取りするさまざまな方法を特定しました(D7:起動)。たとえば、人々は「プロアクティブ」の異なるレベルを提案しました。これは、ユーザーがモデルがイニシアチブを取る程度を示します。最後に、参加者は、入力に音声やジェスチャーを使用するなど、異なる相互作用方法を想定しました(D8:相互作用)。…

多言語での音声合成の評価には、SQuIdを使用する

Googleの研究科学者Thibault Sellamです。 以前、私たちは1000言語イニシアチブとUniversal Speech Modelを紹介しました。これらのプロジェクトは、世界中の何十億人ものユーザーに音声および言語技術を提供することを目的としています。この取り組みの一部は、多様な言語を話すユーザー向けにVDTTSやAudioLMなどのプロジェクトをベースにした高品質の音声合成技術を開発することにあります。 新しいモデルを開発した後は、生成された音声が正確で自然であるかどうかを評価する必要があります。コンテンツはタスクに関連し、発音は正確で、トーンは適切で、クラックや信号相関ノイズなどの音響アーティファクトはない必要があります。このような評価は、多言語音声システムの開発において大きなボトルネックとなります。 音声合成モデルの品質を評価する最も一般的な方法は、人間の評価です。テキストから音声(TTS)エンジニアが最新のモデルから数千の発話を生成し、数日後に結果を受け取ります。この評価フェーズには、聴取テストが含まれることが一般的で、何十もの注釈者が一つずつ発話を聴取して、自然な音に聞こえるかどうかを判断します。人間はテキストが自然かどうかを検出することでまだ敵わないことがありますが、このプロセスは実用的ではない場合があります。特に研究プロジェクトの早い段階では、エンジニアがアプローチをテストして再戦略化するために迅速なフィードバックが必要な場合があります。人間の評価は費用がかかり、時間がかかり、対象言語の評価者の可用性によって制限される場合があります。 進展を妨げる別の障壁は、異なるプロジェクトや機関が通常、異なる評価、プラットフォーム、およびプロトコルを使用するため、apple-to-applesの比較が不可能であることです。この点で、音声合成技術はテキスト生成に遅れを取っており、研究者らが人間の評価をBLEUや最近ではBLEURTなどの自動評価指標と補完して長年にわたって利用してきたテキスト生成から大きく遅れています。 「SQuId: Measuring Speech Naturalness in Many Languages」でICASSP 2023に発表する予定です。SQuId(Speech Quality Identification)という600Mパラメーターの回帰モデルを紹介します。このモデルは、音声がどの程度自然かを示します。SQuIdは、Googleによって開発された事前学習された音声テキストモデルであるmSLAMをベースにしており、42言語で100万件以上の品質評価をファインチューニングし、65言語でテストされました。SQuIdが多言語の評価において人間の評価を補完するためにどのように使用できるかを示します。これは、今までに行われた最大の公開努力です。 SQuIdによるTTSの評価 SQuIdの主な仮説は、以前に収集された評価に基づいて回帰モデルをトレーニングすることで、TTSモデルの品質を評価するための低コストな方法を提供できるということです。このモデルは、TTS研究者の評価ツールボックスに貴重な追加となり、人間の評価に比べて正確性は劣るものの、ほぼ即時に提供されます。 SQuIdは、発話を入力とし、オプションのロケールタグ(つまり、”Brazilian Portuguese”や”British English”などのローカライズされた言語のバリアント)を指定することができます。SQuIdは、音声波形がどの程度自然に聞こえるかを示す1から5までのスコアを返します。スコアが高いほど、より自然な波形を示します。 内部的には、モデルには3つのコンポーネントが含まれています:(1)エンコーダー、(2)プーリング/回帰層、および(3)完全接続層。最初に、エンコーダーはスペクトログラムを入力として受け取り、1,024サイズの3,200ベクトルを含む小さな2D行列に埋め込みます。各ベクトルは、時間ステップをエンコードします。プーリング/回帰層は、ベクトルを集約し、ロケールタグを追加し、スコアを返す完全接続層に入力します。最後に、アプリケーション固有の事後処理を適用して、スコアを再スケーリングまたは正規化して、自然な評価の範囲である[1、5]の範囲内に収まるようにします。回帰損失で全モデルをエンドツーエンドでトレーニングします。…

人間の注意力を予測するモデルを通じて、心地よいユーザーエクスペリエンスを実現する

Google Researchのシニアリサーチサイエンティスト、Junfeng He氏とスタッフリサーチサイエンティスト、Kai Kohlhoff氏による記事です。 人間は、驚くほど多くの情報を取り入れる能力を持っています(網膜に入る情報は秒間約10 10ビット)。そして、タスクに関連し、興味深い領域に選択的に注目し、さらに処理する能力を持っています(例:記憶、理解、行動)。人間の注意(その結果として得られるものはしばしば注目モデルと呼ばれます)をモデル化することは、神経科学、心理学、人間コンピュータインタラクション(HCI)、コンピュータビジョンの分野で興味を持たれてきました。どの領域でも、どの領域でも、注目が集まる可能性が高い領域を予測する能力には、グラフィックス、写真、画像圧縮および処理、視覚品質の測定など、多数の重要な応用があります。 以前、機械学習とスマートフォンベースの注視推定を使用して、以前は1台あたり3万ドルにも及ぶ専門的なハードウェアが必要だった視線移動の研究を加速する可能性について説明しました。関連する研究には、「Look to Speak」というアクセシビリティニーズ(ALSのある人など)を持つユーザーが目でコミュニケーションするのを支援するものと、「Differentially private heatmaps」という、ユーザーのプライバシーを保護しながら注目のようなヒートマップを計算する技術が最近発表されました。 このブログでは、私たちはCVPR 2022からの1つの論文と、CVPR 2023での採用が決定したもう1つの論文、「Deep Saliency Prior for Reducing Visual Distraction」と「Learning from Unique Perspectives: User-aware…

NeRFを使用して室内空間を再構築する

Marcos Seefelder、ソフトウェアエンジニア、およびDaniel Duckworth、リサーチソフトウェアエンジニア、Google Research 場所を選ぶ際、私たちは次のような疑問を持ちます。このレストランは、デートにふさわしい雰囲気を持っているのでしょうか?屋外にいい席はありますか?試合を見るのに十分なスクリーンがありますか?これらの質問に部分的に答えるために、写真やビデオを使用することがありますが、実際に訪れることができない場合でもそこにいるような感覚には代わりがありません。 インタラクティブでフォトリアルな多次元の没入型体験は、このギャップを埋め、スペースの感触や雰囲気を再現し、ユーザーが必要な情報を自然かつ直感的に見つけることができるようにすることができます。これを支援するために、Google MapsはImmersion Viewを開発しました。この技術は、機械学習(ML)とコンピュータビジョンの進歩を活用して、Street Viewや航空写真など数十億の画像を融合して世界の豊富なデジタルモデルを作成します。さらに、天気、交通、場所の混雑度などの役立つ情報を上に重ねます。Immersive Viewでは、レストラン、カフェ、その他の会場の屋内ビューが提供され、ユーザーが自信を持ってどこに行くかを決めるのに役立ちます。 今日は、Immersion Viewでこれらの屋内ビューを提供するために行われた作業について説明します。私たちは、写真を融合してニューラルネットワーク内で現実的な多次元の再構成を生成するための最先端の手法であるニューラル輝度場(NeRF)に基づいています。私たちは、DSLRカメラを使用してスペースのカスタム写真キャプチャ、画像処理、およびシーン再現を含むNeRFの作成パイプラインについて説明します。私たちは、Alphabetの最近の進歩を活用して、視覚的な忠実度で以前の最先端を上回るか、それに匹敵する方法を設計しました。これらのモデルは、キュレーションされたフライトパスに沿って組み込まれたインタラクティブな360°ビデオとして埋め込まれ、スマートフォンで利用可能になります。 アムステルダムのThe Seafood Barの再構築(Immersive View内)。 写真からNeRFへ 私たちの作業の中核にあるのは、最近開発された3D再構成および新しいビュー合成の方法であるNeRFです。シーンを説明する写真のコレクションがある場合、NeRFはこれらの写真をニューラルフィールドに凝縮し、元のコレクションに存在しない視点から写真をレンダリングするために使用できます。 NeRFは再構成の課題を大部分解決したものの、実世界のデータに基づくユーザー向け製品にはさまざまな課題があります。たとえば、照明の暗いバーから歩道のカフェ、ホテルのレストランまで、再構成品質とユーザー体験は一貫している必要があります。同時に、プライバシーは尊重され、個人を特定する可能性のある情報は削除される必要があります。重要なのは、シーンを一貫してかつ効率的にキャプチャし、必要な写真を撮影するための労力を最小限に抑えたまま、高品質の再構成が確実に得られることです。最後に、すべてのモバイルユーザーが同じ自然な体験を手に入れられるようにすることが重要です。 Immersive View屋内再構築パイプライン。 キャプチャ&前処理 高品質なNeRFを生成するための最初のステップは、シーンを注意深くキャプチャすることです。3Dジオメトリーとカラーを派生させるための複数の異なる方向からの密な写真のコレクションを作成する必要があります。オブジェクトの表面に関する情報が多いほど、モデルはオブジェクトの形状やライトとの相互作用の方法を発見する際により優れたものになります。 さらに、NeRFモデルはカメラやシーンそのものにさらなる仮定を置きます。たとえば、カメラのほとんどのプロパティ(ホワイトバランスや絞りなど)は、キャプチャ全体で固定されていると仮定されます。同様に、シーン自体は時間的に凍結されていると仮定されます。ライティングの変更や動きは避ける必要があります。これは、キャプチャに必要な時間、利用可能な照明、機器の重さ、およびプライバシーなどの実用上の問題とのバランスを取る必要があります。プロの写真家と協力して、DSLRカメラを使用して会場写真を迅速かつ信頼性の高い方法でキャプチャする戦略を開発しました。このアプローチは、現在までのすべてのNeRF再構築に使用されています。…

デジタルルネッサンス:NVIDIAのNeuralangelo研究が3Dシーンを再構築

NVIDIA Researchによる新しいAIモデル、Neuralangeloは、ニューラルネットワークを使用して3D再構築を行い、2Dビデオクリップを詳細な3D構造に変換し、建物、彫刻、およびその他の現実世界のオブジェクトのリアルなバーチャルレプリカを生成します。 ミケランジェロが大理石のブロックから驚くべきリアルなビジョンを彫刻したように、Neuralangeloは複雑なディテールと質感を持つ3D構造を生成します。クリエイティブなプロフェッショナルは、これらの3Dオブジェクトをデザインアプリケーションにインポートし、アート、ビデオゲーム開発、ロボット工学、および産業用デジタルツインに使用するためにさらに編集することができます。 Neuralangeloは、屋根の瓦、ガラスの板、滑らかな大理石などの複雑な素材の質感を、従来の手法を大幅に上回る精度で2Dビデオから3Dアセットに変換することができます。この高い信頼性により、開発者やクリエイティブなプロフェッショナルは、スマートフォンでキャプチャされた映像を使用してプロジェクトに使用できる仮想オブジェクトを迅速に作成できます。 「Neuralangeloが提供する3D再構築機能は、クリエイターにとって大きな利益になります。現実世界をデジタル世界に再現するのを支援することで、開発者は小さな像や巨大な建築物などの詳細なオブジェクトを仮想環境にインポートできるようになります。」と、研究のシニアディレクターであり、論文の共著者でもあるMing-Yu Liu氏は述べています。 デモでは、NVIDIAの研究者が、ミケランジェロのダビデ像やフラットベッドトラックなどといったアイコニックなオブジェクトを再現する方法を紹介しました。Neuralangeloは、建物の内部および外部も再構築することができ、NVIDIAのベイエリアキャンパスの公園の詳細な3Dモデルで実証されました。 ニューラルレンダリングモデルが3Dで見る 3Dシーンを再構築するための以前のAIモデルは、繰り返しのテクスチャパターン、同質的な色、および強い色の変化を正確に捉えることができませんでした。Neuralangeloは、これらの微細なディテールを捉えるために、NVIDIA Instant NeRFの背後にある技術であるインスタントニューラルグラフィックスプリミティブを採用しています。 さまざまな角度から撮影されたオブジェクトまたはシーンの2Dビデオを使用して、モデルは異なる視点を捉えたいくつかのフレームを選択します。これは、アーティストが対象を多角的に考慮して深度、サイズ、および形状を把握するのと同じです。 フレームごとのカメラ位置が決定されたら、NeuralangeloのAIはシーンの大まかな3D表現を作成します。これは、彫刻家が主題の形を彫刻し始めるのと同じです。 次に、モデルはレンダリングを最適化してディテールをシャープにします。これは、彫刻家が石を注意深く削って布の質感や人物の形を再現するのと同じです。 最終的な結果は、仮想リアリティアプリケーション、デジタルツイン、またはロボット工学の開発に使用できる3Dオブジェクトまたは大規模なシーンです。 CVRPでNVIDIA Researchを見つける、6月18日〜22日 Neuralangeloは、6月18日から22日にバンクーバーで開催されるコンピュータビジョンとパターン認識のカンファレンス(CVRP)で発表されるNVIDIA Researchの約30のプロジェクトの1つです。これらの論文は、ポーズ推定、3D再構築、およびビデオ生成などのトピックをカバーしています。 これらのプロジェクトの1つであるDiffCollageは、長いランドスケープ方向、360度パノラマ、およびループモーション画像を含む大規模なコンテンツを作成する拡散法です。標準的なアスペクト比の画像のトレーニングデータセットをフィードすると、DiffCollageはこれらの小さな画像をコラージュのピースのように扱い、より大きなビジュアルのセクションとして扱います。これにより、拡散モデルは、同じスケールの画像のトレーニングを必要とせずに、継ぎ目のない大規模なコンテンツを生成できるようになります。 この技術は、テキストプロンプトをビデオシーケンスに変換することもできます。これは、人間の動きを捉える事前訓練された拡散モデルを使用して実証されました。 NVIDIA Researchについてもっと学ぶ。

魚の養殖スタートアップ、AIを投入して水産養殖をより効率的かつ持続可能にする

海洋生物学の学生だったJosef Melchnerは、イルカ、クジラ、魚を探すために毎日海をクルーズすることを常に夢見ていましたが、「実際的で、世界に利益をもたらすことができるものがしたかった」と述べています。キャリアを選ぶ時、彼は水産養殖に飛び込みました。 彼は現在、AIと機械学習を利用して魚の養殖をより効率的で持続可能なものにするイスラエルのGoSmartのCEOです。 NVIDIA MetropolisビジョンAIパートナーエコシステムと、最先端のスタートアップ向けのNVIDIA InceptionプログラムのメンバーであるGoSmartは、完全に自律的で省エネのシステムを提供しています。これらは、水産養殖のカゴ、池、またはタンクに取り付けることができる、ソーダボトル程度の大きさです。 エッジAIのためのNVIDIA Jetsonプラットフォームによって動力を供給され、これらのシステムは、環境内の魚の平均体重と人口分布、および温度と酸素レベルを分析します。 この情報は、GoSmartのソフトウェア・サービスを通じてユーザーに提供され、リアルタイムで魚の餌の量と収穫の最適なタイミングをより正確かつ効率的に決定するのに役立ちます。 「GoSmartシステムが分析するパラメータは、魚の餌の量の管理に不可欠です。適切な魚の餌の量の管理により、農家は多額のお金を節約し、水中の余分なデブリから有機物を減らすことができます。」とMelchner氏は述べています。 GoSmartシステムは、世界最大の魚の餌生産業者であるSkrettingによって採用され、南ヨーロッパの8か国で生産パイプラインを持続可能に拡大し、農家にパーソナライズされたデジタル化された情報を提供する取り組みの一環として使用されています。 持続可能なための精密農業 2020年に設立されたGoSmartは、環境保護に焦点を当てているため、魚の養殖に焦点を当てています。 「世界はタンパク質不足に直面していますが、海産タンパク質はしばしば漁船が漁網や長い針で獲得する方法で取得されます。一方、牛、豚、鶏などの代替タンパク質はほぼ常に養殖されますが、海産物の半分はまだ野生から取得されています。」とMelchner氏は述べています。 このような過剰漁獲は惑星に悪影響を及ぼします。 「これは私たち全員に影響を与える可能性のある重要な問題です。藻類は世界で最も大きな炭素の貯蔵庫の一つです。大気から炭素を消費し、酸素を放出しますが、過剰な漁獲は海洋の藻類のレベルに影響を与えます。」とMelchner氏は述べています。 これを理解することがMelchner氏を水産養殖に人生をささげるように導いたと彼は言います。 GoSmartシステムは、太陽光パネルで充電されたリチウムイオンバッテリーを使用し、自己の電源管理ソフトウェアが搭載されているため、自律的にスリープモードに入り、シャットダウン、起動し、必要に応じて作業を行うことができます。 AIによる農業の効率向上 GoSmartシステムは、AIをエッジで実行するために必要なセンサ、カメラ、およびNVIDIA Jetsonモジュールで構築されています。これにより、魚の餌や成長、健康、福祉に影響を与える環境要因、および効率的または正確でない操作による水中の過剰な有機物の環境汚染を分析することができます。 「私たちは、エッジAIで最高のパフォーマンスを発揮するAI用の最高のプロセッサを、水産養殖業者に手頃な価格で提供できるシステムであるコンパクトで水中に潜水可能なシステムに使用することを望んでいました。それがJetsonシリーズを選んだ理由です。」とMelchner氏は述べています。 GoSmartは現在、魚の行動や病気の指標を分析するシステムをトレーニングしています。Jetsonは複数のAIアルゴリズムを並列に実行できるため、これらの特性を同時にリアルタイムで分析できます。 同社は、高性能なディープラーニング推論には、NVIDIA…

NYUとNVIDIAが協力して、患者の再入院を予測するための大規模言語モデルを開発する

退院は患者にとって重要なマイルストーンですが、時には回復への道のりの終わりではありません。米国では、初回退院後30日以内に約15%の入院患者が再入院することがあり、患者と病院の両方にとってより悪い結果や高いコストが伴うことがしばしばあります。 ニューヨーク大学の学術医療センターであるNYUランゴーンヘルスの研究者は、NVIDIAの専門家と協力して、患者の30日間の再入院リスクや他の臨床的な結果を予測する大規模言語モデル(LLM)を開発しました。 NYUランゴーンヘルスの6つの入院施設に展開されたNYUTronモデルは、今日発表された科学誌ネイチャーに掲載され、AIによる洞察力を提供することで、再入院の可能性を低減する臨床介入が必要な患者を特定する医師を支援します。 「患者を退院させる際には、再入院が必要になることは予想されません。また、もしそうだった場合は、病院に長く入院させる必要があるかもしれません」と、NYUグロスマン医学部の放射線科と脳神経外科の助教授であり、NYUTronの主要な協力者の一人であるエリック・オーマン博士は述べています。「AIモデルの分析を使用することで、私たちはクリニシャンに再入院のリスクを予測し、防止または解決するための手段を提供できるようになるでしょう。」 このモデルはNYUの医療システムで50,000人以上の患者に適用され、再入院リスクの予測結果が医師に電子メール通知で共有されています。オーマン氏のチームは、NYUTronの分析に基づく介入が再入院率を減らすかどうかを検証する臨床試験を計画しています。 急速な再入院の脅威に立ち向かう 米国政府は、30日間の再入院率を医療の質の指標として追跡しています。再入院率が高い医療機関には罰金が科され、これにより病院が退院プロセスを改善するように刺激されます。 最近退院した患者が再び入院する必要がある理由はたくさんあります。例えば、感染症、抗生物質の過剰処方、早すぎる手術ドレーンの除去などがあります。これらのリスク要因が早期に発見されれば、医師は治療計画を調整したり、患者を長期入院させたりすることで介入することができます。 「患者の再入院を予測する計算モデルは、1980年代から存在していますが、これを自然言語処理のタスクとして、臨床テキストの健康システム規模のコーパスが必要となるものとして扱っています」と、オーマン博士は述べています。「私たちは、電子健康記録の非構造化データを使用してLLMをトレーニングし、人々が以前に考慮していなかった洞察力を捕捉できるかどうかを確認しました。」 NYUTronは、NYUランゴーンヘルスの10年間の健康記録、約4十億語の臨床ノート、約40万人の患者を表す大量のデータによって事前トレーニングされました。このモデルは、再入院を予測するための最先端の機械学習モデルよりも10%以上の精度改善を達成しました。 LLMが初期の使用ケースで30日間の再入院を予測するためにトレーニングされた後、チームは1週間ほどで他の4つの予測アルゴリズムを展開することができました。これには、患者の入院期間の長さを予測すること、入院中の死亡リスク、患者の保険請求が拒否される可能性などが含まれます。 「病院を運営することは、ある意味ではホテルを管理することに似ています」と、オーマン博士は述べています。「病院がより効率的に運営できるようにする洞察力は、より多くの患者により多くのベッドとより良いケアを提供することを意味します。」 トレーニングから展開までのLLM NYUTronは、数億のパラメータを持つLLMで、NVIDIA NeMo Megatronフレームワークを使用して、NVIDIA A100 Tensor Core GPUの大規模クラスターでトレーニングされました。 「言語モデルに関する話題の多くは、数百または数千のGPUを使用して、汚いデータセットでトレーニングされた数十億のパラメータを持つ巨大で汎用的なモデルについてです」と、オーマン博士は述べています。「私たちは、高度に洗練されたデータでトレーニングされた中程度のサイズのモデルを使用して、医療特化のタスクを達成しています。」 現実の医療現場で推論を最適化するために、チームはNVIDIA Tritonオープンソースソフトウェアの変更バージョンを開発し、NVIDIA TensorRTソフトウェア開発キットを使用してAIモデルの展開を簡素化しました。…

AIを学校に持ち込む:MITのアナント・アガルワルとの対話

NVIDIAのAI Podcastの最新エピソードで、edXの創設者であり2Uの最高プラットフォーム責任者であるAnant Agarwal氏は、オンライン教育の未来と、AIが学習体験を革新している方法について語りました。 大規模オープンオンラインコース(MOOC)の強力な提唱者であるAgarwal氏は、教育のアクセシビリティと品質の重要性について話しました。このMITの教授であり、著名なedtechの先駆者でもある彼は、edXプラットフォームでのChatGPTプラグインや、AIによる学習アシスタントであるedX Xpertの実装を強調しました。 関連記事 Jules Anh Tuan Nguyen氏が説明する、AIが切断された手の義手やビデオゲームを操作する方法 ミネソタ大学のポストドクトラル研究者が、義手を手の指の動きまで自分の意思で制御できるようにする取り組みについて説明しています。 OverjetのAi Wardah Inam氏が歯科医療にAIを導入することについて語る NVIDIA InceptionのメンバーであるOverjetは、AIを歯科医療に導入することを急いでいます。同社のCEOであるWardah Inam博士は、AIを利用して患者ケアを改善することについて説明しています。 ImmunaiのCTO兼共同創設者であるLuis Voloch氏が、深層学習を用いた新しい薬剤の開発について語る Immunaiの共同創設者兼最高技術責任者であるLuis Voloch氏は、機械学習とデータサイエンスのマインドセットで免疫システムの課題に取り組むことについて話しています。 AI Podcastを購読する:Amazon Musicで利用可能…

AIを活用した空中監視:UCSBイニシアチブがNVIDIA RTXを使い、宇宙の脅威を撃退する目的で立ち上がる

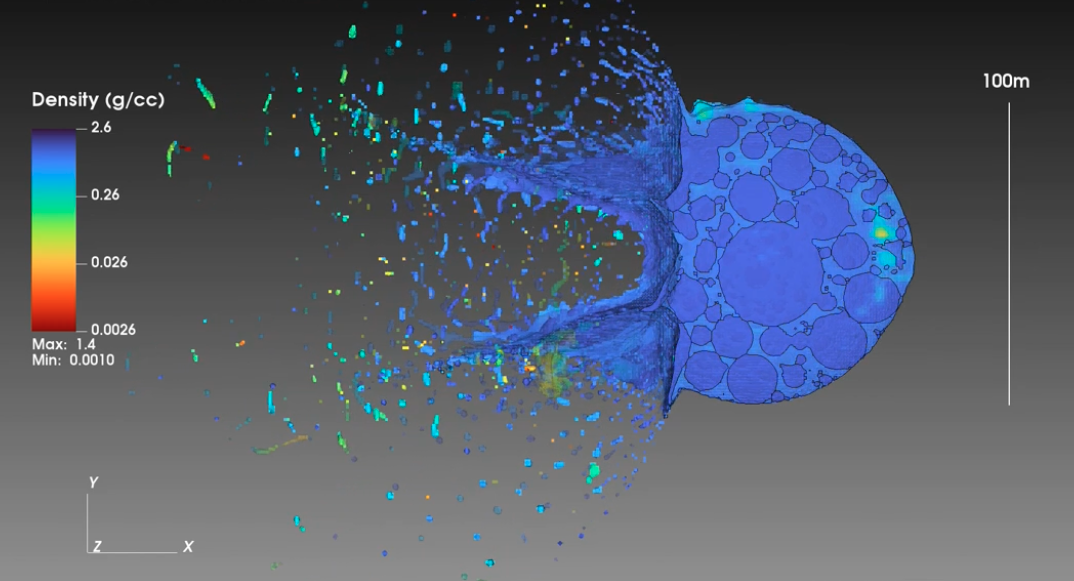

数か月ごとに流星群が起こると、観察者は夜空に散らばる流れ星や光の筋が輝く見事な光景を見ることができます。 通常、流星は地球の大気圏に入った瞬間に速やかに燃え尽きる宇宙からの小さな岩や塵の塊です。しかし、彗星や小惑星がやや大きく、地球の表面に直接向かっていて、警告時間がほとんどない場合には、物語は暗い方向に向かうことになります。 このようなシナリオを、カリフォルニア大学サンタバーバラ校の物理学教授フィリップ・ルビン氏と彼の大学院生たちは防御策を講じるために取り組んでいます。 チームは最近、NASAから第II相資金を受け取り、より迅速かつ効率的に脅威を検出および緩和することができる新しい、より実用的な惑星防御のアプローチを探ることになっています。彼らのイニシアチブはPI-Terminal Planetary Defenseと呼ばれ、PIは「Pulverize It」の略です。 彼らが開発している脅威を検出するためのAIおよび機械学習アルゴリズムをトレーニングし、スピードアップするために、NVIDIAはApplied Research Accelerator Programの一環として、グループにNVIDIA RTX A6000グラフィックスカードを提供しました。 AIをスカイに持っていく 毎日、約100トンの小さなデブリが地球に降り注ぎますが、大気中で速やかに崩壊し、サバイバルするものはほとんどありません。しかし、月の表面に見られるクレーターの責任を持つような大きな小惑星は、地球上の生命にとって実際の脅威となります。 平均して、直径65フィート以上の小惑星が60年ごとに現れ、2013年にロシアのチェリャビンスク上空で爆発したものに相当する約440,000トンのTNTに相当するエネルギーを持つものがあります。 PI-Terminal Planetary Defenseイニシアチブは、関連する脅威をより早く検出し、それから超高速度のキネティックペネトレーターの配列を使用して小惑星または小さな彗星を粉砕し分解し、脅威を大幅に最小限に抑えることを目的としています。 従来の惑星防御のアプローチは脅威をそらすことでしたが、Pulverize-Itは、小惑星または彗星をより小さな破片に効果的に破砕し、高高度で地球の大気圏で燃え尽きさせ、地上のダメージを最小限に抑えることを目的としています。これにより、より迅速な緩和が可能になります。 脅威を認識することは、最初の重要なステップです。ルビン氏と彼の学生たちは、AIのパワーを活用しました。 多くの現代の調査は、大量の天体物理学データを収集しますが、データの収集速度は収集された画像を処理および分析する能力よりも速いです。ルビン氏のグループは、特に惑星防御のためにより大きな調査を設計し、迅速に処理する必要があるより多くのデータを生成することにしています。 グループは、You Only…

Rendered.aiは、合成データの生成にNVIDIA Omniverseを統合します

Rendered.aiは、プラットフォームとして提供される合成データ生成(SDG)により、開発者、データサイエンティスト、その他の人々のAIトレーニングを簡素化しています。 コンピュータビジョンAIモデルのトレーニングには、膨大で高品質で多様で偏りのないデータセットが必要です。これらを入手することは困難でコストがかかるため、AIの需要と供給の双方が増大する中で特に課題になります。 Rendered.aiのプラットフォームは、3Dシミュレーションから作成された物理的に正確な合成データを生成することにより、コンピュータビジョンモデルのトレーニングに役立ちます。 「実世界のデータは、AIモデルを一般化するために必要なすべてのシナリオとエッジケースをキャプチャできないことがあり、それがAIおよび機械学習エンジニアにとってキーとなるSDGの場所です」と、シアトルの郊外であるベルビューに拠点を置くRendered.aiの創設者兼CEOであるNathan Kundtzは述べています。 NVIDIA Inceptionプログラムの一員であるRendered.aiは、オンライントレーニング、ロボティクス、自律走行などの多くのアプリケーションにラベル付き合成データを生成することができるOmniverse Replicatorをプラットフォームに統合しました。 Omniverse Replicatorは、Universal Scene Description(「OpenUSD」)、Material Definition Language(MDL)、およびPhysXを含む3Dワークフローのオープンスタンダードに基づいて構築され、仮想世界の風景と植生のモデリング、衛星画像のオブジェクト検出、さらには人間の卵細胞の生存可能性のテストに使用されています。 Omniverse Replicatorを使用して生成された合成画像。Rendered.ai提供。 Rendered.aiは、Omniverse ReplicatorのRTXアクセラレーション機能を活用することで、レイトレーシング、ドメインランダム化、マルチセンサーシミュレーションなどの機能を利用することができます。コンピュータビジョンエンジニア、データサイエンティスト、およびその他のユーザーは、クラウド上の簡単なウェブインターフェイスを介して合成データを迅速かつ簡単に生成することができます。 「AIをトレーニングするために持つ必要があるデータは、実際にAIのパフォーマンスを支配する要因です」とKundtzは述べています。「Omniverse ReplicatorをRendered.aiに統合することで、さまざまな産業分野でより大きく、より優れたAIモデルをトレーニングするために合成データを利用するユーザーにとって、新しいレベルの簡単さと効率が実現されます。」 Rendered.aiは、カナダのバンクーバーで6月18日から22日まで開催されるコンピュータビジョンとパターン認識のカンファレンス(CVPR)で、Omniverse Replicatorとのプラットフォーム統合をデモンストレーションします。 クラウドでの合成データ生成 AWS…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.