Learn more about Search Results リポジトリ - Page 40

- You may be interested

- このAI論文は『プライバシー保護MAE-Align...

- Sentence Transformersモデルのトレーニン...

- 「Colabノートブックで自分のLlama 2モデ...

- MITによる新しい機械学習の研究は、大規模...

- 「データ分析のためのトップ10のSQLプロジ...

- 「AIを活用したポッドキャストの始め方と...

- 「テック企業は、ワークアウトを通じて女...

- MLCommonsは、臨床効果を提供するためのAI...

- RPDiffと出会ってください:3Dシーン内の6...

- 「プリンストンの研究者たちは、CoALA(コ...

- 「AI安全性の議論がシリコンバレーを引き...

- テキストから類義語(似た言葉)を抽出す...

- 研究者たちは、医薬品の製造において画期...

- 「物理学と流体力学に応用されたディープ...

- 「2024年のトップ5大学の証明書」

クローズドソース対オープンソース画像注釈

このブログでは、オープンソースとクローズドソースの画像注釈ツールを比較し、それがAIモデル開発者の生活を簡単かつ便利にする方法について述べています

Amazon SageMakerドメインをVPCのみモードでサポートし、SageMaker Studioでの自動シャットダウンライフサイクル設定とTerraformでのSageMaker Canvasをサポートします

Amazon SageMakerのドメインは、SageMakerの機械学習(ML)環境をサポートしており、SageMaker StudioやSageMaker Canvasを含んでいますSageMaker Studioは、完全に統合された開発環境(IDE)であり、すべてのML開発ステップを実行するための特別なツールにアクセスできる単一のWebベースの視覚インターフェースを提供しますデータの準備からMLモデルの構築、トレーニング、展開まで、すべてのステップを行うことができます

「Cassandra To-Doリスト ChatGPTプラグインの構築」

「Cassandraのステップバイステップガイド:ChatGPTプラグインを実装して、自分のやるべきことリストを管理するための仮想パーソナルアシスタントとして機能させる方法」

「私たちはデータサイエンスシステムを仮想化すべきでしょうか – それともしないべきでしょうか?」

「ビッグデータ」を活用することが、あらゆる産業における問題解決にますます重要になるにつれて、ホームラボやデータレイクのようなデータリポジトリは、より並列化された計算能力を必要とします

ファイル共有を簡単にする

最近、データ共有の問題が再び発生し、私は共有フォルダと一緒に作業するための方法を設計する良いタイミングだと思いました私は独立したGIScienceの専門家として働いており、頻繁に...

🤗 Transformersにおけるネイティブサポートされた量子化スキームの概要

私たちは、トランスフォーマーでサポートされている各量子化スキームの利点と欠点を明確に示し、どれを選ぶべきかを判断するのに役立つ概要を提供することを目指しています。 現在、モデルの量子化は主に2つの目的で使用されています: 大きなモデルの推論をより小さなデバイスで実行すること 量子化モデルの上にアダプタを微調整すること 現時点で、2つの統合の取り組みが行われ、トランスフォーマーでネイティブにサポートされています:bitsandbytesとauto-gptqです。なお、🤗オプティマムライブラリでは他の量子化スキームもサポートされていますが、このブログ投稿では対象外です。 サポートされている各スキームの詳細については、以下で共有されているリソースのいずれかをご覧ください。また、ドキュメントの適切なセクションもご確認ください。 また、以下で共有されている詳細は、PyTorchモデルにのみ有効であり、TensorflowおよびFlax/JAXモデルについては現在のところ対象外です。 目次 リソース bitsandbyesとauto-gptqの利点と欠点 速度ベンチマークの詳細 結論と最終的な言葉 謝辞 リソース GPTQブログ投稿 – GPTQ量子化方法と使用方法について概説しています。 bitsandbytes 4ビット量子化ブログ投稿 – このブログ投稿では4ビット量子化と効率的なファインチューニング手法であるQLoRaについて紹介しています。 bitsandbytes 8ビット量子化ブログ投稿 –…

TIIのFalcon 180B基本モデルは、Amazon SageMaker JumpStartを通じて利用可能です

今日は、テクノロジーイノベーション研究所(TII)が開発したFalcon 180B基礎モデルが、お客様がAmazon SageMaker JumpStartを通じて利用できることをお知らせいたしますこのモデルは、推論実行のためのワンクリック展開が可能ですFalcon 180Bは、1800億パラメータのサイズであり、3.5兆トークンの巨大なデータセットでトレーニングされていますFalcon 180Bは、公開された重みを持つ最大かつ最もパフォーマンスの高いモデルの一つですSageMaker JumpStartを使用して、このモデルをお試しいただけますSageMaker JumpStartは、アルゴリズム、モデル、および機械学習(ML)ソリューションへのアクセスを提供するMLハブであり、迅速にMLを始めることができますこの記事では、SageMaker JumpStartを介してFalcon 180Bモデルを発見して展開する方法について説明します

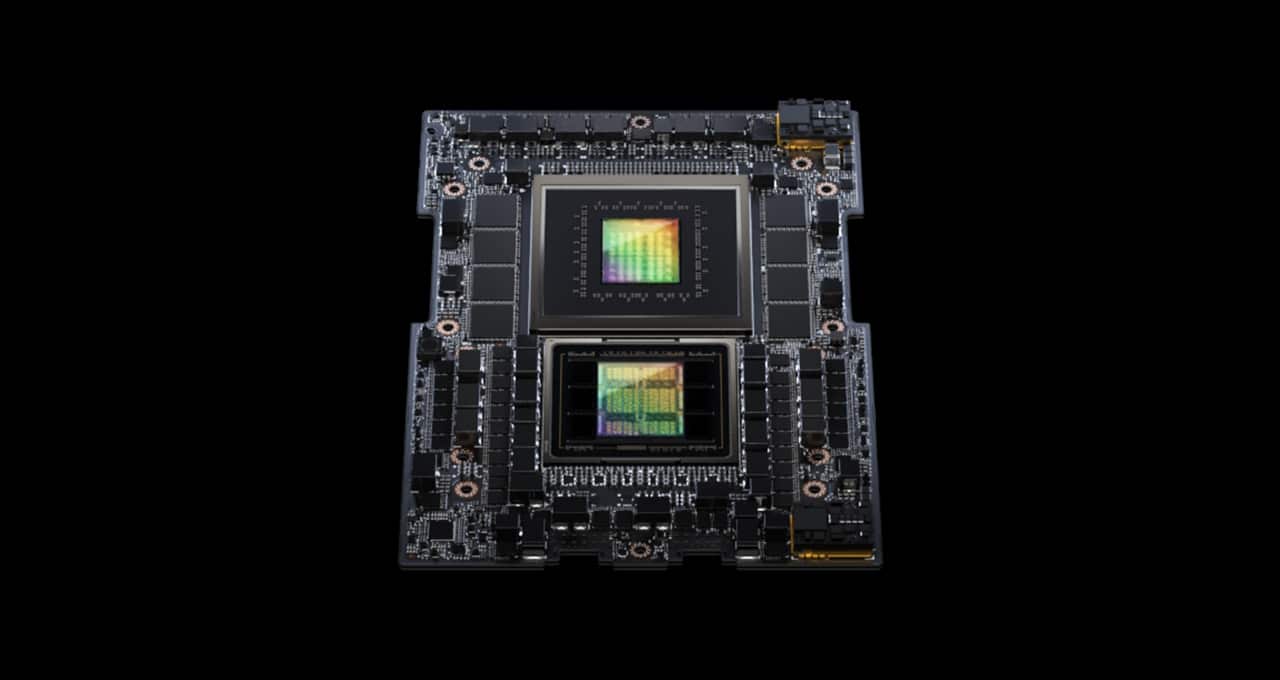

「NVIDIAのグレース・ホッパー・スーパーチップがMLPerfの推論ベンチマークを席巻する」

MLPerf業界ベンチマークに初登場したNVIDIA GH200 Grace Hopperスーパーチップは、すべてのデータセンターインファレンステストを実行し、NVIDIA H100 Tensor Core GPUのリーディングパフォーマンスを拡張しました。 全体的な結果は、NVIDIA AIプラットフォームの卓越したパフォーマンスと多機能性を示しており、クラウドからネットワークのエッジまでの幅広い領域で活躍しています。 別途、NVIDIAは性能、エネルギー効率、総所有コストの向上をユーザーにもたらすインファレンスソフトウェアを発表しました。 GH200スーパーチップがMLPerfで輝く GH200は、Hopper GPUとGrace CPUを1つのスーパーチップに結合しています。この組み合わせにより、より多くのメモリ、帯域幅、およびCPUとGPUの間で自動的に電力を切り替えてパフォーマンスを最適化する能力が提供されます。 また、8つのH100 GPUを搭載したNVIDIA HGX H100システムは、今回のMLPerfインファレンステストのすべての項目で最も高いスループットを実現しました。 Grace HopperスーパーチップとH100 GPUは、コンピュータビジョン、音声認識、医療画像などのMLPerfのデータセンターテスト全般でリードし、推薦システムや生成AIにおける大規模言語モデル(LLM)など、より要求の厳しいユースケースでも優れたパフォーマンスを発揮しました。 全体的に、これらの結果は、2018年のMLPerfベンチマークの開始以来、NVIDIAがAIトレーニングとインファレンスのパフォーマンスリーダーシップを証明し続ける記録を続けています。 最新のMLPerfラウンドでは、推薦システムのテストが更新され、AIモデルのサイズの大まかな指標である6兆パラメータを持つGPT-Jの最初のインファレンスベンチマークが実施されました。…

大規模言語モデル(LLM)の微調整

この投稿では、事前学習されたLLMをファインチューニング(FT)する方法について説明しますまず、FTの重要な概念を紹介し、具体的な例を示して終わります

MetaGPT 現在利用可能な最高のAIエージェントの完全ガイド

「なぜMetaGPTがAutoGPTやBabyAgiなどの他のAIエージェントよりも複雑なコーディングタスクで優れているのかを発見してください詳細な記事でセットアッププロセスを案内し、具体的な例を提供します1行のプロンプトでGPTを搭載したマイクロアプリを構築してください」

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.