Learn more about Search Results bitsandbytes - Page 3

- You may be interested

- 化学エンティティ認識の自動化:ChemNERモ...

- 🤗 Hubでのスーパーチャージド検索

- 「LLMは強化学習を上回る- SPRINGと出会う...

- 「Nvidia Triton Inference Serverを使用...

- 元GoogleのCEOがAIとメタバースを使って米...

- スタンフォード大学の研究者が、大規模言...

- 「Azureプロジェクト管理のナビゲーション...

- GPUを活用した特徴量エンジニアリングにお...

- 「アマゾン対Google対マイクロソフト:AI...

- Google Researchが、凍結された大規模言語...

- 「大規模言語モデルを改善するための簡単...

- 「データストラテジストになりますか?」

- 「ジョンズホプキンスのこの論文は、時間...

- 「Matplotlib チュートリアル:あなたの国...

- MITの新しいAI研究は、深層ニューラルネッ...

「LLMファインチューニングにおけるPEFTテクニック」

イントロダクション 言語モデルまたはLLM(Language models)は、自然言語処理の世界を席巻しています。これらは人間に似たテキストを生成し、自然言語入力に対して理解し応答するために設計された強力なAIシステムです。基本的に、彼らは人間の言語理解と生成を模倣することを目指しています。LLMの微調整の複雑さを理解し、この分野を変革している革新的なPEFT(Prompt Engineering and Fine Tuning)技術を探索する旅に出かけましょう。 学習目標: 言語モデルの微調整の概念を理解する。 PEFT技術とその意義を理解する。 効率的な係数の選択のための技術を探索する。 PEFT技術の理解 まず、頭字語「PEFT」の解読を試みましょう。PEFTはパラメータ効率的な微調整を表します。しかし、この文脈ではパラメータの効率性は何を意味し、なぜ重要なのでしょうか? 機械学習では、モデルは基本的には数多くの係数または重みを持つ複雑な数学方程式です。これらの係数はモデルの振る舞いを制御し、データから学習することが可能にします。機械学習モデルを訓練する際には、これらの係数を調整してエラーを最小化し正確な予測を行います。LLMの場合は、数十億のパラメータを持つ可能性がありますので、すべての係数を訓練中に変更するのは計算コストが高くメモリを消費することになります。 ここで微調整が登場します。微調整とは、事前に訓練されたモデルを特定のタスクに適応させるプロセスです。モデルは既に言語の基本的な理解力を持っていると仮定し、特定の領域での優れた性能を発揮するように調整することに焦点を当てます。 PEFTは、微調整のサブセットとしてパラメータの効率性を重要視しています。すべての係数を変更する代わりに、PEFTはそれらのサブセットを選択し、計算やメモリの要件を大幅に減らします。効率性が重要なFalcon 7Bのような大規模なモデルのトレーニングに特に有効なアプローチです。 トレーニング、微調整、プロンプトエンジニアリング:主な違い PEFTに深く入る前に、トレーニング、微調整、プロンプトエンジニアリングの違いを明確にしましょう。これらの用語はしばしば同義に使用されますが、LLMの文脈で特定の意味を持っています。 トレーニング:モデルがゼロから作成されるとき、トレーニングが行われます。これには、モデルのすべての係数や重みを調整してデータのパターンや関係性を学習する作業が含まれます。モデルに言語の基礎を教えるということです。 微調整:微調整では、モデルが既に言語の基本的な理解力を持っている(トレーニングによって達成されたもの)と仮定しています。特定のタスクやドメインにモデルを適応させるため、目的に合わせた調整が行われます。特定の仕事(例えば質問に答えることやテキストの生成など)において、教養のあるモデルを洗練させると考えてください。 プロンプトエンジニアリング:プロンプトエンジニアリングでは、LLMが望ましい出力を提供するための入力プロンプトや質問を作成します。求める結果を得るためにモデルとのインタラクション方法をカスタマイズすることです。 PEFTは、微調整フェーズで重要な役割を果たし、モデルの係数を選択的に変更して特定のタスクでの性能を向上させます。 係数の選択のためのLoRAとQLoRAの探索…

ラングチェーン101:パート2ab (大規模な言語)モデルについて知っておくべきすべて

(次を見逃さないように、著者をフォローしてください...」

小さなメモリに大きな言語モデルを適合させる方法:量子化

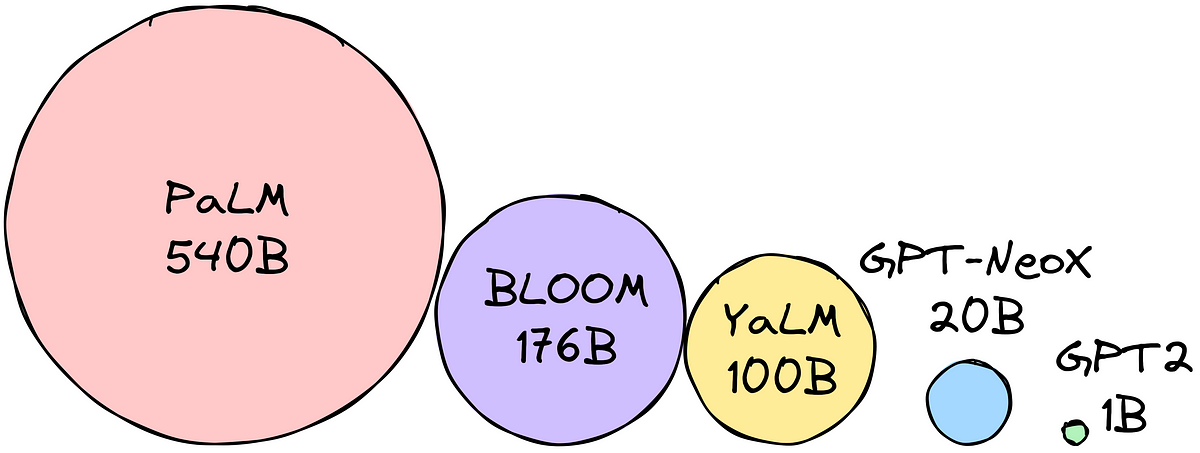

大型言語モデルは、テキスト生成、翻訳、質問応答などのタスクに使用することができますしかし、LLM(大型言語モデル)は非常に大きく、多くのメモリを必要とします…

無料でGoogle Colab上でQLoraを使用してLLAMAv2を微調整する

「Google Colabで最も影響力のあるオープンソースモデルの微調整方法を無料で学びましょう」

このAIニュースレターは、あなたが必要とするすべてです#65

今週のAIでは、AI規制に関する進展がありましたエロン・マスクやマーク・ザッカーバーグなどのテックリーダーが60人以上の上院議員とAIについて話し合いましたが、彼らは皆同意しました-

「プロダクションでのあなたのLLMの最適化」

注意: このブログ投稿は、Transformersのドキュメンテーションページとしても利用可能です。 GPT3/4、Falcon、LLamaなどの大規模言語モデル(LLM)は、人間中心のタスクに取り組む能力を急速に向上させており、現代の知識ベース産業で不可欠なツールとして確立しています。しかし、これらのモデルを実世界のタスクに展開することは依然として課題が残っています: ほぼ人間のテキスト理解と生成能力を持つために、LLMは現在数十億のパラメータから構成される必要があります(Kaplanら、Weiら参照)。これにより、推論時のメモリ要件が増大します。 多くの実世界のタスクでは、LLMには豊富な文脈情報が必要です。これにより、推論中に非常に長い入力シーケンスを処理する能力が求められます。 これらの課題の核心は、特に広範な入力シーケンスを扱う場合に、LLMの計算およびメモリ能力を拡張することにあります。 このブログ投稿では、効率的なLLMの展開のために、現時点で最も効果的な技術について説明します: 低精度: 研究により、8ビットおよび4ビットの数値精度で動作することが、モデルのパフォーマンスに大幅な低下を伴わずに計算上の利点をもたらすことが示されています。 Flash Attention: Flash Attentionは、よりメモリ効率の高いアテンションアルゴリズムのバリエーションであり、最適化されたGPUメモリの利用により、高い効率を実現します。 アーキテクチャのイノベーション: LLMは常に同じ方法で展開されるため、つまり長い入力コンテキストを持つ自己回帰的なテキスト生成として、より効率的な推論を可能にする専用のモデルアーキテクチャが提案されています。モデルアーキテクチャの中で最も重要な進歩は、Alibi、Rotary embeddings、Multi-Query Attention(MQA)、Grouped-Query-Attention(GQA)です。 このノートブックでは、テンソルの視点から自己回帰的な生成の分析を提供し、低精度の採用の利点と欠点について包括的な探索を行い、最新のアテンションアルゴリズムの詳細な調査を行い、改良されたLLMアーキテクチャについて議論します。これを行う過程で、各機能の改善を示す実用的な例を実行します。 1. 低精度の活用 LLMのメモリ要件は、LLMを重み行列とベクトルのセット、およびテキスト入力をベクトルのシーケンスとして見ることで最も理解できます。以下では、重みの定義はすべてのモデルの重み行列とベクトルを意味するために使用されます。 この投稿の執筆時点では、LLMは少なくとも数十億のパラメータから構成されています。各パラメータは通常、float32、bfloat16、またはfloat16形式で保存される10進数の数値で構成されています。これにより、LLMをメモリにロードするためのメモリ要件を簡単に計算できます: X十億のパラメータを持つモデルの重みをロードするには、おおよそ4 *…

Amazon SageMakerで@remoteデコレータを使用してFalcon 7Bやその他のLLMを微調整する

今日、生成型AIモデルはテキスト要約、Q&A、画像やビデオの生成など、さまざまなタスクをカバーしています出力の品質を向上させるために、n-短期学習、プロンプトエンジニアリング、検索補完生成(RAG)およびファインチューニングなどの手法が使用されていますファインチューニングにより、これらの生成型AIモデルを調整して、ドメイン固有の改善されたパフォーマンスを達成することができます

🤗 Transformersにおけるネイティブサポートされた量子化スキームの概要

私たちは、トランスフォーマーでサポートされている各量子化スキームの利点と欠点を明確に示し、どれを選ぶべきかを判断するのに役立つ概要を提供することを目指しています。 現在、モデルの量子化は主に2つの目的で使用されています: 大きなモデルの推論をより小さなデバイスで実行すること 量子化モデルの上にアダプタを微調整すること 現時点で、2つの統合の取り組みが行われ、トランスフォーマーでネイティブにサポートされています:bitsandbytesとauto-gptqです。なお、🤗オプティマムライブラリでは他の量子化スキームもサポートされていますが、このブログ投稿では対象外です。 サポートされている各スキームの詳細については、以下で共有されているリソースのいずれかをご覧ください。また、ドキュメントの適切なセクションもご確認ください。 また、以下で共有されている詳細は、PyTorchモデルにのみ有効であり、TensorflowおよびFlax/JAXモデルについては現在のところ対象外です。 目次 リソース bitsandbyesとauto-gptqの利点と欠点 速度ベンチマークの詳細 結論と最終的な言葉 謝辞 リソース GPTQブログ投稿 – GPTQ量子化方法と使用方法について概説しています。 bitsandbytes 4ビット量子化ブログ投稿 – このブログ投稿では4ビット量子化と効率的なファインチューニング手法であるQLoRaについて紹介しています。 bitsandbytes 8ビット量子化ブログ投稿 –…

TIIのFalcon 180B基本モデルは、Amazon SageMaker JumpStartを通じて利用可能です

今日は、テクノロジーイノベーション研究所(TII)が開発したFalcon 180B基礎モデルが、お客様がAmazon SageMaker JumpStartを通じて利用できることをお知らせいたしますこのモデルは、推論実行のためのワンクリック展開が可能ですFalcon 180Bは、1800億パラメータのサイズであり、3.5兆トークンの巨大なデータセットでトレーニングされていますFalcon 180Bは、公開された重みを持つ最大かつ最もパフォーマンスの高いモデルの一つですSageMaker JumpStartを使用して、このモデルをお試しいただけますSageMaker JumpStartは、アルゴリズム、モデル、および機械学習(ML)ソリューションへのアクセスを提供するMLハブであり、迅速にMLを始めることができますこの記事では、SageMaker JumpStartを介してFalcon 180Bモデルを発見して展開する方法について説明します

「Llama 2内のストップ生成の課題」

メタによるLlama 2の発売は、コミュニティ内で興奮を引き起こし、以前は...を通じてのみアクセス可能だった優れた大規模言語モデルの時代の幕開けを告げています

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.