Learn more about Search Results Milvus - Page 3

- You may be interested

- パンダのカット対qcutが明確に説明されて...

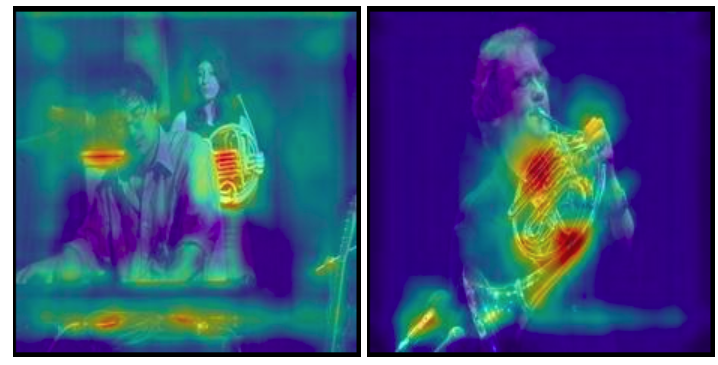

- わかりやすいYOLOv8 Eigen-CAMを使ったYOL...

- ZenMLとStreamlitを使用した従業員離職率予測

- 「銀行を破産させずにビジネスでAIを導入...

- 「OpenAI、DALL·E 3を発表:テキストから...

- Hugging Faceデータセットとトランスフォ...

- 「LMQLに出会ってください:大規模言語モ...

- 学生と教授たちは、建物のセンサーに抗議...

- チャットボットの台頭

- 「ニューロンの多様性を受け入れる:AIの...

- 「ステアリング可能なニューラルネットワ...

- 「NTUシンガポールの研究者がResShiftを導...

- このAI論文は、高品質な3Dセグメンテーシ...

- ChatGPTのドロップシッピング用プロンプト

- 「分析ストリーム処理への控えめな紹介」

「LLMにおけるリトリーバル・オーグメンテッド・ジェネレーションについての深い探求」

「リトリーバル拡張型生成(Retrieval-Augmented Generation)を探求しましょうこのフレームワークは、大規模言語モデルを外部データソースとシームレスに統合し、幻覚やその他の一般的な欠点を排除します」

「GPT-4を超えて 新機能は何ですか?」

「GPT-4を超えて:生成AIの4つの主要なトレンド:LLMからマルチモーダル、ベクトルデータベースへの接続、エージェントからOSへ、そしてファインチューニングからプラグインへそして、MetaのLlama 2とCode Llama」

テキストから音声へ – 大規模な言語モデルのトレーニング

はじめに 音楽家の声コマンドをAIが受け取り、美しいメロディックなギターサウンドに変換する世界を想像してみてください。これはSFではありません。オープンソースコミュニティでの画期的な研究「The Sound of AI」の成果です。本記事では、「テキストからサウンドへ」というジェネレーティブAIギターサウンドの範囲内で、「ミュージシャンの意図認識」のための大規模言語モデル(LLM)の作成の道のりを探求します。このビジョンを実現するために直面した課題と革新的な解決策についても議論します。 学習目標: 「テキストからサウンド」のドメインでの大規模言語モデルの作成における課題と革新的な解決策を理解する。 声コマンドに基づいてギターサウンドを生成するAIモデルの開発において直面する主な課題を探求する。 ChatGPTやQLoRAモデルなどのAIの進歩を活用した将来のアプローチについて、ジェネレーティブAIの改善に関する洞察を得る。 問題の明確化:ミュージシャンの意図認識 問題は、AIが音楽家の声コマンドに基づいてギターサウンドを生成できるようにすることでした。例えば、音楽家が「明るいギターサウンドを出してください」と言った場合、ジェネレーティブAIモデルは明るいギターサウンドを生成する意図を理解する必要があります。これには文脈とドメイン特有の理解が必要であり、一般的な言語では「明るい」という言葉には異なる意味がありますが、音楽のドメインでは特定の音色の品質を表します。 データセットの課題と解決策 大規模言語モデルのトレーニングには、モデルの入力と望ましい出力に一致するデータセットが必要です。ミュージシャンのコマンドを理解し、適切なギターサウンドで応答するために、適切なデータセットを見つける際にいくつかの問題が発生しました。以下に、これらの問題の対処方法を示します。 課題1:ギターミュージックドメインのデータセットの準備 最初の大きな課題は、ギターミュージックに特化したデータセットが容易に入手できないことでした。これを克服するために、チームは独自のデータセットを作成する必要がありました。このデータセットには、音楽家がギターサウンドについて話し合う会話が含まれる必要がありました。Redditの議論などのソースを利用しましたが、データプールを拡大する必要があると判断しました。データ拡張、BiLSTMディープラーニングモデルの使用、コンテキストベースの拡張データセットの生成などの技術を使用しました。 課題2:データの注釈付けとラベル付きデータセットの作成 2番目の課題は、データの注釈付けを行い、ラベル付きのデータセットを作成することでした。ChatGPTなどの大規模言語モデルは一般的なデータセットでトレーニングされることが多く、ドメイン固有のタスクに対してファインチューニングが必要です。例えば、「明るい」という言葉は、光や音楽の品質を指す場合があります。チームは、正しい文脈をモデルに教えるために、Doccanoという注釈付けツールを使用しました。ミュージシャンは楽器や音色の品質に関するラベルをデータに注釈付けしました。ドメインの専門知識が必要であるため、注釈付けは困難でしたが、チームはデータを自動的にラベル付けするためにアクティブラーニングの手法を一部適用し、これに対処しました。 課題3:MLタスクとしてのモデリング – NERアプローチ 適切なモデリングアプローチを決定することもまた、別のハードルでした。トピックまたはエンティティの識別として見るべきでしょうか?チームは、モデルが音楽に関連するエンティティを識別して抽出できるNamed Entity Recognition(NER)を採用しました。spaCyの自然言語処理パイプライン、HuggingFaceのRoBERTaなどのトランスフォーマーモデルを活用しました。このアプローチにより、ジェネレーティブAIは音楽のドメインにおける「明るい」や「ギター」といった単語の文脈を認識できるようになりました。 モデルトレーニングの課題と解決策…

「LangchainなしでPDFチャットボットを構築する方法」

はじめに Chatgptのリリース以来、AI領域では進歩のペースが減速する気配はありません。毎日新しいツールや技術が開発されています。ビジネスやAI領域全般にとっては素晴らしいことですが、プログラマとして、すべてを学んで何かを構築する必要があるでしょうか? 答えはノーです。この場合、より現実的なアプローチは、必要なものについて学ぶことです。ものを簡単にすると約束するツールや技術がたくさんありますが、すべての場合にそれらが必要というわけではありません。単純なユースケースに対して大規模なフレームワークを使用すると、コードが肥大化してしまいます。そこで、この記事では、LangchainなしでCLI PDFチャットボットを構築し、なぜ必ずしもAIフレームワークが必要ではないのかを理解していきます。 学習目標 LangchainやLlama IndexのようなAIフレームワークが必要ない理由 フレームワークが必要な場合 ベクトルデータベースとインデックス作成について学ぶ PythonでゼロからCLI Q&Aチャットボットを構築する この記事は、Data Science Blogathonの一環として公開されました。 Langchainなしで済むのか? 最近の数ヶ月間、LangchainやLLama Indexなどのフレームワークは、開発者によるLLMアプリの便利な開発を可能にする非凡な能力により、注目を集めています。しかし、多くのユースケースでは、これらのフレームワークは過剰となる場合があります。それは、銃撃戦にバズーカを持ってくるようなものです。 これらのフレームワークには、プロジェクトで必要のないものも含まれています。Pythonはすでに肥大化していることで有名です。その上で、ほとんど必要のない依存関係を追加すると、環境が混乱するだけです。そのようなユースケースの一つがドキュメントのクエリです。プロジェクトがAIエージェントやその他の複雑なものを含まない場合、Langchainを捨ててゼロからワークフローを作成することで、不要な肥大化を減らすことができます。また、LangchainやLlama Indexのようなフレームワークは急速に開発が進んでおり、コードのリファクタリングによってビルドが壊れる可能性があります。 Langchainはいつ必要ですか? 複雑なソフトウェアを自動化するエージェントを構築したり、ゼロから構築するのに長時間のエンジニアリングが必要なプロジェクトなど、より高度なニーズがある場合は、事前に作成されたソリューションを使用することは合理的です。改めて発明する必要はありません、より良い車輪が必要な場合を除いては。その他にも、微調整を加えた既製のソリューションを使用することが絶対に合理的な場合は数多くあります。 QAチャットボットの構築 LLMの最も求められているユースケースの一つは、ドキュメントの質問応答です。そして、OpenAIがChatGPTのエンドポイントを公開した後、テキストデータソースを使用して対話型の会話ボットを構築することがより簡単になりました。この記事では、ゼロからLLM Q&A…

大規模言語モデルの探索-パート2

この記事は主に自己学習のために書かれていますそのため、幅広く深く進んでいます興味のあるセクションをスキップしたり、自分の興味がある分野を探したりしても構いません以下にいくつかの…

このAI研究は、OpenAIの埋め込みを使用した強力なベクトル検索のためのLuceneの統合を提案します

最近、機械学習の検索分野において、深層ニューラルネットワークを応用することで大きな進歩がありました。特に、バイエンコーダーアーキテクチャ内の表現学習に重点を置いています。このフレームワークでは、クエリ、パッセージ、さらには画像などのマルチメディアなど、さまざまな種類のコンテンツが、密なベクトルとして表されるコンパクトで意味のある「埋め込み」として変換されます。このアーキテクチャに基づいて構築されたこれらの密な検索モデルは、大規模な言語モデル(LLM)内の検索プロセスの強化の基盤として機能します。このアプローチは人気があり、現在の生成的AIの広い範囲でLLMの全体的な能力を高めるのに非常に効果的であることが証明されています。 この論文では、多くの密なベクトルを処理する必要があるため、企業は「AIスタック」に専用の「ベクトルストア」または「ベクトルデータベース」を組み込むべきだと示唆しています。一部のスタートアップ企業は、これらのベクトルストアを革新的で不可欠な現代の企業アーキテクチャの要素として積極的に推進しています。有名な例には、Pinecone、Weaviate、Chroma、Milvus、Qdrantなどがあります。一部の支持者は、これらのベクトルデータベースが従来のリレーショナルデータベースをいずれ置き換える可能性さえ示しています。 この論文では、この説に対して反論を示しています。その議論は、既存の多くの組織で存在し、これらの機能に大きな投資がなされているという点を考慮した、簡単なコスト対効果分析を中心に展開されています。生産インフラストラクチャは、Elasticsearch、OpenSearch、Solrなどのプラットフォームによって主導されている、オープンソースのLucene検索ライブラリを中心とした広範なエコシステムによって支配されています。 https://arxiv.org/abs/2308.14963 上記の画像は、標準的なバイエンコーダーアーキテクチャを示しており、エンコーダーがクエリとドキュメント(パッセージ)から密なベクトル表現(埋め込み)を生成します。検索はベクトル空間内のk最近傍探索としてフレーム化されています。実験は、ウェブから抽出された約880万のパッセージから構成されるMS MARCOパッセージランキングテストコレクションに焦点を当てて行われました。評価には、標準の開発クエリとTREC 2019およびTREC 2020 Deep Learning Tracksのクエリが使用されました。 調査結果は、今日ではLuceneを直接使用してOpenAIの埋め込みを使用したベクトル検索のプロトタイプを構築することが可能であることを示唆しています。埋め込みAPIの人気の増加は、私たちの主張を支持しています。これらのAPIは、コンテンツから密なベクトルを生成する複雑なプロセスを簡素化し、実践者にとってよりアクセスしやすくしています。実際には、今日の検索エコシステムを構築する際に必要なのはLuceneだけです。しかし、時間が経って初めて正しいかどうかがわかります。最後に、これはコストと利益を比較することが主要な考え方であり続けることを思い起こさせてくれるものです。急速に進化するAIの世界でも同様です。

「Auto-GPT&GPT-Engineer:今日の主要なAIエージェントについての詳細ガイド」

「ChatGPTとAuto-GPT&GPT-Engineerなどの自律型AIエージェントの包括的な分析に没入してください機能、セットアップガイドを探索し、労働市場への影響を理解してください」

「GPTCacheとは:LLMクエリセマンティックキャッシュの開発に役立つライブラリを紹介します」

ChatGPTと大規模言語モデル(LLM)は非常に柔軟性があり、多くのプログラムの作成が可能です。ただし、LLM APIの呼び出しに関連するコストは、アプリケーションが人気を集め、トラフィック量が増加するときに重要になる可能性があります。多くのクエリを処理する場合、LLMサービスには長い待ち時間が生じることもあります。 この困難に立ち向かうために、研究者はGPTCacheというプロジェクトを開発しました。GPTCacheは、LLMの回答を格納するためのセマンティックキャッシュを作成することを目指しています。オープンソースのGPTCacheプログラムは、LLMの出力回答をキャッシュすることにより、LLMを高速化することができます。キャッシュにリクエストされた応答がすでに格納されている場合、それを取得する時間を大幅に短縮することができます。 GPTCacheは柔軟でシンプルであり、どのアプリケーションにも適しています。OpenAIのChatGPTなど、多くの言語学習機械(LLM)と互換性があります。 どのように動作するのか? GPTCacheは、LLMの最終的な応答をキャッシュします。キャッシュは、最近使用された情報を迅速に取得するために使用されるメモリバッファです。新しいリクエストがLLMに送信されるたびに、GPTCacheはまずキャッシュを調べて要求された応答が既にそこに格納されているかどうかを判断します。キャッシュ内で応答が見つかった場合、すぐに返されます。そうでない場合は、LLMが応答を生成してキャッシュに追加します。 GPTCacheのモジュラーアーキテクチャにより、カスタムのセマンティックキャッシュソリューションを簡単に実装することができます。ユーザーはさまざまな設定を選択することで、各モジュールとの経験をカスタマイズすることができます。 LLMアダプターは、さまざまなLLMモデルで使用されるAPIとリクエストプロトコルを統一し、それらをOpenAI APIで標準化します。LLMアダプターは、コードの書き直しや新しいAPIの理解を必要とせずにLLMモデル間を移動できるため、テストと実験を簡素化します。 埋め込み生成器は、要求されたモデルを使用して埋め込みを作成し、類似性検索を実行します。サポートされているモデルでは、OpenAIの埋め込みAPIを使用できます。これには、GPTCache/paraphrase-albert-onnxモデルを使用するONNX、Hugging Face埋め込みAPI、Cohere埋め込みAPI、fastText埋め込みAPI、SentenceTransformers埋め込みAPIが含まれます。 キャッシュストレージでは、ChatGPTなどのLLMからの応答が取得できるまで保持されます。2つのエンティティが意味的に類似しているかどうかを判断する際には、キャッシュされた応答が取得され、要求されたパーティーに送信されます。GPTCacheはさまざまなデータベース管理システムと互換性があります。ユーザーは、パフォーマンス、拡張性、および最も一般的にサポートされているデータベースのコストに関する要件を最も満たすデータベースを選択することができます。 ベクトルストアの選択肢:GPTCacheには、オリジナルのリクエストから派生した埋め込みを使用して、K個の最も類似したリクエストを特定するベクトルストアモジュールが含まれています。この機能を使用すると、2つのリクエストがどれだけ類似しているかを判断することができます。さらに、GPTCacheはMilvus、Zilliz Cloud、FAISSなどの複数のベクトルストアをサポートし、それらとの作業に対して簡単なインターフェースを提供します。ユーザーは、さまざまなベクトルストアオプションを選択できます。これらのオプションのいずれかが、GPTCacheの類似性検索のパフォーマンスに影響を与える可能性があります。さまざまなベクトルストアをサポートすることで、GPTCacheは適応性があり、さまざまなユースケースとユーザーの要件を満たすことができます。 GPTCacheキャッシュマネージャーは、キャッシュストレージとベクトルストアコンポーネントのエビクションポリシーを管理します。キャッシュが一杯になったときに新しいデータのためのスペースを作るために、置換ポリシーが古いデータを削除するかどうかを決定します。 類似性評価器の情報は、GPTCacheのキャッシュストレージとベクトルストアのセクションから取得されます。入力リクエストをベクトルストア内のリクエストと比較することで、類似度を測定します。リクエストがキャッシュから提供されるかどうかは、類似度の程度に依存します。GPTCacheは類似性アルゴリズムを使用してキャッシュの一致を判断する能力を持つため、さまざまなユースケースとユーザーの要件に適応することができます。 特徴と利点 GPTCacheによるLLMクエリの待ち時間の短縮により、応答性と速度が向上します。 トークンベースおよびリクエストベースの価格体系により、LLMサービスに共通のコスト削減が可能です。GPTCacheはAPIの呼び出し回数を制限することで、サービスのコストを削減することができます。 GPTCacheはLLMサービスからの作業をオフロードする能力を持つため、スケーラビリティが向上します。リクエスト数が増えるにつれて、ピークの効率で運営を続けるのに役立ちます。 GPTCacheの助けを借りて、LLMアプリケーションの作成に関連するコストを最小限に抑えることができます。LLMで生成されたデータをキャッシュしたり、模擬したりすることで、LLMサービスにAPIリクエストを行わずにアプリをテストすることができます。 GPTCacheは、選択したアプリケーション、LLM(ChatGPT)、キャッシュストア(SQLite、PostgreSQL、MySQL、MariaDB、SQL Server、またはOracle)、およびベクトルストア(FAISS、Milvus、Ziliz Cloud)と連携して使用することができます。GPTCacheプロジェクトの目標は、毎回ゼロから始めるのではなく、できる限り以前に生成された返信を再利用することによって、GPTベースのアプリケーションで言語モデルを最も効率的に活用することです。

2023年のMLOpsの景色:トップのツールとプラットフォーム

2023年のMLOpsの領域に深く入り込むと、多くのツールやプラットフォームが存在し、モデルの開発、展開、監視の方法を形作っています総合的な概要を提供するため、この記事ではMLOpsおよびFMOps(またはLLMOps)エコシステムの主要なプレーヤーについて探求します...

私が通常のRDBMSをベクトルデータベースに変換して埋め込みを保存する方法

この記事では、一般的なRDBMSを完全に機能したベクトルデータベースに変換して、GenerativeAIアプリケーションの開発に埋め込みを格納する方法について説明します

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.