Learn more about Search Results Ding et al. 2021 - Page 3

- You may be interested

- 3Dインスタンスセグメンテーションにおけ...

- 「大型言語モデルとビジネスの架け橋:LLM...

- 「IBMの「脳のような」AIチップが、環境に...

- UCサンディエゴとクアルコムの研究者たち...

- 「クロード2の探索:アントロピックの次世...

- ギャラリー、図書館、アーカイブ、博物館...

- MLモデルのパッケージング【究極のガイド】

- 「NVIDIAがAIおよびHPCワークロードに特化...

- 新しいAmazon KendraのWebクローラーを使...

- ‘LLMがデータアナリストを置き換えること...

- なぜデータは新たな石油ではなく、データ...

- 感情予測のためのFine-Tuned LLM — 分析と...

- 「Underrepresented Groupsの存在下での学...

- デジタルアイデンティティを保護する方法

- 「S4 HANAとDomoでSQLを使用してデータ分...

「人物再識別入門」

「人物再識別」は、異なる非重複カメラビューに現れる個人を識別するプロセスですこのプロセスは、顔認識に頼らずに、服装を考慮します...

施設分散問題:混合整数計画モデル

いくつかの施設配置問題では、施設を配置する必要があります他の施設に影響を与えたり、悪影響を及ぼしたりしないようにするために、施設の位置を決める必要がありますリスク軽減の動機によって駆動されるかどうかに関係なく...

画像中のテーブルの行と列をトランスフォーマーを使用して検出する

はじめに 非構造化データを扱ったことがあり、ドキュメント内のテーブルの存在を検出する方法を考えたことはありますか?ドキュメントを迅速に処理するための方法を提供しますか?この記事では、トランスフォーマーを使用して、テーブルの存在だけでなく、テーブルの構造を画像から認識する方法を見ていきます。これは、2つの異なるモデルによって実現されます。1つはドキュメント内のテーブルの検出のためのもので、もう1つはテーブル内の個々の行と列を認識するためのものです。 学習目標 画像上のテーブルの行と列を検出する方法 Table TransformersとDetection Transformer(DETR)の概要 PubTables-1Mデータセットについて Table Transformerでの推論の実行方法 ドキュメント、記事、PDFファイルは、しばしば重要なデータを伝えるテーブルを含む貴重な情報源です。これらのテーブルから情報を効率的に抽出することは、異なるフォーマットや表現の間の課題により複雑になる場合があります。これらのテーブルを手動でコピーまたは再作成するのは時間がかかり、ストレスがかかることがあります。PubTables-1Mデータセットでトレーニングされたテーブルトランスフォーマーは、テーブルの検出、構造の認識、および機能分析の問題に対処します。 この記事はData Science Blogathonの一環として公開されました。 この方法はどのように実現されたのですか? これは、PubTables-1Mという名前の大規模な注釈付きデータセットを使用して、記事などのドキュメントや画像を検出するためのトランスフォーマーモデルであるTable Transformerによって実現されました。このデータセットには約100万のパラメータが含まれており、いくつかの手法を用いて実装されており、モデルに最先端の感触を与えています。効率性は、不完全な注釈、空間的な整列の問題、およびテーブルの構造の一貫性の課題に取り組むことで達成されました。モデルとともに公開された研究論文では、テーブルの構造認識(TSR)と機能分析(FA)のジョイントモデリングにDetection Transformer(DETR)モデルを活用しています。したがって、DETRモデルは、Microsoft Researchが開発したTable Transformerが実行されるバックボーンです。DETRについてもう少し詳しく見てみましょう。 DEtection TRansformer(DETR) 前述のように、DETRはDEtection TRansformerの略であり、エンコーダーデコーダートランスフォーマーを使用したResNetアーキテクチャなどの畳み込みバックボーンから構成されています。これにより、オブジェクト検出のタスクを実行する潜在能力を持っています。DETRは、領域提案、非最大値抑制、アンカー生成などの複雑なモデル(Faster…

メタスの新しいテキストから画像へのモデル – CM3leon論文の説明

メタは最近、Stable-Diffusion [2]、Midjourney、またはDALLE [3]のような拡散に基づかない最新のテキストから画像へのモデル、CM3Leon [1]を発表しました少々長いですが、要するに...

スウィン・トランスフォーマー | モダンなコンピュータビジョンタスク

イントロダクション Swin Transformerは、ビジョントランスフォーマーの分野における重要なイノベーションです。トランスフォーマーは、様々なタスクで優れたパフォーマンスを発揮してきました。その中でも、Swin Transformerはコンピュータビジョンのバックボーンとして優れた柔軟性と拡張性を提供し、現代のディープラーニングモデルの要求に応える能力を持っています。このトランスフォーマーのフルポテンシャルを引き出し、その印象的な能力を目の当たりにしましょう。 学習目標 この記事では、強力な階層的なビジョントランスフォーマーであるSwin Transformerを紹介します。この記事を読み終えることで、以下のことが理解できるようになるでしょう: Swin Transformerの主な特徴 コンピュータビジョンモデルのバックボーンとしての応用 画像分類、物体検出、インスタンスセグメンテーションなどの様々なコンピュータビジョンタスクにおけるSwin Transformerの利点 この記事は、データサイエンスブログマラソンの一環として公開されました。 Swin Transformerの理解 2021年の論文「Swin Transformer: Hierarchical Vision Transformer using Shifted Windows」で、Ze Liu、Yutong…

車両ルーティング問題 正確な解法とヒューリスティック解法

「車両ルーティング問題(VRP)は、与えられた一連の顧客をサービスするために、車両のフリートが実行する最適なルートセットを決定することを目指していますその多くの応用と挑戦的な性質により…」

大規模言語モデルの挙動を監視する7つの方法

自然言語処理の世界では、大規模言語モデル(LLM)の使用による急速な進化が見られています彼らの印象的なテキスト生成およびテキスト理解能力を通じて、LLMは...

CPU上でBERT推論をスケーリングアップする(パート1)

.centered { display: block; margin: 0 auto; } figure { text-align: center; display: table; max-width: 85%; /* デモです; 必要に応じていくつかの量 (px や %) を設定してください */…

1Bのトレーニングペアで文埋め込みモデルをトレーニングする

文の埋め込みは、文を実数のベクトルにマッピングする手法です。理想的には、これらのベクトルは文の意味を捉え、高度に汎用的であるべきです。そのような表現は、クラスタリング、テキストマイニング、質問応答など、多くの下流アプリケーションで使用することができます。 私たちは、「1Bのトレーニングペアで最高の文埋め込みモデルをトレーニングするプロジェクト」として、最先端の文埋め込みモデルを開発しました。このプロジェクトは、Hugging Faceによって主催されたCommunity week using JAX/Flax for NLP & CVの一環として行われました。このプロジェクトでは、GoogleのFlax、JAX、およびCloudチームのメンバーから、効率的なディープラーニングフレームワークに関するガイダンスを受けました! トレーニング手法 モデル 単語とは異なり、有限の文の集合を定義することはできません。したがって、文の埋め込み手法では、内部の単語を組み合わせて最終的な表現を計算します。たとえば、SentenceBertモデル(Reimers and Gurevych, 2019)では、多くのNLPアプリケーションの基盤であるTransformerを使用し、コンテキスト化された単語ベクトルに対してプーリング操作を行います(以下の図を参照)。 マルチプルネガティブランキングロス 構成モジュールのパラメータは通常、自己教師ありの目的関数を使用して学習されます。このプロジェクトでは、以下の図で説明されているコントラスティブトレーニング方法を使用しました。文のペア(a_i, p_i)が意味的に近いペアであるデータセットを構成します。たとえば、(クエリ、回答パッセージ)、(質問、重複質問)、(論文タイトル、引用論文タイトル)などのペアを考慮します。その後、モデルは、ペア(a_i, p_i)を埋め込み空間で近いベクトルにマッピングするようにトレーニングされます。一方、非一致のペア(a_i, p_j)、i ≠ jは、埋め込み空間で遠いベクトルにマッピングされます。このトレーニング方法は、インバッチネガティブ、InfoNCE、またはNTXentLossとも呼ばれます。 形式的には、トレーニングサンプルのバッチが与えられた場合、モデルは以下の損失関数を最適化します:…

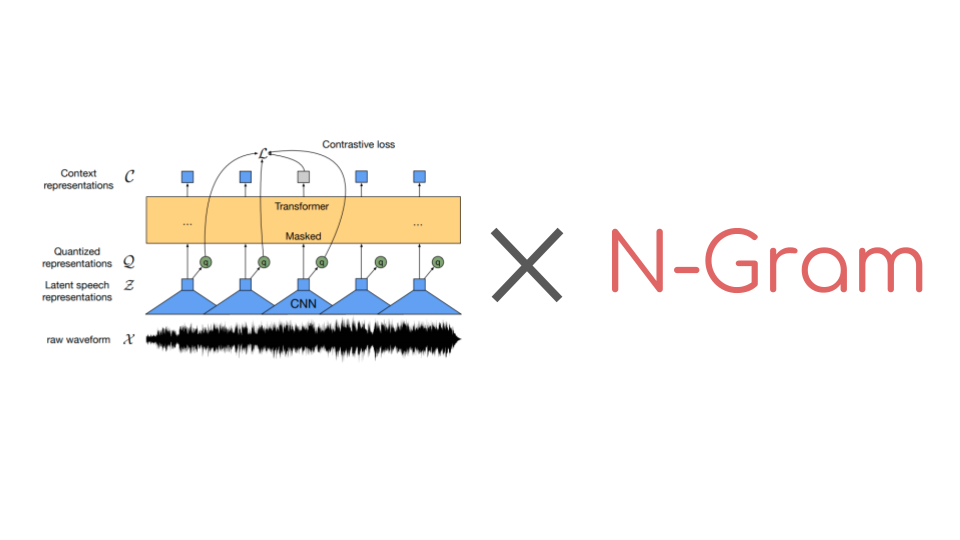

🤗 Transformersでn-gramを使ってWav2Vec2を強化する

Wav2Vec2は音声認識のための人気のある事前学習モデルです。2020年9月にMeta AI Researchによってリリースされたこの新しいアーキテクチャは、音声認識のための自己教師あり事前学習の進歩を促進しました。例えば、G. Ng et al.、2021年、Chen et al、2021年、Hsu et al.、2021年、Babu et al.、2021年などが挙げられます。Hugging Face Hubでは、Wav2Vec2の最も人気のある事前学習チェックポイントは現在、月間ダウンロード数25万以上です。 コネクショニスト時系列分類(CTC)を使用して、事前学習済みのWav2Vec2のようなチェックポイントは、ダウンストリームの音声認識タスクで非常に簡単にファインチューニングできます。要するに、事前学習済みのWav2Vec2のチェックポイントをファインチューニングする方法は次のとおりです。 事前学習チェックポイントの上にはじめに単一のランダムに初期化された線形層が積み重ねられ、生のオーディオ入力を文字のシーケンスに分類するために訓練されます。これは以下のように行います。 生のオーディオからオーディオ表現を抽出する(CNN層を使用する) オーディオ表現のシーケンスをトランスフォーマーレイヤーのスタックで処理する 処理されたオーディオ表現を出力文字のシーケンスに分類する 以前のオーディオ分類モデルでは、分類されたオーディオフレームのシーケンスを一貫した転写に変換するために、追加の言語モデル(LM)と辞書が必要でした。Wav2Vec2のアーキテクチャはトランスフォーマーレイヤーに基づいているため、各処理されたオーディオ表現は他のすべてのオーディオ表現から文脈を得ることができます。さらに、Wav2Vec2はファインチューニングにCTCアルゴリズムを利用しており、変動する「入力オーディオの長さ」と「出力テキストの長さ」の比率の整列の問題を解決しています。 文脈化されたオーディオ分類と整列の問題がないため、Wav2Vec2には受け入れ可能なオーディオ転写を得るために外部の言語モデルや辞書は必要ありません。 公式論文の付録Cに示されているように、Wav2Vec2は言語モデルを使用せずにLibriSpeechで印象的なダウンストリームのパフォーマンスを発揮しています。ただし、付録からも明らかなように、Wav2Vec2を10分間の転写済みオーディオのみで訓練した場合、言語モデルと組み合わせると特に改善が見られます。 最近まで、🤗 TransformersライブラリにはファインチューニングされたWav2Vec2と言語モデルを使用してオーディオファイルをデコードするための簡単なユーザーインターフェースがありませんでした。幸いにも、これは変わりました。🤗…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.