Learn more about Search Results 定義 - Page 3

- You may be interested

- (CodeGPT AIコミュニティで話題となってい...

- 「OpenAIとMetaが著作権侵害で訴えられる」

- 「Appleの研究者たちは、暗黙的なフィード...

- ポリシーグラディエント(Policy Gradient...

- ステアラブルニューラルネットワーク(パ...

- 「現実の応用における一般線形モデルの自...

- 「トランスフォーマーは戦略を学ぶことが...

- A.I.-検出ツールを騙すのはどれくらい簡単...

- GoogleのAIスタジオ:ジェミニの創造的な...

- GoogleのSymbol Tuningは、LLM(Language ...

- 線形回帰の理論的な深堀り

- 「Pythonデータ構造について知っておくべ...

- 「データ品質とは何ですか?」

- データサイエンティストのためのDockerチ...

- AIを用いた遺伝子発現の予測

DeepMindの研究者たちは、正確な数学的定義を用いて、連続した強化学習を再定義しました

深層強化学習(RL)の最近の進展により、人工知能(AI)エージェントがさまざまな印象的なタスクで超人的なパフォーマンスを発揮しています。これらの結果を達成するための現在のアプローチは、主に興味のある狭いタスクをマスターする方法を学習するエージェントを開発することに従っています。未訓練のエージェントはこれらのタスクを頻繁に実行する必要があり、単純なRLモデルでも新しいバリエーションに一般化する保証はありません。それに対して、人間は生涯を通じて知識を獲得し、新しいシナリオに適応するために一般化します。これを連続的な強化学習(CRL)と呼びます。 RLにおける学習の視点は、エージェントがマルコフ環境と対話して最適な行動を効率的に特定することです。最適な行動の探索は学習の一点で停止します。たとえば、よく定義されたゲームをプレイしていると想像してください。ゲームをマスターしたら、タスクは完了し、新しいゲームシナリオについて学習することはありません。学習を解決策の発見ではなく、終わりのない適応として見る必要があります。 連続的な強化学習(CRL)はそのような研究を含みます。これは監督された終わりのない継続的な学習です。DeepMindの研究者は、エージェントを2つのステップで明示的に理解します。1つは、すべてのエージェントを行動の集合上で暗黙的に検索していると理解し、もう1つはすべてのエージェントが検索を続けるか、最終的に行動の選択肢で停止するという考え方です。研究者は、エージェントに関連する2つの生成子を生成到達演算子として定義します。この形式主義を使用して、彼らはCRLをすべてのエージェントが検索を停止しないRL問題として定義します。 ニューラルネットワークの構築には、要素の重みの任意の割り当てと、基盤のアクティブな要素の更新のための学習メカニズムが必要です。研究者は、CRLではネットワークのパラメータ数は構築できるものに制約され、学習メカニズムは基盤の無制約な検索方法ではなく確率的勾配降下法と考えることができます。ここで、基盤は任意ではありません。 研究者は、振る舞いの表現として機能する関数のクラスを選択し、経験に応じて望ましい方法で反応するための特定の学習ルールを利用します。関数のクラスの選択は、利用可能なリソースやメモリに依存します。確率的勾配降下法は、現在の基盤の選択肢を更新してパフォーマンスを向上させます。基盤の選択は任意ではありませんが、これにはエージェントの設計および環境によって課せられる制約も含まれます。 研究者は、学習ルールのさらなる研究が新しい学習アルゴリズムの設計を直接変更することができると主張しています。継続的な学習ルールの特徴付けにより、継続的な学習エージェントの収穫が保証され、基本的な継続的な学習エージェントの設計をガイドするためにさらに利用できます。彼らはまた、可塑性損失、インコンテキスト学習、および壊滅的な忘却などのさらなる手法の調査を意図しています。

「TALL(タール):空間および時間的な依存関係の保存を実現するため、ビデオクリップを事前定義されたレイアウトに変換するAIアプローチ」

この論文の主題は、ディープフェイク動画の検出方法の開発です。 ディープフェイクとは、人工知能を使用して、誰かが言ったり何かをしたりしたように見せるために操作された動画です。これらの操作された動画は悪用され、個人のプライバシーやセキュリティに脅威をもたらす可能性があります。研究者が解決しようとしている問題は、これらのディープフェイク動画の検出です。 既存の動画検出方法は計算量が多く、一般化能力を改善する必要があります。研究チームは、サムネイルレイアウト(TALL)というシンプルで効果的な戦略を提案しています。この戦略は、ビデオクリップを事前定義されたレイアウトに変換して、空間的および時間的な依存関係を保持します。 空間的依存性:これは、近くにあるデータ点や隣接するデータ点は、遠くにあるデータ点よりも類似している可能性が高いという概念を指します。画像やビデオ処理の文脈では、空間的依存性はしばしば画像やフレーム内のピクセル間の関係を指します。 時間的依存性:これは、現在のデータ点やイベントが過去のデータ点やイベントに影響を受けるという概念を指します。ビデオ処理の文脈では、時間的依存性はしばしばビデオ内のフレーム間の関係を指します。 研究者によって提案されたこの方法はモデルに依存せず、シンプルであり、コードのわずかな修正のみが必要です。著者たちはTALLをSwin Transformerに組み込み、効率的かつ効果的な方法であるTALL-Swinを形成しました。この論文では、TALLとTALL-Swinの妥当性と優越性を検証するために、幅広いデータセット内およびデータセット間の実験が含まれています。 Swin Transformerについての簡単な概要:マイクロソフトのSwin Transformerは、画像認識のタスクで成功したモデルのクラスであるビジョンTransformerの一種です。Swin Transformerは、画像内の階層的な特徴を処理することを特に目的としており、オブジェクト検出やセマンティックセグメンテーションなどのタスクに有益です。元のViTにあった問題を解決するために、Swin Transformerは階層的な特徴マップとシフトしたウィンドウの注意を組み込んでいます。細かい予測が必要な状況でSwin Transformerを適用することにより、階層的な特徴マップを使用して解決することが可能になりました。今日、さまざまなビジョンのジョブでは、Swin Transformerがバックボーンアーキテクチャとして一般的に使用されています。 論文で提案されたサムネイルレイアウト(TALL)戦略:マスキング:最初のステップでは、各フレームの固定位置に連続するフレームをマスキングします。論文の文脈では、各フレームが「マスク」され、モデルがマスクされていない部分に焦点を当ててより堅牢な特徴を学習する可能性があります。 リサイズ:マスキング後、フレームはサブイメージにリサイズされます。このステップにより、モデルの計算量が削減される可能性があります。小さなイメージは処理により少ない計算リソースを必要とします。 並べ替え:リサイズされたサブイメージは、事前定義されたレイアウトに並べ替えられ、サムネイルが形成されます。このステップは、ビデオの空間的および時間的な依存関係を保持するために重要です。サブイメージを特定の方法で配置することにより、モデルは各サブイメージ内のピクセル間の関係(空間的依存性)および時間の経過におけるサブイメージ間の関係(時間的依存性)を分析することができます。ディープフェイク動画の検出のためのTALL-Swinメソッドの効果を評価する実験: データセット内評価: 著者たちは、FF++データセットを使用して、複数の高度な方法とTALL-Swinを比較しました。低品質(LQ)および高品質(HQ)ビデオの両方で、TALL-Swinは以前のビデオトランスフォーマーメソッドと比較して、同等の性能を持ち、より低い消費量を示しました。 未知のデータセットへの一般化: 著者たちはまた、FF++(HQ)データセットでモデルをトレーニングし、Celeb-DF(CDF)、DFDC、FaceShifter(FSh)、DeeperForensics(DFo)データセットでテストすることでTALL-Swinの一般化能力を試験しました。TALL-Swinは最先端の結果を達成しました。 サリエンシーマップの可視化: 著者たちは、TALL-Swinがディープフェイクの顔に注目している箇所を可視化するためにGrad-CAMを使用しました。TALL-Swinは、特定の方法固有のアーティファクトを捉え、顔や口の領域などの重要な領域に焦点を当てることができました。 結論:最後に、著者たちは、彼らのTALL-Swinメソッドがディープフェイク動画の検出に効果的であり、既存の方法と比較して同等または優れたパフォーマンスを示し、未知のデータセットに対する良好な一般化能力と一般的な干渉に対する堅牢性を示したことを結論付けました。

私たちの原則がAlphaFoldの公開を定義するのにどのように役立ったか

私たちのオペレーティング・プリンシプルは、広範な利益を優先することへの取り組みと、追求しない研究領域やアプリケーションの定義において、私たちを特徴付けるようになりましたこれらの原則は、DeepMindの創設以来、私たちの意思決定の中心にあり、AIの風景が変化し成長するにつれて、磨かれ続けていますこれらの原則は、研究主導の科学企業としての役割に合わせて設計され、GoogleのAI原則と一致しています

AWS CDKを介してAmazon SageMakerロールマネージャーを使用して、カスタム権限を数分で定義します

機械学習(ML)の管理者は、MLワークロードのセキュリティと完全性を維持する上で重要な役割を果たしています彼らの主な焦点は、ユーザーが最高のセキュリティで操作し、最小特権の原則に従うことを確認することですただし、異なるユーザーペルソナの多様なニーズに対応し、適切な許可ポリシーを作成することは、時にアジリティを妨げることがあります[…]

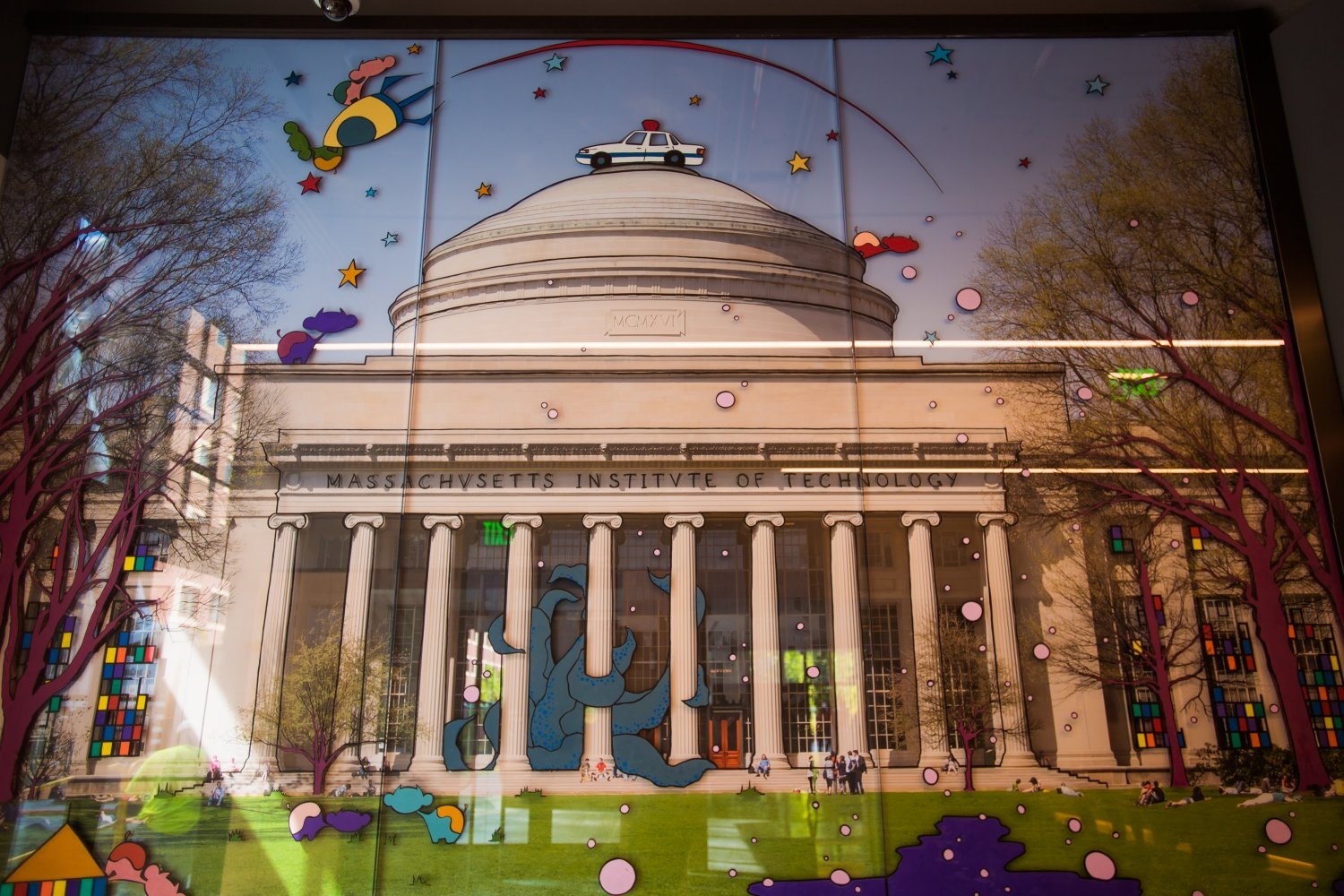

新技術における公共の利益の定義

新しいオンラインジャーナルが、テクノロジーを設計、実装、評価する個人の社会的責任について議論するために、MITコミュニティを一緒にすることを目的としています

📱 アップルが不正な認証からのiMessageアクセスをブロック

アップルは積極的な対策を実施することで顧客の安全を最優先に考えていますしかし、Beeperによると、彼らの最新の行動は逆効果になってしまったようですしかし、アップルは顧客の安全を重視し、積極的な対策を実施する姿勢は評価されるべきです

「2023年、オープンLLMの年」

2023年には、大型言語モデル(Large Language Models、LLMs)への公衆の関心が急増しました。これにより、多くの人々がLLMsの定義と可能性を理解し始めたため、オープンソースとクローズドソースの議論も広範な聴衆に届くようになりました。Hugging Faceでは、オープンモデルに大いに興味を持っており、オープンモデルは研究の再現性を可能にし、コミュニティがAIモデルの開発に参加できるようにし、モデルのバイアスや制約をより簡単に評価できるようにし、チェックポイントの再利用によってフィールド全体の炭素排出量を低減するなど、多くの利点があります(その他の利点もあります)。 では、オープンLLMsの今年を振り返ってみましょう! 文章が長くなりすぎないようにするために、コードモデルには触れません。 Pretrained Large Language Modelの作り方 まず、大型言語モデルはどのようにして作られるのでしょうか?(もし既に知っている場合は、このセクションをスキップしてもかまいません) モデルのアーキテクチャ(コード)は、特定の実装と数学的な形状を示しています。モデルのすべてのパラメータと、それらが入力とどのように相互作用するかがリストとして表されます。現時点では、大部分の高性能なLLMsは「デコーダーのみ」トランスフォーマーアーキテクチャのバリエーションです(詳細は元のトランスフォーマーペーパーをご覧ください)。訓練データセットには、モデルが訓練された(つまり、パラメータが学習された)すべての例と文書が含まれています。したがって、具体的には学習されたパターンが含まれます。ほとんどの場合、これらの文書にはテキストが含まれており、自然言語(例:フランス語、英語、中国語)、プログラミング言語(例:Python、C)またはテキストとして表現できる構造化データ(例:MarkdownやLaTeXの表、方程式など)のいずれかです。トークナイザは、訓練データセットからテキストを数値に変換する方法を定義します(モデルは数学的な関数であり、したがって入力として数値が必要です)。トークン化は、テキストを「トークン」と呼ばれるサブユニットに変換することによって行われます(トークン化方法によっては単語、サブワード、または文字になる場合があります)。トークナイザの語彙サイズは、トークナイザが知っている異なるトークンの数を示しますが、一般的には32kから200kの間です。データセットのサイズは、これらの個々の「原子論的」単位のシーケンスに分割された後のトークンの数としてよく測定されます。最近のデータセットのサイズは、数千億から数兆のトークンに及ぶことがあります!訓練ハイパーパラメータは、モデルの訓練方法を定義します。新しい例ごとにパラメータをどれだけ変更すべきですか?モデルの更新速度はどのくらいですか? これらのパラメータが選択されたら、モデルを訓練するためには1)大量の計算パワーが必要であり、2)有能な(そして優しい)人々が訓練を実行し監視する必要があります。訓練自体は、アーキテクチャのインスタンス化(訓練用のハードウェア上での行列の作成)および上記のハイパーパラメータを使用して訓練データセット上の訓練アルゴリズムの実行からなります。その結果、モデルの重みが得られます。これらは学習後のモデルパラメータであり、オープンな事前学習モデルへのアクセスに関して多くの人々が話す内容です。これらの重みは、推論(つまり、新しい入力の予測やテキストの生成など)に使用することができます。 事前学習済みLLMsは、重みが公開されると特定のタスクに特化または適応することもあります。それらは、「ファインチューニング」と呼ばれるプロセスを介して、ユースケースやアプリケーションの出発点として使用されます。ファインチューニングでは、異なる(通常はより専門化された小規模な)データセット上でモデルに追加の訓練ステップを適用して、特定のアプリケーションに最適化します。このステップには、計算パワーのコストがかかりますが、モデルをゼロから訓練するよりも財政的および環境的にはるかにコストがかかりません。これは、高品質のオープンソースの事前学習モデルが非常に興味深い理由の一つです。コミュニティが限られたコンピューティング予算しか利用できない場合でも、自由に使用し、拡張することができます。 2022年 – サイズの競争からデータの競争へ 2023年以前、コミュニティで利用可能だったオープンモデルはありましたか? 2022年初頭まで、機械学習のトレンドは、モデルが大きければ(つまり、パラメータが多ければ)、性能が良くなるというものでした。特に、特定のサイズの閾値を超えるモデルは能力が向上するという考えがあり、これらの概念はemergent abilitiesとscaling lawsと呼ばれました。2022年に公開されたオープンソースの事前学習モデルは、主にこのパラダイムに従っていました。 BLOOM(BigScience Large Open-science…

「BERTをゼロから訓練する究極のガイド:最終幕」

自分自身のBERTモデルの構築とトレーニング

AIと自動化

「AIと自動化技術が優れたリターンを提供する一方で、関連するリスクを理解し最小化するために慎重に取り組む必要がある方法を学びましょう」

パスライトのCTO兼共同創設者、トレイ・ドイグのインタビューシリーズ

トレイ・ドイグは、パスライトの共同創設者兼CTOですトレイは、IBM、クリエイティブ・コモンズ、Yelpでエンジニアとして働いた経験を持つ、テック業界で10年以上の経験を持っていますTreyは、Yelp Reservationsのリードエンジニアであり、SeatMeの機能をYelp.comに統合する責任を負っていましたTreyはまた、SeatMeウェブアプリケーションの開発を率いました...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.