Learn more about Search Results モード - Page 36

- You may be interested

- 単一モダリティとの友情は終わりました &#...

- 「OpenAIのGPT Builderが壊れたのは誰のお...

- 「Plotly プロットでインド数字システムの...

- 「リトリーバル増強生成によるジェネラテ...

- 「モノのインターネット」から「すべての...

- NVIDIAが新しいDLSS 3.5を使用して、ゲー...

- 「スタンフォード研究者は、直接の監督な...

- メタAIのもう一つの革命的な大規模モデル ...

- 「ファウンデーションモデルの安全で準拠...

- 「物理学と流体力学に応用されたディープ...

- (パイソン で グラディエント こうか アニ...

- KiliとHuggingFace AutoTrainを使用した意...

- AIはETLの再発明に時間を浪費する必要はない

- OpenAIの進化:GPT5への競争

- 「AIデータ統合とコンテンツベースのマッ...

Google Researchにおける責任あるAI:パーセプションの公平性

Google ResearchのPerception Fairnessチームの共同リーダーであるSusanna RiccoとUtsav Prabhuが投稿しました。 Googleの責任あるAI研究は、異なるバックグラウンドと専門知識を持つチーム間、研究者と製品開発者間、そして最終的には広範なコミュニティとの協力の基盤の上に築かれています。パーセプションフェアネスチームは、コンピュータビジョンと機械学習(ML)のフェアネスに関する深い専門知識と、Googleをはじめとする製品にパワーを与える知覚システムを構築する研究者との直接的なつながりを組み合わせることで進歩を推進しています。私たちはGoogleのAI原則に基づいて、システムを包括的に設計するために協力して取り組んでいます。 パーセプションフェアネス研究は、Googleの製品をパワーにする最新の基盤と生成モデルを含む高度なマルチモーダルモデルの設計、開発、展開にわたります。 私たちのチームのミッションは、特に基盤モデルと生成AIに関連するマルチモーダルMLシステムにおける公平性と包括性のフロンティアを推進することです。これには、分類、ローカリゼーション、キャプション付け、検索、ビジュアルな質問応答、テキストから画像またはビデオの生成、生成画像とビデオの編集などの中核技術コンポーネントが含まれます。私たちは、これらのアプリケーションにおいて公平性と包括性を最優先のパフォーマンス目標とすることができると信じています。私たちの研究は、開発サイクル全体でこれらの目標を積極的に設計するための新しい分析と緩和策を開放することに焦点を当てています。私たちは、次のような核心の問いに答えます:MLをどのように使用して、人種、文化、社会的アイデンティティの人々の知覚を責任を持ってモデル化し、公平性と包括性を促進することができるのか?どのようなシステムのバイアス(例:特定の肌の色の人物の画像でのパフォーマンスの低下)を計測することができ、これらの指標を使用してより良いアルゴリズムを設計することができるのか?より包括的なアルゴリズムとシステムを構築し、障害が発生した場合に迅速に対応するにはどうすればよいのか? メディアにおける人々の表現の測定 画像やビデオを編集、キュレーション、または作成することができるMLシステムは、世界中の視聴者の信念を形成または強化することができます。これには、ステレオタイプの強化、人々のグループの傷つけや消去などの表現上の害を減らすための研究は、コンテンツと社会的な文脈の両方を深く理解することにかかっています。これは、異なる観察者が自分自身や自分のコミュニティをどのように捉え、他者がどのように表現されているかにかかっています。責任を持って行われるべき社会的カテゴリの研究とその方法については、この分野で大いに議論があります。私たちの研究は、社会学と社会心理学に基づき、人間の知覚に合致し、問題の主観性を受け入れ、微妙な測定と緩和を可能にするスケーラブルなソリューションに向けて取り組んでいます。例として、私たちはMonk Skin Toneスケールを使用した画像の肌のトーンの人間の知覚と注釈の違いに関する研究を行っています。 私たちのツールは、大規模なコンテンツコレクションにおける表現を研究するためにも使用されています。Media Understanding for Social Exploration(MUSE)プロジェクトを通じて、私たちは学術研究者、非営利団体、主要な消費者ブランドと提携して、主流メディアや広告コンテンツのパターンを理解しています。この研究は、2017年に最初に発表され、ハリウッド映画のジェンダー平等を分析した共著研究で始まりました。それ以来、私たちは分析のスケールと深さを増してきました。2019年には、270万本以上のYouTube広告に基づく調査結果を公開しました。最新の研究では、12年以上にわたる人気のある米国のテレビ番組における知覚される性別プレゼンテーション、知覚される年齢、肌のトーンの交差点での表現を調査しています。これらの研究は、コンテンツクリエーターや広告主に洞察を提供し、私たち自身の研究をさらに進めています。 メディアコレクションにおける表現パターンを明らかにするためにスケールで分析できるコンピュータシグナルのイラスト(実際のデータではありません)。[ビデオコレクション/ゲッティイメージズ] 進んでいくにつれて、私たちはMLの公平性に焦点を当てる概念と、それが責任を持って適用される領域を拡大しています。人々の写真の写実的なイメージを超えて、私たちはイラストや抽象的な人型のキャラクターの表現をモデル化するツールの開発に取り組んでいます。さらに、人間の姿が全くない画像さえも含めて、コミュニティや文化の表現をモデル化するツールを開発しています。最後に、描かれているのは誰だけでなく、それらがどのように描かれているかについても考える必要があります。周囲の画像コンテンツ、関連するテキスト、そして広範な文化的文脈を通じて伝えられる物語は何かを推論する必要があります。 知覚システムのバイアス特性の分析 高度なMLシステムの構築は複雑であり、製品の動作を決定するさまざまな利害関係者が情報を提供しています。全体的な品質は、ユーザーエクスペリエンスのプロキシとしてテストデータセット上の要約統計(全体的な正確度など)を使用してこれまでに定義され、測定されてきました。しかし、すべてのユーザーが同じ方法で製品を経験するわけではありません。 知覚の公平性は、要約統計を超えた微妙なシステムの振る舞いの実測を可能にし、これらの指標をシステムの品質に直接関連付けて製品の動作とローンチの意思決定に重要な役割を果たします。これは思っているよりもはるかに難しいことです。複雑なバイアスの問題(例:交差するサブグループ間のパフォーマンスの不均衡やステレオタイプの強化のインスタンス)を重要なニュアンスを失うことなく、わずかな数の指標に凝縮することは非常に困難です。また、公平性の指標と他の製品の指標(ユーザー満足度、正確性、レイテンシなど)の相互作用のバランスを取ることも課題です。これらはしばしば相反するとされながらも互換性があるとされるものです。広範なユーザーの満足度は、公平性と包含の目標を達成することに一致しているにもかかわらず、研究者が自分の仕事を「正確性と公平性のトレードオフの最適化」と表現するのは一般的です。 私たちは、Open Imagesの一部としてMIAPデータセットを構築し、複雑なシステムの社会的に関連する概念の知覚とバイアスの検出の研究を活用して、コンピュータビジョンにおけるMLの公平性研究を推進するリソースを作成しました。オリジナルの写真クレジット…

PythonとDashを使用してダッシュボードを作成する

この記事では、PythonとDashを使用してNetflixのダッシュボードを構築し、地図、グラフ、チャートを使用してコンテンツの配信と分類を視覚化する方法について説明しています

「リアルタイムデータのためのPythonでのChatGPT APIの使用方法」

「ChatGPTが未知のトピックに回答するようにしたいですか? ここでは、わずかなコード行でAIパワードのアプリを構築する方法について、ステップバイステップのチュートリアルをご紹介します」

なぜ科学者たちは仮想世界に没頭しているのか

「仮想現実(VR)技術を実験室で使用する科学研究者の数が増えており、しばしば遠くの同僚と簡単に協力したり、単にリモートで作業したりするために使用しています」

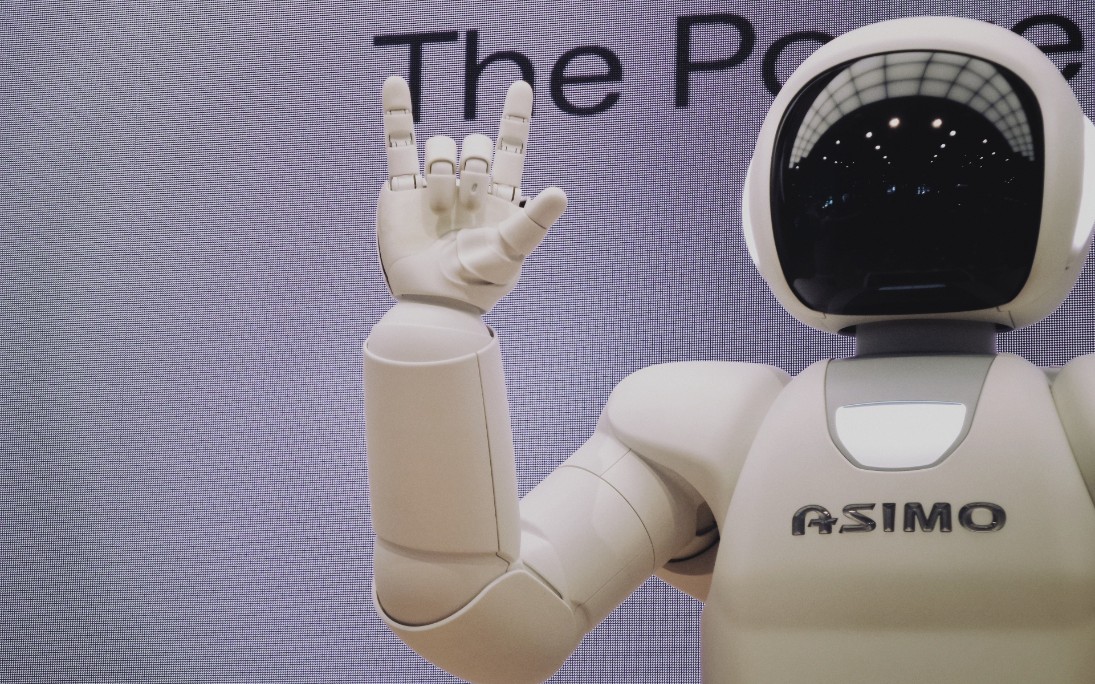

研究者たちは、ロボットが手全体を使って複雑な計画を立てることができるようにするAIを開発しました

「ロボットにとって、人間にとって自然な全身の操作という緻密な技能は、機械にとっての課題でしたしかし、MITの研究者たちは、人工知能の力を活用して、ロボティクスのこの問題を解決するために、接触豊かな操作計画と呼ばれる新しいアプローチを導入しています論文によると、...」

「PyTorch ProfilerとTensorBoardを使用して、データ入力パイプラインのボトルネックを解消する」

「これは、GPUベースのPyTorchワークロードのパフォーマンス分析と最適化に関するシリーズ投稿の4番目の投稿ですこの投稿では、トレーニングデータの入力に焦点を当てます...」

「Androidのための10最高のデータ復旧ツール」

「今日の高速デジタル時代では、Androidデバイスから重要なデータを失うことは悪夢とも言えます思い出の写真、必要な連絡先、重要な業務文書など、データを取り戻すための信頼性のある回復ツールが必要です幸いにも、数多くの効率的なAndroidデータ回復ツールが利用可能であり、失われたファイルを復元するのに役立ちます[…]

「LegalBenchとは:英語の大規模言語モデルにおける法的推論を評価するための共同構築されたオープンソースAIベンチマークです」

アメリカの弁護士や管理者は、大規模言語モデル(LLM)の進歩により、法律の専門職を再評価しています。支持者によれば、LLMは、ブリーフの執筆や企業のコンプライアンスなどの仕事にアプローチする弁護士の方法を変える可能性があります。また、法的サービスのアクセス可能性を高めることで、アメリカの長年の司法へのアクセス問題の解決にも貢献するかもしれません。この見解は、LLMが法的な仕事により適しているとされる独自の特性を持っていることに影響を受けています。法的言語モデルの作成に関連する手作業のデータ注釈に関連する費用は、モデルが少量のラベル付きデータから新しい仕事を学習する能力により、削減されるでしょう。 彼らはまた、複雑な専門用語を含む複雑なテキストを解読し、複数の思考モードを統合した推論手続きに従事する法律の厳密な研究にも適しています。しかし、法的アプリケーションはしばしば高いリスクを伴うため、この熱意を冷ます要素も存在します。研究により、LLMは攻撃的で欺瞞的で事実に反した情報を生み出すことが示されています。もしこれらの行動が法的な文脈で繰り返された場合、歴史的に弱い立場にある人々が不釣り合いな重荷を負う可能性があります。そのため、安全性の影響を考慮して、法的な文脈でのLLMの測定のためのインフラストラクチャと手順を構築するための緊急の必要性があります。 しかし、LLMが法的推論を使用できるかどうかを判断したいと考える実務者は、重大な障壁に直面しています。最初の障壁は、法的ベンチマークのエコロジーが限られていることです。例えば、現在のほとんどのベンチマークは、モデルが調整またはタスク固有のデータによるトレーニングを通じて学習するタスクに焦点を当てています。これらの基準は、法的業務に興味を持たせるLLMの特性を捉えていません。同様に、ベンチマーキングの取り組みは、Uniform Bar Examなどの専門資格試験に焦点を当てていますが、これらは常にLLMの現実世界での応用を示しているわけではありません。2番目の問題は、弁護士と確立された基準が「法的推論」という用語をどのように定義しているかの不一致です。 現在使用されているベンチマークは、法的知識や法律が必要とされる仕事を「法的推論」として広く分類しています。一方、弁護士は、「法的推論」というフレーズが広範であり、さまざまな種類の推論を含んでいることを認識しています。様々な法的責任には異なる能力と知識体系が必要です。既存の法的基準はこれらの違いを特定する必要があるため、法的実務者にとっては、現代のLLMのパフォーマンスを法的な能力の感覚の中で理解することは困難です。法的専門家がベンチマークプロセスに積極的に関与する必要があるため、法的コミュニティがLLMの法的推論能力を厳密に評価するためには、これらの制約が存在します。 これを実現するために、彼らはLEGALBENCHを導入します。これは、英語のための法的推論の学際的な共同ベンチマークの初期段階の構築を表しています。この研究の著者たちは、過去1年間にわたって協力して162のタスク(36の異なるデータソースから)を構築しました。各タスクは特定の形式の法的推論をテストします。彼らは、さまざまな法律とコンピュータ科学のバックグラウンドを活用しました。彼らによれば、LEGALBENCHは最初のオープンソースの法的ベンチマークプロジェクトです。このベンチマークデザインの方法は、専門家が評価タスクの開発に積極的に参加することを示しており、LLMの研究における多学科的な協力の一形態を具体化しています。彼らはまた、これが法律の評価と推進において法的実務者が果たす重要な役割を示していると主張しています。 彼らは、LEGALBENCHの研究プロジェクトとして3つの側面を強調しています: 1. LEGALBENCHは、少量のラベル付きデータから学習するfew-shot LLMパラダイムに適した形式に再構築された既存の法的データセットと、この作業の著者としてもリストされている法的専門家によって生成および提供された手作りのデータセットの組み合わせを使用して構築されました。この協力に参加した法的専門家は、LLMの法的能力を確認するための興味深い法的推論能力をテストするデータセットまたは実用的な価値のあるLLMの応用を表すデータセットを提供するよう招待されました。その結果、LEGALBENCHの課題での優れたパフォーマンスは、弁護士が自分のLLMの法的能力に対する意見を確認するために使用したり、ワークフローに役立つLLMを見つけるために使用したりすることができる関連データを提供します。 2. LEGALBENCHのタスクは、課題を完了するために必要な法的推論の種類を詳細に説明した分類学に配置されています。この分類学は、法的コミュニティに共通のフレームワークから引用し、既に馴染みのある語彙と概念的な枠組みを使用しているため、法律専門家はLLMのパフォーマンスについての議論に積極的に参加することができます。 3. 最後に、LEGALBENCHはさらなる研究のためのプラットフォームとして設計されています。LEGALBENCHは、法律に関するトレーニングを受けていないAI研究者がさまざまな活動を促進し評価する方法を知るための大きな支援を提供しています。彼らはまた、法律実務者からの作業を引き続き募集し、LEGALBENCHを拡大する意図も持っています。なぜなら、法律コミュニティがLLMsの潜在的な影響と機能との相互作用をさらに行うようになるからです。 彼らは以下の内容をこの論文に貢献しています: 1. 必要な正当化に基づいて法的義務を分類し特徴づけるためのタイポロジーを提供しています。このタイポロジーは、弁護士が法的推論を説明するために使用するフレームワークに基づいています。 2. 次に、LEGALBENCHの活動の概要を示し、作成方法、重要な異質性の次元、制約について説明しています。付録では、各割り当ての詳細な説明が記載されています。 3. さまざまなサイズの11つの異なるファミリーから20のLLMsを分析するために、彼らは最後のステップとしてLEGALBENCHを使用しています。彼らはいくつかのプロンプトエンジニアリングの戦術の初期調査を行い、さまざまなモデルの効果についてコメントを述べています。 これらの調査結果は、LEGALBENCHが促進する可能性のあるいくつかの研究トピックを明らかにしています。彼らは、さまざまなコミュニティがこのベンチマークに興味を持つと予想しています。実務家は、これらの活動を使用して、LLMsを現行プロセスに組み込む方法やその効果を判断することができます。LLMsが可能なさまざまなアノテーションの種類や、許可されるさまざまなタイプの実証的な学術研究は、法学アカデミックにとって興味深いものです。特殊な語彙的特徴と難解なタスクが新たな洞察をもたらす可能性のある法律のような分野でこれらのモデルの成功は、コンピュータサイエンティストにとっても興味深いでしょう。 続ける前に、彼らはこの作業の目標が、計算技術が弁護士や法務スタッフを置き換えるべきかどうかを評価することではないこと、またそのような置き換えの利点と欠点を理解することでもないことを明確にしています。代わりに、彼らは影響を受けるコミュニティと関係者が、LLMsが特定の法的責任を果たす能力をどの程度持っているかをよりよく理解するためのアーティファクトを作成したいと考えています。これらの技術の普及を考えると、この問題の解決は、計算法的な法的ツールの安全で倫理的な使用を保証する上で重要だと彼らは考えています。

「生成AIの風景を探索する」

ジェネレーティブAIは、特にニューラルネットワークを用いて、与えられたデータセット内のパターンを解読するために、さまざまな機械学習技術を使用します

「iOSのための10の最高のデータ復旧ツール(2023年8月)」

「今日のデジタル時代において、私たちのモバイルデバイスは私たちの生活の重要な部分を保管しています思い出の写真やビデオ、重要なドキュメントやメッセージまで、私たちのiOSデバイスには失うことのできない大量のデータが保存されていますしかし、事故は起こりますソフトウェアのグリッチ、意図しない削除、またはハードウェアの損傷など、原因はさまざまですが、 […]」

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.