Learn more about Search Results ML - Page 368

- You may be interested

- 「設定パラメータを使用して、ChatGPTの出...

- 「過小評価されている宝石Pt.1:あなたを...

- LLM Fine-Tuningの初心者ガイド

- 次世代の終わりのない学習者のベンチマーク化

- 生産性向上のための10の最高のAIツール(...

- 「火星のためのモルフォボット:カリフォ...

- ChatGPTを使用して、忘れられないスローガ...

- 「トップの生成AIプロジェクト」

- ミニGPT-5:生成的なヴォケンによる交錯し...

- 埋め込みの視覚化

- 「AIのための機会の議題」

- 単一のGPUでChatgptのようなチャットボッ...

- 未来への進化-新しいウェーブガイドがデー...

- 「不確定性pyと混沌pyを用いた多項式混沌...

- 「ChatGPTのリリースはオープンデータの生...

データ駆動型の世界で理解すべき重要な統計的アイデア4つ

2023年にデータリテラシーを持つためには、サンプリング、不確実性、AI、機械学習、そして統計的な主張の解釈といった基本的な概念が必要です

SalesforceはXGen-7Bを導入:1.5Tトークンのために8Kシーケンス長でトレーニングされた新しい7B LLMを紹介します

最近の人工知能の技術的なブレークスルーにより、Large Language Models(LLMs)はますます一般的になっています。過去数年間、研究者たちは、これらのモデルを膨大な量のデータでトレーニングして、複雑な言語関連のタスクを解決するための急速な進歩を遂げてきました。これには、複雑な言語パターンの理解、連続した回答の生成などが含まれます。特に研究者や開発者の関心を引いている研究の1つは、LLMsの長文コンテンツの取り扱いにおける応用です。これらのタスクの例は、テキストの要約やコードの生成などの比較的単純なタスクから、タンパク質の構造予測や情報検索などのより複雑な問題の記述まで様々です。長いテキストのシーケンスには、段落、表、画像などさまざまな形式の情報が含まれているため、LLMsはこれらの要素を処理し理解するためにトレーニングされなければなりません。さらに、長距離の構造的依存関係を効果的に考慮することで、LLMsはテキストの異なる部分間の関連性を特定し、最も関連性の高い情報を抽出することができます。したがって、より広範な知識に触れることで、LLMsはユーザーのクエリにより正確で文脈に即した回答を提供することができます。 しかし、数多くの潜在的なユースケースにもかかわらず、MetaのLLaMAからMosaicMLのMPT LLMモデルに至るまで、ほとんどのオープンソースのLLMsは、最大2Kトークンのシーケンスでトレーニングされています。この制限は、より長いシーケンスのモデリングにおいて大きな課題を提起します。さらに、モデルのスケーリングに関する以前の研究は、固定された計算予算が与えられた場合、トークン数が多いほど小さなモデルの方が大きなモデルよりも優れたパフォーマンスを発揮することを示しています。したがって、現在の進歩と課題に着想を受けて、Salesforce ResearchはXGen-7Bを導入し、1.5兆トークンの8Kシーケンス長でトレーニングされた一連の7B LLMsにおいて画期的な成果を上げました。このモデルシリーズには、4Kシーケンス長に対応するXGen-7B-4K-Base、8Kシーケンス長に対応するXGen-7B-8K-Base、および公開用の教育データでファインチューニングされたXGen-7B-8k-Instが含まれています(研究目的のみで公開されています)。これらのLLMsの注目すべき特徴は、XGenがMPT、Falcon、LLaMAなどといった同様のサイズの最先端のLLMsと比較して、標準のNLPベンチマークで同等または優れた結果を達成することです。 この研究で使用されたXGen-7bモデルは、Salesforceの独自のライブラリJaxFormerを使用してトレーニングされました。このライブラリは、TPU-v4ハードウェアに最適化されたデータとモデルの並列処理を利用した、効率的なLLMのトレーニングを可能にします。トレーニングプロセスはLLaMAのガイドラインに従い、さらに2つの追加の調査を行いました。最初の調査は「損失スパイク」の理解に焦点を当てました。これは、トレーニング中に損失が突然一時的に増加する現象であり、明確な原因がない状態です。これらのスパイクの原因はまだ不明ですが、研究者は「順次回路の並列化」、「swish-GLUの使用」、「RMS-Normの使用」などがトレーニングの不安定性に寄与する可能性があると特定しました。2つ目の調査はシーケンス長に関連しています。自己注意の二次の計算量のため、より長いシーケンスでのトレーニングは計算コストが著しく増加するため、段階的なトレーニングアプローチが採用されました。トレーニングは最初にシーケンス長2kの800Bトークンから始まり、次にシーケンス長4kの400Bトークン、最後にシーケンス長8kの300Bトークンを対象としました。 XGen-7b 8kモデルの長い文脈の理解能力を評価するために、研究者たちは3つの主要なタスクで評価を行いました。それらのタスクは、長い対話生成、テキストの要約、および質問応答です。研究者は、対象のタスクの難しさに基づいて、インストラクションに調整されたモデルを使用しました。長い対話生成に関しては、AMIミーティングの要約、ForeverDreaming、およびTVMegaSiteの脚本の要約の3つのタスクを評価に使用しました。すべての指標において、XGen-7B-instモデルは他のいくつかのインストラクションに調整されたモデルと比較して最高のスコアを達成し、優れたパフォーマンスを示しました。 長文の質問応答に関しては、研究者は物理学、工学、歴史、エンターテイメントなどさまざまなトピックをカバーするウィキペディアのドキュメントを基にChatGPTを使用して質問を生成しました。質問と元の文書の関連性、構成、および関連性に基づいて、256トークンのLLM生成された回答をGPT-4で評価しました。このシナリオでは、2kトークンに制限されたベースラインモデルに比べて、XGen-7B-8k-Instモデルのパフォーマンスが優れていることが示されました。テキストの要約に関しては、研究者は会議の会話と政府の報告書という2つの異なるドメインのデータセットを使用してXGen-7bモデルを評価しました。その結果、XGen-7bモデルはこれらのタスクで他のベースラインモデルを大幅に上回り、テキストの要約でも優れたパフォーマンスを発揮することが示されました。 評価により、XGen-7bモデルは、長い文脈を理解する能力に優れており、長い対話生成、質問応答、テキスト要約など、さまざまなタスクで優れた性能を発揮しました。その性能は、他の指示に調整されたモデルやベースラインモデルを上回り、広範なテキスト文脈での理解力と連続した応答生成能力を示しています。ただし、その効果的さにもかかわらず、XGenモデルには制約があることが研究者によって認識されており、バイアスが免除されず、有害な応答を生成する可能性があります。これは、他の多くのAIモデルと共有する特徴です。Salesforce Researchはまた、コードをオープンソース化して、コミュニティが研究内容を探求できるようにしています。 SF BlogとGithub Linkをチェックしてください。最新のAI研究ニュース、素晴らしいAIプロジェクトなどを共有している25k+ ML SubReddit、Discord Channel、Email Newsletterにもぜひ参加してください。上記の記事に関する質問や見落としがある場合は、お気軽に[email protected]までメールでお問い合わせください。

Pythonを使用したウェブサイトモニタリングによるリアルタイムインサイトの強化

イントロダクション このプロジェクトの目的は、複数のウェブサイトの変更をモニタリングし、追跡するプロセスを自動化するPythonプログラムを開発することです。Pythonを活用して、ウェブベースのコンテンツの変更を検出し、文書化する繊細な作業を効率化することを目指しています。リアルタイムのニュース追跡、即時の製品更新、競合分析を行うために、この能力は非常に貴重です。デジタルの世界が急速に変化する中で、ウェブサイトの変更を特定することは、持続的な認識と理解を保つために不可欠です。 学習目標 このプロジェクトの学習目標は、以下のコンポーネントをカバーすることです: BeautifulSoupやScrapyなどのPythonライブラリを使用したウェブスクレイピングの方法に関する知識を向上させる。効率的にウェブサイトから価値のあるデータを抽出し、HTMLの構造をナビゲートし、特定の要素を特定し、さまざまなコンテンツタイプを処理することを目指します。 ウェブサイトのコンテンツの微妙な変化を特定するスキルを向上させる。新しくスクレイピングされたデータを既存の参照と比較して、挿入、削除、または変更を検出するための技術を学ぶことを目指します。また、これらの比較中に遭遇するさまざまなデータ形式と構造を処理することも目指します。 ウェブサイトの更新を追跡するためにPythonの自動化機能を活用する。cronジョブやPythonのスケジューリングライブラリなどのスケジューリングメカニズムを使用して、データ収集を強化し、繰り返しのタスクを排除する予定です。 HTMLのアーキテクチャについて包括的な理解を開発する。HTMLドキュメントを効率的にナビゲートし、データ抽出中に重要な要素を特定し、ウェブサイトのレイアウトと構造の変更を効果的に管理することを目指します。 データ操作技術を探索することにより、テキスト処理のスキルを向上させる。抽出したデータをクリーンアップし、洗練させ、データエンコーディングの複雑さに対処し、洞察に基づいた分析と多目的なレポートのためにデータを操作する方法を学びます。 この記事は、データサイエンスのブログマラソンの一環として公開されました。 プロジェクトの説明 このプロジェクトでは、特定のウェブサイトの変更を監視し、カタログ化するためのPythonアプリケーションを作成することを目指しています。このアプリケーションには、以下の機能が組み込まれます: ウェブサイトのチェック:特定のコンテンツやセクションの更新を検出するために、割り当てられたウェブサイトを一貫して評価します。 データの取得:ウェブスクレイピングの方法を使用して、テキスト、グラフィック、または関連データなど、必要な詳細をウェブサイトから抽出します。 変更の特定:新しくスクレイピングされたデータを以前に保存されたデータと比較し、違いや変更箇所を特定します。 通知メカニズム:変更が検出された場合にユーザーをリアルタイムに通知するアラートメカニズムを実装します。 ログ記録:変更の詳細な記録を時間スタンプや変更の情報とともに保持します。このアプリケーションは、ユーザーの設定に基づいて、任意のウェブサイトと特定のコンテンツを監視するようにカスタマイズできます。期待される結果には、ウェブサイトの変更に関する直ちにアラートが含まれ、変更の性質とタイミングを理解するための包括的な変更記録が含まれます。 問題の定義 このプロジェクトの主な目的は、特定のウェブサイトの監視プロセスを効率化することです。Pythonアプリケーションを作成することで、興味のあるウェブサイトの変更を追跡し、カタログ化します。このツールは、ニュース記事、製品リスト、その他のウェブベースのコンテンツの最新の変更について、タイムリーな更新情報を提供します。この追跡プロセスを自動化することで、時間の節約とウェブサイトへの変更や追加に対する即時の認識が確保されます。 アプローチ このプロジェクトを成功裏に実装するために、以下の手順に従う高レベルのアプローチを取ります: プロジェクトでは、BeautifulSoupやScrapyなどの強力なPythonライブラリを使用します。これらのライブラリを使用すると、ウェブサイトから情報を収集し、HTMLコンテンツを取捨選択することが容易になります。 始めに、ウェブサイトから情報を取得してベースラインを作成します。このベンチマークデータは、後で変更を特定するのに役立ちます。 入力データを設定されたベンチマークと照合して、新しい追加や変更を追跡することができます。テキストの比較やHTML構造の違いの分析など、さまざまな技術を使用する場合があります。…

Spotifyで学んだ初心者データサイエンティストのための5つの重要なレッスン(パート2)

この記事は「データサイエンティストの新入生クロニクル」シリーズの第2部ですまずは第1部をチェックしてください!これによって、チームや利害関係者との信頼関係を築くのに役立ちます

Pythonを使用してTenacityを使用してリトライを制御する:エンドツーエンドのチュートリアル

Python Tenacityライブラリを発見し、Pythonアプリケーションで効果的な再試行ロジックとエラーハンドリングを実装する方法を学びましょうネットワークやAPIの障害、タイムアウト、およびさまざまな他の課題に対処するための実践的な例と業界で証明されたベストプラクティスを提供します

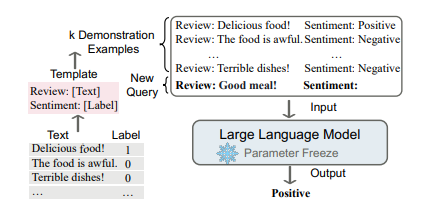

大規模な言語モデルにおけるコンテキストに基づく学習アプローチ

言語モデリング(LM)は、単語のシーケンスの生成的な尤度をモデル化することを目指し、将来の(または欠損している)トークンの確率を予測します言語モデルは自然言語処理の世界を革新しました...

AIが置き換えることができない仕事

はじめに サイバーノートであろうとそうでなかろうと、おそらく「AIが置き換えることのできない仕事」の議論を聞いたことがあるでしょう。2025年までに、世界中で約8500万の仕事が自動化によって廃れるリスクに直面しています。人工知能は毎回新たな発明を行っており、それが大規模に展開されれば、ほとんどの人間の仕事をこなすことができる可能性があります。過去にはChatGPTというものが登場し、作家やコンテンツマーケターを驚かせました。スポーツ業界では、食事計画の自動化や選手の怪我予防などにAIが活用されています。カスタマーサービスでは、既にチャットボットを導入する環境が整っています。この状況から考えると、本当にAIに置き換えられない仕事が存在するのかと思われます。 しかし、上記で議論した内容を考慮すると、作家や栄養士、カスタマーサービスエージェントが別の職業に転職する必要があるのでしょうか?この記事の最後まで読み進めると、自分自身で判断することができます。さて、AIに置き換えることができない仕事について話しましょう。 しかし、その前に、私たちはあなたに素晴らしい機会を提供したいと思います。データサイエンスやAIに熱中しているすべての方々に、2023年の高い期待を寄せたDataHack Summitに参加していただきたいと思います。8月2日から5日まで、バンガロールの名門NIMHANSコンベンションセンターでイベントが開催されます。このイベントでは、実践的な学び、貴重な業界の洞察、そして非競争力のあるネットワーキングの機会が満載です。ぜひDataHack Summit 2023をチェックしてください! AIの仕事市場への影響 出典:Built In 仕事市場におけるAIによる変化は、多くのトレンドや話題の中心となっています。この技術は特定のタスクを自動化し、産業を変革する可能性を持っていますが、雇用に対して複雑な全体的な影響を与え、AIはいくつかの仕事を置き換えることはできません。しかし、そこに進む前に、世界の注目を浴びている出来事をすべてご紹介しましょう。 自動化が仕事を置き換えています AIに関する懸念の一つは、自動化が以前は人間が行っていた特定のタスクを置き換える可能性です。研究によると、AIによって2030年までに約4億から8億人が仕事を失い、別の職業に転職する可能性があります。ロボット工学や機械学習などのAI技術は、さまざまなセクターでルーチンや繰り返しのタスクを自動化することができ、一部の仕事の需要が減少することをもたらす可能性があります。製造業、カスタマーサービス、交通、データ入力などの産業は、自動化による仕事の置き換えの影響を最も受けやすい産業の一部です。 新しい役割が生まれています 出典:The Enterprise Project AIは一部の仕事をなくすかもしれませんが、新しい仕事の機会を生み出し、既存の役割を補完する可能性もあります。AI技術が進化するにつれて、AIシステムを開発、実装、維持するための新しい役割が出現します。さらに、データ分析、機械学習、AI倫理、アルゴリズム設計などの分野に精通した専門家への需要が高まるでしょう。組織はAIシステムを監督し、倫理的な考慮事項を確保し、AIの洞察に基づいた戦略的な意思決定を行う人材を必要とするでしょう。 スキルの開発と同様にスキルの向上も重要です 人工知能の広範な採用は、仕事市場で求められるスキルの変化をもたらす可能性があります。一部の低スキルで繰り返しのタスクは自動化される可能性があり、AI技術と補完するスキルに重点が置かれることになるでしょう。これには、批判的思考、創造性、問題解決能力、適応力、感情知性、複雑な意思決定などのスキルが含まれます。スキル向上の取り組みは、変化する仕事市場に適応するために必要な能力を獲得するために重要となるでしょう。 社会経済的な考慮事項が注目されています AIが求人市場に与える影響は、より広範な社会経済的な意味を持っています。AIの恩恵が公平に分配されない場合、所得格差に寄与する可能性があります。教育や資源へのアクセスが制限されている特定のコミュニティや個人は、変化する求人市場に適応する際に困難を抱えるかもしれません。スキルのギャップに対処し、終身学習を支援し、包括的なAI技術へのアクセスを促進する政策や取り組みは、潜在的な不平等を緩和するのに役立ちます。 AIが置き換えられない仕事の概要 出典:Analytics…

科学ソフトウェアの開発

この記事では、このシリーズの最初の記事で示されたように、科学ソフトウェアの開発においてTDDの原則に従って、Sobelフィルタとして知られるエッジ検出フィルタを開発します

SDFStudio(エスディーエフスタジオ)は、Nerfstudioプロジェクトの上に構築された、ニューラル暗黙的表面再構築のための統一されたモジュラーフレームワークです

ここ数年、特に表面再構築において、いくつかのコンピュータビジョンおよびコンピュータグラフィックス関連分野で急速な進歩がありました。 3Dスキャンにおけるこの変化し続ける分野の主な目標は、特定の品質基準を満たしながら、与えられた点群から効率的に表面を再現することです。 これらのアルゴリズムは、与えられた点群データに基づいて、スキャンされたオブジェクトの表面の基礎的なジオメトリを推定することを目指しています。 その表面は、可視化、バーチャルリアリティ、コンピュータ支援設計、医療画像など、さまざまな目的に活用することができます。 表面再構築の最もよく知られた手法には、自己組織化マップ、ベイジアン再構築、ポアソン再構築などがあります。 表面再構築は3Dスキャンの重要な要素であるため、非教師あり機械学習を使用した3Dスキャンからの表面再構築のためのさまざまな適切な技術を開発するために、大規模な研究が進行しています。 この方向性を踏まえて、チュービンゲン大学、ETHチューリッヒ、チェコ工科大学プラハの多様な研究者グループが協力して、SDFStudioという統一された多機能ツールを開発しました。 このフレームワークは、主にニューラルラジアンスフィールド(NeRF)の作成、トレーニング、視覚化プロセスを効率化するAPIを提供するnerfstudioプロジェクトの上に構築されています。 実装の一環として、開発者は3つの主要な表面再構築手法を使用しています:UniSurf、VolSDF、およびNeuS。 UniSurfは、非組織化点群から滑らかな表面表現を生成することを目指す表面再構築手法であり、暗黙的な関数と多角形メッシュを組み合わせています。 一方、VolSDFは、入力点群のボリューメトリック表現を活用する表面再構築手法です。 NeuSは、深層ニューラルネットワークを利用して、点群から表面表現を生成する表面再構築手法であり、暗黙的な表面表現と学習ベースの手法の両方の特性を組み合わせています。 さまざまなシーン表現と表面再構築技術をサポートするために、SDFStudioはキーとなる表現として符号付き距離関数(SDF)を使用しており、この関数の等値面を表面と定義しています。 SDFStudioは、マルチレイヤーパーセプトロン(MLP)、トライプレーン、およびマルチレス機能グリッドなど、さまざまな技術を使用してSDFを推定します。 これらの技術は、シーン内の異なる場所で符号付き距離または占有値を推定するために、ニューラルネットワークと特徴グリッドを利用しています。 精度と効率をさらに向上させるために、このツールはさまざまなポイントサンプリング戦略を組み込んでおり、その一つがUniSurfの方法に着想を得たサーフェスガイドサンプリングです。 さらに、SDFStudioはNeuralReconWの手法から派生したボクセルサーフェスガイドサンプリングも使用しています。 この手法は、ボクセルグリッドの情報を活用してサンプリングプロセスを誘導し、生成されるポイントがオブジェクトの表面上にある可能性が高くなるようにします。 このようなサンプリング技術を取り入れることで、SDFStudioは生成されるポイントサンプルが基礎となる表面を代表するものであり、再構築された表面の品質と精度が向上することを保証します。 SDFStudioの特筆すべき特徴の一つは、異なる手法間でのアイデアや技術の移植を容易にする統一されたモジュラーな実装を提供していることです。 たとえば、Mono-NeuSからNeuSへのアイデアの移植が見られます。 Geo-VolSDFでは、Geo-NeuSからのアイデアをVolSDFに組み込んでいます。 SDFStudioで異なる手法間でアイデアを移植できる能力は、研究者が異なる組み合わせを試し、あるプロセスからインスピレーションを得て別のプロセスに統合することで、表面再構築の進歩を促進します。 SDFStudioをすばやく始めるには、GitHubリポジトリで利用可能なセットアップ手順に従ってください。

製造品の品質におけるコンピュータビジョンの欠陥検出を、Amazon SageMaker Canvasを使用したノーコード機械学習で民主化する

品質の低下によるコストは、製造業者にとっての最重要課題です品質の欠陥は、廃棄物や再作業のコストを増加させ、スループットを減少させ、顧客と企業の評判に影響を与える可能性があります生産ラインでの品質検査は、品質基準を維持するために重要です多くの場合、品質と欠陥の検出のために人間の視覚検査が使用されますが、これは...

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.