Learn more about Search Results 2022年 - Page 34

- You may be interested

- このAI論文は、ChatGPTを基にしたテキスト...

- ギアに乗り込んでください:「Forza Motor...

- A12研究者は、人工衛星画像から生成された...

- チャーン予測とチャーンアップリフトを超えて

- VoAGIニュース、6月14日:あなたの無料の...

- 「企業が職場のAIを求める中、テック企業...

- 「オンプレミスからクラウドへデータを移...

- Map Imagesからデータを抽出するためにGPT...

- 新しいAI研究が「SWIM-IR」をリリース!28...

- 分析における人工知能

- Gradioを使用して、Spacesで自分のプロジ...

- プロンプトエンジニアリング:検索強化生...

- 『チュートリアルを超えて LangChainのPan...

- AIがセキュリティを向上させる方法

- 「GROOTに会おう:オブジェクト中心の3D先...

米国AI国家研究リソース暫定報告書に関するコメント

2022年6月下旬、Hugging Faceは、米国大統領府科学技術政策局と国立科学財団の「国家人工知能研究リソース(NAIRR)タスクフォースの中間報告結果を実装するためのロードマップ」に関する情報提供依頼に回答しました。私たちは、機械学習を民主化し、あらゆるバックグラウンドがAIに貢献できるようにすることを目指すプラットフォームとして、NAIRRの取り組みを強く支持しています。 私たちの回答では、タスクフォースに以下の点を提案しています: 技術的および倫理的な専門家をアドバイザーとして指名すること 倫理的なイノベーションの実績を持つ技術的専門家をアドバイザーとして優先的に指名するべきです。彼らはNAIRRが技術的に実現可能で実施可能であり、AIシステムに必要なだけでなく、有害なバイアスや他の悪意のあるAIシステムの使用を悪化させない方法について調整することができます。Margaret Mitchell博士は、AI分野で最も優れた技術的専門家および倫理の実践者の一人であり、Hugging FaceのChief Ethics Scientistです。 リソース(モデルおよびデータ)のドキュメンテーション基準 NAIRRが提供するシステムおよびデータセットのドキュメンテーションの基準とテンプレートは、アクセシビリティを向上させ、チェックリストとして機能します。この標準化により、さまざまな対象者やバックグラウンド間での読みやすさが確保されるべきです。モデルカードは、AIモデルのドキュメンテーションのための広く採用されている構造であり、強力なテンプレートとなる可能性があります。 異分野の非技術的な専門家に対して機械学習を利用可能にすること NAIRRは、AIモデルのトレーニングなどの複雑なタスクを実行するための教育リソース、理解しやすいインターフェース、低コードまたはノーコードのツールを提供するべきです。例えば、Hugging FaceのAutoTrainは、技術的なスキルに関係なく、自然言語処理(NLP)モデルのトレーニング、評価、展開を行うことができるようにします。 悪用および悪意のある使用の可能性のあるオープンソースおよびオープンサイエンスの監視 NAIRRとアドバイザーによって被害が定義され、継続的に更新されるべきですが、それは顕著な有害なバイアス、政治的なディスインフォメーション、ヘイトスピーチを含むべきです。NAIRRはまた、リソースの誤用が発生した場合に対策を講じるために法的な専門知識に投資するべきです。 多様な研究者の視点をアクセス可能なツールとリソースによって強化すること ツールとリソースは、異なる学問分野だけでなく、責任あるイノベーションを推進するために必要な多言語と多様な視点に対して利用可能でアクセス可能でなければなりません。これは、少なくとも最も話されている言語に基づいて複数の言語でのリソース提供を意味します。Hugging Faceとフランス政府が主催する異なる学問分野からの1000人以上の研究者からなるコミュニティであるBigScience Research Workshopは、最も強力なオープンソースの多言語言語モデルの構築のために60以上の国からの視点を取り入れる良い例です。 私たちのメモは、各提案についてさらに詳細に説明しています。私たちは、責任ある方法でAIを幅広く利用できるように、さらなるリソースに熱心に取り組んでいます。

SetFit プロンプトなしで効率的なフューショット学習

SetFitは、通常のファインチューニングよりもサンプル効率が高く、ノイズに強いです。 事前学習済みの言語モデルを用いたフューショット学習は、データサイエンティストの悪夢であるほとんどラベルのないデータを扱うための有望な解決策として浮上しています 😱。 Intel LabsとUKP Labとの共同研究を通じて、Hugging FaceはSetFitを紹介できることを嬉しく思っています。SetFitは、Sentence Transformersのフューショットファインチューニングの効率的なフレームワークです。SetFitは少量のラベル付きデータで高い精度を達成します – 例えば、顧客レビュー(CR)感情データセットでクラスごとにわずか8つのラベル付きの例を使用すると、SetFitはフルトレーニングセットの3,000の例でRoBERTa Largeのファインチューニングと競争力を持ちます 🤯! 他のフューショット学習手法と比較して、SetFitにはいくつかの特徴があります: 🗣 プロンプトや口述者不要:フューショットファインチューニングの現在の技術は、例を基に言語モデルに適した形式に変換するための手作りのプロンプトや口述者が必要です。SetFitはプロンプトを一切必要とせず、わずかな数のラベル付きテキスト例から直接豊かな埋め込みを生成します。 🏎 高速トレーニング:SetFitは、高い精度を実現するためにT0やGPT-3のような大規模なモデルを必要としません。そのため、トレーニングと推論の速度は通常1桁以上速くなります。 🌎 多言語対応:SetFitはHubの任意のSentence Transformerと組み合わせて使用できるため、マルチリンガルなチェックポイントをファインチューニングするだけで、複数の言語でテキストを分類することができます。 詳細については、私たちの論文、データ、コードをご覧ください。このブログ投稿では、SetFitの動作方法と独自のモデルをトレーニングする方法について説明します。さあ、始めましょう! どのように動作するのか? SetFitは効率とシンプルさを考慮して設計されています。SetFitはまず、少数のラベル付き例(通常はクラスごとに8または16個)でSentence Transformerモデルをファインチューニングします。次に、ファインチューニングされたSentence…

マルチリンガルASRのためのWhisperの調整を行います with 🤗 Transformers

このブログでは、ハギングフェイス🤗トランスフォーマーを使用して、Whisperを任意の多言語ASRデータセットに対して細かく調整する手順を段階的に説明します。このブログでは、Whisperモデル、Common Voiceデータセット、および細かな調整の背後にある理論について詳しく説明し、データの準備と細かい調整の手順を実行するためのコードセルと共に提供しています。説明は少ないですが、すべてのコードがあるより簡略化されたバージョンのノートブックは、関連するGoogle Colabを参照してください。 目次 はじめに Google ColabでのWhisperの細かい調整 環境の準備 データセットの読み込み 特徴抽出器、トークナイザー、およびデータの準備 トレーニングと評価 デモの作成 締めくくり はじめに Whisperは、OpenAIのAlec Radfordらによって2022年9月に発表された自動音声認識(ASR)のための事前学習モデルです。Whisperは、Wav2Vec 2.0などの先行研究とは異なり、ラベル付きの音声トランスクリプションデータで事前学習されています。具体的には、680,000時間のデータが使用されています。これは、Wav2Vec 2.0の訓練に使用されるラベルなしの音声データ(60,000時間)よりも桁違いに多いデータです。さらに、この事前学習データのうち117,000時間が多言語ASRデータです。これにより、96以上の言語に適用できるチェックポイントが生成され、その多くは低リソース言語とされています。 このような大量のラベル付きデータにより、Whisperは事前学習データから音声認識の教師ありタスクを直接学習し、音声トランスクリプションデータからテキストへのマッピングを学習します。そのため、Whisperはパフォーマンスの高いASRモデルを得るためにほとんど追加の細かい調整を必要としません。これに対して、Wav2Vec 2.0は非教師付きタスクのマスク予測で事前学習されており、音声から隠れた状態への中間的なマッピングを学習します。非教師付きの事前学習は音声の高品質な表現を生み出しますが、音声からテキストへのマッピングは学習されません。このマッピングは細かい調整中にのみ学習されるため、競争力のあるパフォーマンスを得るにはより多くの細かい調整が必要です。 680,000時間のラベル付き事前学習データにスケールされると、Whisperモデルは多くのデータセットとドメインに対して高い汎化能力を示します。事前学習されたチェックポイントは、LibriSpeech ASRのtest-cleanサブセットで約3%の単語エラーレート(WER)を達成し、TED-LIUMでは4.7%のWERで新たな最先端の結果を実現します(Whisper論文の表8を参照)。Whisperが事前学習中に獲得した多言語ASRの知識は、他の低リソース言語に活用することができます。細かい調整により、事前学習済みのチェックポイントを特定のデータセットと言語に適応させることで、これらの結果をさらに改善することができます。 Whisperは、Transformerベースのエンコーダーデコーダーモデルであり、シーケンスからシーケンスへのモデルとも呼ばれています。Whisperは、オーディオのスペクトログラム特徴のシーケンスをテキストトークンのシーケンスにマッピングします。まず、生のオーディオ入力は特徴抽出器によってログメルスペクトログラムに変換されます。次に、Transformerエンコーダーはスペクトログラムをエンコードしてエンコーダーの隠れ状態のシーケンスを形成します。最後に、デコーダーはエンコーダーの隠れ状態と以前に予測されたトークンの両方に依存して、テキストトークンを自己回帰的に予測します。図1はWhisperモデルを要約しています。 <img…

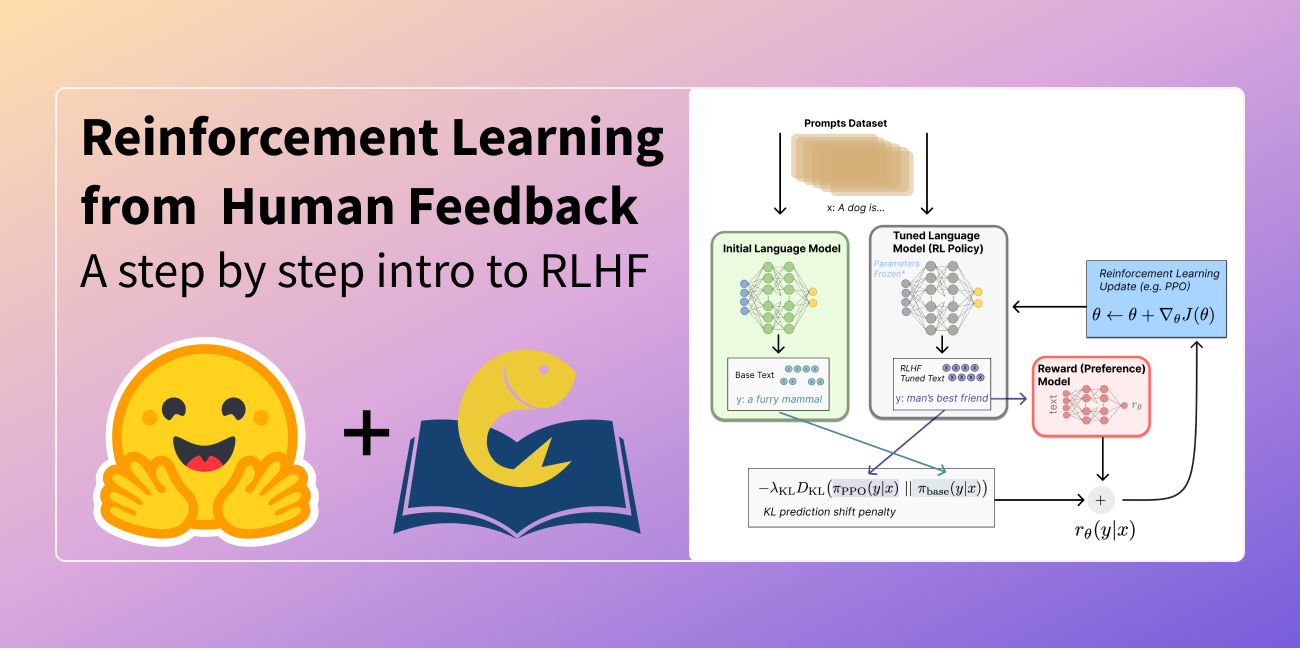

人間のフィードバックからの強化学習(RLHF)の説明

この記事は以下の言語に翻訳されています:中国語(簡体字)とベトナム語。他の言語に翻訳に興味がありますか?nathan at huggingface.co までお問い合わせください。 言語モデルは、過去数年間に人間の入力プロンプトから多様で魅力的なテキストを生成する能力を示してきました。しかし、「良い」テキストとは何かは、主観的で文脈に依存するため、本質的に定義するのは難しいです。創造性を求める物語の執筆などの多くのアプリケーションでは、真実であるべき情報の断片、または実行可能なコードのスニペットなどが必要です。 これらの属性を捉えるための損失関数を作成することは困難であり、ほとんどの言語モデルはまだ単純な次のトークン予測の損失(例:クロスエントロピー)で訓練されています。損失自体の欠点を補うために、人々はBLEUやROUGEなど、人間の優先順位をより適切に捉えるように設計されたメトリクスを定義しています。これらのメトリクスは、パフォーマンスを測定する上で損失関数自体より適しているものの、生成されたテキストを単純なルールで参照テキストと比較するだけなので、制約もあります。生成されたテキストに対する人間のフィードバックをパフォーマンスの指標として使用するか、さらに進んでそのフィードバックを損失としてモデルを最適化することができれば、素晴らしいことではないでしょうか?それが「人間のフィードバックによる強化学習(RLHF)」のアイデアです。強化学習の手法を使用して、言語モデルを人間のフィードバックで直接最適化するのです。RLHFにより、言語モデルは一般的なテキストデータのコーパスで訓練されたモデルを複雑な人間の価値に合わせることができるようになりました。 RLHFの最近の成功例は、ChatGPTでの使用です。ChatGPTの印象的な能力を考慮して、RLHFについて説明してもらいました: それは驚くほどうまくいっていますが、すべてをカバーしているわけではありません。それらのギャップを埋めましょう! 人間のフィードバックによる強化学習(RL from human preferencesとも呼ばれます)は、複数のモデルのトレーニングプロセスと異なる展開の段階を伴うため、難しい概念です。このブログ記事では、トレーニングプロセスを次の3つの主要なステップに分解します: 言語モデル(LM)の事前トレーニング データの収集と報酬モデルのトレーニング 強化学習によるLMの微調整 まず、言語モデルの事前トレーニングについて見ていきましょう。 言語モデルの事前トレーニング RLHFの出発点として、クラシカルな事前トレーニング目標で既に事前トレーニングされた言語モデルを使用します(詳細については、このブログ記事を参照してください)。OpenAIは、最初の人気のあるRLHFモデルであるInstructGPTに対して、より小さなバージョンのGPT-3を使用しました。Anthropicは、このタスクのためにトレーニングされた1,000万から520億のパラメータを持つトランスフォーマーモデルを使用しました。DeepMindは、2800億のパラメータモデルGopherを使用しました。 この初期モデルは、追加のテキストや条件で微調整することもできますが、必ずしも必要ではありません。たとえば、OpenAIは「好ましい」とされる人間が生成したテキストを微調整し、Anthropicは彼らの「助けになり、正直で無害な」基準に基づいて元のLMを蒸留することで、RLHFのための初期LMを生成しました。これらは共に、私が高価な増強データと呼ぶものの一部ですが、RLHFを理解するために必要なテクニックではありません。 一般的に、「どのモデル」がRLHFの出発点として最適かは明確な答えがありません。このブログ記事では、RLHFのトレーニングにおけるオプションの設計空間が完全に探索されていないという共通のテーマになります。 次に、言語モデルが必要なデータを生成して、人間の優先順位がシステムに統合される「報酬モデル」をトレーニングする必要があります。 報酬モデルのトレーニング 人間の優先順位に合わせてキャリブレーションされた報酬モデル(RM、優先モデルとも呼ばれます)を生成することは、RLHFの比較的新しい研究の出発点です。その基本的な目標は、テキストのシーケンスを受け取り、数値で人間の優先順位を表すべきスカラー報酬を返すモデルまたはシステムを取得することです。システムはエンドツーエンドのLMであるか、報酬を出力するモジュラーシステム(例:モデルが出力をランク付けし、ランキングが報酬に変換される)である場合があります。出力がスカラーの報酬であることは、既存のRLアルゴリズムが後のRLHFプロセスにシームレスに統合されるために重要です。 報酬モデリングのためのこれらの言語モデルは、別の微調整された言語モデルまたは好みのデータでスクラッチからトレーニングされた言語モデルのいずれかです。例えば、Anthropicは、これらのモデルを事前トレーニング(好みモデルの事前トレーニング、PMP)の後に初期化するために専門の微調整方法を使用しています。彼らは、これが微調整よりもサンプル効率が高いと結論付けましたが、報酬モデリングのバリエーションの中で明確な最良の選択肢はありません。…

グラフ機械学習の概要

このブログ投稿では、グラフ機械学習の基礎をカバーします。 まず、グラフの定義、使用目的、および最良の表現方法について学びます。次に、人々がグラフ上で学習する方法について簡単に説明し、ニューラルメソッド(グラフの特徴を同時に探索する)から一般的にグラフニューラルネットワークと呼ばれるものまでをカバーします。最後に、グラフのためのトランスフォーマーの世界を垣間見ます。 グラフ グラフとは何ですか? 基本的に、グラフは関係でリンクされたアイテムの記述です。 グラフの例には、ソーシャルネットワーク(Twitter、Mastodon、論文と著者をリンクする引用ネットワークなど)、分子、知識グラフ(UML図、百科事典、ページ間のハイパーリンクを持つウェブサイトなど)、文を構文木として表現したもの、3Dメッシュなどがあります。したがって、グラフはどこにでも存在すると言っても過言ではありません。 グラフのアイテム(またはネットワーク)をノード(または頂点)と呼び、それらの接続をエッジ(またはリンク)と呼びます。たとえば、ソーシャルネットワークでは、ノードはユーザーであり、エッジはその接続です。分子では、ノードは原子であり、エッジは分子結合です。 ノードまたはエッジに型が付いたグラフは異種と呼ばれます(例:論文または著者のいずれかとなるアイテムを持つ引用ネットワークには型付きノードがあり、関係に型が付いたXMLダイアグラムには型付きエッジがあります)。これは単にトポロジだけで表現することはできず、追加の情報が必要です。この投稿では同種のグラフに焦点を当てています。 グラフはまた、有向(フォローネットワークのように、AがBをフォローしていることがBがAをフォローしていることを意味しない)または無向(分子のように、原子間の関係が両方の方向に進む)になります。エッジは異なるノードを接続することも、ノード自体に接続することもできますが、すべてのノードが接続される必要はありません。 データを使用する場合、最初に最適な特性(同種/異種、有向/無向など)を考慮する必要があります。 グラフはどのように使用されますか? グラフで行う可能性のあるタスクの一覧を見てみましょう。 グラフレベルでは、主なタスクは次のとおりです: グラフ生成:新しい可能性のある分子を生成するために薬剤探索で使用されます グラフの進化(与えられたグラフが時間とともにどのように進化するかを予測する):物理学でシステムの進化を予測するために使用されます グラフレベルの予測(グラフからのカテゴリ化または回帰タスク):分子の毒性を予測するなど ノードレベルでは、通常はノードの特性予測が行われます。たとえば、Alphafoldは、分子の全体的なグラフからノードの特性予測を使用して原子の3D座標を予測し、分子が3D空間でどのように折りたたまれるかを予測します。これは難しい生化学の問題です。 エッジレベルでは、エッジの特性予測または欠損エッジの予測が行われます。エッジの特性予測は、薬物の副作用予測に使用され、一対の薬物に対して副作用を予測します。欠損エッジの予測は、推薦システムで使用され、グラフ内の2つのノードが関連しているかどうかを予測します。 サブグラフレベルでは、コミュニティの検出やサブグラフの特性予測などが行われます。ソーシャルネットワークでは、コミュニティの検出を使用して人々がどのように接続されているかを判断します。サブグラフの特性予測は、旅程システム(Googleマップなど)で推定到着時間を予測するために使用されます。 これらのタスクに取り組む方法は2つあります。 特定のグラフの進化を予測する場合、すべて(トレーニング、検証、テスト)を同じ単一のグラフ上で行う転移学習の設定で作業します。この場合、単一のグラフからトレーニング/評価/テストデータセットを作成することは容易ではありませんので注意してください。ただし、異なるグラフ(別々のトレーニング/評価/テストデータセット)を使用して作業することもあります。これは帰納的な設定と呼ばれます。 グラフはどのように表現されますか? グラフを処理および操作するための一般的な方法は次のいずれかです: すべてのエッジの集合として表現する(すべてのノードの集合と補完される場合もあります)…

Hugging Face Hubへようこそ、PaddlePaddleさん

私たちは、オープンソースのコラボレーションをHugging FaceとPaddlePaddleの間で共有し、オープンソースを通じてAIの進歩と民主化を推進する共通の使命を喜んで共有します! 2016年にBaiduによって最初にオープンソース化されたPaddlePaddleは、スキルレベルに関係なく、開発者がディープラーニングをスケールで採用および実装できるようにします。2022年第4四半期現在、PaddlePaddleは500万人以上の開発者と20万社以上の企業によって使用されており、中国のディープラーニングプラットフォームの中で市場シェア第1位です。PaddlePaddleには、Paddle Deep Learning Framework、さまざまなモダリティのモデルライブラリ(例:PaddleOCR、PaddleDetection、PaddleNLP、PaddleSpeech)、モデル圧縮のためのPaddleSlim、モデル展開のためのFastDeployなど、人気のあるオープンソースのリポジトリがあります。 PaddleNLPが先導する中、PaddlePaddleはHugging Face Hubとそのライブラリを徐々に統合していく予定です。近々、テキスト、画像、音声、ビデオ、マルチモダリティの豪華な事前学習済みPaddlePaddleモデルのフルスイートをHubでお楽しみいただけるようになります! PaddlePaddleモデルの検索 PaddlePaddleモデルは、PaddlePaddleライブラリタグでフィルタリングすることで、モデルハブで見つけることができます。 既にハブには75以上のPaddlePaddleモデルがあります。例えば、マルチタスク情報抽出モデルシリーズUIE、最先端の中国語言語モデルERNIE 3.0モデルシリーズ、全ワークフローにおけるレイアウト知識強化のための革新的なドキュメントプレトレーニングモデルErnie-Layoutなどがあります。 HuggingFace HubのPaddlePaddle orgもぜひご覧ください。上記のモデルに加えて、テキストからイメージへの変換Ernie-ViLG、クロスモーダル情報抽出エンジンUIE-X、素晴らしいマルチリンガルOCRツールキットPaddleOCRなど、さまざまなスペースを探索することもできます。 推論APIとウィジェット PaddlePaddleモデルは、HTTPを介してcURL、Pythonのrequestsライブラリ、またはネットワークリクエストを行うためのご希望の方法でアクセスできる推論APIを通じて利用できます。 タスクをサポートするモデルには、ブラウザで直接モデルを操作できるインタラクティブなウィジェットが備わっています。 既存のモデルの使用 特定のモデルを読み込む方法を確認したい場合は、Use in paddlenlp(または将来の他のPaddlePaddleライブラリ)をクリックすると、それを読み込むための動作するスニペットが表示されます! モデルの共有…

⚔️AI vs. AI⚔️は、深層強化学習マルチエージェント競技システムを紹介します

私たちは新しいツールを紹介するのを楽しみにしています: ⚔️ AI vs. AI ⚔️、深層強化学習マルチエージェント競技システム。 このツールはSpacesでホストされており、マルチエージェント競技を作成することができます。以下の3つの要素で構成されています: マッチメイキングアルゴリズムを使用してモデルの戦いをバックグラウンドタスクで実行するスペース。 結果を含むデータセット。 マッチ履歴の結果を取得し、モデルのELOを表示するリーダーボード。 ユーザーが訓練済みモデルをHubにアップロードすると、他のモデルと評価およびランキング付けされます。これにより、マルチエージェント環境で他のエージェントとの評価が可能です。 マルチエージェント競技をホストする有用なツールであるだけでなく、このツールはマルチエージェント環境での堅牢な評価技術でもあると考えています。多くのポリシーと対戦することで、エージェントは幅広い振る舞いに対して評価されます。これにより、ポリシーの品質を良く把握することができます。 最初の競技ホストであるSoccerTwos Challengeでどのように機能するか見てみましょう。 AI vs. AIはどのように機能しますか? AI vs. AIは、Hugging Faceで開発されたオープンソースのツールで、マルチエージェント環境での強化学習モデルの強さをランク付けするためのものです。 アイデアは、モデルを継続的に互いに対戦させ、その結果を使用して他のすべてのモデルと比較してパフォーマンスを評価し、ポリシーの品質を把握するための相対的なスキルの尺度を得ることです。従来のメトリクスを必要とせずに。 エージェントが特定のタスクや環境に提出される数が増えるほど、ランキングはより代表的になります。 競争環境での試合結果に基づいて評価を生成するために、私たちはELOレーティングシステムを基にランキングを作成することにしました。…

テキストからビデオへのモデルの深掘り

ModelScopeで生成されたビデオサンプルです。 テキストからビデオへの変換は、生成モデルの驚くべき進歩の長いリストの中で次に来るものです。その名前の通り、テキストからビデオへの変換は、時間的にも空間的にも一貫性のある画像のシーケンスをテキストの説明から生成する、比較的新しいコンピュータビジョンのタスクです。このタスクは、テキストから画像への変換と非常によく似ているように思えるかもしれませんが、実際にははるかに難しいものです。これらのモデルはどのように動作し、テキストから画像のモデルとはどのように異なり、どのようなパフォーマンスが期待できるのでしょうか? このブログ記事では、テキストからビデオモデルの過去、現在、そして未来について論じます。まず、テキストからビデオとテキストから画像のタスクの違いを見直し、条件付きと非条件付きのビデオ生成の独特の課題について話し合います。さらに、テキストからビデオモデルの最新の開発について取り上げ、これらの方法がどのように機能し、どのような能力があるのかを探ります。最後に、Hugging Faceで取り組んでいるこれらのモデルの統合と使用を容易にするための取り組みや、Hugging Face Hub内外でのクールなデモやリソースについて話します。 さまざまなテキストの説明を入力として生成されたビデオの例、Make-a-Videoより。 テキストからビデオ対テキストから画像 最近の開発が非常に多岐にわたるため、テキストから画像の生成モデルの現在の状況を把握することは困難かもしれません。まずは簡単に振り返りましょう。 わずか2年前、最初のオープンボキャブラリ、高品質なテキストから画像の生成モデルが登場しました。VQGAN-CLIP、XMC-GAN、GauGAN2などの最初のテキストから画像のモデルは、すべてGANアーキテクチャを採用していました。これらに続いて、2021年初めにOpenAIの非常に人気のあるトランスフォーマーベースのDALL-E、2022年4月のDALL-E 2、Stable DiffusionとImagenによって牽引された新しい拡散モデルの新たな波が続きました。Stable Diffusionの大成功により、DreamStudioやRunwayML GEN-1などの多くの製品化された拡散モデルや、Midjourneyなどの既存製品との統合が実現しました。 テキストから画像生成における拡散モデルの印象的な機能にもかかわらず、拡散および非拡散ベースのテキストからビデオモデルは、生成能力においてはるかに制約があります。テキストからビデオは通常、非常に短いクリップで訓練されるため、長いビデオを生成するためには計算コストの高いスライディングウィンドウアプローチが必要です。そのため、これらのモデルは展開とスケーリングが困難であり、文脈と長さに制約があります。 テキストからビデオのタスクは、さまざまな面で独自の課題に直面しています。これらの主な課題のいくつかには以下があります: 計算上の課題:フレーム間の空間的および時間的な一貫性を確保することは、長期的な依存関係を伴い、高い計算コストを伴います。そのため、このようなモデルを訓練することは、ほとんどの研究者にとって手の届かないものです。 高品質なデータセットの不足:テキストからビデオの生成のためのマルチモーダルなデータセットは希少で、しばしばスパースに注釈が付けられているため、複雑な動きのセマンティクスを学ぶのが難しいです。 ビデオのキャプションに関する曖昧さ:モデルが学習しやすいようにビデオを記述する方法は未解決の問題です。完全なビデオの説明を提供するためには、複数の短いテキストプロンプトが必要です。生成されたビデオは、時間の経過に沿って何が起こるかを物語る一連のプロンプトやストーリーに基づいて条件付ける必要があります。 次のセクションでは、テキストからビデオへの進展のタイムラインと、これらの課題に対処するために提案されたさまざまな手法について別々に議論します。高レベルでは、テキストからビデオの作業では以下のいずれかを提案しています: 学習しやすいより高品質なデータセットの作成。 テキストとビデオのペアデータなしでこのようなモデルを訓練する方法。 より計算効率の良い方法で長く、高解像度のビデオを生成する方法。 テキストからビデオを生成する方法…

DuckDB Hugging Face Hubに保存されている50,000以上のデータセットを分析する

Hugging Face Hubは、誰にでもデータセットへのオープンアクセスを提供し、ユーザーがそれらを探索し理解するためのツールを提供することに特化しています。Falcon、Dolly、MPT、およびStarCoderなどの人気のある大規模言語モデル(LLM)のトレーニングに使用されるデータセットの多くを見つけることができます。不公平性や偏見を解決するためのDisaggregatorsのようなデータセット用のツールや、データセット内の例をプレビューするためのDataset Viewerなどのツールもあります。 Dataset Viewerを使用してOpenAssistantデータセットのプレビューを表示します。 私たちは、Hub上のデータセットを分析するための別の機能を最近追加しました。Hubに保存されている任意のデータセットでDuckDBを使用してSQLクエリを実行できます!2022年のStackOverflow Developer Surveyによると、SQLは3番目に人気のあるプログラミング言語です。また、分析クエリを実行するために設計された高速なデータベース管理システム(DBMS)が必要でしたので、DuckDBとの統合に興奮しています。これにより、より多くのユーザーがHub上のデータセットにアクセスし、分析することができると思います! 要約 Datasets Serverは、Hub上のすべての公開データセットをParquetファイルに自動変換します。データセットページの上部にある「Auto-converted to Parquet」ボタンをクリックすることで、それらのファイルを表示することができます。また、単純なHTTP呼び出しでParquetファイルのURLリストにアクセスすることもできます。 r = requests.get("https://datasets-server.huggingface.co/parquet?dataset=blog_authorship_corpus") j = r.json() urls = [f['url'] for…

倫理と社会ニュースレター#4:テキストから画像へのモデルにおけるバイアス

要約: テキストから画像へのモデルのバイアスを評価するためにより良い方法が必要です はじめに テキストから画像(TTI)生成は最近のトレンドであり、数千のTTIモデルがHugging Face Hubにアップロードされています。各モダリティは異なるバイアスの影響を受ける可能性がありますが、これらのモデルのバイアスをどのように明らかにするのでしょうか?このブログ投稿では、TTIシステムのバイアスの源泉、それらに対処するためのツールと潜在的な解決策について、私たち自身のプロジェクトと広範なコミュニティのものを紹介します。 画像生成における価値観とバイアスのエンコード バイアスと価値観には非常に密接な関係があります。特に、これらが与えられたテキストから画像モデルのトレーニングやクエリに埋め込まれている場合、この現象は生成された画像に大きな影響を与えます。この関係は、広範なAI研究分野で知られており、それに対処するためのかなりの努力が進行中ですが、特定のモデルで進化する人々の価値観を表現しようとする複雑さは依然として存在しています。これは、適切に明らかにし、対処するための持続的な倫理的な課題を提起します。 たとえば、トレーニングデータが主に英語である場合、それはおそらく西洋の価値観を伝えています。その結果、異なる文化や遠い文化のステレオタイプな表現が得られます。以下の例では、同じプロンプト「北京の家」に対してERNIE ViLG(左)とStable Diffusion v 2.1(右)の結果を比較すると、この現象が顕著に現れます: バイアスの源泉 近年、自然言語処理(Abidら、2021年)およびコンピュータビジョン(BuolamwiniおよびGebru、2018年)の両方の単一モダリティのAIシステムにおけるバイアス検出に関する重要な研究が行われています。MLモデルは人々によって構築されるため、すべてのMLモデル(そして技術全般)にはバイアスが存在します。これは、画像の中で特定の視覚的特性が過剰または過少に表現される(たとえば、オフィスワーカーのすべての画像にネクタイがある)ことや、文化的および地理的なステレオタイプの存在(たとえば、白いドレスとベールを着た花嫁のすべての画像、代表的な花嫁のイメージである赤いサリーの花嫁など)が現れることで現れます。AIシステムは広く異なるセクターやツール(例:Firefly、Shutterstock)に展開される社会技術的なコンテキストで展開されるため、既存の社会的なバイアスや不平等を強化する可能性があります。以下にバイアスの源泉の非徹底的なリストを示します: トレーニングデータのバイアス:テキストから画像への変換のための人気のあるマルチモーダルデータセット(たとえば、テキストから画像へのLAION-5B、画像キャプショニングのMS-COCO、ビジュアルクエスチョンアンサリングのVQA v2.0など)には、多数のバイアスや有害な関連が含まれていることが判明しています(Zhaoら、2017年、PrabhuおよびBirhane、2021年、Hirotaら、2022年)。これらのデータセットでトレーニングされたモデルには、画像生成の多様性の欠如や、文化やアイデンティティグループの共通のステレオタイプが永続化するという初期の結果がHugging Face Stable Biasプロジェクトから示されています。たとえば、CEO(右)とマネージャー(左)のDall-E 2の生成結果を比較すると、両方とも多様性に欠けていることがわかります: 事前トレーニングデータのフィルタリングにおけるバイアス:モデルのトレーニングに使用される前に、データセットに対して何らかの形のフィルタリングが行われることがよくあります。これにより、異なるバイアスが導入されます。たとえば、Dall-E 2の作者たちは、トレーニングデータのフィルタリングが実際にバイアスを増幅することを発見しました。これは、既存のデータセットが女性をより性的な文脈で表現するというバイアスや、使用されるフィルタリング手法の固有のバイアスに起因する可能性があると彼らは仮説を立てています。 推論におけるバイアス:Stable…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.