Learn more about Search Results いくつかの - Page 314

- You may be interested

- 「生物コンピューター」の独自の約束

- 室温超伝導体であることが確認されたLK-99...

- 「AIとブロックチェーンの交差点を探る:...

- PaLM AI | Googleの自家製生成AI

- 研究チームがニューロモーフィックコンピ...

- 「本番環境での機械学習モデルのモニタリ...

- 「KNIMEによるデータの可視化」

- 「グラフデータベースを使用してリアルタ...

- マイクロソフトの研究者がTable-GPTを紹介...

- マルコフとビネメ・シェビシェフの不等式

- 「キャリアは、AWS GlueとAmazon SageMake...

- 「モンテカルロシミュレーションを通じてA...

- lazy_staticを使用してランタイムでRustの...

- 「従来のAI vs 生成的AI」

- なぜ仮説検定はハムレットからヒントを得...

PyTorchを使った転移学習の実践ガイド

この記事では、転移学習と呼ばれる技術を使用して、カスタム分類タスクに事前学習済みモデルを適応する方法を学びますPyTorchを使用した画像分類タスクで、Vgg16、ResNet50、およびResNet152の3つの事前学習済みモデルで転移学習を比較します

バードの未来展望:よりグローバルで、よりビジュアル的で、より統合されたもの

「Bardのウェイトリストを終了し、より多くの地域をサポートするようになり、画像を導入し、パートナーアプリと連携することができるようになりました」

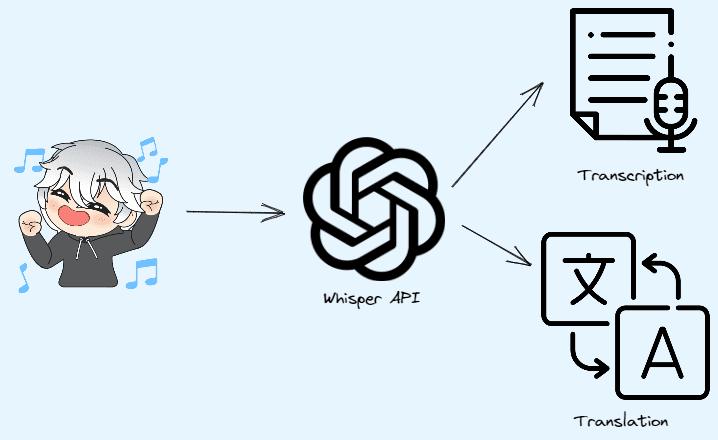

OpenAIのWhisper APIによる転写と翻訳

この記事では、OpenAIのWhisper APIを使用してオーディオをテキストに変換する方法を紹介しますまた、自分自身のプロジェクトでの使用方法やデータサイエンスプロジェクトへの統合方法も説明します

DeepMindのAIマスターゲーマー:2時間で26のゲームを学習

強化学習は、Google DeepMindの中核的な研究分野であり、AIを用いて実世界の問題を解決するための膨大な可能性を秘めています。しかし、そのトレーニングデータとコンピューティングパワーの非効率性は、重大な課題を引き起こしています。DeepMindは、MilaとUniversité de Montréalの研究者と協力して、これらの制限に対抗するAIエージェントを導入しました。このエージェントは、Bigger, Better, Faster(BBF)モデルとして知られており、わずか2時間で26のゲームを学習しながらAtariベンチマークで超人的なパフォーマンスを達成しました。この驚異的な成果は、効率的なAIトレーニング方法の新たな道を開き、RLアルゴリズムの将来的な進歩の可能性を解き放ちます。 詳細はこちらをご覧ください:DataHack Summit 2023のワークショップで、最新のAI技術を使用して強化学習の信じられないほどの可能性を解き放ち、実世界の課題に取り組んでください。 強化学習の効率課題 強化学習は、複雑なタスクに取り組むための有望なアプローチとして長年認識されてきました。しかし、従来のRLアルゴリズムは、実用的な実装を妨げる非効率性に苦しんでいます。これらのアルゴリズムは、大量のトレーニングデータと膨大なコンピューティングパワーを要求し、リソースを消費し、時間を要します。 また読む:強化学習の包括的なガイド Bigger, Better, Faster(BBF)モデル:人間を凌駕する DeepMindの最新のブレイクスルーは、Atariベンチマークでの卓越したパフォーマンスを発揮したBBFモデルから来ています。以前のRLエージェントはAtariゲームで人間を超えていましたが、BBFの特筆すべき点は、人間のテスターが利用可能な時間枠と同等の2時間のゲームプレイ内で、このような印象的な結果を達成したことです。 モデルフリー学習:新しいアプローチ BBFの成功は、ユニークなモデルフリー学習アプローチに帰することができます。ゲーム世界との相互作用を通じて受け取った報酬と罰に依存することにより、BBFは明示的なゲームモデルを構築する必要を回避します。この簡素化されたプロセスにより、エージェントは学習とパフォーマンスの最適化に集中し、より迅速かつ効率的なトレーニングが可能になります。 また読む:OpenAIとTensorFlowを使用した人間のフィードバックで強化学習を強化する トレーニング方法と計算効率の向上 BBFの急速な学習の成果は、いくつかの重要な要因によるものです。研究チームは、より大きなニューラルネットワークを採用し、自己モニタリングトレーニング方法を改良し、効率を向上させるための様々な技術を実装しました。特に、BBFは、以前のアプローチと比較して必要な計算リソースを減らすことができる、単一のNvidia A100 GPUでトレーニングすることができます。 進歩のベンチマーク:RLの進歩のための足がかり…

単一モダリティとの友情は終わりました – 今やマルチモダリティが私の親友です:CoDiは、合成可能な拡散による任意から任意への生成を実現できるAIモデルです

ジェネレーティブAIは、今ではほぼ毎日聞く用語です。私はジェネレーティブAIに関する論文をどれだけ読んでまとめたか覚えていません。彼らは印象的で、彼らがすることは非現実的で魔法のようであり、多くのアプリケーションで使用できます。テキストプロンプトを使用するだけで、画像、動画、音声などを生成できます。 近年のジェネレーティブAIモデルの大幅な進歩により、以前は不可能と考えられていたユースケースが可能になりました。テキストから画像へのモデルで始まり、信じられないほど素晴らしい結果が得られたことがわかった後、複数のモダリティを扱うことができるAIモデルの需要が高まりました。 最近は、任意の入力の組み合わせ(例:テキスト+音声)を取り、様々な出力の組み合わせ(例:ビデオ+音声)を生成できるモデルの需要が急増しています。これを対処するためにいくつかのモデルが提案されていますが、これらのモデルは、共存し相互作用する複数のモダリティを含む現実世界のアプリケーションに関して制限があります。 モダリティ固有の生成モデルを多段的なプロセスでつなげることは可能ですが、各ステップの生成力は本質的に限定されるため、手間がかかり、遅いアプローチとなります。また、独立に生成された単一モダルストリームは、組み合わせるときに一貫性や整合性が欠けることがあり、後処理の同期が困難になる場合があります。 任意の入力モダリティの混合を処理し、任意の出力の組み合わせを柔軟に生成するためのモデルをトレーニングするには、膨大な計算およびデータ要件が必要です。可能な入力-出力の組み合わせの数は指数関数的に増加し、多数のモダリティグループに対して整列したトレーニングデータはまれまたは存在しないためです。 ここで、この課題に取り組むために提案されたCoDiというモデルを紹介しましょう。 CoDiは、任意のモダリティの任意の組み合わせを同時に処理および生成することを可能にする新しいニューラルアーキテクチャです。 CoDiの概要。出典:https://arxiv.org/pdf/2305.11846.pdf CoDi は、入力条件付けおよび生成拡散ステップの両方で複数のモダリティを整列させることを提案しています。さらに、対照的な学習のための「ブリッジングアライメント」戦略を導入し、線形数のトレーニング目標で指数関数的な入力-出力の組み合わせを効率的にモデル化できるようにしています。 CoDi の主要なイノベーションは、潜在的な拡散モデル(LDM)、多モダル条件付けメカニズム、およびクロスアテンションモジュールの組み合わせを利用して、任意の-to-任意の生成を処理することができる能力にあります。各モダリティ用に別々のLDMをトレーニングし、入力モダリティを共有特徴空間に射影することで、CoDi は、このような設定の直接的なトレーニングなしで、任意のモダリティまたはモダリティの組み合わせを生成できます。 CoDiの開発には、包括的なモデル設計と多様なデータリソースでのトレーニングが必要です。最初に、テキスト、画像、動画、音声などの各モダリティに対して潜在的な拡散モデル(LDM)をトレーニングします。これらのモデルは独立して並行してトレーニングでき、モダリティに固有のトレーニングデータを使用して、卓越した単一モダリティ生成品質を確保します。音声+言語のプロンプトを使用して画像を生成する場合の条件付きクロスモダリティ生成では、入力モダリティを共有の特徴空間に射影し、出力LDMは入力特徴の組み合わせに注意を払います。この多モダル条件付けメカニズムにより、拡散モデルは直接的なトレーニングなしで、任意のモダリティまたはモダリティの組み合わせを処理できるようになります。 CoDiモデルの概要。出典:https://arxiv.org/pdf/2305.11846.pdf トレーニングの第2ステージでは、CoDiは、任意の出力モダリティの任意の組み合わせを同時に生成する多対多の生成戦略を処理します。これは、各ディフューザーにクロスアテンションモジュールを追加し、環境エンコーダーを追加して、異なるLDMの潜在変数を共有潜在空間に投影することによって実現されます。このシームレスな生成能力により、CoDiは、すべての可能な生成組み合わせでトレーニングすることなく、任意のモダリティのグループを生成できるため、トレーニング目標の数を指数関数から線形関数に減らすことができます。 (※以下、原文のHTMLコードを保持します) In the second stage of training, CoDi…

AWSが開発した目的に特化したアクセラレータを使用することで、機械学習ワークロードのエネルギー消費を最大90%削減できます

従来、機械学習(ML)エンジニアは、モデルの学習と展開コストとパフォーマンスのバランスを取ることに焦点を当ててきました最近では、持続可能性(エネルギー効率)が顧客にとって追加の目標となっていますこれは重要なことであり、MLモデルのトレーニングを行い、トレーニングされたモデルを使用して予測(推論)を行うことは、非常にエネルギーを消費するタスクであるためです加えて、さらに...

電力網からハッカーを遠ざける方法

電力供給ネットワークの侵入から保護する

GPTエンジニア:1つのプロンプトで強力なアプリを構築する

GPTエンジニアは、1つのプロンプトで完全なコーディングプロジェクトを構築できるAIエージェントです

中間旅程のタトゥープロンプト

次のタトゥーのインスピレーションを探している場合は、Midjourneyを使用してみてください

ビジネスにおける機械学習オペレーションの構築

私のキャリアで気づいたことは、成功したAI戦略の鍵は機械学習モデルを本番環境に展開し、それによって商業的な可能性をスケールで解放する能力にあるということですしかし…

Find the right Blockchain Investment for you

Web 3.0 is coming, whether buy Coins, NFTs or just Coding, everyone can participate.